電子發燒友網報道(文/周凱揚)隨著AI計算逐漸蠶食通用計算的份額,數據中心的硬件市場已經開始出現了微妙的變化。最搶手的目前已經成了GPU,反觀CPU、ASIC和FPGA等硬件,開始成為陪襯。但高昂的售價以及強綁定的供應關系,還是讓不少企業開始探索別的出路。

仍在被瘋搶的GPU

在今年第一季度AI熱潮高漲下,全球已經開啟了一波GPU搶購。無論是借助GPU開發各自大模型應用的互聯網廠商,還是想借此發展其AI服務器業務的云服務廠商,都在搶購英偉達目前主推的A100和H100兩大GPU。

就連臺積電哪怕第一季度業績下滑明顯,其CEO魏哲家在法說會上也表示在AI相關的需求上觀察到了增量上行,將幫助其在今年實現可觀的庫存消化。

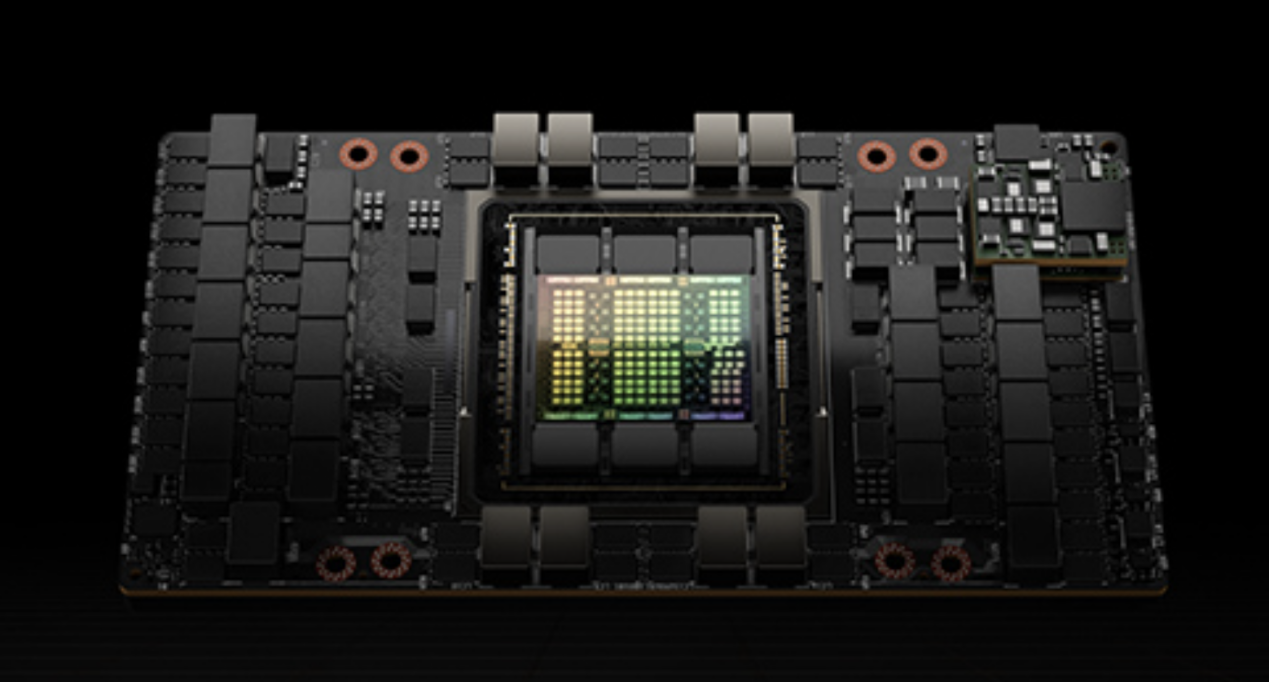

H100 GPU / 英偉達

在美國商務部半導體出口新規剛推出不久,A100在非正常渠道的單價就飆升至20000美元,是原價的兩倍左右。為此英偉達僅僅面向中國市場推出了A800和H800,只不過將高速互聯總線NVLink限制在了400GB/s,但好歹仍足以滿足大部分AI計算的需求。

可好景不長,隨著緊缺和搶購的趨勢很快蔓延到了A800和H800上,據了解,國內市場的A800單價一周上漲了30%,從原來9萬元上升至13萬元,甚至連帶使得搭載該卡的服務器現貨同樣漲價,頗有當年礦潮期顯卡漲價整機一并漲價的趨勢。

使其狀況更加惡化的是,英偉達據傳大量削減了A800的供應,而是轉為推廣更高端也更昂貴的H800,單價在25萬元左右。高端的GPU無疑能夠帶來更高的性能,但性價比相對較低,大規模部署的成本也會更加難以承受。所以從全球市場的購買表現上來看,互聯網公司和云服務廠商顯然覺得A100或A800更香一點。

可為了更高的利潤轉化,英偉達決心調整A800和H800的供應比例的話,也就說得過去了。A100的市場流通率較高,而A800這種面世不久的特供產品,也更方便在供應上加以限制。

省時和省錢

既然GPU困人已久,為何不打破這一限制,轉用大規模量產成本更低的ASIC產品呢?事實上,很多廠商早就有類似的心思,只不過執行起來卻是寸步難行。首先對于大模型這樣的AI應用來說,硬件性能只是一個方面,擁有優質的軟件生態也很重要。

英偉達的CUDA成了任何進軍AI產業的公司在軟件生態上的一頭攔路虎,遲遲沒法突破。固然ASIC的方案可以省下不少硬件成本,但在軟件上仍有不小的障礙。初創公司ASIC硬件的軟件生態不成熟,巨頭自研的產品又難以與第三方開發結合起來,或者說能打造出爆品應用的概率更低。

反觀CUDA,發展這么多年積累的各種library已經逐漸趨于成熟,甚至在英偉達的GPU上優化到了最佳狀態,開發者只需要調用API即可實現所需的效果。這堵墻就連同為GPU廠商的AMD等競爭對手都未能攻破,因為AI時代下省時才能搶占先機,省錢是之后采取考慮的事。

話雖如此,相關的嘗試依舊沒有停止,諸如谷歌的TPU、亞馬遜的Trainium以及微軟最近在研究的Chiplet Cloud等等,都是廠商們對ASIC持續看好的表現。可以看出,讓互聯網企業,尤其是芯片設計能力欠缺的企業,去走ASIC這條路線是很難的。而托管了諸多第三方芯片設計平臺、大模型和AI計算負載的云服務廠商,有這個技術積累,也有實力組建或已組建達標的芯片設計隊伍,最終做到省時又省錢。

寫在最后

ASIC固然前景可觀,但目前廠商們在購置GPU上花的錢多半是多于自研投入的,這也就是GPU作為通用計算硬件的future proofing性質。可能在GPT爆火的今年,這款ASIC提供了遠超GPU的性能或成本優勢,但未來保不齊會出現其他的爆品應用。GPU可以很快調轉勢頭,但ASIC就可能會被淘汰。所以對這些公司來說,無論是購買A100還是A800,不僅是對現在的投資,也是對未來的投資。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

asic

+關注

關注

34文章

1242瀏覽量

121982 -

gpu

+關注

關注

28文章

4910瀏覽量

130651 -

AI

+關注

關注

87文章

34197瀏覽量

275348

發布評論請先 登錄

相關推薦

熱點推薦

Imagination與澎峰科技攜手推動GPU+AI解決方案,共拓計算生態

近日, Imagination Technologies 與國內領先的異構計算軟件與智算混合云服務提供商 澎峰科技 ( PerfXLab )正式簽署合作備忘錄( MoU ),圍繞 GPU 與 AI

發表于 05-21 09:40

?942次閱讀

AI在醫療健康和生命科學中的發展現狀

NVIDIA 首次發布的“AI 在醫療健康和生命科學中的現狀”調研,揭示了生成式和代理式 AI 如何幫助醫療專業人員在藥物發現、患者護理等領域節省時間和成本。

Banana Pi 發布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 計算與嵌入式開發

存儲設計,輕松應對復雜AI模型與實時推理。其堅固耐用的工業級品質與超低成本,不僅適應嚴苛環境的應用,更為工程師提供了極致靈活的開發體驗,堪稱推動開源生態與人工智能未來的標桿之選。” 瑞

發表于 03-19 17:54

GPU加速計算平臺的優勢

傳統的CPU雖然在日常計算任務中表現出色,但在面對大規模并行計算需求時,其性能往往捉襟見肘。而GPU加速計算平臺憑借其獨特的優勢,吸引了行業內人士的廣泛關注和應用。下面,

GPU云計算服務怎么樣

在當今數字化快速發展的時代,高性能計算需求日益增長。為滿足這些需求,GPU云計算服務應運而生。那么,GPU云計算服務怎么樣呢?接下來,

GPU是如何訓練AI大模型的

在AI模型的訓練過程中,大量的計算工作集中在矩陣乘法、向量加法和激活函數等運算上。這些運算正是GPU所擅長的。接下來,AI部落小編帶您了解

《CST Studio Suite 2024 GPU加速計算指南》

《GPU Computing Guide》是由Dassault Systèmes Deutschland GmbH發布的有關CST Studio Suite 2024的GPU計算指南。涵蓋GP

發表于 12-16 14:25

使用瑞薩AnalogPAK SLG47001/03節省開發時間

在當今快速發展的技術市場中,對更快、更高效的產品開發的需求比以往任何時候都高。企業一直在尋找簡化流程和縮短上市時間的方法。有助于節省時間、簡化設計和降低成本的產品對于保持競爭力至關重要。

《算力芯片 高性能 CPUGPUNPU 微架構分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

CPU、GPU的演進歷程,AI專用芯片或將引領未來計算平臺的新方向。正如愛因斯坦所說:\"想象力比知識更重要\" —— 在芯片設計領域,創新思維帶來的突破往往令人驚嘆。

發表于 11-24 17:12

FPGA和ASIC在大模型推理加速中的應用

隨著現在AI的快速發展,使用FPGA和ASIC進行推理加速的研究也越來越多,從目前的市場來說,有些公司已經有了專門做推理的ASIC,像Groq的LPU,專門針對大語言模型的推理做了優化,因此相比

如何計算上拉電阻的值

,但在對性能有更高要求或特定條件下,則需要通過更為精確的計算來確定電阻值。本文將詳細介紹如何計算上拉電阻的值。 首先,我們需要理解上拉電阻在I2C總線中的基本作用。在I2C的開漏輸出設計中,上拉電阻負責在無設備驅動總線時,將SC

人工智能在項目管理中的應用:Atlassian Intelligence六大自動化任務方法詳解,讓Jira與Confluence效率翻倍

的情況下節省時間和金錢的有效方法之一。無論是設置提醒還是改進寫作,AI都可以幫助您高效地完成工作。AtlassianIntelligence將AI的強大功能與At

省成本還是省時間,AI計算上的GPU與ASIC之選

省成本還是省時間,AI計算上的GPU與ASIC之選

評論