近日,高通技術(shù)公司正式發(fā)布白皮書《混合 AI 是 AI 的未來》。高通在白皮書中提到,隨著生成式 AI 正以前所未有的速度發(fā)展以及計算需求的日益增長,AI 處理必須分布在云端和終端進(jìn)行,才能實現(xiàn) AI 的規(guī)模化擴展并發(fā)揮其最大潛能——正如傳統(tǒng)計算從大型主機和瘦客戶端演變?yōu)楫?dāng)前云端和邊緣終端相結(jié)合的模式。與僅在云端進(jìn)行處理不同,混合 AI 架構(gòu)在云端和邊緣終端之間分配并協(xié)調(diào) AI 工作負(fù)載。云端和邊緣終端如智能手機、 汽車、個人電腦和物聯(lián)網(wǎng)終端協(xié)同工作,能夠?qū)崿F(xiàn)更強大、更高效且高度優(yōu)化的 AI。

高通產(chǎn)品管理高級副總裁兼 AI 負(fù)責(zé)人 Ziad Asghar 在媒體溝通會上進(jìn)一步分享了高通對于混合 AI 的愿景,以及如何結(jié)合自身的產(chǎn)品技術(shù)優(yōu)勢,讓混合 AI 的愿景成為現(xiàn)實。

Ziad Asghar 表示,“我們正在引領(lǐng)混合 AI 愿景的實現(xiàn)。對隱私和安全要求比較高的終端側(cè)工作負(fù)載,可以繼續(xù)通過邊緣云,完全在終端側(cè)完成。對于其它的模型工作,我們也可以和云服務(wù)供應(yīng)商合作完成。通過在云端和邊緣側(cè)終端分布工作負(fù)載,我們能夠大幅度減少云端的處理量。混合 AI 的優(yōu)勢在于,即使不同終端處理能力不盡相同,但仍然能夠提供相近的體驗,同時帶來包括成本、能耗、隱私與安全、個性化等優(yōu)勢;還能通過出色的 5G 連接技術(shù)確保信息在端到端之間進(jìn)行高效傳輸。”

混合 AI 對生成式 AI 規(guī)模化擴展至關(guān)重要

ChatGPT 的爆火掀起生成式 AI 熱潮。自 2022 年 11 月推出后,ChatGPT 僅用了短短兩個月時間月活用戶便達(dá)到 1 億,成為有史以來增長速度最快的消費類應(yīng)用和第一個殺手級的生成式 AI 應(yīng)用。

作為一項變革性的技術(shù),生成式 AI 顛覆了原有的工作、娛樂方式,并擁有非常豐富的應(yīng)用領(lǐng)域,應(yīng)用數(shù)量也在不斷激增。具體而言,生成式 AI 的應(yīng)用主要包括搜索、內(nèi)容生成、生產(chǎn)力、代碼編寫等等,能夠在數(shù)秒之內(nèi)通過大型基礎(chǔ)模型創(chuàng)作內(nèi)容。數(shù)據(jù)顯示,AI 正迎來大爆發(fā)時期,目前已有超過 3000 個可用的生成式 AI 應(yīng)用和特性。

據(jù)初步估計顯示,生成式 AI 市場規(guī)模將達(dá)到 1 萬億美元,廣泛覆蓋生態(tài)鏈的各個參與方。為把 握這一巨大機遇,并推動 AI 成為主流,計算架構(gòu)需要不斷演進(jìn)并滿足大規(guī)模生成式 AI 日益增長的處理和性能需求。

擁有數(shù)十億參數(shù)的眾多生成式 AI 模型對計算基礎(chǔ)設(shè)施提出了極高的需求。因此,無論是為 AI 模型優(yōu)化參數(shù)的 AI 訓(xùn)練,還是執(zhí)行該模型的 AI 推理,至今都一直受限于大型復(fù)雜模型而在云端部署。

AI 推理的規(guī)模遠(yuǎn)高于 AI 訓(xùn)練。盡管訓(xùn)練單個模型會消耗大量資源,但大型生成式 AI 模型預(yù)計每年僅需訓(xùn)練幾次。然而,這些模型的推理成本將隨著日活用戶數(shù)量及其使用頻率的增加而增加。在云端進(jìn)行推理的成本極高,這將導(dǎo)致規(guī)模化擴展難以持續(xù)。

高通認(rèn)為,混合 AI 能夠解決上述問題,正如傳統(tǒng)計算從大型主機和瘦客戶端演變?yōu)楫?dāng)前云端和 PC、智能手機等邊緣終端相結(jié)合的模式。

具體來說,混合 AI 指終端和云端協(xié)同工作,在適當(dāng)?shù)膱鼍昂蜁r間下分配 AI 計算的工作負(fù)載,以提供更好的體驗,并高效利用資源。在一些場景下,計算將主要以終端為中心,在必要時向云端分流任務(wù)。而在以云為中心的場景下,終端將根據(jù)自身能力,在可能的情況下從云端分擔(dān)一些 AI 工作負(fù)載。混合 AI 架構(gòu) (或僅在終端側(cè)運行 AI),能夠在全球范圍帶來成本、能耗、性能、隱私、安全和個性化優(yōu)勢。

利用邊緣側(cè)終端規(guī)模化 擴展生成式 AI

Ziad Asghar 表示,當(dāng)前很多人將生成式 AI 和云端聯(lián)系在一起,通過高通的技術(shù),能夠讓這些出色的用例在邊緣側(cè)實現(xiàn)。“生成式 AI 對眾多領(lǐng)域產(chǎn)生了廣泛影響,目前有大量的新興應(yīng)用需要生成式 AI 能力,且已經(jīng)擁有了龐大的用戶規(guī)模,市場上也出現(xiàn)了眾多非常龐大的模型。我們認(rèn)為,要真正釋放生成式 AI 的全部潛能,AI 需要在邊緣側(cè)運行,這也是高通一直努力的方向,我們相信憑借我們的技術(shù),我們能夠帶來遙遙領(lǐng)先的終端側(cè)生成式 AI 體驗。”

在以終端為中心的混合AI架構(gòu)中,云端僅用于處理終端側(cè)無法充分運行的AI任務(wù)。

據(jù)了解,目前生成式 AI 的應(yīng)用能夠在高通所推出的幾乎所有主要產(chǎn)品線中使用。舉例來說,手機作為高度個性化的設(shè)備,能夠通過生成式 AI 成為消費者真正意義上的數(shù)字助手,它可以接受用戶的所有需求,且甚至無需聯(lián)網(wǎng)就能夠完成任務(wù),并完全通過大型基礎(chǔ)模型(例如文本生成文本模型 LLaMA)與用戶交流。此外,生成式 AI 能夠基于視頻會議的語音轉(zhuǎn)錄內(nèi)容,制定任務(wù)清單,并自動生成完整的演示文稿直接供用戶使用,使生產(chǎn)力能夠成倍增長。驍龍計算平臺擁有專用的硬件單元,能夠原生支持生成式 AI 在本地使用。

在 XR 方面,生成式 AI 能夠根據(jù)終端側(cè)所提供的用戶信息進(jìn)行定制和優(yōu)化,為用戶帶來完全不同的獨特虛擬世界體驗。Ziad Asghar 表示,如果只在云端運行,則不具備終端側(cè)的情境信息,因此利用終端能夠帶來更好的用戶體驗。

汽車領(lǐng)域的用例也非常豐富。在座艙中使用對話式 AI,能夠幫助用戶規(guī)劃路線,在去餐廳的路上推薦用餐選項,或者在上班途中列出今日的工作事項。生成式 AI 還可以根據(jù)出發(fā)點和目的地信息,結(jié)合汽車的豐富傳感器數(shù)據(jù)制定不同的路線規(guī)劃,找到最佳路線。

物聯(lián)網(wǎng)領(lǐng)域,生成式 AI 能夠助力打造面向?qū)I(yè)領(lǐng)域的 GPT 類型模型,以及幫助用戶完成不同任務(wù)的 IoT 助手。如果來到一個新的城市,生成式 AI 能夠幫助提供旅行目的地推薦。此外它還適用于其他的垂直領(lǐng)域,如醫(yī)療、零售、酒店管理等等。

隨著強大的生成式 AI 模型不斷縮小,以及終端側(cè)處理能力的持續(xù)提升,混合 AI 的潛力將會進(jìn)一步增長。參數(shù)超過 10 億的 AI 模型已經(jīng)能夠在手機上運行,且性能和精度達(dá)到與云端相似的水平。不久的將來,擁有 100 億或更高參數(shù)的模型將能夠在終端上運行。

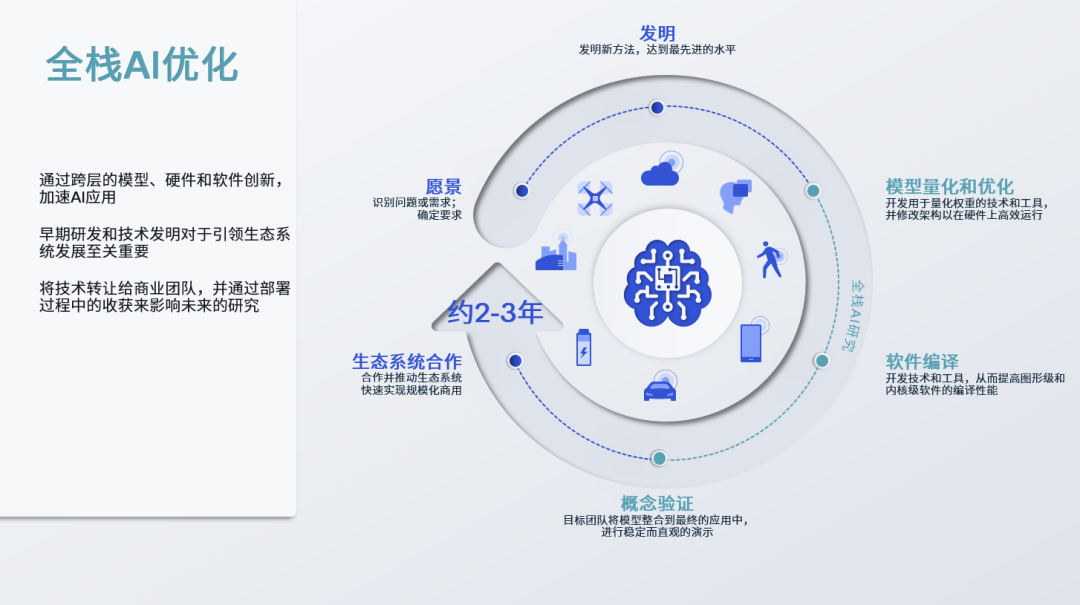

全棧 AI 優(yōu)化

Ziad Asghar 表示,目前高通已經(jīng)實現(xiàn)了全球首個 Android 手機上的 Stable Diffusion 終端側(cè)演示。Stable Diffusion 是一個參數(shù)超過 10 億的超大神經(jīng)網(wǎng)絡(luò)基礎(chǔ)模型,能夠基于輸入的文本提示生成圖片。高通的這一終端側(cè)演示是在飛行模式下進(jìn)行的,通過高通的全棧 AI 優(yōu)化,這一模型能夠完全在終端側(cè)運行,實現(xiàn)在 15 秒內(nèi)完成 20 步推理,生成飽含細(xì)節(jié)的圖像。

高通面向 Stable Diffusion 進(jìn)行了全棧 AI 優(yōu)化。2022 年 6 月,高通推出了專門面向邊緣側(cè) AI 的領(lǐng)先軟件棧產(chǎn)品——高通 AI 軟件棧,能夠從軟件層面進(jìn)行模型優(yōu)化。

Ziad Asghar 表示,在云端服務(wù)器上訓(xùn)練的模型一般采用 32 位浮點運算(FP32),這意味著完成模型推理需要大量的處理工作。“我們希望通過整數(shù)運算模式和量化技術(shù)進(jìn)行 AI 推理,即時獲取模型推理結(jié)果。針對 Stable Diffusion,我們所采用的是 8 位整數(shù)運算(INT8)。去年年底在第二代驍龍 8 移動平臺上,我們已經(jīng)進(jìn)一步支持了 4 位整數(shù)運算(INT4)能力。我們的硬件、軟件以及工具設(shè)計也都考慮了如何充分利用這一關(guān)鍵優(yōu)勢。”

目前高通能夠支持 Stable Diffusion 這一超過 10 億參數(shù)的模型在終端側(cè)運行,但許多關(guān)鍵的生成式 AI 模型,比如文本生成圖像、自然語言處理、編程、圖像理解、圖像創(chuàng)作等,模型規(guī)模一般在 10 億到 100 億參數(shù)之間。Ziad Asghar 表示未來幾個月內(nèi),高通將有望支持參數(shù)超過 100 億的模型在終端側(cè)運行。

對話 Ziad Asghar: AI 大模型會在 C 端和 B 端同步落地

在媒體溝通會上,Ziad Asghar 接受了 InfoQ 在內(nèi)的部分媒體采訪。以下為采訪實錄,經(jīng)編輯。

問:剛才說到,高通在幾個月之后就可以實現(xiàn)在終端側(cè)處理參數(shù)規(guī)模達(dá) 100 億的模型,你們會用什么樣的大語言模型?

Ziad Asghar:我們看到目前大語言模型的模態(tài)非常豐富,并且已經(jīng)出現(xiàn)了多模態(tài)模型,包括文本生成圖片、文本生成文本、文本生成視頻,甚至還有圖片生成文本、圖片生成視頻等方式。這將揭開新的序幕,開啟許多人們未曾想象過的全新用例。我們已經(jīng)開始面向不同場景和用例需求的模型展開工作。

問:對于文本生成文本模型,會不會考慮使用來自于 Meta 的開源 LLaMA 模型?

Ziad Asghar:我們對模型的應(yīng)用持有非常開放的態(tài)度。針對中國市場的模型,我們會專注于面向本地語言和使用場景的模型調(diào)優(yōu)和訓(xùn)練,以讓用戶能夠根據(jù)不同的需求,隨時隨地地使用模型。我們當(dāng)前在關(guān)注不同的開源模型,同時我們也將與眾多的中國合作伙伴攜手,實現(xiàn)這些模型在本土市場的終端側(cè)部署。

問:智能手機端側(cè)運行生成式 AI 會成為未來的大趨勢嗎?

Ziad Asghar:我們認(rèn)為這將是一個非常值得期待的重要趨勢。所有不同的終端在生成式 AI 的助力之下,將為消費者帶來更強大的吸引力。終端的可用性、娛樂性和生產(chǎn)力價值將遠(yuǎn)遠(yuǎn)超越當(dāng)前的水平。

問:您剛剛提到的 Stable Diffusion 成功在安卓手機上運行,不到 15 秒生成圖片,這個是完全在終端側(cè)上就能運行嗎?我們大約什么時候能用上?以什么樣的方式用上?

Ziad Asghar:目前我們已經(jīng)能夠完全在終端側(cè)運行 Stable Diffusion,無需連接云端,即使是將手機調(diào)到飛行模式也可以。但是目前只有采用高通技術(shù)的終端能夠?qū)崿F(xiàn)。對于具體的用例,舉例來說,我們可以將 Stable Diffusion 的能力集成到相機應(yīng)用中,用戶在任何一個地點拍攝照片,再提出需求,例如將照片背景改為夕陽之下的萬里長城,Stable Diffusion 就能夠完成這一任務(wù)。此外還有其他的用例,比如數(shù)字助手、生產(chǎn)力應(yīng)用等。我們相信通過與合作伙伴的共同努力,用戶將能在今年體驗到這些終端側(cè)用例。

問:高通實現(xiàn)終端側(cè)運行 AI 大模型,在硬件、軟件層面的核心技術(shù)優(yōu)勢是什么?未來基于其他移動芯片平臺的產(chǎn)品是否也會跟進(jìn)這一能力?

Ziad Asghar:長期以來,高通致力于持續(xù)基于我們所打造的硬件、軟件和工具資源,驅(qū)動生成式 AI 在終端側(cè)的規(guī)模化擴展。首先在硬件方面,我們在既定功耗下的處理能力領(lǐng)先于市場上的其他競爭對手,這讓我們能夠在運行生成式 AI 用例時實現(xiàn)非常出色的表現(xiàn)。憑借我們的研究投入,我們能夠在終端側(cè)利用量化技術(shù),在處理相同用例時大幅節(jié)省功耗和算力,同時完全不影響準(zhǔn)確性,這是我們的競爭對手做不到的。另外一個優(yōu)勢在軟件方面,我們提供高通 AI 引擎 Direct 以及 Qualcomm AI Studio 等軟件工具,讓這些模型能夠完全在終端側(cè)運行。

問:以聊天機器人對代表的生成式 AI 應(yīng)用要有好的使用體驗,一個比較大的挑戰(zhàn)是時延,每個指令(token)的時延需要在毫秒級別,如何才能將這類應(yīng)用部署在終端側(cè),并且擁有不錯的體驗?

Ziad Asghar:我們能夠提供非常高效的 token 生成速率,完全不會因為時延影響到用戶的體驗。時延對于用戶體驗的確至關(guān)重要,而得益于我們的技術(shù),我們的每秒 token 生成速率能夠為用戶提供流暢的體驗。

問:高通的 AI 硬件在處理 AI 應(yīng)用時比 CPU 有明顯優(yōu)勢,接下來是否會增加 transformer 核心讓端側(cè)生成式 AI 的體驗更好?

Ziad Asghar:高通 AI 引擎涵蓋了 CPU、GPU 以及 Hexagon 處理器,從而能夠在最合適的位置進(jìn)行 AI 處理。談到在高通 AI 硬件上進(jìn)行 AI 處理的優(yōu)勢,除了我們的硬件引擎有著非常強大的處理能力外,我們也在去年推出了專門面向 transformer 處理的領(lǐng)先技術(shù),能夠大幅提升 transformer 處理效率。所以在硬件層面我們的技術(shù)已經(jīng)完備,能夠支持在終端側(cè)獲得大幅提升的 transformer 處理表現(xiàn)。

問:我們注意到高通今天正式將自研 AI 技術(shù)的起步時間點定在了“十年前”,也就是曾經(jīng)的 Zeroth 處理器。我們想知道,當(dāng)年 Zeroth 的 SNN 網(wǎng)絡(luò)架構(gòu)在如今的驍龍移動平臺上得到了多大程度的繼承?

Ziad Asghar:高通長期專注于脈沖神經(jīng)網(wǎng)絡(luò)(SNN)研究,驍龍 820 平臺是我們最先應(yīng)用這一技術(shù)的產(chǎn)品。我們的大量工作也得益于這一技術(shù)研究,我們在這一技術(shù)基礎(chǔ)之上不斷積累,覆蓋了各個領(lǐng)域,包括技術(shù)、硬件增強和軟件等等。我認(rèn)為這也是我們今天能夠在終端側(cè)取得如此領(lǐng)先和豐富的 AI 能力的原因之一。

問:您認(rèn)為目前的 AI 大模型在 C 端和 B 端,哪側(cè)會更快落地?

Ziad Asghar:我認(rèn)為應(yīng)該會在 C 端和 B 端同步落地,同時高通也有能力來支持這些模型落地。無論是智能手機、VR、AR 還是汽車等面向消費者的智能設(shè)備,亦或是企業(yè)級的搭載驍龍計算平臺的 PC、智能手機等設(shè)備。我們的產(chǎn)品和技術(shù)能夠支持面向?qū)I(yè)領(lǐng)域的 GPT 模型以及豐富的模型模態(tài)(比如文本生成圖片等),這能夠為 C 端和 B 端都帶來巨大可能性,為所有人帶來出色體驗,無論是在家中還是在工作場所。甚至只要人們用手機,就可以感受到 AI 帶來的優(yōu)勢。

問:生成式 AI 在汽車座艙、智能駕駛上的應(yīng)用進(jìn)展如何?需要調(diào)用數(shù)據(jù)量和模型形式和手機端有哪些本質(zhì)不同?邊緣側(cè)的低功耗、低時延,是結(jié)合 5G 座艙芯片或大算力芯片共同實現(xiàn)的嗎?

Ziad Asghar:第一個問題,關(guān)于生成式 AI 賦能的數(shù)字座艙體驗,大家可以想象一下,用戶可以體驗到真正意義上的“和自己的車對話”。你可以告訴你的車:導(dǎo)航帶我去機場,但是在去機場的路上,我要找個地方吃個漢堡,再找個地方喝某種口味的咖啡,順便把我之前干洗的衣服取了。在數(shù)字座艙里,我們可以為用戶提供真正意義上的虛擬助手。對于汽車應(yīng)用的不同模態(tài),其要求會更加嚴(yán)格,并且需要更高的準(zhǔn)確性。因為與其他商用終端不同,在汽車?yán)锍霈F(xiàn)任何一個小錯誤都可能帶來非常嚴(yán)重的后果。所以我們在確保提供最佳體驗的同時,也要確保極高的準(zhǔn)確性。

第二個問題,在汽車領(lǐng)域我們需要將多模態(tài)相結(jié)合,同時結(jié)合雷達(dá)、激光雷達(dá)、以及攝像頭等傳感器數(shù)據(jù),從而讓我們在使用生成式 AI 規(guī)劃路線時,獲得最佳的效果。

第三個問題,汽車需要非常強大的處理能力。一方面,汽車領(lǐng)域的生成式 AI 用例需要非常豐富的終端側(cè)處理能力,同時,它還需要通過高速低時延的 5G 連接,在需要的情況下利用云端資源進(jìn)行處理。與我們其他產(chǎn)品線的產(chǎn)品相比,我們的汽車產(chǎn)品通常能夠提供更多的生成式 AI 處理能力。

問:目前在 PC 以及其他平臺上,NPU 通常是一個獨立于 CPU、GPU 的計算單元。但是在驍龍移動平臺上,CPU、GPU、DSP、ISP、甚至調(diào)制解調(diào)器都具備一定的 AI 計算能力,這就意味著驍龍平臺的 AI 計算架構(gòu)實際上是一種分布式的設(shè)計。那么這是否會加大軟件開發(fā)的難度?或者是否會出現(xiàn)某些應(yīng)用不能完整調(diào)用全部 AI 計算單元的情況?

Ziad Asghar:我們的平臺采用的是異構(gòu)計算架構(gòu),高通 AI 引擎包括 Hexagon 處理器、CPU、GPU 以及 ISP。我們相信 AI 是能夠賦能整個平臺的通用技術(shù),無論是攝像頭還是圖像、調(diào)制解調(diào)器、視頻、音頻、語音等等都可以利用 AI 技術(shù)。同時,基于我們在軟件方面進(jìn)行的大量投入,無論要在終端側(cè)運行何種應(yīng)用,高通 AI 引擎都能提供充沛、強大的算力。

問:終端設(shè)備上的 AI 模型是否對用戶的個人數(shù)據(jù)進(jìn)行處理?

Ziad Asghar:針對用戶所擔(dān)心的個人隱私數(shù)據(jù)保護(hù),終端側(cè)處理恰恰能夠解決這一問題。正如我剛剛所講,無論是 10 億參數(shù)的模型,還是 100 億參數(shù)的模型,如果我們能夠完全在終端側(cè)來運行,比如用戶發(fā)出一個查詢,終端接收之后能夠獨立完成推理,那么所有相關(guān)的查詢信息和數(shù)據(jù)都會留在終端上,不會離開終端,這也是邊緣處理相對于云端處理的獨特優(yōu)勢所在,因為如果要在云端進(jìn)行查詢,那么數(shù)據(jù)就要先發(fā)送到云端,處理完再從云端回到終端。

-

AI

+關(guān)注

關(guān)注

87文章

34294瀏覽量

275481 -

模型

+關(guān)注

關(guān)注

1文章

3488瀏覽量

50021 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1588瀏覽量

8810

原文標(biāo)題:AI 模型只能部署在云端?高通白皮書發(fā)布:混合 AI 是 AI 的未來

文章出處:【微信號:AI前線,微信公眾號:AI前線】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

華為發(fā)布星河AI融合SASE解決方案白皮書

如何基于Kahn處理網(wǎng)絡(luò)定義AI引擎圖形編程模型

AI端側(cè)部署開發(fā)(SC171開發(fā)套件V3)

首創(chuàng)開源架構(gòu),天璣AI開發(fā)套件讓端側(cè)AI模型接入得心應(yīng)手

AI大模型端側(cè)部署正當(dāng)時:移遠(yuǎn)端側(cè)AI大模型解決方案,激活場景智能新范式

AI模型只能部署在云端?高通白皮書發(fā)布:混合AI是AI的未來

AI模型只能部署在云端?高通白皮書發(fā)布:混合AI是AI的未來

評論