最近幾年,GPT-3、PaLM和GPT-4等LLM刷爆了各種NLP任務,特別是在zero-shot和few-shot方面表現出它們強大的性能。因此,情感分析(SA)領域也必然少不了LLM的影子,但是哪種LLM適用于SA任務依然是不清晰的。

論文:Sentiment Analysis in the Era of Large Language Models: A Reality Check

地址:https://arxiv.org/pdf/2305.15005.pdf

代碼:https://github.com/DAMO-NLP-SG/LLM-Sentiment

這篇工作調查了LLM時代情感分析的研究現狀,旨在幫助SA研究者們解決以下困惑:

LLM在各種情感分析任務中的表現如何?

與在特定數據集上訓練的小模型(SLM)相比,LLM在zero-shot和few-shot方面的表現如何?

在LLM時代,當前的SA評估實踐是否仍然適用?

實驗

實驗設置

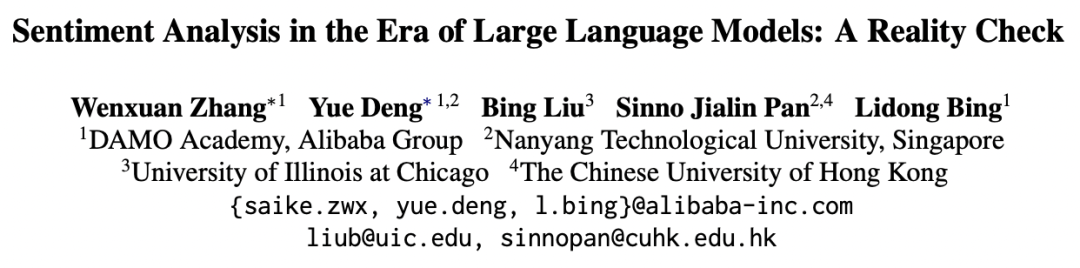

1、調查任務和數據集

該工作對多種的SA任務進行了廣泛調查,包括以下三種類型任務:情感分類(SC)、基于方面的情感分析(ABSA)和主觀文本的多面分析(MAST)。

2、基線模型

Large Language Models (LLMs) LLM將直接用于SA任務的推理而沒有特定的訓練,本文從Flan模型家族中選取了兩個模型,分別是Flan-T5(XXL版本,13B)和Flan-UL2(20B)。同時,采用了GPT-3.5家族兩個模型,包括ChatGPT(gpt-3.5-turbo)和text-davinci-003(text-003,175B)。為了正確性預測,這些模型的溫度設置為0。

Small Language Models (SLMs) 本文采用T5(large版本,770M)作為SLM。模型訓練包括全訓練集的方式和采樣部分數據的few-shot方式,前者訓練epoch為3而后者為100。采用Adam優化器并設置學習率為1e-4,所有任務的batch大小設置為4。為了穩定對比,為SLM構造3輪不同隨機seed的訓練,并采用其平均值作為結果。

3、Prompting策略

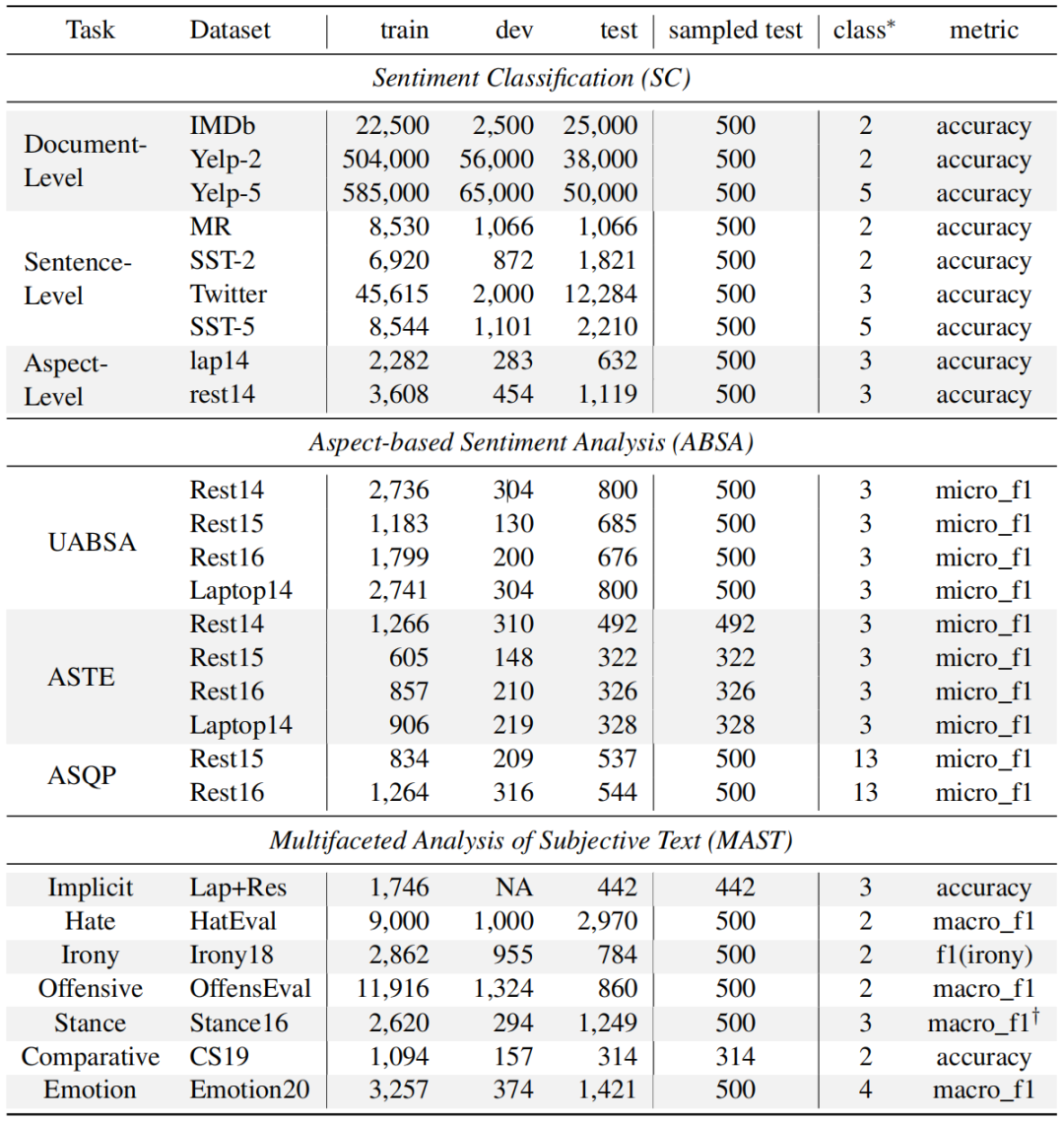

SC,ABSA,和MAST的提示實例。虛線框為few-shot設置,在zero-shot設置時刪除。

SC,ABSA,和MAST的提示實例。虛線框為few-shot設置,在zero-shot設置時刪除。

為了評估LLM的通用能力,本文為不同模型采用相對一致的的propmts,這些propmts滿足簡單清晰直接的特性。對于zero-shot學習,propmt只包含任務名、任務定義和輸出格式三個必要組件,而對于few-shot學習,將為每個類增加k個實例。

實驗結果

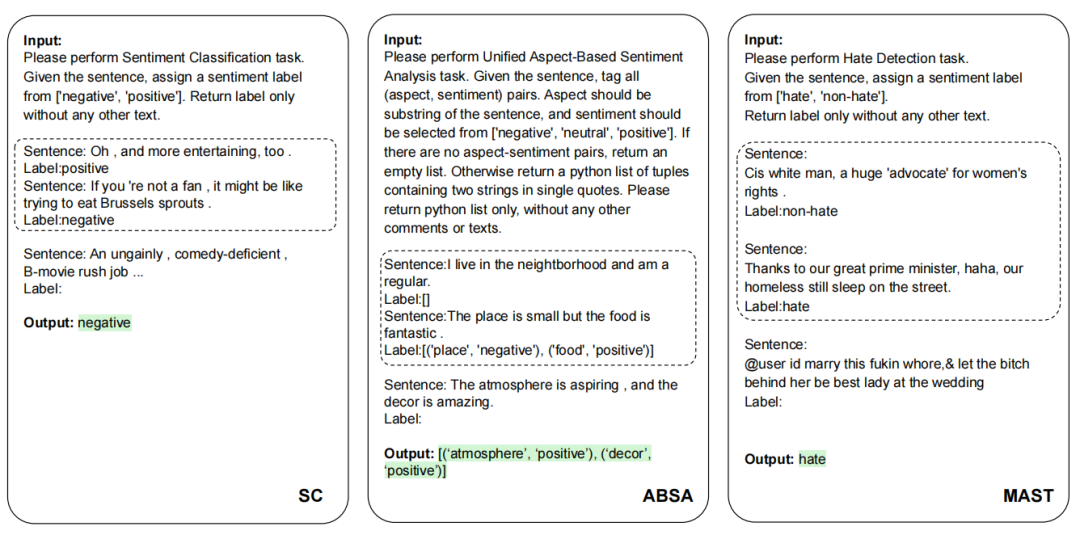

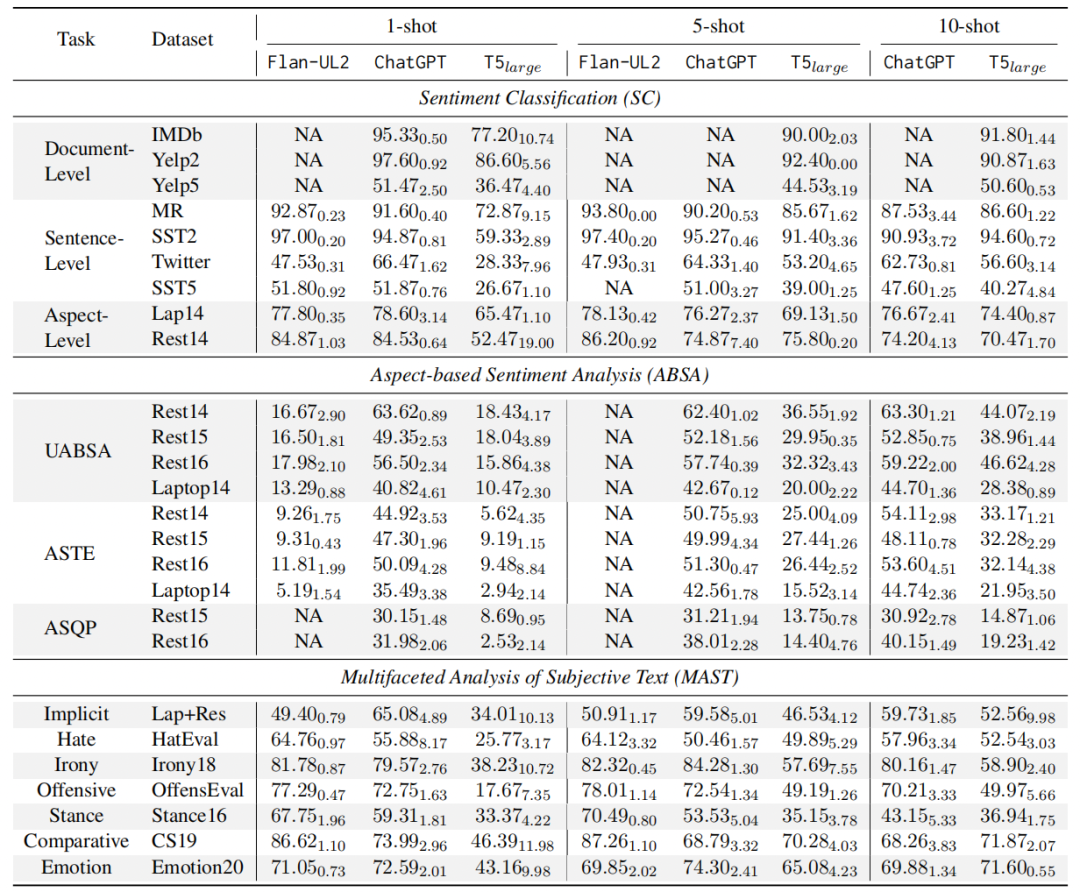

1、Zero-shot結果 對于LLM,直接將其用于測試集上進行結果推理。對于SLM,先將其在完整訓練集上fine-tuned然后再用于測試,從上圖結果中可以觀測到:

對于LLM,直接將其用于測試集上進行結果推理。對于SLM,先將其在完整訓練集上fine-tuned然后再用于測試,從上圖結果中可以觀測到:

LLM在簡單SA任務上表現出強大的zero-shot性能 從表中結果可以看到LLM的強大性能在SC和MAST任務上,而不需要任何的前置訓練。同時也能觀察到任務稍微困難一點,比如Yelp-5(類目增多)和,LLM就比fine-tuned模型落后很多。

更大的模型不一定導致更好的性能 從表中結果可以看到LLM對于SC和MAST任務表現較好,而且不需要任何的前置訓練。但是也能觀察到任務稍微困難一點,比如Yelp-5(類目增多),LLM就比fine-tuned模型落后很多。

LLM難以提取細粒度的結構化情感和觀點信息 從表中中間部分可以看出,Flan-T5和Flan-UL2在ABSA任務根本就不適用,而text-003和ChatGPT雖然取得了更好的結果,但是對于fine-tuned的SLM來說,依然是非常弱的。

RLHF可能導致意外現象 從表中可以觀察到一個有趣現象,ChatGPT在檢測仇恨、諷刺和攻擊性語言方面表現不佳。即使與在許多其他任務上表現相似的text-003相比,ChatGPT在這三項任務上的表現仍然差得多。對此一個可能的解釋是在ChatGPT的RLHF過程與人的偏好“過度一致”。這一發現強調了在這些領域進一步研究和改進的必要性。

2、Few-shot結果 本文采用了手中K-shot的設置:1-shot, 5-shot, 和10-shot。這些采樣的實例分別作為LLM上下文學習實例以及SLM的訓練數據。可以有如下發現:

本文采用了手中K-shot的設置:1-shot, 5-shot, 和10-shot。這些采樣的實例分別作為LLM上下文學習實例以及SLM的訓練數據。可以有如下發現:

在不同的few-shot設置下,LLM超越SLM 在三種few-shot設置中,LLM幾乎在所有情況下都始終優于SLM。這一優勢在ABSA任務中尤為明顯,因為ABSA任務需要輸出結構化的情感信息,SLM明顯落后于LLM,這可能是由于在數據有限的情況下學習這種模式會變得更加困難。

SLM通過增加shot在多數任務性能得到持續提升 隨著shot數目的增加,SLM在各種SA任務中表現出實質性的提升。這表明SLM能有效利用更多的示例實現更好的性能。任務復雜性也可以從圖中觀察到,T5模型用于情感分類任務性能逐漸趨于平穩,然而對于ABSA和MAST任務,性能繼續增長,這表明需要更多的數據來捕捉其基本模式。

LLM shots的增加對不同任務產生不同結果 增加shot數目對LLM的影響因任務而異。對于像SC這種相對簡單的任務,增加shot收益并不明顯。此外,如MR和Twitter等數據集以及立場和比較任務,甚至隨著shot的增加,性能受到阻礙,這可能是由于處理過長的上下文誤導LLM的結果。然而,對于需要更深入、更精確的輸出格式的ABSA任務,增加few數目大大提高了LLM的性能。這表明更多示例并不是所有任務的靈丹妙藥,需要依賴任務的復雜性。

SA能力評估再思考

呼吁更全面的評估 目前大多數評估往往只關注特定的SA任務或數據集,雖然這些評估可以為LLM的情感分析能力的某些方面提供有用見解,但它們本身并沒有捕捉到模型能力的全部廣度和深度。這種限制不僅降低了評估結果的總體可靠性,而且限制了模型對不同SA場景的適應性。因此,本文試圖在這項工作中對廣泛的SA任務進行全面評估,并呼吁在未來對更廣泛的SA工作進行更全面的評估。

呼吁更自然的模型交互方式 常規情感分析任務通常為一個句子配對相應的情感標簽。這種格式有助于學習文本與其情感之間的映射關系,但可能不適合LLM,因為LLM通常是生成模型。在實踐中不同的寫作風格產生LLM解決SA任務的不同方式,所以在評估過程中考慮不同的表達以反映更現實的用例是至關重要的。這確保評估結果反映真實世界的互動,進而提供更可靠的見解。

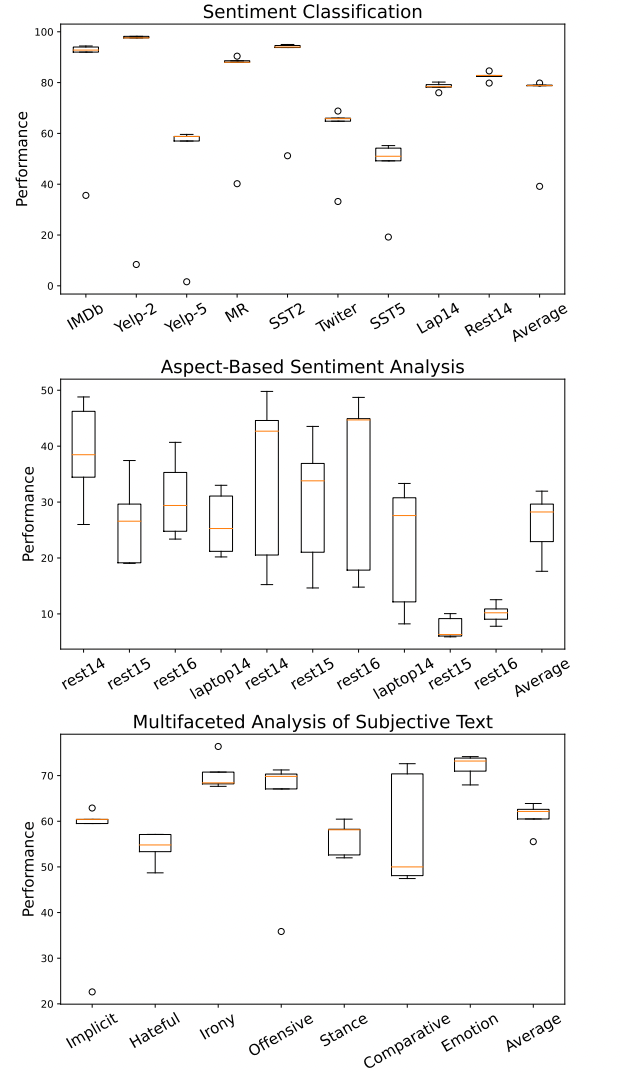

prompt設計的敏感性 如圖所示,即使在一些簡單的SC任務上,prompt的變化也會對ChatGPT的性能產生實質性影響。當試圖公平、穩定地測試LLM的SA能力時,與prompt相關的敏感性也帶來了挑戰。當各種研究在一系列LLM中對不同的SA任務使用不同的prompt時,挑戰被進一步放大。與prompt相關的固有偏見使采用相同prompt的不同模型的公平對比變得復雜,因為單個prompt可能并不適用于所有模型。

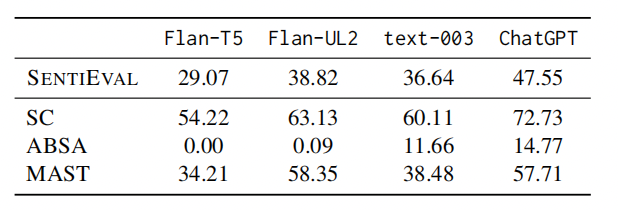

為了緩解上述評估LLM的SA能力時的局限性,本文提出了SENTIEVAL基準,用于在LLM時代進行更好的SA評估,并利用各種LLM模型進行了再評估,結果如圖所示。

總結

這項工作使用LLM對各種SA任務進行了系統評估,有助于更好地了解它們在SA問題中的能力。結果表明,雖然LLM在zero-shot下的簡單任務中表現很好,但它們在處理更復雜的任務時會遇到困難。在few-shot下,LLM始終優于SLM,這表明它們在標注資源稀缺時的潛力。同時還強調了當前評估實踐的局限性,然后引入了SENTIEVAL基準作為一種更全面、更現實的評估工具。

總體而言,大型語言模型為情感分析開辟了新的途徑。雖然一些常規SA任務已經達到了接近人類的表現,但要全面理解人類的情感、觀點和其他主觀感受還有很長的路要走。LLM強大的文本理解能力為LLM時代情感分析探索之路提供了有效的工具和令人興奮的研究方向。

-

模型

+關注

關注

1文章

3486瀏覽量

49989 -

數據集

+關注

關注

4文章

1222瀏覽量

25275 -

ChatGPT

+關注

關注

29文章

1587瀏覽量

8796 -

LLM

+關注

關注

1文章

319瀏覽量

680

原文標題:ChatGPT時代情感分析還存在嗎?一份真實調查

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

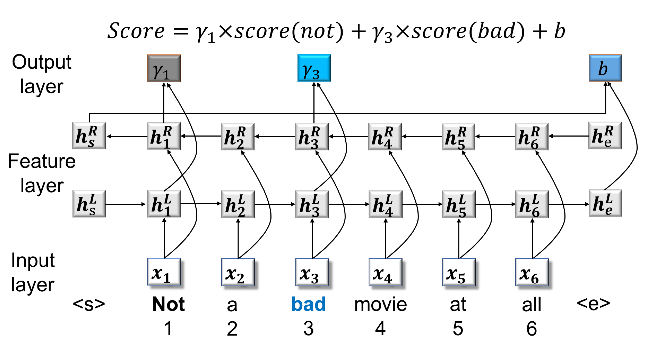

簡單介紹ACL 2020中有關對象級情感分析的三篇文章

LLM在各種情感分析任務中的表現如何

LLM在各種情感分析任務中的表現如何

評論