介紹

大規(guī)模語言模型(LMs)已經(jīng)成為了現(xiàn)在自然語言處理的關(guān)鍵技術(shù),但由于訓(xùn)練語料中常帶有主觀的性別偏見、歧視等,在大模型的使用過程中,它們時常會被放大,因此探測和緩解數(shù)據(jù)中的性別偏見變得越來越重要。

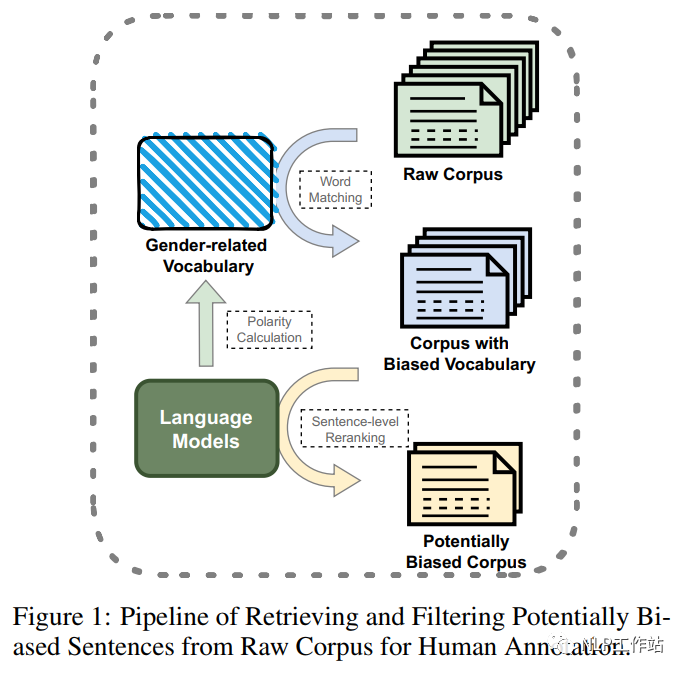

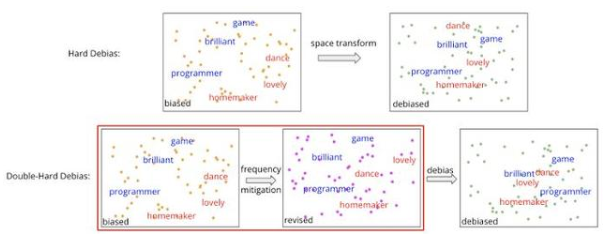

部分研究通過性別交換等自動標(biāo)注方法,緩解性別偏見的語料庫;也有一些人工標(biāo)注的性別偏見語料庫,但主要集中在單詞層面或語法層面的偏見,或只關(guān)注與性別歧視相關(guān)的話題,并主要以英文為主。因此,該論文提出了第一個用于性別偏見探測和緩解的句子級中文語料庫,采用一種自動方法(如圖1所示,對含有性別偏見得分高的詞的樣本進(jìn)行召回,然后根據(jù)其句子級性別偏見概率對樣本進(jìn)行重新排序和過濾),從現(xiàn)有的大規(guī)模中文語料庫中構(gòu)建可能存在性別偏見的句子集,再通過精心設(shè)計(jì)的標(biāo)注方案,對候選數(shù)據(jù)集進(jìn)行進(jìn)一步的標(biāo)注,構(gòu)建可以用于性別偏見檢測、分類和緩解三種任務(wù)的數(shù)據(jù)集。

數(shù)據(jù)構(gòu)建

樣本過濾

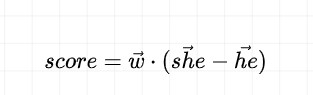

如圖1所示,該研究通過單詞級到句子級的兩階段過濾,從原始語料庫中召回、排序和過濾待標(biāo)注候選數(shù)據(jù)。對于詞級別過濾,通過計(jì)算目標(biāo)詞與種子方向之間得分,構(gòu)建一個高偏見分?jǐn)?shù)的詞表,并從原始語料庫中匹配包含這些詞語的句子,為初步候選集合。其中得分計(jì)算如下:

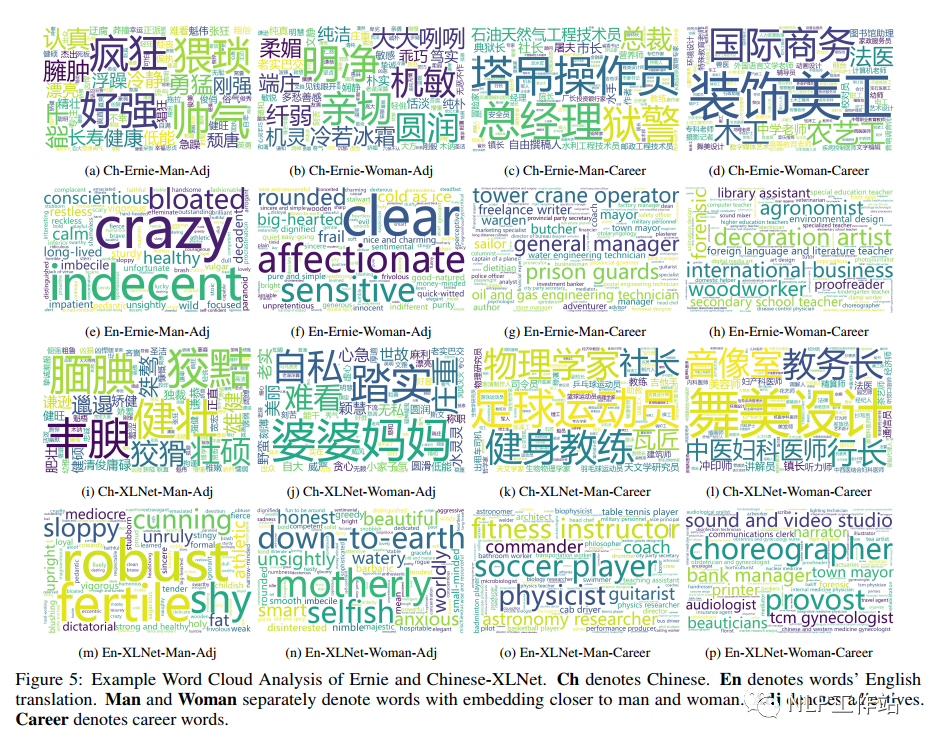

正值表示該詞語更適合女性,負(fù)值表示該詞語更適合男性,性別偏見得分絕對值越高,說明該詞語的偏見程度越高。過濾得到的詞匯繪制的詞云如圖5所示,

對于句子級別過濾,計(jì)算句子的性別偏見得分,并根據(jù)獲得性別偏見關(guān)鍵詞進(jìn)行分組,然后根據(jù)特定的全局閾值性別偏見得分和組內(nèi)閾值排名選擇待標(biāo)注的最終句子集合。

標(biāo)注規(guī)則

標(biāo)注方案為標(biāo)注人員對一個句子進(jìn)行判斷,判斷是否存在性別偏見;如果存在,則需要給出偏見具體類型,并為了緩解性別偏見,還需要對有偏見的句子進(jìn)行糾正,給出無偏見句子。為保證標(biāo)注質(zhì)量,6名標(biāo)注人員均具有學(xué)士學(xué)位,并且男女比例相同。

「偏見類別」共包含3種:

AC:性別刻板的活動和職業(yè)選擇;

DI:性別刻板的描述和概況;

ANB:表達(dá)性別刻板的態(tài)度、規(guī)范和信仰。

緩解性別偏見主要是在保留原始語義信息的同時,減輕所選句子的性別偏見,并要求標(biāo)注者進(jìn)行使句子的表達(dá)式多樣化,主要修改規(guī)則如下:

用中性代詞取代性別代詞;

用語義定義相近的中性描述替換性別特定的形容詞;

對不能直接減輕的句子,添加額外的解釋進(jìn)行中和。

標(biāo)注過程分為兩個階段:第一階段,各標(biāo)注者進(jìn)行標(biāo)注,并要求不要輸入不確定樣本;第二階段,標(biāo)注者之間進(jìn)行交叉標(biāo)注。

語料分析

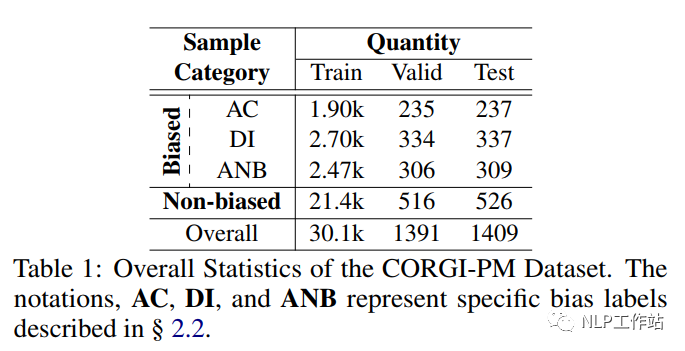

CORGI-PM數(shù)據(jù)統(tǒng)計(jì)如表1所示,共包含32.9k數(shù)據(jù),并考慮數(shù)據(jù)分布,劃分了訓(xùn)練集、驗(yàn)證集及測試集。

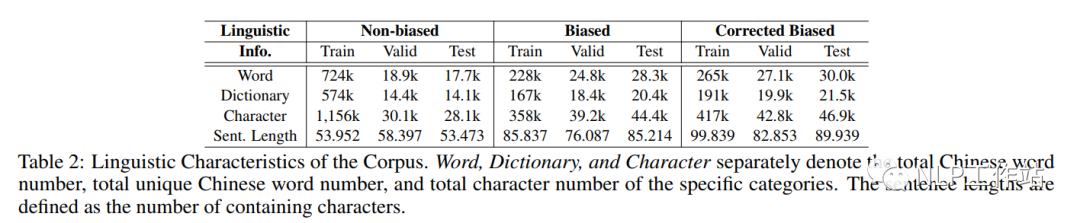

如表2所示,發(fā)現(xiàn)偏見句子相較于無偏見句子來說,句子更長,包含詞匯更少;但由于去偏句子需要在保持原意圖語義不變、句子連貫、減輕偏見,因此去偏樣本與原樣本相比表達(dá)更長、更多樣化。

偏見數(shù)據(jù)格式樣例:

{

'train':{

#原始句子

'ori_sentence':[

sent_0,

sent_1,

...,

],

#偏見類型

'bias_labels':[

[010],

[010],

[010],

...,

],

#人工去偏句子

'edit_sentence':[

edited_sent_0,

edited_sent_1,

...,

],

},

'valid':{

...#與訓(xùn)練集一致

},

'test':{

...#與訓(xùn)練集一致

}

}

無偏見數(shù)據(jù)格式樣例:

{

'train':{

#原始句子

'text':[

sent_0,

sent_1,

...,

],

},

'valid':{

...#與訓(xùn)練集一致

},

'test':{

...#與訓(xùn)練集一致

}

}

實(shí)驗(yàn)結(jié)果

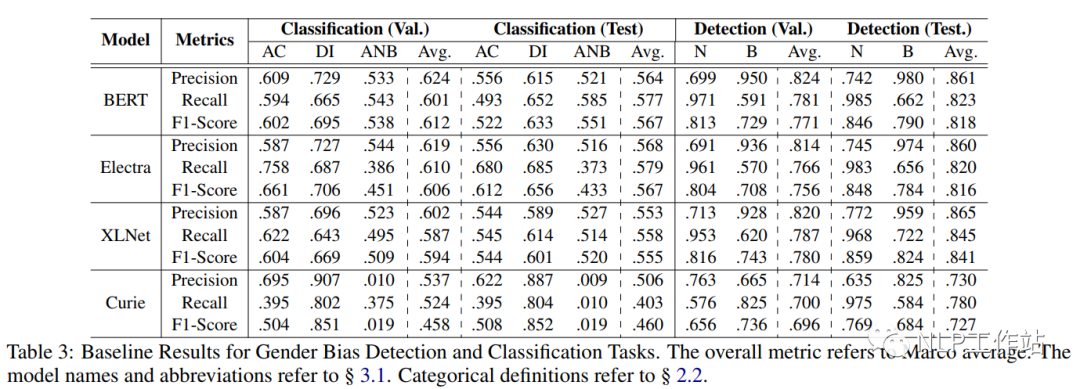

針對性別偏見檢測及分類任務(wù),以Precision、Recall和F1作為評價指標(biāo),采用BERT、Electra和XLNet模型進(jìn)行微調(diào)進(jìn)行實(shí)驗(yàn)對比,并采用GPT-3 Curie模型進(jìn)行zero-shot實(shí)驗(yàn),結(jié)果如表3所示。

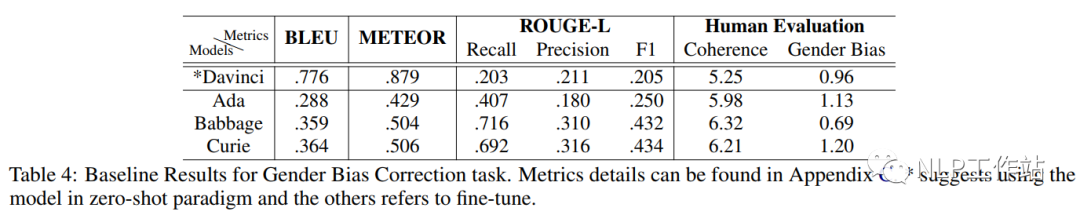

針對性別緩解任務(wù),采用GPT-3 Ada(350M)、Babbage(1.3B)和Curie(6.7B)進(jìn)行微調(diào), 并采用Davinci(175B)進(jìn)行zero-shot實(shí)驗(yàn),結(jié)果如表4所示。

總結(jié)

中文首個性別偏見探索和緩解數(shù)據(jù)集,開源不易,且用且珍惜。

審核編輯:劉清

-

RGB

+關(guān)注

關(guān)注

4文章

803瀏覽量

59589 -

過濾器

+關(guān)注

關(guān)注

1文章

436瀏覽量

20226 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25276

原文標(biāo)題:CORGI-PM:首個中文性別偏見探索和緩解數(shù)據(jù)集

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

那個涉嫌性別歧視被開除的谷歌工程師,到底吐槽了些什么?

本應(yīng)公平公正的 AI,卻從數(shù)據(jù)中學(xué)會了人類的偏見

Spectre和Meltdown的利用漏洞的軟件影響和緩解措施

基于情緒特征用戶性別識別

IBM打造百萬人臉數(shù)據(jù) 意圖減少AI偏見與歧視問題

創(chuàng)新工具和開源軟件如何幫助測量和緩解RF問題

Cloud AI提供免費(fèi)消除性別偏見 將不再標(biāo)識性別

谷歌的AI工具已可以通過人的圖像標(biāo)記來識別個人的性別

AI可能帶有性別偏見?Salesforce提出了減輕AI性別偏見的方法

性別偏見探索和緩解的中文數(shù)據(jù)集-CORGI-PM

性別偏見探索和緩解的中文數(shù)據(jù)集-CORGI-PM

評論