圖像生成領域越來越卷了!

文本到圖像生成是 2022 年最火的 AIGC 方向之一,被《science》評選為 2022 年度十大科學突破。最近,谷歌的一篇文本到圖像生成新論文《Muse: Text-To-Image Generation via Masked Generative Transformers》又引起高度關注。

Muse: Text-To-Image Generation via Masked Generative Transformers

論文地址:https://arxiv.org/abs/2301.00704

項目地址:https://muse-model.github.io/

該研究提出了一種使用掩碼圖像建模方法進行文本到圖像合成的新模型,其中的圖像解碼器架構以來自預訓練和 frozen T5-XXL 大型語言模型 (LLM) 編碼器的嵌入為條件。

與谷歌先前的 Imagen 模型類似,該研究發現基于預訓練 LLM 進行調整對于逼真、高質量的圖像生成至關重要。Muse 模型是建立在 Transformer (Vaswani et al., 2017) 架構之上。

與建立在級聯像素空間(pixel-space)擴散模型上的 Imagen (Saharia et al., 2022) 或 Dall-E2 (Ramesh et al., 2022) 相比,Muse 由于使用了離散 token,效率顯著提升。與 SOTA 自回歸模型 Parti (Yu et al., 2022) 相比,Muse 因使用并行解碼而效率更高。

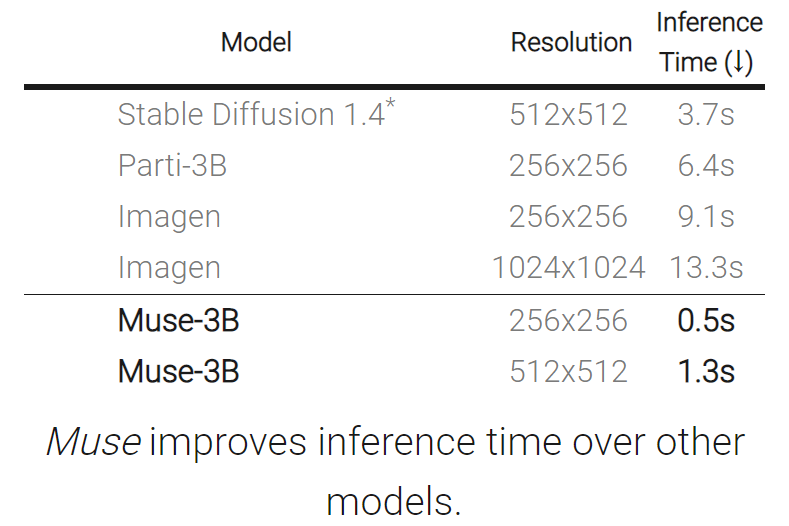

基于在 TPU-v4 上的實驗結果,研究者估計 Muse 在推理速度上比 Imagen-3B 或 Parti-3B 模型快 10 倍以上,比 Stable Diffusion v1.4 (Rombach et al., 2022) 快 2 倍。研究者認為:Muse 比 Stable Diffusion 推理速度更快是因為 Stable Diffusion v1.4 中使用了擴散模型,在推理時明顯需要更多次迭代。

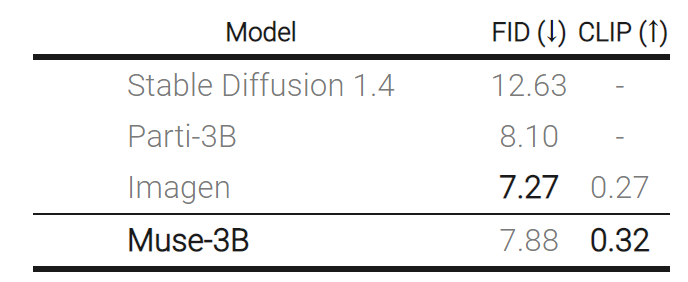

另一方面,Muse 效率的提升沒有造成生成圖像質量下降、模型對輸入文本 prompt 的語義理解能力降低的問題。該研究根據多個標準評估了 Muse 的生成結果,包括 CLIP 評分 (Radford et al., 2021) 和 FID (Heusel et al., 2017)。Muse-3B 模型在 COCO (Lin et al., 2014) 零樣本驗證基準上取得了 0.32 的 CLIP 分數和 7.88 的 FID 分數。

下面我們看看 Muse 生成效果:

文本 - 圖像生成:Muse 模型從文本提示快速生成高質量的圖像(在 TPUv4 上,對于 512x512 分辨率的圖像需要時間為 1.3 秒,生成 256x256 分辨率的圖像需要時間為 0.5 秒)。例如生成「一只熊騎著自行車,一只鳥棲息在車把上」:

Muse 模型通過對文本提示條件下的圖像 token 進行迭代重新采樣,為用戶提供了零樣本、無掩碼編輯(mask-free editing)。

Muse 還提供了基于掩碼的編輯,例如「在美麗的秋葉映照下,有一座涼亭在湖上」。

模型簡介

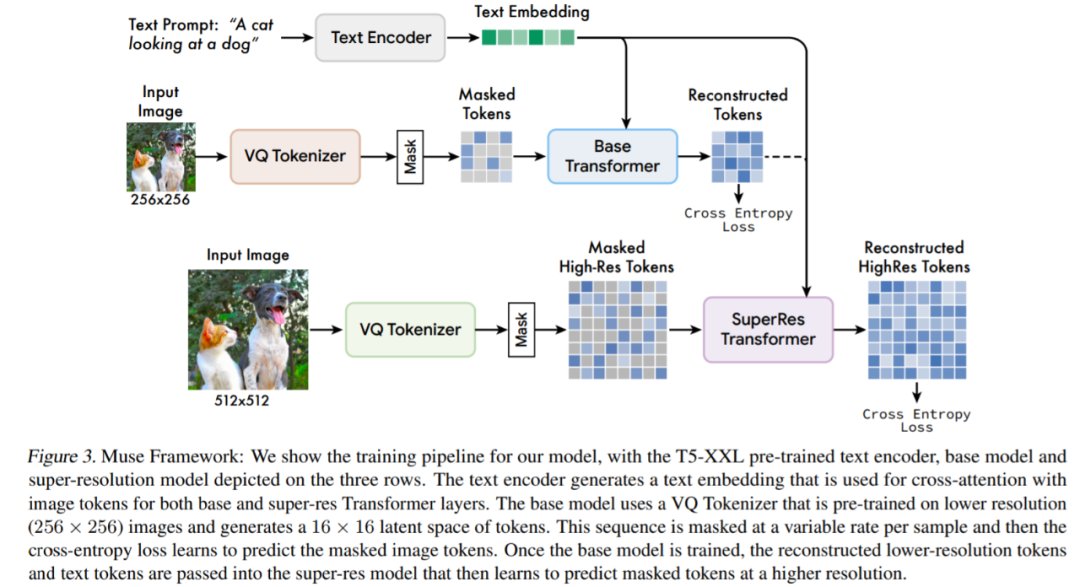

Muse 建立在許多組件之上,圖 3 提供了模型體系架構概述。

具體而言所包含的組件有:

預訓練文本編碼器:該研究發現利用預訓練大型語言模型(LLM)可以提高圖像生成質量。他們假設,Muse 模型學會了將 LLM 嵌入中的豐富視覺和語義概念映射到生成的圖像。給定一個輸入文本字幕,該研究將其通過凍結的 T5-XXL 編碼器,得到一個 4096 維語言嵌入向量序列。這些嵌入向量線性投影到 Transformer 模型。

使用 VQGAN 進行語義 Tokenization:該模型的核心組件是使用從 VQGAN 模型獲得的語義 token。其中,VQGAN 由一個編碼器和一個解碼器組成,一個量化層將輸入圖像映射到一個學習碼本中的 token 序列。該研究全部使用卷積層構建編碼器和解碼器,以支持對不同分辨率圖像進行編碼。

基礎模型:基礎模型是一個掩碼 transformer,其中輸入是投影到 T5 的嵌入和圖像 token。該研究保留所有的文本嵌入(unmasked),隨機掩碼不同比例的圖像 token,并用一個特殊的 [mask] token 替換它們。

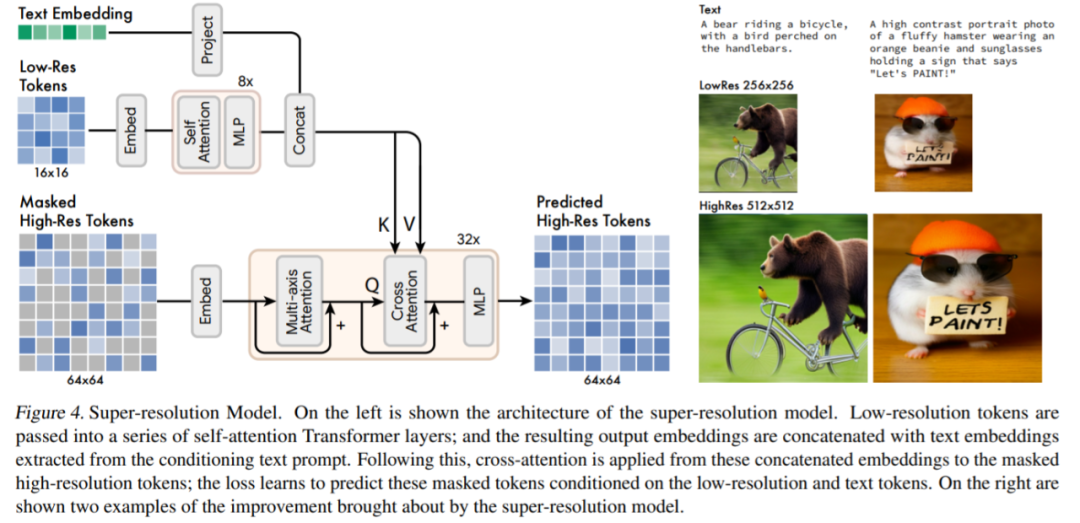

超分辨率模型:該研究發現使用級聯模型是有益的:首先是生成 16 × 16 潛在映射(對應于 256 × 256 圖像)的基礎模型,然后是將基礎的潛在映射上采樣到的超分辨率模型,也就是 64 × 64 的潛在映射(對應于一個 512 × 512 的圖像)。

解碼器微調:為了進一步提高模型生成精細細節的能力,該研究通過添加更多的殘差層和通道來增加 VQGAN 解碼器的容量,同時保持編碼器容量不變。然后微調新的解碼器層,同時凍結 VQGAN 編碼器權重、碼本和 transformer(即基礎模型和超分辨率模型)。

除了以上組件外,Muse 還包含可變掩碼比率組件、在推理時迭代并行解碼組件等。

實驗及結果

如下表所示,與其他模型相比,Muse 縮短了推理時間。

下表為不同模型在 zero-shot COCO 上測量的 FID 和 CLIP 得分:

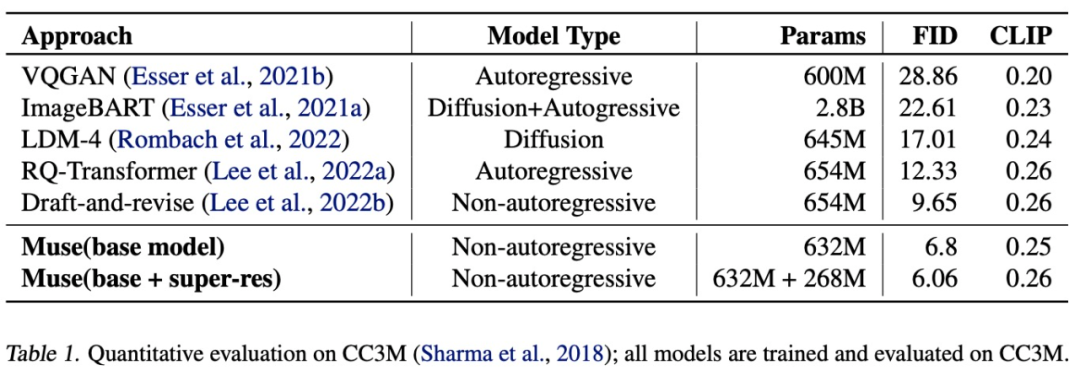

如下表所示,Muse(632M (base)+268M (super-res) 參數模型)在 CC3M 數據集上訓練和評估時得到了 6.06 的 SOTA FID 分數。

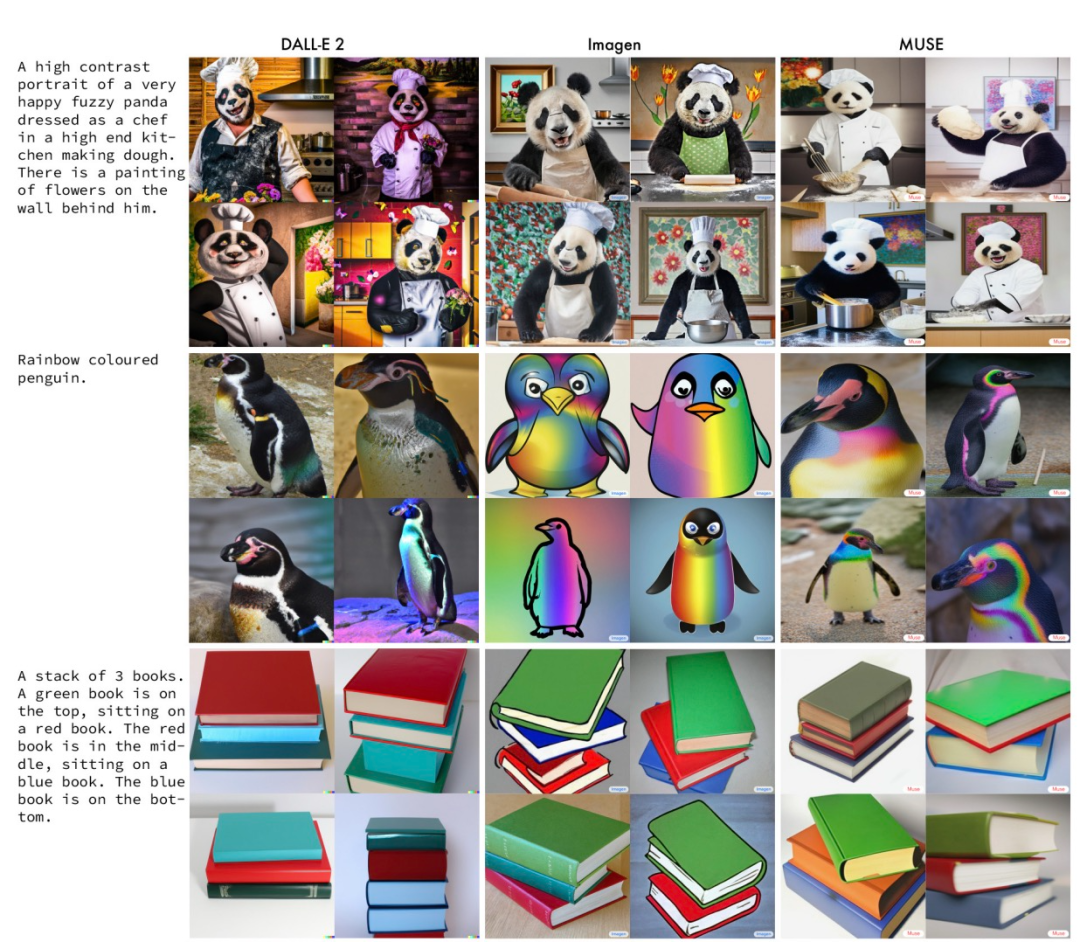

下圖是 Muse 與 Imagen、DALL-E 2 在相同 prompt 下生成結果的例子。

審核編輯 :李倩

-

模型

+關注

關注

1文章

3520瀏覽量

50421 -

圖像生成

+關注

關注

0文章

25瀏覽量

7037 -

Transformer

+關注

關注

0文章

151瀏覽量

6519

原文標題:比Imagen更高效!谷歌新作Muse:通過掩碼生成Transformer進行文本到圖像生成

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

關于鴻蒙App上架中“AI文本生成模塊的資質證明文件”的情況說明

利用NVIDIA 3D引導生成式AI Blueprint控制圖像生成

Gemini API集成Google圖像生成模型Imagen 3

如何使用離線工具od SPSDK生成完整圖像?

使用OpenVINO GenAI和LoRA適配器進行圖像生成

借助谷歌Gemini和Imagen模型生成高質量圖像

谷歌新作Muse:通過掩碼生成Transformer進行文本到圖像生成

谷歌新作Muse:通過掩碼生成Transformer進行文本到圖像生成

評論