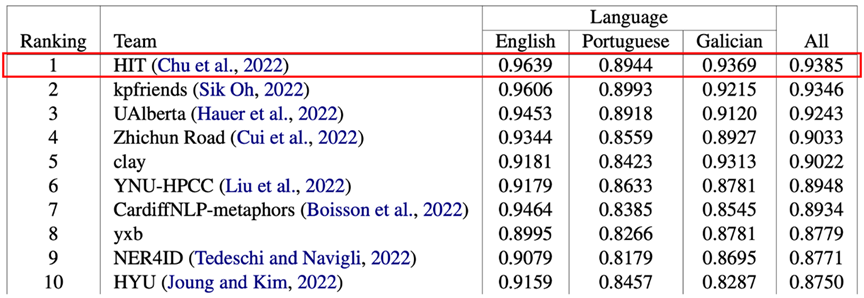

在前不久落下帷幕的第十六屆國際語義評測比賽(The 16th International Workshop on Semantic Evaluation,SemEval 2022)中,哈工大社會計算與信息檢索研究中心(HIT-SCIR)與哈工大訊飛聯(lián)合實驗室的聯(lián)合團隊在多語種慣用語識別任務(wù)子賽道SubtaskA(one-shot)中獲得冠軍。本期我們將對這個任務(wù)的奪冠系統(tǒng)進行簡要介紹,更多具體細節(jié)請參考我們的論文。

論文標題:HITat SemEval-2022 Task 2: Pre-trained Language Model for Idioms Detection

論文作者:初征,楊子清,崔一鳴,陳志剛,劉銘

論文鏈接:http://arxiv.org/abs/2204.06145

任務(wù)介紹

Task 2 Subtask A子賽道是跨語言慣用語檢測任務(wù)。任務(wù)給出多種語言的含多字短語的語句,參賽隊伍需要利用模型判斷目標句子中的多字短語的使用方法是慣用語用法 (Idiomatic)還是字面用法(Literal)。任務(wù)共覆蓋三種語言,包括英語、葡萄牙語和加利西亞語。與普通的慣用語檢測任務(wù)相比,該評測更加強調(diào)考察模型的跨語言遷移能力。在zero-shot設(shè)置下,不提供加利西亞語的訓練數(shù)據(jù),需要模型通過英語和葡萄牙語的數(shù)據(jù)集進行zero-shot遷移;在one-shot下提供少量加利西亞語的訓練數(shù)據(jù),需要模型具備在不同語言之下良好的few-shot遷移能力。

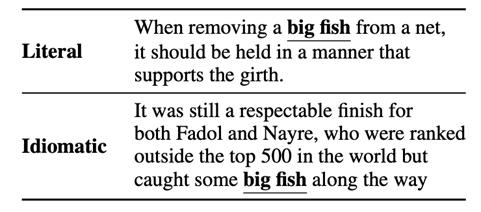

圖1是任務(wù)數(shù)據(jù)示例。在第一句中,big fish為字面義,表示大魚;第二句中,big fish為隱含義(慣用語),表示大人物。模型需要利用訓練數(shù)據(jù)對這兩種用法做出區(qū)分。

圖1:SemEval-2022 Task2 SubtaskA任務(wù)數(shù)據(jù)示例

系統(tǒng)介紹

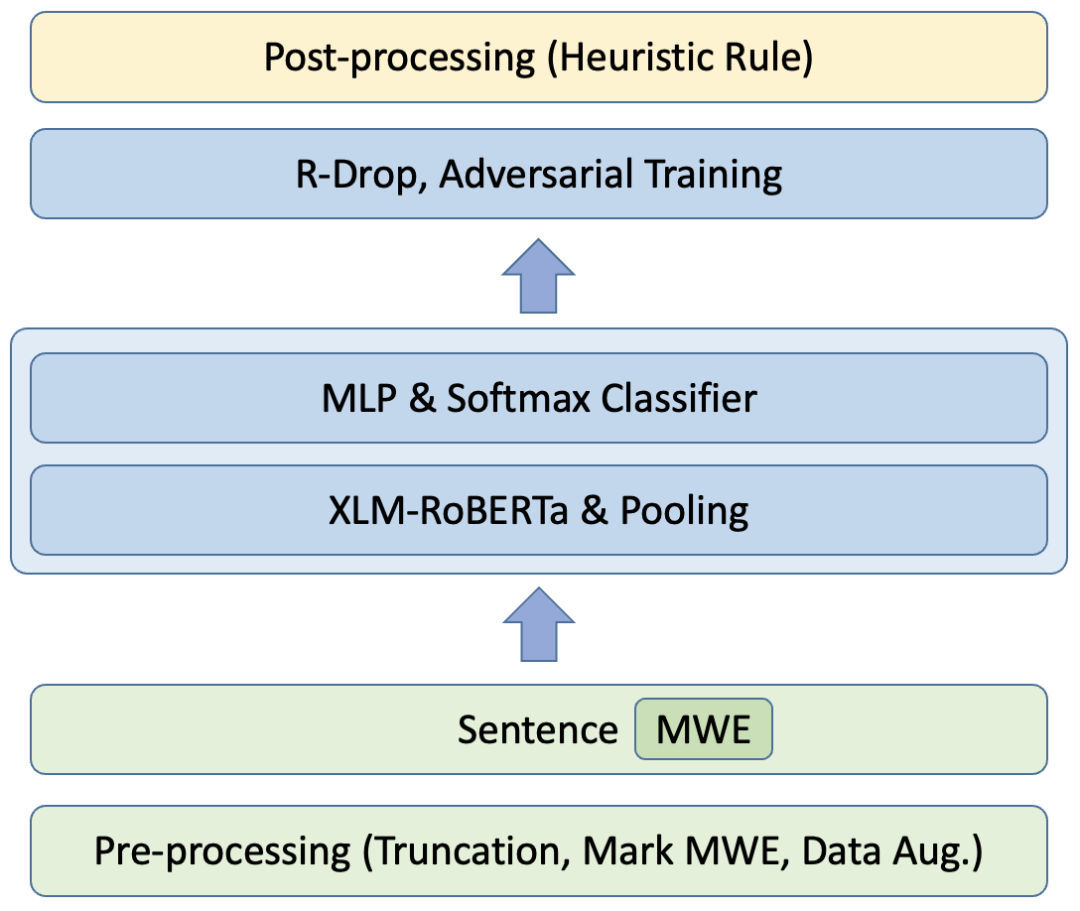

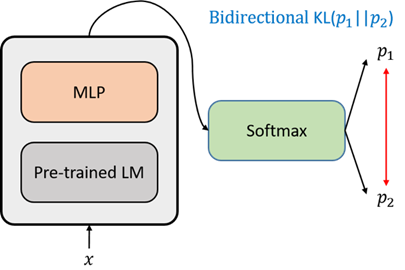

提交的系統(tǒng)使用XLM-RoBERTa作為編碼器,在預(yù)處理過程中對訓練數(shù)據(jù)的慣用語短語(MWE)進行特殊標記,在訓練過程中使用R-Drop作為輔助訓練目標,在訓練結(jié)束后,根據(jù)訓練數(shù)據(jù)的統(tǒng)計信息制定了啟發(fā)式規(guī)則對模型預(yù)測結(jié)果進行校正。此外還嘗試了數(shù)據(jù)增強、對比學習輔助訓練、對抗訓練等方法,整體結(jié)構(gòu)如圖2所示:

1. 預(yù)處理:對輸入的樣本進行截斷、標記MWE、數(shù)據(jù)增強等操作。

2. 模型訓練:采用XLM-R作為基模型,以cross-entropy損失作為主要訓練目標,以R-drop等方式優(yōu)化輔助目標。

3. 后處理:根據(jù)訓練數(shù)據(jù)特征對模型預(yù)測結(jié)果進行校正。

下面將針對部分主要優(yōu)化技巧進行簡要介紹。

圖2:SemEval-2022 Task2 Subtask A 系統(tǒng)結(jié)構(gòu)

1、數(shù)據(jù)預(yù)處理

數(shù)據(jù)截斷:為了盡可能地減少截斷所產(chǎn)生的文本信息丟失,在設(shè)定句子最大長度前對長度信息進行了統(tǒng)計,最終確定使用128作為最大長度可保證絕大多數(shù)句子不被截斷。

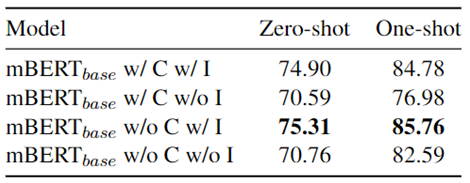

短語標記:任務(wù)的每一條數(shù)據(jù)提供了目標句子中要被預(yù)測的慣用語短語,為了能夠讓模型能夠關(guān)注到慣用語,對句子中的慣用語使用特殊符號進行標記。例如,包含慣用語bigfish的文本 caught some bigfish along the way 將被標記為caught some[SEP] big fish [SEP] along the way。由于預(yù)訓練對于命名實體具有識別能力,而在該任務(wù)的數(shù)據(jù)中,命名實體幾乎都進行首字母大寫變形并且標注為非慣用語用法,在后續(xù)的實驗中改善了慣用語標注方法,僅標注未經(jīng)過變形的慣用語短語。對比實驗結(jié)果如圖3所示,I表示標記慣用語,C表示使用上下文文本。對比w/ I 和 w/o I的實驗,可驗證這一改動能夠提高性能效果。

上下文信息:此外,我們還發(fā)現(xiàn),不使用任務(wù)提供的額外上下文文本數(shù)據(jù),而僅使用包含慣用語的句子(w/o C),能取得更優(yōu)的效果,如圖3第三行所示。原因可能為不包含上下文文本數(shù)據(jù)的短文本能使模型更聚焦于待判別的慣用短語。

圖3: 上下文以及標注慣用語對結(jié)果的影響

2、模型訓練

訓練過程使用XLM-RoBERTa作為編碼器,接池化層和softmax分類器。對不同池化方法進行了實驗,結(jié)果表明池化方法對最終結(jié)果沒有顯著影響,為了簡便,使用[SEP]作為句子向量表示。訓練過程中嘗試了多種輔助手段,包括R-Drop、對抗訓練、數(shù)據(jù)增強、對比學習輔助目標等。實驗結(jié)果表明,R-Drop以及對抗訓練能夠顯著提高模型表現(xiàn),并且相較于對抗訓練,R-Drop能夠取得更大的性能提升,結(jié)果詳見下一節(jié)。

圖4:R-Drop示意圖

3、后處理

在訓練結(jié)束后,根據(jù)訓練數(shù)據(jù)的分布統(tǒng)計信息制定了啟發(fā)式規(guī)則。對于在訓練集中僅出現(xiàn)過一次的短語,因缺乏不同標簽對應(yīng)的訓練數(shù)據(jù),我們采用訓練集中僅出現(xiàn)過的標簽作為預(yù)測標簽,以減少訓練集的人工標記偏差對結(jié)果的影響。

實驗結(jié)果

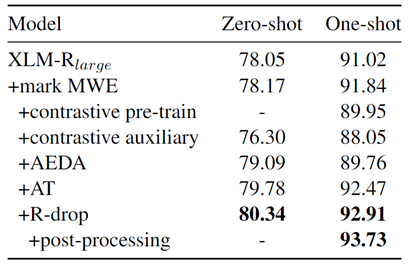

模型的最終效果及消融實驗如圖5所示。

圖5:不同方法對結(jié)果的影響

標記MWE(mark MWE)可以同時提升zero-shot和one-shot效果;我們還嘗試了對比學習方法,然而在zero-shot和one-shot上均沒有提升;AEDA是一個簡單的操作標點符號的數(shù)據(jù)增強策略,對zero-shot有一定幫助;在兩種提升模型穩(wěn)定性的方法(對抗訓練和R-drop)中,R-drop有更好的表現(xiàn)。最后,后處理策略對訓練集中出現(xiàn)的偏差做了很好的校正。顯著地提升了效果。

多語種慣用語識別任務(wù)子賽道Subtask A(one-shot)最終榜單:HIT-SCIR與HFL聯(lián)合團隊排名第一

結(jié)論

基于多語言預(yù)訓練模型,我們構(gòu)建了一個多語言慣用語識別系統(tǒng)。通過對輸入格式、模型訓練方式、預(yù)測結(jié)果后處理等方面的優(yōu)化,最終系統(tǒng)整體性能較baseline有較為顯著的提升,并在one-shot賽道上取得最優(yōu)成績。在后續(xù)研究中,可嘗試探索如何讓預(yù)訓練模型利用訓練數(shù)據(jù)之外的語料,如慣用語詞典等,以進一步提升預(yù)測效果,并降低對標注數(shù)據(jù)資源的需求,發(fā)揮多語言模型的zero-shot能力。

審核編輯 :李倩

-

編碼器

+關(guān)注

關(guān)注

45文章

3777瀏覽量

137203 -

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

7242瀏覽量

91047

原文標題:競賽 | SemEval 2022: 多語種慣用語識別評測冠軍系統(tǒng)簡介

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

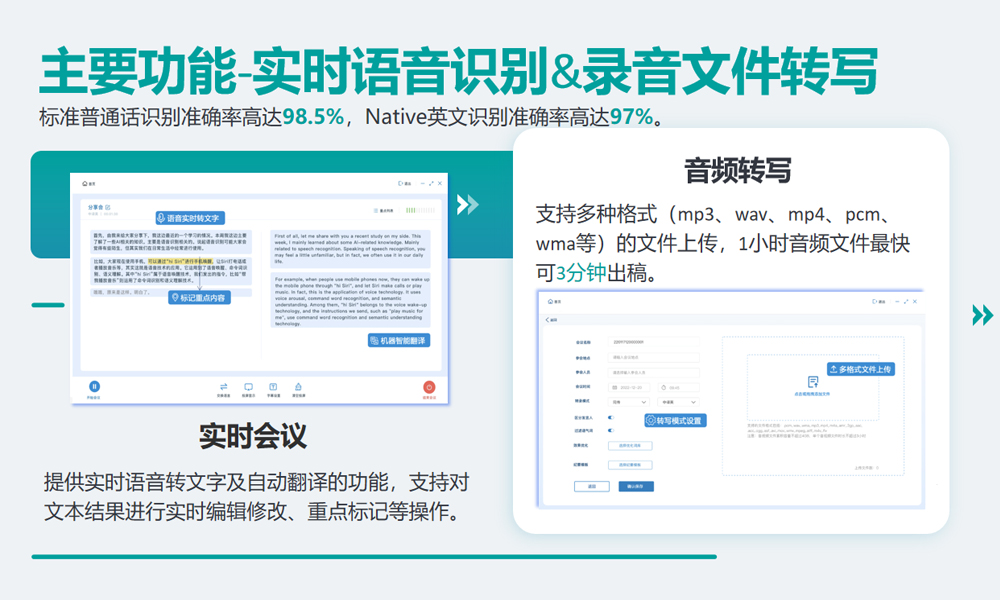

普強信息入選2024語音識別技術(shù)公司TOP30榜單

聲智科技出席G20青年企業(yè)家聯(lián)盟走進海淀活動

ASR與傳統(tǒng)語音識別的區(qū)別

訊維智能語音轉(zhuǎn)寫系統(tǒng):開啟智能會議記錄新篇章!

訊維智能語音轉(zhuǎn)寫系統(tǒng)核心優(yōu)勢大解析!

冠軍說|第二屆OpenHarmony競賽訓練營冠軍團隊專訪

ChatGPT 的多語言支持特點

HarmonyOS NEXT應(yīng)用元服務(wù)開發(fā)多語種場景

HarmonyOS NEXT應(yīng)用元服務(wù)開發(fā)多語種場景

智能自行車碼表:基于2605C語音芯片的創(chuàng)新開發(fā)方案

思必馳AI多語種技術(shù)助力中國企業(yè)加快全球布局

訊維智能語音轉(zhuǎn)寫系統(tǒng)確保企業(yè)數(shù)據(jù)的安全性

科大訊飛榮獲2023年度國家科學技術(shù)進步獎一等獎

有效提升智能會議系統(tǒng)語音識別準確性案例分享

有效提升智能會議系統(tǒng)語音識別準確性案例分享

SemEval 2022: 多語種慣用語識別評測冠軍系統(tǒng)簡介

SemEval 2022: 多語種慣用語識別評測冠軍系統(tǒng)簡介

評論