數據中心正在等待一場升級。

新基建正在以我們肉眼可見的速度穩步推進,不難想象的是,隨著5G的發展和應用,數據中心將會迎來一次新的發展契機,但更多的則是來自各方面的挑戰。大規模的連接和海量的數據會推動數據中心規模和設備密度的進一步加劇,而視頻、直播等新興應用的普及也會使得數據中心的負載越來越多樣和復雜,硬件在提高密度的同時也必須具備更大的靈活性。從IDC最新的統計和預測可以看到,全球數據圈會在2018年的32ZB增長到2025年的175ZB,如此海量數據的增長自然需要更多的計算能力進行運算和處理。

全球數據圈將會大幅增長

海量數據當道,數據中心節能減耗迫在眉睫

除了更高的設備密度,數據中心要面臨的另一個問題則來自于能耗方面。隨著邊緣計算、大數據、人工智能等新技術的發展,數據中心需要更高性能的服務器滿足業務的發展需要。但根據摩爾定律的發展,芯片的升級也帶來了芯片溫度的提高,給服務器那顆滾燙的“芯”降溫成為了亟待解決的問題。更低能耗的數據中心,不僅關系到了環境的可持續發展,也決定了算力的成本和服務的競爭力。

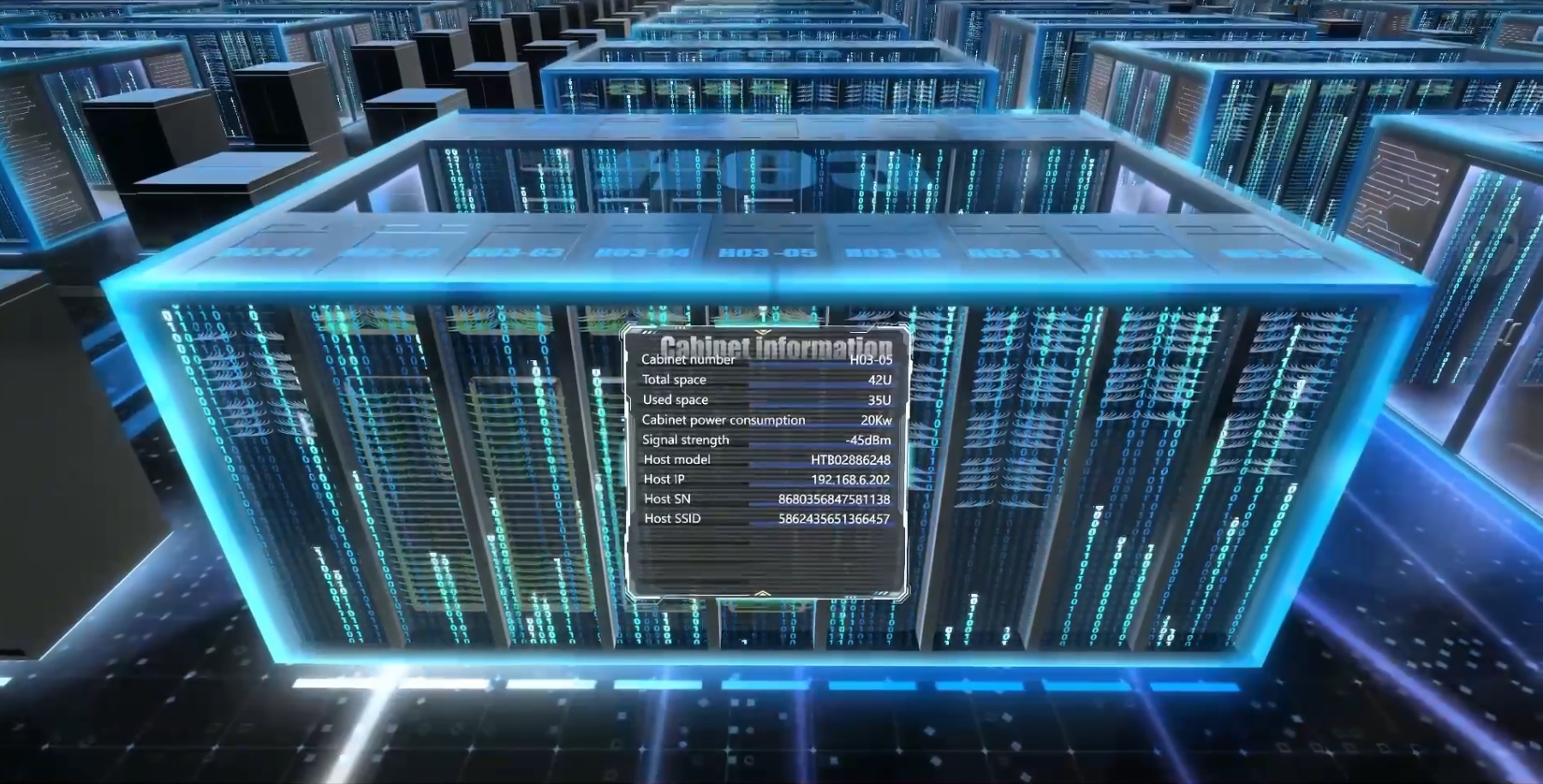

在今年的OCPChinaDay峰會上,英特爾數據中心平臺事業部首席工程師高級平臺架構師龔海峰示,邊緣數據中心的發展速度十分之快,與大型數據中心不同的是,容量相對較小,只有十幾個機柜,也并不采用頂級元器件的邊緣數據中心,工作環境要更加惡劣,既要解決高密度的計算問題,又要解決能效的問題,簡言之,數據中心需要具備更高的可靠性,更低的成本和功耗。

全國也在出臺相應的政策,以上海為例,上海最近發布了新建數據中心PUE嚴格控制在1.3以下,可以預見的是,如果放任不管,無論是對環境的污染還是對能源的浪費都是很嚴重的,無論是國家還是各個地方政府,對未來的大規模數據中心的建設都會嚴格控制。

數據中心早期并沒有專用的精密空調,也沒有統一的標準,最早的時候用的甚至還是民用大功率空調,到上世紀70年代,機房專用精密空調出現,可以有效保障數據中心的恒溫恒濕環境,而除塵方面采用新風系統和機房正壓除塵,從而滿足數據中心保持適度恒定,良好的空氣潔凈度、具備遠程監控等要求。但在當下的市場環境里,風冷則面臨著很多窘境,拋去能耗升高的問題不談,風冷失效率上升的因素包含溫度、振動、粉塵、潮濕等,而這些因素也會同時造成硬盤、主板、內存等元器件的故障,進而影響到整個數據中心的可靠性。

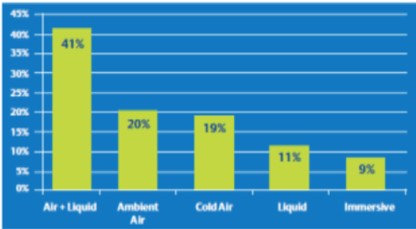

根據第三方數據公司統計,到2025年,常見的自然風冷技術會得到廣泛使用,風冷+液冷混合的分散方案會成為主流,浸沒式液冷的方案也會得到大量應用。

未來冷卻技術使用比例預測

風冷未央,液冷已至,“老”技術仍待升級

從年齡上看,液冷技術也是十多歲的大齡技術了,但發展比較緩慢,究其原因還是落地、部署及運行的過程中存在不少問題,以浸沒式液冷為例,之前鮮有互聯網數據中心大規模進行部署,首先是液冷的可靠性,如果可靠性不能達到和風冷一個級別,那使用液冷就變得毫無意義。再就是由于介質的改變,元器件是否能在液體中可以長期穩定的工作,液體的導電性如何,很多諸如此類的問題,最后就是運維的挑戰,密度變高之后,重量也會增加,維護也會更難。

“阿里云從2015年開始對比了不同的冷卻架構,包括空氣冷卻,冷板液冷,我們從不同的維度進行總結和對比。從空氣冷卻到冷板液冷,從各個方面進行對比,我們實踐中不同的嘗試著驗證迭代,我們總結出一些對比可以看到,浸沒液冷是數據中心的一個躍遷式的技術創新,具有高可靠、高可用的特點。”阿里云基礎設施服務器研發架構師鐘楊帆說道。

要實現綠色數據中心,首先要解決的是電子元器件產品方面的問題,英特爾對CPU的路線圖,其產品策略就是在制造風冷產品的同時,也大力發展支持液冷的產品,同時英特爾對四種液冷方式都在做產品開發,以適應未來液冷普及的需求。而阿里巴巴則從2016年開始嘗試大規模部署液冷技術,今年在杭州建成了全球規模最大的浸沒液冷數據中心,這也是全中國首個綠色數據中心。相比傳統的數據中心,阿里云這一個數據中心每年可以節省至少上千萬的電。

阿里巴巴綠色數據中心實踐

相比傳統的風冷,浸沒式液冷幾乎不依賴任何氣象條件,可以在高溫、高濕、甚至在腐蝕性極強的環境中進行,此外噪音也比較小,對于運維人員來講也是十分大的改善。但到了具體的使用場景,首先要考慮產品對業務性能的要求,在根據業務性能要求選擇元器件,再根據業務的算力選擇CPU或者元器件的型號后,根據對應的TDP選擇液冷或者風冷。除此之外,機房的基礎設施、機柜的功率密度、可靠性的要求、PUE的要求,機房占地面積等要求都對采取的冷卻方式有所影響。

機房冷卻技術的發展將在很大程度上推動著數據中心的發展,隨著計算存儲網絡以及各種應用的加速,這種設備的虛擬性能的要求對散熱提出了更高的挑戰,如何幫助數據中心達到節能綠色環保的要求,對液冷這個面世雖早,但仍然具有很大發展潛力的技術而言,也需要更多的實踐探索。

責任編輯:pj

-

數據中心

+關注

關注

16文章

5226瀏覽量

73499 -

人工智能

+關注

關注

1806文章

49008瀏覽量

249289 -

大數據

+關注

關注

64文章

8960瀏覽量

140156

發布評論請先 登錄

數據中心液冷技術和風冷技術的比較

適用于數據中心和AI時代的800G網絡

優化800G數據中心:高速線纜、有源光纜和光纖跳線解決方案

光通信在數據中心的應用

亞馬遜云科技發布全新數據中心組件

如何選擇數據中心服務

海量數據當道,數據中心節能減耗迫在眉睫

海量數據當道,數據中心節能減耗迫在眉睫

評論