最新一期《ACM通訊》發(fā)表專欄文章,以深度神經網絡研究起起伏伏的歷史為例,提醒人們“將研究視為一場漫長的競賽,才有可能獲得真正的突破”。

最新一期《ACM通訊》發(fā)表專欄文章,以深度神經網絡從備受懷疑,到2018年Geoffrey Hinton、Yoshua Bengio和Yann LeCun獲得圖靈獎的一段漫長歷史為例,提醒人們“將研究視為一場漫長的競賽,才有可能獲得真正的突破”。

本文作者Moshe Y. Vardi是以色列著名數(shù)學家和計算機科學家,美國萊斯大學計算機科學教授、Ken Kennedy信息技術研究所所長。

Moshe Y. Vardi

Yann LeCun也在Twitter上推薦了這篇文章:

研究是一場漫長的競賽,耐心和耐力都是必要的

位于加州帕洛阿爾托的未來研究所(IFTF)是一家美國智庫。它成立于1968年,是蘭德公司(RAND Corporation)的一個分支機構,旨在幫助企業(yè)規(guī)劃長遠的未來。

羅伊·阿瑪拉(Roy Amara)從1971年至1990年擔任IFTF主席,他于2007年去世。阿瑪拉最著名的是創(chuàng)造了關于技術效果的阿瑪拉定律(Amara's Law):“人們總是高估一項科技所帶來的短期效益,卻又低估它的長期影響。”Gartner的“技術炒作周期”最能說明這一規(guī)律,它的特征是“過高期望的峰值”,接著是“泡沫化的低谷期”,然后是“穩(wěn)步爬升的光明期”,最后是“實質生產的高原期”。

當我聽說2018年圖靈獎被授予Yoshua Bengio、Geoffrey Hinton和Yann LeCun,以表彰他們“在概念和工程上的突破,使深度神經網絡成為計算的關鍵組成部分”時,我不禁想起阿瑪拉定律。這個決定并不十分令人驚訝。畢竟,很難想象還有什么其他計算技術在過去十年中有如此引人注目的表現(xiàn)和影響。引用圖靈獎的公告:“近年來,深度學習方法一直是計算機視覺、語音識別、自然語言處理和機器人技術等應用領域取得驚人突破的重要原因。”

但是,為了將這一貢獻置于適當?shù)臍v史背景中,有必要反思神經網絡的悠久歷史。1943年,神經生理學家沃倫·麥卡洛克(Warren McCulloch)和年輕的數(shù)學家沃爾特·皮茨(Walter Pitts)寫了一篇關于大腦神經元如何工作的論文。他們用電路模擬了一個簡單的神經網絡。1958年,康奈爾大學的神經生物學家弗蘭克·羅森布拉特(Frank Rosenblatt)發(fā)明了感知器(Perceptron),一個單層的神經網絡。《紐約時報》報道稱,感知器是“一臺電子計算機的雛形,(海軍)希望它能夠走路、說話、看、寫、自我復制,并意識到自己的存在。”不幸的是,感知器是非常有限的,這在Marvin Minsky和Seymour Papert 1969年的著作“Perceptrons”中得到了證明。炒作達到頂峰后,隨之而來的是幻滅的低谷。這個所謂的“第一個AI冬天”,除其他外,還體現(xiàn)在AI研究經費的下降上,一直持續(xù)到上世紀80年代初。

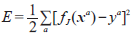

1982年,加州理工學院的約翰·霍普菲爾德(John Hopfield)發(fā)表了一篇論文(Neural networks and physical systems with emergent collective computational abilities,被稱為Hopfield Network),其重點不是建模大腦,而是創(chuàng)造有用的設備。他用清晰的數(shù)學方法,展示了這樣的網絡是如何工作的,以及它們能做什么。大約在同一時間,美國-日本合作在日本京都舉行“合作/競爭神經網絡聯(lián)合會議”。隨后,日本宣布“第五代項目”。美國期刊刊登了這篇報道,引發(fā)了人們對美國可能會落后的擔憂。不久,資金再次流入。神經信息處理系統(tǒng)大會(NIPS)于1987年召開。然而,炒作的新高峰之后,又一次出現(xiàn)了幻滅的低谷。再次引用圖靈獎的公告:“到21世紀初,LeCun、Hinton和Bengio是堅持這種方法的一小群人中的成員。”事實上,他們重新點燃AI社區(qū)對神經網絡興趣的努力最初遭到了質疑。這種幻滅導致了“第二個AI冬天”,一直持續(xù)到上世紀90年代。

直到本世紀初,改進的算法、改進的硬件(GPU),以及非常大的數(shù)據(jù)集(ImageNet有1400萬多個標記圖像)結合起來,達成了令人印象深刻的突破。并且很明顯,很深(很多層的)機器視覺神經網絡有顯著在效率和速度方面具有顯著的優(yōu)勢。Hinton和他的同事們的想法帶來了重大的技術進步,他們的方法現(xiàn)在已經該領域的主導范式,并因此獲得了2018年圖靈獎。

這個故事的寓意是,研究是一場漫長的競賽;耐心和耐力都是必要的。然而,我記得上世紀90年代初,在一個工業(yè)研究實驗室舉行的一次研究評估會議上,有人在數(shù)據(jù)挖掘方面的開創(chuàng)性工作沒有得到認可,因為“他已經做了兩年了,現(xiàn)在還不清楚這項工作是否會有什么進展。”我與普林斯頓大學高級研究院創(chuàng)始人Abraham Flexner有著同樣的擔憂;在1939年發(fā)表的《論無用知識的有用性》(The Usefulness of Useless Knowledge)一文中,F(xiàn)lexner探討了一種危險的傾向,即為了所謂的實用主義而放棄純粹的好奇心。

成功的研究沒有單一的公式。有時候,把注意力集中在眼前的問題上是有意義的,但是,通常情況下,將研究視為一場漫長的競賽,才可以獲得戲劇性的突破。

-

神經網絡

+關注

關注

42文章

4814瀏覽量

103533 -

AI

+關注

關注

88文章

35065瀏覽量

279340

原文標題:LeCun推薦:警惕炒作周期,神經網絡研究是一場漫長的競賽

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

無刷電機小波神經網絡轉子位置檢測方法的研究

神經網絡RAS在異步電機轉速估計中的仿真研究

NVIDIA實現(xiàn)神經網絡渲染技術的突破性增強功能

BP神經網絡與卷積神經網絡的比較

什么是BP神經網絡的反向傳播算法

BP神經網絡與深度學習的關系

神經網絡理論研究的物理學思想介紹

人工神經網絡的原理和多種神經網絡架構方法

卷積神經網絡與傳統(tǒng)神經網絡的比較

RNN模型與傳統(tǒng)神經網絡的區(qū)別

LSTM神經網絡的結構與工作機制

Moku人工神經網絡101

將神經網絡研究視為一場漫長的競賽,才有可能獲得真正的突破

將神經網絡研究視為一場漫長的競賽,才有可能獲得真正的突破

評論