2016,VR元年,oculus、HTC、索尼等這樣的重量級廠商紛紛推出或宣布了自己的消費級硬件產品來搶占消費者市場,相信廣大VR愛好者們中的很多人都已經入手了一款虛擬現實設備。在這些硬件當中,Oculus Rift CV1(以下簡稱“CV1”)無疑是最受人矚目的硬件產品之一,畢竟它有2014年拿了Facebook20億美金這樣的大事件撐腰。

眾所周知,Oculus Rift采用的是主動式光學定位技術,那它到底是如何實現的呢?

(via:nukethefridge.com)

基本實現流程:

Oculus Rift設備上會隱藏著一些紅外燈(即為標記點),這些紅外燈可以向外發射紅外光,并用紅外攝像機實時拍攝。獲得紅外圖像后,將攝像機采集到的圖像傳輸到計算單元中,通過視覺算法過濾掉無用的信息,從而獲得紅外燈的所在方向,再利用PnP算法,即利用四個不共面的紅外燈在設備上的位置信息、四個點獲得的圖像信息即可最終將設備納入攝像頭坐標系,擬合出設備的三維模型,并以此來實時監控玩家的頭部、手部運動。

注:具體可看如下圖,注意上面這些紅色的小點點。

接下來我將向大家介紹一下我的推理過程,以及算法的一些細節。

| 頭顯上的LED燈

前文中我提到我們需要利用四個不共面的紅外燈在設備上的位置信息來進行定位,而如果想要知道不同的紅外燈在設備上的位置信息,就必須能夠區分不同的紅外燈。

為什么這么說呢,如果不區分紅外燈,那么當DK2(注:特指頭顯)在空間中運動時,攝像機捕捉到光點后,要進行關聯(姿態最優匹配的過程)的次數 會非常大,舉個列子:

1) 如果有N預測圖像點和M 《= N觀察圖像點,則有N!/(N-M)!可能的關聯

2) 對于N = 40和M = 20(對DK2 LED的數量),有3.3×1029的關聯,所以就算是計算機,也無法快速地得到結果。

很顯然,DK2一定是采用了某種先驗的方式區分光點。那么問題來了,DK2到底是如何區分的呢?

我曾看到有文章中猜測說DK2是通過LED燈的亮滅來區分的,實際上卻并非如此。因為雖然通過LED燈的亮滅來區分比較簡單,因為亮滅最容易區分出來,但是這種方法有個缺陷,就是無法區分是姿態改變導致的LED燈被遮擋,還是LED燈本身就熄滅了,所以,DK2沒有使用這個方法,而是采用LED燈光信息的強弱來實現的。我們來觀察用灰度攝像機拍攝的圖:

對比上面兩圖,可以發現亮斑的大小有變化。可以看出紅色部分,在圖2時光斑更大,藍色則相反。接下里我們看詳細的做法。這里必須說一下,在推測具體的做法過程中,我曾誤以為DK2直接判斷光斑大小,然后根據多幀圖像的規律來判斷LED燈的ID,但實際上DK2是使用差分法來判斷光斑大小。我在這里簡單給大家介紹一下我的推理過程。

首先我用自己的攝像機拍攝了大量照片進行觀察后發現如果把攝像機用60HZ左右頻率拍攝,圖像每10張就會開始重復。

我先給光點編個號,如下圖:

比如,2號點的可以用肉眼識別的強弱順序:弱,弱,強,強,弱,強,弱,弱,弱,強。

那么是不是這樣呢?如何在DK2中表示這些強弱關系呢?

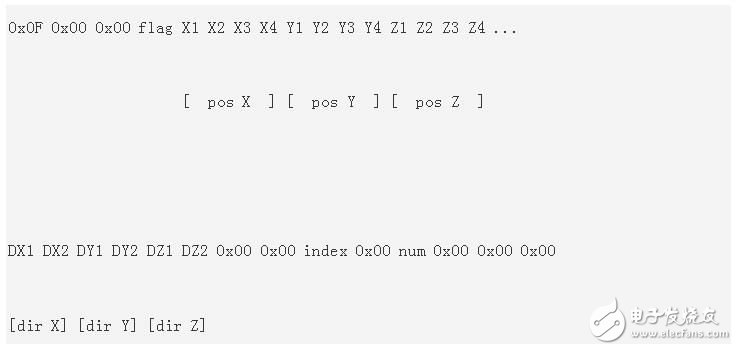

首先,已知SDK的windows的driver會發送一個開始信息,讓頭顯開始運作;

緊接著,這個driver就會不斷接收到下面信息:

X1 X2 X3 X4 是1個32位數,是圖像分析后得到的空間坐標(原理后面給大家解釋),DX則不知道干什么用,但是觀察上面的num,換算出來是40,index從1開始,不斷遞增到40,說明DK2在一個一個的識別LED燈,另外,這些信息每17ms左右發上來一次,和60HZ的拍攝頻率差不多,基本上可以認定是利用每10幀確定一個LED的方式。

為了完全確定這一點,還必須確定另一個問題:同步。

如果真的是LED通過10幀不同的變化來讓攝像機確定LED燈的ID,那么必須要同步。

這要求一個同步信號能同時傳給攝像機和頭顯,如果能了解同步的時機,就知道到底是不是60HZ的頻率了。

可是當我看了MT9V034的資料后發現居然拍攝的頻率是30HZ左右,不過細想一下,如果使用差分檢測發,使用30HZ這個頻率也能拍攝出光強的變化。也就是說,DK2根本不是直接判斷光斑是大還是小,而是將當前幀的光斑與上一幀同一個光斑做對比,如果比之前大,則為大,反之則為小。那么當一個新的幀到達時,該算法首先提取幀的亮像素斑點,如下圖。忽略少于10個像素或不是圓盤狀的,最后確保所有的斑點來自前一幀中提取的大圓盤狀斑點,然后進行對比。

所以,DK2將當前幀的光斑與上一幀同一個光斑做對比,然后根據10幀不同的變化來讓攝像機確定LED燈的ID。

我在進一步查看這些點和位置信息的對應關系后,總結出DK2判斷強弱變化的依據是:

1) 如果當前幀的斑點比上一幀斑點大10%,就是0;

2) 如果當前幀的斑點比上一幀斑點小10%,就是1;

3) 否則忽略。

這樣的設計非常好,防止了LED燈受到隨機干擾。

不過在實際驗證中,發現如果這樣提取圖像,在頭顯運動時,還是會有錯誤出現(比如漏拍了幾幀), 那么它是如何判別的呢?這個花了我不少時間去想,最后發現這和漢明距離有關系。

所謂漢明距離,簡單地說:如果數字是相同的,它們的漢明距離為0,如果他們在單一的比特不同,它們的距離為1,如果10比特它們彼此逐位否定,它們的漢明距離是10。我發現,DK2已經默認每個拍攝后的圖像(提取40個LED燈表示的比特位)和前一幀最多的漢明距離是 3,如果大于這個數字,則認為是錯誤幀。

最后,給出幾個比較有特點的LED的10幀圖,大家可以看一下:

| 感知姿態

前面談了如何探測LED燈,我介紹了DK2的攝像機通過視頻流捕獲LED燈獨特的閃爍模式,拼出10位二進制數來識別ID。

現在來談如何感知姿態,你可能會很自然地想到,通過每10幀來識別LED,然后利用已知LED的位置來判斷姿態。說實話,這個方法也可以,但是這就表示要間隔10個幀才能識別一次姿態,萬一動作快一點,就出現麻煩了。

當然,要估計一個三維模型的姿態,需要足夠的LED的信息,如果拍攝到的LED點不夠,就必須使用DK2中的IMU來進行姿態的感知。另外,IMU本身也會累計誤差。

DK2的算法其實是這樣的:

1) 初始狀態,先讀取靜止狀態的頭顯,10幀的時間,識別每個LED的ID號;

2) 不斷地拍攝,利用前面幀的信息,推測出現在的LED燈的位置;

3) 如果出現錯誤,就重新通過10幀的時間識別LED;

4) 如果有足夠的LED燈信息,就使用識別算法;

5) 如果沒有足夠的LED燈的信息,就使用IMU識別姿態;

三維姿態估計或已知物體相對于2D照相機的角度,求出該物體在相機坐標系的坐標值,稱為PNP問題。在Oculus Rift中,感知頭顯的姿態是利用PnP算法,融合IMU實現的。Oculus Rift沒有單純的采用IMU進行姿態解算是因為IMU本身會產生漂移,無法在長時間內跟蹤對象的絕對位置,因此必須外接3D參照系,PnP正可以提供這樣一個參照系。說白了,就是要利用PnP來糾正IMU,最后融合成一組比較合理的姿態信息。

那么,什么是PnP算法?

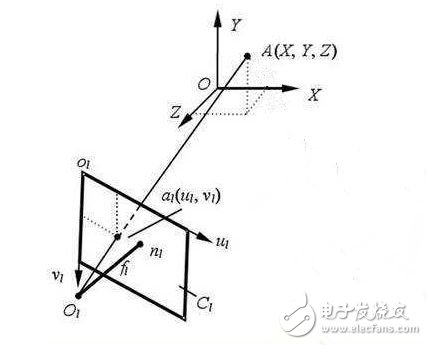

3D姿態估計是一個多維非線性優化問題,攝像機拍攝圖像中的一組2D點,例如提取的LED斑點的集合,可以嘗試重建相對于相機的坐標模型的未知位置(X,Y,Z)和方向(偏航,俯仰,滾動)。

說詳細一點,在相機內參數巳知的情況,由特征點與其像點的對應關系求解目標相對于相機的位姿,就是經典的PnP 問題,這些算法大致可分為迭代算法和非迭代算法兩類。

非迭代算法采用代數方法直接求出相對位姿,針對P3P 、P4P等問題推導出多種解析算法,該類算法具有運算量小、計算速度快等優點,但受誤差影響大且精度不高。Lepetit 提出的一種計算量為O(n)的PnP問題非迭代算法,只需要4個點的信息就可以求解目標相對于相機的姿態信息, Oculus Rift正是利用這種算法實現的。

最后再向大家總結說明一下感知姿態的基本步驟:

1、發出同步信號,等待LED燈亮起后,提取收到的8位灰度視頻幀明亮的斑點。

2、創造一種斑點顏色為亮綠色的8位RGB輸出視頻幀(用于調試/可視化的目的)。

3、匹配大致圓盤形的斑點,并與來自先前幀中的斑點進行比較,比較它們的尺寸差異到差分位解碼器中,累積其10位ID和LED關聯。排序所有提取或投射二維LED的位置到一個kd樹,用在下一幀中快速匹配。

4、如果有四個或更多的識別斑點且沒有當前姿勢估計,運行從頭計算姿態估計方法。

5、如果有四個或多個識別的斑點,且已經識別了先前幀的姿態,采用迭代姿態估計方法。

6、用姿態信息糾正IMU的漂移,并融合IMU的姿態信息。

以上介紹了Oculus Rift的實現過程。

Oculus Rift的主動式紅外光學+IMU定位系統精度較高,抗遮擋性強。

由于其所用的攝像機具備很高的拍攝速率,并且該類系統總是能夠得到標記點在當前空間的絕對位置坐標,所以不存在累積誤差。但是由于攝像頭視角有限,因此該產品的可用范圍有限,會在很大程度上限制使用者的適用范圍,因而無法使用Oculus Rift來玩需要走動等大范圍活動的虛擬現實游戲。也因此,雖然Oculus Rift可以支持多個目標物同時定位,但是目標物不可過多,一般不超過兩個。

電子發燒友App

電子發燒友App

評論