完善資料讓更多小伙伴認識你,還能領(lǐng)取20積分哦,立即完善>

標簽 > transformer

文章:142個 瀏覽:6517次 帖子:3個

如何應對邊緣設(shè)備上部署GenAI的挑戰(zhàn)

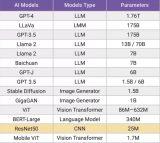

過去十年間,人工智能(AI)和機器學習(ML)領(lǐng)域發(fā)生了巨大的變化。卷積神經(jīng)網(wǎng)絡(luò)(CNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)逐漸被Transformer和生成式人...

SparseViT:以非語義為中心、參數(shù)高效的稀疏化視覺Transformer

? 背景簡介 隨著圖像編輯工具和圖像生成技術(shù)的快速發(fā)展,圖像處理變得非常方便。然而圖像在經(jīng)過處理后不可避免的會留下偽影(操作痕跡),這些偽影可分為語義和...

2025-01-15 標簽:圖像IMLTransformer 458 0

2022年,我們打賭說transformer會統(tǒng)治世界。 我們花了兩年時間打造Sohu,這是世界上第一個用于transformer(ChatGPT中的“...

2025-01-06 標簽:芯片asicTransformer 1153 0

Transformer是機器人技術(shù)的基礎(chǔ)嗎

生成式預訓練Transformer(GPT)被吹捧為將徹底改變機器人技術(shù)。但實際應用中,GPT需要龐大且昂貴的計算資源、冗長的訓練時間以及(通常)非機載...

2024-12-05 標簽:機器人TransformerLLM 670 0

自動駕駛中一直說的BEV+Transformer到底是個啥?

在很多車企的自動駕駛介紹中,都會聽到一個關(guān)鍵技術(shù),那就是BEV+Transformer,那BEV+Transformer到底是個啥?為什么很多車企在自動...

2024-11-07 標簽:自動駕駛Transformer 1373 0

英偉達推出歸一化Transformer,革命性提升LLM訓練速度

英偉達團隊近日在AI領(lǐng)域投下了一枚震撼彈,他們提出了一種全新的神經(jīng)網(wǎng)絡(luò)架構(gòu)——歸一化Transformer(nGPT)。這一創(chuàng)新架構(gòu)基于超球面(hype...

2024-10-23 標簽:神經(jīng)網(wǎng)絡(luò)英偉達Transformer 873 0

電子發(fā)燒友網(wǎng)報道(文/周凱揚)近日,一家由哈佛輟學生成立的初創(chuàng)公司Etched,宣布了他們在打造的一款“專用”AI芯片Sohu。據(jù)其聲稱該芯片的速度將是...

2024-07-01 標簽:TransformerAI芯片 2106 0

Adobe提出DMV3D:3D生成只需30秒!讓文本、圖像都動起來的新方法!

因此,本文研究者的目標是實現(xiàn)快速、逼真和通用的 3D 生成。為此,他們提出了 DMV3D。DMV3D 是一種全新的單階段的全類別擴散模型,能直接根據(jù)模型...

2024-01-30 標簽:編碼器3DTransformer 1630 0

大語言模型背后的Transformer,與CNN和RNN有何不同

? 電子發(fā)燒友網(wǎng)報道(文/李彎彎)近年來,隨著大語言模型的不斷出圈,Transformer這一概念也走進了大眾視野。Transformer是一種非常流行...

2023-12-25 標簽:cnnTransformerrnn 5404 0

如何在手持設(shè)備上安裝龐大的transformer網(wǎng)絡(luò)

Siri和OK Google是最早實現(xiàn)語音控制的應用程序,這著實為我們帶來了很多樂趣;但很快我們便意識到,必須仔細說出請求才能獲得實用回答。 就現(xiàn)在所見...

2023-10-11 標簽:網(wǎng)絡(luò)手持設(shè)備應用程序 1065 0

Quadric是一家機器學習推理IP公司,Untether AI則將其硬件宣傳為是“通用推理加速器”,這兩家公司都在兜售可處理transformer的技...

2023-08-30 標簽:機器學習深度學習Transformer 1217 0

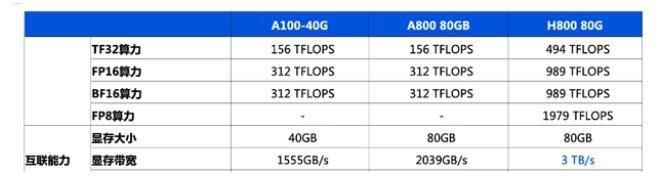

英偉達h800和h100的區(qū)別 其實大白話就是,A100、H100是原版,特供中國市場的減配版是A800、H800。A100、H100是價格更便宜,性能...

2023-08-08 標簽:英偉達TransformerAI芯片 5.4萬 0

首個線性注意力Transformer大模型!1750億參數(shù),速度和精度更優(yōu)

即便如此,傳統(tǒng)的 Transformer 依然存在局限。首要的一點,它們有著對于序列長度的二次時間復雜度,這會限制它們的可擴展性并拖累訓練和推理階段的計...

2023-07-31 標簽:線性語言模型Transformer 1450 0

在X3派上玩轉(zhuǎn)一億參數(shù)量超大Transformer,DIY專屬你的離線語音識別

Transformer模型在自然語言領(lǐng)域被提出后,目前已經(jīng)擴展到了計算機視覺、語音等諸多領(lǐng)域。然而,雖然Transformer模型在語音識別領(lǐng)域有著更好...

視海芯圖Transformer加速SoC助力AR/VR設(shè)備性能升級

5月12日,第十三屆松山湖中國IC創(chuàng)新高峰論壇在廣東東莞松山湖凱酒店舉行,本屆活動繼續(xù)由中國半導體行業(yè)協(xié)會IC設(shè)計分會(ICCAD)、芯原微電子、松山湖...

2023-05-12 標簽:ArTransformer視海芯圖 3730 0

ConvNeXt 架構(gòu)的出現(xiàn)使傳統(tǒng)的 ConvNet 更加現(xiàn)代化,證明了純卷積模型也可以適應模型和數(shù)據(jù)集的規(guī)模變化。然而,要想對神經(jīng)網(wǎng)絡(luò)架構(gòu)的設(shè)計空間進...

2023-01-12 標簽:解碼器編碼器Transformer 1522 0

然而,transformer的原始公式在輸入令牌(token)數(shù)量方面具有二次計算復雜度。鑒于這個數(shù)字通常從圖像分類的14^2到圖像去噪的128^2 =...

2023-01-10 標簽:編碼Transformer自然語言處理 1779 0

換一批

換一批

編輯推薦廠商產(chǎn)品技術(shù)軟件/工具OS/語言教程專題

| 電機控制 | DSP | 氮化鎵 | 功率放大器 | ChatGPT | 自動駕駛 | TI | 瑞薩電子 |

| BLDC | PLC | 碳化硅 | 二極管 | OpenAI | 元宇宙 | 安森美 | ADI |

| 無刷電機 | FOC | IGBT | 逆變器 | 文心一言 | 5G | 英飛凌 | 羅姆 |

| 直流電機 | PID | MOSFET | 傳感器 | 人工智能 | 物聯(lián)網(wǎng) | NXP | 賽靈思 |

| 步進電機 | SPWM | 充電樁 | IPM | 機器視覺 | 無人機 | 三菱電機 | ST |

| 伺服電機 | SVPWM | 光伏發(fā)電 | UPS | AR | 智能電網(wǎng) | 國民技術(shù) | Microchip |

| Arduino | BeagleBone | 樹莓派 | STM32 | MSP430 | EFM32 | ARM mbed | EDA |

| 示波器 | LPC | imx8 | PSoC | Altium Designer | Allegro | Mentor | Pads |

| OrCAD | Cadence | AutoCAD | 華秋DFM | Keil | MATLAB | MPLAB | Quartus |

| C++ | Java | Python | JavaScript | node.js | RISC-V | verilog | Tensorflow |

| Android | iOS | linux | RTOS | FreeRTOS | LiteOS | RT-THread | uCOS |

| DuerOS | Brillo | Windows11 | HarmonyOS |