美滿電子科技(Marvell)今天宣布,中國(guó)搜索引擎巨頭百度在全球首次商用的ARM架構(gòu)服務(wù)器中,采用了Marvell公司的 ARM芯片組。作為世界范圍內(nèi)首家商用ARM服務(wù)器的公司,百度引領(lǐng)并開啟了具有更低能耗和更高性能的全新“綠色數(shù)據(jù)中心”的新時(shí)代。

2013-02-26 11:04:02 1372

1372 Machine Learning SDK 相集成以供預(yù)覽。客戶可以使用 Azure 大規(guī)模部署的英特爾? FPGA(現(xiàn)場(chǎng)可編程邏輯門陣列)技術(shù),為其模型提供行業(yè)領(lǐng)先的人工智能 (AI) 推理性能。

2018-05-16 17:25:03 6184

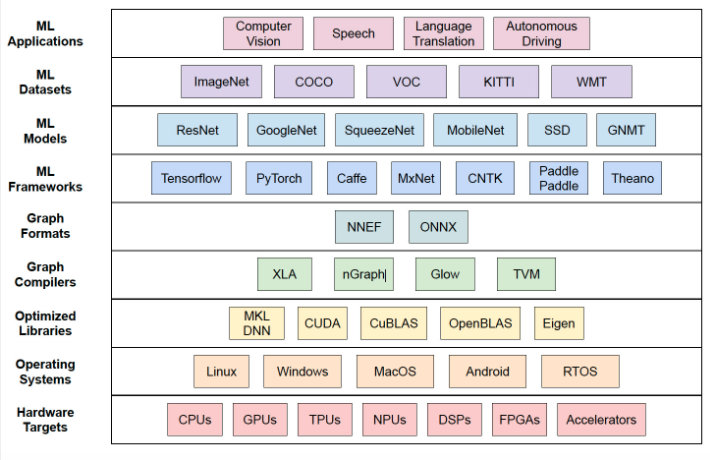

6184 Nvidia不太可能很快放棄目前在AI培訓(xùn)處理器市場(chǎng)上的領(lǐng)先優(yōu)勢(shì),特別是考慮到它也在該領(lǐng)域投入巨資。雖然服務(wù)器推理處理器市場(chǎng)競(jìng)爭(zhēng)更加激烈,但英特爾可能會(huì)成為與Nvidia和Xilinx一樣強(qiáng)大的玩家。

2019-03-18 21:07:10 7659

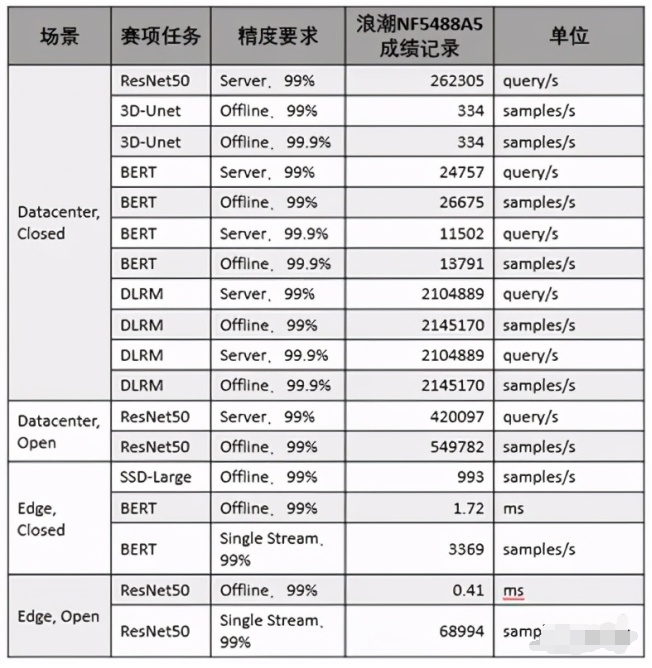

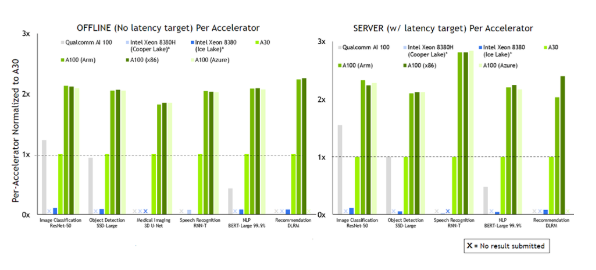

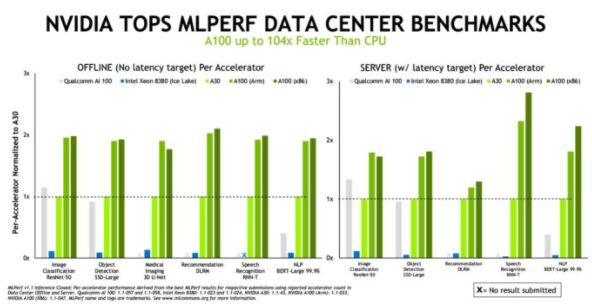

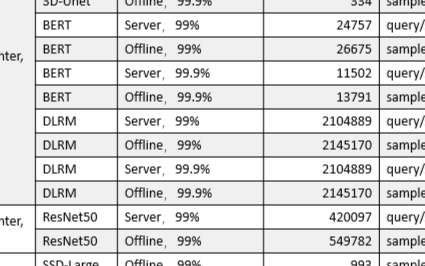

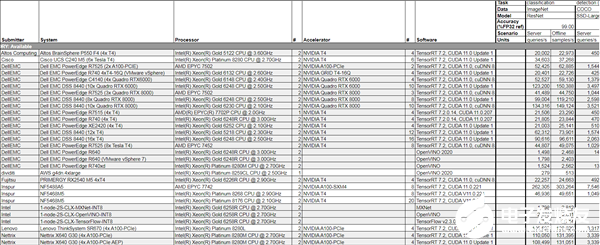

7659 不久前,AI性能基準(zhǔn)評(píng)測(cè)平臺(tái)MLPerf公布了2022年首次推理(Inference v2.0)測(cè)試成績(jī),NVIDIA的AI平臺(tái)表現(xiàn)依然搶眼。

2022-04-15 22:12:00 2738

2738

NVIDIA Turing GPU和Xavier 芯片系統(tǒng)在首個(gè)獨(dú)立AI推理基準(zhǔn)測(cè)試 ——MLPerf Inference 0.5中取得第一名。

2019-11-08 16:53:29 5054

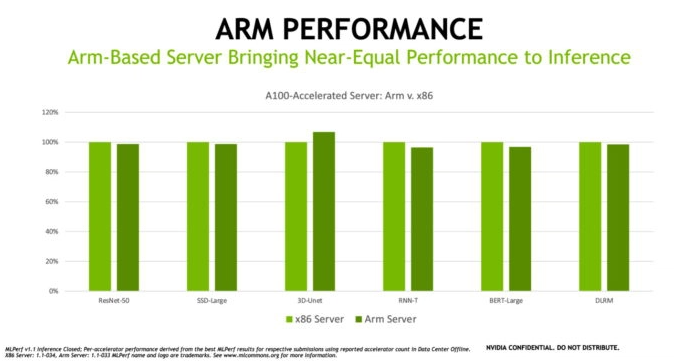

5054 NVIDIA與Arm、Ampere、Cray、富士通、HPE、Marvell攜手構(gòu)建GPU加速服務(wù)器,以滿足從超大規(guī)模云到邊緣、從模擬到AI、從高性能存儲(chǔ)到百萬(wàn)兆級(jí)超級(jí)計(jì)算等多樣化需求。

2019-11-20 09:38:42 1384

1384 NVIDIA憑借A100進(jìn)一步擴(kuò)大了在MLPerf基準(zhǔn)測(cè)試中的領(lǐng)先優(yōu)勢(shì),實(shí)現(xiàn)了比CPU快237倍的AI推理性能,助力企業(yè)將AI研究轉(zhuǎn)化為生產(chǎn)力。

2020-10-22 14:07:58 714

714 寧暢工程師介紹,參加MLPerf Inference(推理)基準(zhǔn)測(cè)試的X640 G30 AI服務(wù)器,最高可支持10張NVIDIA A100 PCIe卡或21張NVIDIA T4 PCIe卡,堪稱“性能猛獸”。

2020-10-23 10:48:37 644

644 arm9linux系統(tǒng)平臺(tái):最近查ARM9上可以用的輕型WEB服務(wù)器 ,有BOA, HTTPD , THTTPD 等等,支持資源比較好的 是BOA ,但這種實(shí)現(xiàn)方式需要接入互聯(lián)網(wǎng),而且還可能集成

2022-10-28 10:53:39

和數(shù)據(jù)吞吐量進(jìn)行優(yōu)化的服務(wù)器和數(shù)據(jù)中心人工智能和機(jī)器學(xué)習(xí) (ML) 的需求。否則,人工智能所需的成本、電力和碳將開始超過(guò)收益。NVIDIA 率先使用 GPU 來(lái)提高數(shù)據(jù)中心中 HPC 和 AI 的性能

2022-03-29 14:40:21

:具有 AWS Graviton3 處理器的 c7g.4xlarge 實(shí)例集群和具有 AWS Graviton2 處理器的 c6g.4xlarge 實(shí)例集群實(shí)現(xiàn)的 Resnet-50 v1.5 實(shí)時(shí)推理性能

2022-08-31 15:03:46

Cortex 三兄弟里最追求性能的了,但畢竟不是面向服務(wù)器平臺(tái)的產(chǎn)品,不能放寬功耗限制去飆性能。于是,在Graviton 公開之前一個(gè)月,Arm 發(fā)布了面向云計(jì)算和邊緣基礎(chǔ)設(shè)施的 Neoverse

2022-09-08 14:32:42

的方式之一。作為通用的系統(tǒng)架構(gòu),Arm64服務(wù)器在多種數(shù)據(jù)中心應(yīng)用場(chǎng)景都具有獨(dú)特優(yōu)勢(shì),如存儲(chǔ),大數(shù)據(jù)分析,高性能計(jì)算,物聯(lián)網(wǎng)的邊緣計(jì)算,Android應(yīng)用,容器微服務(wù)等等。Arm64服務(wù)器基于開放的芯片

2018-06-03 13:20:30

首個(gè)獨(dú)立AI推理基準(zhǔn)測(cè)試 ——MLPerf Inference 0.5中取得第一名。由于推理一直是AI市場(chǎng)中最大、同時(shí)也是最具競(jìng)爭(zhēng)力的領(lǐng)域,業(yè)內(nèi)此前一直希望能夠有一套客觀的推理性能測(cè)試指標(biāo)。在參與

2019-11-08 19:44:51

擁有ARM而不僅僅是獲得ARM的許可,Nvidia可以添加特殊的指令來(lái)與其GPU建立更緊密的集成。為了獲得最高性能,需要將CPU和GPU集成在一個(gè)芯片上,并且由于英特爾正在開發(fā)其競(jìng)爭(zhēng)的Xe系列加速器

2020-09-07 09:49:42

客戶在其環(huán)境中擁有nVidia Licensing服務(wù)器(vSphere Enterprise Plus和Horizo??n 7)。許可證文件在nVidia企業(yè)門戶中生成,并且許可證服務(wù)器中安裝了2

2018-09-20 11:41:44

arm9linux系統(tǒng)平臺(tái):最近查ARM9上可以用的輕型WEB服務(wù)器 ,有BOA, HTTPD , THTTPD 等等,支持資源比較好的 是BOA ,但這種實(shí)現(xiàn)方式需要接入互聯(lián)網(wǎng),而且還可能集成

2022-07-22 14:10:59

現(xiàn)在的進(jìn)展并不快,因?yàn)槔蠝y(cè)試集里面用例數(shù)量龐大。目前,老測(cè)試集中的用例數(shù)量還遠(yuǎn)遠(yuǎn)大于新測(cè)試集。問(wèn)題大量的集成測(cè)試用例為性能研究提供了方便。筆者通過(guò)比較同一測(cè)試集在arm64和x86服務(wù)器上運(yùn)行的耗時(shí)來(lái)

2022-07-12 15:48:13

服務(wù),讓傳感器和相關(guān)的控制設(shè)備接入,為此,本期blog將向大家介紹如何使用gevent高性能的并發(fā)處理庫(kù)在draognbaord 410c上來(lái)實(shí)現(xiàn)一個(gè)高性能的TCP服務(wù)器。gevent是基于協(xié)程

2018-09-25 15:53:03

的示例是在 Arm 上運(yùn)行 ML 推理的 Linux 應(yīng)用程序。我們之前已經(jīng)在MNIST 數(shù)據(jù)集上訓(xùn)練了一個(gè)神經(jīng)網(wǎng)絡(luò) 來(lái)識(shí)別手寫數(shù)字。使用Arm NN和 Streamline,我們希望了解我們模型

2022-09-27 14:24:27

就不能勝任的話,一臺(tái)價(jià)值幾萬(wàn),甚至幾十萬(wàn)的服務(wù)器在短時(shí)間內(nèi)就要遭到淘汰,這是任何企業(yè)都無(wú)法承受的。為了保持可擴(kuò)展性,通常需要在服務(wù)器上具備一定的可擴(kuò)展空間和冗余件(如磁盤陣列架位、PCI和內(nèi)存條插槽位

2014-08-02 10:42:26

請(qǐng)問(wèn)一下,關(guān)于 ESP8266 模塊在使用 AT 固件的情況下,如何通過(guò)域名取得服務(wù)器的IP地址和端口號(hào)的問(wèn)題?

2023-03-08 06:36:51

請(qǐng)問(wèn)一下,關(guān)于 ESP8266 模塊在使用 AT 固件的情況下,如何通過(guò)域名取得服務(wù)器的IP地址和端口號(hào)的問(wèn)題?

2023-03-09 06:21:51

Part 1 OpenPPL ARM Server 簡(jiǎn)介OpenPPL Arm Server 定義? 針對(duì)高性能 ARM 架構(gòu)服務(wù)器處理器優(yōu)化的深度學(xué)習(xí)推理引擎? 目前支持 FP32 及 FP16

2022-03-31 11:51:33

服務(wù)器。 MARS3500系列,就是基于RK3588、RK3588S的高密度ARM陣列服務(wù)器,可廣泛應(yīng)用于云手機(jī)、云手游、云VR、云電視、云渲染、邊緣計(jì)算、移動(dòng)辦公、網(wǎng)絡(luò)輿情監(jiān)測(cè)等領(lǐng)域

2022-07-18 17:54:32

,這在滿足個(gè)性化需求和增強(qiáng)服務(wù)器安全

性上具有優(yōu)勢(shì)。

Linux服務(wù)器還具有出色的性能和穩(wěn)定性。相比之下,Windows服務(wù)器在性能和穩(wěn)定性方面稍有不足。特別是在處理高負(fù)載和

大數(shù)據(jù)量的情況下

2024-02-22 15:46:15

、穩(wěn)定的異構(gòu)計(jì)算云基礎(chǔ)設(shè)施資源。異構(gòu)計(jì)算GN5規(guī)格族實(shí)例性能展現(xiàn)相信有了阿里云GPU云服務(wù)器的助力,人工智能企業(yè)和AI生態(tài)一定會(huì)取得更多更快的發(fā)展。

2017-12-26 11:22:09

`現(xiàn)如今,隨著云計(jì)算技術(shù)的發(fā)展,現(xiàn)在很多企業(yè)都紛紛選擇云服務(wù)器,正是因?yàn)檫@種方式可以有效降低企業(yè)的成本,而且從性能上來(lái)說(shuō),也是遠(yuǎn)遠(yuǎn)超于傳統(tǒng)服務(wù)器的,使用也十分的方便。然而,還有一些朋友擔(dān)心云服務(wù)器

2021-03-27 14:31:18

自身的優(yōu)勢(shì),支持企業(yè)業(yè)務(wù)在彈性擴(kuò)展能力上的高要求,具有高可用性,滿足企業(yè)對(duì)數(shù)據(jù)進(jìn)行快速恢復(fù)需求。云服務(wù)器能夠滿足企業(yè)在電子商務(wù)、企業(yè)網(wǎng)站、OA系統(tǒng)、企業(yè)ERP/CRM管理軟件、論壇和SNS等等各種需求

2018-07-31 18:35:28

、內(nèi)存、系統(tǒng)總線等,和通用的計(jì)算機(jī)架構(gòu)類似。由于服務(wù)器需要提供高可靠的服務(wù),所以在處理能力、穩(wěn)定性、可靠性、安全性、可擴(kuò)展性、可管理性等方面要求較高。服務(wù)器和電腦功能都是一樣的,也可以將服務(wù)器稱之為電腦,只是服務(wù)器對(duì)穩(wěn)定性與安全性以及處理器數(shù)據(jù)能力有更高要求。比如我們隨時(shí)瀏覽一個(gè)網(wǎng)站,發(fā)現(xiàn)這個(gè)網(wǎng)站

2021-07-16 07:35:04

的是要知道它提供的選項(xiàng)來(lái)提高推理性能。作為開發(fā)人員,您會(huì)尋找可以壓縮的每一毫秒,尤其是在需要實(shí)現(xiàn)實(shí)時(shí)推理時(shí)。讓我們看一下Arm NN中可用的優(yōu)化選項(xiàng)之一,并通過(guò)一些實(shí)際示例評(píng)估它可能產(chǎn)生

2022-04-11 17:33:06

1.臭皮匠服務(wù)器機(jī)房分布:國(guó)內(nèi):福州,湖州,臺(tái)州,鎮(zhèn)江,貴州等地國(guó)外:美國(guó),新加坡等國(guó)2.臭皮匠服務(wù)器優(yōu)勢(shì):我們具有國(guó)內(nèi)技術(shù)與服務(wù)頂尖的I DC及互聯(lián)網(wǎng)云安全服務(wù)商!我司整合了國(guó)內(nèi)領(lǐng)先的I DC運(yùn)營(yíng)

2018-04-21 15:42:54

推理性能與當(dāng)前服務(wù)器級(jí) CPU 相比,VCK190 能夠提供超過(guò) 100 倍的計(jì)算性能。下面是基于 C32B6 DPU 內(nèi)核的 AI 引擎實(shí)現(xiàn)的性能示例,批處理 = 6。有關(guān) VCK190 上各種

2022-11-25 16:29:20

嗨,我想知道,如果可以安裝NVIDIA許可證服務(wù)器嗎?我沒有找到任何關(guān)于此的明確文件。 setup.exe也沒有我能夠使用的任何清晰的開關(guān)/參數(shù)。謝謝,延以上來(lái)自于谷歌翻譯以下為原文Hi, I

2018-09-18 16:18:10

基于SRAM的方法可加速AI推理

2020-12-30 07:28:28

本人現(xiàn)在在做ARM上構(gòu)建一個(gè)web服務(wù)器,就是將網(wǎng)頁(yè)放在這個(gè)服務(wù)器上,然后接入internet可以通過(guò)PC機(jī)上網(wǎng)訪問(wèn)即可。用的是C#編程,實(shí)際實(shí)現(xiàn)上還是有些模糊,希望有心人能教教俺,最好能給出服務(wù)器和客服端的程序做參考說(shuō)明,先謝過(guò)了。。。

2022-10-28 10:55:15

Tengine是什么?如何在RK3399這一 Arm64 平臺(tái)上搭建 Tengine AI 推理框架,并運(yùn)行圖像識(shí)別相關(guān)應(yīng)用?

2022-03-07 07:53:43

Tengine是什么呢?如何在RK3399這一 Arm64平臺(tái)上搭建Tengine AI推理框架呢?

2022-03-04 12:31:35

使用 PyTorch 對(duì)具有非方形圖像的 YOLOv4 模型進(jìn)行了訓(xùn)練。

將 權(quán)重轉(zhuǎn)換為 ONNX 文件,然后轉(zhuǎn)換為中間表示 (IR)。

無(wú)法確定如何獲得更好的推理性能。

2023-08-15 06:58:00

成本比較高,而且不方便工業(yè)現(xiàn)場(chǎng)的應(yīng)用實(shí)施,嵌入式系統(tǒng)以及嵌入式小型Web服務(wù)器的出現(xiàn)使得Web服務(wù)運(yùn)行在資源、性能有限的嵌入式設(shè)備上提供了條件。本文主要介紹嵌入式Web服務(wù)器BOA在ARM9嵌入式系統(tǒng)設(shè)備板上的移植,并對(duì)移植后的BOA服務(wù)器進(jìn)行測(cè)試驗(yàn)證。

2019-10-29 06:48:51

的參考。評(píng)估TI處理器模型性能的方式有兩種:TDA4VM入門套件評(píng)估模塊(EVM)或TI Edge AI Cloud,后者是一項(xiàng)免費(fèi)在線服務(wù),可支持遠(yuǎn)程訪問(wèn)TDA4VM EVM,以評(píng)估深度學(xué)習(xí)推理性能。借助

2022-11-03 06:53:28

1、在Arm服務(wù)器上Robox安卓容器方案的構(gòu)建編譯過(guò)程和使用方法隨著云計(jì)算相關(guān)產(chǎn)業(yè)蓬勃發(fā)展,用戶對(duì)移動(dòng)設(shè)備的彈性需求推動(dòng)出云手機(jī)、云游戲等概念,云手機(jī)和云游戲就是將云計(jì)算技術(shù)運(yùn)用于網(wǎng)絡(luò)終端服務(wù)

2022-06-17 14:34:24

生成兩個(gè) IR文件(相同的 .xml 文件,但不同的 .bin 文件)

具有不同重量的類似模型,以不同的 fps (27fps 和 6fps) 運(yùn)行

更多樣化的權(quán)重是否會(huì)影響 Myriad X 上的推理性能?

2023-08-15 07:00:25

商業(yè)發(fā)行之前就已經(jīng)過(guò)時(shí)了。算法明天需要對(duì)架構(gòu)、內(nèi)存/數(shù)據(jù)進(jìn)行徹底改革資源和能力。推理的夢(mèng)幻建筑重新定義重寫在計(jì)算和交付突破性的人工智能加速和靈活的計(jì)算能力超越了服務(wù)器級(jí)CPU和比GPU/ASIC通用

2020-11-01 09:28:57

(NN)引擎和張量處理架構(gòu)(Tensor Processing Fabric)技術(shù)提供卓越的神經(jīng)網(wǎng)絡(luò)推理性能,具有業(yè)界領(lǐng)先的能耗效率(TOPS/W)和面積效率(平方毫米/瓦),可擴(kuò)展的計(jì)算能力范圍從0.5TOPS( 每秒萬(wàn)億次運(yùn)算)到幾百TOPS。

2019-09-11 11:52:13

網(wǎng)站權(quán)重提高多IP站群服務(wù)器,可以大大降低同一IP上的網(wǎng)站數(shù)量,如果網(wǎng)站數(shù)量在258以下,還可以每個(gè)網(wǎng)站分配一個(gè)獨(dú)立IP,從而可以減少網(wǎng)站之間的分權(quán)。4、多ip避免封殺網(wǎng)站受影響如果一個(gè)ip多個(gè)網(wǎng)站

2023-04-18 16:16:20

荷蘭服務(wù)器的十大優(yōu)勢(shì) 1、荷蘭機(jī)房眾多,例如荷蘭的阿姆斯特丹機(jī)房、萊茵河畔機(jī)房等,都是荷蘭乃至歐洲最優(yōu)質(zhì)的機(jī)房。有需要請(qǐng)聯(lián)系TG:@TW_001 2、荷蘭IP眾多,一臺(tái)服務(wù)器最高可以添加253個(gè)IP

2021-12-16 10:26:55

內(nèi)存也是內(nèi)存(RAM),具有一些特有的技術(shù)從而有著極高的穩(wěn)定性和糾錯(cuò)性能。最直觀的分辨服務(wù)器內(nèi)存與普通內(nèi)存的方法就是看條子上的字有沒有帶ECC模塊。◆◆現(xiàn)我司大量在服務(wù)器內(nèi)存條,收購(gòu)?fù)?b class="flag-6" style="color: red">服務(wù)器內(nèi)存條

2021-09-22 19:20:15

、操作系統(tǒng)等,滿足不同的需求。綜上所述,高防服務(wù)器具有很多的優(yōu)勢(shì),能夠?yàn)榭蛻籼峁┓€(wěn)定可靠、安全高效、高品質(zhì)帶寬的網(wǎng)絡(luò)服務(wù)。因此,在如今互聯(lián)網(wǎng)猖獗的環(huán)境中,選擇一個(gè)好的高防服務(wù)器,能夠在網(wǎng)站運(yùn)營(yíng)中起到關(guān)鍵

2023-03-21 12:40:07

27日消息 ARM與聯(lián)發(fā)科技(MediaTek)今日宣布擴(kuò)大雙方長(zhǎng)期合作關(guān)系,聯(lián)發(fā)科技取得大量市場(chǎng)領(lǐng)先的高性能ARM知識(shí)產(chǎn)權(quán)(IP)授權(quán),包括可用于智能手機(jī)、智能電視與藍(lán)光播放器的ARMMali系列

2012-02-28 09:11:01 737

737 針對(duì)CLINK算法在路由改變時(shí)擁塞鏈路推理性能下降的問(wèn)題,建立一種變結(jié)構(gòu)離散動(dòng)態(tài)貝葉斯網(wǎng)模型,通過(guò)引入馬爾可夫性及時(shí)齊性假設(shè)簡(jiǎn)化該模型,并基于簡(jiǎn)化模型提出一種IP網(wǎng)絡(luò)擁塞鏈路推理算法(VSDDB

2018-01-16 18:46:26 0

0 Azure Machine Learning SDK 相集成以供預(yù)覽。客戶可以使用 Azure 大規(guī)模部署的英特爾 FPGA(現(xiàn)場(chǎng)可編程邏輯門陣列)技術(shù),為其模型提供行業(yè)領(lǐng)先的人工智能 (AI) 推理性能。 “作為一家整體技術(shù)提供商,我們通過(guò)與 Microsoft 密切合作為人工智能提供支持。

2018-05-20 00:10:00 2865

2865 TaiShan系列服務(wù)器主要面向大數(shù)據(jù)、分布式存儲(chǔ)和ARM原生應(yīng)用等場(chǎng)景,發(fā)揮ARM架構(gòu)在多核、高能效等方面的優(yōu)勢(shì),為企業(yè)構(gòu)建高性能、低功耗的新計(jì)算平臺(tái);例如大數(shù)據(jù)場(chǎng)景,實(shí)現(xiàn)了多核高并發(fā)和資源調(diào)度調(diào)優(yōu),計(jì)算性能提升20%。基于TaiShan服務(wù)器,華為云也將提供彈性云服務(wù)、裸金屬服務(wù)和云手機(jī)服務(wù)。

2019-01-09 09:39:05 10813

10813 MLPerf Inference 0.5是業(yè)內(nèi)首個(gè)獨(dú)立AI推理基準(zhǔn)套件,其測(cè)試結(jié)果證明了NVIDIA Turing數(shù)據(jù)中心GPU以及 NVIDIA Xavier 邊緣計(jì)算芯片系統(tǒng)的性能。

2019-11-29 14:45:02 2696

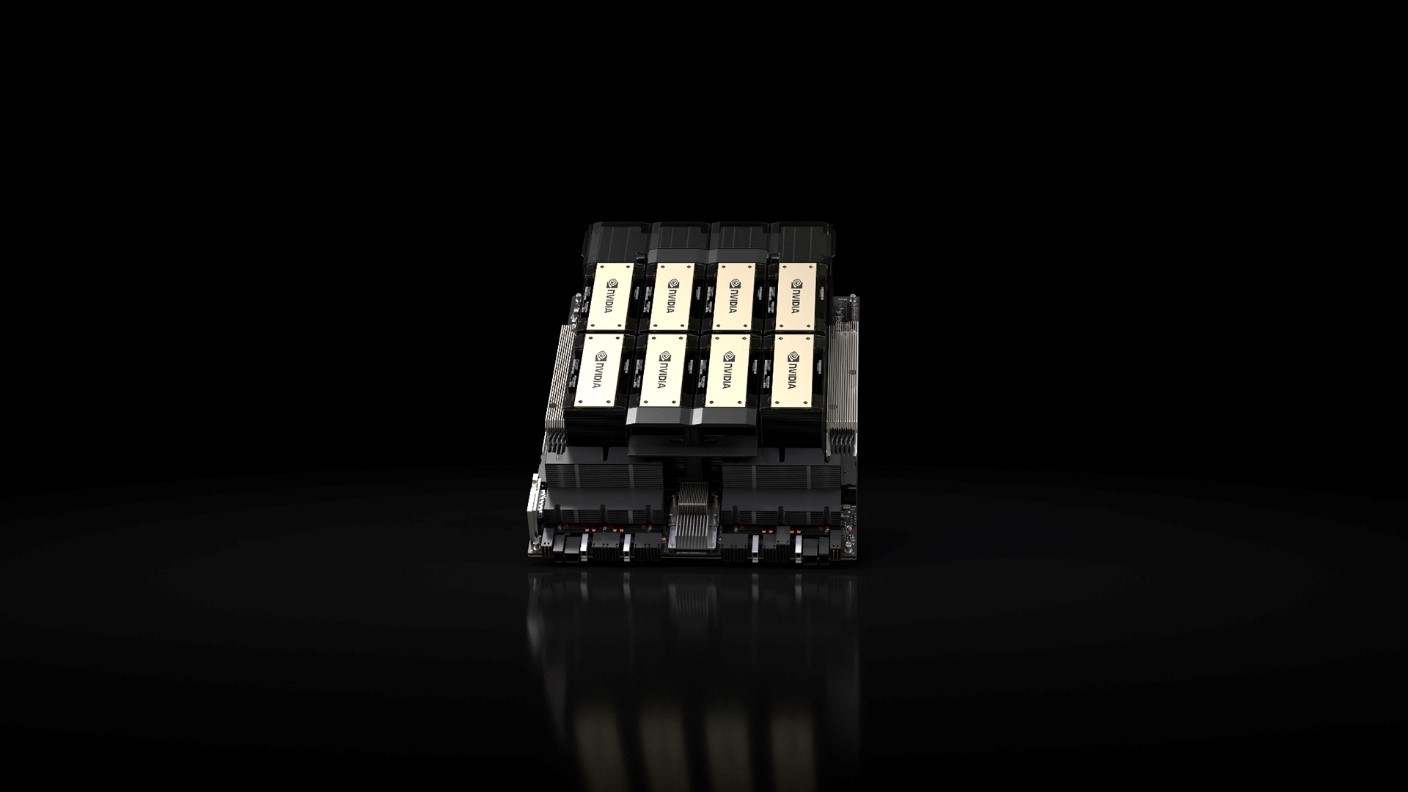

2696 NVIDIA和多家全球領(lǐng)先的服務(wù)器制造商于今日發(fā)布多款內(nèi)置NVIDIA A100的系統(tǒng)。這些系統(tǒng)具有多種不同的設(shè)計(jì)和配置,可應(yīng)對(duì)AI、數(shù)據(jù)科學(xué)和科學(xué)計(jì)算領(lǐng)域最復(fù)雜的挑戰(zhàn)。

2020-06-24 16:04:33 2585

2585 結(jié)合NVIDIA 領(lǐng)先的人工智能技術(shù)與 Arm 龐大的計(jì)算生態(tài)系統(tǒng),讓創(chuàng)新成果惠及所有客戶 NVIDIA 將建立世界先進(jìn)的 AI 研究和教育中心來(lái)擴(kuò)大Arm在英國(guó)劍橋的研發(fā)業(yè)務(wù),并打造采用 Arm

2020-09-21 13:44:17 1347

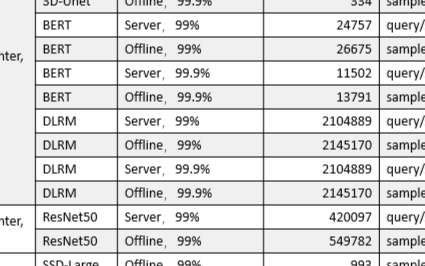

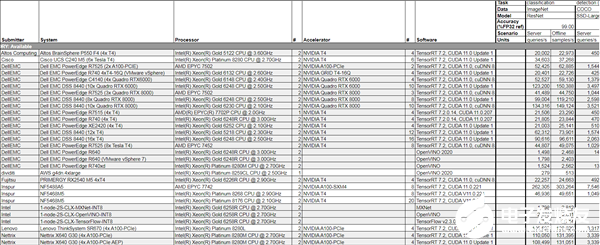

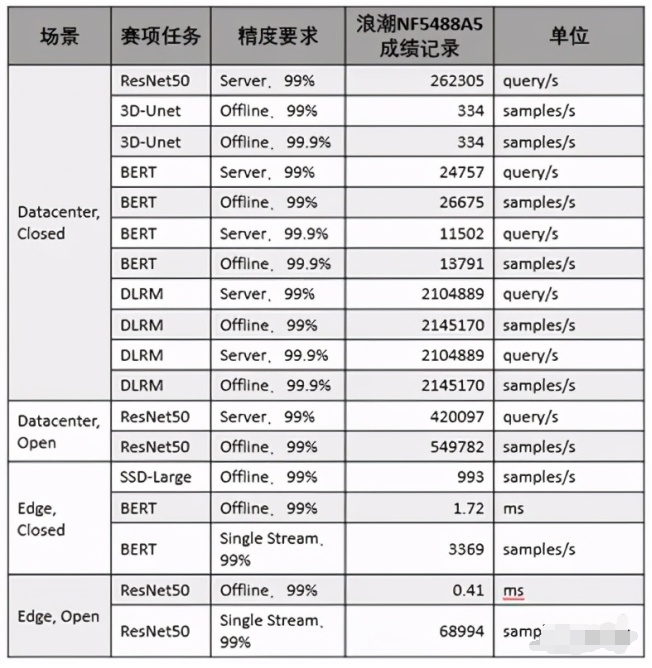

1347 美國(guó)東部時(shí)間10月21日,全球備受矚目的權(quán)威AI基準(zhǔn)測(cè)試MLPerf公布今年的推理測(cè)試榜單,浪潮AI服務(wù)器NF5488A5一舉創(chuàng)造18項(xiàng)性能紀(jì)錄,在數(shù)據(jù)中心AI推理性能上遙遙領(lǐng)先其他廠商產(chǎn)品

2020-10-23 16:59:44 1615

1615

的237倍。 MLPerf Inference V0.7部分結(jié)果截圖 最新的AI推理測(cè)試結(jié)果意味著,NVIDIA未來(lái)可能在AI推理和訓(xùn)練市場(chǎng)都占據(jù)領(lǐng)導(dǎo)地位,給云端AI推理市場(chǎng)擁有優(yōu)勢(shì)的Intel帶來(lái)更大壓力的

2020-10-23 17:40:02 3929

3929

弗洛伊德說(shuō):“英偉達(dá)在競(jìng)爭(zhēng)激烈的競(jìng)爭(zhēng)者中表現(xiàn)出色。” 與(Nvidia)V100(GPU)相比,他們的A100效果驚人,證明了其增強(qiáng)的Tensor核心架構(gòu)的價(jià)值。我贊揚(yáng)MLPerf添加了新的基準(zhǔn),這些基準(zhǔn)越來(lái)越代表快速增長(zhǎng)的推理機(jī)會(huì),例如推薦引擎。

2020-10-24 09:17:15 1995

1995 美國(guó)東部時(shí)間10月21日,全球倍受矚目的權(quán)威AI基準(zhǔn)測(cè)試MLPerf公布今年的推理測(cè)試榜單,浪潮AI服務(wù)器NF5488A5一舉創(chuàng)造18項(xiàng)性能記錄,在數(shù)據(jù)中心AI推理性能上遙遙領(lǐng)先其他廠商產(chǎn)品。

2020-10-26 16:30:44 1709

1709

近日,在GTC China元腦生態(tài)技術(shù)論壇上,中科極限元、趨動(dòng)科技、睿沿科技等元腦生態(tài)伙伴分享了多個(gè)場(chǎng)景下浪潮AI服務(wù)器NF5488A5的實(shí)測(cè)數(shù)據(jù),結(jié)果表明浪潮NF5488A5大幅提升了智能語(yǔ)音、圖像識(shí)別等AI模型的訓(xùn)練和推理性能,促進(jìn)了產(chǎn)業(yè)AI解決方案的開發(fā)與應(yīng)用。

2020-12-24 15:25:01 2123

2123

一個(gè)支持邊緣實(shí)時(shí)推理的姿態(tài)估計(jì)模型,其推理性能比OpenPose模型快9倍。

2021-06-25 11:55:52 1450

1450 ,其中的模型數(shù)量達(dá)數(shù)千個(gè),日均調(diào)用服務(wù)達(dá)到千億級(jí)別。無(wú)量推薦系統(tǒng),在模型訓(xùn)練和推理都能夠進(jìn)行海量Embedding和DNN模型的GPU計(jì)算,是目前業(yè)界領(lǐng)先的體系結(jié)構(gòu)設(shè)計(jì)。 傳統(tǒng)推薦系統(tǒng)面臨挑戰(zhàn) 傳統(tǒng)推薦系統(tǒng)具有以下特點(diǎn): 訓(xùn)練是基于參數(shù)

2021-08-23 17:09:03 4486

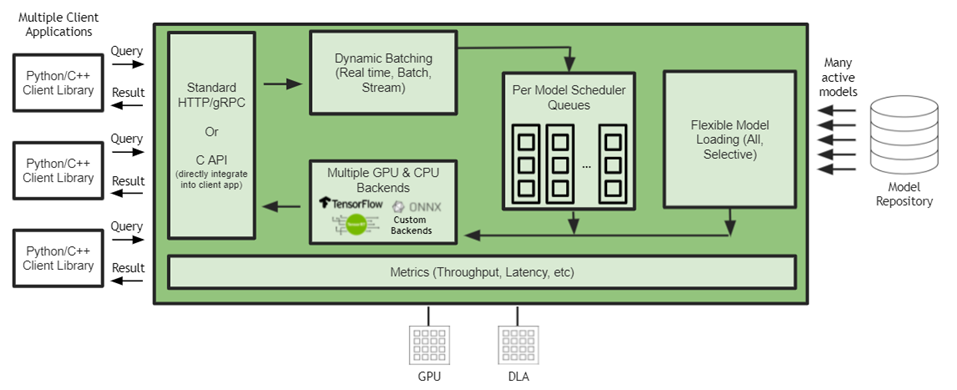

4486 Capital One、Microsoft、Samsung Medison、Siemens Energy、Snap等25000多家客戶都在使用該平臺(tái)。 這些更新包括開源NVIDIA Triton推理服務(wù)器

2021-11-12 14:42:53 1684

1684 西門子能源公司正在發(fā)揮 NVIDIA Triton 推理服務(wù)器的強(qiáng)大力量,利用 AI 協(xié)助解決全球發(fā)電廠在預(yù)測(cè)性服務(wù)管理方面的擔(dān)憂。

2021-11-16 16:25:31 3490

3490 Microsoft Teams借助AI生成的實(shí)時(shí)字幕和轉(zhuǎn)錄功能,幫助全球?qū)W生和職場(chǎng)人士順利進(jìn)行在線會(huì)議。用于訓(xùn)練的NVIDIA AI計(jì)算技術(shù)和用于推理語(yǔ)音識(shí)別模型的NVIDIA Triton推理服務(wù)器進(jìn)一步提升了這兩個(gè)功能。

2022-01-04 14:20:11 1407

1407 Microsoft Teams借助AI生成的實(shí)時(shí)字幕和轉(zhuǎn)錄功能,幫助全球?qū)W生和職場(chǎng)人士順利進(jìn)行在線會(huì)議。用于訓(xùn)練的NVIDIA AI計(jì)算技術(shù)和用于推理語(yǔ)音識(shí)別模型的NVIDIA Triton推理服務(wù)器進(jìn)一步提升了這兩個(gè)功能。

2022-01-04 17:45:12 1472

1472 能力。 一、GPU服務(wù)器處理性能和用例: 1、GPU 用例 雖然投資 GPU 服務(wù)器的原因過(guò)于廣泛,無(wú)法在一篇文章中涵蓋,但我們已經(jīng)概述了我們?cè)谶^(guò)去幾年中看到的最喜歡的用例。 2、3D處理 GPU 服務(wù)器非常適合 2D 和 3D 計(jì)算以及渲染 3D 圖形和 GPU 技術(shù),以至于

2022-02-22 16:44:04 1434

1434 NVIDIA Grace CPU是首款面向AI基礎(chǔ)設(shè)施和高性能計(jì)算的基于Arm Neoverse的數(shù)據(jù)中心專屬CPU,是當(dāng)今領(lǐng)先服務(wù)器芯片內(nèi)存帶寬和能效的兩倍。

2022-03-30 14:11:31 1489

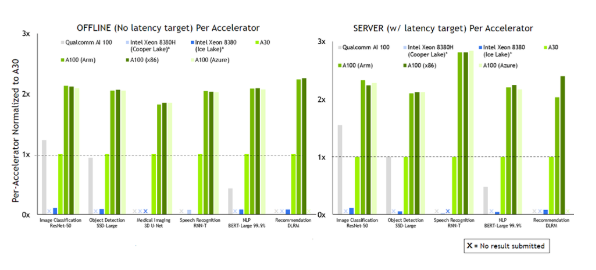

1489 在首次參加行業(yè) MLPerf 基準(zhǔn)測(cè)試時(shí),基于 NVIDIA Ampere 架構(gòu)的低功耗系統(tǒng)級(jí)芯片 NVIDIA Orin 就創(chuàng)造了新的AI推理性能紀(jì)錄,并在邊緣提升每個(gè)加速器的性能。

2022-04-08 10:14:44 4200

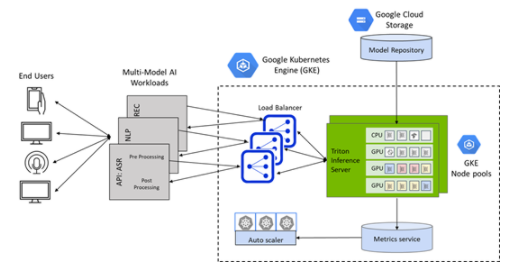

4200

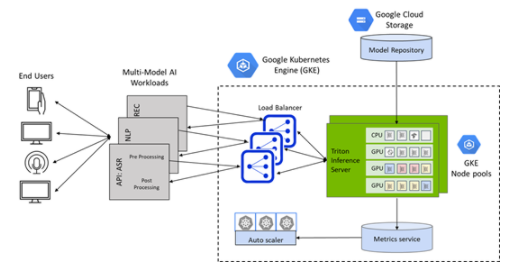

GKE 的 Triton 推理服務(wù)器應(yīng)用程序是一個(gè) helm chart 部署程序,可自動(dòng)安裝和配置 Triton ,以便在具有 NVIDIA GPU 節(jié)點(diǎn)池的 GKE 集群上使用,包括

2022-04-08 16:43:03 1855

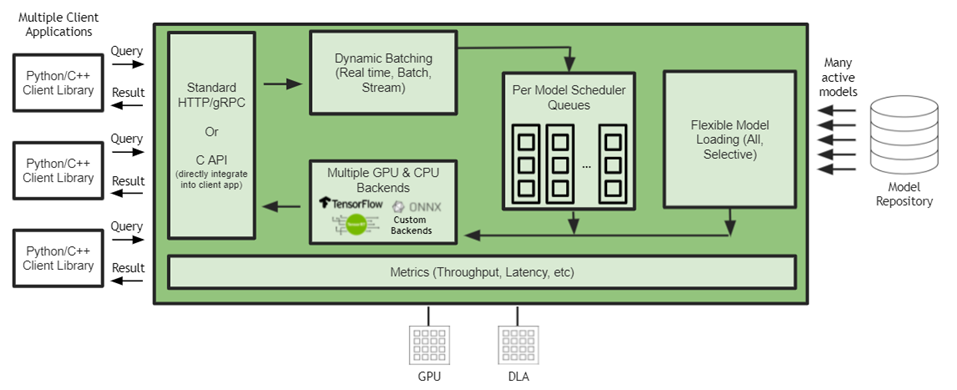

1855

NVIDIA Triton 有助于在每個(gè)數(shù)據(jù)中心、云和嵌入式設(shè)備中實(shí)現(xiàn)標(biāo)準(zhǔn)化的可擴(kuò)展生產(chǎn) AI 。它支持多個(gè)框架,在 GPU 和 DLA 等多個(gè)計(jì)算引擎上運(yùn)行模型,處理不同類型的推理查詢。通過(guò)與 NVIDIA JetPack 的集成, NVIDIA Triton 可用于嵌入式應(yīng)用。

2022-04-18 15:40:02 2306

2306

網(wǎng)易互娛 AI Lab 的研發(fā)人員,基于 Wenet 語(yǔ)音識(shí)別工具進(jìn)行優(yōu)化和創(chuàng)新,利用 NVIDIA Triton 推理服務(wù)器的 GPU Batch Inference 機(jī)制加速了語(yǔ)音識(shí)別的速度,并且降低了成本。

2022-05-13 10:40:19 1481

1481 最新的 AI 推理基準(zhǔn)顯然具有重要意義,因?yàn)樗悄壳翱捎玫淖罱咏鎸?shí)世界 AI 推理性能的衡量標(biāo)準(zhǔn)。但隨著它的成熟和吸引更多的提交,它也將成為成功部署技術(shù)堆棧的晴雨表和新實(shí)施的試驗(yàn)場(chǎng)。

2022-07-08 15:37:55 1246

1246

騰訊云 TI 平臺(tái) TI-ONE 利用 NVIDIA Triton 推理服務(wù)器構(gòu)造高性能推理服務(wù)部署平臺(tái),使用戶能夠非常便捷地部署包括 TNN 模型在內(nèi)的多種深度學(xué)習(xí)框架下獲得的 AI 模型,并且顯著提升推理服務(wù)的吞吐、提升 GPU 利用率。

2022-09-05 15:33:01 1419

1419 螞蟻鏈 AIoT 團(tuán)隊(duì)與 NVIDIA 合作,將量化感知訓(xùn)練(QAT)技術(shù)應(yīng)用于深度學(xué)習(xí)模型性能優(yōu)化中,并通過(guò) NVIDIA TensorRT 高性能推理 SDK 進(jìn)行高效率部署, 通過(guò) INT8 推理, 吞吐量提升了 3 倍, 助力螞蟻鏈版權(quán) AI 平臺(tái)中的模型推理服務(wù)大幅降本增效。

2022-09-09 09:53:52 872

872 推理識(shí)別是人工智能最重要的落地應(yīng)用,其他與深度學(xué)習(xí)相關(guān)的數(shù)據(jù)收集、標(biāo)注、模型訓(xùn)練等工作,都是為了得到更好的最終推理性能與效果。

2022-10-26 09:43:57 1370

1370 、NVIDIA 的技術(shù)專家將帶來(lái) AI Infra 、 推理引擎 相關(guān)的專題分享,包括目前各企業(yè)面臨的模型推理挑戰(zhàn)、Triton 的應(yīng)用及落地的具體方案等,現(xiàn)身說(shuō)法,干貨十足。此外,還有來(lái)自

2023-02-15 16:10:05 207

207 AI推理性能對(duì)比 / Ampere 從性能對(duì)比上,我們可以看出AmpereOne在AI推理負(fù)載上的領(lǐng)先,比如在生成式AI和推薦算法上,AmpereOne的單機(jī)架性能是AMD EYPC 9654 Genoa的兩倍或以上,但兩者卻有著近乎相同的系統(tǒng)功耗,AmpereOne的優(yōu)勢(shì)在此展現(xiàn)得一覽無(wú)余。

2023-06-13 15:03:51 789

789

AI 服務(wù)器確實(shí)是整個(gè)服務(wù)器市場(chǎng)的一部分,但它們是專門為基于云的 AI 模型訓(xùn)練或推理而設(shè)計(jì)的。在規(guī)格方面,廣義的AI服務(wù)器是指搭載AI芯片(如前面提到的GPU、FPGA、ASIC)的服務(wù)器,而狹義的定義則包括至少搭載一塊GPU的服務(wù)器。

2023-06-21 12:40:02 1208

1208 使用集成模型在 NVIDIA Triton 推理服務(wù)器上為 ML 模型管道提供服務(wù)

2023-07-05 16:30:34 1082

1082

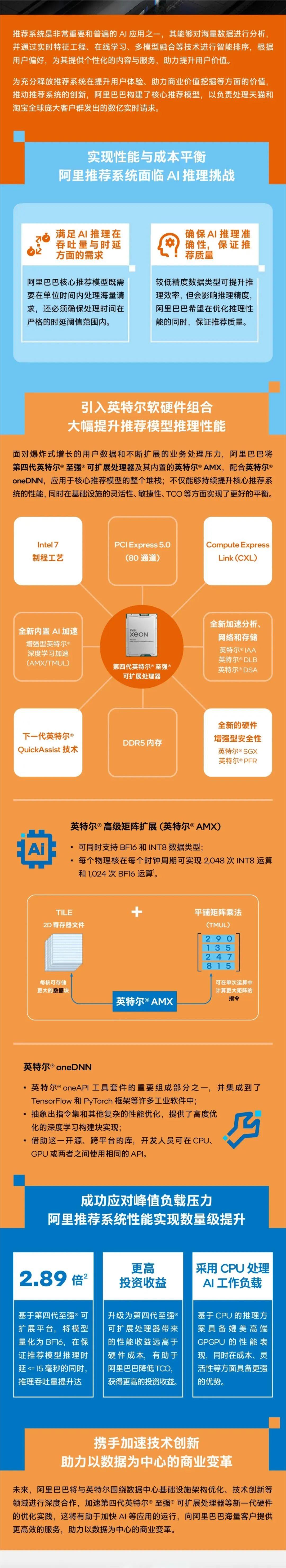

達(dá)沃斯論壇|英特爾王銳:AI驅(qū)動(dòng)工業(yè)元宇宙,釋放數(shù)實(shí)融合無(wú)窮潛力 英特爾研究院發(fā)布全新AI擴(kuò)散模型,可根據(jù)文本提示生成360度全景圖 英特爾內(nèi)部代工模式的最新進(jìn)展 原文標(biāo)題:英特爾? AMX 加速AI推理性能,助阿里電商推薦系統(tǒng)成功應(yīng)對(duì)峰值負(fù)載

2023-07-08 14:15:03 294

294

科技賦能千行百業(yè) 人民網(wǎng)攜手英特爾啟動(dòng)“數(shù)智加速度”計(jì)劃 WAIC 2023:英特爾以技術(shù)之力推動(dòng)邊緣人工智能發(fā)展,打造數(shù)字化未來(lái)“芯”時(shí)代 英特爾 AMX 加速AI推理性能,助阿里電商推薦系統(tǒng)成功應(yīng)對(duì)峰值負(fù)載壓力 原文標(biāo)題:英特爾? AMX 助力百度ERNIE-T

2023-07-14 20:10:05 245

245

with NVIDIA 拉斯維加斯 — VMware Explore — 太平洋時(shí)間 2023 年 8 月 22 日 — NVIDIA 宣布,全球領(lǐng)先的系統(tǒng)制造商將推出 AI 就緒型服務(wù)器,其支持同發(fā)布的 VMware

2023-08-23 19:10:09 350

350 英特爾產(chǎn)品在全新MLCommons AI推理性能測(cè)試中盡顯優(yōu)勢(shì) 今日,MLCommons公布針對(duì) 60 億參數(shù)大語(yǔ)言模型及計(jì)算機(jī)視覺與自然語(yǔ)言處理模型GPT-J的 MLPerf推理v3.1 性能基準(zhǔn)

2023-09-12 17:54:32 200

200

超級(jí)芯片 首次亮相 MLPerf 行業(yè)基準(zhǔn)測(cè)試,其運(yùn)行了所有數(shù)據(jù)中心推理測(cè)試,進(jìn)一步擴(kuò)大了 NVIDIA H100 Tensor Core GPU 的領(lǐng)先優(yōu)勢(shì)。 總體測(cè)試結(jié)果表明,NVIDIA AI

2023-09-12 20:40:04 249

249 Hopper超級(jí)芯片首次亮相 MLPerf 行業(yè)基準(zhǔn)測(cè)試,其運(yùn)行了所有數(shù)據(jù)中心推理測(cè)試,進(jìn)一步擴(kuò)大了NVIDIA H100 Tensor Core GPU的領(lǐng)先優(yōu)勢(shì)。 ? 總體測(cè)試結(jié)果表明,NVIDIA AI

2023-09-13 09:45:40 139

139

加利福尼亞州圣克拉拉——Nvidia通過(guò)一個(gè)名為TensorRT LLM的新開源軟件庫(kù),將其H100、A100和L4 GPU的大型語(yǔ)言模型(LLM)推理性能提高了一倍。 正如對(duì)相同硬件一輪又一輪改進(jìn)

2023-10-23 16:10:19 284

284 ,使用 NVIDIA Triton TM? 推理服務(wù)器進(jìn)行端到端部署 LLM Serving,以及金融行業(yè)的 AI、NLP/LLM 應(yīng)用場(chǎng)景、客戶案例。 通過(guò)本次活動(dòng),您將了解基于上述產(chǎn)品的 LLM

2023-10-26 09:05:02 174

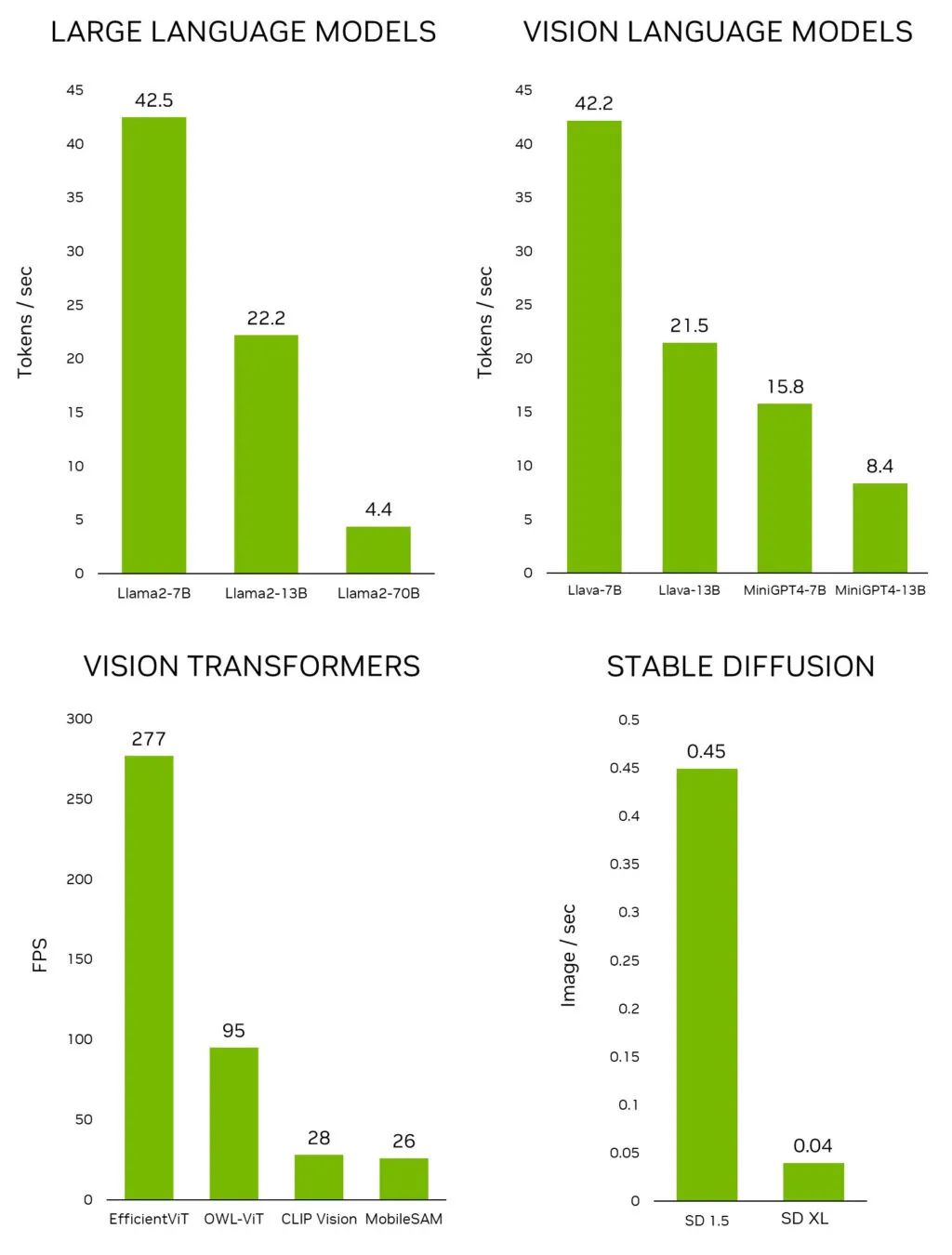

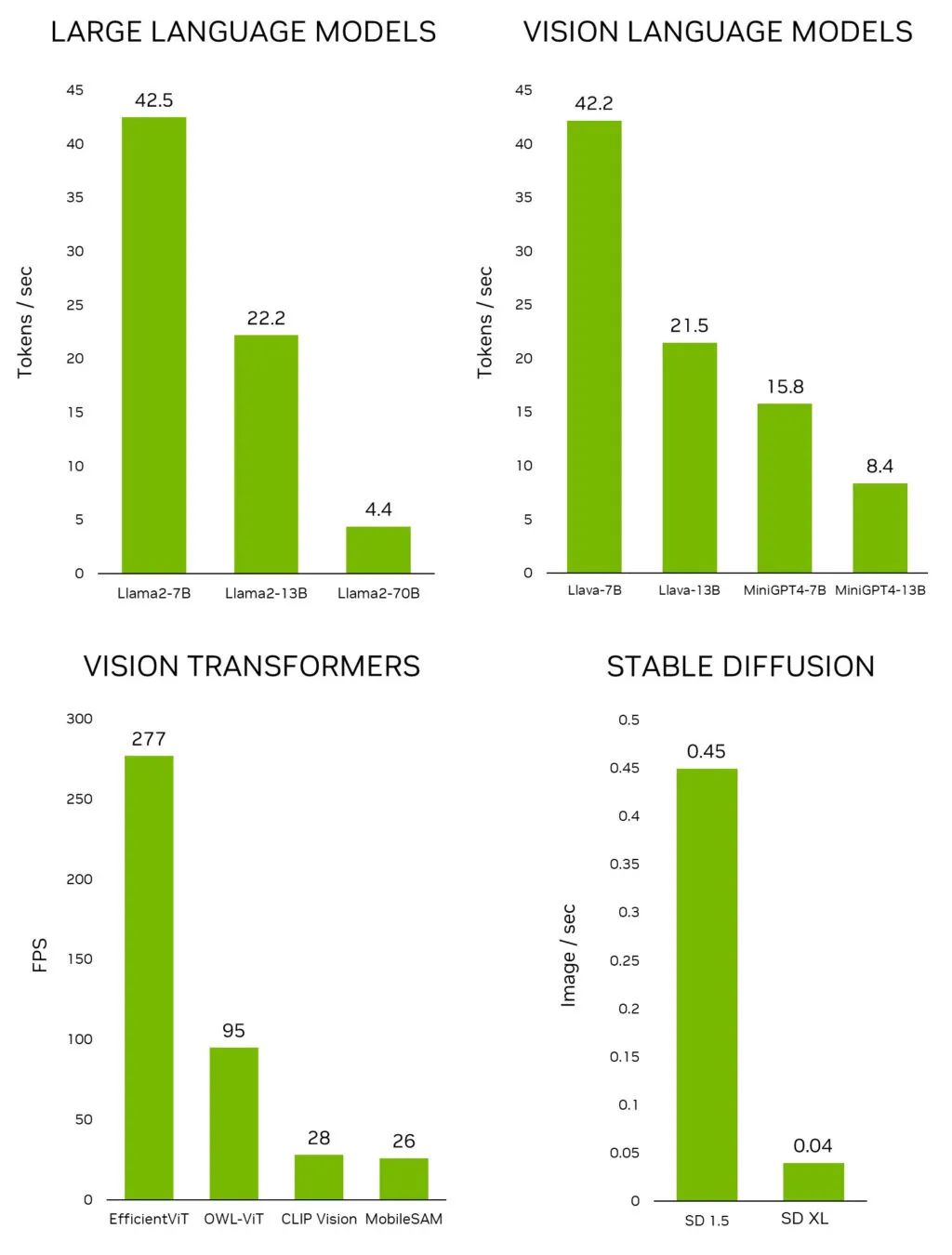

174 上以交互速率運(yùn)行的 Llama-2-70B 模型。 圖 1. 領(lǐng)先的生成式 AI 模型在? Jetson AGX Orin 上的推理性能 如要在 Jetson 上快速測(cè)試最新的模型和應(yīng)用,請(qǐng)使用 Jetson 生成式 AI 實(shí)驗(yàn)室提供的教程和資源。

2023-11-07 21:25:01 398

398

Tensor Core GPU 和領(lǐng)先的顯存配置,可處理生成式 AI 與高性能計(jì)算工作負(fù)載的海量數(shù)據(jù)。 ? NVIDIA H200 是首款采用 HBM3e 的 GPU,其運(yùn)行更快、更大的顯存容量將進(jìn)一步加速生成式 AI 與大語(yǔ)言模型,同時(shí)

2023-11-14 14:30:01 85

85

作者: 英特爾公司 沈海豪、羅嶼、孟恒宇、董波、林俊 編者按: 只需不到9行代碼, 就能在CPU上實(shí)現(xiàn)出色的LLM推理性能。 英特爾 ?Extension for Transformer 創(chuàng)新

2023-12-01 20:40:03 552

552

那么,什么是Torch TensorRT呢?Torch是我們大家聚在一起的原因,它是一個(gè)端到端的機(jī)器學(xué)習(xí)框架。而TensorRT則是NVIDIA的高性能深度學(xué)習(xí)推理軟件工具包。Torch TensorRT就是這兩者的結(jié)合。

2024-01-09 16:41:51 286

286

這家云計(jì)算巨頭的計(jì)算機(jī)視覺和數(shù)據(jù)科學(xué)服務(wù)使用 NVIDIA Triton 推理服務(wù)器來(lái)加速 AI 預(yù)測(cè)。

2024-02-29 14:04:40 162

162

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論