從視頻中估計3D結構和相機運動是計算機視覺中的一個關鍵問題,這個技術在自動駕駛領域有著廣闊的工業(yè)應用前景。目前自動駕駛的核心技術是LiDAR(激光雷達),一種運用雷達原理,采用光和激光作為主要傳感器的汽車視覺系統(tǒng)。LiDAR傳感器賦予了自動駕駛汽車能夠看到周邊環(huán)境的“雙眼”,激光雷達技術越先進,視覺感知的精準程度越高,這是自動駕駛得以實現(xiàn)的底層技術基礎。但是最近幾年,放在攝像頭上的深度學習研究,發(fā)展很蓬勃。相比之下, 雖然激光雷達 (LiDAR)的數(shù)據(jù)有諸多優(yōu)點,但相關學術進展并不太多。相機+數(shù)據(jù)+神經(jīng)網(wǎng)絡的組合,正在迅速縮小與LiDAR的能力差距。

無需相機參數(shù)、單目、以無監(jiān)督學習的方式從未標記場景視頻中搞定深度圖!

什么是深度圖?

深度圖像(depth image)也被稱為距離影像(range image),由相機拍攝,是指將從圖像采集器到場景中各點的距離(深度)作為像素值的圖像,它直接反映了景物可見表面的幾何形狀。單位為mm,效果參考下圖:

在場景視頻景深學習領域,谷歌AI和機器人實驗室聯(lián)合公布了三項最新研究突破:

第一,證明了可以以一種無監(jiān)督的方式訓練深度網(wǎng)絡,這個深度網(wǎng)絡可以從視頻本身預測相機的內(nèi)在參數(shù),包括鏡頭失真(見圖1)。

第二,在這種情況下,他們是第一個以幾何方式從預測深度直接解決遮擋的問題。

第三,大大減少了處理場景中移動元素所需的語義理解量:只需要一個覆蓋可能屬于移動對象的像素的單個掩碼,而不是分割移動對象的每個實例并跨幀跟蹤它。

圖1:從未知來源的視頻中學習深度的方法的定性結果,通過同時學習相機的外在和內(nèi)在參數(shù)來實現(xiàn)。 由于該方法不需要知道相機參數(shù),因此它可以應用于任何視頻集。 所有深度圖(在右側可視化,作為差異)都是從原始視頻中學習而不使用任何相機內(nèi)在函數(shù)。 從上到下:來自YouTube8M的幀,來自EuRoC MAV數(shù)據(jù)集,來自Cityscapes和來自KITTI的幀。

推特網(wǎng)友對此不吝贊美:“這是我見過的最令人印象深刻的無監(jiān)督結果之一。來自未標記視頻的深度圖對于自動駕駛非常有用:)“

以下是論文具體內(nèi)容:

從視頻中估計3D結構和相機運動是計算機視覺中的一個關鍵問題,這個技術在自動駕駛領域有著廣闊的工業(yè)應用前景。

解決該問題的傳統(tǒng)方法依賴于在多個連續(xù)幀中識別場景中的相同點,并求解在這些幀上最大程度一致的3D結構和相機運動。

但是,幀之間的這種對應關系只能針對所有像素的子集建立,這導致了深度估計不確定的問題。與通常處理逆問題一樣,這些缺口是由連續(xù)性和平面性等假設填充的。

深度學習能夠從數(shù)據(jù)中獲得這些假設,而不是手工指定這些假設。在信息不足以解決模糊性的地方,深度網(wǎng)絡可以通過對先前示例進行歸納,以生成深度圖和流場。

無監(jiān)督方法允許單獨從原始視頻中學習,使用與傳統(tǒng)方法類似的一致性損失,但在訓練期間對其進行優(yōu)化。在推論中,經(jīng)過訓練的網(wǎng)絡能夠預測來自單個圖像的深度以及來自成對或更長圖像序列的運動。

隨著對這個方向的研究越來越有吸引力,很明顯,物體運動是一個主要障礙,因為它違反了場景是靜態(tài)的假設。已經(jīng)提出了幾個方向來解決該問題,包括通過實例分割利用對場景的語義理解。

遮擋是另一個限制因素,最后,在此方向的所有先前工作中,必須給出相機的內(nèi)在參數(shù)。這項工作解決了這些問題,因此減少了監(jiān)督,提高了未標記視頻的深度和運動預測質(zhì)量。

首先,我們證明了可以以一種無監(jiān)督的方式訓練深度網(wǎng)絡,這個深度網(wǎng)絡從視頻本身預測相機的內(nèi)在參數(shù),包括鏡頭失真(見圖1)。

其次,在這種情況下,我們是第一個以幾何方式從預測深度直接解決遮擋的問題。

最后,我們大大減少了處理場景中移動元素所需的語義理解量:我們需要一個覆蓋可能屬于移動對象的像素的單個掩碼,而不是分割移動對象的每個實例并跨幀跟蹤它。

這個掩模可能非常粗糙,實際上可以是矩形邊界框的組合。獲得這樣的粗糙掩模是一個簡單得多的問題,而且與實例分割相比,使用現(xiàn)有的模型可以更可靠地解決這個問題。

除了這些定性進展之外,我們還對我們的方法進行了廣泛的定量評估,并發(fā)現(xiàn)它在多個廣泛使用的基準數(shù)據(jù)集上建立了新的技術水平。將數(shù)據(jù)集匯集在一起,這種能力通過我們的方法得到了極大的提升,證明可以提高質(zhì)量。

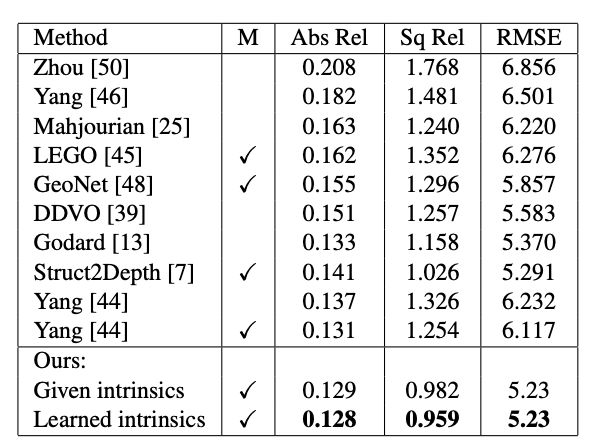

表1:總結了在KITTI上訓練的模型和評估結果,使用給定相機內(nèi)建和學習相機內(nèi)建兩種方式來評估我們方法的深度估計,結果顯而易見,我們獲得了當前最佳SOTA。

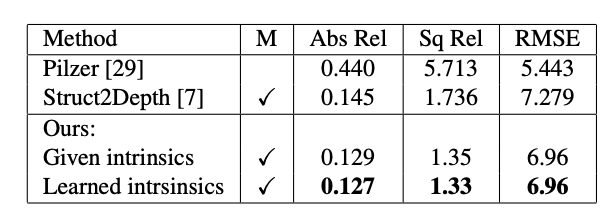

表2:總結了在Cityscapes上訓練和測試的模型的評估結果,我們的方法優(yōu)于以前的方法,并從學習的內(nèi)建中獲益。

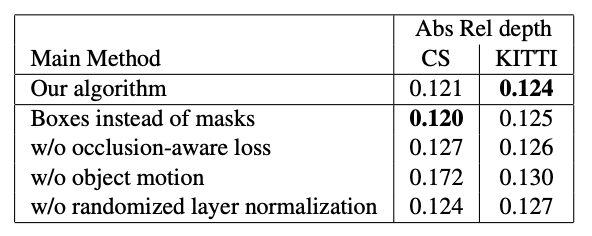

表3:深度估計的消融實驗。 在所有實驗中,訓練集是Cityscapes(CS)和KITTI組合,我們分別在Cityscapes(CS)和KITTI(Eigen partition)上測試模型。 每行代表一個實驗,其中與主方法相比進行了一次更改,如“實驗”行中所述。 數(shù)字越小越好。

除了這些定性的進步,我們對我們的方法進行了廣泛的定量評估,發(fā)現(xiàn)它在多個廣泛使用的基準數(shù)據(jù)集上建立了一個新的技術狀態(tài)。將數(shù)據(jù)集集中在一起,這種方法大大提高了數(shù)據(jù)集的質(zhì)量。

最后,我們首次演示了可以在YouTube視頻上學習深度和相機內(nèi)在預測,這些視頻是使用多個不同的相機拍攝的,每個相機的內(nèi)建都是未知的,而且通常是不同的。

-

谷歌

+關注

關注

27文章

6223瀏覽量

107532 -

LIDAR

+關注

關注

10文章

342瀏覽量

30157

原文標題:谷歌AI:根據(jù)視頻生成深度圖,效果堪比激光雷達

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

標準引領,賦能健康中國|喜報!回映電子參與起草的三項腦機接口臨床醫(yī)療器械團體標準正式發(fā)布

Future AIHER公司提交三項AI混增系統(tǒng)專利申請

深演智能斬獲三項國家級權威認證

華為MWC2025斬獲三項GLOMO大獎

《AI Agent 應用與項目實戰(zhàn)》----- 學習如何開發(fā)視頻應用

FPGA+AI王炸組合如何重塑未來世界:看看DeepSeek東方神秘力量如何預測......

?超景深3D檢測顯微鏡技術解析

科技為用戶而生!海爾智家大腦HomeGPT連獲三項大獎

松下電氣榮獲SGS三項服務認證

鴻海榮獲2024 IR Magazine三項大獎

蘋果iOS 18.2將推三項備忘錄AI功能,提升創(chuàng)作效率

《AI for Science:人工智能驅(qū)動科學創(chuàng)新》第二章AI for Science的技術支撐學習心得

3D ToF三維場景距離(景深)測量系統(tǒng)簡介

場景視頻景深學習領域,谷歌AI公布三項最新研究突破

場景視頻景深學習領域,谷歌AI公布三項最新研究突破

評論