面向用戶體驗的感知視頻編碼即通過機(jī)器學(xué)習(xí)檢測用戶感興趣的視覺感知區(qū)域,并重新分配以更多的碼率與復(fù)雜度。本文來自北京航空航天大學(xué)副教授、博士生導(dǎo)師 徐邁在LiveVideoStack 線上交流分享,并由LiveVideoStack整理而成。

大家好,我是來自北京航空航天大學(xué)的徐邁。本次我將為大家分享面向QoE的感知視頻編碼。我們希望通過基于感知模型的視頻壓縮編碼技術(shù),優(yōu)化產(chǎn)品用戶體驗。

本次的分享將圍繞以下四個方面展開:

1.技術(shù)發(fā)展背景

用戶的需求升級推動技術(shù)的不斷前行,技術(shù)的進(jìn)步也在不斷優(yōu)化產(chǎn)品用戶體驗。

十幾年前,人們聚在一起慶祝新年,借助電話或短信噓寒問暖,一起在溫馨氛圍中為新年到來而歡呼;而現(xiàn)在,人們相聚在一起慶祝新年,更多的是拿出智能手機(jī)、平板電腦等移動智能終端記錄這樣一個美好的瞬間。十幾年的發(fā)展帶來的首要影響就是數(shù)據(jù)量的激增,如何穩(wěn)定高效傳輸大量用戶隨時隨地采集到的音視頻數(shù)據(jù)成為我們亟待解決的問題。

數(shù)據(jù)量的激增雖然為網(wǎng)絡(luò)傳輸帶來了巨大挑戰(zhàn),但也為人工智能等高新技術(shù)帶來了需求與發(fā)展契機(jī)。

于是在2009年,斯坦福的李飛飛等科學(xué)家一起構(gòu)筑了用于測試視覺識別性能的ImageNet數(shù)據(jù)庫。初期ImageNet包含了四千多個類別的四百多萬張圖像,而到了2017年底其已包含兩萬多個類別的1400~1500萬張圖像。2009年ImageNet數(shù)據(jù)庫的建立與當(dāng)時互聯(lián)網(wǎng)上出現(xiàn)的大量圖像數(shù)據(jù)密切相關(guān),直到2018年的ImageNet中已包括了5400萬余張圖片,不得不說這加速了機(jī)器學(xué)習(xí)在視覺識別領(lǐng)域的運(yùn)用進(jìn)程。視覺識別離不開通過大量的圖片訓(xùn)練增強(qiáng)其對相似視覺元素特性的規(guī)律總結(jié)能力,我們可以將這一思路運(yùn)用在編碼壓縮領(lǐng)域,通過大量的視頻壓縮訓(xùn)練使機(jī)器學(xué)習(xí)掌握洞悉視頻壓縮結(jié)構(gòu)規(guī)律的能力,極大程度優(yōu)化視頻編碼性能,提升用戶體驗。

根據(jù)統(tǒng)計,過去的2017年全球互聯(lián)網(wǎng)上有1.2萬億幅圖像產(chǎn)生,每一分鐘就有幾百萬張圖片被上傳至包括Facebook、Snapchat在內(nèi)的各大互聯(lián)網(wǎng)平臺;而視頻的數(shù)據(jù)量則更為龐大,預(yù)計全球互聯(lián)網(wǎng)視頻數(shù)據(jù)總量將在2021年達(dá)到近2000EB。

如此龐大的數(shù)據(jù)量無疑會為圖像識別與通訊網(wǎng)絡(luò)的發(fā)展帶來巨大挑戰(zhàn),受限于通訊資源,我們的實際傳輸帶寬資源遠(yuǎn)沒有視頻數(shù)據(jù)量所要求的那么充裕;若想借助有限的帶寬資源快速穩(wěn)定傳輸大量的圖像與視頻數(shù)據(jù),則離不開高效的視頻編碼解決方案。

講到這里,我想我們需要回顧一下視頻編碼的發(fā)展歷程。早期視頻編碼變革較快:四年間MPEG-1發(fā)展到MPEG-2,所帶來的碼率節(jié)省約為50%,編碼效率翻倍,復(fù)雜度增長為5%左右;而H.264(AVC)發(fā)展到H.265(HEVC),雖然編碼效率仍有部分提高,但其背后復(fù)雜度增長卻十分顯著達(dá)到了二至十倍,實測可能更高。復(fù)雜度增長是現(xiàn)在編碼發(fā)展的一個明顯趨勢,而從右側(cè)數(shù)據(jù)中我們可以看出,隨著編碼標(biāo)準(zhǔn)的演進(jìn),編碼增益的成長也十分顯著:從初期AVC的9個Modes發(fā)展到HEVC的35個Modes;除此之外,早期的MPEG-1與MPEG-2是基于8x8的DCT變換,而發(fā)展到了AVC則實現(xiàn)了4x4與8x8的DCT,HEVC更是實現(xiàn)了4x4~32x32 DCT與4x4 DST;至于H.266還引入了預(yù)測模式,60多種預(yù)測模式使得相關(guān)參數(shù)復(fù)雜程度進(jìn)一步提升。從中我們不難看出,視頻壓縮一直基于信號處理技術(shù)并不斷進(jìn)行演進(jìn),而信號處理技術(shù)發(fā)展到現(xiàn)在已經(jīng)很難再產(chǎn)生顛覆性革新。隨著技術(shù)的發(fā)展,邊際效應(yīng)愈發(fā)明顯,技術(shù)突破愈發(fā)困難,因此我們迫切需要一種編碼壓縮的新思路。

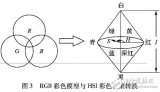

這種新思路就是結(jié)合用戶感知對編碼過程進(jìn)行優(yōu)化。用戶感知與QoE緊密相關(guān),人類視網(wǎng)膜大約擁有十億視覺細(xì)胞,這使得人眼成為一臺十億像素的高清相機(jī);大腦皮層會識別分析處理這些視覺信號,但連接人眼與大腦皮層的神經(jīng)細(xì)胞僅有一萬個左右,這就像一個資源十分有限的窄帶帶寬,那么人眼是如何利用這樣一個窄帶帶寬傳輸像素高達(dá)十億的高清視覺信號呢?這就是人作為高級動物的智慧所在:研究人的視覺感知模型我們可以發(fā)現(xiàn),在人眼可感知的視角內(nèi),真正會引起大腦皮層明顯興奮的區(qū)域僅為2~3度;換句話說,人的視覺會將感知重點放在感興趣的目標(biāo)區(qū)域。由此啟發(fā),我們可通過降低感知冗余進(jìn)一步提升視頻壓縮效率。

基于人類智慧我們提出了感知視頻壓縮并努力降低感知冗余。首先我們明確了如何察覺到視頻感知冗余的出現(xiàn),解決方案是借助機(jī)器學(xué)習(xí)與計算機(jī)視覺檢測出視頻畫面里用戶會重點關(guān)注的部分;當(dāng)監(jiān)測到感知冗余出現(xiàn)之后,我們嘗試減少感知冗余與其影響,解決方案是重新分配資源,將更多碼率與復(fù)雜度分配到用戶感興趣的視覺感知區(qū)域;接下來我們嘗試將視頻感知冗余的優(yōu)化運(yùn)用在全景視頻之上,使得視頻壓縮更加契合人類的視覺習(xí)慣,也就是我們所說的面向QoE的感知視頻編碼。

2.基于數(shù)據(jù)驅(qū)動實現(xiàn)視頻顯著性檢測

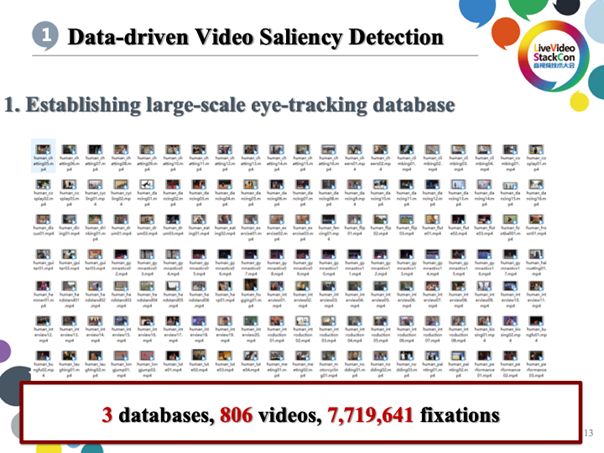

視頻顯著性檢測是指通過計算機(jī)視覺技術(shù)推斷用戶觀看視頻時視覺感知重點集中的區(qū)域,主要借助基于機(jī)器學(xué)習(xí)的CV。其大致步驟為建庫、分析與建模;我們的建庫工作開始于2015年,初期主要依靠眼動儀檢測志愿者觀看視頻時視覺關(guān)注重點的變化從而生成熱點圖數(shù)據(jù)庫;建庫之后我們對熱點數(shù)據(jù)進(jìn)行了特征分析,隨后依據(jù)特征分析結(jié)果建立深度學(xué)習(xí)模型從而初步實現(xiàn)了視頻顯著性檢測。

現(xiàn)在我們針對視頻已建立三個包括八百多個視頻的數(shù)據(jù)庫,共積累七百多萬個關(guān)注點。

在完成數(shù)據(jù)庫的建立之后,我們對數(shù)據(jù)庫進(jìn)行分析,并對顯著性進(jìn)行可視化。上圖展示的就是多位志愿者觀看視頻時視覺重點關(guān)注的位置變化數(shù)據(jù),借助此數(shù)據(jù)可生成視覺熱點圖,偏向紅色的區(qū)域代表視覺關(guān)注重點而偏向藍(lán)色的區(qū)域則代表視覺關(guān)注程度較少,沒有顏色則代表不被關(guān)注。通過上圖展示的實驗數(shù)據(jù)我們可以發(fā)現(xiàn),人在觀看視頻時視覺感知系統(tǒng)不會過多關(guān)注視頻畫面的背景部分而會重點關(guān)注目標(biāo)元素尤其是運(yùn)動的人與物。

為了找到能夠支撐上述結(jié)論的有力依據(jù),我們嘗試通過深度學(xué)習(xí)模型預(yù)測視覺關(guān)注重點。首先我們基于對目標(biāo)物體的檢測來構(gòu)建網(wǎng)絡(luò),接下來針對容易吸引視覺關(guān)注的運(yùn)動物體我們構(gòu)建了Motion Subnet用以優(yōu)化對運(yùn)動物體的檢測識別;在分別準(zhǔn)確識別了物體與其運(yùn)動狀態(tài)之后,我們借助借助Cross-net mask實現(xiàn)綜合分析二者數(shù)據(jù)得到運(yùn)動物體的動態(tài)參數(shù),并通過經(jīng)歷多次迭代的深度學(xué)習(xí)得出具備預(yù)測視覺關(guān)注重點的深度學(xué)習(xí)網(wǎng)絡(luò)。初期此網(wǎng)絡(luò)檢測精度依舊有限只能檢測識別整個運(yùn)動的物體,但經(jīng)過多達(dá)150K代的迭代以后,現(xiàn)已可實現(xiàn)對物體局部的某一運(yùn)動部分(如汽車正在旋轉(zhuǎn)的車輪)進(jìn)行準(zhǔn)確識別檢測。

完成了CNN網(wǎng)絡(luò)的構(gòu)建,隨后我們又將CNN網(wǎng)絡(luò)特征輸入進(jìn)SS-ConvLSTM從而使得系統(tǒng)能夠準(zhǔn)確推測幀與幀間視覺關(guān)注重點的相關(guān)性。為了實現(xiàn)這樣的功能,我們提出了Center-bias Dropout ,其依據(jù)在于人眼更容易將畫面的中心區(qū)域作為視覺關(guān)注重點,除了人類遺傳導(dǎo)致人的視覺系統(tǒng)會將視覺中央附近的物體作為感知重點之外,主要的原因還有攝影師拍攝畫面時自然會把拍攝主體放在畫面中央。這就使得即使系統(tǒng)不對視頻進(jìn)行內(nèi)容分析,也能大致確定某視頻用戶的視覺關(guān)注重點會分布在畫面中央附近。

除此之外我們也提出了Sparsity-weighted loss(稀疏加權(quán)損失函數(shù)),主要用于對目標(biāo)物體與關(guān)注重點區(qū)域的定量分析,下圖展示的是我們的定量結(jié)果,可以看到性能好于其他多種算法。

通過測試上述的分析流程我們得到了上圖展示的測試數(shù)據(jù):以人臉檢測為例,“Human”行代表人類視覺實際的重點關(guān)注區(qū)域,“Ours”行代表計算機(jī)預(yù)測的視覺顯著性結(jié)果,可以看到與真實區(qū)域基本重疊,而相對于下面幾行代表的傳統(tǒng)方法在準(zhǔn)確度上優(yōu)勢明顯。

下圖展示的是我們在此研究上主要發(fā)表的論文。

3.面向一般視頻的感知視頻壓縮編碼

接下來將重點介紹有關(guān)感知視頻編碼在一般視頻場景中的應(yīng)用。

3.1 編碼優(yōu)化

編碼優(yōu)化是必不可少的優(yōu)化思路。

速率失真優(yōu)化

首先我們進(jìn)行了速率失真優(yōu)化,也就是在控制一定碼率的同時盡可能降低失真或在控制失真的同時盡可能降低碼率。速率失真優(yōu)化主要包括借助基于感知模型的碼率控制實現(xiàn)指標(biāo)優(yōu)化與基于機(jī)器學(xué)習(xí)預(yù)測壓縮失真的位置與特性實現(xiàn)質(zhì)量增強(qiáng)。

復(fù)雜度失真優(yōu)化

復(fù)雜度失真優(yōu)化主要包括以下兩方面工作:首先是在保證質(zhì)量的同時盡可能降低復(fù)雜度,其次是將復(fù)雜度控制在目標(biāo)值之下并確保失真盡可能少。

進(jìn)一步落實優(yōu)化算法,我們期待通過算法盡可能減少失真與其帶來的影響。

1)針對HEVC感知視頻編碼的閉型質(zhì)量優(yōu)化

根據(jù)上圖展示的公式我們可以看到算法的原理是盡可能(減少第n塊的碼率分配)并引入Wn(Predicted Saliency)顯著性預(yù)測,將其作為權(quán)重加入失真優(yōu)化當(dāng)中,顯著性越高失真影響越大那么系統(tǒng)對其優(yōu)化越明顯。如果不引入Wn僅依賴(it模型),經(jīng)過多次迭代之后客觀情況下可達(dá)到5%的碼率節(jié)省而在主觀情況下基本可達(dá)到一半左右的碼率節(jié)省。

例如上圖中下半部分展示的視頻畫面中左側(cè)熱力圖表示觀眾對人臉的關(guān)注重點發(fā)布,但可以比較明顯地看到人物眼睛與嘴巴的位置較為模糊,嚴(yán)重影響觀看體驗;此時我們就會著重對眼睛與嘴巴區(qū)域的畫面進(jìn)行優(yōu)化,將更多碼率調(diào)整至人臉部位尤其眼睛和嘴巴的位置從而盡可能降低眼睛與嘴巴所在畫面位置的失真。這種碼率調(diào)整會將更多碼率資源用在人臉的眼睛與嘴巴等視覺重點區(qū)域,也會同時降低背景部分的碼率,這種主觀保證視覺重點區(qū)域編碼質(zhì)量的方案可使編碼效率與性能提升一倍。

2)針對視頻壓縮的多幀質(zhì)量提升

接下來我們需要將此技術(shù)用于提升多幀畫面的編碼質(zhì)量。通過實驗我們發(fā)現(xiàn),幾乎所有的編碼標(biāo)準(zhǔn)都會使視頻質(zhì)量出現(xiàn)明顯波動,尤其HEVC編碼會導(dǎo)致幀與幀之間的編碼質(zhì)量差異過大。體現(xiàn)在畫面上的結(jié)果可能是第50、61幀質(zhì)量較高畫面較為清晰而到了第87幀則被遭到丟棄使其難以恢復(fù)原有質(zhì)量。此時我們需要依賴87幀前后質(zhì)量較高幀的幫助,進(jìn)一步還原提升87幀的質(zhì)量,這就是多幀質(zhì)量提升操作。進(jìn)行多幀質(zhì)量提升之前,我們需要借助SVM對每一幀進(jìn)行質(zhì)量評估并選取其中質(zhì)量不一的幀構(gòu)造其特征并分類:ln=1代表高質(zhì)量幀ln=0代表低質(zhì)量幀。

在確定高質(zhì)量幀與低質(zhì)量幀后,系統(tǒng)會在處理視頻的同時將低質(zhì)量目標(biāo)幀與其前后相鄰高質(zhì)量幀一并輸入神經(jīng)網(wǎng)絡(luò),借助運(yùn)動補(bǔ)全方法使得目標(biāo)幀與其前后相鄰兩幀像素內(nèi)容一致,編碼近似,憑借機(jī)器學(xué)習(xí)得到的優(yōu)化算法處理這三幀從而顯著提高其壓縮質(zhì)量。如畫面當(dāng)中球所在的區(qū)域,畫面質(zhì)量較高。

上圖展示的是我們測試得到的主觀指標(biāo),Ave一行代表平均測試結(jié)果。可以看到我們MFQE的質(zhì)量提升平均值達(dá)到了0.5102dB,領(lǐng)先于前者多種算法。下圖展示的是直觀帶來的優(yōu)化體驗,可以看到畫面中籃球所在畫面區(qū)域的質(zhì)量重建提升十分明顯。

3.2 復(fù)雜度降低

大家知道,H.265、H.266的最大貢獻(xiàn)是CTU分割,并且H.266引入了二叉樹與三叉樹,其背后復(fù)雜程度十分驚人。例如在CU分割時,由于無法準(zhǔn)確預(yù)判分割塊的編碼性能優(yōu)劣,只能通過預(yù)編碼也就是對RDO進(jìn)行全局搜索的形式確定分割塊的編碼性能;由此導(dǎo)致的編譯次數(shù)增多會使其復(fù)雜度占總體高達(dá)80%。

為了進(jìn)一步降低復(fù)雜程度,我們可借助內(nèi)容分析推測合適的CU分割策略。對于單幀可通過CNN挖掘其在空間上的相關(guān)性;

而對于多個相連幀可通過CNN+LSTM分析得出其在分割上的相關(guān)性與一致性。

之后我們的探索主要分為三步完成:首先是建立一個包括115個視頻與兩千多幅圖像的數(shù)據(jù)庫,接下來我們運(yùn)用特征分析方法構(gòu)建結(jié)構(gòu)性輸出,最后利用卷積神經(jīng)網(wǎng)絡(luò)預(yù)測塊分割策略。

上圖展示的是降低復(fù)雜度帶來的性能提升。在幀間模式上我們的復(fù)雜度可降低約54%,與此同時BDBR增加約1.459%,BDPSNR損失約0.046%;對于幀內(nèi)模式而言同時測試圖像與視頻,無論是視頻還是圖像其復(fù)雜度都會降低約60%,與此同時BDBR增加約2%。下圖展示的是我們與此技術(shù)相關(guān)的部分技術(shù)專利。

4.面向全景視頻的感知視頻壓縮編碼

接下來將為大家介紹我們針對全景視頻進(jìn)行的感知壓縮編碼優(yōu)化。

全景視頻的感知壓縮編碼主要分為以下三個步驟:第一步進(jìn)行的Model預(yù)測主要是用于判斷用戶觀看全景視頻時人眼視野關(guān)注到的畫面區(qū)域;第二步進(jìn)行全景視頻質(zhì)量評估。最后進(jìn)行視頻編碼優(yōu)化。

4.1 Model預(yù)測

人類視覺系統(tǒng)對全景視頻的感知與普通視頻存在明顯區(qū)別:用戶在觀看全景視頻時視覺不會受到畫幅的限制,但人眼110度的視覺角度只占全景視頻180度甚至360度廣幅畫面中的一部分,而人眼真正關(guān)注的視覺重點可能最多在60度左右;通俗來說用戶在觀看全景視頻時畫面中的很多內(nèi)容是無法感知的。這就是我們在實現(xiàn)全景視頻的感知壓縮編碼時首要解決的問題:哪些區(qū)域是用戶視覺重點關(guān)注的?全景視頻的視角變化與用戶頭部運(yùn)動的狀態(tài)有關(guān),我們可從用戶頭部運(yùn)動入手,借助機(jī)器學(xué)習(xí)對用戶頭部運(yùn)動與設(shè)備的交互所決策的視野角度進(jìn)行強(qiáng)化學(xué)習(xí)訓(xùn)練;而人類頭部的運(yùn)動狀態(tài)與交互行為是根據(jù)全景視頻內(nèi)容展現(xiàn)的環(huán)境而改變的;這種根據(jù)環(huán)境變化得到的頭部運(yùn)動狀態(tài)與交互反饋信息能讓我們準(zhǔn)確得到經(jīng)優(yōu)化構(gòu)造而成的最優(yōu)回報函數(shù)(Reward),讓用戶在自己最為感興趣的目標(biāo)畫面上得到最佳的用戶體驗;最后我們通過深度學(xué)習(xí)進(jìn)一步優(yōu)化此回報函數(shù)得出其最佳策略,再將此策略運(yùn)用于對用戶頭部運(yùn)動狀態(tài)的預(yù)測判斷;擁有了用戶頭部運(yùn)動狀態(tài)的預(yù)測信息,我們就可以預(yù)測推斷用戶視野的變化并將其用于視頻畫面的感知壓縮編碼。

圖中上半部分展示的是我們通過多人實驗得到的可用于全景識別感知預(yù)測的DRL Network模型的架構(gòu)。根據(jù)圖中下半部分展示的測試結(jié)果,我們能從中得出視覺熱點圖。

下圖同樣展示了我們的定量測試結(jié)果。

4.2 全景識別與質(zhì)量評估

為了實現(xiàn)質(zhì)量評估,我們首先構(gòu)建了有包括60個無失真的基準(zhǔn)視頻在內(nèi)的600個全景視頻的全景識別數(shù)據(jù)庫。其中的基準(zhǔn)視頻采用了ERP、RCMP、TSP三種映射模式并使用27、37、42三種QP規(guī)格的壓縮方式。我們請大約221個觀測對象為多個全景視頻集評分并使每個全景視頻擁有約20個評分?jǐn)?shù)據(jù);評分同時我們也會收集被測對象頭部的運(yùn)動狀態(tài)、視野位置、眼部運(yùn)動狀態(tài)等關(guān)鍵數(shù)據(jù)。

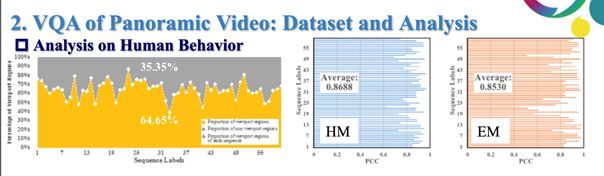

整理分析這些信息我們可得到多項結(jié)論:

1)左側(cè)圖線代表是人們視野不關(guān)注的比例變化,平均有35%的區(qū)域是用戶從未關(guān)注到的;側(cè)圖線代表頭部與眼睛運(yùn)動的一致性,縱坐標(biāo)代表視頻而橫坐標(biāo)代表相關(guān)系數(shù),可以看到頭部運(yùn)動狀態(tài)與眼部運(yùn)動狀態(tài)相關(guān)性保持較高,由此我們可得出結(jié)論:用戶觀看全景視頻時的行為習(xí)慣相似,畫面中有約30%的內(nèi)容被視覺系統(tǒng)忽視。

2)用戶行為與全景視頻質(zhì)量的關(guān)系:畫面中用戶看不到或者不愿意觀看的非重點部分的質(zhì)量變化對用戶觀看體驗的影響微乎其微;將用戶頭部運(yùn)動狀態(tài)、視野變化、眼動狀態(tài)與PSNR相結(jié)合可大幅度提升PSNR性能,即可推斷出頭部運(yùn)動狀態(tài)、眼動狀態(tài)等用戶行為可被用于提升全景視頻質(zhì)量評估性能。

基于以上研究,我們可針對全景視頻提出基于深度學(xué)習(xí)的質(zhì)量預(yù)測方法,也就是將頭部運(yùn)動狀態(tài)檢測與眼動狀態(tài)檢測得到的數(shù)據(jù)用于評估不同優(yōu)化模型得出的全景視頻質(zhì)量并將輸出的質(zhì)量分?jǐn)?shù)與其相關(guān)性進(jìn)行比較。如傳統(tǒng)方法得到的PCC模型預(yù)測值約為0.78,而SRCC模型則可達(dá)到0.81,從而進(jìn)一步提升全景視頻質(zhì)量評估結(jié)果。

下圖展示的是與此項研究相關(guān)的一些References。

5.總結(jié)

最后總結(jié)一下,首先我們的這些技術(shù)離不開數(shù)據(jù)的澎湃力量;其次全新的感知模型擁有非凡的編碼優(yōu)化潛力,最后是未來層出不窮的創(chuàng)新媒體渠道與應(yīng)用模式離不開技術(shù)的強(qiáng)大力量。

-

編碼技術(shù)

+關(guān)注

關(guān)注

1文章

35瀏覽量

11185 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8487瀏覽量

133994

原文標(biāo)題:編碼壓縮新思路:面向QoE的感知視頻編碼

文章出處:【微信號:livevideostack,微信公眾號:LiveVideoStack】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

處理圖像和視頻編碼中,基于感知視頻編碼優(yōu)化框架

最新視頻編碼標(biāo)準(zhǔn)H.264及其核心技術(shù)

面向頻譜感知的傳感器網(wǎng)絡(luò)設(shè)計

Agilent N2X IPTV QoE Test Solu

基于PCI的視頻編碼卡的設(shè)計與實現(xiàn)

H.264視頻編碼基本知識

淺析移動通信網(wǎng)絡(luò)中的QoE

HSDPA系統(tǒng)中一種感知用戶終端緩存狀態(tài)的QoE保障調(diào)度算法

一種面向視頻感知的靜電力觸覺渲染方法

字典學(xué)習(xí)的壓縮感知視頻編解碼模型

AI視頻編碼技術(shù)創(chuàng)新 探索極致視覺體驗

面向機(jī)器視覺的視頻編碼將成為5G和后5G時代的主要增量流量來源之一

什么是視頻編碼 常見的視頻編碼格式有哪些

實時互動下視頻QoE端到端輕量化網(wǎng)絡(luò)建模

面向QoE的感知視頻編碼

面向QoE的感知視頻編碼

評論