在當今快速發展的人工智能領域,算力成為決定模型訓練與推理速度的關鍵因素之一。為了提高計算效率,不同精度的數據類型應運而生,包括FP64、FP32、FP16、TF32、BF16、int8以及混合精度等。本文將淺顯易懂地介紹這些精度計算方式及其差別。

什么是精度?

精度,是數據表示的一個重要參數,它決定了數據的準確性。在計算機科學中,精度通常與數值表示的位數有關。對于浮點數,精度取決于浮點數的存儲方式,即占用的比特數(bits)越多,精度越高。

為了更直觀的理解,舉個例子:假設你每秒鐘賺到的錢是1塊錢,那一個月的收入是1*60*60*24*30=216000,如果每秒鐘賺到1塊1呢,那一個月的收入是237600,就一個1毛錢的小數點,讓你月收入少了1萬多,這就是精度不同導致的差異。

另外一個典型的例子是π,常用3.14表示,但是如果要更高精度,小數點后面可以有無數位。

為什么需要不同的精度?

為什么要有這么多精度,因為成本和準確度。

都知道精度高肯定更準確,但是也會帶來更高的計算和存儲成本。較低的精度會降低計算精度,但可以提高計算效率和性能。所以多種不同精度,可以讓你在不同情況下選擇最適合的一種。在人工智能領域,不同的應用場景對精度的需求各不相同。例如,在深度學習模型的訓練中,需要大量的數據進行計算,如果精度過高,會導致計算量巨大,訓練時間延長;而如果精度過低,則可能影響模型的準確性。因此,為了在保證準確性的前提下提高計算效率,就需要使用不同的精度。

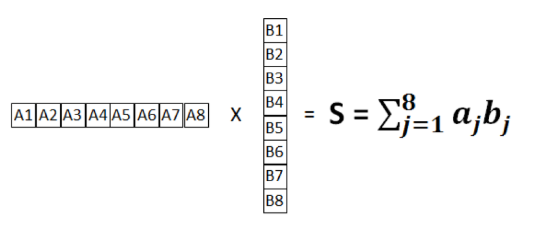

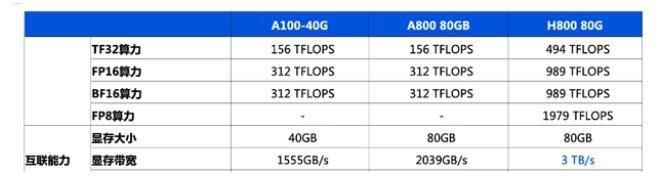

精度分類及對比算力精度指的是計算過程中使用的數值精度。分為浮點計算(半精度、單精度、雙精度)和整型計算,不同精度的運算代表了在計算中使用不同的位數,影響了計算速度、精度和能耗。

FP64

雙精度浮點數,占用64位空間。常用于大規模科學計算、工程計算、金融分析等對高精度有嚴格要求的算法領域。

FP32

單精度浮點數,占據32位空間。相較于雙精度浮點數,其存儲空間較小,精度也略低,一般應用于科學計算、圖形渲染、深度學習訓練和推理等。在大多數通用計算任務和科學計算中,FP32被廣泛使用。它在性能與精度之間提供了較好的平衡,適合需要較高精度的計算任務。

FP16

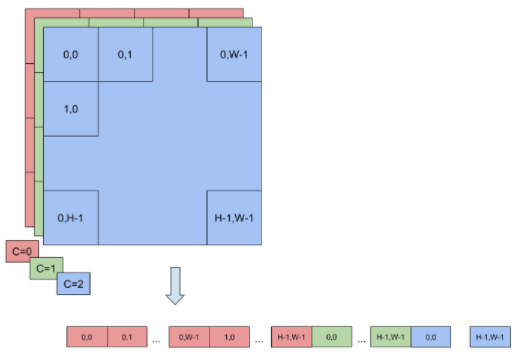

半精度浮點數,僅占用16位空間。存儲空間大幅減小,精度進一步降低,通常在模型訓練過程中用于參數和梯度的計算,應用于深度學習推理、圖形渲染、某些嵌入式系統等,特別是在需要減少內存和計算資源消耗時。

TF32

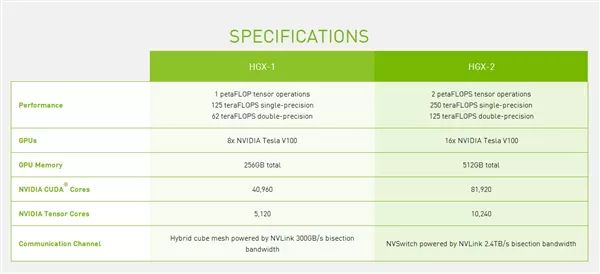

一種由NVIDIA引入的用于深度學習計算的格式,是使用 Tensor Core 的中間計算格式,它在內部使用FP32進行計算,但在存儲和通信時使用FP16。

INT8

是8位整數運算,通常用于量化后的深度學習模型推理。INT8的表示范圍進一步縮小,但其計算速度非常快,且能顯著降低能耗和內存占用,廣泛應用于需要高效能效比的應用場景,如邊緣計算、車輛和移動設備上的AI推理。

在人工智能模型訓練和推理中,根據模型的復雜度和性能要求,選擇合適的算力精度。例如,如果您的模型對精度要求不高,那么可以使用半精度(FP16)或單精度(FP32)浮點計算,以加快計算速度;如果精度要求非常高,那么可能需要使用雙精度(FP64)浮點計算。

-

人工智能

+關注

關注

1805文章

48898瀏覽量

247875 -

算力

+關注

關注

2文章

1173瀏覽量

15553

發布評論請先 登錄

計算精度對比:FP64、FP32、FP16、TF32、BF16、int8

計算精度對比:FP64、FP32、FP16、TF32、BF16、int8

評論