周志華,南京大學(xué)教授,計(jì)算機(jī)系主任,南京大學(xué)人工智能學(xué)院院長,歐洲科學(xué)院外籍院士,美國計(jì)算機(jī)學(xué)會 (ACM)、美國科學(xué)促進(jìn)會 (AAAS)、國際人工智能學(xué)會 (AAAI) 、國際電氣電子工程師學(xué)會 (IEEE) 、國際模式識別學(xué)會 (IAPR)、國際工程技術(shù) (IET/IEE) 等學(xué)會的會士,實(shí)現(xiàn)了 AI 領(lǐng)域會士大滿貫。

導(dǎo)讀:周志華教授從深度神經(jīng)網(wǎng)絡(luò)的深層含義說起,條分縷析地總結(jié)出神經(jīng)網(wǎng)絡(luò)取得成功的三大原因:

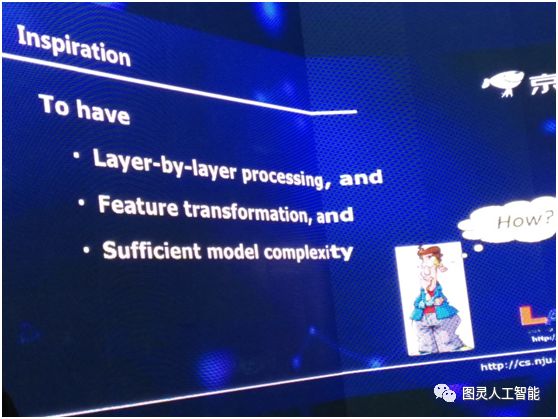

有逐層的處理

有特征的內(nèi)部變化

有足夠的模型復(fù)雜度

并得出結(jié)論:如果滿足這三大條件,則并不一定只能用深度神經(jīng)網(wǎng)絡(luò)。

各位嘉賓,各位朋友大家下午好!

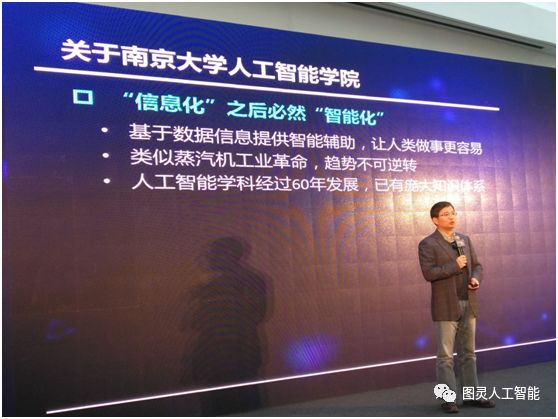

很高興今天下午來參加京東的這個活動,各位最近可能都聽說過我們南京大學(xué)成立了人工智能學(xué)院,這是中國C9高校(編輯注:C9高校是指北京大學(xué)、清華大學(xué)、復(fù)旦大學(xué)、上海交通大學(xué)、南京大學(xué)、浙江大學(xué)、中國科學(xué)技術(shù)大學(xué)、哈爾濱工業(yè)大學(xué)、西安交通大學(xué)共9所高校)的第一所人工智能學(xué)院。我們會和京東在科學(xué)研究和人才培養(yǎng)方面開展非常深度的合作。具體的合作內(nèi)容過一段時間會陸續(xù)地告訴大家。今天參加這個活動,謝謝伯文(編輯注:指周伯文博士,京東集團(tuán)副總裁,京東AI平臺與研究部負(fù)責(zé)人)的邀請,在跟伯文溝通的時候談到今天講些什么呢?伯文說,今天的會議會有很多對技術(shù)前沿感興趣的專家,所以希望我分享些我們對技術(shù)前沿的一些思考。所以,我今天就跟大家分享些我們對深度學(xué)習(xí)的一點(diǎn)點(diǎn)思考,僅供大家一起來討論。

我們知道今天人工智能很熱,人工智能背后掀起的熱潮技術(shù)之一就是深度學(xué)習(xí),當(dāng)我們談到深度學(xué)習(xí)的時候,在各種應(yīng)用場景中都應(yīng)用到它,包括圖像、視頻、聲音和自然語言處理等等,但是,如果我們問一個問題,什么是深度學(xué)習(xí)?可能大多數(shù)人差不多都會認(rèn)為,深度學(xué)習(xí)就等于深度神經(jīng)網(wǎng)絡(luò)。

我給大家看一個例子。有一個非常著名的學(xué)會是國際工業(yè)與應(yīng)用數(shù)學(xué)學(xué)會,他們有一個報紙叫 SIAM News。去年 6 月份的頭版上有一篇文章,它里面的重點(diǎn)說的就是深度學(xué)習(xí)是什么?它(深度學(xué)習(xí))是機(jī)器學(xué)習(xí)的一個子域(subfield),這里面要用深度神經(jīng)網(wǎng)絡(luò)。

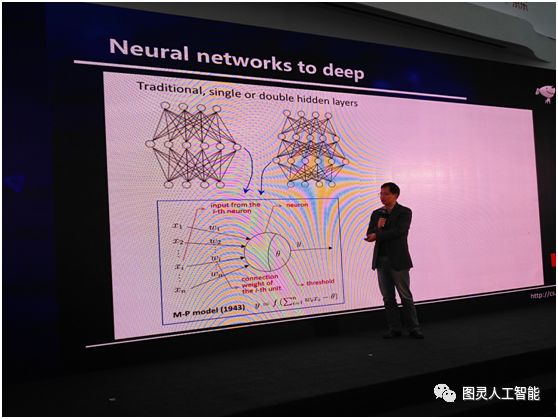

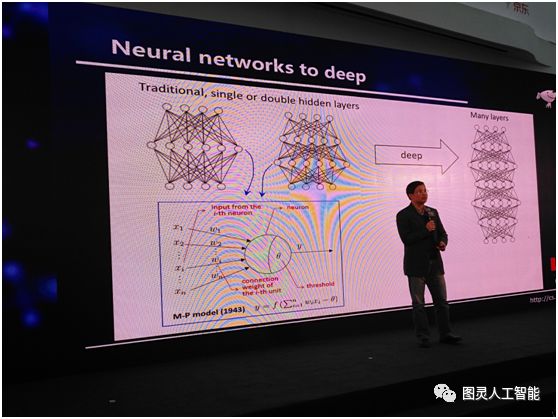

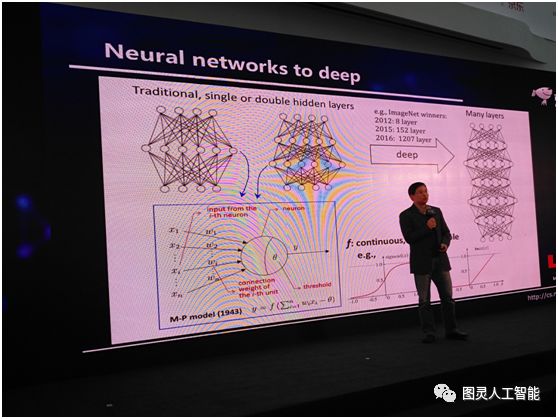

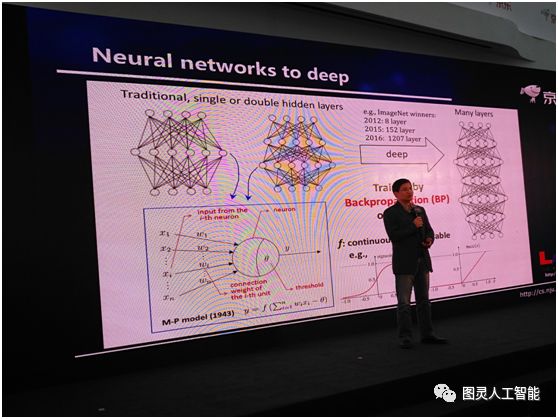

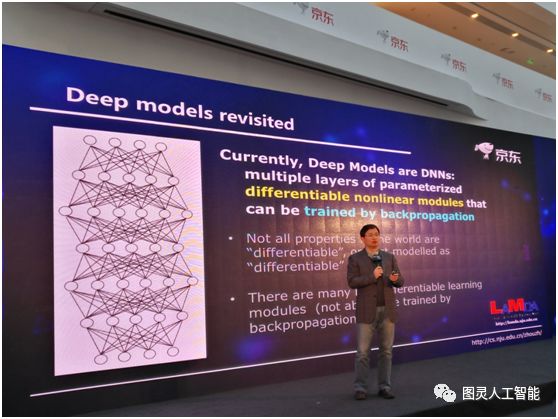

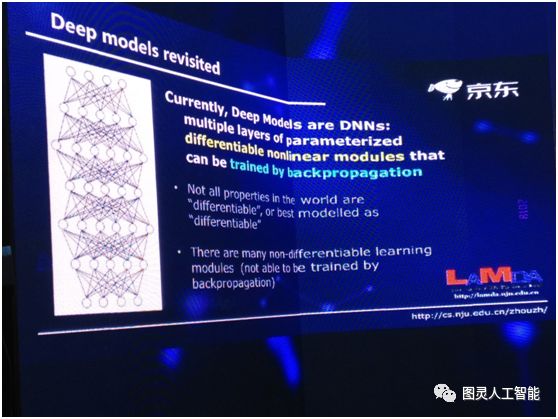

所以,基本上,如果我們要談深度學(xué)習(xí)的話,我們必須談深度神經(jīng)網(wǎng)絡(luò),或者必須從深度神經(jīng)網(wǎng)絡(luò)說起,神經(jīng)網(wǎng)絡(luò)并不是一個新生事物,它在人工智能界已經(jīng)研究了半個多世紀(jì)。以往的話,我們一般會用這樣的神經(jīng)網(wǎng)絡(luò),就是中間有一個隱層或者兩個隱層。在這樣的神經(jīng)網(wǎng)絡(luò)當(dāng)中,它的每個單元是個什么東西呢?其實(shí),網(wǎng)絡(luò)中的每個單元是一個非常簡單的計(jì)算模型,如下圖左下角所示,這個計(jì)算模型在半個世紀(jì)以前人們就已經(jīng)總結(jié)出來了。給定一些輸入,它們通過連接和放大,到達(dá)一個細(xì)胞之后,它的加和不超過一個閾值,就被激活。說穿了,它就是這么一個非常簡單的公式,深度神經(jīng)網(wǎng)絡(luò)就是很多這樣的公式通過嵌套和迭代得到的一個數(shù)學(xué)系統(tǒng)。

我們今天用到深度神經(jīng)網(wǎng)絡(luò)的時候,其實(shí)指的是什么呢?其實(shí)是指這個網(wǎng)絡(luò)的層數(shù)很深很深,很多層,大概是多少呢,給大家看一組數(shù)據(jù):2012年,ImageNet競賽的冠軍,用到的是8層;2015年,用到的是152層;2016年用到的是1207層;這是一個非常龐大的系統(tǒng),把這樣的一個系統(tǒng)訓(xùn)練出來,難度是非常大的。但是呢,我們有一個非常好的消息,神經(jīng)網(wǎng)絡(luò)中的計(jì)算單元的激活函數(shù)是連續(xù)的、可微的,比如說,我們在深度神經(jīng)網(wǎng)絡(luò)中,可能會用Sigmod函數(shù),有了這么一個性質(zhì)之后,我們會得到一個非常好的結(jié)果。這個結(jié)果就是現(xiàn)在我們可以很容易計(jì)算系統(tǒng)的梯度。因此就可以很容易用著名的 BP 算法(注:反向傳播算法)來訓(xùn)練這系統(tǒng)。

今天通過這樣的算法,神經(jīng)網(wǎng)絡(luò)已經(jīng)取得了非常多的勝利,但實(shí)際上在學(xué)術(shù)界大家一直沒有想清楚一件事情,就是我們?yōu)槭裁匆眠@么深的模式?可能今天有很多人會說深度學(xué)習(xí)已經(jīng)取得了很多的成功,但它一個很大的問題就是理論基礎(chǔ)不清楚,我們理論上還說不清楚它到底怎么做?為什么會成功?這里面的關(guān)鍵是什么?其實(shí)我們根本不知道該從什么角度去看它。因?yàn)槿绻覀円隼碚摲治龅脑挘紫葢?yīng)該有一點(diǎn)直覺,你到底因?yàn)槭裁从杏茫谶@條路上往前走才能有關(guān)鍵的結(jié)果。

關(guān)于深度神經(jīng)網(wǎng)絡(luò)為什么能深,其實(shí)這件事情到今天為止學(xué)術(shù)界都沒有統(tǒng)一的看法。在這里面給大家講一個我們前一段時間給出的論述,這個論述其實(shí)是從主要模型的復(fù)雜度的角度來討論的。

我們知道一個機(jī)器學(xué)習(xí)模型的復(fù)雜度實(shí)際上和它的容量有關(guān),而這個容量直接決定了它的學(xué)習(xí)能力,所以說學(xué)習(xí)能力和復(fù)雜度是有關(guān)的。其實(shí)我們老早就知道,如果我們能夠增強(qiáng)一個學(xué)習(xí)模型的復(fù)雜度,它的學(xué)習(xí)能力就能夠提升,那么怎樣去提高復(fù)雜度呢?

對神經(jīng)網(wǎng)絡(luò)這樣的模型來說有兩條很明顯的途徑,一條是我們把模型變深,一條是我們把它變寬,但是如果從提升復(fù)雜度的角度,變深會更有效。當(dāng)你變寬的時候你只不過增加了一些計(jì)算單元、增加了函數(shù)的個數(shù),而在變深的時候不僅增加了個數(shù),其實(shí)還增加了嵌入的層次,所以泛函的表達(dá)能力會更強(qiáng)。所以從這個角度來說,我們應(yīng)該嘗試變深。

我們知道一個機(jī)器學(xué)習(xí)模型的復(fù)雜度實(shí)際上和它的容量有關(guān),而這個容量直接決定了它的學(xué)習(xí)能力,所以說學(xué)習(xí)能力和復(fù)雜度是有關(guān)的。其實(shí)我們老早就知道,如果我們能夠增強(qiáng)一個學(xué)習(xí)模型的復(fù)雜度,它的學(xué)習(xí)能力就能夠提升,那么怎樣去提高復(fù)雜度呢?

對神經(jīng)網(wǎng)絡(luò)這樣的模型來說有兩條很明顯的途徑,一條是我們把模型變深,一條是我們把它變寬,但是如果從提升復(fù)雜度的角度,變深會更有效。當(dāng)你變寬的時候你只不過增加了一些計(jì)算單元、增加了函數(shù)的個數(shù),而在變深的時候不僅增加了個數(shù),其實(shí)還增加了嵌入的層次,所以泛函的表達(dá)能力會更強(qiáng)。所以從這個角度來說,我們應(yīng)該嘗試變深。

給定一個數(shù)據(jù)集,我們希望把數(shù)據(jù)集里的東西學(xué)出來,但是有時候可能把這個數(shù)據(jù)本身的一些特性學(xué)出來了,而這個特性卻不是一般的規(guī)律。當(dāng)把學(xué)出來的錯誤東西當(dāng)成一般規(guī)律來用的時候,就會犯巨大的錯誤,這種現(xiàn)象就是過擬合。為什么會把數(shù)據(jù)本身的特性學(xué)出來?就是因?yàn)槲覀兊哪P蛯W(xué)習(xí)能力太強(qiáng)了。

所以以往我們不太用太復(fù)雜的模型,為什么現(xiàn)在我們可以用這樣的模型?其實(shí)有很多因素,第一個因素是現(xiàn)在我們有很大的數(shù)據(jù),那么比如說我手上如果只有 3000 多數(shù)據(jù),學(xué)出來的特性就不太可能是一般規(guī)律。但是如果有三千萬、甚至三千萬萬的數(shù)據(jù),那么這些數(shù)據(jù)里的特性本來就是一般規(guī)律,所以使用大的數(shù)據(jù)本身就是緩解過擬合的關(guān)鍵條件。

第二個因素,今天有很多很強(qiáng)大的計(jì)算設(shè)備,所以才能夠訓(xùn)練出這樣的模型,同時通過領(lǐng)域里很多學(xué)者的努力,我們有了大量關(guān)于訓(xùn)練這樣復(fù)雜模型的技巧和算法,所以這使得我們使用復(fù)雜模型成為可能。

按照這個思路來說,其實(shí)有三件事:第一,我們今天有更大的數(shù)據(jù);第二;有強(qiáng)力的計(jì)算設(shè)備;第三,有很多有效的訓(xùn)練技巧。

這導(dǎo)致我們可以用高復(fù)雜度的模型。而深度神經(jīng)網(wǎng)絡(luò)恰恰就是一種很便于實(shí)現(xiàn)的高復(fù)雜度的模型。所以這么一套理論解釋,如果我們說它是一個解釋的話,它好像是能告訴我們?yōu)槭裁次覀儸F(xiàn)在能用深度神經(jīng)網(wǎng)絡(luò)。為什么它能成功?就是因?yàn)閺?fù)雜度大。

在一年多之前,我們把這個解釋說出來的時候,其實(shí)國內(nèi)外很多同行也很贊同這么一個解釋,因?yàn)榇蠹矣X得這聽起來蠻有道理的,其實(shí)我一直對這個不是特別滿意,這是為什么?其實(shí)有一個潛在的問題我們一直沒有回答。如果從復(fù)雜度解釋的話,我們就沒有辦法說為什么扁平的或者寬的網(wǎng)絡(luò)做不到深度神經(jīng)網(wǎng)絡(luò)的性能?因?yàn)槭聦?shí)上我們把網(wǎng)絡(luò)變寬,雖然它的效率不是那么高,但是它同樣也能起到增加復(fù)雜度的能力。

實(shí)際上我們在 1989 年的時候就已經(jīng)有一個理論證明,說神經(jīng)網(wǎng)絡(luò)有萬有逼近能力:只要你用一個隱層,就可以以任意精度逼近任意復(fù)雜度的定義在一個緊集上的連續(xù)函數(shù)。

其實(shí)不一定要非常深。這里面我要引用一個說法,神經(jīng)網(wǎng)絡(luò)有萬有逼近能力,可能是有的人會認(rèn)為這是導(dǎo)致神經(jīng)網(wǎng)絡(luò)為什么這么強(qiáng)大的一個主要原因,其實(shí)這是一個誤解。

我們在機(jī)器學(xué)習(xí)里面用到的所有模型,它必須具有萬有逼近能力。如果沒有這個能力,根本不可用。所以最簡單的,哪怕傅立葉變換,它就已經(jīng)有這個能力,所以這個能力不是神經(jīng)網(wǎng)絡(luò)所特有的。那我們在這兒要強(qiáng)調(diào)的一件事情是什么?其實(shí)我只要有一個隱層,我加無限度的神經(jīng)元進(jìn)去,它的能力也會變得很強(qiáng),復(fù)雜度會變得很高。但是這樣的模型無論在應(yīng)用里面怎么試,我們發(fā)現(xiàn)都不如深度神經(jīng)網(wǎng)絡(luò)好。所以從復(fù)雜的角度可能很難解決這個問題,我們需要一點(diǎn)更深入的思考。

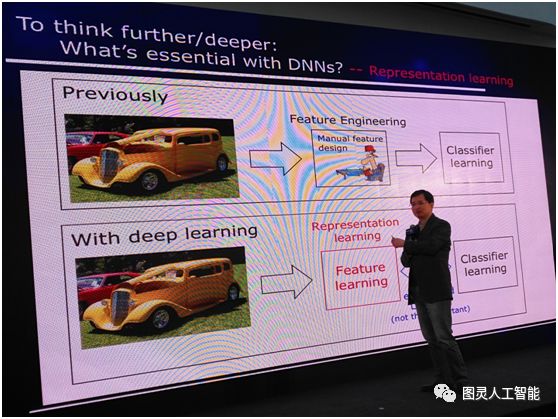

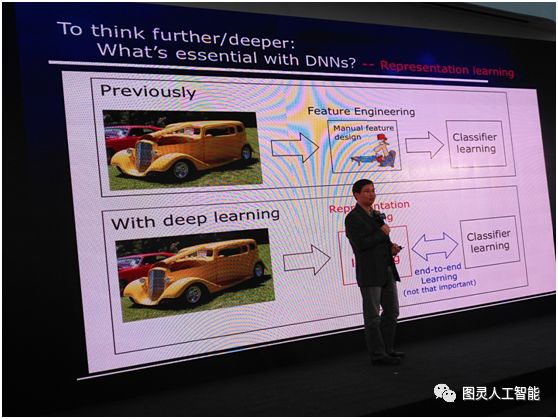

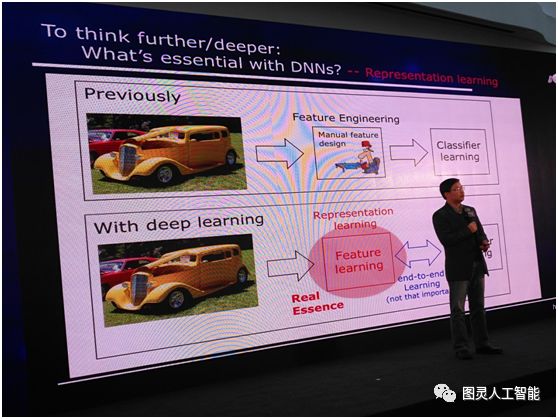

所以我們要問這么一個問題:深度神經(jīng)網(wǎng)絡(luò)里面最本質(zhì)的東西到底是什么?今天我們的答案可能是要做表示學(xué)習(xí)的能力。以往我們用機(jī)器學(xué)習(xí),首先拿到一個數(shù)據(jù),比如這個數(shù)據(jù)對象是一個圖像,我們就用很多特征把它描述出來,比如說顏色、紋理等等,這一些特征都是我們?nèi)祟悓<彝ㄟ^手工來設(shè)計(jì)的,表達(dá)出來之后我們再去進(jìn)行學(xué)習(xí)。

而今天我們有了深度學(xué)習(xí)之后,現(xiàn)在不再需要手工設(shè)計(jì)特征,把數(shù)據(jù)從一端扔進(jìn)去,模型從另外一端出來,中間所有的特征完全通過學(xué)習(xí)自己來解決,這是所謂的特征學(xué)習(xí)或者表示學(xué)習(xí),這和以往的機(jī)器學(xué)習(xí)技術(shù)相比是一個很大的進(jìn)步,我們不再需要完全依賴人類專家去設(shè)計(jì)特征了。

有時候我們的工業(yè)界朋友會說,這里面有一個很重要的叫做端到端學(xué)習(xí),大家認(rèn)為這個非常重要。其實(shí)這一件事情要分兩個方面來看:一個方面當(dāng)我們把特征學(xué)習(xí)和分類器學(xué)習(xí)聯(lián)合起來考慮,可以達(dá)到聯(lián)合優(yōu)化的作用,這是好的方面;但另一方面,如果這里面發(fā)生什么我們不清楚,這時候端到端的學(xué)習(xí)不一定真的好,因?yàn)榭赡艿谝徊糠滞鶘|,第二部分往西,合起來看往東走的更多一些,其實(shí)內(nèi)部有一些東西已經(jīng)抵消了。

實(shí)際上機(jī)器學(xué)習(xí)里面早就有端到端學(xué)習(xí),比如說做特征選擇,但這類方法是不是比其它特征選擇的方法要強(qiáng)?不一定,所以這不是最重要的,真正重要的還是特征學(xué)習(xí)或者表示學(xué)習(xí)。

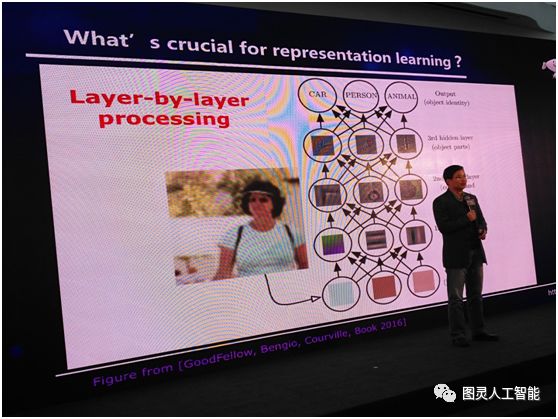

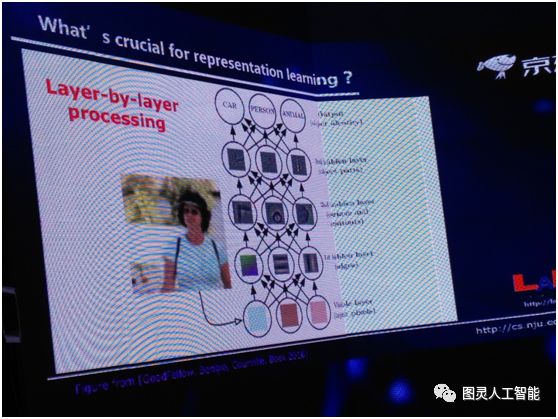

我們再問下一個問題,表示學(xué)習(xí)最關(guān)鍵的又是什么?對這件事情我們現(xiàn)在有這么一個答案,就是逐層的處理。現(xiàn)在我們就引用非常流行的《深度學(xué)習(xí)》一書里的一張圖,當(dāng)我們拿到一個圖像的時候,如果我們把神經(jīng)網(wǎng)絡(luò)看作很多層的時候,首先在最底層我們看到是一些像素的東西,當(dāng)我們一層一層往上的時候,慢慢的有邊緣,再往上有輪廓等等,在真正的神經(jīng)網(wǎng)絡(luò)模型里不一定有這么清晰的分層,但總體上確實(shí)是在往上不斷做對象的抽象。

而這個特點(diǎn),我們現(xiàn)在認(rèn)為這好像是深度學(xué)習(xí)真正成功的關(guān)鍵因素之一,因?yàn)楸馄缴窠?jīng)網(wǎng)絡(luò)能做很多深層神經(jīng)網(wǎng)絡(luò)所做的事,但是有一點(diǎn)它做不到:當(dāng)它是扁平的時候,就沒有進(jìn)行一個深度加工,所以深度的逐層抽象可能很關(guān)鍵。那如果我們再看一看,大家可能就會問,其實(shí)逐層處理這件事,在機(jī)器學(xué)習(xí)里也不是一個新東西。

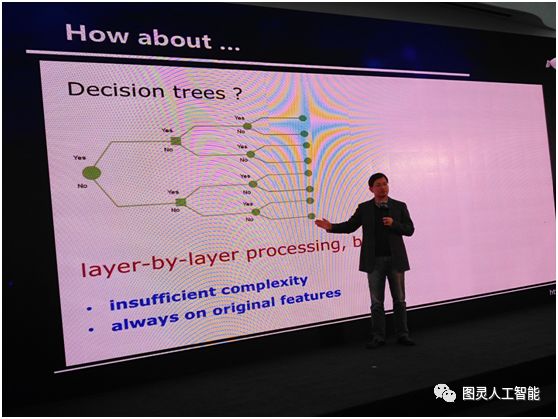

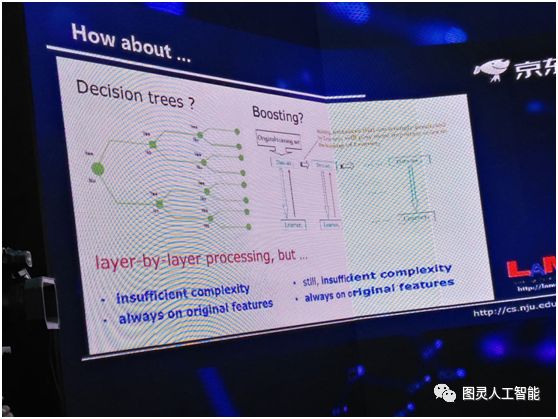

以前有很多逐層處理的東西,比如說決策樹,它就是逐層處理,這是非常典型的模型。這個已經(jīng)有五六十年的歷史了,但它為什么做不到深度神經(jīng)網(wǎng)絡(luò)這么好呢?首先它的復(fù)雜度不夠,因?yàn)闆Q策樹的深度,如果我們只考慮離散特征,其最深的深度不會超過特征的個數(shù),所以它的模型復(fù)雜度有上限;第二整個決策樹的學(xué)習(xí)過程中,它內(nèi)部沒有進(jìn)行特征變化,始終是在一個特征空間里面進(jìn)行,這可能也是一個問題。

大家如果對高級一點(diǎn)的機(jī)器學(xué)習(xí)模型有所了解,你可能會問,現(xiàn)在很多 Boosting 模型也是一層一層往下走,為什么它沒有取得深度學(xué)習(xí)的成功?我想問題其實(shí)差不多,首先復(fù)雜度還不夠,第二,更關(guān)鍵的一點(diǎn),它始終在原始空間里面做事情,所有的這些學(xué)習(xí)器都是在原始特征空間,中間沒有進(jìn)行任何的特征變換。

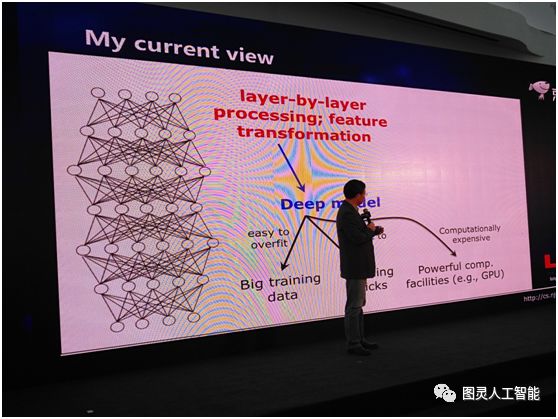

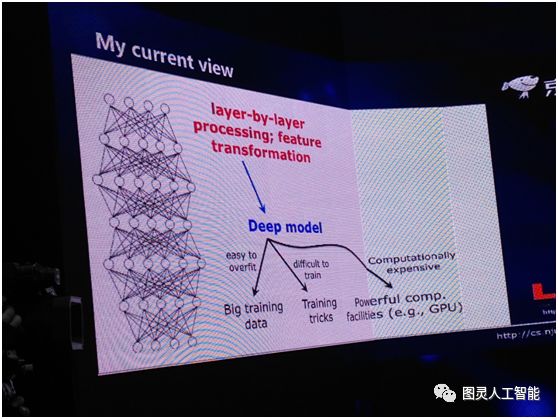

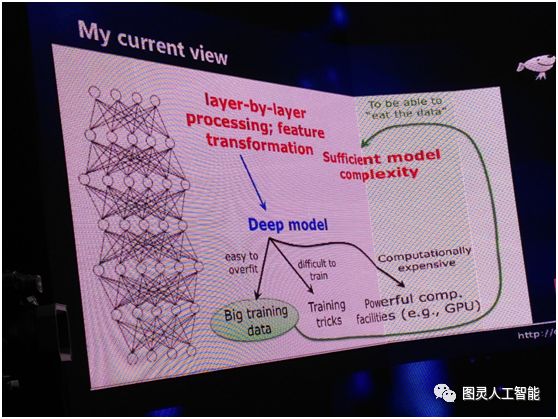

深度神經(jīng)網(wǎng)絡(luò)到底為什么成功?里面的關(guān)鍵原因是什么?我想首先我們需要兩件事,第一是逐層地處理,第二我們要有一個內(nèi)部的特征變換。而當(dāng)我們考慮到這兩件事情的時候,我們就會發(fā)現(xiàn),其實(shí)深度模型是一個非常自然的選擇。有了這樣的模型,我們很容易可以做上面兩件事。但是當(dāng)我們選擇用這么一個深度模型的時候,我們就會有很多問題,它容易 overfit,所以我們要用大數(shù)據(jù),它很難訓(xùn)練,我們要有很多訓(xùn)練的 trick,這個系統(tǒng)的計(jì)算開銷非常大,所以我們要有非常強(qiáng)有力的計(jì)算設(shè)備,比如 GPU 等等。

實(shí)際上所有這些東西是因?yàn)槲覀冞x擇了深度模型之后產(chǎn)生的一個結(jié)果,他們不是我們用深度學(xué)習(xí)的原因。所以這和以往我們的思考不太一樣,以往我們認(rèn)為有了這些東西,導(dǎo)致我們用深度模型,現(xiàn)在我們覺得這個因果關(guān)系恰恰是反過來的——因?yàn)槲覀円盟晕覀儾艜紤]上面的這些東西。

而另外還有一點(diǎn)我們要注意,當(dāng)我們要有很大的訓(xùn)練數(shù)據(jù)的時候,這就要求我們必須要有很復(fù)雜的模型。假設(shè)我們有一個線性模型的話,給你 2000 萬要的還是 2 億的樣本,其實(shí)對它不是太大區(qū)別,它已經(jīng)學(xué)不進(jìn)去。而我們有了充分的復(fù)雜度,其實(shí)我們看到恰恰它又給我們使用深度模型加了一分。

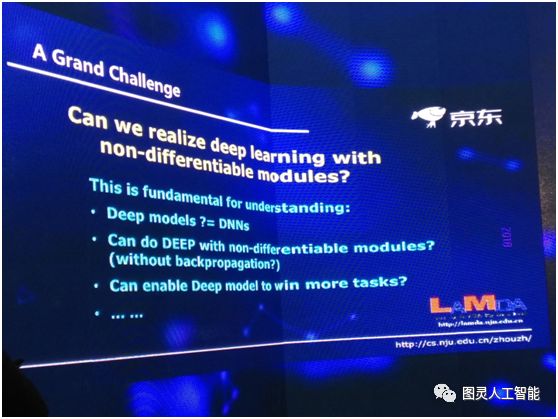

由于這幾個原因,我們才覺得可能這是深度學(xué)習(xí)里面最關(guān)鍵的事情。所以這是我們現(xiàn)在的一個認(rèn)識:第一我們要有逐層的處理;第二我們要有特征的內(nèi)部變化;第三,我們要有足夠的模型復(fù)雜度。

這三件事情是我們現(xiàn)在認(rèn)為深度神經(jīng)網(wǎng)絡(luò)為什么能夠成功的關(guān)鍵原因,或者說這是一個猜測。如果滿足這幾個條件,我其實(shí)可以馬上想到,不一定真的要用神經(jīng)網(wǎng)絡(luò),神經(jīng)網(wǎng)絡(luò)是選擇的幾個方案之一,我只要同時做到這三件事,別的模型也可以,并不一定只能用深度神經(jīng)網(wǎng)絡(luò)。

我們就要想一想,我們有沒有必要考慮神經(jīng)網(wǎng)絡(luò)之外的模型?其實(shí)是有的。因?yàn)榇蠹叶贾郎窠?jīng)網(wǎng)絡(luò)有很多缺陷。

第一,凡是用過深度神經(jīng)網(wǎng)絡(luò)的人都知道,你要花大量的精力來調(diào)它的參數(shù),因?yàn)檫@是一個巨大的系統(tǒng)。這里面會帶來很多問題,首先當(dāng)我們調(diào)參數(shù)的時候,這個經(jīng)驗(yàn)其實(shí)是很難共享的。有的朋友可能說,我在第一個圖像數(shù)據(jù)集之上調(diào)數(shù)據(jù)的經(jīng)驗(yàn),當(dāng)我用第二個圖像數(shù)據(jù)集的時候,這個經(jīng)驗(yàn)肯定可以重用的。但是我們有沒有想過,比如說我們在圖像方面做了一個很大的神經(jīng)網(wǎng)絡(luò),這時候如果要去做語音,其實(shí)在圖像上面調(diào)參數(shù)的經(jīng)驗(yàn),在語音問題上可能基本上不太有借鑒作用,所以當(dāng)我們跨任務(wù)的時候,經(jīng)驗(yàn)可能就很難有成效。

而且還帶來第二個問題,我們今天都非常關(guān)注結(jié)果的可重復(fù)性,不管是科學(xué)研究、技術(shù)發(fā)展,都希望這結(jié)果可重復(fù),而在整個機(jī)器學(xué)習(xí)領(lǐng)域里面,深度學(xué)習(xí)的可重復(fù)性是最弱的。我們經(jīng)常會碰到這樣的情況,有一組研究人員發(fā)文章報告了一個結(jié)果,而這結(jié)果其他的研究人員很難重復(fù)。因?yàn)槟呐履阌猛瑯拥臄?shù)據(jù)、同樣的方法,只要超參數(shù)的設(shè)計(jì)不一樣,你的結(jié)果就不一樣。

我們在用深度神經(jīng)網(wǎng)絡(luò)的時候,模型的復(fù)雜度必須事先指定,因?yàn)樵谟?xùn)練模型之前,神經(jīng)網(wǎng)絡(luò)是什么樣就必須定了,然后才能用 BP 算法等等去訓(xùn)練它。其實(shí)這就會帶來很大的問題,因?yàn)樵跊]有解決這個任務(wù)之前,我們怎么知道這個復(fù)雜度應(yīng)該有多大呢?所以實(shí)際上大家做的通常都是設(shè)更大的復(fù)雜度。

如果在座各位關(guān)注過去三四年里深度神經(jīng)網(wǎng)絡(luò)、深度學(xué)習(xí)領(lǐng)域的進(jìn)展,你可以看到很多最前沿的工作在做什么事呢?其實(shí)都是在有效地縮減網(wǎng)絡(luò)的復(fù)雜度。比如說 ResNet 網(wǎng)絡(luò),還有最近大家經(jīng)常用的模型壓縮等,其實(shí)我們想一想不都是把復(fù)雜度變小,實(shí)際上是先用了一個過大的復(fù)雜度,然后再降下來。

那么我們有沒有可能在一開始就讓這個模型的復(fù)雜度隨著數(shù)據(jù)而變化?這一點(diǎn)對神經(jīng)網(wǎng)絡(luò)可能很困難,但是對別的模型是有可能的。還有很多別的問題,比如說理論分析很困難,需要非常大的數(shù)據(jù),黑箱模型等等。

那么這些能不能用來構(gòu)建深度模型?能不能通過構(gòu)建深度模型之后得到更好的性能呢?能不能通過把它們變深之后,使得今天深度模型還打不過隨機(jī)森林這一些模型的任務(wù),能夠得到更好的結(jié)果呢?

那我們自己就受到這樣的一個啟發(fā),我們要考慮這三件事,就是剛才跟大家分析得到的三個結(jié)論:第一要做逐層處理,第二是特征的內(nèi)部變換,第三我們希望得到一個充分的模型復(fù)雜度。

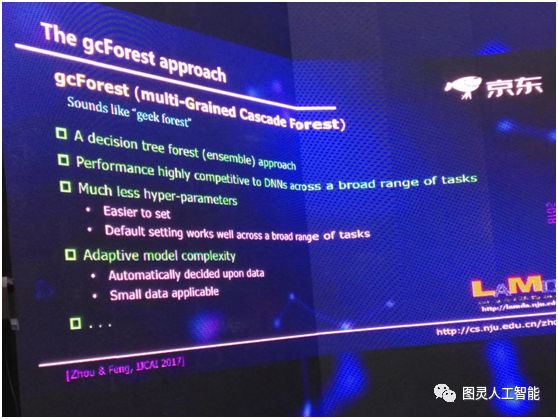

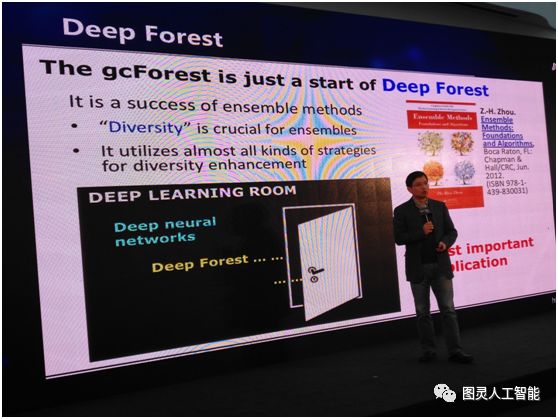

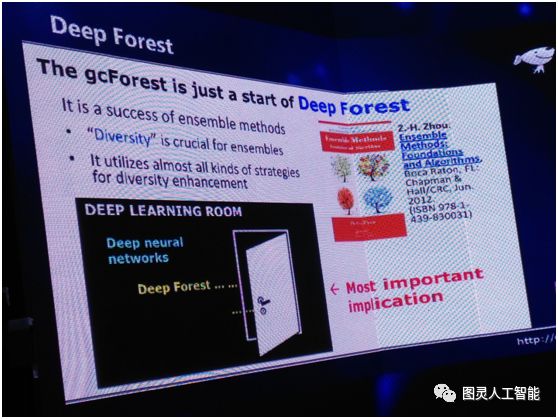

我自己領(lǐng)導(dǎo)的研究組最近在這一方面做了一些工作,我們最近提出了一個 深度森林的方法。

在這個方法里面我今天不跟大家講技術(shù)細(xì)節(jié),它是一個基于樹模型的方法,主要是借用集成學(xué)習(xí)的很多想法。其次在很多不同的任務(wù)上,它的模型得到的結(jié)果和深度神經(jīng)網(wǎng)絡(luò)是高度相似的,除了一些大規(guī)模的圖像等等。在其他的任務(wù)上,特別是跨任務(wù)表現(xiàn)非常好,我們可以用同樣一套參數(shù),用在不同的任務(wù)中得到不錯的性能,就不需要逐任務(wù)的慢慢調(diào)參數(shù)。

還有一個很重要的特性,它有自適應(yīng)的模型復(fù)雜度,可以根據(jù)數(shù)據(jù)的大小自動來判定該模型長到什么程度。它的中間有很多好的性質(zhì),有很多朋友可能也會下載我們的開源代碼拿去試,到時候我們會有更大規(guī)模分布式的版本等等,要做大的任務(wù)必須要有更大規(guī)模的實(shí)現(xiàn),就不再是單機(jī)版能做的事。

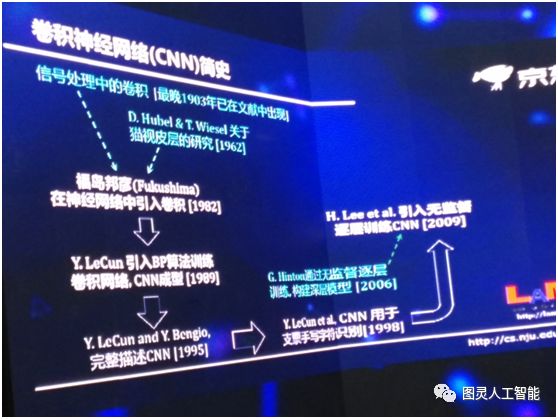

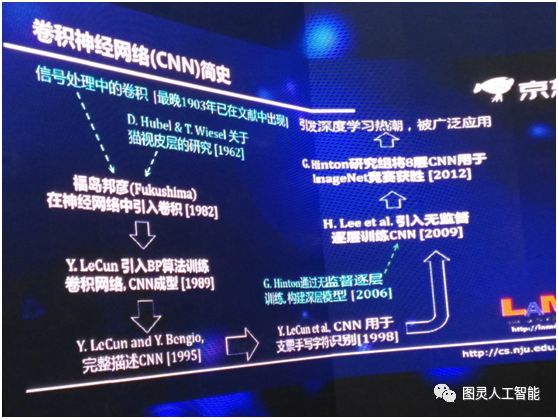

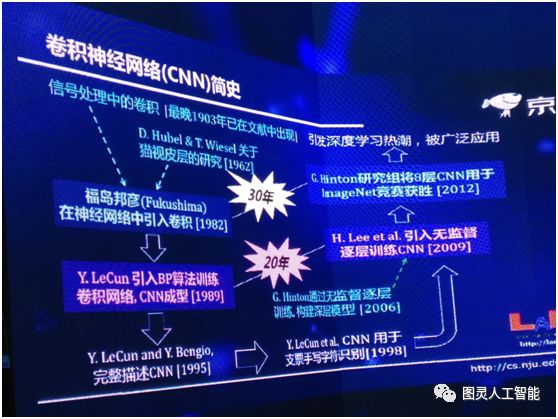

但另一方面,我們要看到這實(shí)際上是在發(fā)展學(xué)科思路上一個全新的思路探索,所以今天雖然它已經(jīng)能夠解決一部分問題了,但是我們應(yīng)該可以看到它再往下發(fā)展,前景可能是今天我們還不太能夠完全預(yù)見到的,所以我這邊簡單回顧一下卷積神經(jīng)網(wǎng)絡(luò),這么一個非常流行的技術(shù),它其實(shí)也是經(jīng)過了很長期的發(fā)展。

最早信號處理里面關(guān)于卷積的出現(xiàn),其實(shí)是有一個多世紀(jì)了,但是現(xiàn)在深度神經(jīng)網(wǎng)絡(luò)的歷史是從 1962 年兩位諾貝爾獎得主關(guān)于生物視覺皮層的研究開始。但是不管怎么樣第一次在神經(jīng)網(wǎng)絡(luò)里引入卷積是 1982 年,在此之后他們做了很多的工作,1989 年引入 BP 算法,那時算法就已經(jīng)成型了,到了 1995 年第一次對 CNN 有了一個完整的描述,在 1998 年對美國支票的識別取得了很大的成功,在 2006 年提出了通過無監(jiān)督逐層訓(xùn)練深層模型,到了 2009 年這個技術(shù)被引到 CNN 里,我們可以做深度的 CNN,2012年深度的 CNN 被用在ImageNet 比賽中,直接掀起了一波深度學(xué)習(xí)的浪潮。

我所做的工作的最重要的意義是什么呢?以前我們說深度學(xué)習(xí)是一個黑屋子,這個黑屋子里面有什么東西呢?大家都知道它有深度神經(jīng)網(wǎng)絡(luò),現(xiàn)在我們把這個屋子打開了一扇門,把深度森林放進(jìn)來,我想以后可能還有更多的東西。所以這是這個工作從學(xué)術(shù)科學(xué)發(fā)展上的意義上,有一個更重要的價值。

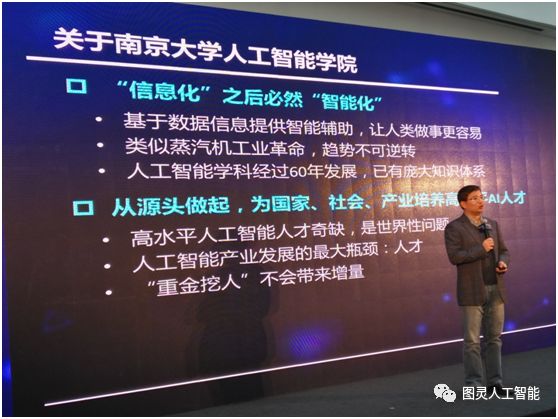

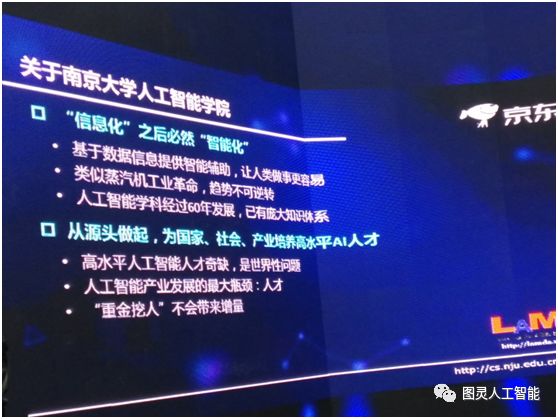

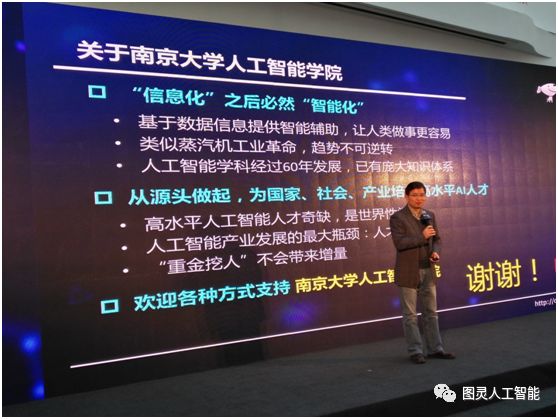

最后我想用兩分鐘的時間談一談,南京大學(xué)人工智能學(xué)院馬上跟京東開展全面的、深入的在科學(xué)研究和人才培養(yǎng)方面的合作。

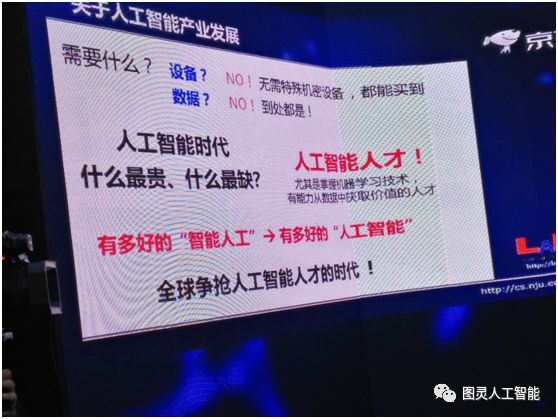

關(guān)于人工智能產(chǎn)業(yè)的發(fā)展,我們要問一個問題,我們到底需要什么?大家說需要設(shè)備嗎?其實(shí)做人工智能的研究不需要特殊機(jī)密的設(shè)備,你只要花錢,這些設(shè)備都買得到,GPU 這些都不是什么高端的禁運(yùn)的商品。第二是不是缺數(shù)據(jù)?也不是,現(xiàn)在我們的數(shù)據(jù)收集存儲、傳輸、處理的能力大幅度的提升,到處都是數(shù)據(jù),真正缺的是什么?

其實(shí)人工智能時代最缺的就是人才。因?yàn)閷@個行業(yè)來說,你有多好的人,才有多好的人工智能。所以我們現(xiàn)在可以看到,其實(shí)全球都在爭搶人工智能人才,不光是中國,美國也是這樣。所以我們成立人工智能學(xué)院,其實(shí)就有這樣的考慮。

可能我們投資風(fēng)口里面有一些詞,今年還很熱,明年就已經(jīng)不見了,這些詞如果我們追究一下,它里面科學(xué)含義到底是什么?可能沒幾個人說的清楚,而人工智能和這些東西完全不一樣,是經(jīng)過 60 多年發(fā)展出來的一個學(xué)科。

高水平的人工智能人才奇缺,這是一個世界性的問題,我們很多企業(yè)都是重金挖人,但實(shí)際上挖人不能帶來增量,所以我們要從源頭做起,為國家、社會、產(chǎn)業(yè)的發(fā)展培養(yǎng)高水平的人工智能人才。

-

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122487

原文標(biāo)題:南京大學(xué)教授:周志華——關(guān)于深度學(xué)習(xí)的一點(diǎn)思考

文章出處:【微信號:gh_ecbcc3b6eabf,微信公眾號:人工智能和機(jī)器人研究院】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

周志華教授——關(guān)于深度學(xué)習(xí)的一點(diǎn)思考,這一點(diǎn)你都理解嗎?

周志華教授——關(guān)于深度學(xué)習(xí)的一點(diǎn)思考,這一點(diǎn)你都理解嗎?

評論