Diffusion生成式動作引擎

Diffusion生成式動作引擎是一種基于擴散模型(Diffusion Models)的生成式人工智能技術,專注于生成連續、逼真的人類動作或動畫序列。這類引擎在游戲開發、虛擬現實、影視動畫和機器人控制等領域具有廣泛應用前景。以下是其核心原理、技術實現和應用方向的詳細解析:

一、核心原理

-

擴散模型基礎

Diffusion模型通過逐步添加噪聲破壞數據(正向過程),再學習逆向去噪過程(逆向過程),最終從隨機噪聲中生成目標數據。在動作生成中,數據可以是人體關節的運動軌跡(如骨骼關節點坐標、旋轉角度等)。 - 動作序列建模

- 動作序列是時間連續的時空數據(多幀姿態的序列),通常用3D骨骼坐標或運動捕捉數據(MoCap)表示。

- 擴散模型被擴展為處理時間序列數據,例如通過引入時序注意力機制或循環結構(如Transformer、LSTM)。

- 條件生成

- 支持多模態輸入控制(如文本、音樂、目標路徑等),通過條件編碼(如CLIP文本嵌入)引導動作生成的方向。

二、技術實現

- 數據準備與預處理

- 數據集:常用AMASS、Human3.6M、Mixamo等動作捕捉數據集。

- 標準化:對動作數據進行歸一化,消除骨骼尺寸差異。

- 特征提取:提取關節旋轉、速度、接觸點等物理特征。

- 模型架構

- 主干網絡:

- U-Net變體:結合時間維度卷積(1D/3D CNN)處理時序數據。

- Transformer:捕捉長距離時序依賴。

- 圖卷積網絡(GCN):建模人體骨骼拓撲結構。

- 擴散過程:

- 定義噪聲調度(Noise Schedule),逐步破壞動作序列。

- 在逆向過程中,通過迭代預測噪聲并重建動作。

- 條件控制機制

- 文本到動作:使用CLIP或BERT編碼文本,通過交叉注意力注入到擴散模型。

- 音樂到舞蹈:提取音樂節拍/旋律特征,與動作節奏對齊。

- 路徑規劃:結合目標軌跡(如起點到終點)生成合理運動。

- 訓練與推理優化

- 訓練目標:最小化預測噪聲與真實噪聲的差異(均方誤差)。

- 加速推理:采用DDIM(Denoising Diffusion Implicit Models)或Latent Diffusion減少采樣步數。

三、應用場景

- 游戲與虛擬角色

- 實時生成NPC動作,提升開放世界游戲的交互真實感。

- 根據玩家輸入動態生成角色動畫(如戰斗、對話動作)。

- 影視與動畫制作

- 自動生成復雜群組動畫(如人群奔跑、舞蹈)。

- 輔助關鍵幀補間,減少手動調整工作量。

- 機器人控制

- 生成符合物理規律的機器人運動軌跡。

- 結合強化學習優化動作策略(如行走、抓取)。

- 醫療與運動分析

- 生成康復訓練動作庫,個性化調整運動幅度。

- 模擬運動員動作,輔助技術優化。

四、挑戰與解決方案

- 動作連貫性

- 問題:生成動作可能出現抖動或邏輯不合理。

- 方案:引入物理約束(如接觸點檢測、關節運動范圍限制)和對抗訓練(判別器網絡)。

- 多模態對齊

- 問題:文本/音樂與動作的語義對齊困難。

- 方案:使用對比學習(如CLIP)增強跨模態特征匹配。

- 實時性

- 問題:擴散模型推理速度慢。

- 方案:模型蒸餾、Latent Diffusion(在低維潛在空間操作)、緩存高頻動作模板。

五、開源工具與框架

- 研究項目

- MDM(Motion Diffusion Model):基于Transformer的擴散動作生成模型。

- MotionDiffuse:支持多條件控制的動作生成框架。

- Stable Diffusion擴展:適配動作生成任務的變體(如調整U-Net輸入維度)。

- 開發工具

- PyTorch/TensorFlow:深度學習框架。

- Blender/Unity:動畫制作與引擎集成。

- DeepMoCap:動作數據處理工具包。

六、未來方向

- 物理增強生成:結合剛體動力學模擬(如PyBullet)生成物理合理動作。

- 交互式編輯:允許用戶實時調整生成動作的風格、速度、幅度。

- 跨域適應:從虛擬動作遷移到真實機器人控制(Sim2Real)。

通過擴散模型構建生成式動作引擎,能夠突破傳統動畫制作中關鍵幀綁定的限制,為動態、多樣化的動作生成提供強大支持。隨著模型效率的提升和多模態融合技術的進步,這一領域有望成為下一代人機交互的核心技術之一。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

發布評論請先 登錄

相關推薦

熱點推薦

魯班,視覺生成引擎的應用

is to create.”。三、使用場景視覺生成引擎的使用場景大致可抽象成下圖。以顯式輸入而言,用戶可以輸入標簽需要的風格、色彩、構圖等,或者輸入一個例子,或者進行一些交互的輸入。除顯式

發表于 04-28 15:36

Stability AI開源圖像生成模型Stable Diffusion

Stable Diffusion 的很多用戶已經公開發布了生成圖像的樣例,Stability AI 的首席開發者 Katherine Crowson 在推特上分享了許多圖像。基于 AI 的圖像合成可能會對藝術家和藝術領域帶來一定的影響

關于生成式AI的關鍵技術

生成式AI的關鍵技術是生成式對抗網絡(GANs, Generative Adversarial Networks ),其本質是一種深度學習模

SOTA生成式模型:9大類別21個模型合集

過去的兩年時間里,AI界的大型生成模型發布呈井噴之勢,尤其是Stable Diffusion開源和ChatGPT開放接口后,更加激發了業界對生成式模型的熱情。

一文讀懂Stable Diffusion教程,搭載高性能PC集群,實現生成式AI應用

PC Farm、生成式AI和Stable Diffusion模型都是非常有用的工具和技術,可以幫助用戶快速構建和管理計算機集群,生成高質量的

使用OpenVINO?在算力魔方上加速stable diffusion模型

Stable Diffusion 是 stability.ai 開源的 AI 圖像生成模型,實現輸入文字,生成圖像的功能。Stable Diffusion 將 AI 圖像

優化 Stable Diffusion 在 GKE 上的啟動體驗

Diffusion 等應運而生。Stable Diffusion 是一個文字生成圖像的 Diffusion 模型,它能夠根據給定任何文本輸入生成

虹軟圖像深度恢復技術與生成式AI的創新 生成式AI助力

當前,生成式人工智能(AI)技術的快速發展令人矚目。它能夠理解人類的描述,并在短時間內生成逼真的圖像和視頻。在生成

發表于 06-21 09:06

?587次閱讀

高通WAIC展示兩大終端側生成式AI技術 AI引擎獲獎

賦能等多個角度,描繪了混合AI賦能的智能未來。同期,第二代驍龍8的高通AI引擎獲得大會最高獎項——SAIL獎(卓越人工智能引領者獎);高通還在現場帶來了其強大終端側AI賦能的生成式AI用例技術

樹莓派能跑Stable Diffusion了?

Stable Diffusion是一種文本到圖像生成的大型深度學習模型,它可以根據文本的描述生成詳細的圖像,也可以用于其他任務,如圖像修復、圖像擴展、圖像翻譯等。

投票選出你喜歡的生成式 AI 賀卡!

NVIDIA NGC Stable Diffusion XL ?是一款根據用戶提供的文本內容巧妙生成相應圖像作品的模型。在剛剛過去的假期,我們開展了中秋賀卡生成活動 , 聚焦于生成

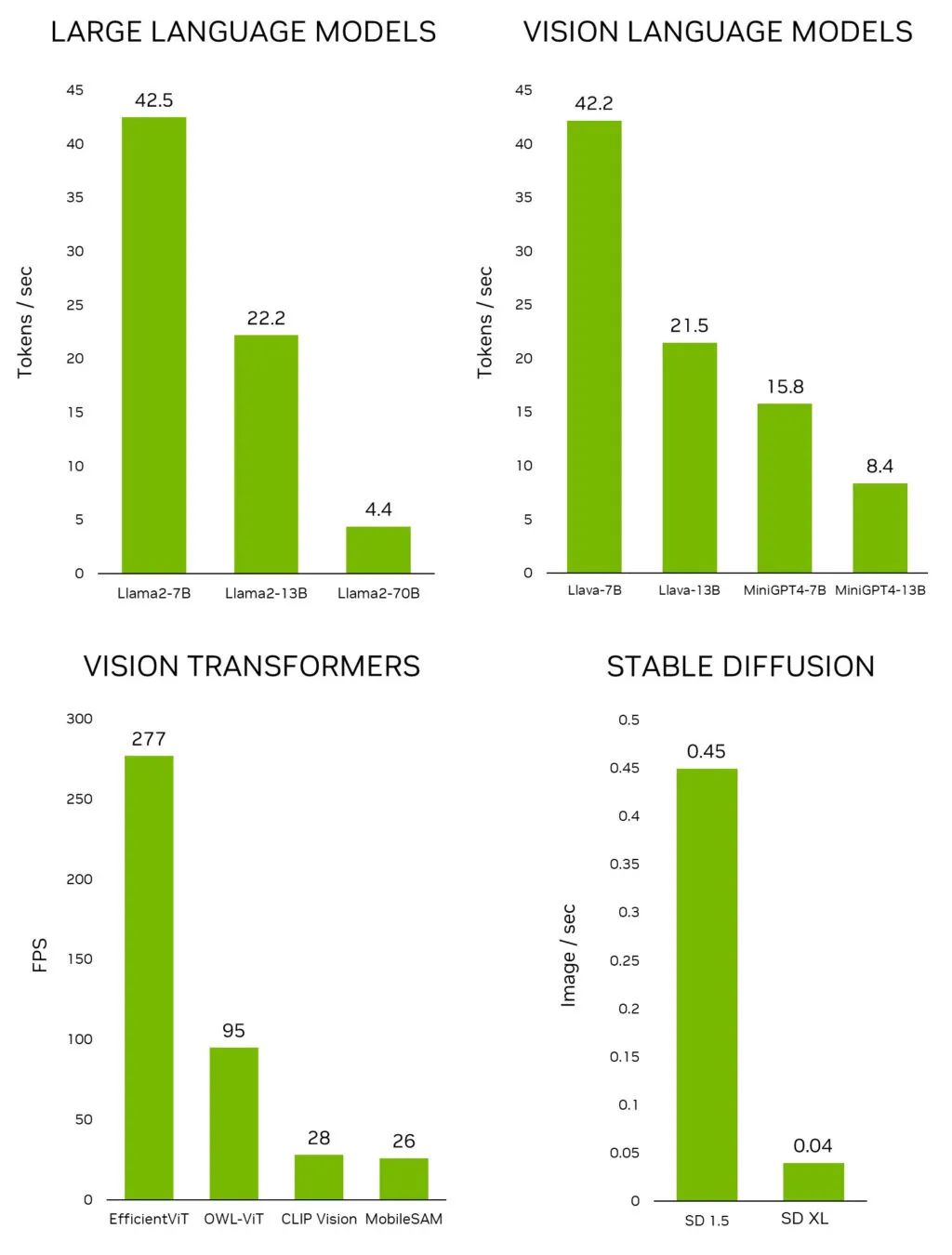

利用 NVIDIA Jetson 實現生成式 AI

近日,NVIDIA 發布了 Jetson 生成式 AI 實驗室(Jetson Generative AI Lab),使開發者能夠通過 NVIDIA Jetson 邊緣設備在現實世界中探索生成式

火山引擎推出豆包·視頻生成模型

在近期舉辦的2024火山引擎AI創新巡展上,火山引擎總裁譚待隆重推出了豆包·視頻生成模型,這一舉措標志著火山引擎在視頻內容生成領域邁出了重要

IDC生成式AI白皮書亮點速遞

在數字化浪潮中,生成式 AI 正成為推動創新和變革的關鍵力量。本文將分享由 IDC 發布的《技術革新引領未來——生成式 AI 塑造核心發展

使用OpenVINO GenAI和LoRA適配器進行圖像生成

借助生成式 AI 模型(如 Stable Diffusion 和 FLUX.1),用戶可以將平平無奇的文本提示詞轉換為令人驚艷的視覺效果。

?Diffusion生成式動作引擎技術解析

?Diffusion生成式動作引擎技術解析

評論