前言:

在RK3588上部署Deepseek有兩種方法,分別是使用Ollama工具部署和使用瑞芯微官方的 RKLLM量化部署。Ollama 是一個開源的大模型服務工具,調用的是CPU進行的運算,如果要將RK3588強悍的NPU性能發揮出來,可以重點了解一下RKLLM量化部署。

一、RKLLM介紹

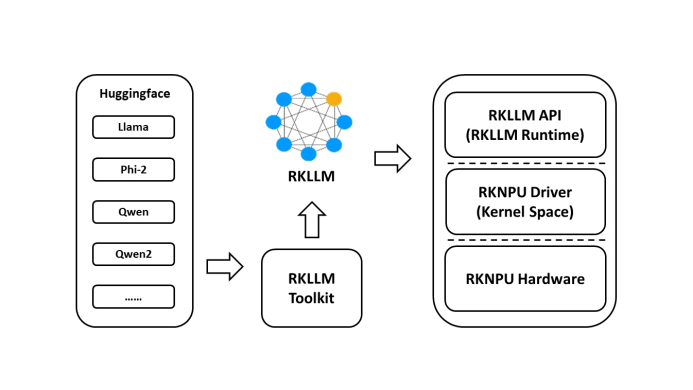

為了使用RK NPU,用戶需要先在計算機上安裝RKLLM-Toolkit工具。RKLLM-Toolkit 是為用戶提供在計算機上進行大語言模型的量化、轉換的開發套件。通過該 工具提供的接口可以便捷地完成模型轉換和模型量化。

RKLLM的整體開發步驟主要分為:模型轉換和板端部署運行。

模型轉換是使用RKLLM-Toolkit將預訓練的大語言模型轉換為RKLLM格式。

板端部署運行是調用RKLLM Runtime庫加載RKLLM模型到Rockchip NPU平臺,然后進行推理等操作。

二、DeepSeek-R1介紹

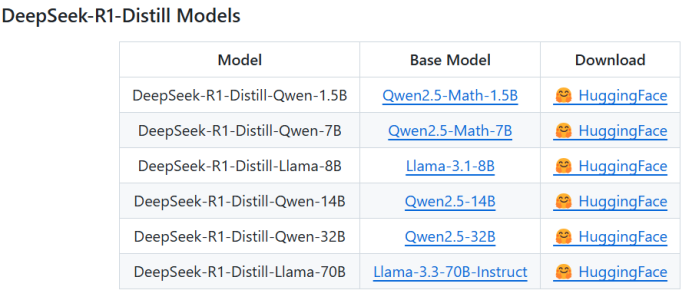

`DeepSeek-R1是深度求索(DeepSeek)公司推出的開源多模態大語言模型,專為長上下文理解和多模態交互優化。DeepSeek-R1基于開源模型進行了微調,提供了1.5B、7B等參數版本的DeepSeek-R1-Distill模型,適合部署到邊緣設備。

三、部署過程

3.1獲取模型

從 deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B 獲取模型文件;

# 獲取DeepSeek-R1-Distill-Qwen-1.5Bgitclonehttps://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

3.2安裝轉換工具

在Ubuntu虛擬機安裝RKLLM-Toolkit,以便將DeepSeek-R1大語言模型轉換為RKLLM模型格式和編譯板端推理的可執行程序,具體RKLLM-Toolkit環境安裝步驟不在此詳述;

3.3安裝轉換工具

使用RKLLM-Toolkit對模型進行轉換。運行模型轉換腳本;

cd rknn-llm/examples/rkllm_api_demo/bash build-linux.sh

生成的可執行文件在:

build/build_linux_aarch64_Release/llm_demo

3.4板端部署

將轉換成功后的 DeepSeek-R1-Distill-Qwen-1.5B.rkllm 模型與編譯后的二進制文件 llm_demo 復制到板端,并導入環境變量

exportLD_LIBRARY_PATH=$LD_LIBRARY_PATH:rknn-llm/rkllm-runtime/Linux/librkllm_api/aarch64

3.5運行測試

運行 llm_demo

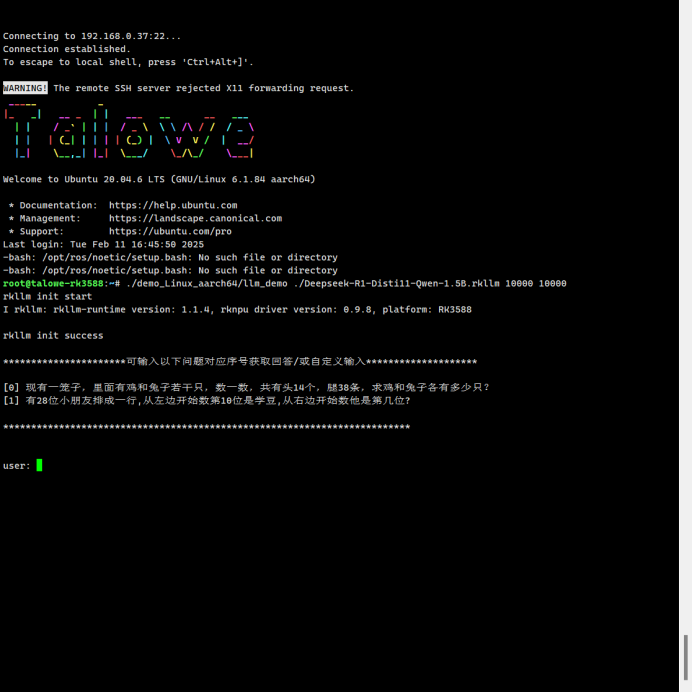

./demo_Linux_aarch64/llm_demo./Deepseek-R1-Disti11-Qwen-1.5B.rkllm1000010000

四、測試效果

4.1環境說明

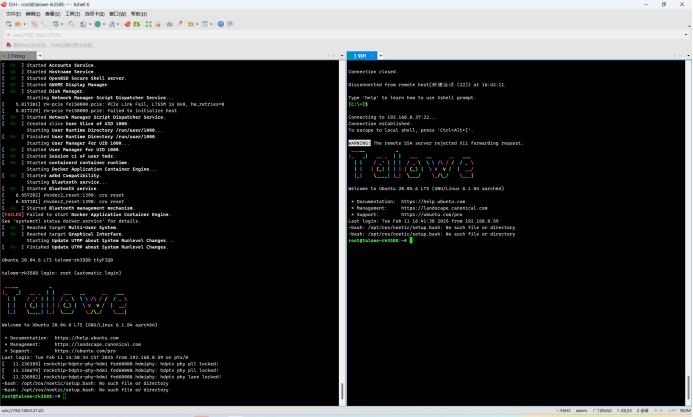

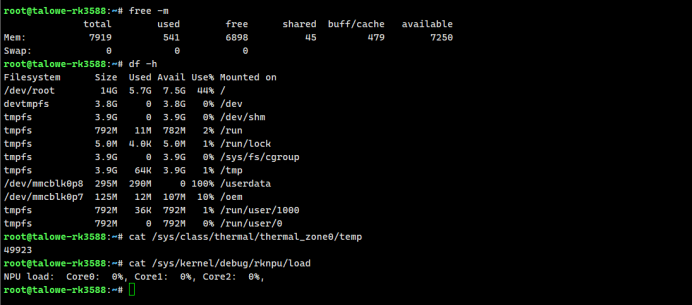

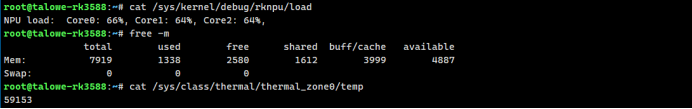

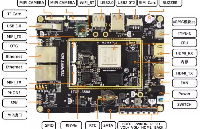

使用眺望電子EVM-RK3588開發套件,搭載8GB內存配置,板載運行Ubuntu20.04系統。通過SSH登入主板運行模型,Debug調試口用于監測運行器件資源消耗。

4.2推理過程

Connecting to 192.168.0.37:22...Connection established.To escape to local shell, press 'Ctrl+Alt+]'.WARNING! The remote SSH server rejected X11 forwarding request._____ _ |_ _| __ _ | | ___ __ __ ___| | / _` | | | / _ \ \ \ /\ / / / _ \| | | (_| | | | | (_) | \ V V / | __/|_| \__,_| |_| \___/ \_/\_/ \___|

Welcome to Ubuntu 20.04.6 LTS (GNU/Linux 6.1.84 aarch64)* Documentation: https://help.ubuntu.com* Management: https://landscape.canonical.com* Support: https://ubuntu.com/proLast login: Tue Feb 11 1425 2025-bash: /opt/ros/noetic/setup.bash: No such file or directory-bash: /opt/ros/noetic/setup.bash: No such file or directoryroot@talowe-rk3588:~#root@talowe-rk3588:~# lsDeepseek-R1-Disti11-Qwen-1.5B.rkllm demo_Linux_aarch64root@talowe-rk3588:~# ./demo_Linux_aarch64/llm_demo ./Deepseek-R1-Disti11-Qwen-1.5B.rkllm 10000 10000rkllm init startI rkllm: rkllm-runtime version: 1.1.4, rknpu driver version: 0.9.8, platform: RK3588rkllm init success**********************可輸入以下問題對應序號獲取回答/或自定義輸入********************[0] 現有一籠子,里面有雞和兔子若干只,數一數,共有頭14個,腿38條,求雞和兔子各有多少只?[1] 有28位小朋友排成一行,從左邊開始數第10位是學豆,從右邊開始數他是第幾位?*************************************************************************user: 0現有一籠子,里面有雞和兔子若干只,數一數,共有頭14個,腿38條,求雞和兔子各有多少只?robot:

4.3資源消耗

DeepSeek-R1模型輸出的回答結果清晰流暢,內存資源占用797MB,NPU負載約為64%,在無風扇環境下,溫升約10℃。

總而言之,DeepSeek-R1模型的強力有目共睹,同時也驗證了眺望電子對RK3588系列處理器的深度優化與強大可靠。如果您對部署過程感興趣,歡迎隨時與我們聯系,我們可以為您提供專業的技術支持,期待與您合作!

-

RK3588

+關注

關注

7文章

397瀏覽量

5461 -

LLM

+關注

關注

1文章

318瀏覽量

659 -

DeepSeek

+關注

關注

1文章

760瀏覽量

1191

發布評論請先 登錄

從DeepSeek到Qwen,AI大模型的移植與交互實戰指南-飛凌嵌入式

【幸狐Omni3576邊緣計算套件試用體驗】DeepSeek 部署及測試

實戰案例 | 299元國產工業級AI核心板部署DeepSeek-R1

RK3588開發板上部署DeepSeek-R1大模型的完整指南

米爾RK3576開發板評測】+ RKLLM-Toolkit 環境安裝

案例分享 ▏【瑞芯微RK3588】HZHY-AI300G智能盒部署DeepSeek-R1模型實戰指南

香橙派發布OrangePi 5Plus本地部署Deepseek-R1蒸餾模型指南

RK3588+DeepSeek有沒有“搞頭”?

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

ATK-DLRK3588開發板deepseek-r1-1.5b/7b部署指南

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

在RK3588開發板上部署并測試DeepSeek模型

實戰案例 | 眺望RK3588 RKLLM部署DeepSeek-R1全流程

實戰案例 | 眺望RK3588 RKLLM部署DeepSeek-R1全流程

評論