隨著人工智能技術的迅速發展,Transformer在自然語言處理、機器翻譯、問答系統等領域取得了顯著的性能提升。然而,這些模型的部署面臨著巨大的挑戰,主要源于其龐大的模型尺寸和內存消耗。

在部署過程中,網絡壓縮是一種常用的解決方案,可以有效減小模型的體積,提高模型在移動設備等資源受限環境下的部署效率。其中,量化技術是將大模型中的浮點數參數轉換為整數,并進行存儲和計算的方法。由于Transformer的網絡參數越來越多、計算量越來越大,對于存儲和計算資源有限的邊緣設備來說,模型部署帶來了很大的挑戰。

網絡量化是一種常見的解決方案,通過將模型參數量化為整數,可以大幅度減少模型的存儲空間和計算量,從而實現在邊緣設備上高效部署Transformer。

后摩智能也在Transformer量化提出了一些領先的算法方案。在本文中,我們將重點介紹兩種針對Transformer的量化方案:

RPTQ(Reorder-based Post-training Quantization)

PB-LLM(Partially Binarized Large Language Models)

這兩種方法分別針對激活量化和權重量化,旨在實現極端低位量化,同時保持語言推理能力。

RPTQ:

量化激活通道的新思路

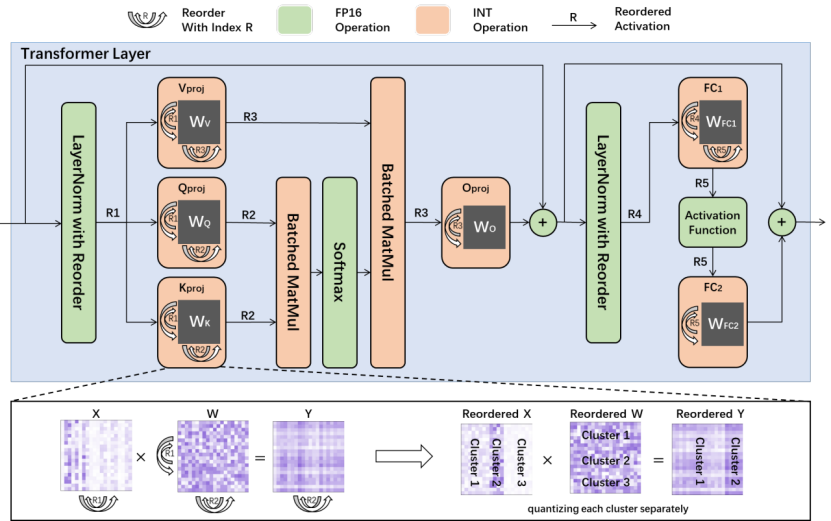

RPTQ(Reorder-based Post-training Quantization)是后摩智能團隊與華中科技大學等合作單位提出的一種全新的量化方法,旨在解決量化Transformer時激活通道之間的數值范圍差異問題。

相較于以往的研究,RPTQ首次將3位激活引入了LLMs,實現了顯著的內存節省,例如在量化OPT-175B模型方面,內存消耗降低了高達80%。RPTQ的關鍵思想是通過重新排列激活通道并按簇量化,從而減少通道范圍差異的影響。同時,通過操作融合,避免了顯式重新排序的操作,使得RPTQ的開銷幾乎為零。通過這種方法,RPTQ有效地解決了激活通道數值范圍差異導致的量化誤差問題。

PB-LLM:

實現極端低位量化的新突破

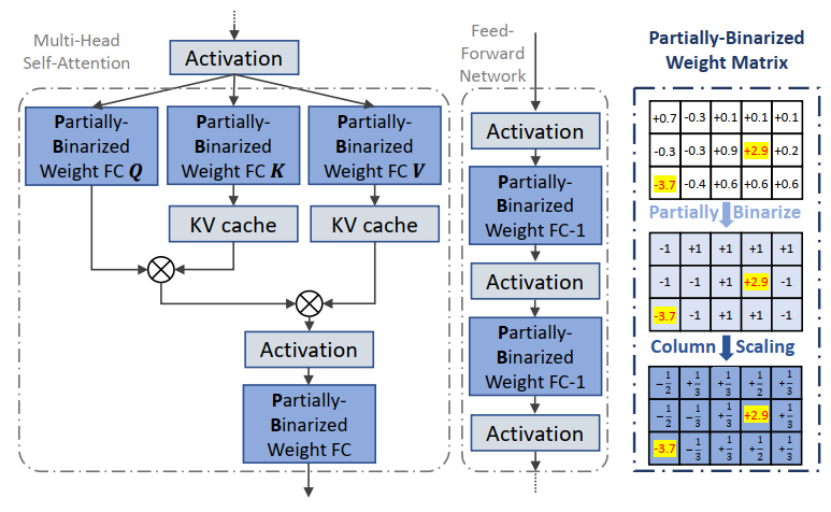

PB-LLM(Partially Binarized Large Language Models)是后摩智能團隊與伊利諾伊理工和伯克利大學等單位合作提出的另一種創新性量化方法,主要針對權重量化。目前該篇論文已被接收至ICLR 2024,ICLR 以介紹和發布人工智能、統計學和數據科學領域深度學習的尖端研究而聞名,被認為是“深度學習的頂級會議”。

相較于傳統的二值化方法,PB-LLM采用了部分二值化的策略,即將一部分顯著權重分配到高位存儲,從而在實現極端低位量化的同時,保持了Transformer的語言推理能力。通過對顯著權重的充分利用,PB-LLM取得了顯著的性能提升,為Transformer的內存消耗和計算復雜度提供了有效的解決方案。這是學術界首次探索對Transformer權重數值二值化的工作。

后摩智能的技術優勢:突破性內存計算技術驅動AI發展

后摩智能作為大算力存算一體領域的先行者,憑借著RPTQ和PB-LLM等創新性量化方法的提出,取得了在大型語言模型中實現極端低位量化的突破。同時,后摩智能團隊在內存計算領域擁有深厚的研究實力和豐富的實踐經驗,與行業內多家頂尖機構展開了廣泛的合作。這使得后摩智能得以不斷推動內存計算技術的發展,為人工智能技術的應用提供了更多創新性解決方案。

總的來說,后摩智能的RPTQ和PB-LLM等突破性量化方法為解決大型語言模型部署中的內存消耗和計算復雜度問題提供了有效的解決方案。隨著內存計算技術的不斷演進,后摩智能將繼續致力于推動人工智能技術的發展,實現萬物智能的愿景。

審核編輯:劉清

-

人工智能

+關注

關注

1804文章

48714瀏覽量

246517 -

自然語言處理

+關注

關注

1文章

628瀏覽量

14010 -

LLM

+關注

關注

1文章

319瀏覽量

682

原文標題:后摩前沿 | Transformer 壓縮部署的前沿技術:RPTQ與PB-LLM

文章出處:【微信號:后摩智能,微信公眾號:后摩智能】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Transformer壓縮部署的前沿技術:RPTQ與PB-LLM

Transformer壓縮部署的前沿技術:RPTQ與PB-LLM

評論