這篇mylangrobot項目由neka-nat創建,本文已獲得作者Shirokuma授權進行編輯和轉載。

https://twitter.com/neka_nat

GitHub-mylangrobot :GitHub - neka-nat/mylangrobot: Language instructions to mycobot using GPT-4V

引言

本項目創建了一個使用GPT-4V和myCobot的一個演示,演示機械臂簡單得到拾取操作,這個演示使用了一個名叫SoM(物體檢測對象)的方法,通過自然語言生成機器人動作。通俗點換一句話來說就是,機器接受自然語言,去尋找目標然后讓機械臂進行抓取的一個案例。

本項目的亮點主要是GPT-4V的圖像處理和SoM物體檢測算法相結合,通過自然語言和機器交互實現機械臂運動。

軟件

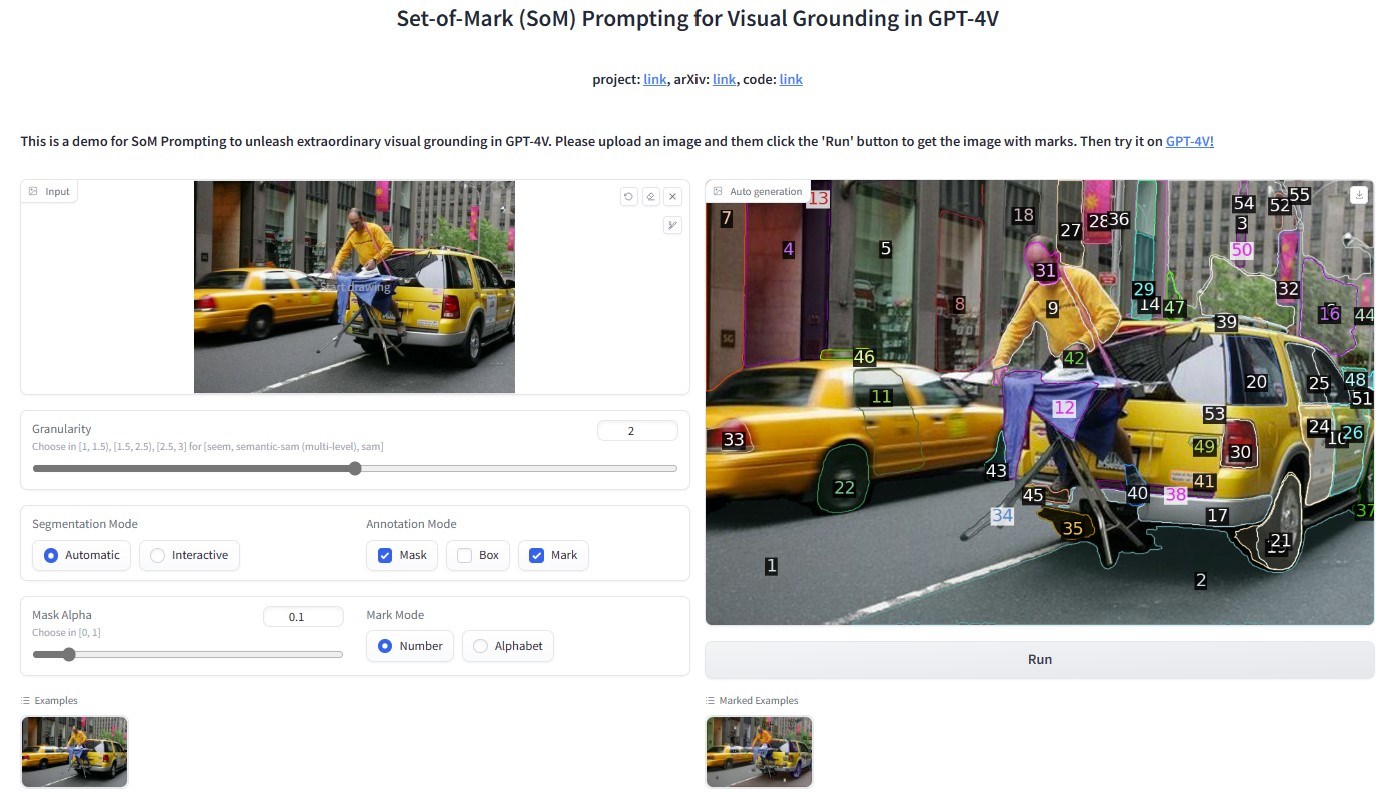

SoM

Set of Mark(SoM)是一種用于增強大型語言模型的視覺理解能力。圖像經過SoM處理之后能夠在圖像上添加一系列的標記,這些標記能夠被語言類模型識別和處理。這些標記有助于模型更準確的識別和理解圖像中的物體和內容。

這使得語言模型能夠針對圖像中的元素進行更精準的分析和描述,從而提高其在視覺任務上的表現。

GPT-4V

我們常聊的GPT是一個大預言模型,我們可以跟它進行對話聊天。在迭代新的版本的GPT-4V是一個大模型多模態語言模型,它不單單能處理文本信息,現在還能夠處理圖像信息。能夠對圖像理解,圖像生成,圖像描述的功能,這樣大模型結合GPT-4的強大自然語言處理能力和現金的圖像分析技術,可以提供更高效和更準確的視覺和語言綜合能力。

下面是OpenAI 提供的例子

簡要介紹:將一個視頻提供給GPT4,通過GPT-4V對圖像的處理,生成對視頻講解的內容的過程。原文鏈接:Processing and narrating a video with GPT's visual capabilities and the TTS API | OpenAI Cookbook

User:

"These are frames from a video that I want to upload. Generate a compelling description that I can upload along with the video."

視頻中某一幀的圖像

#GPT-4V對圖像的描述處理

GPT4:

"

審核編輯 黃宇

-

機器人

+關注

關注

213文章

29615瀏覽量

212195 -

人工智能

+關注

關注

1805文章

48899瀏覽量

247986 -

GPT

+關注

關注

0文章

368瀏覽量

16012 -

機械臂

+關注

關注

13文章

551瀏覽量

25305 -

大象機器人

+關注

關注

0文章

85瀏覽量

90

發布評論請先 登錄

利用人工智能和機器人技術實現復雜的自動化任務!

利用人工智能和機器人技術實現復雜的自動化任務!

評論