11月27日,浪潮信息發(fā)布"源2.0"基礎(chǔ)大模型,并宣布全面開源。源2.0基礎(chǔ)大模型包括1026億、518億、21億等三種參數(shù)規(guī)模的模型,在編程、推理、邏輯等方面展示出了先進(jìn)的能力。

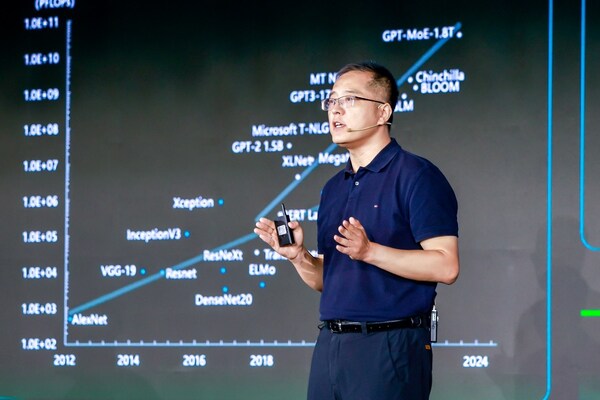

當(dāng)前,大模型技術(shù)正在推動(dòng)生成式人工智能產(chǎn)業(yè)迅猛發(fā)展,而基礎(chǔ)大模型的關(guān)鍵能力則是大模型在行業(yè)和應(yīng)用落地能力表現(xiàn)的核心支撐,但基礎(chǔ)大模型的發(fā)展也面臨著在算法、數(shù)據(jù)和算力等方面的諸多挑戰(zhàn)。源2.0基礎(chǔ)大模型則針對(duì)性地提出了新的改進(jìn)方法并獲得了能力的提升。

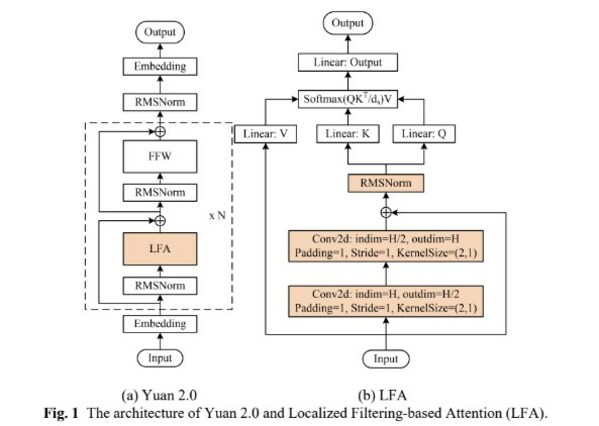

算法方面,源2.0提出并采用了一種新型的注意力算法結(jié)構(gòu):局部注意力過濾增強(qiáng)機(jī)制(LFA:Localized Filtering-based Attention)。LFA通過先學(xué)習(xí)相鄰詞之間的關(guān)聯(lián)性,然后再計(jì)算全局關(guān)聯(lián)性的方法,能夠更好地學(xué)習(xí)到自然語言的局部和全局的語言特征,對(duì)于自然語言的關(guān)聯(lián)語義理解更準(zhǔn)確、更人性,提升了模型的自然語言表達(dá)能力,進(jìn)而提升了模型精度。

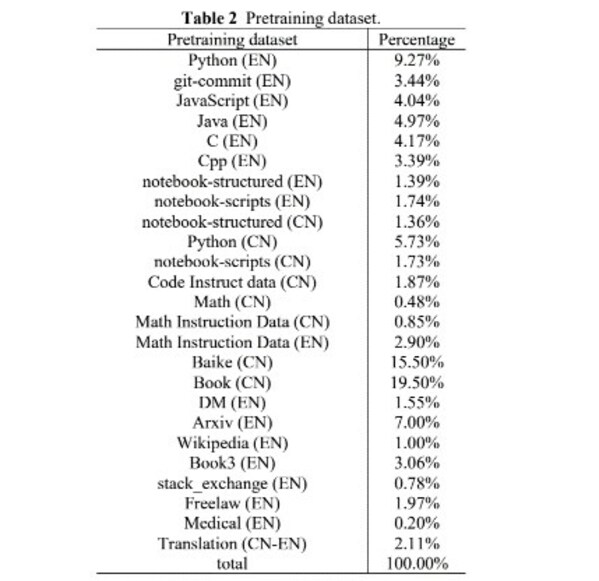

數(shù)據(jù)方面,源2.0通過使用中英文書籍、百科、論文等高質(zhì)量中英文資料,降低了互聯(lián)網(wǎng)語料內(nèi)容占比,結(jié)合高效的數(shù)據(jù)清洗流程,為大模型訓(xùn)練提供了高質(zhì)量的專業(yè)數(shù)據(jù)集和邏輯推理數(shù)據(jù)集。為了獲取中文數(shù)學(xué)數(shù)據(jù),我們清洗了從2018年至今約12PB的互聯(lián)網(wǎng)數(shù)據(jù),但僅獲取到了約10GB的數(shù)學(xué)數(shù)據(jù),投入巨大,收益較小。為了更高效地獲得相對(duì)匱乏的高質(zhì)量中文數(shù)學(xué)及代碼數(shù)據(jù)集,源2.0采用了基于大模型的數(shù)據(jù)生產(chǎn)及過濾方法,在保證數(shù)據(jù)的多樣性的同時(shí)也在每一個(gè)類別上提升數(shù)據(jù)質(zhì)量,獲取了一批高質(zhì)量的數(shù)學(xué)與代碼預(yù)訓(xùn)練數(shù)據(jù)。

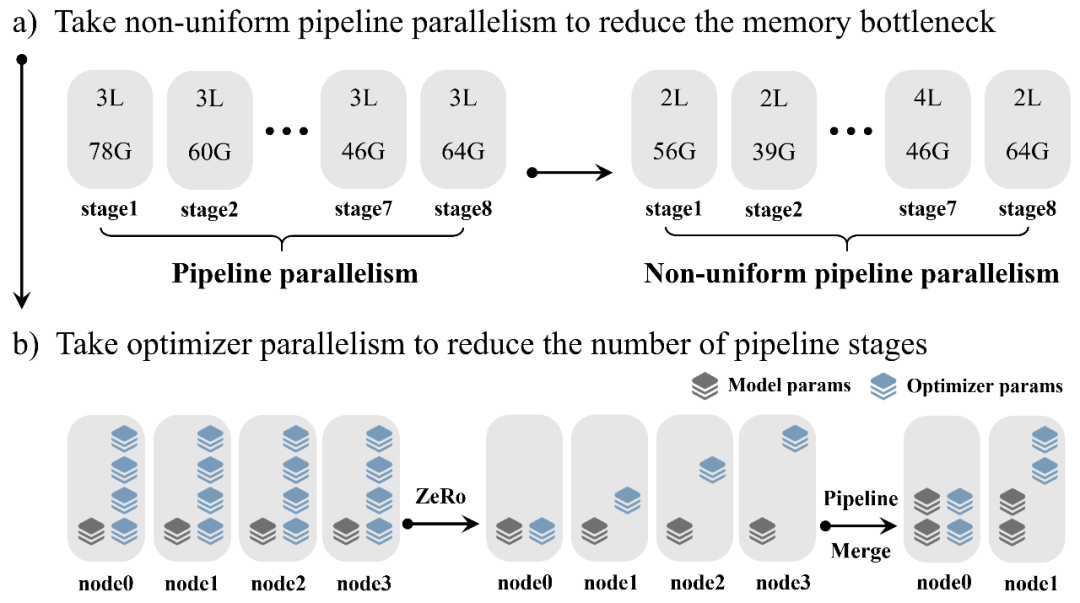

算力方面,源2.0采用了非均勻流水并行的方法,綜合運(yùn)用流水線并行+優(yōu)化器參數(shù)并行+數(shù)據(jù)并行的策略,讓模型在流水并行各階段的顯存占用量分布更均衡,避免出現(xiàn)顯存瓶頸導(dǎo)致的訓(xùn)練效率降低的問題,該方法顯著降低了大模型對(duì)芯片間P2P帶寬的需求,為硬件差異較大訓(xùn)練環(huán)境提供了一種高性能的訓(xùn)練方法。

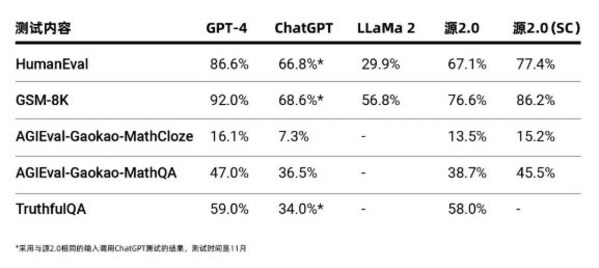

源2.0作為千億級(jí)基礎(chǔ)大模型,在業(yè)界公開的評(píng)測(cè)上進(jìn)行了代碼生成、數(shù)學(xué)問題求解、事實(shí)問答方面的能力測(cè)試,測(cè)試結(jié)果顯示,源2.0在多項(xiàng)模型評(píng)測(cè)中,展示出了較為先進(jìn)的能力表現(xiàn)。

源2.0采用全面開源策略,全系列模型參數(shù)和代碼均可免費(fèi)下載使用。

審核編輯:湯梓紅

-

半導(dǎo)體

+關(guān)注

關(guān)注

335文章

28613瀏覽量

232796 -

浪潮

+關(guān)注

關(guān)注

1文章

474瀏覽量

24506 -

大模型

+關(guān)注

關(guān)注

2文章

3030瀏覽量

3832

發(fā)布評(píng)論請(qǐng)先 登錄

浪潮信息與智源研究院攜手共建大模型多元算力生態(tài)

浪潮信息與智源研究院達(dá)成戰(zhàn)略合作協(xié)議

浪潮信息發(fā)布"源"Yuan-EB,刷新RAG檢索最高成績(jī)

借助浪潮信息元腦企智EPAI高效創(chuàng)建大模型RAG

浪潮信息發(fā)布“源”Yuan-EB助力RAG檢索精度新高

浪潮信息發(fā)布KOS AI定制版,大幅提升大模型訓(xùn)練效率

浪潮信息AI存儲(chǔ)性能測(cè)試的領(lǐng)先之道

浪潮信息源2.0大模型與百度PaddleNLP全面適配

浪潮信息發(fā)布元腦企智一體機(jī)

浪潮信息:元腦企智EPAI助力金融大模型快速落地

源2.0-M32大模型發(fā)布量化版 運(yùn)行顯存僅需23GB 性能可媲美LLaMA3

浪潮信息趙帥:開放計(jì)算創(chuàng)新 應(yīng)對(duì)Scaling Law挑戰(zhàn)

浪潮信息發(fā)布AIStation V5,全面支持大模型開發(fā)流程與高效算力調(diào)度

浪潮信息發(fā)布源2.0基礎(chǔ)大模型,千億參數(shù)全面開源

浪潮信息發(fā)布源2.0基礎(chǔ)大模型,千億參數(shù)全面開源

評(píng)論