前言

視覺伺服是工業(yè)上很重要的一個領(lǐng)域,在自動裝配、高精配準(zhǔn)上應(yīng)用非常多。針對近兩年常見的算法模式,在這里進(jìn)行了簡單的匯總。

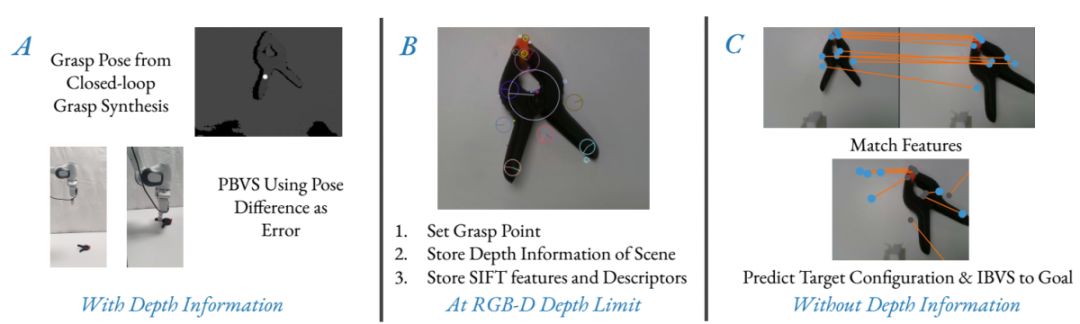

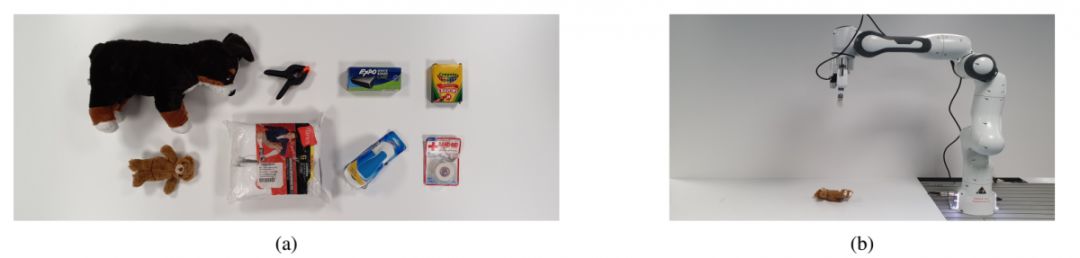

1、Predicting Target Feature Configuration of Non-stationary Objects for Grasping with Image-Based Visual Servoing

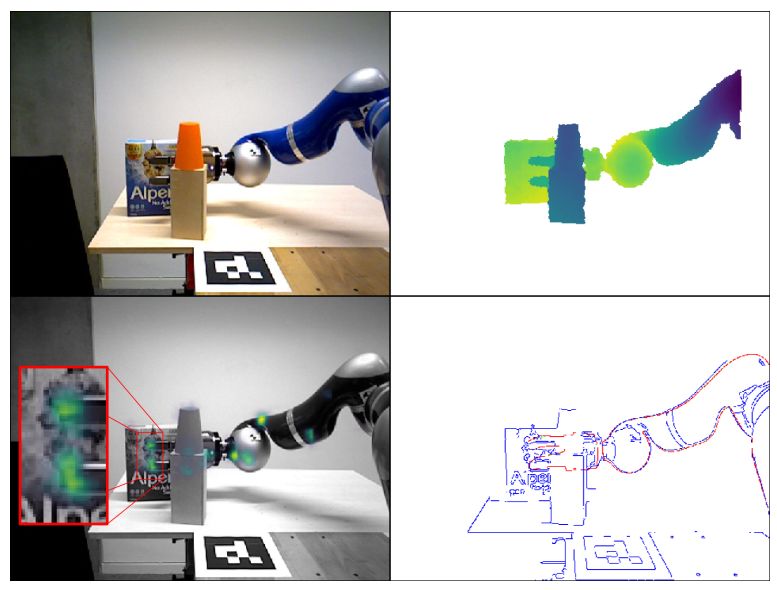

本文研究了RGB-D相機(jī)無法提供有效深度信息時,閉環(huán)抓取的最后逼近階段問題,這對于當(dāng)前機(jī)器人抓取控制器失靈的情況下抓取非平穩(wěn)物體是必要的。

在最后的抓取姿態(tài)下,本文預(yù)測觀察到的圖像特征像面坐標(biāo),并使用基于圖像的視覺伺服來引導(dǎo)機(jī)器人達(dá)到該姿態(tài)。

基于圖像的視覺伺服是一種成熟的控制技術(shù),它可以在三維空間中移動攝像機(jī),從而將圖像平面的特征配置驅(qū)動到某種目標(biāo)狀態(tài)。先前的工作中,假設(shè)目標(biāo)特征配置是已知的,但是對于某些應(yīng)用,這可能是不可行的,例如第一次對場景執(zhí)行運(yùn)動。本文提出的方法對抓取最后階段的場景運(yùn)動以及機(jī)器人運(yùn)動控制中的誤差具有魯棒性。

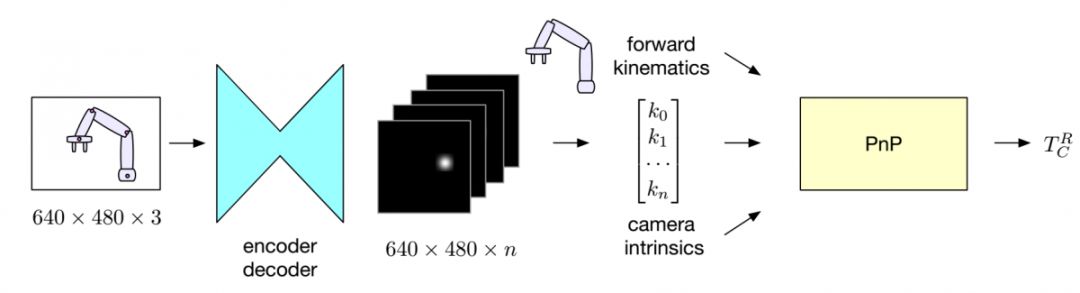

2、Camera-to-Robot Pose Estimation from a Single Image(卡內(nèi)基梅隆大學(xué),代碼開源)

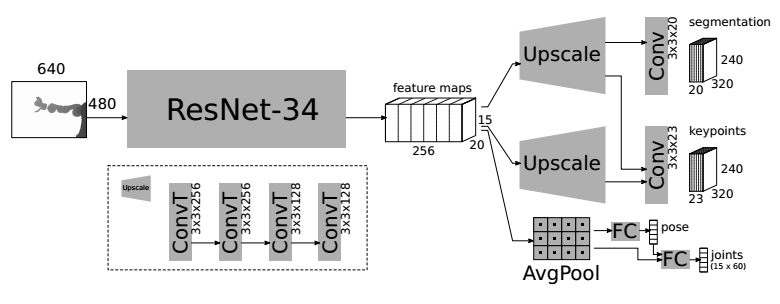

本文提出了一種從單個圖像估計(jì)攝像機(jī)相對于機(jī)器人姿態(tài)的方法。該方法利用深度神經(jīng)網(wǎng)絡(luò)對攝像機(jī)的RGB圖像進(jìn)行處理,檢測機(jī)器人上的二維關(guān)鍵點(diǎn),并利用區(qū)域隨機(jī)化的方法對網(wǎng)絡(luò)進(jìn)行完全的模擬訓(xùn)練。假設(shè)機(jī)器人機(jī)械手的關(guān)節(jié)結(jié)構(gòu)已知,一般使用PnP方式恢復(fù)相機(jī)外部。與傳統(tǒng)的手眼標(biāo)定系統(tǒng)不同,本文的方法不需要離線標(biāo)定步驟,能夠通過單幀計(jì)算相機(jī)外參,從而打開了在線標(biāo)定的可能性。本文給出了三種不同攝像機(jī)傳感器的實(shí)驗(yàn)結(jié)果,證明了該方法能夠在單幀條件下達(dá)到比傳統(tǒng)的多幀離線手眼標(biāo)定更好的精度。通過附加幀,精度進(jìn)一步提高。

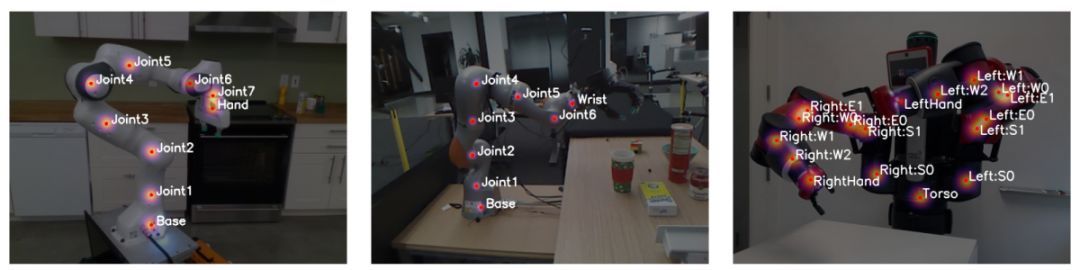

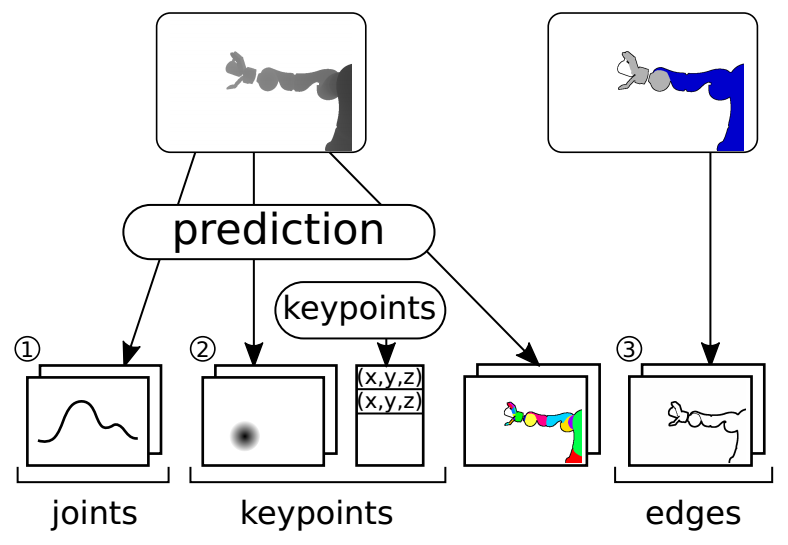

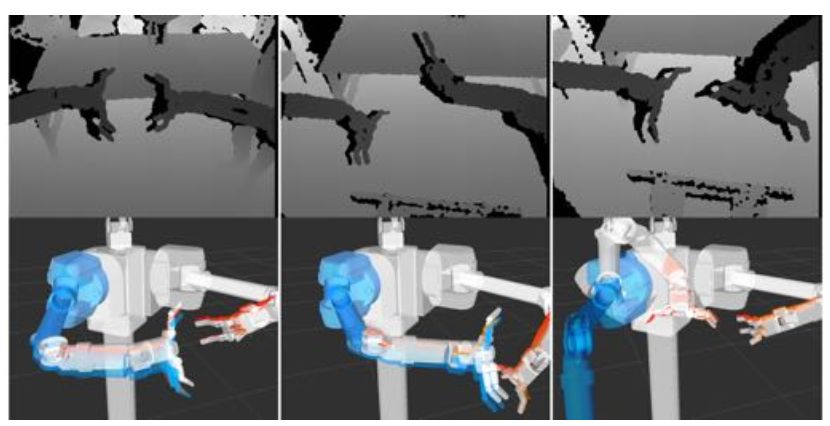

3、Learning Driven Coarse-to-Fine Articulated Robot Tracking(ICRA2019)

本文提出了一種機(jī)器人關(guān)節(jié)跟蹤方法,它只依賴于顏色和深度圖像的視覺線索來估計(jì)機(jī)器人在與環(huán)境交互或被環(huán)境遮擋時的狀態(tài)。文章假設(shè)只有在觀測狀態(tài)和估計(jì)狀態(tài)之間建立亞像素級的精確對應(yīng)關(guān)系時,關(guān)節(jié)模型擬合方法才能實(shí)現(xiàn)精確跟蹤。以前工作只依賴于識別深度信息或彩色邊緣對應(yīng)作為跟蹤目標(biāo),并要求從聯(lián)合編碼器初始化。本文提出了一種粗糙到精細(xì)的關(guān)節(jié)狀態(tài)估計(jì)器,該估計(jì)器僅依賴于顏色邊緣和學(xué)習(xí)到的深度關(guān)鍵點(diǎn)的視覺線索,并由深度圖像預(yù)測的機(jī)器人狀態(tài)分布初始化。在四個RGB-D序列上評估了論文的方法,展示了KUKA-LWR臂和 Schunk-SDH2手與環(huán)境進(jìn)行交互,并證明這種組合的關(guān)鍵點(diǎn)和邊緣跟蹤目標(biāo)可以在不使用任何聯(lián)合編碼器傳感的情況下進(jìn)行平均誤差為2.5cm的手掌位置估計(jì)。

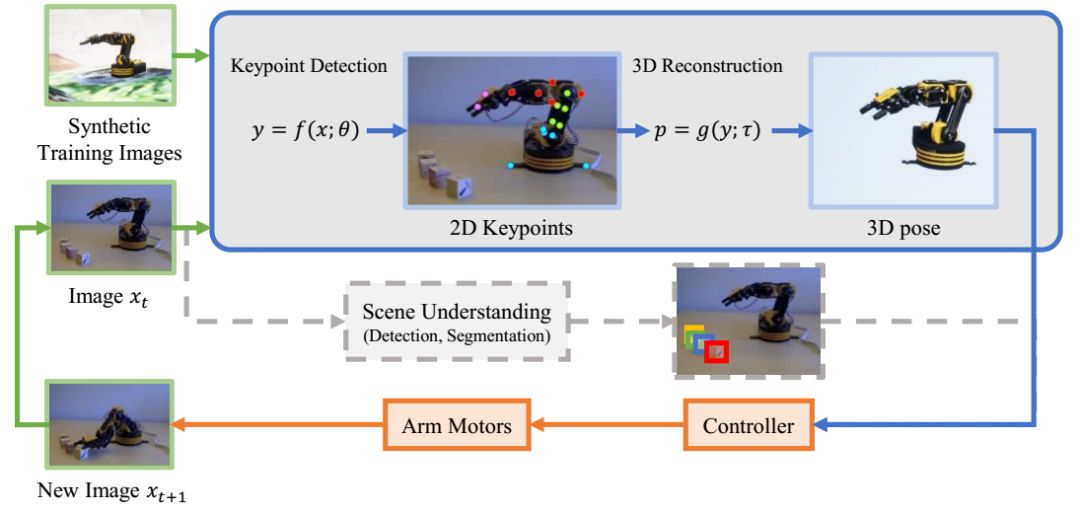

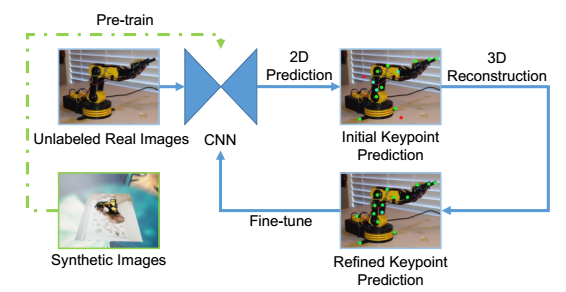

4、CRAVES: Controlling Robotic Arm with a Vision-based Economic System(CVPR2019)

訓(xùn)練機(jī)器人手臂來完成現(xiàn)實(shí)世界的任務(wù)已經(jīng)引起學(xué)術(shù)界和工業(yè)界越來越多的關(guān)注。本文討論了計(jì)算機(jī)視覺算法在這一領(lǐng)域中的作用并專注于沒有傳感器的低成本機(jī)械臂,因此所有的決策都是基于視覺識別,例如實(shí)時三維姿態(tài)估計(jì)。然而,這就需要標(biāo)注大量的訓(xùn)練數(shù)據(jù),不僅費(fèi)時而且費(fèi)力。基于該原因,本文提出了一種新的解決方案,即利用三維模型生成大量的合成數(shù)據(jù),在該虛擬域中訓(xùn)練一個視覺模型,并在域自適應(yīng)后應(yīng)用于真實(shí)圖像。為此,論文設(shè)計(jì)了一個半監(jiān)督方法,充分利用了關(guān)鍵點(diǎn)之間的幾何約束,并采用迭代算法進(jìn)行優(yōu)化。該算法不需要對真實(shí)圖像進(jìn)行任何標(biāo)注,具有很好的推廣性,在兩個真實(shí)數(shù)據(jù)集上得到了不錯的三維姿態(tài)估計(jì)結(jié)果。本文還構(gòu)建了一個基于視覺的任務(wù)完成控制系統(tǒng),在虛擬環(huán)境中訓(xùn)練了一個強(qiáng)化學(xué)習(xí)agent,并將其應(yīng)用于現(xiàn)實(shí)世界。

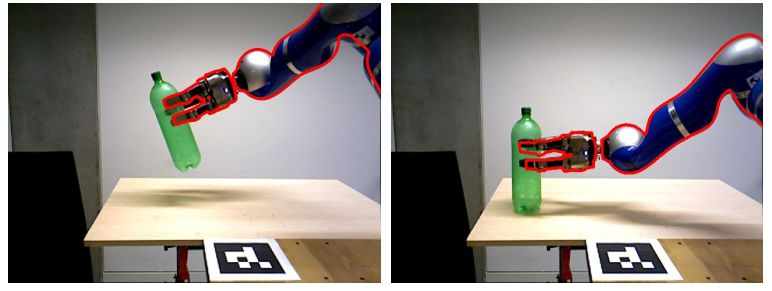

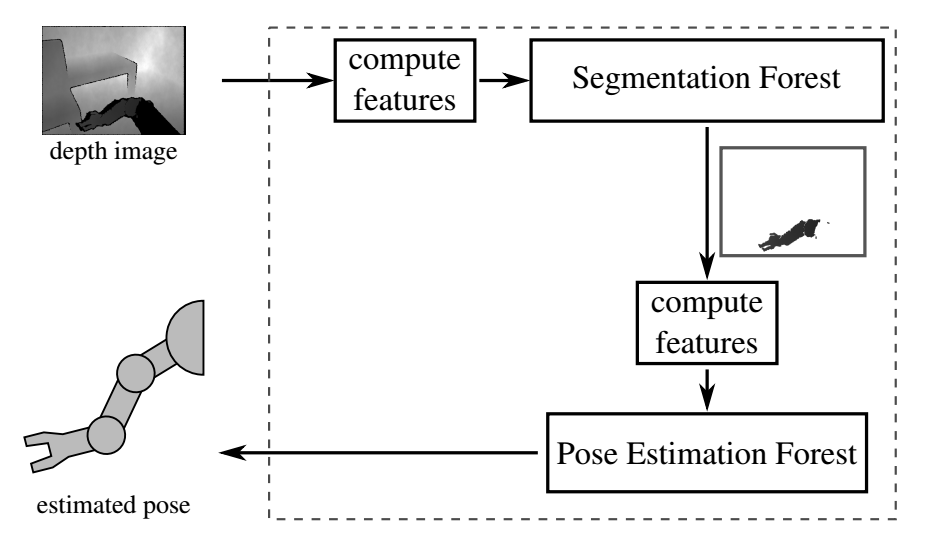

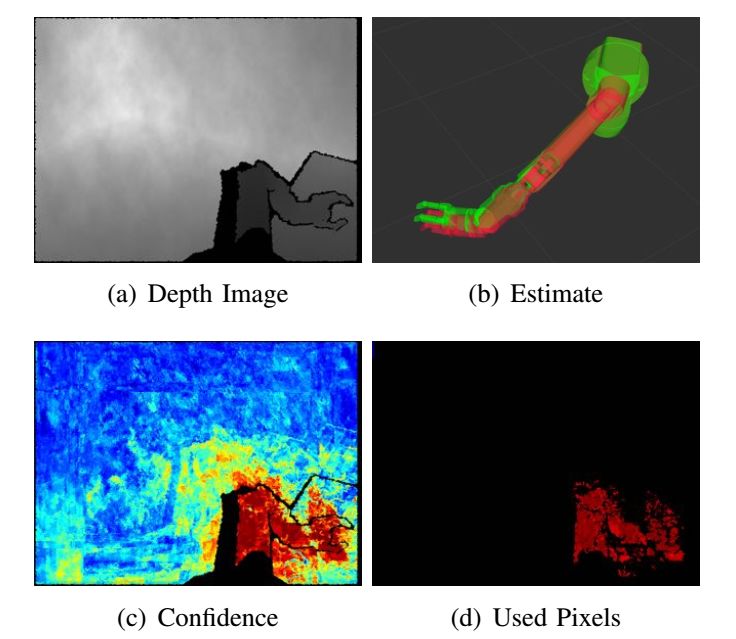

5、Robot Arm Pose Estimation by Pixel-wise Regression of Joint Angles(ICRA)

為了用機(jī)械臂實(shí)現(xiàn)基于視覺的精確控制,需要良好的手眼協(xié)調(diào)。然而,由于來自關(guān)節(jié)編碼器的噪聲讀數(shù)或不準(zhǔn)確的手眼校準(zhǔn),了解手臂的當(dāng)前配置可能非常困難。提出了一種以手臂深度圖像為輸入,直接估計(jì)關(guān)節(jié)角位置的機(jī)器人手臂姿態(tài)估計(jì)方法。這是一種逐幀的方法,它不依賴于前一幀解的良好初始化或來自聯(lián)合編碼器的知識。為了進(jìn)行估計(jì),本文使用了一個隨機(jī)回歸森林,它基于綜合生成的數(shù)據(jù)進(jìn)行訓(xùn)練。論文比較了隨機(jī)森林的不同訓(xùn)練目標(biāo),并分析了手臂的先驗(yàn)分割對訓(xùn)練精度的影響。實(shí)驗(yàn)表明,這種方法提高了先前的工作,無論是在計(jì)算復(fù)雜性和準(zhǔn)確性方面。盡管只對合成數(shù)據(jù)進(jìn)行了訓(xùn)練,但這種估計(jì)也適用于真實(shí)的深度圖像。

-

機(jī)器人

+關(guān)注

關(guān)注

213文章

29469瀏覽量

211522 -

高精度

+關(guān)注

關(guān)注

1文章

631瀏覽量

25930 -

視覺伺服

+關(guān)注

關(guān)注

0文章

11瀏覽量

7928

原文標(biāo)題:面向高精度領(lǐng)域的視覺伺服算法匯總

文章出處:【微信號:vision263com,微信公眾號:新機(jī)器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

全自動打靶機(jī)系統(tǒng),視覺對位算法精度高操作簡單

如何實(shí)現(xiàn)高精度且高定位來控制伺服電機(jī)?

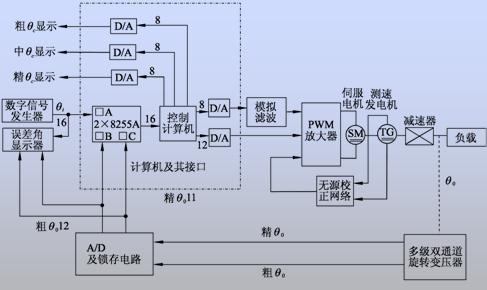

基于DSP高精度伺服位置環(huán)設(shè)計(jì)

基于FFT的高精度頻率估計(jì)算法

基于視覺的高速高精度貼片機(jī)系統(tǒng)的程序?qū)崿F(xiàn)

基于FPGA的交流伺服高精度反饋系統(tǒng)

使用機(jī)械手和視覺技術(shù)實(shí)現(xiàn)機(jī)器視覺的高精度插件系統(tǒng)的資料說明

如何對RTK高精度定位算法進(jìn)行驗(yàn)證

高精度視覺識別與定位的算法

內(nèi)置RTK算法的GNSS全頻點(diǎn)高精度定位模塊介紹

高精度電流源的應(yīng)用領(lǐng)域有哪些

面向高精度領(lǐng)域的視覺伺服算法匯總

面向高精度領(lǐng)域的視覺伺服算法匯總

評論