?背景

?背景

在機器學習領域中,學習不平衡的標注數據一直是一個常見而具有挑戰性的任務。近年來,視覺 Transformer 作為一種強大的模型,在多個視覺任務上展現出令人滿意的效果。然而,視覺 Transformer 處理長尾分布數據的能力和特性,還有待進一步挖掘。

目前,已有的長尾識別模型很少直接利用長尾數據對視覺 Transformer(ViT)進行訓練。基于現成的預訓練權重進行研究可能會導致不公平的比較結果,因此有必要對視覺 Transformer 在長尾數據下的表現進行系統性的分析和總結。

論文鏈接:

https://arxiv.org/abs/2212.02015代碼鏈接:

https://github.com/XuZhengzhuo/LiVT 本文旨在填補這一研究空白,詳細探討了視覺 Transformer 在處理長尾數據時的優勢和不足之處。本文將重點關注如何有效利用長尾數據來提升視覺 Transformer 的性能,并探索解決數據不平衡問題的新方法。通過本文的研究和總結,研究團隊有望為進一步改進視覺 Transformer 模型在長尾數據任務中的表現提供有益的指導和啟示。這將為解決現實世界中存在的數據不平衡問題提供新的思路和解決方案。 文章通過一系列實驗發現,在有監督范式下,視覺 Transformer 在處理不平衡數據時會出現嚴重的性能衰退,而使用平衡分布的標注數據訓練出的視覺 Transformer 呈現出明顯的性能優勢。相比于卷積網絡,這一特點在視覺 Transformer 上體現的更為明顯。另一方面,無監督的預訓練方法無需標簽分布,因此在相同的訓練數據量下,視覺 Transformer 可以展現出類似的特征提取和重建能力。 基于以上觀察和發現,研究提出了一種新的學習不平衡數據的范式,旨在讓視覺 Transformer 模型更好地適應長尾數據。通過這種范式的引入,研究團隊希望能夠充分利用長尾數據的信息,提高視覺 Transformer 模型在處理不平衡標注數據時的性能和泛化能力。 ?文章貢獻

本文是第一個系統性的研究用長尾數據訓練視覺 Transformer 的工作,在此過程中,做出了以下主要貢獻:

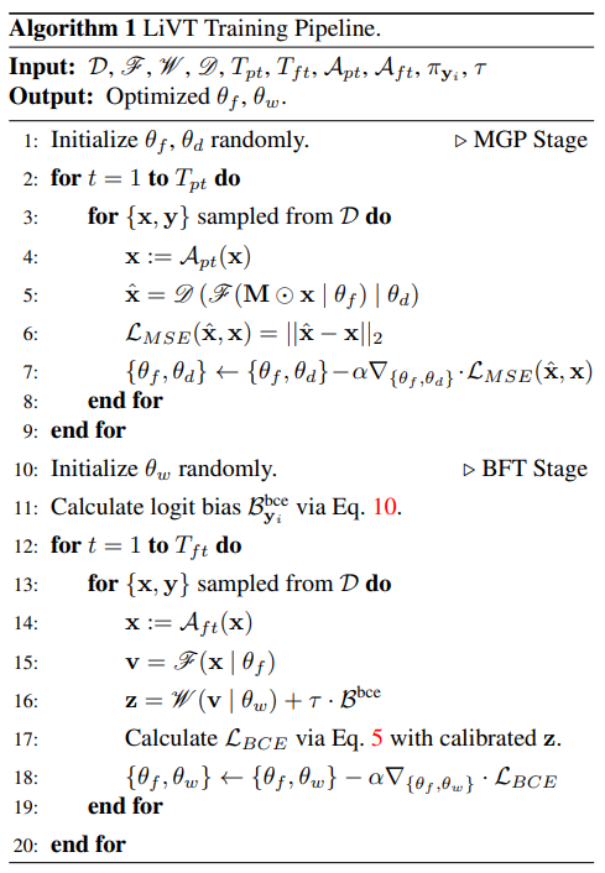

首先,本文深入分析了傳統有監督訓練方式對視覺 Transformer 學習不均衡數據的限制因素,并基于此提出了雙階段訓練流程,將視覺 Transformer 模型內在的歸納偏置和標簽分布的統計偏置分階段學習,以降低學習長尾數據的難度。其中第一階段采用了流行的掩碼重建預訓練,第二階段采用了平衡的損失進行微調監督。

?文章貢獻

本文是第一個系統性的研究用長尾數據訓練視覺 Transformer 的工作,在此過程中,做出了以下主要貢獻:

首先,本文深入分析了傳統有監督訓練方式對視覺 Transformer 學習不均衡數據的限制因素,并基于此提出了雙階段訓練流程,將視覺 Transformer 模型內在的歸納偏置和標簽分布的統計偏置分階段學習,以降低學習長尾數據的難度。其中第一階段采用了流行的掩碼重建預訓練,第二階段采用了平衡的損失進行微調監督。

?

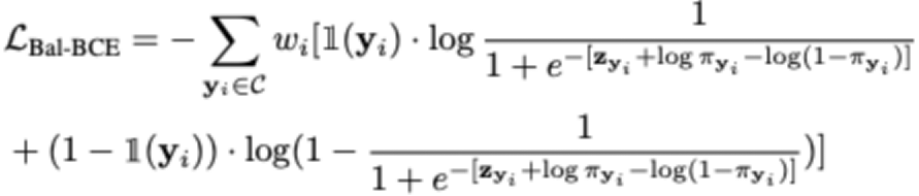

?其次,本文提出了平衡的二進制交叉熵損失函數,并給出了嚴格的理論推導。平衡的二進制交叉熵損失的形式如下:

?

?其次,本文提出了平衡的二進制交叉熵損失函數,并給出了嚴格的理論推導。平衡的二進制交叉熵損失的形式如下:

?

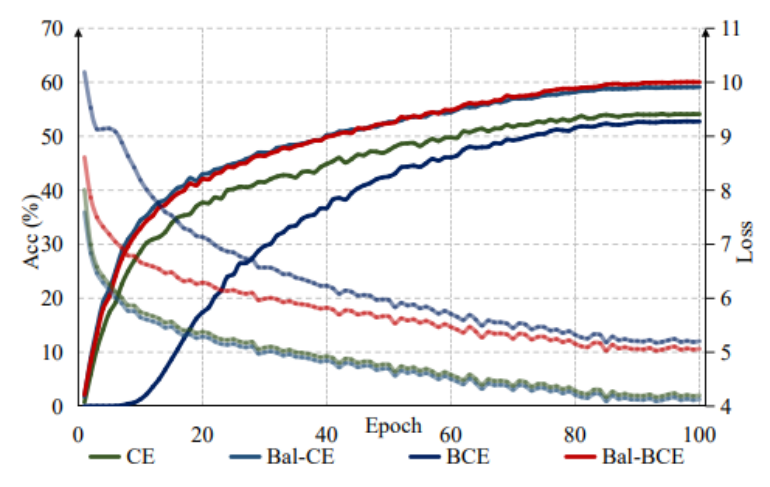

?與之前的平衡交叉熵損失相比,本文的損失函數在視覺 Transformer 模型上展現出更好的性能,并且具有更快的收斂速度。研究中的理論推導為損失函數的合理性提供了嚴密的解釋,進一步加強了我們方法的可靠性和有效性。

?

?與之前的平衡交叉熵損失相比,本文的損失函數在視覺 Transformer 模型上展現出更好的性能,并且具有更快的收斂速度。研究中的理論推導為損失函數的合理性提供了嚴密的解釋,進一步加強了我們方法的可靠性和有效性。

▲不同損失函數的收斂速度的比較

基于以上貢獻,文章提出了一個全新的學習范式 LiVT,充分發揮視覺 Transformer 模型在長尾數據上的學習能力,顯著提升模型在多個數據集上的性能。該方案在多個數據集上取得了遠好于視覺 Transformer 基線的性能表現。

▲不同損失函數的收斂速度的比較

基于以上貢獻,文章提出了一個全新的學習范式 LiVT,充分發揮視覺 Transformer 模型在長尾數據上的學習能力,顯著提升模型在多個數據集上的性能。該方案在多個數據集上取得了遠好于視覺 Transformer 基線的性能表現。

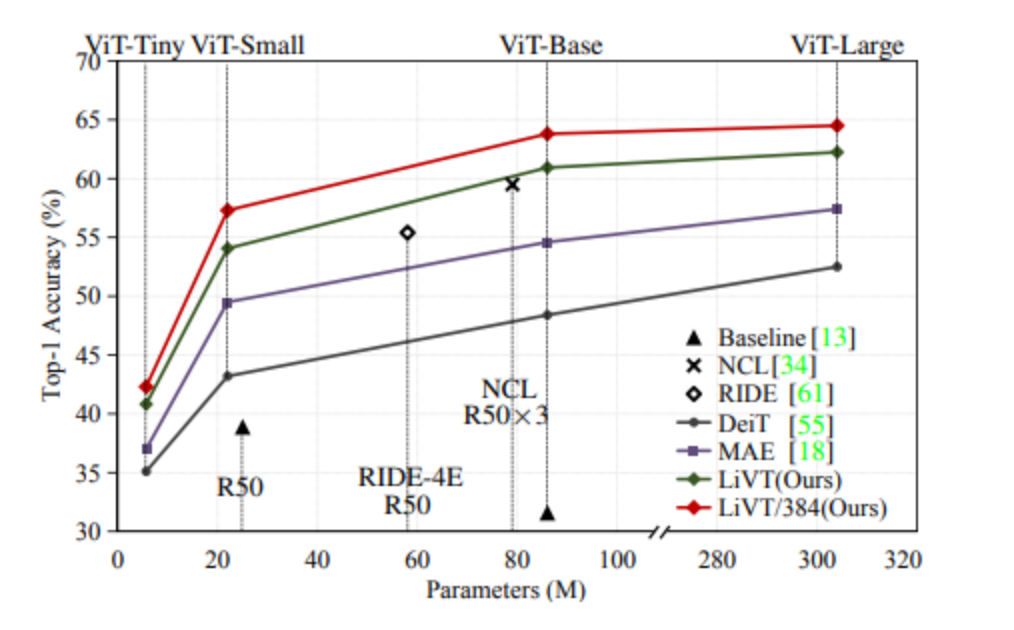

▲不同參數量下在ImageNet-LT上的準確性

▲不同參數量下在ImageNet-LT上的準確性

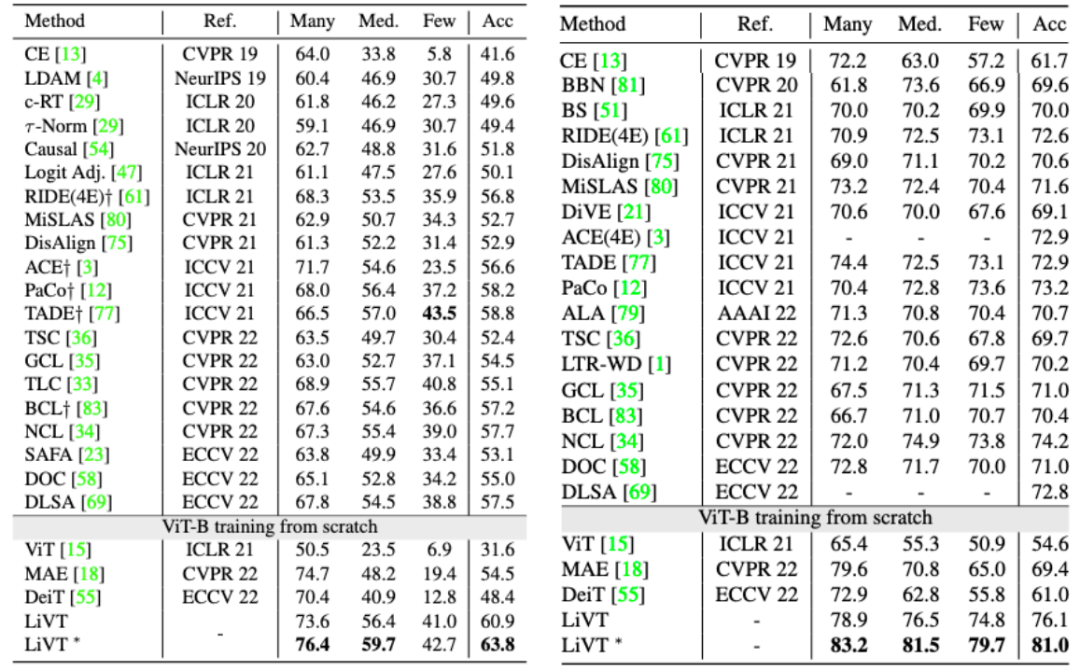

▲在ImagNet-LT(左)和iNaturalist18(右)數據集上的性能表現

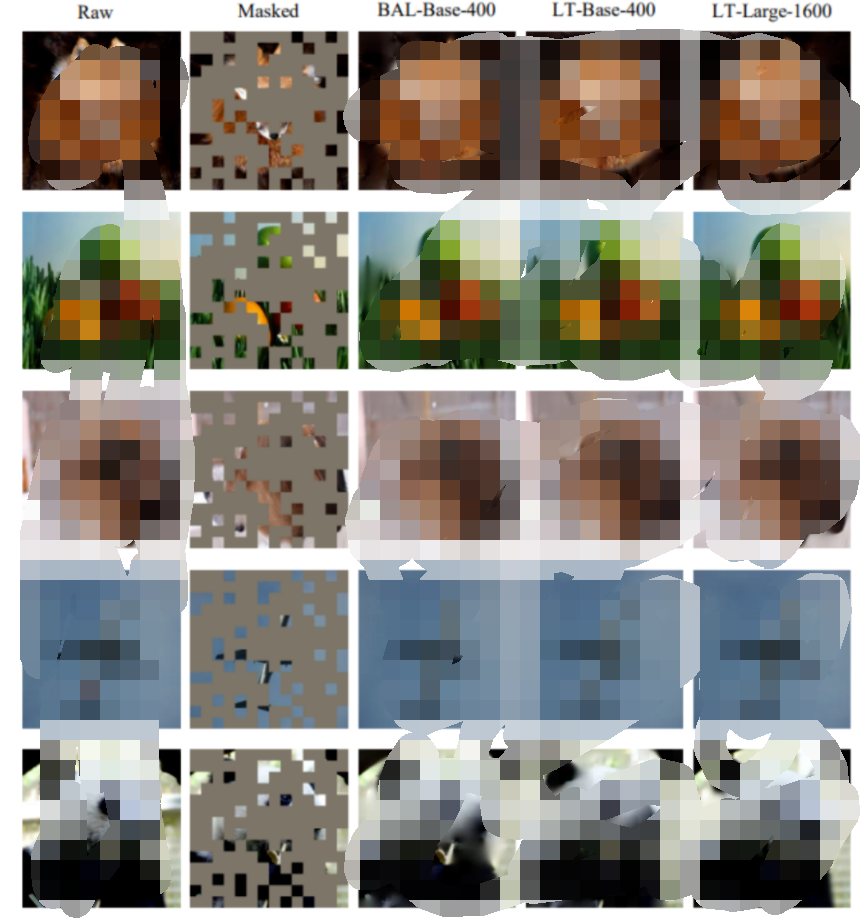

▲在ImagNet-LT(左)和iNaturalist18(右)數據集上的性能表現同時,本文還驗證了在相同的訓練數據規模的情況下,使用ImageNet的長尾分布子集(LT)和平衡分布子集(BAL)訓練的 ViT-B 模型展現出相近的重建能力。如 LT-Large-1600 列所示,在 ImageNet-LT 數據集中,可以通過更大的模型和 MGP epoch 獲得更好的重建結果。

?

?

?

? ?

?總結

本文提供了一種新的基于視覺 Transformer 處理不平衡數據的方法 LiVT。LiVT 利用掩碼建模和平衡微調兩個階段的訓練策略,使得視覺 Transformer 能夠更好地適應長尾數據分布并學習到更通用的特征表示。該方法不僅在實驗中取得了顯著的性能提升,而且無需額外的數據,具有實際應用的可行性。 論文的更多細節請參考論文原文和補充材料。

-

物聯網

+關注

關注

2927文章

45847瀏覽量

387812

原文標題:CVPR 2023 | 清華大學提出LiVT,用視覺Transformer學習長尾數據

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

從清華大學到鎵未來科技,張大江先生在半導體功率器件十八年的堅守!

清華大學攜手華為打造業內首個園區網絡智能體

2025年開放原子校源行清華大學站成功舉辦

奇瑞汽車攜手清華大學發布“分體式飛行汽車”專利

清華大學鯤鵬昇騰科教創新卓越中心專項合作啟動,引領高校科研和人才培養新模式

清華大學與華為啟動“卓越中心”專項合作

清華大學DeepSeek指南:從入門到精通

清華大學師生到訪智行者科技交流學習

博世與清華大學續簽人工智能研究合作協議

京微齊力受邀參加2024年清華大學工程博士論壇

英諾達與清華大學攜手,共促國產EDA進步

熱烈歡迎清華大學電子工程系學子來武漢六博光電交流實踐!

CVPR 2023 | 清華大學提出LiVT,用視覺Transformer學習長尾數據

CVPR 2023 | 清華大學提出LiVT,用視覺Transformer學習長尾數據

評論