在 ChatGPT 引爆科技領(lǐng)域之后,人們一直在討論 AI「下一步」的發(fā)展會是什么,很多學(xué)者都提到了多模態(tài),我們并沒有等太久。近期,OpenAI 發(fā)布了多模態(tài)預(yù)訓(xùn)練大模型 GPT-4,GPT-4 實現(xiàn)了以下幾個方面的飛躍式提升:強大的識圖能力、文字輸入限制提升至 2.5 萬字、回答準確性顯著提高、能夠生成歌詞、創(chuàng)意文本,實現(xiàn)風格變化。

如此高效的迭代,離不開人工智能大規(guī)模模型訓(xùn)練,需要大量的計算資源和高速的數(shù)據(jù)傳輸網(wǎng)絡(luò)。其中,端到端IB(InfiniBand)網(wǎng)絡(luò)是一種高性能計算網(wǎng)絡(luò),特別適合用于高性能計算和人工智能模型訓(xùn)練。本文將介紹什么是AIGC模型訓(xùn)練,為什么需要端到端IB網(wǎng)絡(luò)以及如何使用ChatGPT模型進行AIGC訓(xùn)練。

AIGC是什么?

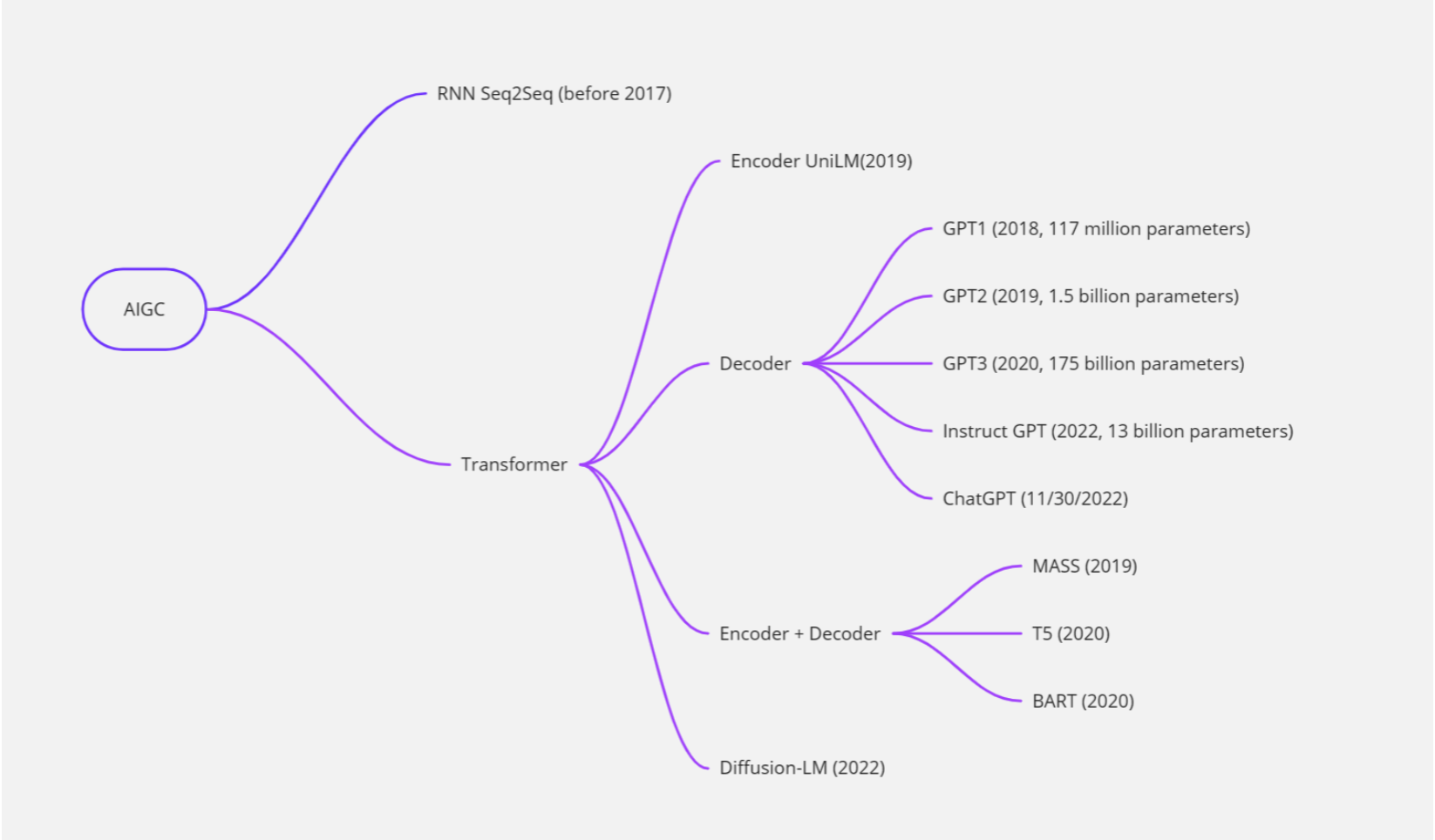

AIGC 即 AI Generated Content,是指人工智能自動生成內(nèi)容,可用于繪畫、寫作、視頻等多種類型的內(nèi)容創(chuàng)作。2022年AIGC高速發(fā)展,這其中深度學(xué)習模型不斷完善、開源模式的推動、大模型探索商業(yè)化的可能,成為AIGC發(fā)展的“加速度”。以最近爆火的聊天機器人ChatGPT為例,這款機器人既會寫論文,也能創(chuàng)作小說,還可編代碼,上線僅2個月,月活用戶達1億。因為出乎意料的“聰明”,AIGC被認為是“科技行業(yè)的下一個顛覆者”“內(nèi)容生產(chǎn)力的一次重大革命”。

大型語言模型(LLM)和ChatGPT

大型語言模型(Large Language Model)是一種能夠自動學(xué)習并理解自然語言的人工智能技術(shù)。它通常基于深度學(xué)習算法,通過對大量文本數(shù)據(jù)的學(xué)習來獲取語言知識,并能夠自動生成自然語言文本,如對話、文章等。

ChatGPT是一種基于大型語言模型的聊天機器人,它采用了OpenAI開發(fā)的GPT(Generative Pre-trained Transformer)模型,通過對大量文本數(shù)據(jù)的預(yù)訓(xùn)練和微調(diào),能夠生成富有語言表達力的自然語言文本,并實現(xiàn)與用戶的交互。

因此,可以說ChatGPT是一種基于大型語言模型技術(shù)的聊天機器人,它利用了大型語言模型的強大語言理解和生成能力,從而能夠在對話中進行自然語言文本的生成和理解。

隨著深度學(xué)習技術(shù)的發(fā)展,大型語言模型的能力和規(guī)模不斷提升。最初的語言模型(如N-gram模型)只能考慮有限的上下文信息,而現(xiàn)代的大型語言模型(如BERT、GPT-3等)能夠考慮更長的上下文信息,并且具有更強的泛化能力和生成能力。

大型語言模型通常采用深度神經(jīng)網(wǎng)絡(luò)進行訓(xùn)練,如循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)、長短時記憶網(wǎng)絡(luò)(LSTM)、門控循環(huán)單元(GRU)和變壓器網(wǎng)絡(luò)(Transformer)等。在訓(xùn)練中,模型利用大規(guī)模的文本數(shù)據(jù)集,采用無監(jiān)督或半監(jiān)督的方式進行訓(xùn)練。例如,BERT模型通過預(yù)測掩碼、下一個句子等任務(wù)來訓(xùn)練,而GPT-3則采用了大規(guī)模的自監(jiān)督學(xué)習方式。

大型語言模型在自然語言處理領(lǐng)域有廣泛的應(yīng)用,例如機器翻譯、自然語言生成、問答系統(tǒng)、文本分類、情感分析等。

當前訓(xùn)練LLM的瓶頸在哪里?

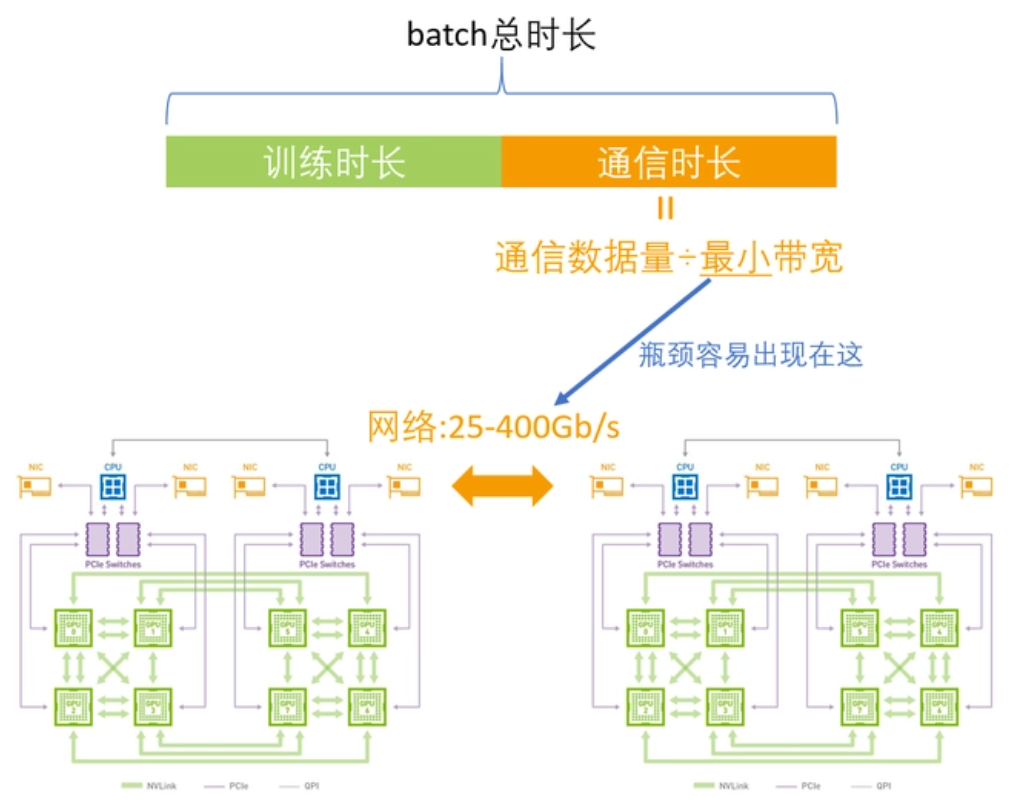

在訓(xùn)練大型語言模型時,需要高速、可靠的網(wǎng)絡(luò)來傳輸大量的數(shù)據(jù)。例如OpenAI發(fā)布了第一版GPT模型(GPT-1),其模型規(guī)模為1.17億個參數(shù)。之后,OpenAI相繼發(fā)布了GPT-2和GPT-3等更大的模型,分別擁有1.5億和1.75萬億個參數(shù)。如此大的參數(shù)在單機訓(xùn)練是完全不可能的,需要高度依賴GPU計算集群,目前的瓶頸在于如何解決訓(xùn)練集群中各節(jié)點之間高效通信的問題。

目前比較常用的GPU通信算法就是Ring-Allreduce。其基本思想就是讓GPU形成一個環(huán),讓數(shù)據(jù)在環(huán)內(nèi)流動。環(huán)中的GPU都被安排在一個邏輯中,每個GPU有一個左鄰和一個右鄰,它只會向它的右鄰居發(fā)送數(shù)據(jù),并從它的左鄰居接收數(shù)據(jù)。

該算法分兩個步驟進行:首先是scatter-reduce,然后是allgather。在scatter-reduce步驟中,GPU將交換數(shù)據(jù),使每個GPU可得到最終結(jié)果的一個塊。在allgather步驟中,GPU將交換這些塊,以便所有GPU得到完整的最終結(jié)果。

在早期,單機內(nèi)部沒有NVLink,網(wǎng)絡(luò)上沒有RDMA,帶寬相對較低,單機分布式和多機分布式在帶寬上沒太大差別,所以建一個大環(huán)即可。

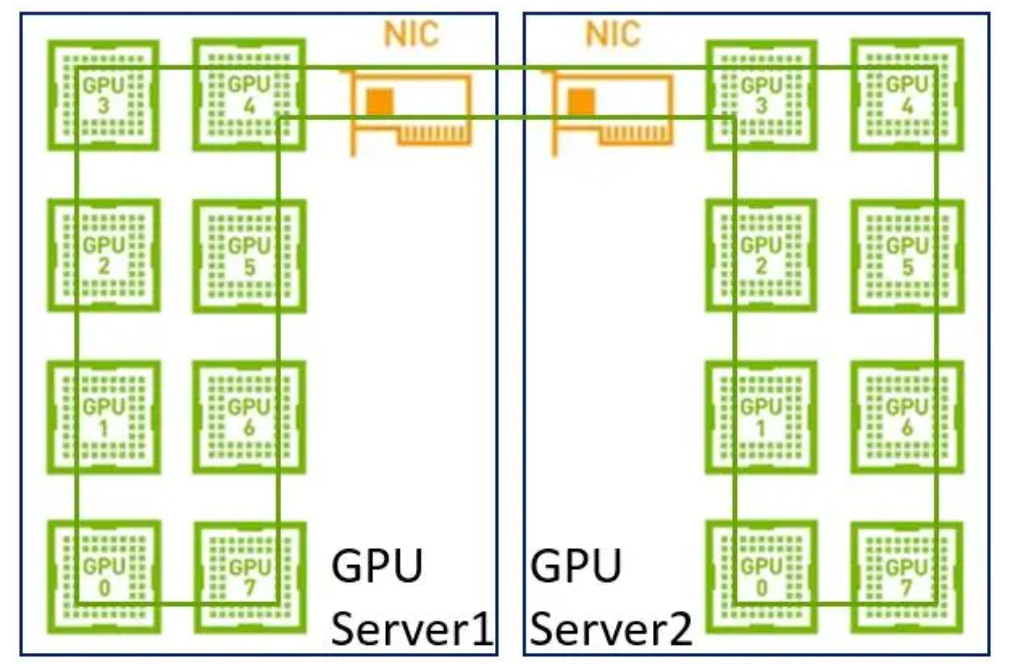

但是現(xiàn)在我們單機內(nèi)部有了NVLink,在使用同樣的方法就不合適了。因為網(wǎng)絡(luò)的帶寬是遠低于NVLink,如果再用一個大環(huán),那會導(dǎo)致NVLink的高帶寬被嚴重拉低到網(wǎng)絡(luò)的水平。其次,現(xiàn)在是具備多網(wǎng)卡的環(huán)境,如果只用一個環(huán)也無法充分利用多網(wǎng)卡優(yōu)勢。

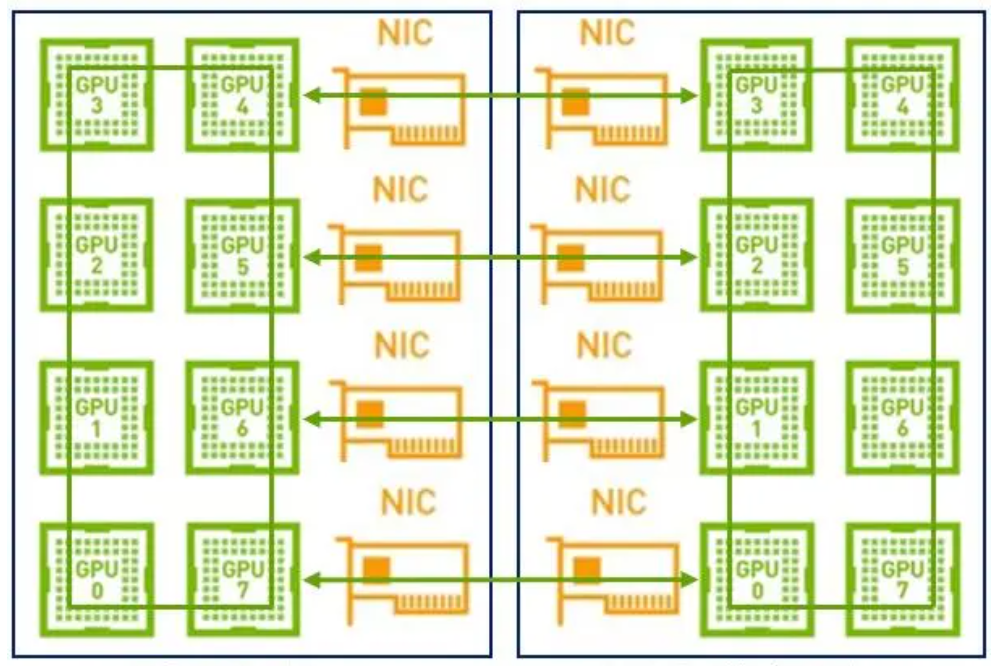

因此,在這樣的場景下建議采用兩級環(huán):首先利用NVLink高帶寬優(yōu)勢在單機內(nèi)部的GPU之間完成數(shù)據(jù)同步;然后多機之間的GPU利用多網(wǎng)卡建立多個環(huán),對不同分段數(shù)據(jù)進行同步;最后單機內(nèi)部的GPU再同步一次,最終完成全部GPU的數(shù)據(jù)同步,在這里就不得不提到NCCL。

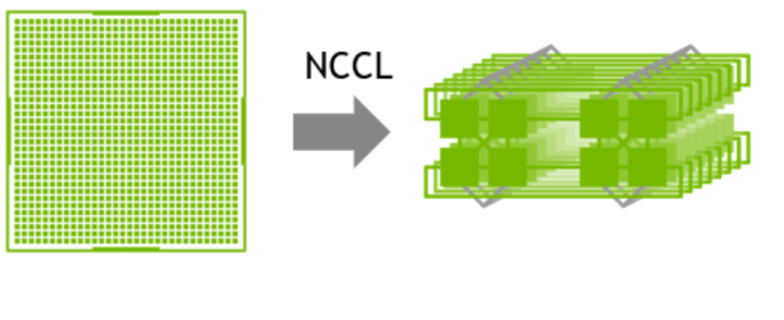

NVIDIA集體通信庫(NCCL)實現(xiàn)了針對NVIDIA GPU和網(wǎng)絡(luò)優(yōu)化的多GPU和多節(jié)點通信原語。

1GPU->multi-GPU multi node

NCCL提供全收集、全減、廣播、減少、減少散射以及點對點發(fā)送和接收等例程,這些例程經(jīng)過優(yōu)化,通過節(jié)點內(nèi)和NVIDIA Mellanox網(wǎng)絡(luò)通過PCIe和NVLink高速互連實現(xiàn)高帶寬和低延遲。

為什么要使用端到端IB網(wǎng)絡(luò)?

以太網(wǎng)是一種廣泛使用的網(wǎng)絡(luò)協(xié)議,但其傳輸速率和延遲無法滿足大型模型訓(xùn)練的需求。相比之下,端到端IB(InfiniBand)網(wǎng)絡(luò)是一種高性能計算網(wǎng)絡(luò),能夠提供高達 400 Gbps 的傳輸速率和微秒級別的延遲,遠高于以太網(wǎng)的性能。這使得IB網(wǎng)絡(luò)成為大型模型訓(xùn)練的首選網(wǎng)絡(luò)技術(shù)。

此外,端到端IB網(wǎng)絡(luò)還支持數(shù)據(jù)冗余和糾錯機制,能夠保證數(shù)據(jù)傳輸?shù)目煽啃浴_@在大型模型訓(xùn)練中尤為重要,因為在處理如此多的數(shù)據(jù)時,數(shù)據(jù)傳輸錯誤或數(shù)據(jù)丟失可能會導(dǎo)致訓(xùn)練過程中斷甚至失敗。

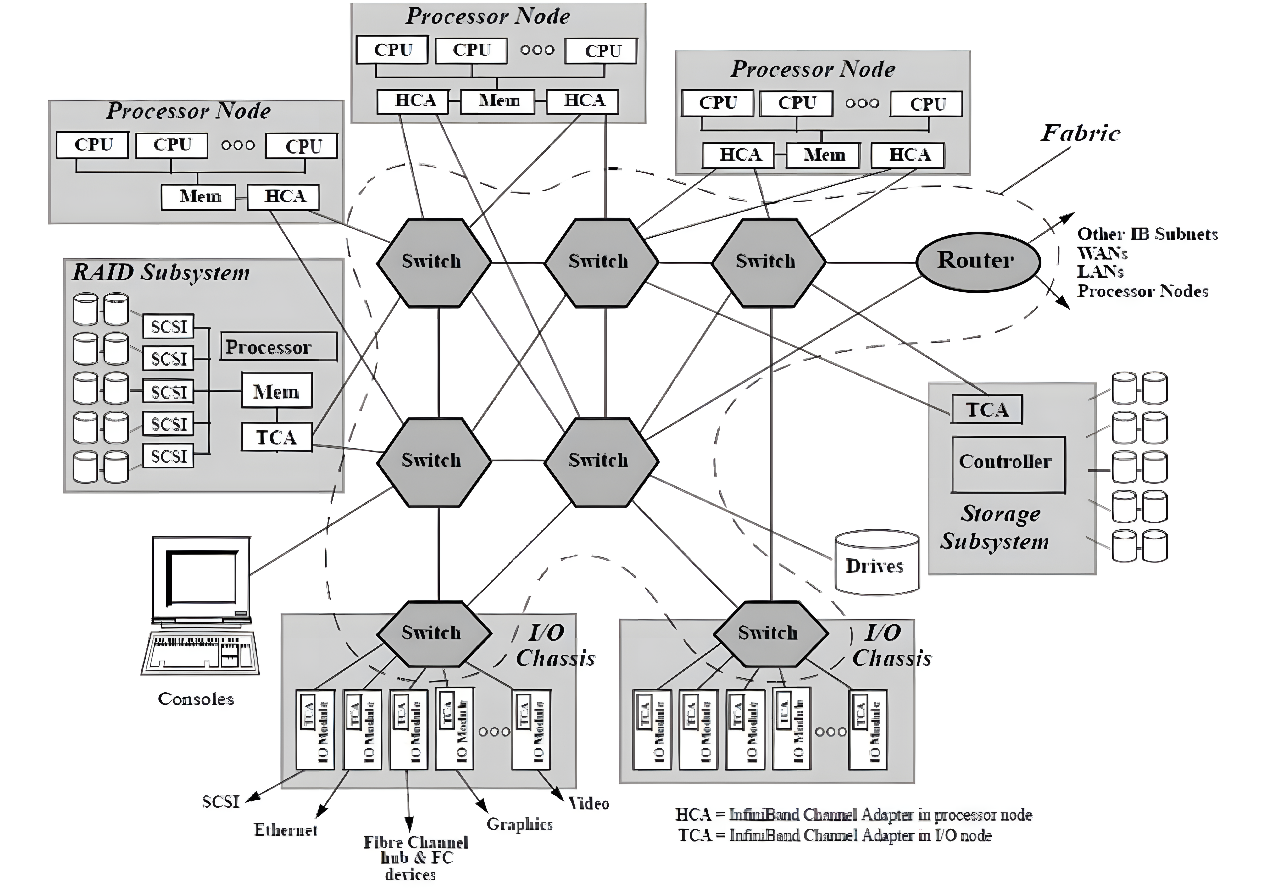

隨著網(wǎng)絡(luò)節(jié)點數(shù)目的急劇增加和計算能力不斷上升,高性能計算消除性能瓶頸和改進系統(tǒng)管理變得比以往更加重要。InfiniBand被認為是可以提升當前I/O架構(gòu)性能瓶頸的一種極具潛力的I/O技術(shù),如圖所示。InfiniBand是一種普及的、低延遲的、高帶寬的互連通信協(xié)議,處理開銷很低,非常適合在單個連接上承載多種流量類型(集群、通信、存儲和管理)。1999年,IBTA (InfiniBand Trade Association)制定了InfiniBand相關(guān)標準,在InfiniBand?中規(guī)范定義了用于互連服務(wù)器、通信基礎(chǔ)設(shè)施設(shè)備、存儲和嵌入式系統(tǒng)的輸入/輸出體系結(jié)構(gòu)。InfiniBand是一項成熟的、經(jīng)過現(xiàn)場驗證的技術(shù),被廣泛應(yīng)用于高性能計算集群中。

InfiniBand互連架構(gòu)圖

InfiniBand互聯(lián)協(xié)議中規(guī)定,每個端節(jié)點必須有一個主機通道適配器(HCA)來設(shè)置和維護與主機設(shè)備的鏈接,交換機包含多個端口,并將數(shù)據(jù)包從一個端口轉(zhuǎn)發(fā)到另一個端口,完成在子網(wǎng)內(nèi)傳輸數(shù)據(jù)的功能。子網(wǎng)管理器(Subnet Manager, SM)用于配置其本地子網(wǎng)并確保其持續(xù)運行,借助子網(wǎng)管理器數(shù)據(jù)包(Subnet Manager Packet, SMP)和每個InfiniBand設(shè)備上的子網(wǎng)管理代理(Subnet Manager Agent, SMA),子網(wǎng)管理器發(fā)現(xiàn)并初始化網(wǎng)絡(luò),為所有設(shè)備分配唯一標識符,確定MTU(Maximum Transmission Unit,最小傳輸單元),并根據(jù)選定的路由算法生成交換機路由表。SM還定期對子網(wǎng)進行光掃描,以檢測任何拓撲變化,并相應(yīng)地配置網(wǎng)絡(luò)。與其他網(wǎng)絡(luò)通信協(xié)議相比,InfiniBand網(wǎng)絡(luò)提供了更高的帶寬、更低的延遲和更強的可擴展性。此外,由于InfiniBand提供了基于credit的流控制(其中發(fā)送方節(jié)點發(fā)送的數(shù)據(jù)不會超過鏈路另一端的接收緩沖區(qū)公布的credit數(shù)量),傳輸層不需要像TCP窗口算法那樣的丟包機制來確定最佳的正在傳輸?shù)臄?shù)據(jù)包數(shù)量,這使得InfiniBand網(wǎng)絡(luò)能夠以極低的延遲和極低的CPU使用率為應(yīng)用程序提供極高的數(shù)據(jù)傳輸速率。InfiniBand使用RDMA技術(shù)(Remote Direct Memory Access,遠程直接內(nèi)存訪問)將數(shù)據(jù)從通道一端傳輸?shù)搅硪欢耍琑DMA是一種通過網(wǎng)絡(luò)在應(yīng)用程序之間直接傳輸數(shù)據(jù)的協(xié)議,無需操作系統(tǒng)的參與,同時消耗雙方極低的CPU資源(零拷貝傳輸),一端的應(yīng)用程序只需直接從內(nèi)存中讀取消息,消息就已成功傳輸,減少的CPU開銷增加了網(wǎng)絡(luò)快速傳輸數(shù)據(jù)的能力,并允許應(yīng)用程序更快地接收數(shù)據(jù)。

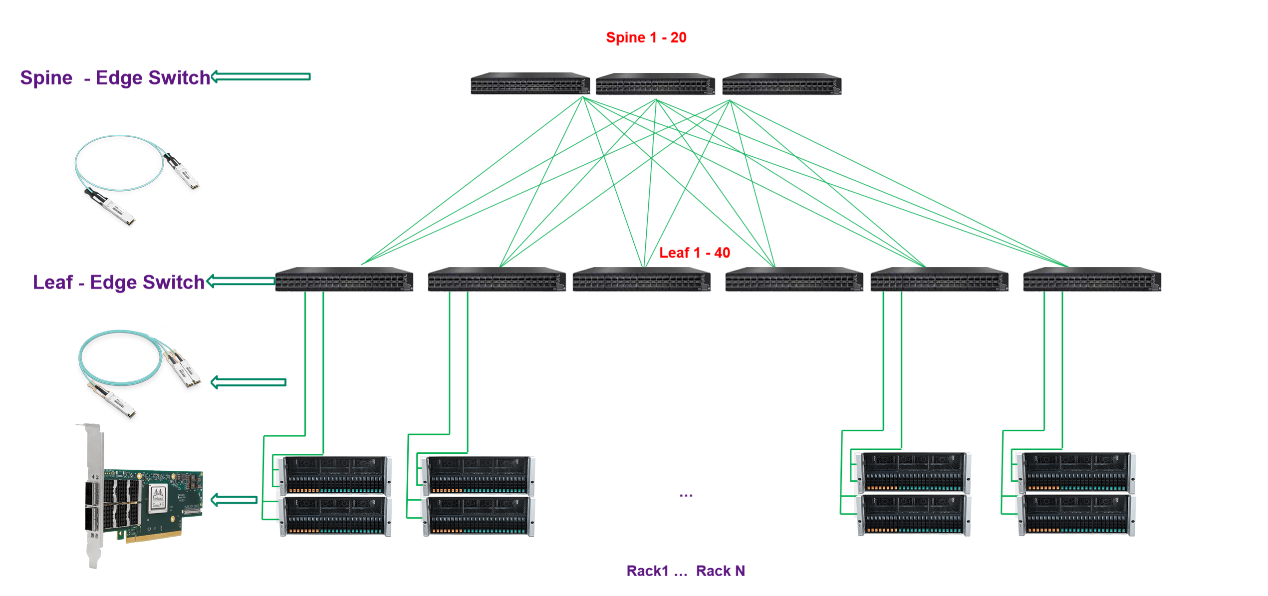

納多德端到端IB網(wǎng)絡(luò)解決方案

納多德基于對高速率網(wǎng)絡(luò)發(fā)展趨勢的理解,和豐富的HPC、AI項目實施經(jīng)驗,提供基于NVIDIA Quantum-2交換機、 ConnectX InfiniBand 智能網(wǎng)卡和靈活的400Gb/s InfiniBand端到端解決方案,在降低成本和復(fù)雜性的同時在高性能計算 (HPC)、AI 和超大規(guī)模云基礎(chǔ)設(shè)施中帶來超強性能。

納多德數(shù)據(jù)中心IB網(wǎng)絡(luò)解決方案

交換機

更快的服務(wù)器、高性能存儲和日益復(fù)雜的計算應(yīng)用正在將數(shù)據(jù)帶寬要求推向新的高度。NVIDIA Mellanox QM9700 交換機提供具有極低的延遲,NVIDIA Quantum-2 采用第七代 NVIDIA InfiniBand 架構(gòu),可為 AI 開發(fā)者和科學(xué)研究人員提供超強網(wǎng)絡(luò)性能和豐富功能,幫助他們解決充滿挑戰(zhàn)性的問題。NVIDIA Quantum-2 通過軟件定義網(wǎng)絡(luò)、網(wǎng)絡(luò)計算、性能隔離、高級加速引擎、遠程直接內(nèi)存訪問 (RDMA) 以及高達 400 Gb/s 的超快的速度,為先進的超級計算數(shù)據(jù)中心提供助力。

智能網(wǎng)卡

納多德在網(wǎng)卡側(cè)提供NVIDIA ConnectX SmartNIC智能網(wǎng)卡,NVIDIA ConnectX InfiniBand 智能網(wǎng)卡支持更快的速度和創(chuàng)新的網(wǎng)絡(luò)計算技術(shù),實現(xiàn)了超強性能和可擴展性。NVIDIA ConnectX 降低了每次操作的成本,從而可為高性能計算 (HPC)、機器學(xué)習、高性能存儲及數(shù)據(jù)庫業(yè)務(wù)和低延遲嵌入式等應(yīng)用提高投資回報率。來自 NVIDIA Quantum-2 InfiniBand 架構(gòu)的 ConnectX-7 智能網(wǎng)卡(HCA)可提供超高的網(wǎng)絡(luò)性能,用于處理極具挑戰(zhàn)性的工作負載。ConnectX-7 支持超低時延、400Gb/s 吞吐量和創(chuàng)新的 NVIDIA 網(wǎng)絡(luò)計算加速引擎,實現(xiàn)額外加速,為超級計算機、人工智能和超大規(guī)模云數(shù)據(jù)中心提供所需的高可擴展性和功能豐富的技術(shù)。

光模塊

納多德提供靈活的NVIDIA 400Gb/s InfiniBand光連接方案,包括使用單模和多模收發(fā)器、MPO光纖跳線、有源銅纜(ACC)和無源銅纜(DAC),用以滿足搭建各種網(wǎng)絡(luò)拓撲的需要。

>配有帶鰭設(shè)計的 OSFP 連接器的雙端口收發(fā)器適用于風冷固定配置交換機,而配有扁平式OSFP 連接器的雙端口收發(fā)器則適用于液冷模塊化交換機和 HCA 中。

>在交換機互連上,可選擇采用全新OSFP封裝 2XNDR(800Gbps) 光模塊進行兩臺 QM9700交換機的互連,帶鰭的設(shè)計,可以大大提高光模塊散熱性。

>交換機和HCA的互聯(lián)上,交換機端采用OSFP封裝2xNDR(800Gbps)帶鰭光模塊,網(wǎng)卡端采用帶有扁平OSFP 400Gbps光模塊,MPO光纖跳線可提供3-150米,一對二分光器光纖可提供3-50米。

>交換機到HCA的連接也提供DAC(最長1.5米)或者ACC(最長3米)的解決方案,一對二式分接線纜可用于交換機的一個OSFP端口(配備兩個400Gb/s InfiniBand端口)和兩個獨立的400Gb/s HCA。一分四式分接線纜可用于連接交換機的一個OSFP交換機端口和四個200Gb/s HCA。

納多德是光網(wǎng)絡(luò)解決方案的領(lǐng)先提供商,是NVIDIA網(wǎng)絡(luò)產(chǎn)品的Elite Partner,攜手NVIDIA實現(xiàn)光連接+網(wǎng)絡(luò)產(chǎn)品與解決方案的強強聯(lián)合,尤其是在InfiniBand高性能網(wǎng)絡(luò)建設(shè)與應(yīng)用加速方面擁有深刻的業(yè)務(wù)理解和豐富的項目實施經(jīng)驗,可根據(jù)用戶不同的應(yīng)用場景,提供最優(yōu)的InfiniBand高性能交換機+智能網(wǎng)卡+AOC/DAC/光模塊產(chǎn)品組合方案,為數(shù)據(jù)中心、高性能計算、邊緣計算、人工智能等應(yīng)用場景提供更具優(yōu)勢與價值的光網(wǎng)絡(luò)產(chǎn)品和整體解決方案,以低成本和出色的性能,大幅提高客戶業(yè)務(wù)加速能力。

審核編輯:湯梓紅

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5232瀏覽量

105715 -

光模塊

+關(guān)注

關(guān)注

80文章

1376瀏覽量

60000 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1586瀏覽量

8779 -

AIGC

+關(guān)注

關(guān)注

1文章

382瀏覽量

2189

發(fā)布評論請先 登錄

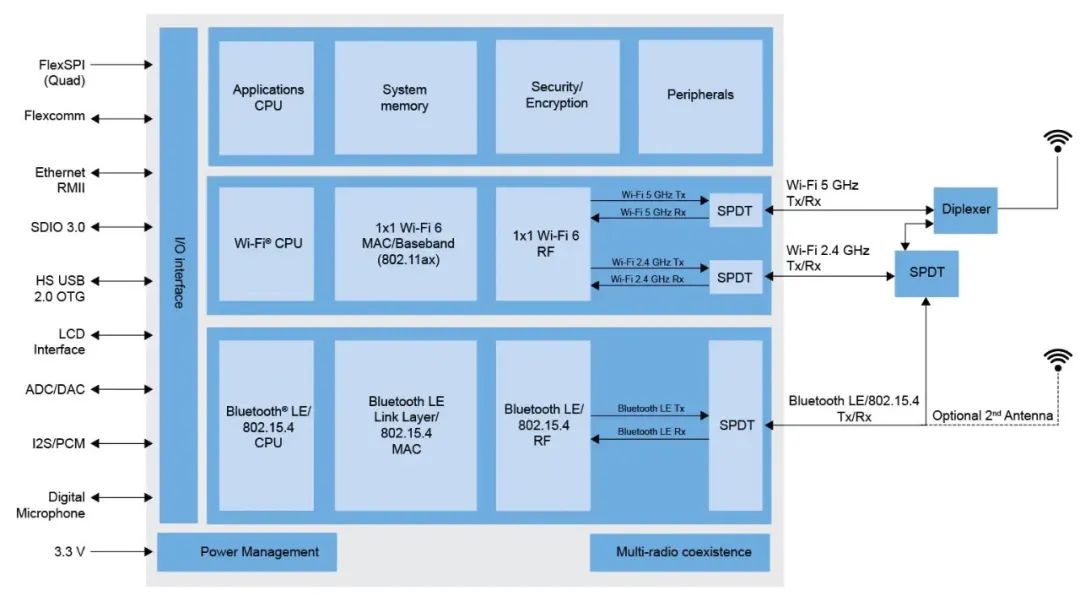

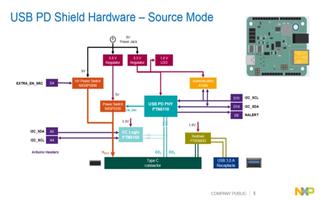

恩智浦完整的Matter端到端解決方案

華為端到端解決方案

集成數(shù)據(jù)網(wǎng)絡(luò)端到端和段到段監(jiān)測解決方案

Airvana宣布全球首個端到端LTE毫微微蜂窩解決方案

USB Type-C端到端解決方案的應(yīng)用

首個基于APP應(yīng)用端的5G SA端到端切片解決方案成功實現(xiàn)

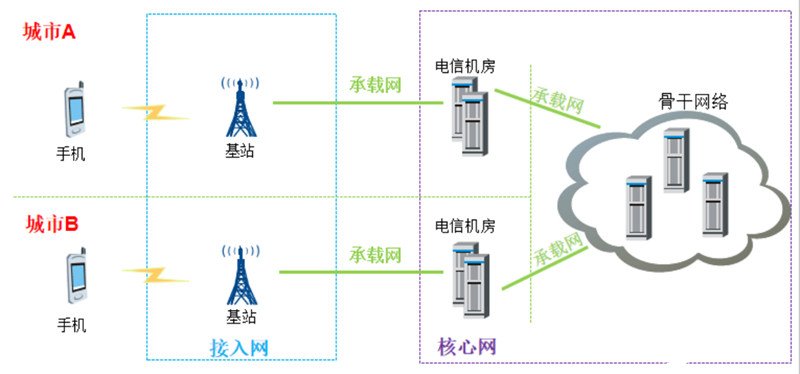

中興通訊端到端傳輸解決方案實現(xiàn)承載業(yè)務(wù)“光速直達”

松下幫助高校提供端到端解決方案

華為IPv6+端到端解決方案通過信通院IPv6+ 2.0 Advanced測試評估

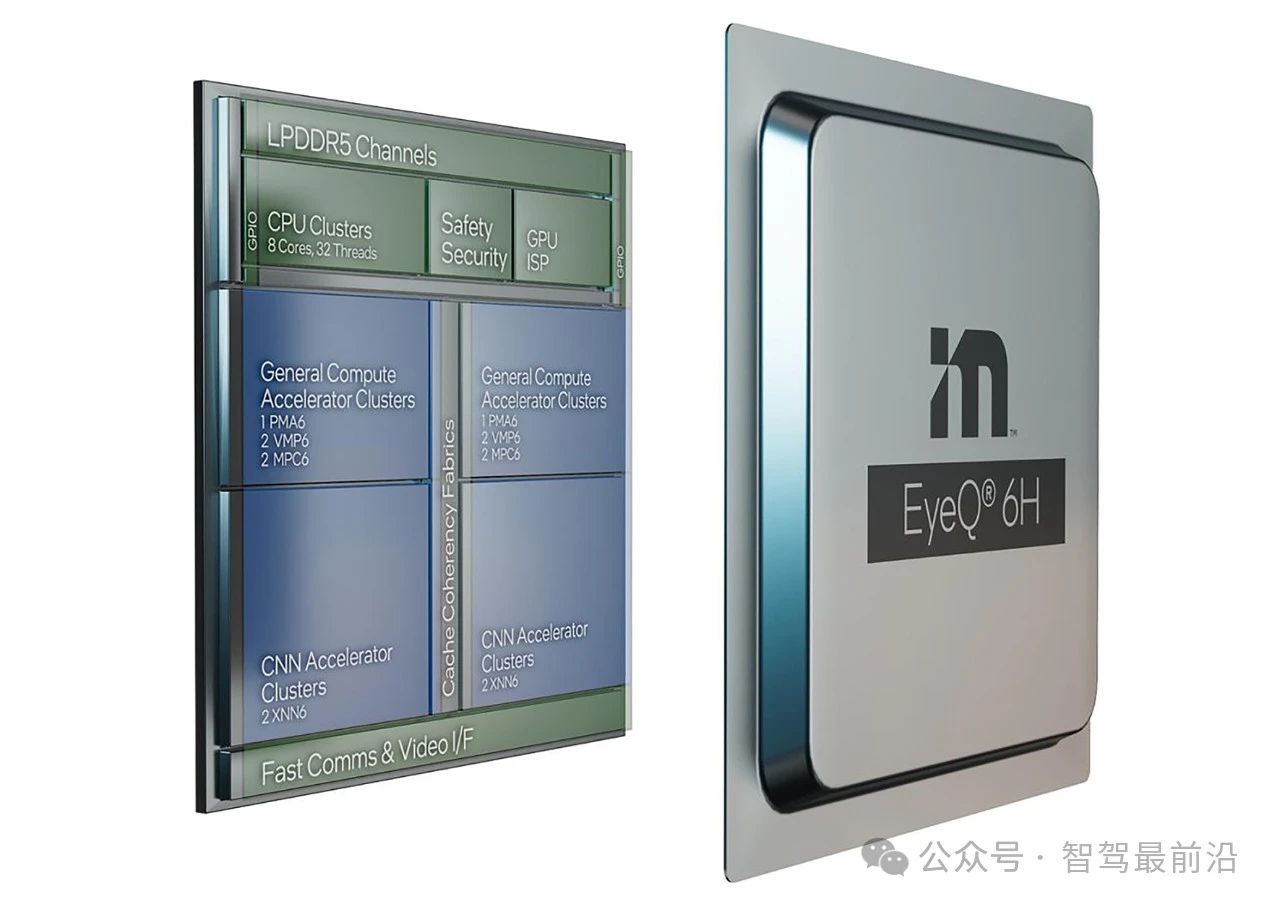

Mobileye端到端自動駕駛解決方案的深度解析

納多德端到端IB解決方案

納多德端到端IB解決方案

評論