解析ChatGPT背后的技術(shù)演進(jìn)

一、OpenAI正式發(fā)布多模態(tài)大模型GPT-4,實(shí)現(xiàn)多重能力躍升

(一)多模態(tài)大模型GPT-4是OpenAI公司GPT系列最新一代模型

美國(guó)OpenAI公司成立于2015年12月,是全球頂級(jí)的人工智能研究機(jī)構(gòu)之一,創(chuàng)始人 包括Elon Musk、著名投資者Sam Altman、支付服務(wù)PayPal創(chuàng)始人Peter Thiel等人。 OpenAI作為人工智能領(lǐng)域的革命者,成立至今開發(fā)出多款人工智能產(chǎn)品。2016年, OpenAI推出了用于強(qiáng)化學(xué)習(xí)研究的工具集OpenAI Gym;同時(shí)推出開源平臺(tái)OpenAI Universe,用于測(cè)試和評(píng)估智能代理機(jī)器人在各類環(huán)境中的表現(xiàn)。2019年,OpenAI 發(fā)布了GPT-2模型,可根據(jù)輸入文本自動(dòng)生成語(yǔ)言,展現(xiàn)出人工智能創(chuàng)造性思維的 能力;2020年更新了GPT-3語(yǔ)言模型,并在其基礎(chǔ)上發(fā)布了OpenAI Codex模型,該 模型可以自動(dòng)生成完整有效的程序代碼。

2021年1月,OpenAI發(fā)布了OpenAI CLIP, 用于進(jìn)行圖像和文本的識(shí)別分類;同時(shí)推出全新產(chǎn)品DALL-E,該模型可以根據(jù)文字 描述自動(dòng)生成對(duì)應(yīng)的圖片,2022年更新的DALL-E2更是全方位改進(jìn)了生成圖片的質(zhì) 量,獲得了廣泛好評(píng)。 2022年12月,OpenAI推出基于GPT-3.5的新型AI聊天機(jī)器人ChatGPT,在發(fā)布進(jìn) 兩個(gè)月后擁有1億用戶,成為史上用戶增長(zhǎng)最快的應(yīng)用;美東時(shí)間2023年3月14日, ChatGPT的開發(fā)機(jī)構(gòu)OpenAI正式推出多模態(tài)大模型GPT-4。

GPT(General Pre-Training)系列模型即通用預(yù)訓(xùn)練語(yǔ)言模型,是一種利用 Transformer作為特征抽取器,基于深度學(xué)習(xí)技術(shù)的自然語(yǔ)言處理模型。 GPT系列模型由OpenAI公司開發(fā),經(jīng)歷了長(zhǎng)達(dá)五年時(shí)間的發(fā)展: (1)其最早的產(chǎn)品GPT模型于2018年6月發(fā)布,該模型可以根據(jù)給定的文本序列進(jìn) 行預(yù)測(cè)下一個(gè)單詞或句子,充分證明通過對(duì)語(yǔ)言模型進(jìn)行生成性預(yù)訓(xùn)練可以有效減 輕NLP任務(wù)中對(duì)于監(jiān)督學(xué)習(xí)的依賴; (2)2019年2月GPT-2模型發(fā)布,該模型取消了原GPT模型中的微調(diào)階段,變?yōu)闊o(wú) 監(jiān)督模型,同時(shí),GPT-2采用更大的訓(xùn)練集嘗試zero-shot學(xué)習(xí),通過采用多任務(wù)模 型的方式使其在面對(duì)不同任務(wù)時(shí)都能擁有更強(qiáng)的理解能力和較高的適配性;

(3)GPT-3模型于2020年6月被發(fā)布,它在多項(xiàng)自然語(yǔ)言處理任務(wù)上取得了驚人的 表現(xiàn),并被認(rèn)為是迄今為止最先進(jìn)的自然語(yǔ)言處理模型之一。GPT-3訓(xùn)練使用的數(shù) 據(jù)集為多種高質(zhì)量數(shù)據(jù)集的混合,一次保證了訓(xùn)練質(zhì)量;同時(shí),該模型在下游訓(xùn)練 時(shí)用Few-shot取代了GPT-2模型使用的zero-shot,即在執(zhí)行任務(wù)時(shí)給予少量樣例, 以此提高準(zhǔn)確度;除此之外,它在前兩個(gè)模型的基礎(chǔ)上引入了新的技術(shù)——“零樣 本學(xué)習(xí)”,即GPT-3即便沒有對(duì)特定的任務(wù)進(jìn)行訓(xùn)練也可以完成相應(yīng)的任務(wù),這使 得GPT-3面對(duì)陌生語(yǔ)境時(shí)具有更好的靈活性和適應(yīng)性。

(4)2022年11月,OpenAI發(fā)布GPT-3.5模型,是由GPT-3微調(diào)出來(lái)的版本,采用 不同的訓(xùn)練方式,其功能更加強(qiáng)大。基于GPT-3.5模型,并加上人類反饋強(qiáng)化學(xué)習(xí) (RLHF)發(fā)布ChatGPT應(yīng)用,ChatGPT的全稱為Chat Generative Pre-trained Transformer,是建立在大型語(yǔ)言模型基礎(chǔ)上的對(duì)話式自然語(yǔ)言處理工具,表現(xiàn)形式 是一種聊天機(jī)器人程序,能夠?qū)W習(xí)及理解人類的語(yǔ)言,根據(jù)聊天的上下文進(jìn)行互動(dòng), 甚至能夠完成翻譯、編程、撰寫論文、編輯郵件等功能。 (5)2023年3月,OpenAI正式發(fā)布大型多模態(tài)模型GPT-4(輸入圖像和文本,輸出 文本輸出),此前主要支持文本,現(xiàn)模型能支持識(shí)別和理解圖像。

(二)GPT大模型通過底層技術(shù)的疊加,實(shí)現(xiàn)組合式的創(chuàng)新

由于OpenAI并沒有提供關(guān)于GPT-4用于訓(xùn)練的數(shù)據(jù)、算力成本、訓(xùn)練方法、架構(gòu)等 細(xì)節(jié),故我們本章主要討論ChatGPT模型的技術(shù)路徑。 ChatGPT模型從算法分來(lái)上來(lái)講屬于生成式大規(guī)模語(yǔ)言模型,底層技術(shù)包括 Transformer架構(gòu)、有監(jiān)督微調(diào)訓(xùn)練、RLHF強(qiáng)化學(xué)習(xí)等,ChatGPT通過底層技術(shù) 的疊加,實(shí)現(xiàn)了組合式的創(chuàng)新。 GPT模型采用了由Google提出的Transformer架構(gòu)。Transformer架構(gòu)采用自注意 力機(jī)制的序列到序列模型,是目前在自然語(yǔ)言處理任務(wù)中最常用的神經(jīng)網(wǎng)絡(luò)架構(gòu)之 一。相比于傳統(tǒng)的循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)或卷積神經(jīng)網(wǎng)絡(luò)(CNN),Transformer 沒有顯式的時(shí)間或空間結(jié)構(gòu),因此可以高效地進(jìn)行并行計(jì)算,并且Transformer具有 更好的并行化能力和更強(qiáng)的長(zhǎng)序列數(shù)據(jù)處理能力。

ChatGPT模型采用了“預(yù)訓(xùn)練+微調(diào)”的半監(jiān)督學(xué)習(xí)的方式進(jìn)行訓(xùn)練。第一階段是 Pre-Training階段,通過預(yù)訓(xùn)練的語(yǔ)言模型(Pretrained Language Model),從大 規(guī)模的文本中提取訓(xùn)練數(shù)據(jù),并通過深度神經(jīng)網(wǎng)絡(luò)進(jìn)行處理和學(xué)習(xí),進(jìn)而根據(jù)上下 文預(yù)測(cè)生成下一個(gè)單詞或者短語(yǔ),從而生成流暢的語(yǔ)言文本;第二階段是Fine-tuning 階段,將已經(jīng)完成預(yù)訓(xùn)練的GPT模型應(yīng)用到特定任務(wù)上,并通過少量的有標(biāo)注的數(shù) 據(jù)來(lái)調(diào)整模型的參數(shù),以提高模型在該任務(wù)上的表現(xiàn)。

ChatGPT在訓(xùn)練中使用了RLHF人類反饋強(qiáng)化學(xué)習(xí)模型,是GPT-3模型經(jīng)過升級(jí)并 增加對(duì)話功能后的最新版本。2022年3月,OpenAI發(fā)布InstructGPT,這一版本是 GPT-3模型的升級(jí)版本。相較于之前版本的GPT模型,InstructGPT引入了基于人類 反饋的強(qiáng)化學(xué)習(xí)技術(shù)(Reinforcement Learning with Human Feedback,RLHF), 對(duì)模型進(jìn)行微調(diào),通過獎(jiǎng)勵(lì)機(jī)制進(jìn)一步訓(xùn)練模型,以適應(yīng)不同的任務(wù)場(chǎng)景和語(yǔ)言風(fēng) 格,給出更符合人類思維的輸出結(jié)果。

RLHF的訓(xùn)練包括訓(xùn)練大語(yǔ)言模型、訓(xùn)練獎(jiǎng)勵(lì)模型及RLHF微調(diào)三個(gè)步驟。首先,需 要使用預(yù)訓(xùn)練目標(biāo)訓(xùn)練一個(gè)語(yǔ)言模型,同時(shí)也可以使用額外文本進(jìn)行微調(diào)。其次, 基于語(yǔ)言模型訓(xùn)練出獎(jiǎng)勵(lì)模型,對(duì)模型生成的文本進(jìn)行質(zhì)量標(biāo)注,由人工標(biāo)注者按 偏好將文本從最佳到最差進(jìn)行排名,借此使得獎(jiǎng)勵(lì)模型習(xí)得人類對(duì)于模型生成文本 序列的偏好。最后利用獎(jiǎng)勵(lì)模型輸出的結(jié)果,通過強(qiáng)化學(xué)習(xí)模型微調(diào)優(yōu)化,最終得 到一個(gè)更符合人類偏好語(yǔ)言模型。

(三)GPT-4相較于ChatGPT實(shí)現(xiàn)多重能力躍遷

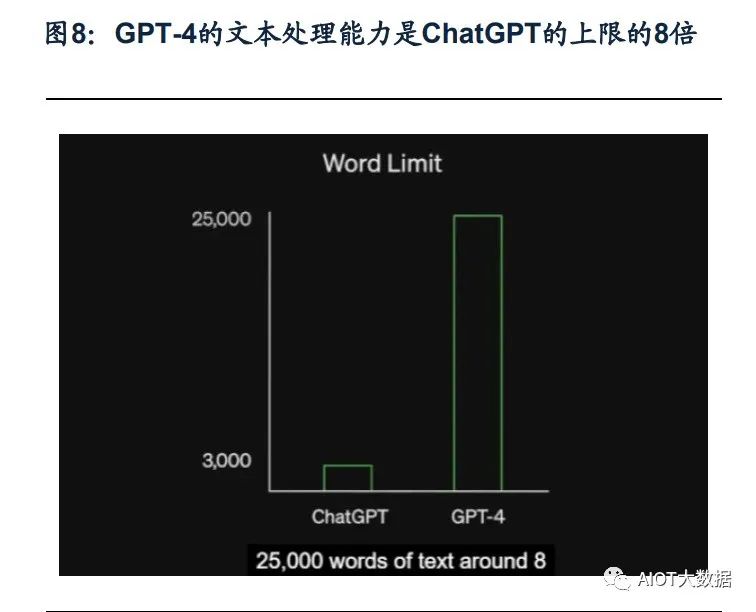

ChatGPT于2022年11月推出之后,僅用兩個(gè)月時(shí)間月活躍用戶數(shù)便超過1億,在短 時(shí)間內(nèi)積累了龐大的用戶基數(shù),也是歷史上增長(zhǎng)最快的消費(fèi)應(yīng)用。多模態(tài)大模型GPT-4是OpenAI的里程碑之作,是目前最強(qiáng)的文本生成模型。 ChatGPT推出后的三個(gè)多月時(shí)間里OpenAI就正式推出GPT-4,再次拓寬了大模型的 能力邊界。GPT-4是一個(gè)多模態(tài)大模型(接受圖像和文本輸入,生成文本),相比 上一代,GPT-4可以更準(zhǔn)確地解決難題,具有更廣泛的常識(shí)和解決問題的能力:更 具創(chuàng)造性和協(xié)作性;能夠處理超過25000個(gè)單詞的文本,允許長(zhǎng)文內(nèi)容創(chuàng)建、擴(kuò)展 對(duì)話以及文檔搜索和分析等用例。

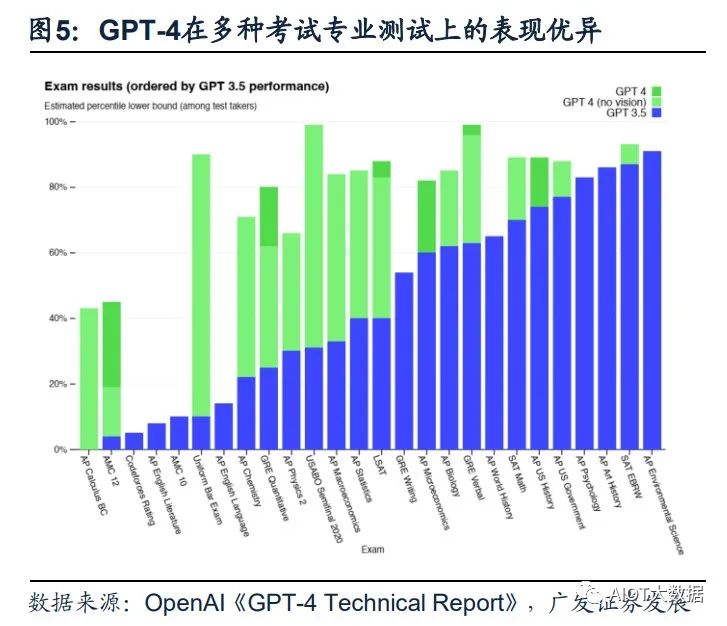

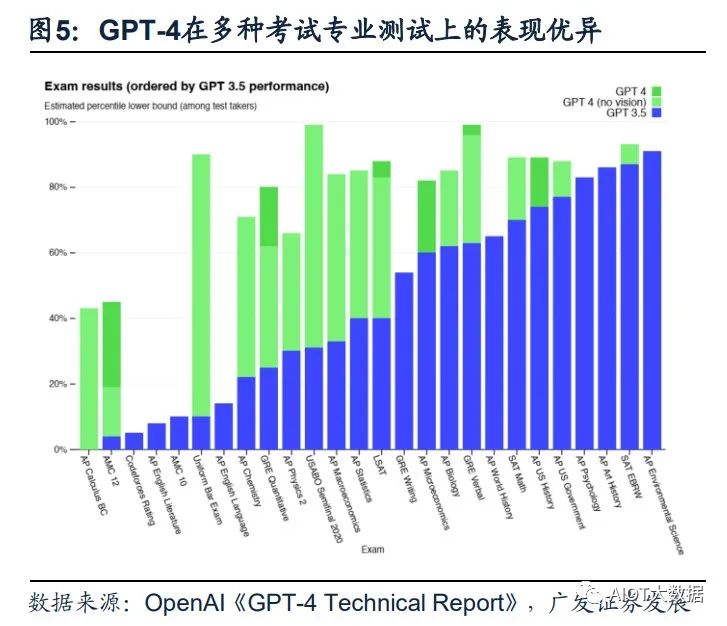

(1)GPT-4具備更高的準(zhǔn)確性及更強(qiáng)的專業(yè)性。GPT-4在更復(fù)雜、細(xì)微的任務(wù)處理 上回答更可靠、更有創(chuàng)意,在多類考試測(cè)驗(yàn)中以及與其他LLM的benchmark比較中 GPT-4明顯表現(xiàn)優(yōu)異。GPT-4在模擬律師考試GPT-4取得了前10%的好成績(jī),相比 之下GPT-3.5是后10%;生物學(xué)奧賽前1%;美國(guó)高考SAT中GPT-4在閱讀寫作中拿 下710分高分、數(shù)學(xué)700分(滿分800)。

(2)GPT能夠處理圖像內(nèi)容,能夠識(shí)別較為復(fù)雜的圖片信息并進(jìn)行解讀。GPT-4 突破了純文字的模態(tài),增加了圖像模態(tài)的輸入,支持用戶上傳圖像,并且具備強(qiáng)大 的圖像能力—能夠描述內(nèi)容、解釋分析圖表、指出圖片中的不合理指出或解釋梗圖。 在OpenAI發(fā)布的產(chǎn)品視頻中,開發(fā)者給GPT-4輸入了一張“用VGA電腦接口給 iPhone充電”的圖片,GPT-4不僅可以可描述圖片,還指出了圖片的荒謬之處。

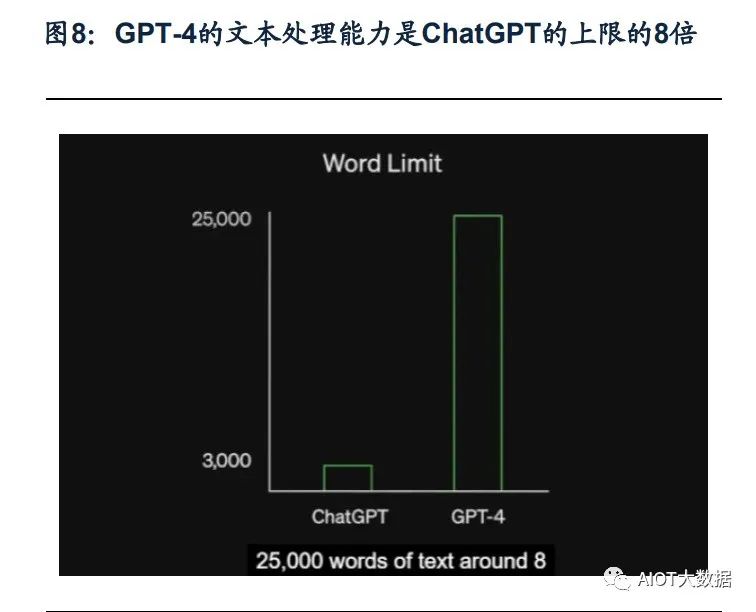

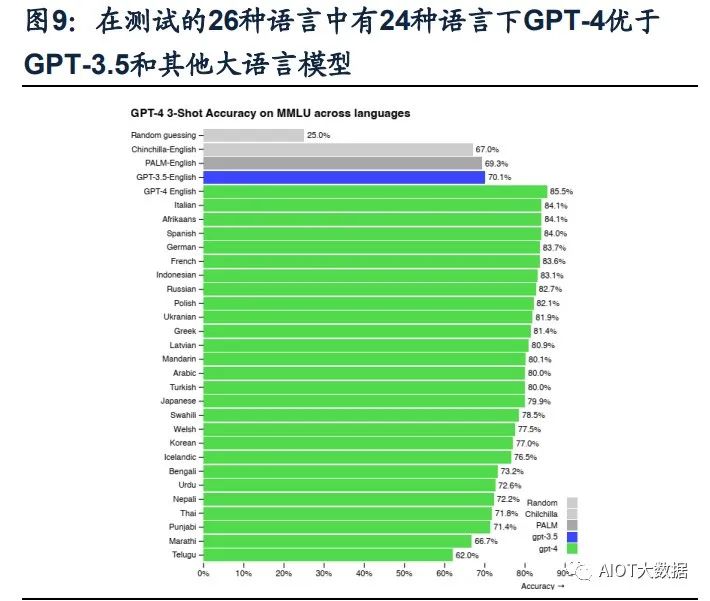

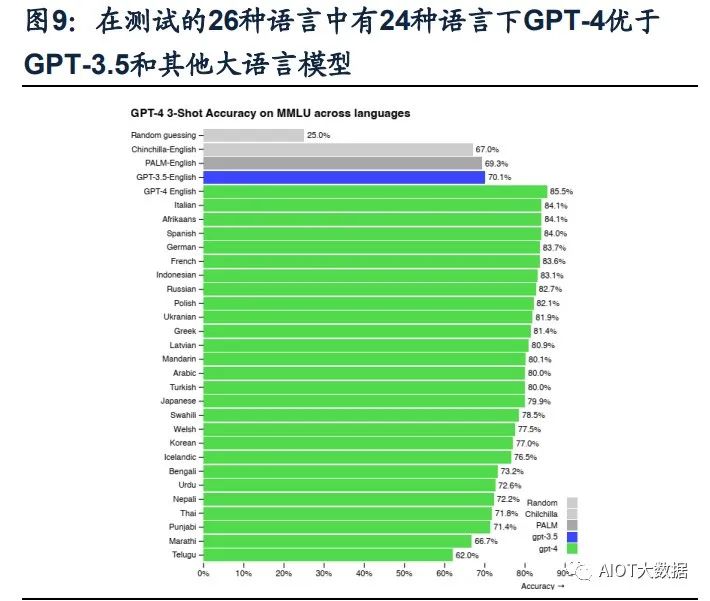

(3)GPT-4可以處理超過25000字的文本。在文本處理上,GPT-4支持輸入的文字 上限提升至25000字,允許長(zhǎng)文內(nèi)容創(chuàng)建、擴(kuò)展對(duì)話以及文檔搜索和分析等用例。 且GPT-4的多語(yǔ)言處理能力更優(yōu),在GPT-4的測(cè)評(píng)展示中,GPT-4可以解決法語(yǔ)的 物理問題,且在測(cè)試的英語(yǔ)、拉脫維亞語(yǔ)、威爾士語(yǔ)和斯瓦希里語(yǔ)等26種語(yǔ)言中, 有24種語(yǔ)言下,GPT-4優(yōu)于GPT-3.5和其他大語(yǔ)言模型(Chinchilla、PaLM)的英 語(yǔ)語(yǔ)言性能。(4)具備自我訓(xùn)練與預(yù)測(cè)能力,同時(shí)改善幻覺、安全等局限性。GPT-4的一大更新 重點(diǎn)是建立了一個(gè)可預(yù)測(cè)拓展的深度學(xué)習(xí)棧,使其具備了自我訓(xùn)練及預(yù)測(cè)能力。同 時(shí),GPT-4在相對(duì)于以前的模型已經(jīng)顯著減輕了幻覺問題。在OpenAI的內(nèi)部對(duì)抗性 真實(shí)性評(píng)估中,GPT-4的得分比最新的GPT-3.5模型高 40%;在安全能力的升級(jí)上, GPT-4明顯超出ChatGPT和GPT3.5。

(四)商業(yè)模式愈發(fā)清晰,微軟Copilot引發(fā)跨時(shí)代的生產(chǎn)力變革

OpenAI已正式宣布為第三方開開發(fā)者開放ChatGPT API,價(jià)格降低加速場(chǎng)景應(yīng)用 爆發(fā)。起初ChatGPT免費(fèi)向用戶開放,以獲得用戶反饋;今年2月1日,Open AI推 出新的ChatGPT Plus訂閱服務(wù),收費(fèi)方式為每月20美元,訂閱者能夠因此而獲得更 快、更穩(wěn)定的響應(yīng)并優(yōu)先體驗(yàn)新功能。3月2日,OpenAI官方宣布正式開放ChatGPT API(應(yīng)用程序接口),允許第三方開發(fā)者通過API將ChatGPT集成至他們的應(yīng)用程 序和服務(wù)中,價(jià)格為1ktokens/$0.002,即每輸出100萬(wàn)個(gè)單詞需要2.7美元,比已有 的GPT-3.5模型價(jià)格降低90%。模型價(jià)格的降低將推動(dòng)ChatGPT被集成到更多場(chǎng)景 或應(yīng)用中,豐富ChatGPT的應(yīng)用生態(tài),加速多場(chǎng)景應(yīng)用的爆發(fā)。

GPT-4發(fā)布后OpenAI把ChatGPT直接升級(jí)為GPT-4最新版本,同時(shí)開放了GPT-4 的API。ChatGPT Plus付費(fèi)訂閱用戶可以獲得具有使用上限的GPT-4訪問權(quán)限(每4 小時(shí)100條消息),可以向GPT-4模型發(fā)出純文本請(qǐng)求。用戶可以申請(qǐng)使用GPT-4 的API,OpenAI會(huì)邀請(qǐng)部分開發(fā)者體驗(yàn),并逐漸擴(kuò)大邀請(qǐng)范圍。該API的定價(jià)為每輸 入1000個(gè)字符(約合750個(gè)單詞),價(jià)格為0.03美元;GPT-4每生成1000個(gè)字符價(jià)格為 0.06美元。 Office引入GPT-4帶來(lái)的結(jié)果是生產(chǎn)力、創(chuàng)造力的全面躍升。微軟今天宣布,其與 OpenAI共同開發(fā)的聊天機(jī)器人技術(shù)Bing Chat正在GPT-4上運(yùn)行。

Copilot OpenAI發(fā)布升級(jí)后的GPT-4后,微軟重磅發(fā)布了GPT-4平臺(tái)支持的新AI功能, Microsoft 365 Copilot,并將其嵌入Word、PowerPoint、Excel、Teams等Office辦 公軟件中。Copilot可以在一篇速記的基礎(chǔ)上快速生成新聞草稿、并完成草稿潤(rùn)色; 在Excel中完成各種求和、求平均數(shù),做表格、歸納數(shù)據(jù)、甚至是完成總結(jié)提取;在 PPT上可以直接將文稿內(nèi)容一鍵生成;在Outlook郵件中自動(dòng)生成內(nèi)容、并自由調(diào)整 寫作風(fēng)格、插入圖表;在Teams中總結(jié)視頻會(huì)議的要點(diǎn)/每個(gè)發(fā)言人誰(shuí)說(shuō)了核心內(nèi)容, 跟進(jìn)會(huì)議流程和內(nèi)容,自動(dòng)生成會(huì)議紀(jì)要、要點(diǎn)和任務(wù)模板。基于GPT-4的Copilot 可以看作是一個(gè)辦公AI助理,充分發(fā)揮出了AI對(duì)于辦公場(chǎng)景的賦能作用,有望從根 本上改變工作模式并開啟新一輪生產(chǎn)力增長(zhǎng)浪潮。

二、GPT-4帶動(dòng)多模態(tài)x多場(chǎng)景落地,AIGC藍(lán)海市場(chǎng)打開

(一)歷經(jīng)三階段發(fā)展,AIGC技術(shù)升級(jí)步入深化階段

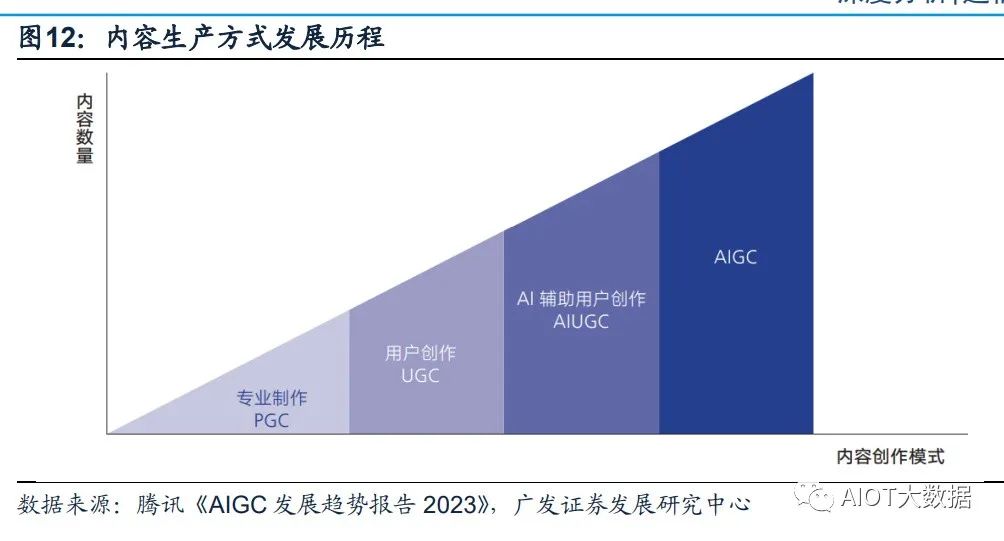

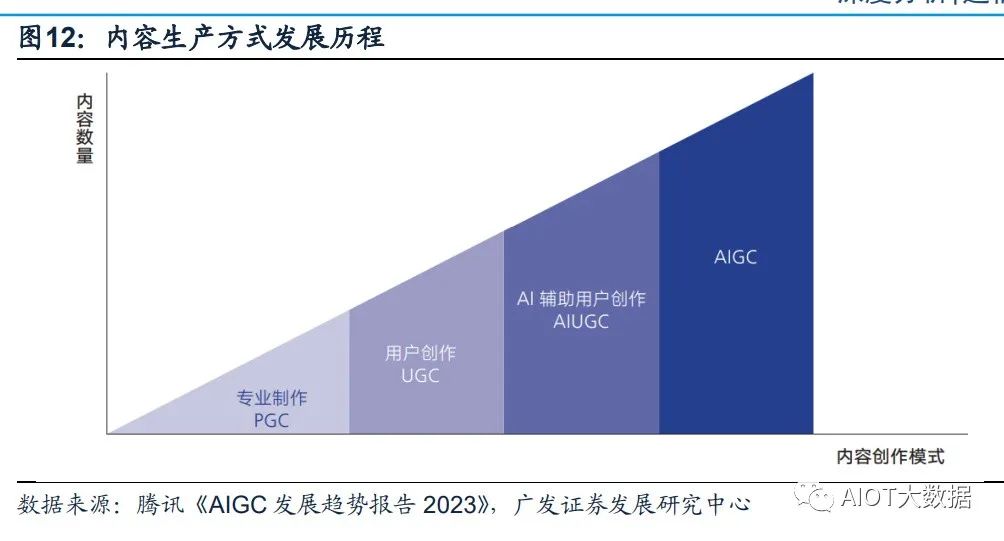

AIGC全程為AI-Generated Content,人工智能生成內(nèi)容,是繼專業(yè)生成內(nèi)容(PGC, Professional Generate Content)和用戶生成內(nèi)容(UGC,User Generate Content) 之后,利用AI自動(dòng)生成內(nèi)容的新型生產(chǎn)方式。傳統(tǒng)AI大多屬于分析式AI,對(duì)已有數(shù) 據(jù)進(jìn)行分析并應(yīng)用于相應(yīng)領(lǐng)域。以AIGC為典型的生成式AI不在局限于分析固有數(shù)據(jù), 而是基于訓(xùn)練數(shù)據(jù)和算法模型自主生成創(chuàng)造新的文本、3D、視頻等各種形式的內(nèi)容。

歷經(jīng)三階段迭代,AIGC現(xiàn)已進(jìn)入快速發(fā)展階段: (1)早期萌芽階段(1950s-1990s),受限于科技水平及高昂的系統(tǒng)成本,AIGC 僅限于小范圍實(shí)驗(yàn)。 (2)沉淀積累階段(1990s-2010s),AIGC開始從實(shí)驗(yàn)性向?qū)嵱眯灾饾u轉(zhuǎn)變。但 由于其受限于算法瓶頸,完成創(chuàng)作能力有限,應(yīng)用領(lǐng)域仍具有局限性; (3)快速發(fā)展階段(2010s-至今),GAN(Generative Adversarial Network,生成 式對(duì)抗網(wǎng)絡(luò))等深度學(xué)習(xí)算法的提出和不斷迭代推動(dòng)了AIGC技術(shù)的快速發(fā)展,生成 內(nèi)容更加多元化。

AIGC可分為智能數(shù)字內(nèi)容孿生、智能數(shù)字內(nèi)容編輯及智能數(shù)字內(nèi)容創(chuàng)作三大層次。 生成式AI是指利用現(xiàn)有文本、音頻文件或圖像創(chuàng)建新內(nèi)容的人工智能技術(shù),其起源 于分析式AI,在分析式AI總結(jié)歸納數(shù)據(jù)知識(shí)的基礎(chǔ)上學(xué)習(xí)數(shù)據(jù)產(chǎn)生模式,創(chuàng)造出新 的樣本內(nèi)容。在分析式AI的技術(shù)基礎(chǔ)上,GAN、Transformer網(wǎng)絡(luò)等多款生成式AI 技術(shù)催生出許多AIGC產(chǎn)品,如DALL-E、OpenAI系列等,它們?cè)谝纛l、文本、視覺 上有眾多技術(shù)應(yīng)用,并在創(chuàng)作內(nèi)容的方式上變革演化出三大前沿能力。AIGC根據(jù)面 向?qū)ο蟆?shí)現(xiàn)功能的不同可以分為智能數(shù)字內(nèi)容孿生、智能數(shù)字內(nèi)容編輯及智能數(shù) 字內(nèi)容創(chuàng)作三大層次。

(二)生成算法+預(yù)訓(xùn)練模型+多模態(tài)推動(dòng)AIGC的爆發(fā)

AIGC的爆發(fā)離不開其背后的深度學(xué)習(xí)模型的技術(shù)加持,生成算法、預(yù)訓(xùn)練和多模態(tài) 技術(shù)的不斷發(fā)展幫助了AIGC模型具備通用性強(qiáng)、參數(shù)海量、多模態(tài)和生成內(nèi)容高質(zhì) 量的特質(zhì),讓AIGC實(shí)現(xiàn)從技術(shù)提升到技術(shù)突破的轉(zhuǎn)變。 (1)生成算法模型不斷迭代創(chuàng)新,為AIGC的發(fā)展奠定基礎(chǔ)。早期人工智能算法學(xué) 習(xí)能力不強(qiáng),AIGC技術(shù)主要依賴于事先指定的統(tǒng)計(jì)模型或任務(wù)來(lái)完成簡(jiǎn)單的內(nèi)容生 成和輸出,對(duì)客觀世界和人類語(yǔ)言文字的感知能力較弱,生成內(nèi)容刻板且具有局限 性。GAN(Generative Adversarial Network,生成式對(duì)抗網(wǎng)絡(luò))的提出讓AIGC發(fā)展 進(jìn)入新階段,GAN是早期的生成模型,利用博弈框架產(chǎn)生輸出,被廣泛應(yīng)用于生成 圖像、視頻語(yǔ)音等領(lǐng)域。隨后Transformer、擴(kuò)散模型、深度學(xué)習(xí)算法模型相繼涌現(xiàn)。

Transformer被廣泛應(yīng)用于NLP、CV等領(lǐng)域,GPT-3、LaMDA等預(yù)訓(xùn)練模型大多是 基于transformer架構(gòu)構(gòu)建的。ChatGPT是基于Transformer架構(gòu)上的語(yǔ)言模型, Transformer負(fù)責(zé)調(diào)度架構(gòu)和運(yùn)算邏輯,進(jìn)而實(shí)現(xiàn)最終計(jì)算。Tansformer是谷歌于 2017年《Attention is All You Need》提出的一種深度學(xué)習(xí)模型架構(gòu),其完全基于注 意力機(jī)制,可以按照輸入數(shù)據(jù)各部分重要性來(lái)分配不同的權(quán)重,無(wú)需重復(fù)和卷積。 相較于循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)流水線式的序列計(jì)算,Transformer可以一次處理所有 的輸入,擺脫了人工標(biāo)注數(shù)據(jù)集的缺陷,實(shí)現(xiàn)了大規(guī)模的并行計(jì)算,模型所需的訓(xùn) 練時(shí)間明顯減少,大規(guī)模的AI模型質(zhì)量更優(yōu)。

Transformer的核心構(gòu)成是編碼模塊和解碼模塊。GPT使用的是解碼模塊,通過模 塊間彼此大量堆疊的方式形成了GPT模型的底層架構(gòu),模塊分為前饋神經(jīng)網(wǎng)絡(luò)層、 編解碼自注意力機(jī)制層(Self-Attention)、自注意力機(jī)制掩碼層。自注意力機(jī)制層 負(fù)責(zé)計(jì)算數(shù)據(jù)在全部?jī)?nèi)容的權(quán)重(即Attention),掩碼層幫助模型屏蔽計(jì)算位置右 側(cè)未出現(xiàn)的數(shù)據(jù),最后把輸出的向量結(jié)果輸入前饋神經(jīng)網(wǎng)絡(luò),完成模型參數(shù)計(jì)算。

(2)預(yù)訓(xùn)練模型引發(fā)AIGC技術(shù)能力的質(zhì)變。AI預(yù)訓(xùn)練模型是基于大規(guī)模寬泛的數(shù) 據(jù)進(jìn)行訓(xùn)練后擁有適應(yīng)廣泛下游任務(wù)能力的模型,預(yù)訓(xùn)練屬于遷移學(xué)習(xí)的領(lǐng)域,其 主旨是使用標(biāo)注數(shù)據(jù)前,充分利用大量無(wú)標(biāo)注數(shù)據(jù)進(jìn)行訓(xùn)練,模型從中全面學(xué)習(xí)到 與標(biāo)注無(wú)關(guān)的潛在知識(shí),進(jìn)而使模型靈活變通的完成下游任務(wù)。視覺大模型提升 AIGC感知能力,語(yǔ)言大模型增強(qiáng)AIGC認(rèn)知能力。

NLP模型是一種使用自然語(yǔ)言處理(Natural Language Processing,NLP)技術(shù)來(lái)解決自然語(yǔ)言相關(guān)問題的機(jī)器學(xué)習(xí)模型。在NLP領(lǐng)域,AI大模型可適用于人機(jī)語(yǔ)言交互,并進(jìn)行自然語(yǔ)言處理從實(shí)現(xiàn)相應(yīng)的文本分類、文本生成、語(yǔ)音識(shí)別、序列標(biāo)注、機(jī)器翻譯等功能。NLP的研究經(jīng)過了以規(guī)則為基礎(chǔ)的研究方法和以統(tǒng)計(jì)為基礎(chǔ)的研究方法的發(fā)展,目前以基于Transformer的預(yù)訓(xùn)練模型已成為當(dāng)前NLP領(lǐng)域的研究熱點(diǎn),BERT、GPT等模型均采用這一方法。CV模型指計(jì)算機(jī)視覺模型,是一種基于圖像或視頻數(shù)據(jù)的人工智能模型。常見的CV 模型有采用深度學(xué)習(xí)的卷積神經(jīng)網(wǎng)絡(luò)(CNN)和生成對(duì)抗網(wǎng)絡(luò)(GAN)。

近年來(lái)以 視覺Transformer(ViT)為典型的新型神經(jīng)網(wǎng)絡(luò),通過人類先驗(yàn)知識(shí)引入網(wǎng)絡(luò)設(shè)計(jì), 使得模型的收斂速度、泛化能力、擴(kuò)展性及并行性得到飛速提升,通過無(wú)監(jiān)督預(yù)訓(xùn) 練和微調(diào)學(xué)習(xí),在多個(gè)計(jì)算機(jī)視覺任務(wù),如圖像分類、目標(biāo)檢測(cè)、物體識(shí)別、圖像 生成等取得顯著的進(jìn)步。

(3)多模態(tài)技術(shù)拓寬了AIGC技術(shù)的應(yīng)用廣度。多模態(tài)技術(shù)將不同模態(tài)(圖像、聲 音、語(yǔ)言等)融合在預(yù)訓(xùn)練模型中,使得預(yù)訓(xùn)練模型從單一的NLP、CV發(fā)展成音視 頻、語(yǔ)言文字、文本圖像等多模態(tài)、跨模態(tài)模型。多模態(tài)大模型通過尋找模態(tài)數(shù)據(jù) 之間的關(guān)聯(lián)點(diǎn),將不同模態(tài)的原始數(shù)據(jù)投射在相似的空間中,讓模態(tài)之間的信號(hào)相 互理解,進(jìn)而實(shí)現(xiàn)模態(tài)數(shù)據(jù)之間的轉(zhuǎn)化和生成。這一技術(shù)對(duì)AIGC的原創(chuàng)生成能力的 發(fā)展起到了重要的支持作用,2021年OpenAI推出AI繪畫產(chǎn)品DALL.E可通過輸入文 字理解生成符合語(yǔ)義且獨(dú)一無(wú)二的繪畫作品,其背后離不開多模態(tài)技術(shù)的支持。

(三)多模態(tài)x多場(chǎng)景落地,AIGC爆發(fā)商業(yè)潛力

ChatGPT的廣泛應(yīng)用意味著AIGC規(guī)模化、商業(yè)化的開始。ChatGPT是文字語(yǔ)言模 態(tài)AIGC的具體應(yīng)用,在技術(shù)、應(yīng)用領(lǐng)域和商業(yè)化方面和傳統(tǒng)AI產(chǎn)品均有所不同。 ChatGPT已經(jīng)具備了一定的對(duì)現(xiàn)實(shí)世界內(nèi)容進(jìn)行語(yǔ)義理解和屬性操控的能力,并可 以對(duì)其回以相應(yīng)的反饋。ChatGPT是AIGC重要的產(chǎn)品化應(yīng)用,意味著AIGC規(guī)模化、 商業(yè)化的開始。創(chuàng)新工場(chǎng)董事長(zhǎng)兼CEO李開復(fù)博士在3月14日表示,ChatGPT快速 普及將進(jìn)一步引爆AI 2.0商業(yè)化。AI 2.0 是絕對(duì)不能錯(cuò)過的一次革命。

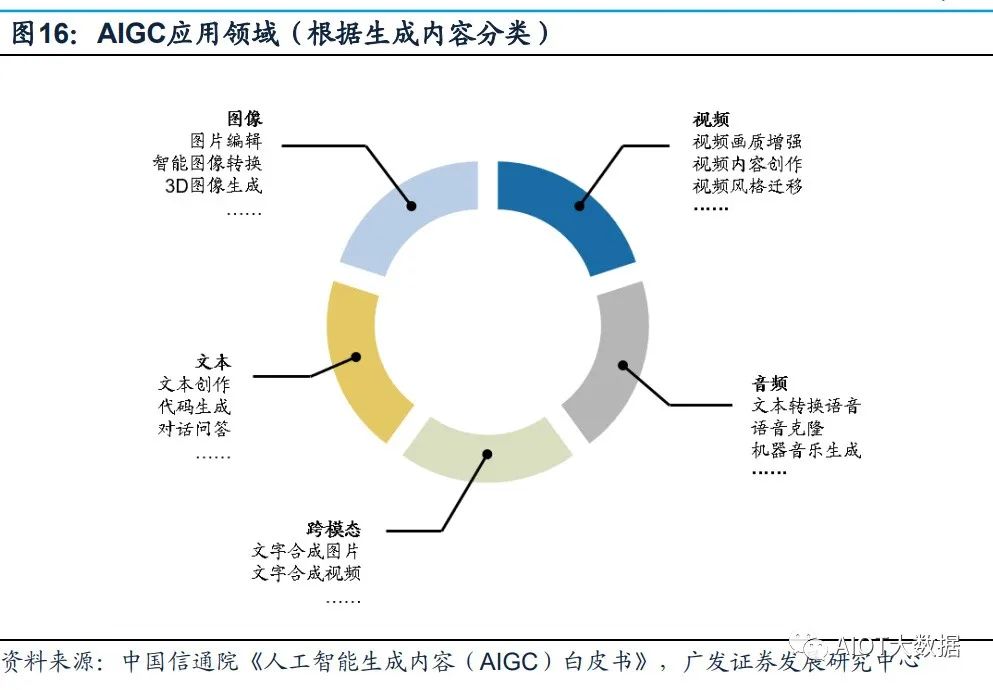

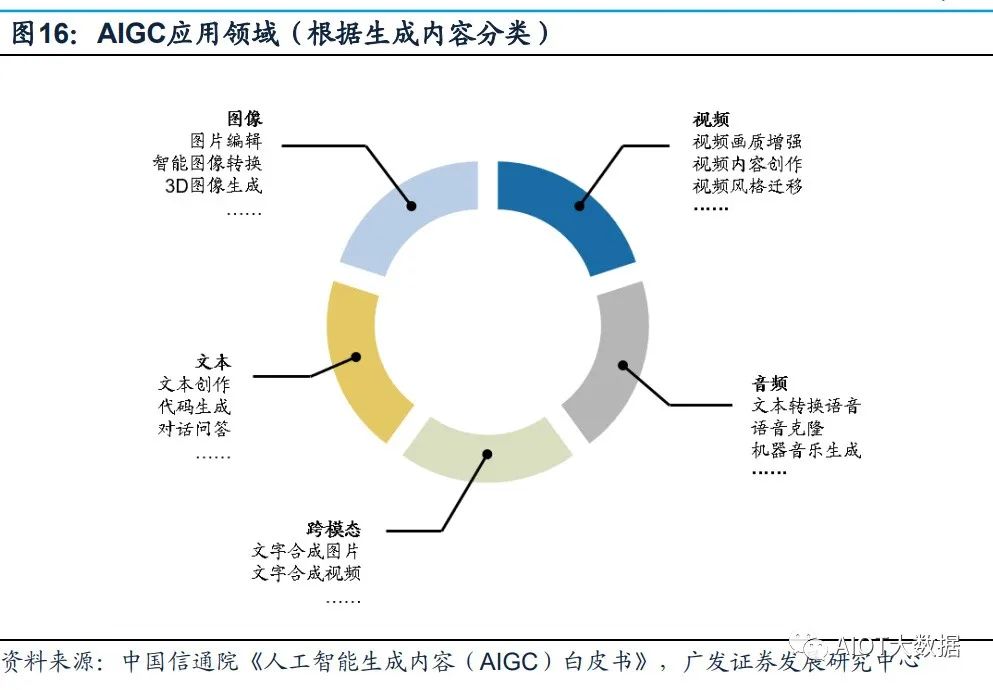

多家公司正加緊研發(fā)ChatGPT類似產(chǎn)品,引爆新一輪科技企業(yè)AI軍備競(jìng)賽。在GPT4 推出之后,Google開放自家的大語(yǔ)言模型API「PaLM API」,此外還發(fā)布了一款幫 助開發(fā)者快速構(gòu)建AI程序的工具 MakerSuite。2月底,META公布一款全新的AI大型 語(yǔ)言模型LLaMA,宣稱可幫助研究人員降低生成式AI工具可能帶來(lái)的“偏見、有毒 評(píng)論、產(chǎn)生錯(cuò)誤信息的可能性”等問題。 AIGC的應(yīng)用領(lǐng)域分為視頻、音頻、文本、圖像、跨模態(tài)生成五個(gè)部分。

AIGC以其 真實(shí)性、多樣性、可控性、組合性的特質(zhì),為各行業(yè)、各領(lǐng)域提供了更加豐富多元、 動(dòng)態(tài)且可交互的內(nèi)容。根據(jù)AIGC生成內(nèi)容的模態(tài)不同,可將AIGC的應(yīng)用領(lǐng)域分為 視頻、音頻、文本、圖像、跨模態(tài)生成五個(gè)部分。其中,在圖像、文本、音頻等領(lǐng) 域,AIGC已經(jīng)得到了較大優(yōu)化,生成內(nèi)容質(zhì)量得到明顯提升;而在視頻與跨模態(tài)內(nèi) 容生成方面,AIGC擁有巨大發(fā)展?jié)摿Α?/p>

三、高算力需求帶動(dòng)基礎(chǔ)設(shè)施迭代加速

(一)AI大模型驅(qū)動(dòng)高算力需求

數(shù)據(jù)、算力及模型是人工智能發(fā)展的三要素。以GPT系列為例: (1)數(shù)據(jù)端:自O(shè)penAI于2018年發(fā)布GPT-1,到2020年的GPT-3,GPT模型參數(shù) 數(shù)量和訓(xùn)練數(shù)據(jù)量實(shí)現(xiàn)指數(shù)型增長(zhǎng)。參數(shù)數(shù)量從GPT-1的1.17億增長(zhǎng)到GPT-3的 1750億,訓(xùn)練數(shù)據(jù)量從5GB增長(zhǎng)到的45TB; (2)模型端:ChatGPT在以往模型的基礎(chǔ)上,在語(yǔ)料庫(kù)、計(jì)算能力、預(yù)訓(xùn)練、自我 學(xué)習(xí)能力等方面有了明顯提升,同時(shí)Transformer架構(gòu)突破了人工標(biāo)注數(shù)據(jù)集的不足, 實(shí)現(xiàn)與人類更順暢的交流; (3)算力端:根據(jù)OpenAl發(fā)布的《Language Models are Few-Shot Learners》, 訓(xùn)練13億參數(shù)的GPT-3 XL模型訓(xùn)練一次消耗的算力約為27.5 PFlop/s-dav,訓(xùn)練 1750億參數(shù)的完整GPT-3模型則會(huì)消耗算力3640 PFlop/s-dav(以一萬(wàn)億次每秒速 度計(jì)算,需要3640天完成)。

在人工智能發(fā)展的三要素中,數(shù)據(jù)與算法都離不開算力的支撐。隨著AI算法突飛猛 進(jìn)的發(fā)展,越來(lái)越多的模型訓(xùn)練需要巨量算力支撐才能快速有效實(shí)施,同時(shí)數(shù)據(jù)量 的不斷增加也要求算力配套進(jìn)化。如此看來(lái),算力成為AI突破的關(guān)鍵因素。 AI大模型的算力需求主要來(lái)自于預(yù)訓(xùn)練、日常運(yùn)營(yíng)和模型微調(diào)。 (1)預(yù)訓(xùn)練:在完成完整訓(xùn)練之前,搭建一個(gè)網(wǎng)絡(luò)模型完成特定任務(wù),在訓(xùn)練網(wǎng)絡(luò) 過程中不斷調(diào)整參數(shù),直至網(wǎng)絡(luò)損失和運(yùn)行性能達(dá)到預(yù)期目標(biāo),此時(shí)可以將訓(xùn)練模 型的參數(shù)保存,用于之后執(zhí)行類似任務(wù)。根據(jù)中國(guó)信通院數(shù)據(jù),ChatGPT基于GPT3.5 系列模型,模型參數(shù)規(guī)模據(jù)推測(cè)達(dá)十億級(jí)別,參照參數(shù)規(guī)模相近的GPT-3 XL模型, 則ChatGPT完整一次預(yù)訓(xùn)練消耗算力約為27.5 PFlop/s-dav。

(2)日常運(yùn)營(yíng):滿足用戶日常使用數(shù)據(jù)處理需求。根據(jù)Similarweb的數(shù)據(jù),23年1月份ChatGPT月活約6.16億,跳出率13.28%每次訪問頁(yè)數(shù)5.85頁(yè),假設(shè)每頁(yè)平均200 token。同時(shí)假設(shè):模型的FLlops利用率為21.3%與訓(xùn)練期間的GPT-3保持一致;完整參數(shù)模型較GPT-3上升至2500億;以FLOPs為指標(biāo),SOTA大型語(yǔ)言在在推理過程中每個(gè)token的計(jì)算成本約為2N。根據(jù)以上數(shù)據(jù)及假設(shè),每月日常運(yùn)營(yíng)消耗算力約為6.16億*2*(1-13.28%)*5.85*200*2500億/21.3%=14672PFlop/s-day。(3)模型微調(diào):執(zhí)行類似任務(wù)時(shí),使用先前保存的模型參數(shù)作為初始化參數(shù),在訓(xùn)練過程中依據(jù)結(jié)果不斷進(jìn)行微調(diào),使之適應(yīng)新的任務(wù)。

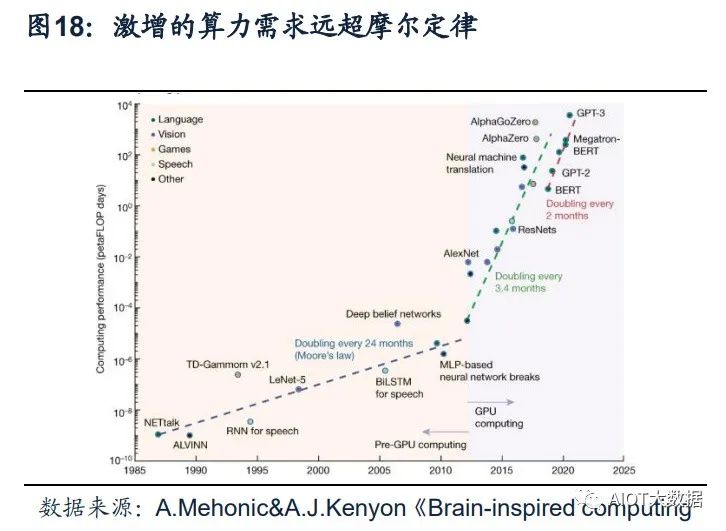

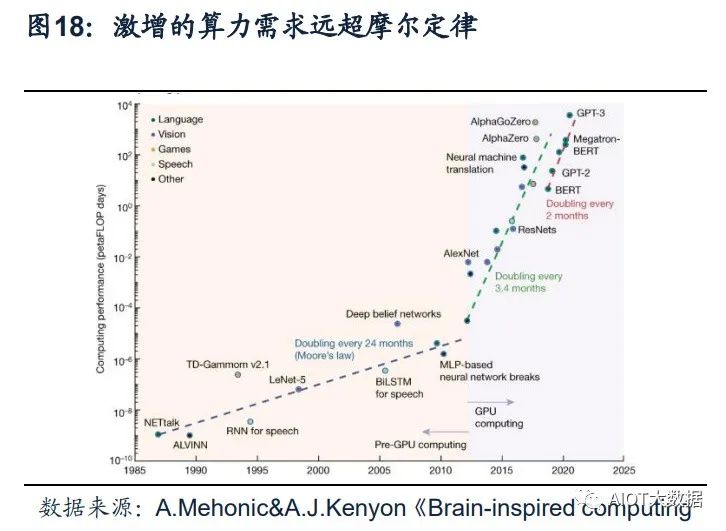

ChatGPT引發(fā)新一輪AI算力需求爆發(fā)。根據(jù)OpenAI發(fā)布的《AI and Compute》分 析報(bào)告中指出,自2012年以來(lái),AI訓(xùn)練應(yīng)用的算力需求每3.4個(gè)月就回會(huì)翻倍,從 2012年至今,AI算力增長(zhǎng)超過了30萬(wàn)倍。據(jù)OpenAI報(bào)告,ChatGPT的總算力消耗 約為3640PF-days(即假如每秒計(jì)算一千萬(wàn)億次,需要計(jì)算3640天),需要7-8個(gè)算 力500P的數(shù)據(jù)中心才能支撐運(yùn)行。上海新興信息通信技術(shù)應(yīng)用研究院首席專家賀仁 龍表示,“自2016年阿爾法狗問世,智能算力需求開啟爆發(fā)態(tài)勢(shì)。如今ChatGPT則 代表新一輪AI算力需求的爆發(fā)”。

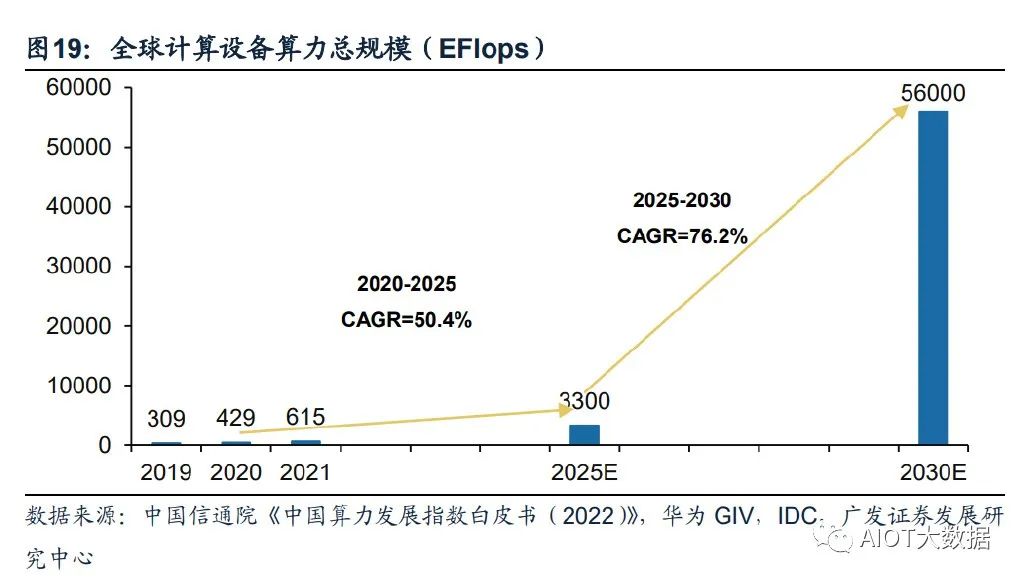

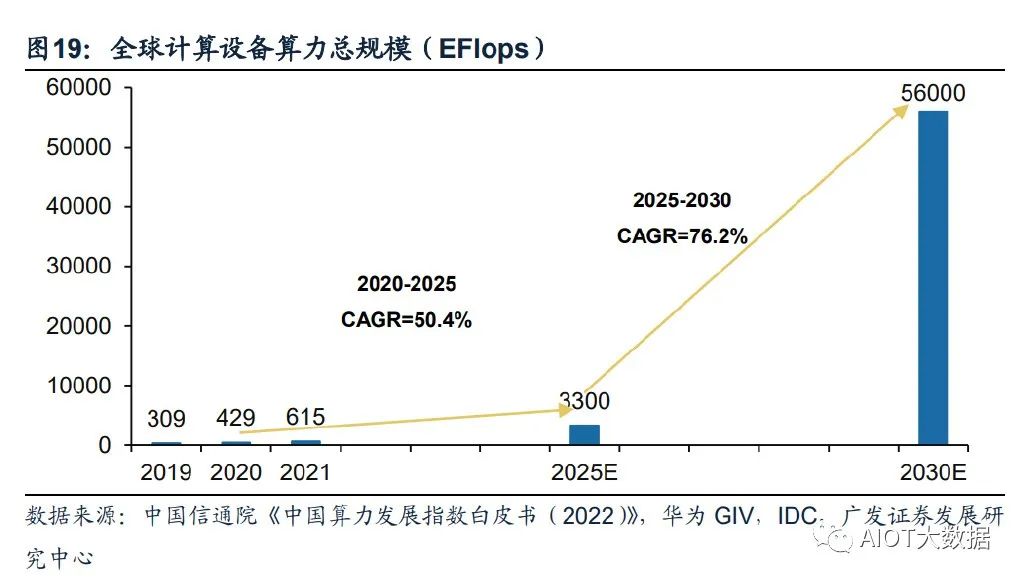

全球算力規(guī)模將呈現(xiàn)高速增長(zhǎng)態(tài)勢(shì)。根據(jù)國(guó)家數(shù)據(jù)資源調(diào)查報(bào)告數(shù)據(jù),2021年全球 數(shù)據(jù)總產(chǎn)量67ZB,近三年平均增速超過26%,經(jīng)中國(guó)信息通信研究院測(cè)算,2021 年全球計(jì)算設(shè)備算力總規(guī)模達(dá)到615EFlops,增速達(dá)44%。根據(jù)中國(guó)信通院援引的 IDC數(shù)據(jù),2025年全球算力整體規(guī)模將達(dá)3300EFlops,2020-2025年的年均復(fù)合增 長(zhǎng)率達(dá)到50.4%。結(jié)合華為GIV預(yù)測(cè),2030年人類將迎來(lái)YB數(shù)據(jù)時(shí)代,全球算力規(guī) 模達(dá)到56ZFlops,2025-2030年復(fù)合增速達(dá)到76.2%。

(二)云商/運(yùn)營(yíng)商推進(jìn)AI領(lǐng)域算力基礎(chǔ)設(shè)施投入

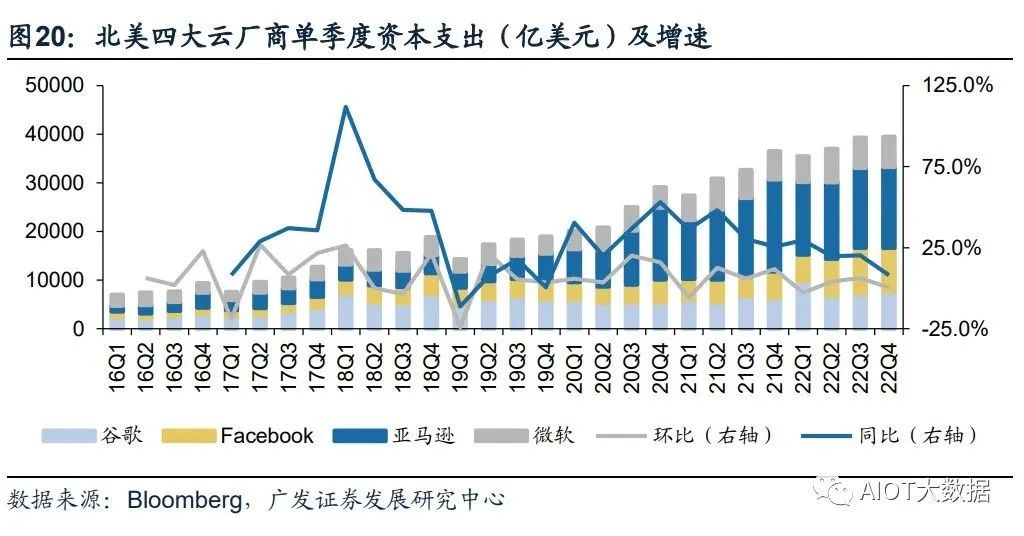

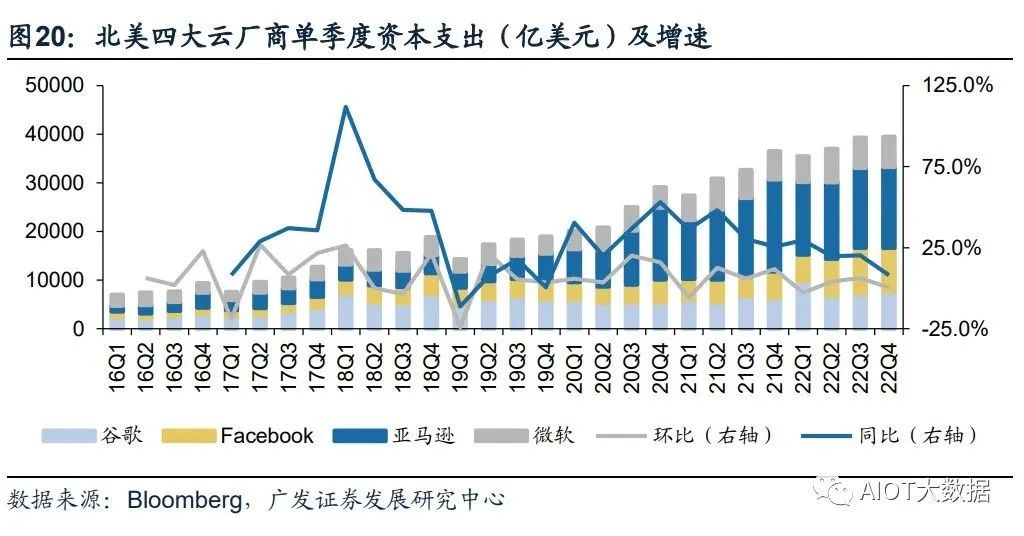

北美云廠商資本支出向技術(shù)基礎(chǔ)設(shè)施和新數(shù)據(jù)中心架構(gòu)傾斜。22Q4亞馬遜資本支出 主要用于技術(shù)基礎(chǔ)設(shè)施的投資,其中大部分用于支持AWS業(yè)務(wù)增長(zhǎng)與支持履行網(wǎng)絡(luò) 的額外能力。預(yù)計(jì)未來(lái)相關(guān)投資將延續(xù),并增加在技術(shù)基礎(chǔ)設(shè)施方面的支出。谷歌 指引2023年資本開支與2022年基本持平,其中技術(shù)基礎(chǔ)設(shè)施有所增加,而辦公基礎(chǔ) 設(shè)施將減少。Meta2022年資本開支為314.3億美元,同比增長(zhǎng)69.3%,但同時(shí)Meta 略微調(diào)低其2023年資本開支預(yù)期至300-330億美元(此前預(yù)期為340-370億美元), 主要原因系減少數(shù)據(jù)中心建設(shè)的相關(guān)支出,轉(zhuǎn)向新的更具成本效益的、同時(shí)支持AI 和非AI工作量的數(shù)據(jù)中心新架構(gòu)。

國(guó)內(nèi)三大運(yùn)營(yíng)商積極布局算力網(wǎng)絡(luò),資本支出向新興業(yè)務(wù)傾斜。電信運(yùn)營(yíng)商作為數(shù) 字基座打造者,運(yùn)營(yíng)商數(shù)字業(yè)務(wù)板塊成為收入增長(zhǎng)的主要引擎,近幾年資本支出由 主干網(wǎng)絡(luò)向新興業(yè)務(wù)傾斜。中國(guó)移動(dòng)計(jì)劃2022年全年算力網(wǎng)絡(luò)投資480億元,占其 總資本開支的39.0%。2022Q3,中國(guó)移動(dòng)算力規(guī)模達(dá)到7.3EFLOPS,并計(jì)劃在2025 年底達(dá)到20EFLOPS以上。中國(guó)電信產(chǎn)業(yè)數(shù)字化資本開支占比同比上升9.3pc,算力 總規(guī)模計(jì)劃由2022年中的3.1EFLOPS提升至2025年底的16.3EFLOPS。中國(guó)聯(lián)通 2022年預(yù)計(jì)算力網(wǎng)絡(luò)資本開支達(dá)到145億,同比提升43%,云投資預(yù)計(jì)提升88%。

作為算力基礎(chǔ)設(shè)施建設(shè)的主力軍,三大運(yùn)營(yíng)商目前已經(jīng)進(jìn)行前瞻性的基礎(chǔ)設(shè)施布局。 通信運(yùn)營(yíng)商自身?yè)碛袃?yōu)質(zhì)網(wǎng)絡(luò)、算力、云服務(wù)能力的通信運(yùn)營(yíng)商,同時(shí)具備天然的 產(chǎn)業(yè)鏈優(yōu)勢(shì),依靠5G+AI技術(shù)優(yōu)勢(shì),為下游客戶提供AI服務(wù)能力,是新型信息服務(wù) 體系中重要的一環(huán),助力千行百業(yè)數(shù)字化轉(zhuǎn)型。在移動(dòng)網(wǎng)絡(luò)方面,中國(guó)運(yùn)營(yíng)商已建 設(shè)覆蓋全國(guó)的高性能高可靠4/5G網(wǎng)絡(luò);在固定寬帶方面,光纖接入(FTTH/O)端 口達(dá)到10.25億個(gè),占比提升至95.7%;在算力網(wǎng)絡(luò)方面,運(yùn)營(yíng)商在資本開支結(jié)構(gòu)上 向算力網(wǎng)絡(luò)傾斜,提升服務(wù)全國(guó)算力網(wǎng)絡(luò)能力。在AI服務(wù)能力方面,加快AI領(lǐng)域商 業(yè)化應(yīng)用推出,發(fā)揮自身產(chǎn)業(yè)鏈優(yōu)勢(shì),助力千行百業(yè)數(shù)字化轉(zhuǎn)型。

(三)算力需求帶動(dòng)數(shù)據(jù)中心架構(gòu)及技術(shù)加速升級(jí)

1、數(shù)據(jù)中心呈現(xiàn)超大規(guī)模發(fā)展趨勢(shì)。超大規(guī)模數(shù)據(jù)中心,即Hyperscale Data Center,與傳統(tǒng)數(shù)據(jù)中心的核心區(qū)別在于 超大規(guī)模數(shù)據(jù)中心具備更強(qiáng)大的可擴(kuò)展性及計(jì)算能力。1)規(guī)模上,超級(jí)數(shù)據(jù)中心可 容納的規(guī)模要比傳統(tǒng)數(shù)據(jù)中心大得多,可以容納數(shù)百萬(wàn)臺(tái)服務(wù)器和更多的虛擬機(jī);2) 性能上,超級(jí)數(shù)據(jù)中心具有更高的可擴(kuò)展性和計(jì)算能力,能夠滿足數(shù)據(jù)處理數(shù)量和 速率大幅提升的需求。

具體來(lái)講,相較于傳統(tǒng)數(shù)據(jù)中心,超大規(guī)模數(shù)據(jù)中心的優(yōu)勢(shì)在于: (1)可擴(kuò)展性:超大規(guī)模數(shù)據(jù)中心的網(wǎng)絡(luò)基礎(chǔ)架構(gòu)響應(yīng)更迅速、擴(kuò)展更高效且更具 成本效益,并且提供快速擴(kuò)展存儲(chǔ)和計(jì)算資源以滿足需求的能力,超大規(guī)模數(shù)據(jù)中 心通過在負(fù)載均衡器后水平擴(kuò)展,快速旋轉(zhuǎn)或重新分配額外資源并將其添加到現(xiàn)有 集群,可以實(shí)現(xiàn)快速向集群添加額外資源,從而在不中斷操作的情況下進(jìn)行擴(kuò)展; (2)定制化:超大規(guī)模數(shù)據(jù)中心采用更新的服務(wù)器設(shè)計(jì),具有更寬的機(jī)架,可以容 納更多組件并且允許定制化設(shè)計(jì)服務(wù)器,使得服務(wù)器能夠同時(shí)接入多個(gè)電源和硬盤 驅(qū)動(dòng)器;

(3)自動(dòng)化服務(wù):超大規(guī)模數(shù)據(jù)中心提供自動(dòng)化服務(wù),幫助客戶管理高流量網(wǎng)站和 需要專門處理的高級(jí)工作負(fù)載,例如密碼學(xué)、基因處理和三維渲染; (4)冷卻效率更高:超大規(guī)模數(shù)據(jù)中心對(duì)其電源架構(gòu)進(jìn)行了優(yōu)化,并將冷卻能力集 中在托管高強(qiáng)度工作負(fù)載的服務(wù)器,大大降低了成本和對(duì)環(huán)境的影響,電源使用效 率和冷卻效率遠(yuǎn)高于傳統(tǒng)數(shù)據(jù)中心;

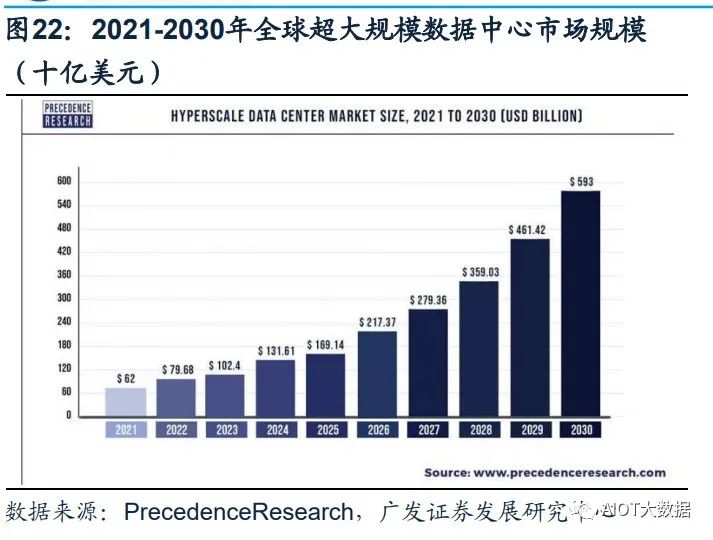

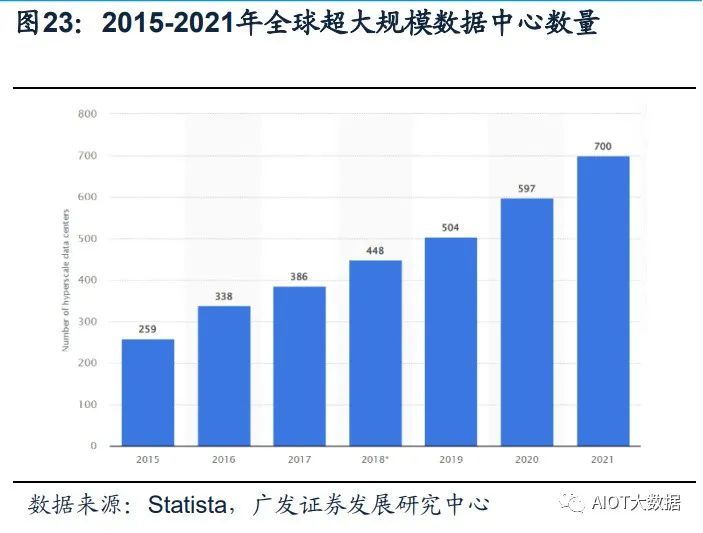

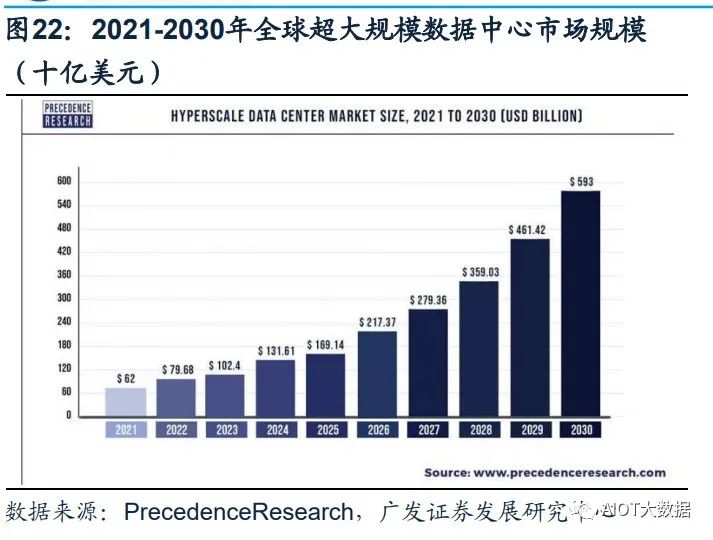

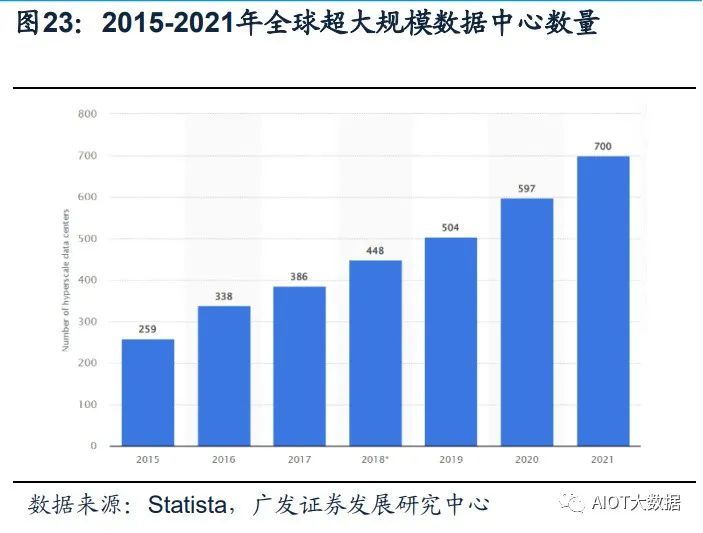

(5)工作負(fù)載更平衡:超大規(guī)模數(shù)據(jù)中心有效地將工作負(fù)載分布在多臺(tái)服務(wù)器上, 從而避免單臺(tái)服務(wù)器過熱。避免了過熱的服務(wù)器損壞附近的服務(wù)器,從而產(chǎn)生不必 要的連鎖反應(yīng)。 Statista數(shù)據(jù)顯示,全球超大規(guī)模數(shù)據(jù)中心的數(shù)量從2015年的259個(gè),提升到2021年 的700個(gè)。根據(jù)PrecedenceResearch的報(bào)告顯示,全球超大規(guī)模數(shù)據(jù)中心市場(chǎng)規(guī)模 在2021年為620億美元,到2030年將達(dá)到5930億美元,預(yù)計(jì)在2022-2030年間以 28.52%的復(fù)合增長(zhǎng)率(CAGR)增長(zhǎng)。

海內(nèi)外云商均具備自己的超大規(guī)模數(shù)據(jù)中心。Structure Research在其報(bào)告中估計(jì), 到2022年全球超大規(guī)模自建數(shù)據(jù)中心總?cè)萘繉⑦_(dá)到13177兆瓦(MW)。全球四大 超大規(guī)模數(shù)據(jù)中心平臺(tái)——AWS、谷歌云、Meta和微軟Azure——約占該容量的78%。 全球占主導(dǎo)地位的超大規(guī)模數(shù)據(jù)中心企業(yè)仍然是亞馬遜、谷歌、Meta和微軟,在中 國(guó),本土企業(yè)阿里巴巴、華為、百度、騰訊和金山云都是領(lǐng)先的超大規(guī)模數(shù)據(jù)中心 企業(yè)。

2、IB網(wǎng)絡(luò)技術(shù)將更廣泛應(yīng)用于AI訓(xùn)練超算領(lǐng)域。超級(jí)數(shù)據(jù)中心是具有更大規(guī)模和更高計(jì)算能力的數(shù)據(jù)中心。隨著對(duì)數(shù)據(jù)處理數(shù)量和 速率需求的提升,數(shù)據(jù)中心的可擴(kuò)展性需求也在迅速提升。超級(jí)數(shù)據(jù)中心在規(guī)模和 性能上較傳統(tǒng)數(shù)據(jù)中心都有了大幅升級(jí),能夠滿足超高速度擴(kuò)展以滿足超級(jí)需求的 能力。

泛AI應(yīng)用是超算中心的重要下游。自20世紀(jì)80年代以來(lái),超級(jí)計(jì)算主要服務(wù)于科研 領(lǐng)域。傳統(tǒng)超算基本上都是以國(guó)家科研機(jī)構(gòu)為主體的超算中心,如氣象預(yù)測(cè)、地震 預(yù)測(cè)、航空航天、石油勘探等。截止2022年底,國(guó)內(nèi)已建成10家國(guó)家超級(jí)計(jì)算中心, 不少省份都建立起省級(jí)超算中心,服務(wù)于當(dāng)?shù)氐闹锌圃骸庀缶忠约暗卣鸨P汀?一方面,行業(yè)頭部企業(yè)將超算應(yīng)用于芯片設(shè)計(jì)、生物醫(yī)療、材料測(cè)試等工業(yè)應(yīng)用場(chǎng) 景;另一方面,自動(dòng)駕駛訓(xùn)練、大語(yǔ)言模型訓(xùn)練、類ChatGPT等AI訓(xùn)練的需求,也 推動(dòng)超算應(yīng)用場(chǎng)景延伸至圖像識(shí)別、視頻識(shí)別定位、智能駕駛場(chǎng)景模擬以及對(duì)話和 客服系統(tǒng)等,成為超算中心的重要下游。

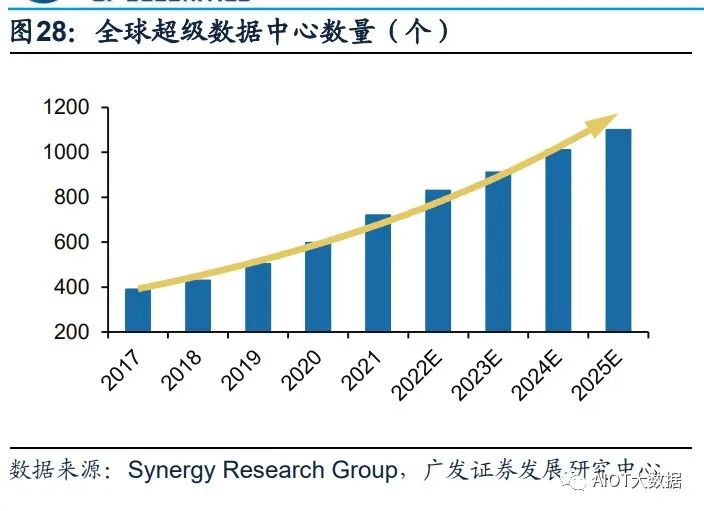

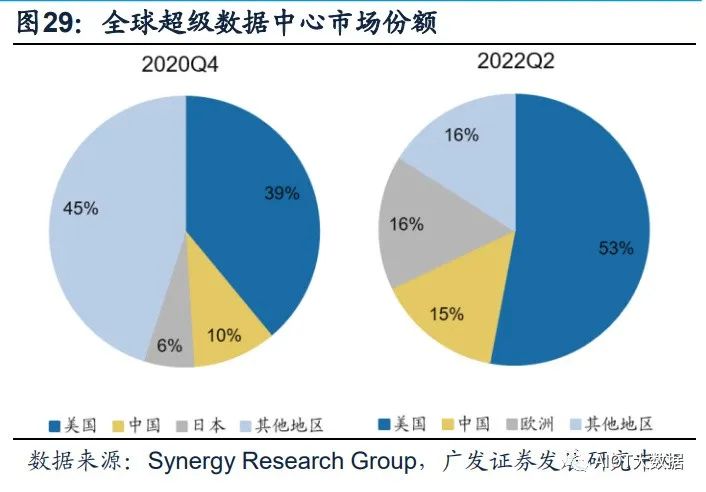

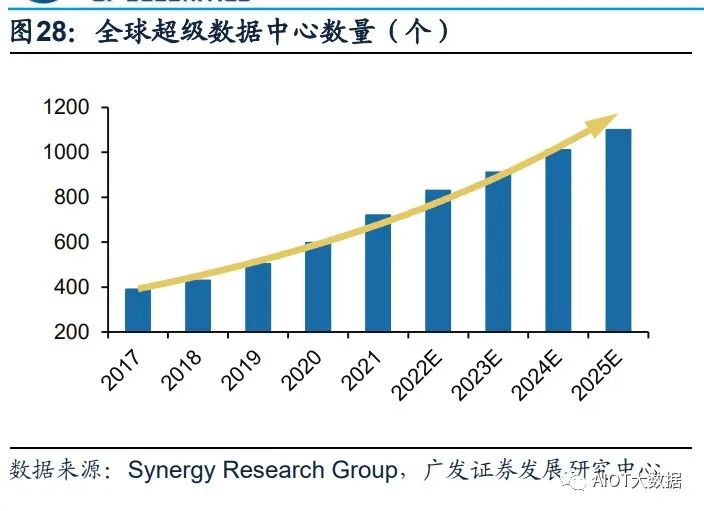

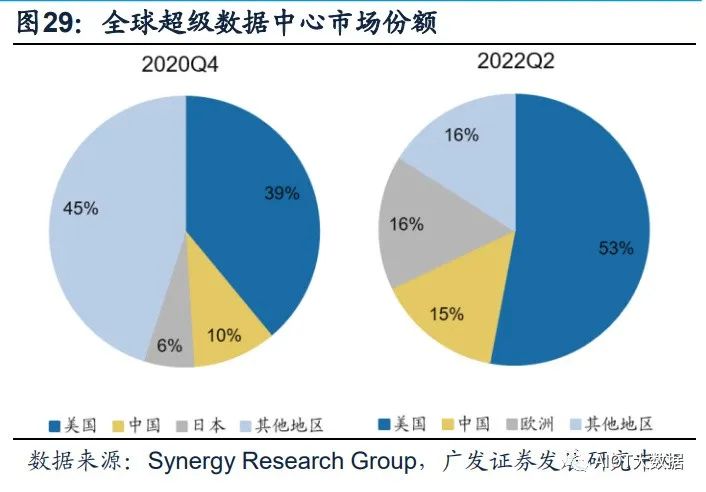

超級(jí)數(shù)據(jù)中心成為算力儲(chǔ)備的重要方向,中美加速算力基建布局。憑借其在算力能 力及能耗效率的巨大提升,超級(jí)數(shù)據(jù)中心在算力儲(chǔ)備中的地位日漸凸顯。根據(jù) Synergy Research Group數(shù)據(jù),全球超級(jí)數(shù)據(jù)中心數(shù)量從2017年的390個(gè)增長(zhǎng)至 2021年二季度的659個(gè),增長(zhǎng)近一倍,預(yù)計(jì)2024年總數(shù)將超1000個(gè)。份額方面,中 美持續(xù)加強(qiáng)超級(jí)數(shù)據(jù)中心的布局,占全球市場(chǎng)份額持續(xù)提升。

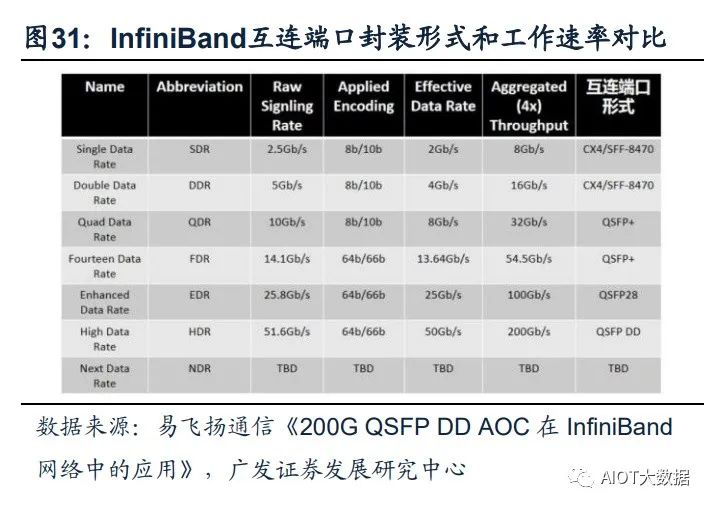

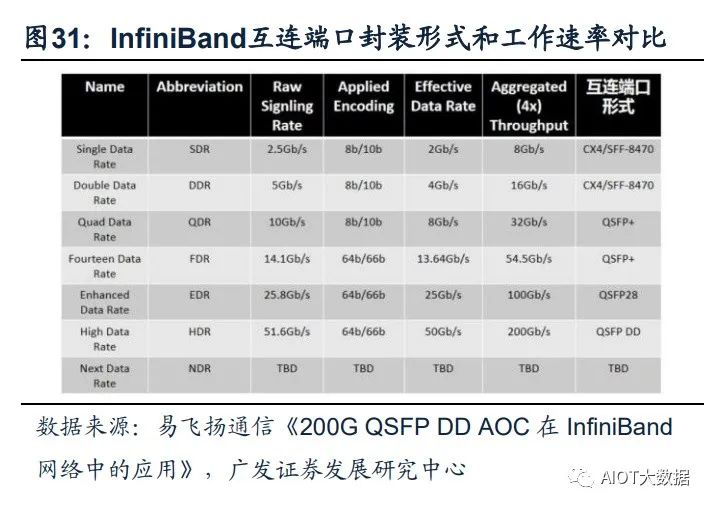

InfiniBand網(wǎng)絡(luò)滿足大帶寬和低時(shí)延的需求,成為超算中心的主流。InfiniBand(簡(jiǎn) 稱IB)是一個(gè)用于高性能計(jì)算的計(jì)算機(jī)網(wǎng)絡(luò)通信標(biāo)準(zhǔn),主要應(yīng)用于大型或超大型數(shù) 據(jù)中心。IB網(wǎng)絡(luò)的主要目標(biāo)是實(shí)現(xiàn)高的可靠性、可用性、可擴(kuò)展性及高性能,且能 在單個(gè)或多個(gè)互聯(lián)網(wǎng)絡(luò)中支持冗余的I/O通道,因此能夠保持?jǐn)?shù)據(jù)中心在局部故障時(shí) 仍能運(yùn)轉(zhuǎn)。相比傳統(tǒng)的以太網(wǎng)絡(luò),帶寬及時(shí)延都有非常明顯的優(yōu)勢(shì)。(一般InfiniBand 的網(wǎng)卡收發(fā)時(shí)延在600ns,而以太網(wǎng)上的收發(fā)時(shí)延在10us左右,英偉達(dá)推出的 MetroX-3提升長(zhǎng)距離InfiniBand系統(tǒng)帶寬至400G)。作為未來(lái)算力的基本單元,高 性能的數(shù)據(jù)中心越來(lái)越多的采用InfiniBand網(wǎng)絡(luò)方案,尤其在超算中心應(yīng)用最為廣 泛,成為AI訓(xùn)練網(wǎng)絡(luò)的主流。

(四)細(xì)分受益環(huán)節(jié)

GPT-4多模態(tài)大模型將引領(lǐng)新一輪AI算力需求的爆發(fā),超大規(guī)模數(shù)據(jù)中心及超算數(shù) 據(jù)中心作為泛AI領(lǐng)域的重要基礎(chǔ)設(shè)施支持,其數(shù)量、規(guī)模都將相應(yīng)增長(zhǎng),帶動(dòng)整個(gè) 算力基礎(chǔ)設(shè)施產(chǎn)業(yè)鏈(如高端服務(wù)器/交換機(jī)、CPO技術(shù)、硅光、液冷技術(shù))的滲透 加速。同時(shí)在應(yīng)用側(cè),Copilot的推出加速AI在辦公領(lǐng)域的賦能,看好辦公場(chǎng)景硬件 配套廠商機(jī)會(huì)。

1、服務(wù)器/交換機(jī): AIGC帶動(dòng)算力爆發(fā)式增長(zhǎng),全球進(jìn)入以數(shù)據(jù)為關(guān)鍵生產(chǎn)要素的數(shù)字經(jīng)濟(jì)時(shí)代。從國(guó) 內(nèi)三大運(yùn)營(yíng)商資本支出結(jié)構(gòu)上看,加碼算力基礎(chǔ)設(shè)施投資成重要趨勢(shì)。重點(diǎn)推薦: 中興通訊。公司作為運(yùn)營(yíng)商板塊算力投資的核心受益標(biāo)的,持續(xù)在服務(wù)器及存儲(chǔ)、 交換機(jī)/路由器、數(shù)據(jù)中心等算力基礎(chǔ)設(shè)施領(lǐng)域加強(qiáng)布局,將作為數(shù)字經(jīng)濟(jì)筑路者充 分受益我國(guó)數(shù)字經(jīng)濟(jì)建設(shè)。

算力需求帶動(dòng)上游硬件設(shè)備市場(chǎng)規(guī)模持續(xù)增長(zhǎng),高規(guī)格產(chǎn)品占比提升。伴隨著數(shù)據(jù) 流量持續(xù)提升,交換機(jī)作為數(shù)據(jù)中心必要設(shè)備,預(yù)計(jì)全球數(shù)據(jù)中心交換機(jī)保持穩(wěn)定 增長(zhǎng)。2021年全球數(shù)據(jù)中心交換機(jī)市場(chǎng)規(guī)模為138億美元,預(yù)計(jì)到2031年將達(dá)246 億美元,2022年至2031年復(fù)合年增長(zhǎng)率為5.9%。多元開放的AI服務(wù)器架構(gòu)為可以人 工智能發(fā)展提供更高的性能和可擴(kuò)展性的AI算力支撐,隨著AI應(yīng)用的發(fā)展,高性能 服務(wù)器數(shù)量有望隨之增長(zhǎng),帶動(dòng)出貨量及服務(wù)器單價(jià)相應(yīng)提升。根據(jù)IDC報(bào)告, 2022Q3,200/400GbE交換機(jī)市場(chǎng)收入環(huán)比增長(zhǎng)25.2%,100GbE交換機(jī)收入同比增 長(zhǎng)19.8%,高速部分呈現(xiàn)快速增長(zhǎng)。

2、光模塊/光芯片: 算力需求提升推動(dòng)算力基礎(chǔ)設(shè)施升級(jí)迭代,傳統(tǒng)可插拔光模塊技術(shù)弊端和瓶頸開始 顯現(xiàn)。(1)功耗過高,AI技術(shù)的加速落地,使得數(shù)據(jù)中心面臨更大的算力和網(wǎng)絡(luò)流 量壓力,交換機(jī)、光模塊等網(wǎng)絡(luò)設(shè)備升級(jí)的同時(shí),功耗增長(zhǎng)過快。以博通交換機(jī)芯 片為例,2010年到2022年交換機(jī)芯片速率從640G提升到51.2T,光模塊速率從10G 迭代到800G。速率提升的同時(shí),交換機(jī)芯片功耗提升了約8倍,光模塊功耗提升了 26倍,SerDes功耗提升了25倍。(2)交換機(jī)端口密度難以繼續(xù)提升,光模塊速率 提升的同時(shí),自身體積也在增大,而交換機(jī)光模塊端口數(shù)量有限。(3)PCB材料遭 遇瓶頸,PCB用于傳輸高速電信號(hào),傳統(tǒng)可插拔光模塊信號(hào)傳輸距離長(zhǎng)、傳輸損失 大,更低耗損的可量產(chǎn)PCB材料面臨技術(shù)難題難以攻克。

NPO/CPO技術(shù)有望成為高算力背景下的解決方案。CPO(光電共封裝技術(shù))是一 種新型的高密度光組件技術(shù),將交換芯片和光引擎共同裝配在同一個(gè)Socketed(插 槽)上,形成芯片和模組的共封裝。CPO可以取代傳統(tǒng)的插拔式光模塊技術(shù),將硅 光電組件與電子晶片封裝相結(jié)合,從而使引擎盡量靠近ASIC,降低SerDes的驅(qū)動(dòng)功 耗成本,減少高速電通道損耗和阻抗不連續(xù)性,實(shí)現(xiàn)更高密度的高速端口,提升帶 寬密度,大幅減少功耗。

CPO技術(shù)的特點(diǎn)主要有:(1)CPO技術(shù)縮短了交換芯片和光引擎之間的距離(控制在5~7cm),使得高速電信號(hào)在兩者之間實(shí)現(xiàn)高質(zhì)量傳 輸,滿足系統(tǒng)的誤碼率(BER)要求;(2)CPO用光纖配線架取代更大體積的可 插拔模塊,系統(tǒng)集成度得到提升,實(shí)現(xiàn)更高密度的高速端口,提升整機(jī)的帶寬密度; (3)降低功耗,根據(jù)銳捷網(wǎng)絡(luò)招股說(shuō)明書,采用CPO技術(shù)的設(shè)備整機(jī)相比于采用可 插拔光模塊技術(shù)的設(shè)備,整機(jī)功耗降低23%。

高算力背景下,數(shù)據(jù)中心網(wǎng)絡(luò)架構(gòu)升級(jí)帶動(dòng)光模塊用量擴(kuò)張及向更高速率的迭代。 硅光、相干及光電共封裝技術(shù)(CPO)等具備高成本效益、高能效、低能耗的特點(diǎn), 被認(rèn)為是高算力背景下的解決方案。CPO將硅光電組件與電子晶片封裝相結(jié)合,使 引擎盡量靠近ASIC,減少高速電通道損耗,實(shí)現(xiàn)遠(yuǎn)距離傳送。目前,頭部網(wǎng)絡(luò)設(shè)備 和芯片廠商已開始布局硅光、CPO相關(guān)技術(shù)與產(chǎn)品。

3、數(shù)據(jù)中心: IDC數(shù)據(jù)中心:“東數(shù)西算”工程正式全面啟動(dòng)一周年,從系統(tǒng)布局進(jìn)入全面建設(shè)階 段。隨著全國(guó)一體化算力網(wǎng)絡(luò)國(guó)家樞紐節(jié)點(diǎn)的部署和“東數(shù)西算”工程的推進(jìn),算 力集聚效應(yīng)初步顯現(xiàn),算力向規(guī)模化集約化方向加速升級(jí),同時(shí)數(shù)據(jù)中心集中東部 的局得到改善,西部地區(qū)對(duì)東部地區(qū)數(shù)據(jù)計(jì)算需求的支撐作用越發(fā)明顯。我們認(rèn)為 政策面推動(dòng)供給側(cè)不斷出清,AI等應(yīng)用將帶動(dòng)新一輪流量需求,有望打破數(shù)據(jù)中心 近兩年供給過剩的局面,帶動(dòng)數(shù)據(jù)中心長(zhǎng)期發(fā)展。

液冷溫控:隨云計(jì)算、AI、超算等應(yīng)用發(fā)展,數(shù)據(jù)中心機(jī)柜平均功率密度數(shù)預(yù)計(jì)將 逐年提升,高密度服務(wù)器也將被更廣泛的應(yīng)用于數(shù)據(jù)中心中。數(shù)據(jù)中心液冷技術(shù)能 夠穩(wěn)定CPU溫度、保障CPU在一定范圍內(nèi)進(jìn)行超頻工作不會(huì)出現(xiàn)過熱故障,有效提 升了服務(wù)器的使用效率和穩(wěn)定性,有助于提高數(shù)據(jù)中心單位空間的服務(wù)器密度,大幅 提升數(shù)據(jù)中心運(yùn)算效率,液冷技術(shù)有望在超高算力密度場(chǎng)景下持續(xù)滲透。

4、運(yùn)營(yíng)商: 通信運(yùn)營(yíng)商自身?yè)碛袃?yōu)質(zhì)網(wǎng)絡(luò)、算力、云服務(wù)能力的通信運(yùn)營(yíng)商,同時(shí)具備天然的 產(chǎn)業(yè)鏈優(yōu)勢(shì),依靠5G+AI技術(shù)優(yōu)勢(shì),為下游客戶提供AI服務(wù)能力,是新型信息服務(wù) 體系中重要的一環(huán),助力千行百業(yè)數(shù)字化轉(zhuǎn)型。作為算力基礎(chǔ)設(shè)施建設(shè)的主力軍已 經(jīng)進(jìn)行前瞻性的基礎(chǔ)設(shè)施布局。中國(guó)移動(dòng)打造九天人工智能平臺(tái),推進(jìn)AI商業(yè)化, 賦能中國(guó)移動(dòng)內(nèi)外部數(shù)智化轉(zhuǎn)型;中國(guó)電信全面布局大模型技術(shù),積極探索產(chǎn)業(yè)版 “ChatGPT”的商業(yè)化應(yīng)用;中國(guó)聯(lián)通全力升級(jí)算力網(wǎng)絡(luò),推動(dòng)5G和AI技術(shù)的融合。

5、企業(yè)通信: 3月16日晚微軟正式宣布推出Microsoft 365 Copilot,將大型語(yǔ)言模型(LLMs)的能 力嵌入到Office辦公套件產(chǎn)品中。基于GPT-4的Copilot以其視頻+圖文的多模態(tài)分析 以及更強(qiáng)大生成與理解能力,可更深度、全面發(fā)揮視頻會(huì)議AI助理功能,比如可以確定目標(biāo)捕捉發(fā)言總結(jié)某人談話要點(diǎn)、全面理解會(huì)議主要內(nèi)容并自動(dòng)整理及發(fā)送會(huì) 議紀(jì)要等。隨著Copilot更強(qiáng)大功能對(duì)微軟辦公套件的加持,有望帶動(dòng)Teams需求的 增長(zhǎng),中國(guó)企業(yè)通信終端廠商將作為微軟重要的硬件合作伙伴有望深度受益。

GPT將如何影響我們的工作?

(報(bào)告出品方/作者:東北證券,黃凈、吳雨萌)

1. 總結(jié):GPT 對(duì)工作的沖擊將跨越各個(gè)職業(yè)

3 月 17 日,OpenAI 官網(wǎng)發(fā)布最新研究論文 GPTs are GPTs: An early look at the labor market impact potential of large language models,對(duì) LLM 語(yǔ)言模型,特別是 GPT, 對(duì)美國(guó)不同職業(yè)和行業(yè)的潛在影響進(jìn)行了探討。我們將論文中的結(jié)論進(jìn)行了匯總:

1、 多數(shù)職業(yè)將受到 GPT 的沖擊:80%的工人有至少 10%的任務(wù)可以被 GPT 減少 ≥50%的工作時(shí)間;19%的工人有至少 50%的任務(wù)可以被 GPT 減少≥50%的工 作時(shí)間;

2、 GPT 的影響橫跨各類薪資層級(jí):盡管存在部分特殊情況,但整體來(lái)看,工資越 高,受 GPT 沖擊的程度越大;

3、 職業(yè)技能與 GPT 的沖擊程度有關(guān):科學(xué)和批判性思維技能最不容易受 GPT 沖 擊,而編程和寫作技能受影響的程度最高;

4、 高學(xué)歷更容易受到 GPT 的沖擊:持有學(xué)士、碩士和更高學(xué)位的人比沒有正規(guī)教 育學(xué)歷的人更容易受到 GPT 的沖擊;

5、 在職培訓(xùn)時(shí)間時(shí)長(zhǎng)與 GPT 沖擊程度有關(guān):在職培訓(xùn)時(shí)長(zhǎng)最長(zhǎng)的職業(yè)收入水平偏 低,且受 GPT 沖擊程度最低,而沒有在職培訓(xùn)或只需實(shí)習(xí)的工作則表現(xiàn)出更高 的收入水平和更容易受 GPT 沖擊的屬性。

6、 證券相關(guān)和數(shù)據(jù)處理行業(yè)受 GPT 影響程度最高:在人類打分和 GPT 打分模式 下,證券商品合約及其他金融投資和數(shù)據(jù)處理托管分別是受 GPT 沖擊程度最高 的行業(yè);在直接調(diào)用 GPT 模型的情況下,口譯筆譯和數(shù)學(xué)家分別是受影響最大 的職業(yè);在進(jìn)一步開發(fā) GPT 衍生功能的情況下,數(shù)學(xué)家和會(huì)計(jì)審計(jì)則分別為受 影響最大的職業(yè)。

2. 統(tǒng)計(jì)指標(biāo)來(lái)源及解釋

2.1. 數(shù)據(jù)來(lái)源

2.1.1. 美國(guó)職業(yè)、工作活動(dòng)和任務(wù)數(shù)據(jù)的來(lái)源

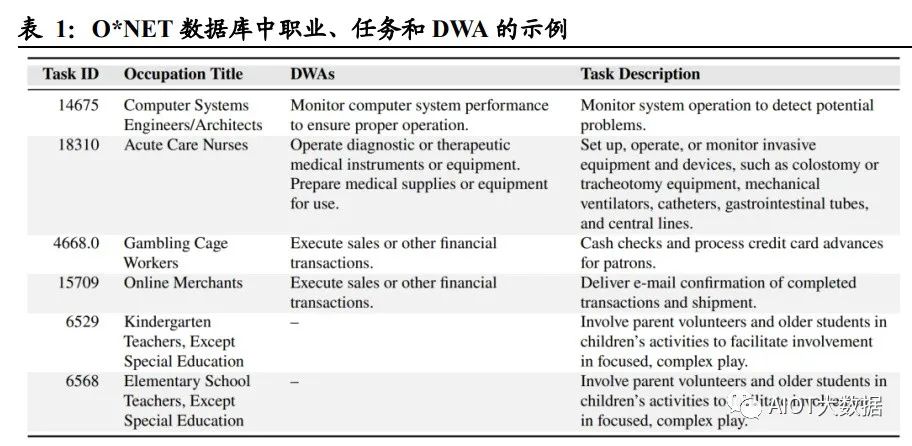

論文中使用了 O*NET 27.2 數(shù)據(jù)庫(kù),包含 1016 種職業(yè),以及各個(gè)職業(yè)的工作活動(dòng) (Detailed Work Activities,簡(jiǎn)稱 DWA)和任務(wù)(Task)。論文中對(duì)工作活動(dòng)和任務(wù) 給出了定義: 詳細(xì)工作活動(dòng) DWA 是由完成任務(wù)構(gòu)成的綜合操作,大多數(shù)工作活動(dòng)與一個(gè)或 多個(gè)任務(wù)相對(duì)應(yīng),該數(shù)據(jù)集中包括 2087 種 DWA; 任務(wù) Task 是某個(gè)特定職業(yè)的基礎(chǔ)單位,一項(xiàng)任務(wù)可以與 0 個(gè)、1 個(gè)或多個(gè) DWA 關(guān)聯(lián),且每個(gè)任務(wù)都有與之對(duì)應(yīng)的職業(yè),該數(shù)據(jù)集中包括 19265 種任務(wù)。 例如,對(duì)于職業(yè)“急癥護(hù)理護(hù)士”,其工作活動(dòng) DWA 包括“操作診斷或治療性醫(yī)療儀 器或設(shè)備”和“準(zhǔn)備醫(yī)療用品或設(shè)備”,其任務(wù)包括“設(shè)置、操作或監(jiān)測(cè)侵入性設(shè)備和 裝置,例如結(jié)腸造口術(shù)或氣管切開術(shù)設(shè)備、機(jī)械呼吸機(jī)、導(dǎo)管、胃腸道管和中心插 管”。

2.1.2. 工資、就業(yè)及人口數(shù)據(jù)來(lái)源

論文選取了美國(guó)勞工統(tǒng)計(jì)局(Bureau of Labor Statistics,以下簡(jiǎn)稱 BLS)提供的 2020 年和 2021 年職業(yè)就業(yè)系列中的就業(yè)和工資數(shù)據(jù)。該數(shù)據(jù)集包括職業(yè)名稱、每個(gè)職 業(yè)的工人數(shù)量、2031 年職業(yè)水平的就業(yè)預(yù)測(cè)、職業(yè)準(zhǔn)入的教育水平以及獲得職業(yè)能 力所需的在職培訓(xùn)情況。BLS 數(shù)據(jù)庫(kù)可以同 O*NET 數(shù)據(jù)庫(kù)進(jìn)行聯(lián)動(dòng):通過當(dāng)前人 口調(diào)查(Current Population Survey,簡(jiǎn)稱 CPS),將 O*NET 中的任務(wù)和工作活動(dòng)數(shù) 據(jù)集與 BLS 勞動(dòng)力人口統(tǒng)計(jì)數(shù)據(jù)聯(lián)系起來(lái),形成截面數(shù)據(jù)。

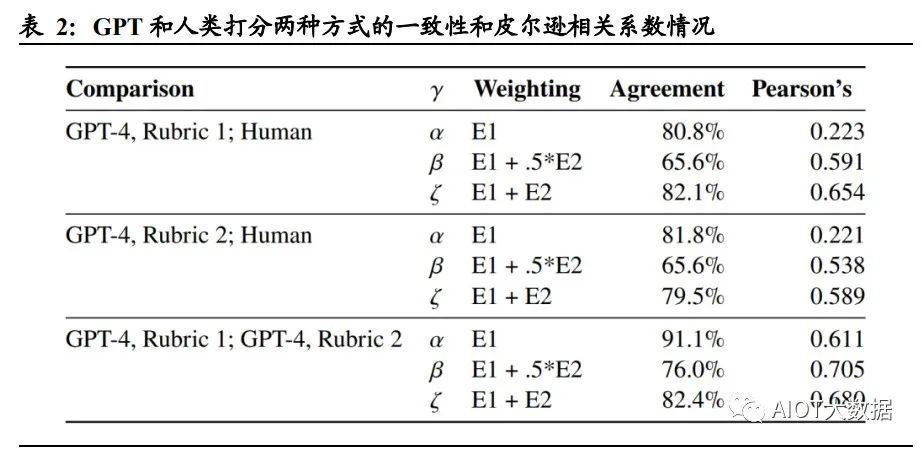

2.2. 暴露度 Exposure:用于衡量 GPT 對(duì)各職業(yè)的沖擊程度

論文中設(shè)定了暴露度 Exposure 這一指標(biāo),作為重點(diǎn)討論的對(duì)象。暴露度 Exposure 用于衡量 GPT 對(duì)特定工作活動(dòng)和任務(wù)的沖擊程度,即保證一項(xiàng)工作活動(dòng)和任務(wù)完成 質(zhì)量相同的情況下,使用 GPT 或 GPT 驅(qū)動(dòng)的系統(tǒng)是否能夠?qū)?zhí)行工作活動(dòng)或任務(wù) 的所需時(shí)間減少 50%以上。 論文采用了兩種暴露度的注釋方式,分別為人工評(píng)分法與 GPT-4 評(píng)級(jí)法: 人工評(píng)分:通過對(duì) O*NET 數(shù)據(jù)庫(kù)中的每一個(gè)工作活動(dòng) DWA 和任務(wù)進(jìn)行人為 歸類并注釋打分。 GPT-4 評(píng)級(jí):采用早期版本的 GPT-4 對(duì)工作活動(dòng)和任務(wù)進(jìn)行注釋打分。

論文將暴露度分為以下三類: E0 無(wú)暴露度:如果經(jīng)驗(yàn)豐富的工人在高質(zhì)量完成任務(wù)時(shí)所需的時(shí)間沒有明顯減少 50%,或使用 GPT 相關(guān)技術(shù)會(huì)降低工作活動(dòng)/任務(wù)的完成質(zhì)量,則定義為 E0(例: 需要高強(qiáng)度人際互動(dòng)的任務(wù))。 E1 直接暴露:在保證完成質(zhì)量相同的前提下,如果通過 ChatGPT 或 OpenAI 直接訪 問 LLM 或 GPT-4 可以將完成工作活動(dòng)或任務(wù)所需時(shí)間減少 50%及以上,則將其定 義為 E1(例:指令編寫、轉(zhuǎn)換文本和代碼的任務(wù))。 E2 LLM+暴露:直接訪問 LLM 不能將完成任務(wù)所需的時(shí)間減>50%,但在 LLM 基 礎(chǔ)上開發(fā)額外功能后可以達(dá)成目的,則定義該類工作活動(dòng)和任務(wù)為 E2(例:總結(jié)超過 2000 字的文檔并回答關(guān)于文檔的問題)。 為了更為準(zhǔn)確地衡量暴露度這一指標(biāo)的統(tǒng)計(jì)學(xué)意義,論文中構(gòu)建了三個(gè)度量指標(biāo), α、β 和 ζ,分別衡量低、中、高水平下的 GPT 對(duì)各職業(yè)的沖擊程度。其中,α=E1, 代表一個(gè)職業(yè)受 GPT 沖擊程度的下限;β=E1+0.5*E2,其中 E2 的 0.5 倍權(quán)重旨在解 釋通過補(bǔ)充工具或應(yīng)用程序來(lái)完成任務(wù)/工作活動(dòng)需要額外計(jì)算的暴露度;ζ=E1+E2, 代表一個(gè)職業(yè)受 GPT 沖擊程度的上限,可用于評(píng)估一項(xiàng)工作/任務(wù)對(duì)于 GPT 及 GPT 驅(qū)動(dòng)的系統(tǒng)的最大暴露度(即GPT進(jìn)一步開發(fā)后,一項(xiàng)工作/任務(wù)受到的最大影響)。

3. 研究結(jié)論:30%的職業(yè)或任務(wù)將受到 GPT 沖擊

前文將暴露度 Exposure 這一指標(biāo)的定義進(jìn)行了描述,論文中還將暴露度的衡量指標(biāo) α、β 和 ζ 進(jìn)行了統(tǒng)計(jì)數(shù)據(jù)的匯總。不論采取人類打分的方式還是 GPT-4 打分,暴露 度α的均值在0.14左右,表示了從平均意義上說(shuō),15%左右的職業(yè)/任務(wù)暴露于GPT, 即 15%左右的工作可能會(huì)被現(xiàn)有的 LLM/GPT-4 降低 50%以上的工作時(shí)間。類似 地,暴露度 β 和 ζ 均值分別在 0.3 和 0.5 左右,代表 30%/50%的職業(yè)或任務(wù)將受到 中/高水平的 GPT 沖擊,即減少工作時(shí)間 50%及以上。

4. 研究結(jié)論:工資水平與 GPT 沖擊程度呈正相關(guān)

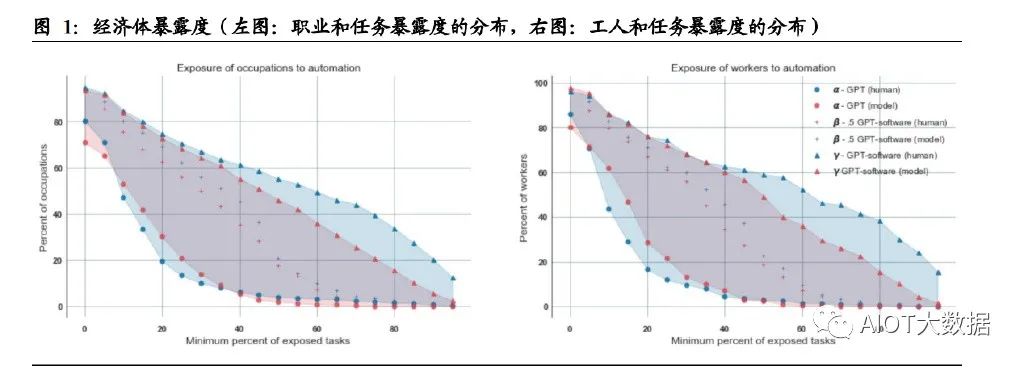

論文探索了職業(yè)、工人分布程度與暴露度之間的關(guān)系。對(duì)于中等水平的 GPT(β) 來(lái)說(shuō),約 19%的工人有 50%以上的任務(wù)將受到 GPT 的沖擊,80%的工人有 10%以 上的任務(wù)受到了 GPT 的沖擊;18%的職業(yè)中有 50%以上的任務(wù)受到了 GPT 的沖 擊。

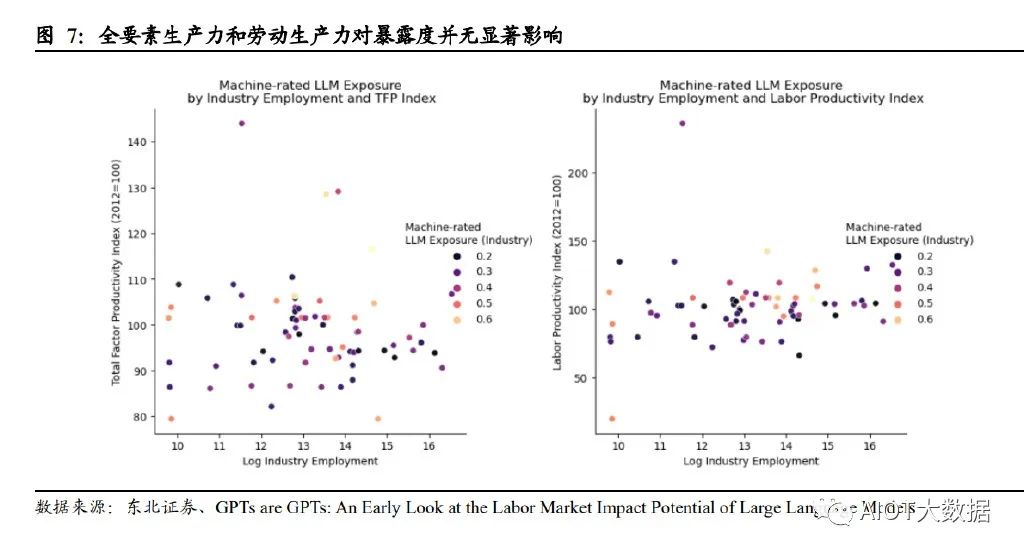

論文還對(duì)工資、就業(yè)水平與暴露度的相關(guān)性進(jìn)行了探討。兩種打分模式下,盡管存 在一些高暴露度的低工資職業(yè)和低暴露度的高工資職業(yè),整體圖表顯示,工資越高, 受 GPT 影響的程度也隨之增加。而 GPT 沖擊程度與就業(yè)水平則并無(wú)顯著關(guān)聯(lián)。

5. 研究結(jié)論:科學(xué)和批判性思維是受 GPT 沖擊最小的技能

論文研究了不同職業(yè)中技能重要性與 GPT 暴露度之間的關(guān)系。作者將 O*NET 數(shù)據(jù) 庫(kù)中的基本技能進(jìn)行標(biāo)準(zhǔn)化,并將其與暴露度指標(biāo)(α,β,ζ)進(jìn)行回歸分析,檢驗(yàn) 技能重要性和暴露度之間的關(guān)聯(lián)度。結(jié)果表明,科學(xué)和批判性思維技能(Science and CriticalThinking)與暴露度呈強(qiáng)烈的負(fù)相關(guān)(以β作為研究,相關(guān)系數(shù)分別-0.23 和 -0.19),即需要該技能的職業(yè)或任務(wù)不太可能受到 GPT 的沖擊;相反,編程和寫作 技能(Programming and Writing)與暴露度呈現(xiàn)出強(qiáng)正相關(guān)(相關(guān)系數(shù)分別為 0.62 和 0.47),即涉及該技能的職業(yè)更容易受到 GPT 的沖擊。

6. 研究結(jié)論:學(xué)歷水平和在職培訓(xùn)時(shí)長(zhǎng)與 GPT 沖擊程度相關(guān)

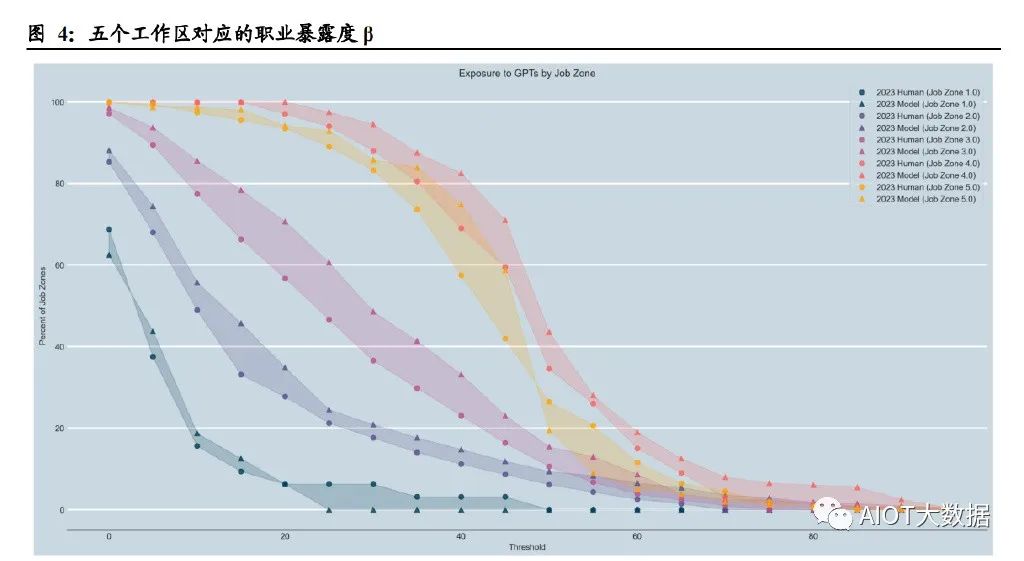

論文研究了不同工作類型的準(zhǔn)入壁壘與暴露程度的關(guān)系。作者選取 O*NET 數(shù)據(jù)庫(kù) 中的“工作區(qū)(Job Zone)”概念作為變量,同一工作區(qū)中的職業(yè)在準(zhǔn)入教育水平、 準(zhǔn)入相關(guān)經(jīng)驗(yàn)、在職培訓(xùn)程度方面具有更高的相似度。O*NET 數(shù)據(jù)庫(kù)將工作區(qū)分為 5 種,隨著準(zhǔn)入工作經(jīng)驗(yàn)的增加,各工作區(qū)收入的中位數(shù)單調(diào)遞增,如工作區(qū) 1 的 準(zhǔn)入工作經(jīng)驗(yàn)是 3 個(gè)月,收入的中位數(shù)為 30,230 美元,而工作區(qū) 5 的準(zhǔn)入工作經(jīng)驗(yàn) 是≥4 年,收入中位數(shù)為 80,980 美元。 研究結(jié)果顯示,從工作區(qū) 1 到工作區(qū) 4,暴露度水平逐漸增加,但在工作區(qū) 5 則保 持相似甚至有所降低。平均來(lái)說(shuō),在不同工作區(qū),50%以上任務(wù)受到 GPT 沖擊的職 業(yè)比例分別為 0.00%(工作區(qū) 1)、6.11%(工作區(qū) 2)、10.57%(工作區(qū) 3)、34.5% (工作區(qū) 4)和 26.45%(工作區(qū) 5)。

論文還單獨(dú)研究了職業(yè)準(zhǔn)入教育水平和在職培訓(xùn)情況與暴露度的關(guān)系。結(jié)果表明, 持有學(xué)士、碩士和更高學(xué)位的人比沒有正規(guī)教育學(xué)歷的人更容易受到GPT的沖擊; 在職培訓(xùn)時(shí)間最長(zhǎng)的職業(yè)受 GPT 沖擊程度最低(且這類工作的收入水平更低),而 沒有在職培訓(xùn)或只需要實(shí)習(xí)的工作表現(xiàn)出更高的收入水平和更容易受 GPT 沖擊的 屬性。

7. 研究結(jié)論:證券投資和數(shù)據(jù)處理可能是受沖擊程度最高的職業(yè)

論文中對(duì)各行業(yè)受 GPT 沖擊的程度進(jìn)行了排序。結(jié)果表明,人類打分模式下,證券 商品合約及其他金融投資及相關(guān)活動(dòng)是受 GPT 沖擊最為嚴(yán)重的行業(yè),而 GPT 打分 模式下,數(shù)據(jù)處理托管和相關(guān)服務(wù)的受沖擊程度最高。 在直接調(diào)用 GPT 模型的情況下(暴露度 α),口譯筆譯和數(shù)學(xué)家分別是兩種打分模 式下受影響最大的職業(yè)。在進(jìn)一步開發(fā) GPT 衍生功能的情況下(暴露度 ζ),人類打 分模式中,有 15 項(xiàng)職業(yè)的所有任務(wù)都將被 GPT 降低 50%以上的工作時(shí)間,包括數(shù) 學(xué)家、稅務(wù)準(zhǔn)備、量化分析師、作家、網(wǎng)頁(yè)和數(shù)字化頁(yè)面設(shè)計(jì)師;GPT 打分模式中, 有 86 項(xiàng)職業(yè)的所有任務(wù)都將被 GPT 降低 50%以上的工作時(shí)間,包括審計(jì)會(huì)計(jì)、新 聞分析記者、法務(wù)專員、臨床數(shù)據(jù)經(jīng)理、氣象變化政策分析師等。從方差角度看, 搜索營(yíng)銷策略師、平面設(shè)計(jì)師、投資基金經(jīng)理、財(cái)務(wù)經(jīng)理、汽車損壞保險(xiǎn)估價(jià)師可 能是受 GPT 影響程度爭(zhēng)議最大的幾項(xiàng)職業(yè)。

此外,論文研究表明,近期的生產(chǎn)增長(zhǎng)率(包含全要素和勞動(dòng)力兩方面)與暴露度 并無(wú)顯著相關(guān)性。換言之,如果 LLM 有可能在不同行業(yè)之間以不同程度提高生產(chǎn)力, 那么生產(chǎn)力最高的企業(yè)可能會(huì)良性循環(huán)。由于這些行業(yè)的生產(chǎn)需求普遍缺乏彈性, 生產(chǎn)率最高的部門在經(jīng)濟(jì)投入中所占的比例將縮小。

8. 對(duì)國(guó)內(nèi)的探討:賣方分析師≥80%的工作可能受 GPT 沖擊

我們采用了論文中類似的方法,試圖對(duì)國(guó)內(nèi)證券行業(yè)相關(guān)工作進(jìn)行打分,并計(jì)算了 其可能受 GPT 沖擊的程度。論文中采用的 O*NET 數(shù)據(jù)庫(kù)將每一項(xiàng)職業(yè)對(duì)應(yīng)的任務(wù)、 工作活動(dòng)都進(jìn)行了定義,但由于國(guó)內(nèi)暫無(wú)類似的數(shù)據(jù)庫(kù)和較為詳細(xì)的職業(yè)分類,我 們?nèi)圆捎昧?O*NET 數(shù)據(jù)庫(kù)中的分類,但依據(jù)國(guó)內(nèi)的情況做了本土化調(diào)整,例如, O*NET 數(shù)據(jù)庫(kù)中的金融投資分析師(Financial and InvestmentAnalysts)職業(yè)包含任 務(wù)“對(duì)綠色建筑和綠色改造項(xiàng)目進(jìn)行投資財(cái)務(wù)分析(Conduct financial analyses related to investments in green construction or green retrofitting projects)”,而中國(guó)的分析師普 遍不涉及這項(xiàng)工作,因此予以刪除調(diào)整。

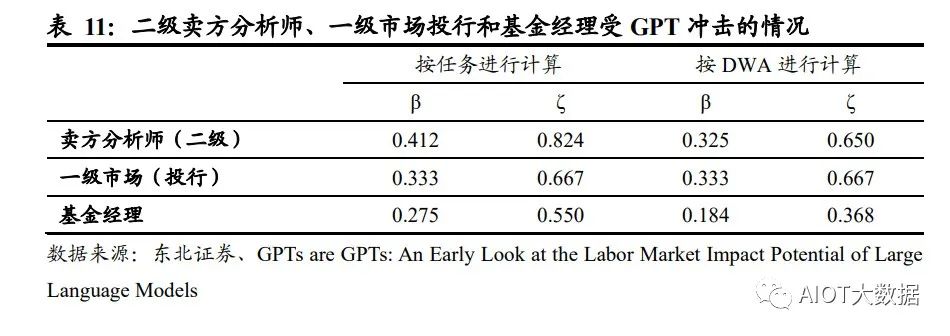

我們選取了 O*NET 數(shù)據(jù)庫(kù)中的Financial and Investment Analysts金融和投資分析師、 Investment Fund Managers 投資基金經(jīng)理這兩項(xiàng)職業(yè)和對(duì)應(yīng)的任務(wù)與工作活動(dòng) (DWA),并根據(jù)中國(guó)的實(shí)際情況,將其重新組合為二級(jí)賣方分析師、一級(jí)市場(chǎng)投 行和基金經(jīng)理。采用與論文相同的標(biāo)準(zhǔn),對(duì)這些職業(yè)的任務(wù)/工作活動(dòng)進(jìn)行了打分, 并計(jì)算了暴露度β和ζ。結(jié)果顯示,按任務(wù)情況進(jìn)行計(jì)算,三種行業(yè)對(duì)比下,二級(jí) 賣方分析師受 GPT 沖擊的程度高于投行一級(jí)市場(chǎng)和基金經(jīng)理。在經(jīng)過專業(yè)知識(shí)訓(xùn) 練的 LLM 和 GPT 的幫助下(代表暴露度ζ),賣方分析師可能有 82%的任務(wù)將被 減少 50%以上的工作時(shí)間,基金經(jīng)理可能有 55%的任務(wù)被減少 50%以上的工作時(shí) 間。按照工作活動(dòng)計(jì)算,二級(jí)賣方分析師和一級(jí)市場(chǎng)投行受 GPT 影響的程度相差不 大,約為 65%左右,但仍顯著高于基金經(jīng)理。

在論文中,作者將 E1 直接暴露定義為運(yùn)用現(xiàn)有 ChatGPT 和 OpenAI 接口直接方位 LLM 可以減少50%以上的工作時(shí)間,對(duì)應(yīng)的工作內(nèi)容包括編寫文本(2000 字以內(nèi))、 翻譯、準(zhǔn)備短資料等,而證券業(yè)的任務(wù)由于涉及專業(yè)知識(shí)、撰寫長(zhǎng)度超過 2000 字的 報(bào)告等,因此在進(jìn)行打分時(shí),不存在直接暴露 E1 的情況,所有任務(wù)及工作活動(dòng)均 被歸類為無(wú)暴露(E0)或 LLM+暴露(E2)。另外,在打分過程中,根據(jù)論文作者 的標(biāo)準(zhǔn),我們將法律法規(guī)要求人類完成的任務(wù)、需要確認(rèn)/授權(quán)/決策的任務(wù)、涉及雇 傭員工和培訓(xùn)團(tuán)隊(duì)的任務(wù)以及涉及大量人際交流的任務(wù)歸類為無(wú)暴露(E0),分析 類、文本整理類、資料搜集類工作定義為 LLM+暴露(E2)。值得注意的是,由于基 金經(jīng)理這一職業(yè)涉及更多審查合規(guī)性、響應(yīng)監(jiān)管要求等任務(wù),因此展現(xiàn)出較分析師 更低的暴露度(ζ),即受 GPT 的影響低于分析師。

根據(jù)論文中對(duì)于不同行業(yè)的暴露度統(tǒng)計(jì),按照人類打分,美國(guó)證券商品合約及其他金融投資的暴露度β在 0.6-0.7 之間,我們將這一數(shù)值作為美國(guó)證券行業(yè)受到 GPT 沖擊的平均水平。為了方便對(duì)比,我們采用暴露度β進(jìn)行對(duì)比,國(guó)內(nèi)賣方分析師、 一級(jí)市場(chǎng)(投行)和基金經(jīng)理分別對(duì)應(yīng)的暴露度 0.41、0.33 和 0.28,證明國(guó)內(nèi)賣方 分析師、一級(jí)市場(chǎng)(投行)和基金經(jīng)理受到 GPT 沖擊的情況略好于美國(guó)證券行業(yè) 受沖擊的平均水平。我們推測(cè)可能由以下原因?qū)е拢?/p>

1、 美國(guó)擁有更高比例的量化分析師:論文中特別提到,在經(jīng)過專業(yè)知識(shí)訓(xùn)練的 LLM 和 GPT 的幫助下(暴露度ζ),人類打分模式下,量化分析師的暴露度是 100%,即量化分析師所有的任務(wù)都可以在 GPT 的幫助下大幅降低工作時(shí)間;美 國(guó)量化分析行業(yè)發(fā)展相對(duì)靠前,量化分析師可能擁有更高的權(quán)重,從而拉高行 業(yè)整體的暴露度;

2、 不同證券市場(chǎng)的有效性可能對(duì)工作任務(wù)的打分產(chǎn)生影響:美國(guó)資本市場(chǎng)被認(rèn)為 是半強(qiáng)有效市場(chǎng),較 A 股相比,美股市場(chǎng)的信息更加公開透明;GPT 在公開信 息的搜集整理、歸納總結(jié)方面具有明顯的優(yōu)勢(shì),因此相比國(guó)內(nèi),GPT 和 LLM 能 夠更好地幫助美國(guó)的證券從業(yè)者降低工作時(shí)長(zhǎng),從而表現(xiàn)出更高的暴露度。

GPT~4引發(fā)新一輪AI算力需求爆發(fā)

(報(bào)告出品方/作者:廣發(fā)證券,李娜,王亮)

一、OpenAI正式發(fā)布多模態(tài)大模型GPT-4,實(shí)現(xiàn)多重能力躍升

(一)多模態(tài)大模型GPT-4是OpenAI公司GPT系列最新一代模型

美國(guó)OpenAI公司成立于2015年12月,是全球頂級(jí)的人工智能研究機(jī)構(gòu)之一,創(chuàng)始人 包括Elon Musk、著名投資者Sam Altman、支付服務(wù)PayPal創(chuàng)始人Peter Thiel等人。 OpenAI作為人工智能領(lǐng)域的革命者,成立至今開發(fā)出多款人工智能產(chǎn)品。2016年, OpenAI推出了用于強(qiáng)化學(xué)習(xí)研究的工具集OpenAI Gym;同時(shí)推出開源平臺(tái)OpenAI Universe,用于測(cè)試和評(píng)估智能代理機(jī)器人在各類環(huán)境中的表現(xiàn)。2019年,OpenAI 發(fā)布了GPT-2模型,可根據(jù)輸入文本自動(dòng)生成語(yǔ)言,展現(xiàn)出人工智能創(chuàng)造性思維的 能力;2020年更新了GPT-3語(yǔ)言模型,并在其基礎(chǔ)上發(fā)布了OpenAI Codex模型,該 模型可以自動(dòng)生成完整有效的程序代碼。

2021年1月,OpenAI發(fā)布了OpenAI CLIP, 用于進(jìn)行圖像和文本的識(shí)別分類;同時(shí)推出全新產(chǎn)品DALL-E,該模型可以根據(jù)文字 描述自動(dòng)生成對(duì)應(yīng)的圖片,2022年更新的DALL-E2更是全方位改進(jìn)了生成圖片的質(zhì) 量,獲得了廣泛好評(píng)。 2022年12月,OpenAI推出基于GPT-3.5的新型AI聊天機(jī)器人ChatGPT,在發(fā)布進(jìn) 兩個(gè)月后擁有1億用戶,成為史上用戶增長(zhǎng)最快的應(yīng)用;美東時(shí)間2023年3月14日, ChatGPT的開發(fā)機(jī)構(gòu)OpenAI正式推出多模態(tài)大模型GPT-4。

GPT(General Pre-Training)系列模型即通用預(yù)訓(xùn)練語(yǔ)言模型,是一種利用 Transformer作為特征抽取器,基于深度學(xué)習(xí)技術(shù)的自然語(yǔ)言處理模型。 GPT系列模型由OpenAI公司開發(fā),經(jīng)歷了長(zhǎng)達(dá)五年時(shí)間的發(fā)展: (1)其最早的產(chǎn)品GPT模型于2018年6月發(fā)布,該模型可以根據(jù)給定的文本序列進(jìn) 行預(yù)測(cè)下一個(gè)單詞或句子,充分證明通過對(duì)語(yǔ)言模型進(jìn)行生成性預(yù)訓(xùn)練可以有效減 輕NLP任務(wù)中對(duì)于監(jiān)督學(xué)習(xí)的依賴; (2)2019年2月GPT-2模型發(fā)布,該模型取消了原GPT模型中的微調(diào)階段,變?yōu)闊o(wú) 監(jiān)督模型,同時(shí),GPT-2采用更大的訓(xùn)練集嘗試zero-shot學(xué)習(xí),通過采用多任務(wù)模 型的方式使其在面對(duì)不同任務(wù)時(shí)都能擁有更強(qiáng)的理解能力和較高的適配性;

(3)GPT-3模型于2020年6月被發(fā)布,它在多項(xiàng)自然語(yǔ)言處理任務(wù)上取得了驚人的 表現(xiàn),并被認(rèn)為是迄今為止最先進(jìn)的自然語(yǔ)言處理模型之一。GPT-3訓(xùn)練使用的數(shù) 據(jù)集為多種高質(zhì)量數(shù)據(jù)集的混合,一次保證了訓(xùn)練質(zhì)量;同時(shí),該模型在下游訓(xùn)練 時(shí)用Few-shot取代了GPT-2模型使用的zero-shot,即在執(zhí)行任務(wù)時(shí)給予少量樣例, 以此提高準(zhǔn)確度;除此之外,它在前兩個(gè)模型的基礎(chǔ)上引入了新的技術(shù)——“零樣 本學(xué)習(xí)”,即GPT-3即便沒有對(duì)特定的任務(wù)進(jìn)行訓(xùn)練也可以完成相應(yīng)的任務(wù),這使 得GPT-3面對(duì)陌生語(yǔ)境時(shí)具有更好的靈活性和適應(yīng)性。

(4)2022年11月,OpenAI發(fā)布GPT-3.5模型,是由GPT-3微調(diào)出來(lái)的版本,采用 不同的訓(xùn)練方式,其功能更加強(qiáng)大。基于GPT-3.5模型,并加上人類反饋強(qiáng)化學(xué)習(xí) (RLHF)發(fā)布ChatGPT應(yīng)用,ChatGPT的全稱為Chat Generative Pre-trained Transformer,是建立在大型語(yǔ)言模型基礎(chǔ)上的對(duì)話式自然語(yǔ)言處理工具,表現(xiàn)形式 是一種聊天機(jī)器人程序,能夠?qū)W習(xí)及理解人類的語(yǔ)言,根據(jù)聊天的上下文進(jìn)行互動(dòng), 甚至能夠完成翻譯、編程、撰寫論文、編輯郵件等功能。 (5)2023年3月,OpenAI正式發(fā)布大型多模態(tài)模型GPT-4(輸入圖像和文本,輸出 文本輸出),此前主要支持文本,現(xiàn)模型能支持識(shí)別和理解圖像。

(二)GPT大模型通過底層技術(shù)的疊加,實(shí)現(xiàn)組合式的創(chuàng)新

由于OpenAI并沒有提供關(guān)于GPT-4用于訓(xùn)練的數(shù)據(jù)、算力成本、訓(xùn)練方法、架構(gòu)等 細(xì)節(jié),故我們本章主要討論ChatGPT模型的技術(shù)路徑。 ChatGPT模型從算法分來(lái)上來(lái)講屬于生成式大規(guī)模語(yǔ)言模型,底層技術(shù)包括 Transformer架構(gòu)、有監(jiān)督微調(diào)訓(xùn)練、RLHF強(qiáng)化學(xué)習(xí)等,ChatGPT通過底層技術(shù) 的疊加,實(shí)現(xiàn)了組合式的創(chuàng)新。 GPT模型采用了由Google提出的Transformer架構(gòu)。Transformer架構(gòu)采用自注意 力機(jī)制的序列到序列模型,是目前在自然語(yǔ)言處理任務(wù)中最常用的神經(jīng)網(wǎng)絡(luò)架構(gòu)之 一。相比于傳統(tǒng)的循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)或卷積神經(jīng)網(wǎng)絡(luò)(CNN),Transformer 沒有顯式的時(shí)間或空間結(jié)構(gòu),因此可以高效地進(jìn)行并行計(jì)算,并且Transformer具有 更好的并行化能力和更強(qiáng)的長(zhǎng)序列數(shù)據(jù)處理能力。

ChatGPT模型采用了“預(yù)訓(xùn)練+微調(diào)”的半監(jiān)督學(xué)習(xí)的方式進(jìn)行訓(xùn)練。第一階段是 Pre-Training階段,通過預(yù)訓(xùn)練的語(yǔ)言模型(Pretrained Language Model),從大 規(guī)模的文本中提取訓(xùn)練數(shù)據(jù),并通過深度神經(jīng)網(wǎng)絡(luò)進(jìn)行處理和學(xué)習(xí),進(jìn)而根據(jù)上下 文預(yù)測(cè)生成下一個(gè)單詞或者短語(yǔ),從而生成流暢的語(yǔ)言文本;第二階段是Fine-tuning 階段,將已經(jīng)完成預(yù)訓(xùn)練的GPT模型應(yīng)用到特定任務(wù)上,并通過少量的有標(biāo)注的數(shù) 據(jù)來(lái)調(diào)整模型的參數(shù),以提高模型在該任務(wù)上的表現(xiàn)。

ChatGPT在訓(xùn)練中使用了RLHF人類反饋強(qiáng)化學(xué)習(xí)模型,是GPT-3模型經(jīng)過升級(jí)并 增加對(duì)話功能后的最新版本。2022年3月,OpenAI發(fā)布InstructGPT,這一版本是 GPT-3模型的升級(jí)版本。相較于之前版本的GPT模型,InstructGPT引入了基于人類 反饋的強(qiáng)化學(xué)習(xí)技術(shù)(Reinforcement Learning with Human Feedback,RLHF), 對(duì)模型進(jìn)行微調(diào),通過獎(jiǎng)勵(lì)機(jī)制進(jìn)一步訓(xùn)練模型,以適應(yīng)不同的任務(wù)場(chǎng)景和語(yǔ)言風(fēng) 格,給出更符合人類思維的輸出結(jié)果。

RLHF的訓(xùn)練包括訓(xùn)練大語(yǔ)言模型、訓(xùn)練獎(jiǎng)勵(lì)模型及RLHF微調(diào)三個(gè)步驟。首先,需 要使用預(yù)訓(xùn)練目標(biāo)訓(xùn)練一個(gè)語(yǔ)言模型,同時(shí)也可以使用額外文本進(jìn)行微調(diào)。其次, 基于語(yǔ)言模型訓(xùn)練出獎(jiǎng)勵(lì)模型,對(duì)模型生成的文本進(jìn)行質(zhì)量標(biāo)注,由人工標(biāo)注者按 偏好將文本從最佳到最差進(jìn)行排名,借此使得獎(jiǎng)勵(lì)模型習(xí)得人類對(duì)于模型生成文本 序列的偏好。最后利用獎(jiǎng)勵(lì)模型輸出的結(jié)果,通過強(qiáng)化學(xué)習(xí)模型微調(diào)優(yōu)化,最終得 到一個(gè)更符合人類偏好語(yǔ)言模型。

(三)GPT-4相較于ChatGPT實(shí)現(xiàn)多重能力躍遷

ChatGPT于2022年11月推出之后,僅用兩個(gè)月時(shí)間月活躍用戶數(shù)便超過1億,在短 時(shí)間內(nèi)積累了龐大的用戶基數(shù),也是歷史上增長(zhǎng)最快的消費(fèi)應(yīng)用。多模態(tài)大模型GPT-4是OpenAI的里程碑之作,是目前最強(qiáng)的文本生成模型。 ChatGPT推出后的三個(gè)多月時(shí)間里OpenAI就正式推出GPT-4,再次拓寬了大模型的 能力邊界。GPT-4是一個(gè)多模態(tài)大模型(接受圖像和文本輸入,生成文本),相比 上一代,GPT-4可以更準(zhǔn)確地解決難題,具有更廣泛的常識(shí)和解決問題的能力:更 具創(chuàng)造性和協(xié)作性;能夠處理超過25000個(gè)單詞的文本,允許長(zhǎng)文內(nèi)容創(chuàng)建、擴(kuò)展 對(duì)話以及文檔搜索和分析等用例。

(1)GPT-4具備更高的準(zhǔn)確性及更強(qiáng)的專業(yè)性。GPT-4在更復(fù)雜、細(xì)微的任務(wù)處理 上回答更可靠、更有創(chuàng)意,在多類考試測(cè)驗(yàn)中以及與其他LLM的benchmark比較中 GPT-4明顯表現(xiàn)優(yōu)異。GPT-4在模擬律師考試GPT-4取得了前10%的好成績(jī),相比 之下GPT-3.5是后10%;生物學(xué)奧賽前1%;美國(guó)高考SAT中GPT-4在閱讀寫作中拿 下710分高分、數(shù)學(xué)700分(滿分800)。

(2)GPT能夠處理圖像內(nèi)容,能夠識(shí)別較為復(fù)雜的圖片信息并進(jìn)行解讀。GPT-4 突破了純文字的模態(tài),增加了圖像模態(tài)的輸入,支持用戶上傳圖像,并且具備強(qiáng)大 的圖像能力—能夠描述內(nèi)容、解釋分析圖表、指出圖片中的不合理指出或解釋梗圖。 在OpenAI發(fā)布的產(chǎn)品視頻中,開發(fā)者給GPT-4輸入了一張“用VGA電腦接口給 iPhone充電”的圖片,GPT-4不僅可以可描述圖片,還指出了圖片的荒謬之處。

(3)GPT-4可以處理超過25000字的文本。在文本處理上,GPT-4支持輸入的文字 上限提升至25000字,允許長(zhǎng)文內(nèi)容創(chuàng)建、擴(kuò)展對(duì)話以及文檔搜索和分析等用例。 且GPT-4的多語(yǔ)言處理能力更優(yōu),在GPT-4的測(cè)評(píng)展示中,GPT-4可以解決法語(yǔ)的 物理問題,且在測(cè)試的英語(yǔ)、拉脫維亞語(yǔ)、威爾士語(yǔ)和斯瓦希里語(yǔ)等26種語(yǔ)言中, 有24種語(yǔ)言下,GPT-4優(yōu)于GPT-3.5和其他大語(yǔ)言模型(Chinchilla、PaLM)的英 語(yǔ)語(yǔ)言性能。(4)具備自我訓(xùn)練與預(yù)測(cè)能力,同時(shí)改善幻覺、安全等局限性。GPT-4的一大更新 重點(diǎn)是建立了一個(gè)可預(yù)測(cè)拓展的深度學(xué)習(xí)棧,使其具備了自我訓(xùn)練及預(yù)測(cè)能力。同 時(shí),GPT-4在相對(duì)于以前的模型已經(jīng)顯著減輕了幻覺問題。在OpenAI的內(nèi)部對(duì)抗性 真實(shí)性評(píng)估中,GPT-4的得分比最新的GPT-3.5模型高 40%;在安全能力的升級(jí)上, GPT-4明顯超出ChatGPT和GPT3.5。

(四)商業(yè)模式愈發(fā)清晰,微軟Copilot引發(fā)跨時(shí)代的生產(chǎn)力變革

OpenAI已正式宣布為第三方開開發(fā)者開放ChatGPT API,價(jià)格降低加速場(chǎng)景應(yīng)用 爆發(fā)。起初ChatGPT免費(fèi)向用戶開放,以獲得用戶反饋;今年2月1日,Open AI推 出新的ChatGPT Plus訂閱服務(wù),收費(fèi)方式為每月20美元,訂閱者能夠因此而獲得更 快、更穩(wěn)定的響應(yīng)并優(yōu)先體驗(yàn)新功能。3月2日,OpenAI官方宣布正式開放ChatGPT API(應(yīng)用程序接口),允許第三方開發(fā)者通過API將ChatGPT集成至他們的應(yīng)用程 序和服務(wù)中,價(jià)格為1ktokens/$0.002,即每輸出100萬(wàn)個(gè)單詞需要2.7美元,比已有 的GPT-3.5模型價(jià)格降低90%。模型價(jià)格的降低將推動(dòng)ChatGPT被集成到更多場(chǎng)景 或應(yīng)用中,豐富ChatGPT的應(yīng)用生態(tài),加速多場(chǎng)景應(yīng)用的爆發(fā)。

GPT-4發(fā)布后OpenAI把ChatGPT直接升級(jí)為GPT-4最新版本,同時(shí)開放了GPT-4 的API。ChatGPT Plus付費(fèi)訂閱用戶可以獲得具有使用上限的GPT-4訪問權(quán)限(每4 小時(shí)100條消息),可以向GPT-4模型發(fā)出純文本請(qǐng)求。用戶可以申請(qǐng)使用GPT-4 的API,OpenAI會(huì)邀請(qǐng)部分開發(fā)者體驗(yàn),并逐漸擴(kuò)大邀請(qǐng)范圍。該API的定價(jià)為每輸 入1000個(gè)字符(約合750個(gè)單詞),價(jià)格為0.03美元;GPT-4每生成1000個(gè)字符價(jià)格為 0.06美元。 Office引入GPT-4帶來(lái)的結(jié)果是生產(chǎn)力、創(chuàng)造力的全面躍升。微軟今天宣布,其與 OpenAI共同開發(fā)的聊天機(jī)器人技術(shù)Bing Chat正在GPT-4上運(yùn)行。

Copilot OpenAI發(fā)布升級(jí)后的GPT-4后,微軟重磅發(fā)布了GPT-4平臺(tái)支持的新AI功能, Microsoft 365 Copilot,并將其嵌入Word、PowerPoint、Excel、Teams等Office辦 公軟件中。Copilot可以在一篇速記的基礎(chǔ)上快速生成新聞草稿、并完成草稿潤(rùn)色; 在Excel中完成各種求和、求平均數(shù),做表格、歸納數(shù)據(jù)、甚至是完成總結(jié)提取;在 PPT上可以直接將文稿內(nèi)容一鍵生成;在Outlook郵件中自動(dòng)生成內(nèi)容、并自由調(diào)整 寫作風(fēng)格、插入圖表;在Teams中總結(jié)視頻會(huì)議的要點(diǎn)/每個(gè)發(fā)言人誰(shuí)說(shuō)了核心內(nèi)容, 跟進(jìn)會(huì)議流程和內(nèi)容,自動(dòng)生成會(huì)議紀(jì)要、要點(diǎn)和任務(wù)模板。基于GPT-4的Copilot 可以看作是一個(gè)辦公AI助理,充分發(fā)揮出了AI對(duì)于辦公場(chǎng)景的賦能作用,有望從根 本上改變工作模式并開啟新一輪生產(chǎn)力增長(zhǎng)浪潮。

二、GPT-4帶動(dòng)多模態(tài)x多場(chǎng)景落地,AIGC藍(lán)海市場(chǎng)打開

(一)歷經(jīng)三階段發(fā)展,AIGC技術(shù)升級(jí)步入深化階段

AIGC全程為AI-Generated Content,人工智能生成內(nèi)容,是繼專業(yè)生成內(nèi)容(PGC, Professional Generate Content)和用戶生成內(nèi)容(UGC,User Generate Content) 之后,利用AI自動(dòng)生成內(nèi)容的新型生產(chǎn)方式。傳統(tǒng)AI大多屬于分析式AI,對(duì)已有數(shù) 據(jù)進(jìn)行分析并應(yīng)用于相應(yīng)領(lǐng)域。以AIGC為典型的生成式AI不在局限于分析固有數(shù)據(jù), 而是基于訓(xùn)練數(shù)據(jù)和算法模型自主生成創(chuàng)造新的文本、3D、視頻等各種形式的內(nèi)容。

歷經(jīng)三階段迭代,AIGC現(xiàn)已進(jìn)入快速發(fā)展階段: (1)早期萌芽階段(1950s-1990s),受限于科技水平及高昂的系統(tǒng)成本,AIGC 僅限于小范圍實(shí)驗(yàn)。 (2)沉淀積累階段(1990s-2010s),AIGC開始從實(shí)驗(yàn)性向?qū)嵱眯灾饾u轉(zhuǎn)變。但 由于其受限于算法瓶頸,完成創(chuàng)作能力有限,應(yīng)用領(lǐng)域仍具有局限性; (3)快速發(fā)展階段(2010s-至今),GAN(Generative Adversarial Network,生成 式對(duì)抗網(wǎng)絡(luò))等深度學(xué)習(xí)算法的提出和不斷迭代推動(dòng)了AIGC技術(shù)的快速發(fā)展,生成 內(nèi)容更加多元化。

AIGC可分為智能數(shù)字內(nèi)容孿生、智能數(shù)字內(nèi)容編輯及智能數(shù)字內(nèi)容創(chuàng)作三大層次。 生成式AI是指利用現(xiàn)有文本、音頻文件或圖像創(chuàng)建新內(nèi)容的人工智能技術(shù),其起源 于分析式AI,在分析式AI總結(jié)歸納數(shù)據(jù)知識(shí)的基礎(chǔ)上學(xué)習(xí)數(shù)據(jù)產(chǎn)生模式,創(chuàng)造出新 的樣本內(nèi)容。在分析式AI的技術(shù)基礎(chǔ)上,GAN、Transformer網(wǎng)絡(luò)等多款生成式AI 技術(shù)催生出許多AIGC產(chǎn)品,如DALL-E、OpenAI系列等,它們?cè)谝纛l、文本、視覺 上有眾多技術(shù)應(yīng)用,并在創(chuàng)作內(nèi)容的方式上變革演化出三大前沿能力。AIGC根據(jù)面 向?qū)ο蟆?shí)現(xiàn)功能的不同可以分為智能數(shù)字內(nèi)容孿生、智能數(shù)字內(nèi)容編輯及智能數(shù) 字內(nèi)容創(chuàng)作三大層次。

(二)生成算法+預(yù)訓(xùn)練模型+多模態(tài)推動(dòng)AIGC的爆發(fā)

AIGC的爆發(fā)離不開其背后的深度學(xué)習(xí)模型的技術(shù)加持,生成算法、預(yù)訓(xùn)練和多模態(tài) 技術(shù)的不斷發(fā)展幫助了AIGC模型具備通用性強(qiáng)、參數(shù)海量、多模態(tài)和生成內(nèi)容高質(zhì) 量的特質(zhì),讓AIGC實(shí)現(xiàn)從技術(shù)提升到技術(shù)突破的轉(zhuǎn)變。 (1)生成算法模型不斷迭代創(chuàng)新,為AIGC的發(fā)展奠定基礎(chǔ)。早期人工智能算法學(xué) 習(xí)能力不強(qiáng),AIGC技術(shù)主要依賴于事先指定的統(tǒng)計(jì)模型或任務(wù)來(lái)完成簡(jiǎn)單的內(nèi)容生 成和輸出,對(duì)客觀世界和人類語(yǔ)言文字的感知能力較弱,生成內(nèi)容刻板且具有局限 性。GAN(Generative Adversarial Network,生成式對(duì)抗網(wǎng)絡(luò))的提出讓AIGC發(fā)展 進(jìn)入新階段,GAN是早期的生成模型,利用博弈框架產(chǎn)生輸出,被廣泛應(yīng)用于生成 圖像、視頻語(yǔ)音等領(lǐng)域。隨后Transformer、擴(kuò)散模型、深度學(xué)習(xí)算法模型相繼涌現(xiàn)。

Transformer被廣泛應(yīng)用于NLP、CV等領(lǐng)域,GPT-3、LaMDA等預(yù)訓(xùn)練模型大多是 基于transformer架構(gòu)構(gòu)建的。ChatGPT是基于Transformer架構(gòu)上的語(yǔ)言模型, Transformer負(fù)責(zé)調(diào)度架構(gòu)和運(yùn)算邏輯,進(jìn)而實(shí)現(xiàn)最終計(jì)算。Tansformer是谷歌于 2017年《Attention is All You Need》提出的一種深度學(xué)習(xí)模型架構(gòu),其完全基于注 意力機(jī)制,可以按照輸入數(shù)據(jù)各部分重要性來(lái)分配不同的權(quán)重,無(wú)需重復(fù)和卷積。 相較于循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)流水線式的序列計(jì)算,Transformer可以一次處理所有 的輸入,擺脫了人工標(biāo)注數(shù)據(jù)集的缺陷,實(shí)現(xiàn)了大規(guī)模的并行計(jì)算,模型所需的訓(xùn) 練時(shí)間明顯減少,大規(guī)模的AI模型質(zhì)量更優(yōu)。

Transformer的核心構(gòu)成是編碼模塊和解碼模塊。GPT使用的是解碼模塊,通過模 塊間彼此大量堆疊的方式形成了GPT模型的底層架構(gòu),模塊分為前饋神經(jīng)網(wǎng)絡(luò)層、 編解碼自注意力機(jī)制層(Self-Attention)、自注意力機(jī)制掩碼層。自注意力機(jī)制層 負(fù)責(zé)計(jì)算數(shù)據(jù)在全部?jī)?nèi)容的權(quán)重(即Attention),掩碼層幫助模型屏蔽計(jì)算位置右 側(cè)未出現(xiàn)的數(shù)據(jù),最后把輸出的向量結(jié)果輸入前饋神經(jīng)網(wǎng)絡(luò),完成模型參數(shù)計(jì)算。

(2)預(yù)訓(xùn)練模型引發(fā)AIGC技術(shù)能力的質(zhì)變。AI預(yù)訓(xùn)練模型是基于大規(guī)模寬泛的數(shù) 據(jù)進(jìn)行訓(xùn)練后擁有適應(yīng)廣泛下游任務(wù)能力的模型,預(yù)訓(xùn)練屬于遷移學(xué)習(xí)的領(lǐng)域,其 主旨是使用標(biāo)注數(shù)據(jù)前,充分利用大量無(wú)標(biāo)注數(shù)據(jù)進(jìn)行訓(xùn)練,模型從中全面學(xué)習(xí)到 與標(biāo)注無(wú)關(guān)的潛在知識(shí),進(jìn)而使模型靈活變通的完成下游任務(wù)。視覺大模型提升 AIGC感知能力,語(yǔ)言大模型增強(qiáng)AIGC認(rèn)知能力。

NLP模型是一種使用自然語(yǔ)言處理(Natural Language Processing,NLP)技術(shù)來(lái)解決自然語(yǔ)言相關(guān)問題的機(jī)器學(xué)習(xí)模型。在NLP領(lǐng)域,AI大模型可適用于人機(jī)語(yǔ)言交互,并進(jìn)行自然語(yǔ)言處理從實(shí)現(xiàn)相應(yīng)的文本分類、文本生成、語(yǔ)音識(shí)別、序列標(biāo)注、機(jī)器翻譯等功能。NLP的研究經(jīng)過了以規(guī)則為基礎(chǔ)的研究方法和以統(tǒng)計(jì)為基礎(chǔ)的研究方法的發(fā)展,目前以基于Transformer的預(yù)訓(xùn)練模型已成為當(dāng)前NLP領(lǐng)域的研究熱點(diǎn),BERT、GPT等模型均采用這一方法。CV模型指計(jì)算機(jī)視覺模型,是一種基于圖像或視頻數(shù)據(jù)的人工智能模型。常見的CV 模型有采用深度學(xué)習(xí)的卷積神經(jīng)網(wǎng)絡(luò)(CNN)和生成對(duì)抗網(wǎng)絡(luò)(GAN)。

近年來(lái)以 視覺Transformer(ViT)為典型的新型神經(jīng)網(wǎng)絡(luò),通過人類先驗(yàn)知識(shí)引入網(wǎng)絡(luò)設(shè)計(jì), 使得模型的收斂速度、泛化能力、擴(kuò)展性及并行性得到飛速提升,通過無(wú)監(jiān)督預(yù)訓(xùn) 練和微調(diào)學(xué)習(xí),在多個(gè)計(jì)算機(jī)視覺任務(wù),如圖像分類、目標(biāo)檢測(cè)、物體識(shí)別、圖像 生成等取得顯著的進(jìn)步。

(3)多模態(tài)技術(shù)拓寬了AIGC技術(shù)的應(yīng)用廣度。多模態(tài)技術(shù)將不同模態(tài)(圖像、聲 音、語(yǔ)言等)融合在預(yù)訓(xùn)練模型中,使得預(yù)訓(xùn)練模型從單一的NLP、CV發(fā)展成音視 頻、語(yǔ)言文字、文本圖像等多模態(tài)、跨模態(tài)模型。多模態(tài)大模型通過尋找模態(tài)數(shù)據(jù) 之間的關(guān)聯(lián)點(diǎn),將不同模態(tài)的原始數(shù)據(jù)投射在相似的空間中,讓模態(tài)之間的信號(hào)相 互理解,進(jìn)而實(shí)現(xiàn)模態(tài)數(shù)據(jù)之間的轉(zhuǎn)化和生成。這一技術(shù)對(duì)AIGC的原創(chuàng)生成能力的 發(fā)展起到了重要的支持作用,2021年OpenAI推出AI繪畫產(chǎn)品DALL.E可通過輸入文 字理解生成符合語(yǔ)義且獨(dú)一無(wú)二的繪畫作品,其背后離不開多模態(tài)技術(shù)的支持。

(三)多模態(tài)x多場(chǎng)景落地,AIGC爆發(fā)商業(yè)潛力

ChatGPT的廣泛應(yīng)用意味著AIGC規(guī)模化、商業(yè)化的開始。ChatGPT是文字語(yǔ)言模 態(tài)AIGC的具體應(yīng)用,在技術(shù)、應(yīng)用領(lǐng)域和商業(yè)化方面和傳統(tǒng)AI產(chǎn)品均有所不同。 ChatGPT已經(jīng)具備了一定的對(duì)現(xiàn)實(shí)世界內(nèi)容進(jìn)行語(yǔ)義理解和屬性操控的能力,并可 以對(duì)其回以相應(yīng)的反饋。ChatGPT是AIGC重要的產(chǎn)品化應(yīng)用,意味著AIGC規(guī)模化、 商業(yè)化的開始。創(chuàng)新工場(chǎng)董事長(zhǎng)兼CEO李開復(fù)博士在3月14日表示,ChatGPT快速 普及將進(jìn)一步引爆AI 2.0商業(yè)化。AI 2.0 是絕對(duì)不能錯(cuò)過的一次革命。

多家公司正加緊研發(fā)ChatGPT類似產(chǎn)品,引爆新一輪科技企業(yè)AI軍備競(jìng)賽。在GPT4 推出之后,Google開放自家的大語(yǔ)言模型API「PaLM API」,此外還發(fā)布了一款幫 助開發(fā)者快速構(gòu)建AI程序的工具 MakerSuite。2月底,META公布一款全新的AI大型 語(yǔ)言模型LLaMA,宣稱可幫助研究人員降低生成式AI工具可能帶來(lái)的“偏見、有毒 評(píng)論、產(chǎn)生錯(cuò)誤信息的可能性”等問題。 AIGC的應(yīng)用領(lǐng)域分為視頻、音頻、文本、圖像、跨模態(tài)生成五個(gè)部分。

AIGC以其 真實(shí)性、多樣性、可控性、組合性的特質(zhì),為各行業(yè)、各領(lǐng)域提供了更加豐富多元、 動(dòng)態(tài)且可交互的內(nèi)容。根據(jù)AIGC生成內(nèi)容的模態(tài)不同,可將AIGC的應(yīng)用領(lǐng)域分為 視頻、音頻、文本、圖像、跨模態(tài)生成五個(gè)部分。其中,在圖像、文本、音頻等領(lǐng) 域,AIGC已經(jīng)得到了較大優(yōu)化,生成內(nèi)容質(zhì)量得到明顯提升;而在視頻與跨模態(tài)內(nèi) 容生成方面,AIGC擁有巨大發(fā)展?jié)摿Α?/p>

三、高算力需求帶動(dòng)基礎(chǔ)設(shè)施迭代加速

(一)AI大模型驅(qū)動(dòng)高算力需求

數(shù)據(jù)、算力及模型是人工智能發(fā)展的三要素。以GPT系列為例: (1)數(shù)據(jù)端:自O(shè)penAI于2018年發(fā)布GPT-1,到2020年的GPT-3,GPT模型參數(shù) 數(shù)量和訓(xùn)練數(shù)據(jù)量實(shí)現(xiàn)指數(shù)型增長(zhǎng)。參數(shù)數(shù)量從GPT-1的1.17億增長(zhǎng)到GPT-3的 1750億,訓(xùn)練數(shù)據(jù)量從5GB增長(zhǎng)到的45TB; (2)模型端:ChatGPT在以往模型的基礎(chǔ)上,在語(yǔ)料庫(kù)、計(jì)算能力、預(yù)訓(xùn)練、自我 學(xué)習(xí)能力等方面有了明顯提升,同時(shí)Transformer架構(gòu)突破了人工標(biāo)注數(shù)據(jù)集的不足, 實(shí)現(xiàn)與人類更順暢的交流; (3)算力端:根據(jù)OpenAl發(fā)布的《Language Models are Few-Shot Learners》, 訓(xùn)練13億參數(shù)的GPT-3 XL模型訓(xùn)練一次消耗的算力約為27.5 PFlop/s-dav,訓(xùn)練 1750億參數(shù)的完整GPT-3模型則會(huì)消耗算力3640 PFlop/s-dav(以一萬(wàn)億次每秒速 度計(jì)算,需要3640天完成)。

在人工智能發(fā)展的三要素中,數(shù)據(jù)與算法都離不開算力的支撐。隨著AI算法突飛猛 進(jìn)的發(fā)展,越來(lái)越多的模型訓(xùn)練需要巨量算力支撐才能快速有效實(shí)施,同時(shí)數(shù)據(jù)量 的不斷增加也要求算力配套進(jìn)化。如此看來(lái),算力成為AI突破的關(guān)鍵因素。 AI大模型的算力需求主要來(lái)自于預(yù)訓(xùn)練、日常運(yùn)營(yíng)和模型微調(diào)。 (1)預(yù)訓(xùn)練:在完成完整訓(xùn)練之前,搭建一個(gè)網(wǎng)絡(luò)模型完成特定任務(wù),在訓(xùn)練網(wǎng)絡(luò) 過程中不斷調(diào)整參數(shù),直至網(wǎng)絡(luò)損失和運(yùn)行性能達(dá)到預(yù)期目標(biāo),此時(shí)可以將訓(xùn)練模 型的參數(shù)保存,用于之后執(zhí)行類似任務(wù)。根據(jù)中國(guó)信通院數(shù)據(jù),ChatGPT基于GPT3.5 系列模型,模型參數(shù)規(guī)模據(jù)推測(cè)達(dá)十億級(jí)別,參照參數(shù)規(guī)模相近的GPT-3 XL模型, 則ChatGPT完整一次預(yù)訓(xùn)練消耗算力約為27.5 PFlop/s-dav。

(2)日常運(yùn)營(yíng):滿足用戶日常使用數(shù)據(jù)處理需求。根據(jù)Similarweb的數(shù)據(jù),23年1月份ChatGPT月活約6.16億,跳出率13.28%每次訪問頁(yè)數(shù)5.85頁(yè),假設(shè)每頁(yè)平均200 token。同時(shí)假設(shè):模型的FLlops利用率為21.3%與訓(xùn)練期間的GPT-3保持一致;完整參數(shù)模型較GPT-3上升至2500億;以FLOPs為指標(biāo),SOTA大型語(yǔ)言在在推理過程中每個(gè)token的計(jì)算成本約為2N。根據(jù)以上數(shù)據(jù)及假設(shè),每月日常運(yùn)營(yíng)消耗算力約為6.16億*2*(1-13.28%)*5.85*200*2500億/21.3%=14672PFlop/s-day。(3)模型微調(diào):執(zhí)行類似任務(wù)時(shí),使用先前保存的模型參數(shù)作為初始化參數(shù),在訓(xùn)練過程中依據(jù)結(jié)果不斷進(jìn)行微調(diào),使之適應(yīng)新的任務(wù)。

ChatGPT引發(fā)新一輪AI算力需求爆發(fā)。根據(jù)OpenAI發(fā)布的《AI and Compute》分 析報(bào)告中指出,自2012年以來(lái),AI訓(xùn)練應(yīng)用的算力需求每3.4個(gè)月就回會(huì)翻倍,從 2012年至今,AI算力增長(zhǎng)超過了30萬(wàn)倍。據(jù)OpenAI報(bào)告,ChatGPT的總算力消耗 約為3640PF-days(即假如每秒計(jì)算一千萬(wàn)億次,需要計(jì)算3640天),需要7-8個(gè)算 力500P的數(shù)據(jù)中心才能支撐運(yùn)行。上海新興信息通信技術(shù)應(yīng)用研究院首席專家賀仁 龍表示,“自2016年阿爾法狗問世,智能算力需求開啟爆發(fā)態(tài)勢(shì)。如今ChatGPT則 代表新一輪AI算力需求的爆發(fā)”。

全球算力規(guī)模將呈現(xiàn)高速增長(zhǎng)態(tài)勢(shì)。根據(jù)國(guó)家數(shù)據(jù)資源調(diào)查報(bào)告數(shù)據(jù),2021年全球 數(shù)據(jù)總產(chǎn)量67ZB,近三年平均增速超過26%,經(jīng)中國(guó)信息通信研究院測(cè)算,2021 年全球計(jì)算設(shè)備算力總規(guī)模達(dá)到615EFlops,增速達(dá)44%。根據(jù)中國(guó)信通院援引的 IDC數(shù)據(jù),2025年全球算力整體規(guī)模將達(dá)3300EFlops,2020-2025年的年均復(fù)合增 長(zhǎng)率達(dá)到50.4%。結(jié)合華為GIV預(yù)測(cè),2030年人類將迎來(lái)YB數(shù)據(jù)時(shí)代,全球算力規(guī) 模達(dá)到56ZFlops,2025-2030年復(fù)合增速達(dá)到76.2%。

(二)云商/運(yùn)營(yíng)商推進(jìn)AI領(lǐng)域算力基礎(chǔ)設(shè)施投入

北美云廠商資本支出向技術(shù)基礎(chǔ)設(shè)施和新數(shù)據(jù)中心架構(gòu)傾斜。22Q4亞馬遜資本支出 主要用于技術(shù)基礎(chǔ)設(shè)施的投資,其中大部分用于支持AWS業(yè)務(wù)增長(zhǎng)與支持履行網(wǎng)絡(luò) 的額外能力。預(yù)計(jì)未來(lái)相關(guān)投資將延續(xù),并增加在技術(shù)基礎(chǔ)設(shè)施方面的支出。谷歌 指引2023年資本開支與2022年基本持平,其中技術(shù)基礎(chǔ)設(shè)施有所增加,而辦公基礎(chǔ) 設(shè)施將減少。Meta2022年資本開支為314.3億美元,同比增長(zhǎng)69.3%,但同時(shí)Meta 略微調(diào)低其2023年資本開支預(yù)期至300-330億美元(此前預(yù)期為340-370億美元), 主要原因系減少數(shù)據(jù)中心建設(shè)的相關(guān)支出,轉(zhuǎn)向新的更具成本效益的、同時(shí)支持AI 和非AI工作量的數(shù)據(jù)中心新架構(gòu)。

國(guó)內(nèi)三大運(yùn)營(yíng)商積極布局算力網(wǎng)絡(luò),資本支出向新興業(yè)務(wù)傾斜。電信運(yùn)營(yíng)商作為數(shù) 字基座打造者,運(yùn)營(yíng)商數(shù)字業(yè)務(wù)板塊成為收入增長(zhǎng)的主要引擎,近幾年資本支出由 主干網(wǎng)絡(luò)向新興業(yè)務(wù)傾斜。中國(guó)移動(dòng)計(jì)劃2022年全年算力網(wǎng)絡(luò)投資480億元,占其 總資本開支的39.0%。2022Q3,中國(guó)移動(dòng)算力規(guī)模達(dá)到7.3EFLOPS,并計(jì)劃在2025 年底達(dá)到20EFLOPS以上。中國(guó)電信產(chǎn)業(yè)數(shù)字化資本開支占比同比上升9.3pc,算力 總規(guī)模計(jì)劃由2022年中的3.1EFLOPS提升至2025年底的16.3EFLOPS。中國(guó)聯(lián)通 2022年預(yù)計(jì)算力網(wǎng)絡(luò)資本開支達(dá)到145億,同比提升43%,云投資預(yù)計(jì)提升88%。

作為算力基礎(chǔ)設(shè)施建設(shè)的主力軍,三大運(yùn)營(yíng)商目前已經(jīng)進(jìn)行前瞻性的基礎(chǔ)設(shè)施布局。 通信運(yùn)營(yíng)商自身?yè)碛袃?yōu)質(zhì)網(wǎng)絡(luò)、算力、云服務(wù)能力的通信運(yùn)營(yíng)商,同時(shí)具備天然的 產(chǎn)業(yè)鏈優(yōu)勢(shì),依靠5G+AI技術(shù)優(yōu)勢(shì),為下游客戶提供AI服務(wù)能力,是新型信息服務(wù) 體系中重要的一環(huán),助力千行百業(yè)數(shù)字化轉(zhuǎn)型。在移動(dòng)網(wǎng)絡(luò)方面,中國(guó)運(yùn)營(yíng)商已建 設(shè)覆蓋全國(guó)的高性能高可靠4/5G網(wǎng)絡(luò);在固定寬帶方面,光纖接入(FTTH/O)端 口達(dá)到10.25億個(gè),占比提升至95.7%;在算力網(wǎng)絡(luò)方面,運(yùn)營(yíng)商在資本開支結(jié)構(gòu)上 向算力網(wǎng)絡(luò)傾斜,提升服務(wù)全國(guó)算力網(wǎng)絡(luò)能力。在AI服務(wù)能力方面,加快AI領(lǐng)域商 業(yè)化應(yīng)用推出,發(fā)揮自身產(chǎn)業(yè)鏈優(yōu)勢(shì),助力千行百業(yè)數(shù)字化轉(zhuǎn)型。

(三)算力需求帶動(dòng)數(shù)據(jù)中心架構(gòu)及技術(shù)加速升級(jí)

1、數(shù)據(jù)中心呈現(xiàn)超大規(guī)模發(fā)展趨勢(shì)。超大規(guī)模數(shù)據(jù)中心,即Hyperscale Data Center,與傳統(tǒng)數(shù)據(jù)中心的核心區(qū)別在于 超大規(guī)模數(shù)據(jù)中心具備更強(qiáng)大的可擴(kuò)展性及計(jì)算能力。1)規(guī)模上,超級(jí)數(shù)據(jù)中心可 容納的規(guī)模要比傳統(tǒng)數(shù)據(jù)中心大得多,可以容納數(shù)百萬(wàn)臺(tái)服務(wù)器和更多的虛擬機(jī);2) 性能上,超級(jí)數(shù)據(jù)中心具有更高的可擴(kuò)展性和計(jì)算能力,能夠滿足數(shù)據(jù)處理數(shù)量和 速率大幅提升的需求。

具體來(lái)講,相較于傳統(tǒng)數(shù)據(jù)中心,超大規(guī)模數(shù)據(jù)中心的優(yōu)勢(shì)在于: (1)可擴(kuò)展性:超大規(guī)模數(shù)據(jù)中心的網(wǎng)絡(luò)基礎(chǔ)架構(gòu)響應(yīng)更迅速、擴(kuò)展更高效且更具 成本效益,并且提供快速擴(kuò)展存儲(chǔ)和計(jì)算資源以滿足需求的能力,超大規(guī)模數(shù)據(jù)中 心通過在負(fù)載均衡器后水平擴(kuò)展,快速旋轉(zhuǎn)或重新分配額外資源并將其添加到現(xiàn)有 集群,可以實(shí)現(xiàn)快速向集群添加額外資源,從而在不中斷操作的情況下進(jìn)行擴(kuò)展; (2)定制化:超大規(guī)模數(shù)據(jù)中心采用更新的服務(wù)器設(shè)計(jì),具有更寬的機(jī)架,可以容 納更多組件并且允許定制化設(shè)計(jì)服務(wù)器,使得服務(wù)器能夠同時(shí)接入多個(gè)電源和硬盤 驅(qū)動(dòng)器;

(3)自動(dòng)化服務(wù):超大規(guī)模數(shù)據(jù)中心提供自動(dòng)化服務(wù),幫助客戶管理高流量網(wǎng)站和 需要專門處理的高級(jí)工作負(fù)載,例如密碼學(xué)、基因處理和三維渲染; (4)冷卻效率更高:超大規(guī)模數(shù)據(jù)中心對(duì)其電源架構(gòu)進(jìn)行了優(yōu)化,并將冷卻能力集 中在托管高強(qiáng)度工作負(fù)載的服務(wù)器,大大降低了成本和對(duì)環(huán)境的影響,電源使用效 率和冷卻效率遠(yuǎn)高于傳統(tǒng)數(shù)據(jù)中心;

(5)工作負(fù)載更平衡:超大規(guī)模數(shù)據(jù)中心有效地將工作負(fù)載分布在多臺(tái)服務(wù)器上, 從而避免單臺(tái)服務(wù)器過熱。避免了過熱的服務(wù)器損壞附近的服務(wù)器,從而產(chǎn)生不必 要的連鎖反應(yīng)。 Statista數(shù)據(jù)顯示,全球超大規(guī)模數(shù)據(jù)中心的數(shù)量從2015年的259個(gè),提升到2021年 的700個(gè)。根據(jù)PrecedenceResearch的報(bào)告顯示,全球超大規(guī)模數(shù)據(jù)中心市場(chǎng)規(guī)模 在2021年為620億美元,到2030年將達(dá)到5930億美元,預(yù)計(jì)在2022-2030年間以 28.52%的復(fù)合增長(zhǎng)率(CAGR)增長(zhǎng)。

海內(nèi)外云商均具備自己的超大規(guī)模數(shù)據(jù)中心。Structure Research在其報(bào)告中估計(jì), 到2022年全球超大規(guī)模自建數(shù)據(jù)中心總?cè)萘繉⑦_(dá)到13177兆瓦(MW)。全球四大 超大規(guī)模數(shù)據(jù)中心平臺(tái)——AWS、谷歌云、Meta和微軟Azure——約占該容量的78%。 全球占主導(dǎo)地位的超大規(guī)模數(shù)據(jù)中心企業(yè)仍然是亞馬遜、谷歌、Meta和微軟,在中 國(guó),本土企業(yè)阿里巴巴、華為、百度、騰訊和金山云都是領(lǐng)先的超大規(guī)模數(shù)據(jù)中心 企業(yè)。

2、IB網(wǎng)絡(luò)技術(shù)將更廣泛應(yīng)用于AI訓(xùn)練超算領(lǐng)域。超級(jí)數(shù)據(jù)中心是具有更大規(guī)模和更高計(jì)算能力的數(shù)據(jù)中心。隨著對(duì)數(shù)據(jù)處理數(shù)量和 速率需求的提升,數(shù)據(jù)中心的可擴(kuò)展性需求也在迅速提升。超級(jí)數(shù)據(jù)中心在規(guī)模和 性能上較傳統(tǒng)數(shù)據(jù)中心都有了大幅升級(jí),能夠滿足超高速度擴(kuò)展以滿足超級(jí)需求的 能力。

泛AI應(yīng)用是超算中心的重要下游。自20世紀(jì)80年代以來(lái),超級(jí)計(jì)算主要服務(wù)于科研 領(lǐng)域。傳統(tǒng)超算基本上都是以國(guó)家科研機(jī)構(gòu)為主體的超算中心,如氣象預(yù)測(cè)、地震 預(yù)測(cè)、航空航天、石油勘探等。截止2022年底,國(guó)內(nèi)已建成10家國(guó)家超級(jí)計(jì)算中心, 不少省份都建立起省級(jí)超算中心,服務(wù)于當(dāng)?shù)氐闹锌圃骸庀缶忠约暗卣鸨P汀?一方面,行業(yè)頭部企業(yè)將超算應(yīng)用于芯片設(shè)計(jì)、生物醫(yī)療、材料測(cè)試等工業(yè)應(yīng)用場(chǎng) 景;另一方面,自動(dòng)駕駛訓(xùn)練、大語(yǔ)言模型訓(xùn)練、類ChatGPT等AI訓(xùn)練的需求,也 推動(dòng)超算應(yīng)用場(chǎng)景延伸至圖像識(shí)別、視頻識(shí)別定位、智能駕駛場(chǎng)景模擬以及對(duì)話和 客服系統(tǒng)等,成為超算中心的重要下游。

超級(jí)數(shù)據(jù)中心成為算力儲(chǔ)備的重要方向,中美加速算力基建布局。憑借其在算力能 力及能耗效率的巨大提升,超級(jí)數(shù)據(jù)中心在算力儲(chǔ)備中的地位日漸凸顯。根據(jù) Synergy Research Group數(shù)據(jù),全球超級(jí)數(shù)據(jù)中心數(shù)量從2017年的390個(gè)增長(zhǎng)至 2021年二季度的659個(gè),增長(zhǎng)近一倍,預(yù)計(jì)2024年總數(shù)將超1000個(gè)。份額方面,中 美持續(xù)加強(qiáng)超級(jí)數(shù)據(jù)中心的布局,占全球市場(chǎng)份額持續(xù)提升。

InfiniBand網(wǎng)絡(luò)滿足大帶寬和低時(shí)延的需求,成為超算中心的主流。InfiniBand(簡(jiǎn) 稱IB)是一個(gè)用于高性能計(jì)算的計(jì)算機(jī)網(wǎng)絡(luò)通信標(biāo)準(zhǔn),主要應(yīng)用于大型或超大型數(shù) 據(jù)中心。IB網(wǎng)絡(luò)的主要目標(biāo)是實(shí)現(xiàn)高的可靠性、可用性、可擴(kuò)展性及高性能,且能 在單個(gè)或多個(gè)互聯(lián)網(wǎng)絡(luò)中支持冗余的I/O通道,因此能夠保持?jǐn)?shù)據(jù)中心在局部故障時(shí) 仍能運(yùn)轉(zhuǎn)。相比傳統(tǒng)的以太網(wǎng)絡(luò),帶寬及時(shí)延都有非常明顯的優(yōu)勢(shì)。(一般InfiniBand 的網(wǎng)卡收發(fā)時(shí)延在600ns,而以太網(wǎng)上的收發(fā)時(shí)延在10us左右,英偉達(dá)推出的 MetroX-3提升長(zhǎng)距離InfiniBand系統(tǒng)帶寬至400G)。作為未來(lái)算力的基本單元,高 性能的數(shù)據(jù)中心越來(lái)越多的采用InfiniBand網(wǎng)絡(luò)方案,尤其在超算中心應(yīng)用最為廣 泛,成為AI訓(xùn)練網(wǎng)絡(luò)的主流。

(四)細(xì)分受益環(huán)節(jié)

GPT-4多模態(tài)大模型將引領(lǐng)新一輪AI算力需求的爆發(fā),超大規(guī)模數(shù)據(jù)中心及超算數(shù) 據(jù)中心作為泛AI領(lǐng)域的重要基礎(chǔ)設(shè)施支持,其數(shù)量、規(guī)模都將相應(yīng)增長(zhǎng),帶動(dòng)整個(gè) 算力基礎(chǔ)設(shè)施產(chǎn)業(yè)鏈(如高端服務(wù)器/交換機(jī)、CPO技術(shù)、硅光、液冷技術(shù))的滲透 加速。同時(shí)在應(yīng)用側(cè),Copilot的推出加速AI在辦公領(lǐng)域的賦能,看好辦公場(chǎng)景硬件 配套廠商機(jī)會(huì)。

1、服務(wù)器/交換機(jī): AIGC帶動(dòng)算力爆發(fā)式增長(zhǎng),全球進(jìn)入以數(shù)據(jù)為關(guān)鍵生產(chǎn)要素的數(shù)字經(jīng)濟(jì)時(shí)代。從國(guó) 內(nèi)三大運(yùn)營(yíng)商資本支出結(jié)構(gòu)上看,加碼算力基礎(chǔ)設(shè)施投資成重要趨勢(shì)。重點(diǎn)推薦: 中興通訊。公司作為運(yùn)營(yíng)商板塊算力投資的核心受益標(biāo)的,持續(xù)在服務(wù)器及存儲(chǔ)、 交換機(jī)/路由器、數(shù)據(jù)中心等算力基礎(chǔ)設(shè)施領(lǐng)域加強(qiáng)布局,將作為數(shù)字經(jīng)濟(jì)筑路者充 分受益我國(guó)數(shù)字經(jīng)濟(jì)建設(shè)。

算力需求帶動(dòng)上游硬件設(shè)備市場(chǎng)規(guī)模持續(xù)增長(zhǎng),高規(guī)格產(chǎn)品占比提升。伴隨著數(shù)據(jù) 流量持續(xù)提升,交換機(jī)作為數(shù)據(jù)中心必要設(shè)備,預(yù)計(jì)全球數(shù)據(jù)中心交換機(jī)保持穩(wěn)定 增長(zhǎng)。2021年全球數(shù)據(jù)中心交換機(jī)市場(chǎng)規(guī)模為138億美元,預(yù)計(jì)到2031年將達(dá)246 億美元,2022年至2031年復(fù)合年增長(zhǎng)率為5.9%。多元開放的AI服務(wù)器架構(gòu)為可以人 工智能發(fā)展提供更高的性能和可擴(kuò)展性的AI算力支撐,隨著AI應(yīng)用的發(fā)展,高性能 服務(wù)器數(shù)量有望隨之增長(zhǎng),帶動(dòng)出貨量及服務(wù)器單價(jià)相應(yīng)提升。根據(jù)IDC報(bào)告, 2022Q3,200/400GbE交換機(jī)市場(chǎng)收入環(huán)比增長(zhǎng)25.2%,100GbE交換機(jī)收入同比增 長(zhǎng)19.8%,高速部分呈現(xiàn)快速增長(zhǎng)。

2、光模塊/光芯片: 算力需求提升推動(dòng)算力基礎(chǔ)設(shè)施升級(jí)迭代,傳統(tǒng)可插拔光模塊技術(shù)弊端和瓶頸開始 顯現(xiàn)。(1)功耗過高,AI技術(shù)的加速落地,使得數(shù)據(jù)中心面臨更大的算力和網(wǎng)絡(luò)流 量壓力,交換機(jī)、光模塊等網(wǎng)絡(luò)設(shè)備升級(jí)的同時(shí),功耗增長(zhǎng)過快。以博通交換機(jī)芯 片為例,2010年到2022年交換機(jī)芯片速率從640G提升到51.2T,光模塊速率從10G 迭代到800G。速率提升的同時(shí),交換機(jī)芯片功耗提升了約8倍,光模塊功耗提升了 26倍,SerDes功耗提升了25倍。(2)交換機(jī)端口密度難以繼續(xù)提升,光模塊速率 提升的同時(shí),自身體積也在增大,而交換機(jī)光模塊端口數(shù)量有限。(3)PCB材料遭 遇瓶頸,PCB用于傳輸高速電信號(hào),傳統(tǒng)可插拔光模塊信號(hào)傳輸距離長(zhǎng)、傳輸損失 大,更低耗損的可量產(chǎn)PCB材料面臨技術(shù)難題難以攻克。

NPO/CPO技術(shù)有望成為高算力背景下的解決方案。CPO(光電共封裝技術(shù))是一 種新型的高密度光組件技術(shù),將交換芯片和光引擎共同裝配在同一個(gè)Socketed(插 槽)上,形成芯片和模組的共封裝。CPO可以取代傳統(tǒng)的插拔式光模塊技術(shù),將硅 光電組件與電子晶片封裝相結(jié)合,從而使引擎盡量靠近ASIC,降低SerDes的驅(qū)動(dòng)功 耗成本,減少高速電通道損耗和阻抗不連續(xù)性,實(shí)現(xiàn)更高密度的高速端口,提升帶 寬密度,大幅減少功耗。

CPO技術(shù)的特點(diǎn)主要有:(1)CPO技術(shù)縮短了交換芯片和光引擎之間的距離(控制在5~7cm),使得高速電信號(hào)在兩者之間實(shí)現(xiàn)高質(zhì)量傳 輸,滿足系統(tǒng)的誤碼率(BER)要求;(2)CPO用光纖配線架取代更大體積的可 插拔模塊,系統(tǒng)集成度得到提升,實(shí)現(xiàn)更高密度的高速端口,提升整機(jī)的帶寬密度; (3)降低功耗,根據(jù)銳捷網(wǎng)絡(luò)招股說(shuō)明書,采用CPO技術(shù)的設(shè)備整機(jī)相比于采用可 插拔光模塊技術(shù)的設(shè)備,整機(jī)功耗降低23%。

高算力背景下,數(shù)據(jù)中心網(wǎng)絡(luò)架構(gòu)升級(jí)帶動(dòng)光模塊用量擴(kuò)張及向更高速率的迭代。 硅光、相干及光電共封裝技術(shù)(CPO)等具備高成本效益、高能效、低能耗的特點(diǎn), 被認(rèn)為是高算力背景下的解決方案。CPO將硅光電組件與電子晶片封裝相結(jié)合,使 引擎盡量靠近ASIC,減少高速電通道損耗,實(shí)現(xiàn)遠(yuǎn)距離傳送。目前,頭部網(wǎng)絡(luò)設(shè)備 和芯片廠商已開始布局硅光、CPO相關(guān)技術(shù)與產(chǎn)品。

3、數(shù)據(jù)中心: IDC數(shù)據(jù)中心:“東數(shù)西算”工程正式全面啟動(dòng)一周年,從系統(tǒng)布局進(jìn)入全面建設(shè)階 段。隨著全國(guó)一體化算力網(wǎng)絡(luò)國(guó)家樞紐節(jié)點(diǎn)的部署和“東數(shù)西算”工程的推進(jìn),算 力集聚效應(yīng)初步顯現(xiàn),算力向規(guī)模化集約化方向加速升級(jí),同時(shí)數(shù)據(jù)中心集中東部 的局得到改善,西部地區(qū)對(duì)東部地區(qū)數(shù)據(jù)計(jì)算需求的支撐作用越發(fā)明顯。我們認(rèn)為 政策面推動(dòng)供給側(cè)不斷出清,AI等應(yīng)用將帶動(dòng)新一輪流量需求,有望打破數(shù)據(jù)中心 近兩年供給過剩的局面,帶動(dòng)數(shù)據(jù)中心長(zhǎng)期發(fā)展。

液冷溫控:隨云計(jì)算、AI、超算等應(yīng)用發(fā)展,數(shù)據(jù)中心機(jī)柜平均功率密度數(shù)預(yù)計(jì)將 逐年提升,高密度服務(wù)器也將被更廣泛的應(yīng)用于數(shù)據(jù)中心中。數(shù)據(jù)中心液冷技術(shù)能 夠穩(wěn)定CPU溫度、保障CPU在一定范圍內(nèi)進(jìn)行超頻工作不會(huì)出現(xiàn)過熱故障,有效提 升了服務(wù)器的使用效率和穩(wěn)定性,有助于提高數(shù)據(jù)中心單位空間的服務(wù)器密度,大幅 提升數(shù)據(jù)中心運(yùn)算效率,液冷技術(shù)有望在超高算力密度場(chǎng)景下持續(xù)滲透。

4、運(yùn)營(yíng)商: 通信運(yùn)營(yíng)商自身?yè)碛袃?yōu)質(zhì)網(wǎng)絡(luò)、算力、云服務(wù)能力的通信運(yùn)營(yíng)商,同時(shí)具備天然的 產(chǎn)業(yè)鏈優(yōu)勢(shì),依靠5G+AI技術(shù)優(yōu)勢(shì),為下游客戶提供AI服務(wù)能力,是新型信息服務(wù) 體系中重要的一環(huán),助力千行百業(yè)數(shù)字化轉(zhuǎn)型。作為算力基礎(chǔ)設(shè)施建設(shè)的主力軍已 經(jīng)進(jìn)行前瞻性的基礎(chǔ)設(shè)施布局。中國(guó)移動(dòng)打造九天人工智能平臺(tái),推進(jìn)AI商業(yè)化, 賦能中國(guó)移動(dòng)內(nèi)外部數(shù)智化轉(zhuǎn)型;中國(guó)電信全面布局大模型技術(shù),積極探索產(chǎn)業(yè)版 “ChatGPT”的商業(yè)化應(yīng)用;中國(guó)聯(lián)通全力升級(jí)算力網(wǎng)絡(luò),推動(dòng)5G和AI技術(shù)的融合。

5、企業(yè)通信: 3月16日晚微軟正式宣布推出Microsoft 365 Copilot,將大型語(yǔ)言模型(LLMs)的能 力嵌入到Office辦公套件產(chǎn)品中。基于GPT-4的Copilot以其視頻+圖文的多模態(tài)分析 以及更強(qiáng)大生成與理解能力,可更深度、全面發(fā)揮視頻會(huì)議AI助理功能,比如可以確定目標(biāo)捕捉發(fā)言總結(jié)某人談話要點(diǎn)、全面理解會(huì)議主要內(nèi)容并自動(dòng)整理及發(fā)送會(huì) 議紀(jì)要等。隨著Copilot更強(qiáng)大功能對(duì)微軟辦公套件的加持,有望帶動(dòng)Teams需求的 增長(zhǎng),中國(guó)企業(yè)通信終端廠商將作為微軟重要的硬件合作伙伴有望深度受益。

審核編輯 :李倩

-

GPT

+關(guān)注

關(guān)注

0文章

368瀏覽量

15941 -

AI算力

+關(guān)注

關(guān)注

0文章

87瀏覽量

9148 -

OpenAI

+關(guān)注

關(guān)注

9文章

1202瀏覽量

8643

原文標(biāo)題:GPT~4引發(fā)新一輪AI算力需求爆發(fā)

文章出處:【微信號(hào):AIOT大數(shù)據(jù),微信公眾號(hào):AIOT大數(shù)據(jù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

動(dòng)態(tài)IP技術(shù)演進(jìn):從網(wǎng)絡(luò)基石到智能連接時(shí)代的創(chuàng)新引擎

光通信模塊技術(shù)特征與應(yīng)用解析

2025 年串口服務(wù)器品牌解析:技術(shù)演進(jìn)與行業(yè)應(yīng)用指南

和安信可Ai-M61模組對(duì)話?手搓一個(gè)ChatGPT 語(yǔ)音助手 #人工智能 #

深入解析三種鋰電池封裝形狀背后的技術(shù)路線與工藝奧秘

OpenAI免費(fèi)開放ChatGPT搜索功能

OpenAI世界最貴大模型:昂貴背后的技術(shù)突破

怎樣搭建基于 ChatGPT 的聊天系統(tǒng)

ChatGPT 適合哪些行業(yè)

ChatGPT背后的AI背景、技術(shù)門道和商業(yè)應(yīng)用

解析ChatGPT背后的技術(shù)演進(jìn)

解析ChatGPT背后的技術(shù)演進(jìn)

評(píng)論