1. 論文信息

標(biāo)題:Long-Tail Learning via Logit Adjustment

作者:Aditya Krishna Menon, Sadeep Jayasumana, Ankit Singh Rawat, Himanshu Jain, Andreas Veit, Sanjiv Kumar (Google Research)

原文鏈接:https://arxiv.org/abs/2007.07314

代碼鏈接:https://github.com/google-research/google-research/tree/master/logit_adjustment

2. 介紹

在傳統(tǒng)的分類(lèi)和識(shí)別任務(wù)中,訓(xùn)練數(shù)據(jù)的分布往往都受到了人工的均衡,即不同類(lèi)別的樣本數(shù)量無(wú)明顯差異,如最有影響力的ImageNet,每種類(lèi)別的樣本數(shù)量就保持在1300張左右。

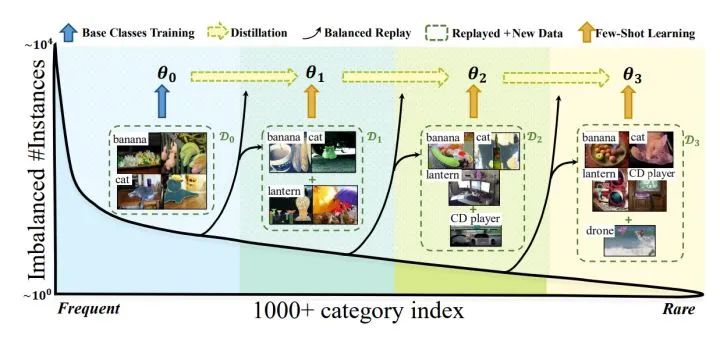

在實(shí)際的視覺(jué)相關(guān)任務(wù)中,數(shù)據(jù)都存在如上圖所示的長(zhǎng)尾分布,少量類(lèi)別占據(jù)了絕大多少樣本,如圖中Head部分,大量的類(lèi)別僅有少量的樣本,如圖中Tail部分。解決長(zhǎng)尾問(wèn)題的方案一般分為4種:

重采樣 (Re-sampling):采樣過(guò)程中采樣不同的策略,如對(duì)tail中的類(lèi)別樣本進(jìn)行過(guò)采樣,或者對(duì)head類(lèi)別樣本進(jìn)行欠采樣。

重加權(quán) (Re-weighting):在訓(xùn)練過(guò)程中給與每種樣本不同的權(quán)重,對(duì)tail類(lèi)別loss設(shè)置更大的權(quán)重,這樣有限樣本數(shù)量。

新的學(xué)習(xí)策略 (Learning strategy):有專(zhuān)門(mén)為解決少樣本問(wèn)題涉及的學(xué)習(xí)方法可以借鑒,如:meta-learning、transfer learning。另外,還可以調(diào)整訓(xùn)練策略,將訓(xùn)練過(guò)程分為兩步:第一步不區(qū)分head樣本和tail樣本,對(duì)模型正常訓(xùn)練;第二步,設(shè)置小的學(xué)習(xí)率,對(duì)第一步的模型使用各種樣本平衡的策略進(jìn)行finetune。

其實(shí)就筆者喜歡的風(fēng)格而言,我對(duì)重加權(quán)這一方向的工作更為喜歡,因?yàn)橥ㄟ^(guò)各種統(tǒng)計(jì)學(xué)上的結(jié)論,來(lái)設(shè)計(jì)很好的loss改進(jìn)來(lái)解決長(zhǎng)尾/不均衡分布問(wèn)題,我喜歡這類(lèi)研究的原因是,他們(大部分)實(shí)現(xiàn)簡(jiǎn)單,往往只需幾行代碼修改下loss,就可以取得非常有競(jìng)爭(zhēng)力的結(jié)果,因?yàn)楹?jiǎn)單所以很容易運(yùn)用到一些復(fù)雜的任務(wù)中。

而從“奧卡姆剃刀”來(lái)看,我覺(jué)得各種遷移模型的理念雖然非常好,從頭部常見(jiàn)類(lèi)中學(xué)習(xí)通用知識(shí),然后遷移到尾部少樣本類(lèi)別中,但是往往會(huì)需要設(shè)計(jì)復(fù)雜的模塊,有增加參數(shù)實(shí)現(xiàn)過(guò)擬合的嫌疑,我認(rèn)為這其實(shí)是把簡(jiǎn)單問(wèn)題復(fù)雜化。我覺(jué)得從統(tǒng)計(jì)方面來(lái)設(shè)計(jì)更加優(yōu)美,因此本文來(lái)介紹一篇我非常喜歡的從統(tǒng)計(jì)角度出發(fā)的工作。這篇論文來(lái)自Google Research,他們提供了一種logit的調(diào)整方法來(lái)應(yīng)對(duì)長(zhǎng)尾分布的問(wèn)題。由于研究風(fēng)格更偏向 machine learning, 所以論文風(fēng)格更偏向統(tǒng)計(jì)類(lèi)。

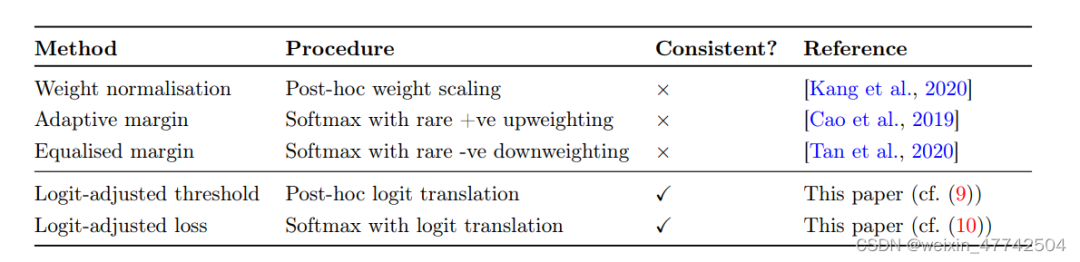

本文首先總結(jié)了對(duì)于logit的調(diào)整方法:

聚焦于測(cè)試階段:對(duì)學(xué)習(xí)完的logit輸出進(jìn)行處理(post-hoc normalization),根據(jù)一些先驗(yàn)假設(shè)進(jìn)行調(diào)整。

聚焦于訓(xùn)練階段:在學(xué)習(xí)中調(diào)整loss函數(shù),相對(duì)平衡數(shù)據(jù)集來(lái)說(shuō),調(diào)整優(yōu)化的方向。

如上圖,這兩種方法都有許多較為優(yōu)秀的工作,但是文中描述了這兩種方法的幾種限制:

weight normalization非常依賴(lài)于weight的模長(zhǎng)會(huì)因?yàn)閏lass的data數(shù)量稀少而變小,然而這種假設(shè)非常依賴(lài)于優(yōu)化器的選擇

直接修改loss進(jìn)行重加權(quán),也會(huì)影響模型的表征學(xué)習(xí),從而導(dǎo)致優(yōu)化過(guò)程不穩(wěn)定,同時(shí)模型可能對(duì)尾部類(lèi)過(guò)擬合,傷害了模型表征學(xué)習(xí)能力。

論文的motivation就是克服這些缺點(diǎn),讓不同類(lèi)(head and tail classed)之間的logit能有一個(gè)相對(duì)較大的margin,設(shè)以一個(gè)consistent的loss,來(lái)讓模型的性能更好。

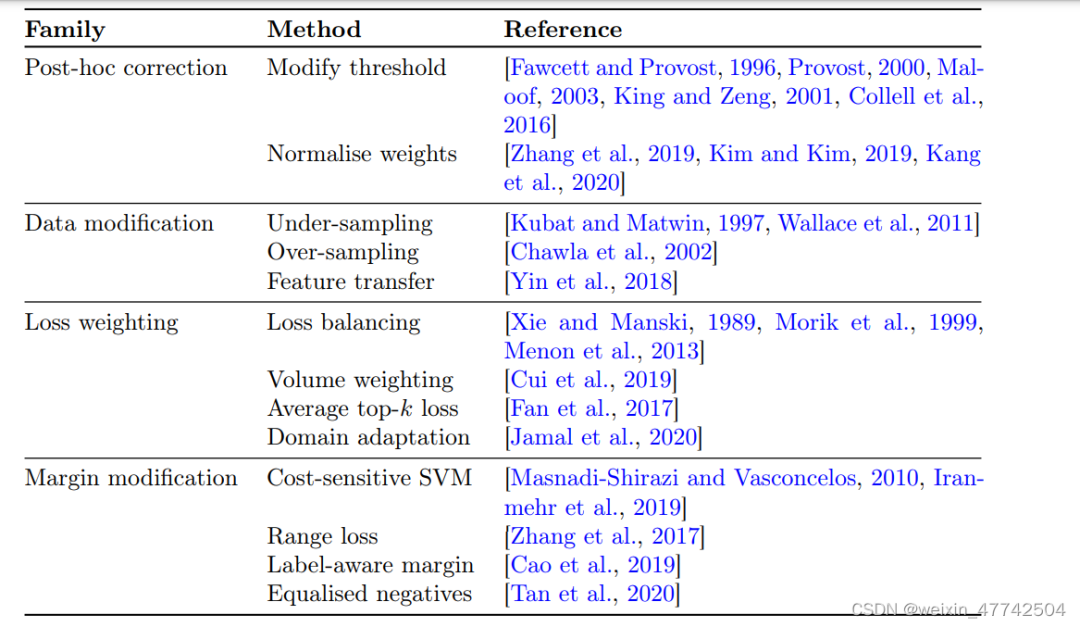

3. 問(wèn)題設(shè)定和過(guò)往方法回顧

3.1 Problem Settings

論文先從統(tǒng)計(jì)學(xué)的角度定義了一下這個(gè)problem settings,其實(shí)就是訓(xùn)練一個(gè)映射,讓這個(gè)scorer的誤分類(lèi)損失最小:

但是類(lèi)別不平衡的學(xué)習(xí)的setting導(dǎo)致P(y)分布是存在高度地skewed,使得許多尾部類(lèi)別標(biāo)簽出現(xiàn)的概率很低。在這里,錯(cuò)誤分類(lèi)的比例就不是一個(gè)合適的metric: 因?yàn)槟P退坪醢阉械奈膊款?lèi)別都分類(lèi)成頭部類(lèi)別也更夠取得比較好的效果。所為了解決這個(gè)問(wèn)題,一個(gè)自然的選擇是平衡誤差,平均每個(gè)類(lèi)的錯(cuò)誤率,從而讓測(cè)試計(jì)算出的metric不是有偏的。

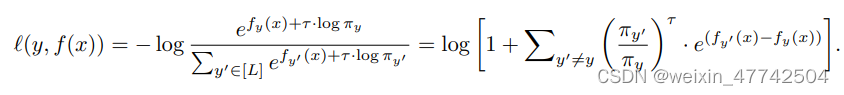

論文總結(jié)出了一個(gè)比較general的loss形式:

這里 是類(lèi)別 yy 的權(quán)重;是另一個(gè)超參, 用來(lái)控制 margin 的大小。

3.2Post-hoc weight normalization

由于頭部類(lèi)別多,容易過(guò)擬合,自然會(huì)對(duì)頭部類(lèi)別overconfidence,所以我們需要通過(guò)一定的映射來(lái)調(diào)整logit。具體到調(diào)整的策略,自然是讓大類(lèi)置信度低一點(diǎn),小類(lèi)置信度高一點(diǎn)。

for , where and . Intuitively, either choice of upweights the contribution of rare labels through weight normalisation. The choice is motivated by the observations that tends to correlate with . Further to the above, one may enforce during training.

這里引用了一些其他做long-tail learning的論文,可以參考以便更好地對(duì)這一塊進(jìn)行理解。

3.3 Loss modification

至于對(duì)于loss的修改,就是很直接了在前面加一個(gè)權(quán)重,對(duì)于的取值,自然就是各個(gè)工作重點(diǎn)關(guān)注和改進(jìn)的地方。

論文給予原有的各種方法各種比較全面的總結(jié)。

4. 方法

首先進(jìn)行Post-hoc logit adjustment:

其實(shí)等號(hào)左邊就是一個(gè)根據(jù)類(lèi)別的樣本數(shù)進(jìn)行re-weighting。但是為了在exp的線性變換加上temperature時(shí)候不影響排序問(wèn)題,所以把等號(hào)右邊變成上式,通過(guò)這種方式放縮不會(huì)導(dǎo)致原本的排序出現(xiàn)問(wèn)題。從而使得重加權(quán)仍能夠給尾部類(lèi)更高的權(quán)重。

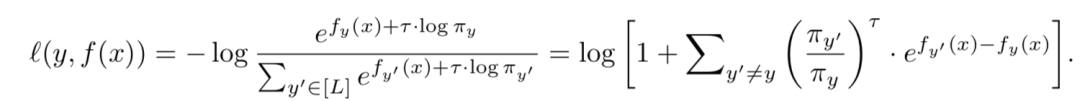

把loss改寫(xiě)成易于理解的方式就如下:

下面這個(gè)更為直接的loss被成為為pairwise margin loss,它可以把 y 與 y' 之間的margin拉大。

然后就是實(shí)現(xiàn)結(jié)合:

通過(guò)一些特殊的取值和另外的trick,可以實(shí)現(xiàn)兩者的結(jié)合。

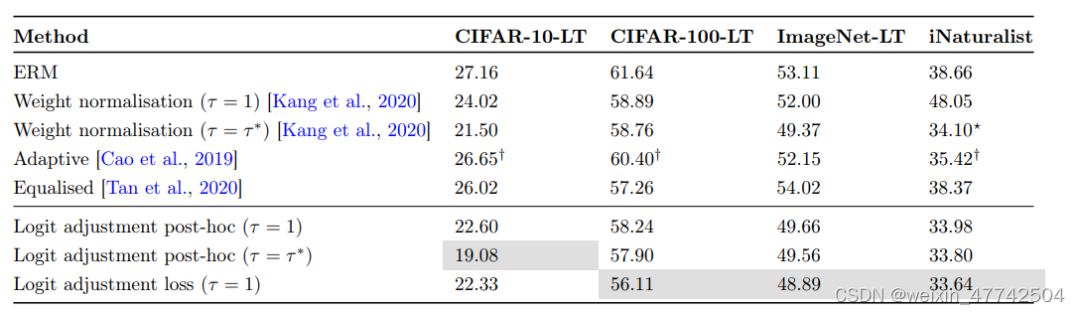

5. 實(shí)驗(yàn)結(jié)果

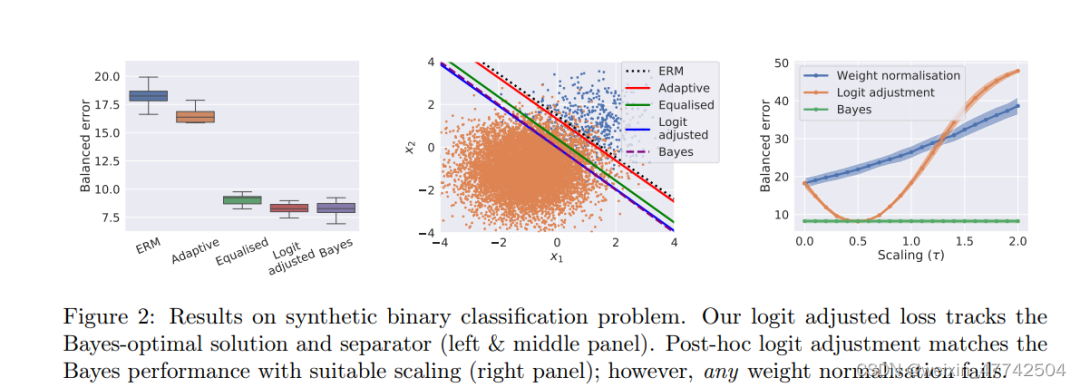

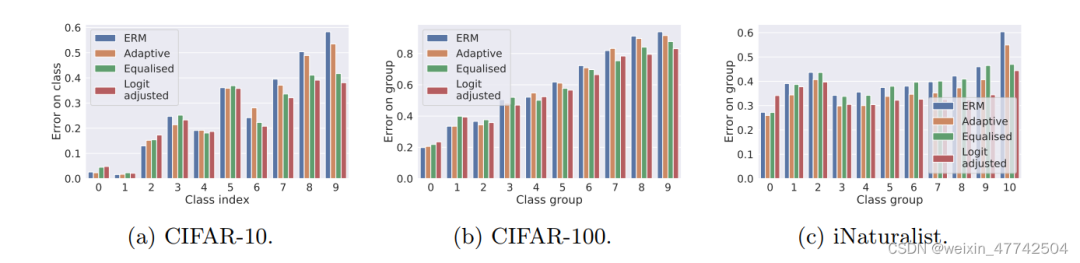

這張圖非常有意思,可以看出兩個(gè)設(shè)計(jì)理念非常有效果。

可以發(fā)現(xiàn)該方法在頭部類(lèi)和尾部類(lèi)的性能都有所提升。

6. 結(jié)論

摘要:這篇寫(xiě)得很好的論文重新審視了logit調(diào)整的想法,以解決長(zhǎng)尾問(wèn)題。本文首先建立了一個(gè)統(tǒng)計(jì)框架,并以此為基礎(chǔ)提出了兩種有效實(shí)現(xiàn)對(duì)數(shù)平差的方法。他們通過(guò)在合成和自然長(zhǎng)尾數(shù)據(jù)集上使用幾個(gè)相關(guān)基線對(duì)其進(jìn)行測(cè)試,進(jìn)一步證明了這種方法的潛力。

審核編輯 :李倩

-

線性

+關(guān)注

關(guān)注

0文章

200瀏覽量

25525 -

模型

+關(guān)注

關(guān)注

1文章

3487瀏覽量

49998 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25278

發(fā)布評(píng)論請(qǐng)先 登錄

電源管理芯片U3205A擁有良好的線性調(diào)整率和負(fù)載調(diào)整率

模擬示波器的波形顯示可以調(diào)整哪些參數(shù)?

DLPC3433的gain具體是通過(guò)調(diào)整什么來(lái)實(shí)現(xiàn)的?

如何優(yōu)化BP神經(jīng)網(wǎng)絡(luò)的學(xué)習(xí)率

BP神經(jīng)網(wǎng)絡(luò)與深度學(xué)習(xí)的關(guān)系

什么是機(jī)器學(xué)習(xí)?通過(guò)機(jī)器學(xué)習(xí)方法能解決哪些問(wèn)題?

tlv320aic3104通過(guò)調(diào)整增益來(lái)控制聲音大小,調(diào)整一下就出現(xiàn)一聲“嘣“,如何解決?

什么是交叉調(diào)整率?怎么改善?

如何調(diào)整TAS5729的BQ參數(shù)?

直流電機(jī)通過(guò)調(diào)整什么改變轉(zhuǎn)速

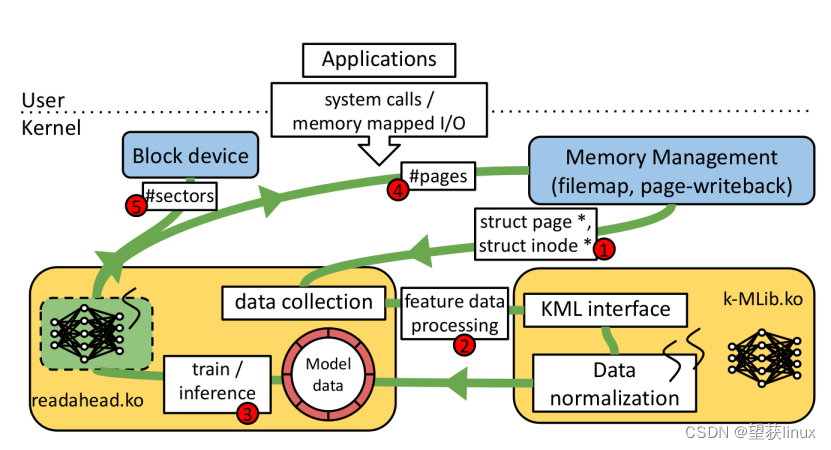

Linux操作系統(tǒng)運(yùn)行參數(shù)自動(dòng)調(diào)整技術(shù)

通過(guò)Logit調(diào)整的長(zhǎng)尾學(xué)習(xí)

通過(guò)Logit調(diào)整的長(zhǎng)尾學(xué)習(xí)

評(píng)論