近年來,建筑業(yè)和采用機(jī)器學(xué)習(xí)( ML )工具。使用 GPU 加速計(jì)算日益密集的模型已成為一個(gè)突出的趨勢(shì)。

為了增加用戶訪問,加速 WEKA 項(xiàng)目通過集成開源 RAPIDS 庫,為在知名的 WEKA 算法中使用 GPU 提供了一個(gè)可訪問的入口點(diǎn)。

在這篇文章中,我們將向您介紹加速 WEKA ,并學(xué)習(xí)如何使用 WEKA 軟件利用圖形用戶界面( GUI )的 GPU 加速算法。這種 Java 開源替代方案適合于從不同環(huán)境或包中尋找各種 ML 算法的初學(xué)者。

什么是加速 WEKA ?

加速 WEKA 將WEKA軟件(一種著名的開源 Java 軟件)與利用 GPU 縮短 ML 算法執(zhí)行時(shí)間的新技術(shù)相結(jié)合。針對(duì)沒有系統(tǒng)配置和編碼專業(yè)知識(shí)的用戶,它有兩個(gè)好處:易于安裝和指導(dǎo) ML 任務(wù)的配置和執(zhí)行的 GUI 。

加速 WEKA 是一個(gè)可用于 WEKA 的軟件包集合,它可以擴(kuò)展以支持新的工具和算法。

什么是急流?

RAPIDS是一組開源 Python 庫,供用戶在 NVIDIA GPU 上開發(fā)和部署數(shù)據(jù)科學(xué)工作負(fù)載。流行的庫包括用于 GPU 加速數(shù)據(jù)幀處理的 cuDF 和用于 GPU 加速機(jī)器學(xué)習(xí)算法的 cuML 。 RAPIDS API 盡可能符合 CPU 對(duì)應(yīng)項(xiàng),例如 pandas 和scikit-learn。

%1 : %2 加速的 WEKA 架構(gòu)

加速 WEKA 的構(gòu)建塊是WekaDeeplearning4j和wekaRAPIDS(受wekaPython啟發(fā))等包。 WekaDeeplearning4j ( WDL4J )已經(jīng)支持 GPU 處理,但在庫和環(huán)境配置方面有非常特殊的需求。 WDL4J 為 Deeplearning4j 庫提供了 WEKA 包裝。

對(duì)于 Python 用戶, weka Python 最初通過創(chuàng)建服務(wù)器并通過套接字與之通信來提供 Python 集成。有了它,用戶可以在 WEKA 工作臺(tái)內(nèi)執(zhí)行 scikit learn ML 算法(甚至XGBoost)。此外, weka RAPIDS 通過在 wekaPython 中使用相同的技術(shù)提供與 RAPIDS cuML 庫的集成。

總之,這兩個(gè)包在用戶友好的 WEKA 工作臺(tái)內(nèi)提供了增強(qiáng)的功能和性能。加速 WEKA 通過改進(jìn) JVM 和 Python 解釋器之間的通信,在性能方面更進(jìn)一步。它通過使用 Apache Arrow 和 GPU 內(nèi)存共享等替代方法來實(shí)現(xiàn)這兩種語言之間的高效數(shù)據(jù)傳輸。

加速 WEKA 還提供了與 RAPIDS cuML 庫的集成,該庫實(shí)現(xiàn)了在 NVIDIA GPU 上加速的機(jī)器學(xué)習(xí)算法。一些 cuML 算法甚至可以支持多 GPU 解。

支持的算法

加速 WEKA 目前支持的算法有:

線性回歸

物流回歸

山脊

套索

彈性網(wǎng)

MBSGD 分類器

MBSGDRegressor 公司

多項(xiàng)式 nb

伯努林

高斯 B

隨機(jī)森林分類器

隨機(jī)森林采伐

靜止無功補(bǔ)償器

SVR 公司

LinearSVC

Kneighbors 回歸器

Kneighbors 分類器

多 GPU 模式下加速 WEKA 支持的算法有:

Kneighbors 回歸器

Kneighbors 分類器

線性回歸

山脊

套索

彈性網(wǎng)

多項(xiàng)式 nb

光盤

使用加速 WEKA GUI

在加速 WEKA 設(shè)計(jì)階段,一個(gè)主要目標(biāo)是使其易于使用。以下步驟概述了如何在系統(tǒng)上進(jìn)行設(shè)置,并提供了一個(gè)簡(jiǎn)單的示例。

有關(guān)更多信息和全面入門,請(qǐng)參閱文檔。加速 WEKA 的唯一先決條件是在系統(tǒng)中安裝Conda。

加速 WEKA 的安裝可通過提供包和環(huán)境管理的系統(tǒng) Conda 獲得。這種能力意味著一個(gè)簡(jiǎn)單的命令可以安裝項(xiàng)目的所有依賴項(xiàng)。例如,在 Linux 機(jī)器上,在終端中發(fā)出以下命令以安裝加速 WEKA 和所有依賴項(xiàng)。

conda create-n accelweka-c rapidsai-c NVIDIA -c conda forge-c waikato weka

Conda 創(chuàng)建環(huán)境后,使用以下命令將其激活:

激活時(shí)

這個(gè)終端實(shí)例剛剛加載了加速 WEKA 的所有依賴項(xiàng)。使用以下命令啟動(dòng) WEKA GUI 選擇器:

韋卡

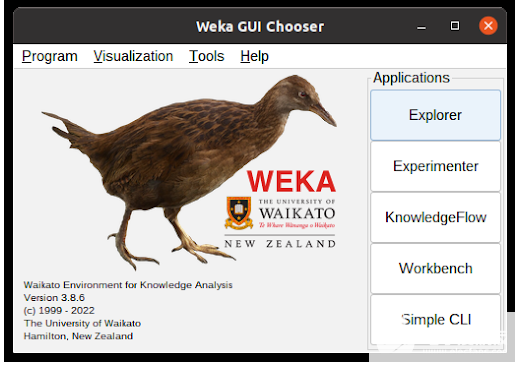

圖 1 顯示了 WEKA GUI 選擇器窗口。從那里,單擊 Explorer 按鈕訪問 Accelerated WEKA 的功能。

圖 1 。 WEKA GUI 選擇器窗口。這是啟動(dòng) WEKA 時(shí)出現(xiàn)的第一個(gè)窗口

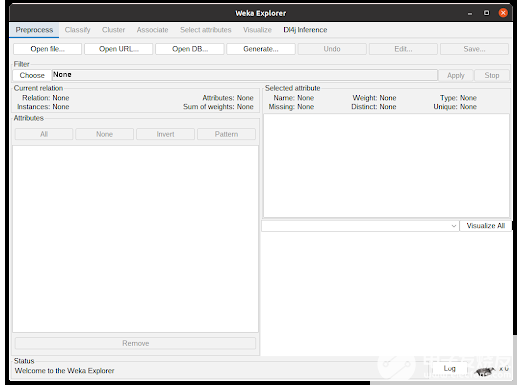

在 WEKA Explorer 窗口(圖 2 )中,單擊 Open file 按鈕以選擇數(shù)據(jù)集文件。 WEKA 使用 ARFF 文件,但可以從 CSV 中讀取。根據(jù)屬性的類型,從 CSV 轉(zhuǎn)換可能非常簡(jiǎn)單,或者需要用戶進(jìn)行一些配置。

圖 2 :在 WEKA Explorer 窗口中,用戶可以導(dǎo)入數(shù)據(jù)集,檢查有關(guān)屬性的統(tǒng)計(jì)信息,并在預(yù)處理時(shí)對(duì)數(shù)據(jù)集應(yīng)用過濾器

加載了數(shù)據(jù)集的 WEKA Explorer 窗口如圖 3 所示。假設(shè)不想預(yù)處理數(shù)據(jù),單擊“分類”選項(xiàng)卡將向用戶顯示分類選項(xiàng)。

圖 3 。加載數(shù)據(jù)集的 WEKA Explorer 窗口。加載數(shù)據(jù)集(從 ARFF 文件或 CSV 文件)后,屬性名稱顯示在左側(cè)。有關(guān)選定屬性的信息顯示在右上角。在右下角可以看到一個(gè)圖表,其中包含根據(jù)所選屬性的類分布

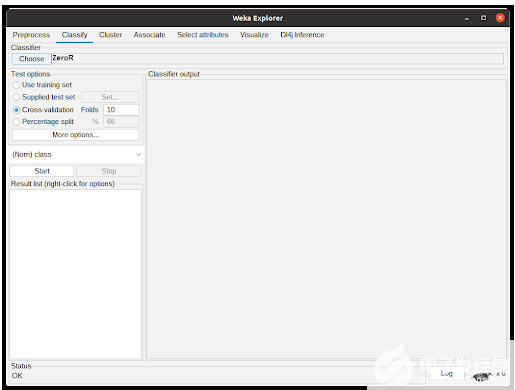

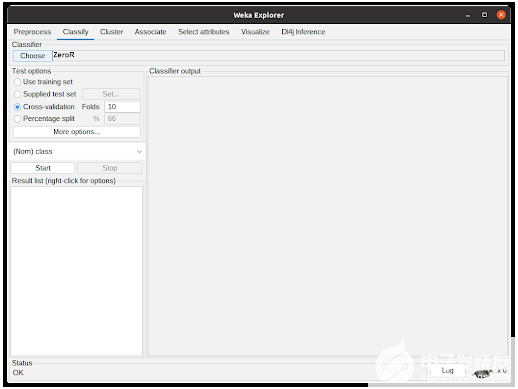

分類選項(xiàng)卡如圖 4 所示。單擊“選擇”按鈕將顯示已實(shí)現(xiàn)的分類器。由于數(shù)據(jù)集的特性,有些可能被禁用。要使用加速 WEKA ,用戶必須選擇急流。積云分類器。之后,單擊粗體 CuMLClassifier 將使用戶轉(zhuǎn)到分類器的選項(xiàng)窗口。

圖 4 。在 WEKA 分類選項(xiàng)卡中,用戶可以配置分類算法和測(cè)試選項(xiàng),這些選項(xiàng)將在使用之前選擇的數(shù)據(jù)集的實(shí)驗(yàn)中使用

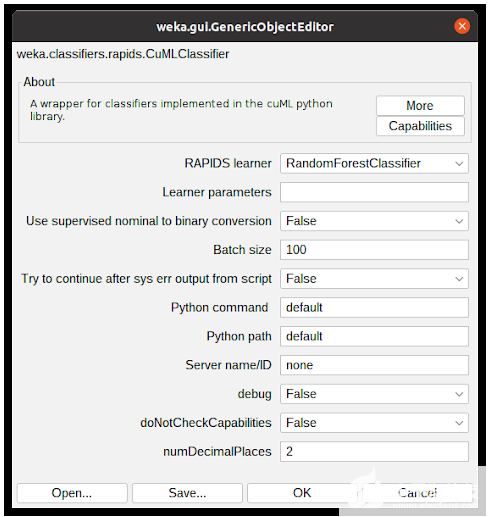

圖 5 顯示了 CuMLClassifier 的選項(xiàng)窗口。使用字段 RAPIDS 學(xué)習(xí)器,用戶可以在軟件包支持的分類器中選擇所需的分類器。現(xiàn)場(chǎng)學(xué)習(xí)者參數(shù)用于修改 cuML 參數(shù),其詳細(xì)信息可在cuML documentation中找到。

其他選項(xiàng)用于用戶微調(diào)屬性轉(zhuǎn)換,配置要使用的 Python 環(huán)境,并確定算法應(yīng)操作的小數(shù)位數(shù)。為了學(xué)習(xí)本教程,請(qǐng)選擇隨機(jī)林分類器,并將所有內(nèi)容保留為默認(rèn)配置。單擊“確定”將關(guān)閉窗口并返回到上一個(gè)選項(xiàng)卡。

圖 5 。通過 WEKA 分類器配置窗口,用戶可以配置所選分類器的參數(shù)。在這種情況下,它顯示了新集成的 CuMLClassifier 選項(xiàng)和所選的 RandomForestClassifier 學(xué)習(xí)器

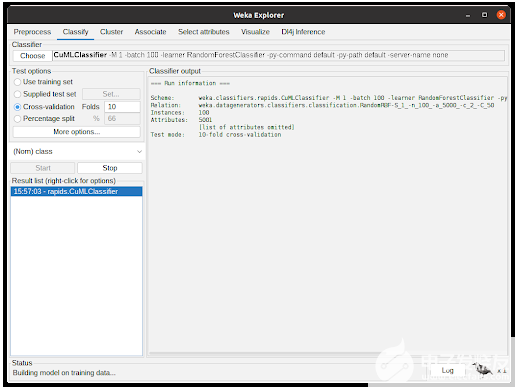

根據(jù)上一步配置分類器后,參數(shù)將顯示在選擇按鈕旁邊的文本字段中。單擊開始后, WEKA 將開始使用數(shù)據(jù)集執(zhí)行所選分類器。

圖 6 顯示了分類器的作用。分類器輸出顯示有關(guān)實(shí)驗(yàn)的調(diào)試和一般信息,例如參數(shù)、分類器、數(shù)據(jù)集和測(cè)試選項(xiàng)。狀態(tài)顯示執(zhí)行的當(dāng)前狀態(tài),底部的 Weka 鳥在實(shí)驗(yàn)運(yùn)行時(shí)從一側(cè)動(dòng)畫并翻轉(zhuǎn)到另一側(cè)。

圖 6 。 WEKA 分類選項(xiàng)卡,所選分類算法正在進(jìn)行中

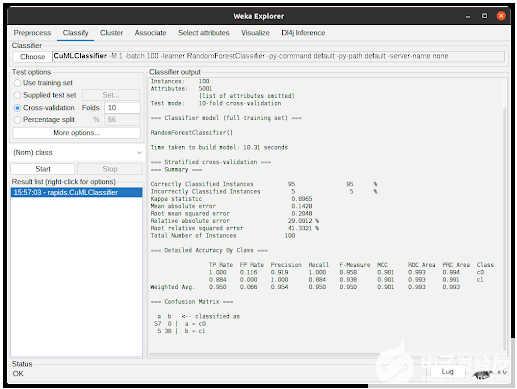

算法完成任務(wù)后,將輸出執(zhí)行摘要,其中包含有關(guān)預(yù)測(cè)性能和所用時(shí)間的信息。在圖 7 中,輸出顯示了使用從 cuML 到 CuMLClassifier 的 RandomForestClassifier 進(jìn)行 10 倍交叉驗(yàn)證的結(jié)果。

圖 7 。實(shí)驗(yàn)完成后的 WEKA 分類選項(xiàng)卡

基準(zhǔn)測(cè)試加速 WEKA

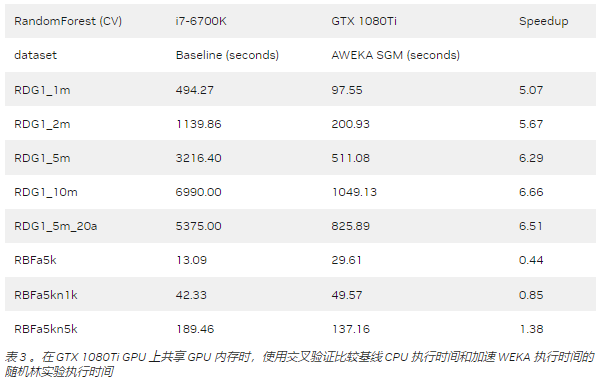

我們?cè)u(píng)估了加速 WEKA 的性能,比較了算法在 CPU 上的執(zhí)行時(shí)間和使用加速 WEKA 的執(zhí)行時(shí)間。實(shí)驗(yàn)中使用的硬件是 i7-6700K 、 GTX 1080Ti 和具有四個(gè) A100 GPU 的 DGX 站。除非另有說明,否則基準(zhǔn)測(cè)試使用單個(gè) GPU 。

我們使用具有不同特征的數(shù)據(jù)集作為基準(zhǔn)。其中一些是合成的,用于更好地控制屬性和實(shí)例,如 RDG 和 RBF 生成器。 RDG 生成器基于決策列表構(gòu)建實(shí)例。默認(rèn)配置有 10 個(gè)屬性, 2 個(gè)類,最小規(guī)則大小為 1 ,最大規(guī)則大小為 10 。我們將最小值和最大值分別更改為 5 和 20 。使用該生成器,我們創(chuàng)建了具有 1 、 2 、 5 和 1000 萬個(gè)實(shí)例的數(shù)據(jù)集,以及具有 20 個(gè)屬性的 500 萬個(gè)實(shí)例。

RBF 生成器為每個(gè)類創(chuàng)建一組隨機(jī)中心,然后通過獲取屬性值中心的隨機(jī)偏移來生成實(shí)例。屬性的數(shù)量用后綴 a _ uu 表示(例如, a5k 表示 5000 個(gè)屬性),實(shí)例的數(shù)量用后綴 n _ u 表示(例如, n10k 表示 10000 個(gè)實(shí)例)。

最后,我們使用了HIGGS 數(shù)據(jù)集,其中包含有關(guān)原子加速器運(yùn)動(dòng)學(xué)特性的數(shù)據(jù)。希格斯數(shù)據(jù)集的前 500 萬個(gè)實(shí)例用于創(chuàng)建希格斯粒子。

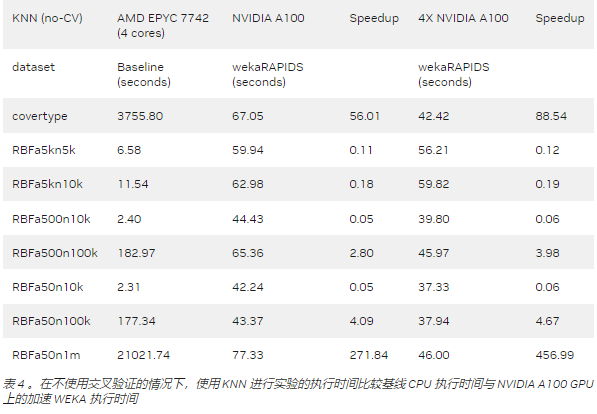

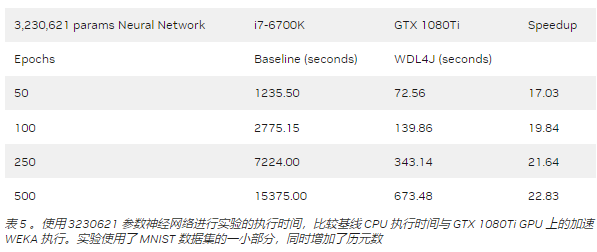

顯示了 weka RAPIDS 積分的結(jié)果,其中我們直接比較了基線 CPU 執(zhí)行和加速 weka 執(zhí)行。 WDL4J 的結(jié)果如表 5 所示。

該基準(zhǔn)測(cè)試表明,加速 WEKA 為具有較大數(shù)據(jù)集的計(jì)算密集型任務(wù)提供了最大的好處。像 RBFa5k 和 RBFa5kn1k 這樣的小數(shù)據(jù)集(分別擁有 100 個(gè)和 1000 個(gè)實(shí)例)呈現(xiàn)出糟糕的加速,這是因?yàn)閿?shù)據(jù)集太小,無法使將內(nèi)容移動(dòng)到 GPU 內(nèi)存的開銷值得。

這種行為在 A100 (表 4 )實(shí)驗(yàn)中很明顯,其中架構(gòu)更為復(fù)雜。使用它的好處開始在 100000 個(gè)實(shí)例或更大的數(shù)據(jù)集上發(fā)揮作用。例如,具有 100000 個(gè)實(shí)例的 RBF 數(shù)據(jù)集顯示了約 3 倍和 4 倍的加速,這仍然不太明顯,但顯示出了改進(jìn)。更大的數(shù)據(jù)集,如 covertype 數(shù)據(jù)集(約 700000 個(gè)實(shí)例)或 RBFa50n1m 數(shù)據(jù)集( 100 萬個(gè)實(shí)例),分別顯示了 56X 和 271X 的加速。請(qǐng)注意,對(duì)于深度學(xué)習(xí)任務(wù),即使使用 GTX 1080Ti ,加速也可以達(dá)到 20 倍以上。

關(guān)鍵要點(diǎn)(與行動(dòng)要求掛鉤)

加速 WEKA 將幫助您使用激流為 WEKA 增壓。加速 WEKA 有助于 RAPIDS 的高效算法實(shí)現(xiàn),并具有易于使用的 GUI 。使用 Conda 環(huán)境簡(jiǎn)化了安裝過程,從一開始就可以直接使用加速 WEKA 。

如果您使用 AcceleratedWEKA ,請(qǐng)?jiān)谏缃幻襟w上使用標(biāo)簽“ AcceleratedWEKA ”。此外,請(qǐng)參閱 文檔 以獲取在學(xué)術(shù)工作中引用加速 WEKA 的正確出版物,并了解有關(guān)該項(xiàng)目的更多詳細(xì)信息。

加速 WEKA

WEKA 在 GPL 開源許可證 下免費(fèi)提供,因此加速了 WEKA 。事實(shí)上, Accelerated WEKA 是通過 Conda 提供的,用于自動(dòng)安裝環(huán)境所需的工具,對(duì)源代碼的添加將發(fā)布到 WEKA 的主包中。

關(guān)于作者

Albert Bifet 是特議會(huì)聯(lián)盟特馬哈拉艾研究所所長(zhǎng)。他是一位計(jì)算機(jī)科學(xué)家,主要興趣領(lǐng)域是數(shù)據(jù)流及其應(yīng)用的人工智能/機(jī)器學(xué)習(xí)。他是 MOA 機(jī)器學(xué)習(xí)軟件的核心開發(fā)者,擁有 150 多篇關(guān)于機(jī)器學(xué)習(xí)方法及其應(yīng)用的出版物。

Guilherme Weigert Cassales 自 2021 以來一直是人工智能研究所的博士后研究員,同年他在圣卡洛斯聯(lián)邦大學(xué)( UFSCar )獲得了計(jì)算機(jī)科學(xué)博士學(xué)位。他的研究興趣包括數(shù)據(jù)流的機(jī)器學(xué)習(xí)、分布式系統(tǒng)和高性能計(jì)算。

自 2021 以來,Justin Liu 一直是人工智能研究所的研究程序員。他在該行業(yè)有十多年的軟件開發(fā)經(jīng)驗(yàn)。他的興趣包括機(jī)器學(xué)習(xí)、大規(guī)模數(shù)據(jù)處理和 ML 操作。

審核編輯:郭婷

-

cpu

+關(guān)注

關(guān)注

68文章

11038瀏覽量

216035 -

加速器

+關(guān)注

關(guān)注

2文章

823瀏覽量

38928 -

gpu

+關(guān)注

關(guān)注

28文章

4912瀏覽量

130673 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8492瀏覽量

134117

發(fā)布評(píng)論請(qǐng)先 登錄

NVIDIA Isaac GR00T N1開源人形機(jī)器人基礎(chǔ)模型+開源物理引擎Newton加速機(jī)器人開發(fā)

機(jī)器學(xué)習(xí)模型市場(chǎng)前景如何

NPU與機(jī)器學(xué)習(xí)算法的關(guān)系

PyTorch GPU 加速訓(xùn)練模型方法

GPU加速計(jì)算平臺(tái)是什么

FPGA加速深度學(xué)習(xí)模型的案例

AI大模型與傳統(tǒng)機(jī)器學(xué)習(xí)的區(qū)別

深度學(xué)習(xí)GPU加速效果如何

【「大模型時(shí)代的基礎(chǔ)架構(gòu)」閱讀體驗(yàn)】+ 第一、二章學(xué)習(xí)感受

大模型向邊端側(cè)部署,AI加速卡朝高算力、小體積發(fā)展

NVIDIA 加速人形機(jī)器人發(fā)展

LLM大模型推理加速的關(guān)鍵技術(shù)

深度學(xué)習(xí)模型量化方法

使用加速WEKA加速機(jī)器學(xué)習(xí)模型

使用加速WEKA加速機(jī)器學(xué)習(xí)模型

評(píng)論