Cerebras公司的技術(shù)將在數(shù)小時(shí)而非數(shù)周的時(shí)間里完成對這些人工智能系統(tǒng)的訓(xùn)練。

人工智能計(jì)算機(jī)初創(chuàng)企業(yè)Cerebras Systems的聯(lián)合創(chuàng)始人兼首席執(zhí)行官安德魯?費(fèi)爾德曼(Andrew Feldman)表示,今天的人工智能效率遠(yuǎn)低于它本應(yīng)能達(dá)到的效率。

他和公司的其他聯(lián)合創(chuàng)始人一致認(rèn)為,如今的人工神經(jīng)網(wǎng)絡(luò)在訓(xùn)練上太過耗時(shí),計(jì)算量太大。比如說,要讓一輛自動駕駛汽車識別出它在路上會遇到的所有重要物體,則需要向汽車的神經(jīng)網(wǎng)絡(luò)展示大量有關(guān)這些物體的圖像。這個(gè)過程發(fā)生在數(shù)據(jù)中心,耗電數(shù)十千瓦有時(shí)甚至數(shù)百千瓦的計(jì)算機(jī)會專門處理這種常常耗時(shí)長達(dá)數(shù)周的任務(wù)。假如生成的網(wǎng)絡(luò)能夠以所需精確度執(zhí)行這項(xiàng)任務(wù),則定義網(wǎng)絡(luò)連接強(qiáng)度的多個(gè)系數(shù)隨后會被下載到汽車的計(jì)算機(jī)中,然后去執(zhí)行另一半深度學(xué)習(xí)工作,即推理。

Cerebras的客戶(該公司已經(jīng)有一些客戶了,不過在去年夏天還在保密狀態(tài))抱怨說,在當(dāng)今的計(jì)算機(jī)上進(jìn)行大型神經(jīng)網(wǎng)絡(luò)訓(xùn)練可能需要長達(dá)6周的時(shí)間。以這樣的速度,他們一年可能只能訓(xùn)練6個(gè)神經(jīng)網(wǎng)絡(luò)。“我們的目的是測試更多的想法,”費(fèi)爾德曼說,“如果你能在2到3個(gè)小時(shí)內(nèi)(訓(xùn)練1個(gè)網(wǎng)絡(luò)),那么你就可以運(yùn)行數(shù)千個(gè)想法。”

記者參觀Cerebras公司位于加州洛思阿圖斯(Los Altos)的總部時(shí),這些客戶和部分潛在新客戶已經(jīng)在用有橙色護(hù)套的光纜將他們的訓(xùn)練數(shù)據(jù)導(dǎo)入4臺CS-1計(jì)算機(jī)中。這些64厘米高、功率為20千瓦的機(jī)器不停地運(yùn)轉(zhuǎn),產(chǎn)生的熱量通過墻上的一個(gè)孔洞被排放到了硅谷的街道上。

從外觀來說,CS-1計(jì)算機(jī)本身并不特別。實(shí)際上,每個(gè)機(jī)箱的3/4都被冷卻系統(tǒng)占據(jù),而另外1/4空間中的內(nèi)容才具有真正的“變革性”:一臺非常強(qiáng)大的計(jì)算機(jī)幾乎完全由一塊單一芯片組成。不過這塊芯片的面積超過46255平方毫米,是任何市售處理器芯片面積的50多倍。借助1.2萬億個(gè)晶體管、40萬個(gè)處理器內(nèi)核、18千兆字節(jié)的靜態(tài)隨機(jī)存儲器(SRAM)以及每秒可移動100千萬億字節(jié)的互連技術(shù),Cerebras的晶圓級引擎(WSE)可輕松秒殺其他系統(tǒng)。

Cerebras引用的統(tǒng)計(jì)數(shù)據(jù)是相當(dāng)驚人的。該公司稱,一個(gè)10機(jī)架的TPU2集群(谷歌人工智能計(jì)算機(jī)產(chǎn)品的第二代)消耗的功率是單臺WSE計(jì)算機(jī)的5倍,占用的空間是它的30倍,性能卻僅為其1/3。單一巨型芯片是否真的是人工智能界一直在等待的答案,今年將變得明朗起來。“(神經(jīng)網(wǎng)絡(luò))模型越來越復(fù)雜,”加州山景城林利集團(tuán)(Linley Group)的高級分析師邁克?戴姆勒(Mike Demler)說,“能夠快速訓(xùn)練或再訓(xùn)練非常重要。”

芝加哥附近的超級計(jì)算機(jī)巨頭阿貢國家實(shí)驗(yàn)室等客戶已經(jīng)在自己的辦公場所安裝了這種機(jī)器,如果Cerebras的推測是正確的,那么有出色表現(xiàn)的神經(jīng)網(wǎng)絡(luò)的數(shù)量將呈爆炸式增長。

費(fèi)爾德曼解釋說,Cerebras的創(chuàng)始人們(都是服務(wù)器公司Sea Micro的老員工,Sea Micro被超微半導(dǎo)體公司AMD收購)在2015年初次開會時(shí)便希望打造一臺完美符合現(xiàn)代人工智能工作量性質(zhì)的計(jì)算機(jī)。這些工作量由以下幾點(diǎn)定義:快速移動大量數(shù)據(jù),接近處理內(nèi)核的內(nèi)存,而且這些內(nèi)核不需要處理其他內(nèi)核正在處理的數(shù)據(jù)。

這立刻給包括首席技術(shù)官加里?勞特巴赫(Gary Lauter-bach)在內(nèi)的資深計(jì)算機(jī)架構(gòu)師提供了一些想法。首先,他們可以使用成千上萬個(gè)用于進(jìn)行相關(guān)神經(jīng)網(wǎng)絡(luò)計(jì)算的小內(nèi)核,而不是使用更少量的通用內(nèi)核。其次,這些內(nèi)核應(yīng)該與一個(gè)低能耗且可以快速移動數(shù)據(jù)的互連方案連接在一起。最后,所有所需數(shù)據(jù)應(yīng)位于處理器芯片中,而不是多個(gè)單獨(dú)的存儲芯片上。

很大程度上正是在這些內(nèi)核之間移動數(shù)據(jù)的需要讓W(xué)SE變得獨(dú)一無二。在兩個(gè)內(nèi)核之間移動數(shù)據(jù)最快、能耗最低的方法就是將它們放在同一個(gè)硅基板上。數(shù)據(jù)必須從一塊芯片傳輸?shù)搅硪粔K芯片時(shí),速度和功率方面的代價(jià)都很高,因?yàn)榫嚯x很長,傳輸信號的“電線”必須更粗且密度更小。

通過硅片實(shí)現(xiàn)所有通信的欲望,加上對小內(nèi)核和本地存儲的渴望,都指向制造一塊盡可能大的芯片(也許大如一整塊硅晶圓)。費(fèi)爾德曼說:“顯然我們做不到這一點(diǎn),這是肯定的。但這很明顯有很大的好處。”

幾十年來,工程師們一直認(rèn)為研究晶圓級芯片是一個(gè)死胡同。畢竟,出色如已故IBM System/360大型機(jī)首席架構(gòu)師吉恩?阿姆達(dá)爾(Gene Amdahl),也在與Trilogy Systems公司合作進(jìn)行的嘗試中失敗了。不過勞特巴赫和費(fèi)爾德曼說,任何與阿姆達(dá)爾的嘗試進(jìn)行的比較都很可笑而且過時(shí)的。阿姆達(dá)爾使用的晶圓只有如今晶圓的1/10大,而在這些晶圓上組成的設(shè)備尺寸卻是現(xiàn)今設(shè)備的30倍。

更重要的是,Triology無法解決芯片制造過程中不可避免出現(xiàn)的錯(cuò)誤。在其他條件相同的情況下,芯片越大出現(xiàn)缺陷的可能性就越大。如果芯片和一張信紙一樣大,那么它必然會有不少缺陷。

不過,勞特巴赫找到了架構(gòu)解決方案。由于他們的目標(biāo)工作量偏向于采用成千上萬個(gè)相同的小內(nèi)核,所以可以容納足夠多的冗余內(nèi)核來承擔(dān)其中高達(dá)1%的缺陷所導(dǎo)致的故障,與此同時(shí)仍然能有一塊非常強(qiáng)大、非常大的芯片。

當(dāng)然,為了制造能容納缺陷的巨型芯片,Cerebras還是需要解決大量制造問題。例如,光刻工具能夠?qū)⑺鼈兊奶卣鞫x圖案刻蝕到相對較小的矩形上,并不斷重復(fù)。由于在晶圓不同位置刻蝕不同圖案的成本和難度較高,僅此一項(xiàng)就導(dǎo)致無法將許多系統(tǒng)構(gòu)建在單個(gè)晶圓上。

不過WSE不需要這樣做。它就像一塊充滿了完全相同的芯片的普通標(biāo)準(zhǔn)晶圓一樣。最大的挑戰(zhàn)是找到一種將這些偽芯片連接在一起的方法。芯片制造商在每個(gè)芯片周圍留下了一條稱為“劃線”的空白硅窄邊。通常會沿著這些線將晶圓切成小塊。Cerebras與臺灣積體電路制造股份有限公司(TSMC)合作開發(fā)了一種跨越劃線實(shí)現(xiàn)互連的方式,以便每塊偽芯片中的內(nèi)核都可以通信。

由于所有通信和內(nèi)存都在一塊硅片上,數(shù)據(jù)可以暢通無阻地快速移動,實(shí)現(xiàn)每秒1000拍比特的內(nèi)核到內(nèi)核帶寬和每秒9拍字節(jié)的SRAM到內(nèi)核帶寬。“這多的可不是一點(diǎn)點(diǎn)。”費(fèi)爾德曼說,”就是因?yàn)槲覀兝^續(xù)使用了硅,我們將帶寬提升了4個(gè)數(shù)量級。”

除了實(shí)現(xiàn)跨劃線互連,芯片制造硬件也必須修改。即便是用于電子設(shè)計(jì)自動化的軟件,也必須定制才能在如此大的芯片上工作。“每一條規(guī)則、每一種工具和每一種制造設(shè)備的設(shè)計(jì)都像是挑選一塊普通大小的巧克力餅干。而(我們)提供的是一整塊烤盤大的餅干,”費(fèi)爾德曼說,“其中的每一步都需要?jiǎng)?chuàng)新。”

晶圓級集成“在過去40年里一直被忽視,當(dāng)然,總有一天它會得到重視”,他說。現(xiàn)在,既然Cerebras已經(jīng)這樣做了,大門可能會向其他人敞開。“我們認(rèn)為,其他公司會尋求與我們合作,以解決人工智能之外的問題。”

確實(shí),伊利諾伊大學(xué)和加州大學(xué)洛杉磯分校的工程師們認(rèn)為,Cerebras芯片可以促進(jìn)他們使用硅互連結(jié)構(gòu)技術(shù)推進(jìn)他們的晶圓級計(jì)算工作。“這是對我們所做研究的極大驗(yàn)證,”伊利諾伊大學(xué)的拉凱什?庫馬爾(Rakesh Kumar)說,“我們很高興這種事情有商業(yè)利益。”

當(dāng)然,CS-1不僅僅是WSE芯片,但它也沒有更多內(nèi)容。這既是出于設(shè)計(jì),也是出于必要。被看作主板的,是一個(gè)位于芯片上方的電力輸送系統(tǒng),其下方還有一塊水冷冷板。令人驚訝的是,在這款計(jì)算機(jī)的開發(fā)過程中,最大的挑戰(zhàn)便是這個(gè)電力傳輸系統(tǒng)。

WSE有1.2萬億個(gè)晶體管,其設(shè)計(jì)工作電壓約為0.8伏,這是處理器的標(biāo)準(zhǔn)配置,但它們的數(shù)量過多,共需要2萬安培的電流。勞特巴赫說:“在沒有明顯電壓下降的情況下,將2萬安培的電流注入晶圓是一個(gè)相當(dāng)艱巨的工程學(xué)挑戰(zhàn),這比冷卻晶圓或解決成品率問題要難得多。”

電力無法從WSE的邊緣傳輸,因?yàn)榛ミB中的電阻在電壓到達(dá)芯片中間之前早已將其降為零。所以應(yīng)該自上而下垂直傳輸。Cerebras設(shè)計(jì)了一塊玻璃纖維電路板,里面裝有數(shù)百個(gè)用于功率控制的專用芯片。100萬根銅柱將玻璃纖維板與WSE上各個(gè)點(diǎn)之間約1毫米的距離連接起來。

以這種方式傳送電力似乎很簡單,但事實(shí)并非如此。操作過程中,芯片、電路板和冷板都會預(yù)熱到相同的溫度,但在預(yù)熱時(shí)它們膨脹的量各不相同。銅膨脹最大,硅膨脹最小,玻璃纖維的膨脹介于兩者之間。對正常尺寸的芯片來說,這種不匹配是一個(gè)令人頭疼的問題,因?yàn)檫@種變化足以切斷它們與印刷電路板的連接,或者產(chǎn)生足以破壞芯片的應(yīng)力。對于WSE大小的芯片而言,即使是很小的尺寸變化也會轉(zhuǎn)化為幾毫米的變化。

勞特巴赫說:“與主板(熱膨脹系數(shù))不匹配是一個(gè)殘酷的問題。”Cerebras曾嘗試尋找一種熱膨脹系數(shù)介于硅和玻璃纖維之間的材料,只有這樣才能保持百萬個(gè)電力輸送柱的連接。不過,最終工程師們不得不自己發(fā)明材料,這項(xiàng)工作耗時(shí)1年半。

WSE明顯比通常用于神經(jīng)網(wǎng)絡(luò)計(jì)算的競爭芯片要大,后者包括英偉達(dá)的Tesla V100圖形處理器和谷歌的Tensor處理器,但更大意味著更好嗎?

2018年,谷歌、百度和一些頂級學(xué)術(shù)團(tuán)體開始研究基準(zhǔn),以便在系統(tǒng)之間進(jìn)行同類比較。結(jié)果是他們于2018年5月發(fā)布了訓(xùn)練基準(zhǔn)MLPerf。

根據(jù)這些基準(zhǔn),神經(jīng)網(wǎng)絡(luò)訓(xùn)練技術(shù)在過去幾年里取得了巨大進(jìn)步。英偉達(dá)DGXSuperPOD(本質(zhì)上是一臺1500-GPU的超級計(jì)算機(jī))用了80秒便解決了ResNet-50圖像分類問題,而使用英偉達(dá)DGX-1機(jī)器(大概在2017年)需要8小時(shí),使用該公司2015年的K80則需要25天。

Cerebras還沒有發(fā)布MLPerf結(jié)果或任何其他可獨(dú)立驗(yàn)證的同類比較結(jié)果。相反,該公司更愿意讓客戶使用自己的神經(jīng)網(wǎng)絡(luò)和數(shù)據(jù)來測試CS-1。

分析人士稱這種做法并不罕見。“每個(gè)人都有為自己的業(yè)務(wù)開發(fā)的模型,”Moor Insights的人工智能分析師卡爾?弗洛因德(Karl Freund)說,“對買家來說,這是唯一重要的。”

例如,早期客戶阿貢國家實(shí)驗(yàn)室就有一些相當(dāng)強(qiáng)烈的需求。在訓(xùn)練神經(jīng)網(wǎng)絡(luò)以實(shí)時(shí)識別不同類型的引力波事件時(shí),科學(xué)家們最近使用了阿貢功率為百萬瓦特的Theta超級計(jì)算機(jī)1/4的資源,該超級計(jì)算機(jī)的計(jì)算能力在全球排名第28位。

把功耗降低到千瓦級似乎是超級計(jì)算的一個(gè)重要益處,勞特巴赫懷疑這項(xiàng)功能是否會成為數(shù)據(jù)中心的一大賣點(diǎn)。“雖然很多數(shù)據(jù)中心都在說(節(jié)約)能源的問題,但歸根結(jié)底……他們并不在乎,”他說,“他們想要的是性能。”而這是一個(gè)約餐盤大小的處理器完全可以提供的。

審核編輯 :李倩

-

芯片

+關(guān)注

關(guān)注

459文章

52190瀏覽量

436227 -

人工智能

+關(guān)注

關(guān)注

1804文章

48716瀏覽量

246523 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122484

原文標(biāo)題:大型芯片將打破深度學(xué)習(xí)的速度壁壘

文章出處:【微信號:HXSLH1010101010,微信公眾號:FPGA技術(shù)江湖】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

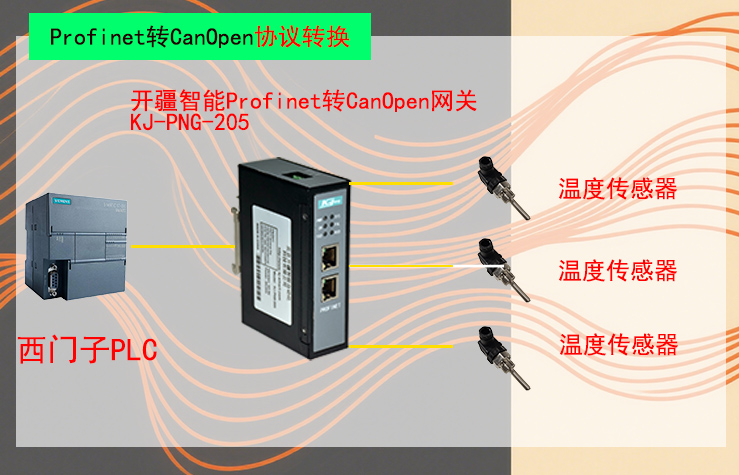

Profinet轉(zhuǎn)CanOpen網(wǎng)關(guān),打破協(xié)議壁壘的關(guān)鍵技術(shù)

用樹莓派搞深度學(xué)習(xí)?TensorFlow啟動!

大型芯片將打破深度學(xué)習(xí)的速度壁壘

大型芯片將打破深度學(xué)習(xí)的速度壁壘

評論