什么是關(guān)系抽取

知識(shí)就是力量。使人類及機(jī)器能夠更好地利用知識(shí)是提升工作效率及實(shí)現(xiàn)人工智能的關(guān)鍵所在,也催生了包括知識(shí)表示、知識(shí)推理在內(nèi)的一系列研究。作為一切對(duì)知識(shí)的利用的基礎(chǔ),我們首先要獲取知識(shí),即知識(shí)抽取。

與我們一般通過(guò)閱讀書籍來(lái)獲取知識(shí)一樣,知識(shí)抽取的主要數(shù)據(jù)來(lái)源是文本(如新聞、小說(shuō)、維基百科等)。通常來(lái)講,我們可以直接從文本中獲取的知識(shí)包含兩類:實(shí)體 (entity) 和關(guān)系 (relation) [1],這也對(duì)應(yīng)了兩類知識(shí)抽取任務(wù):實(shí)體識(shí)別 (entity recognition) 和關(guān)系抽取 (relation extraction)。下表給出了一個(gè)從句子中進(jìn)行知識(shí)抽取的示例。在本文中,我們將主要關(guān)注「關(guān)系抽取」。

| ID | 文本 | 實(shí)體 | 關(guān)系 |

|---|---|---|---|

| 1 | 北京是中國(guó)的首都,具有悠久的歷史。 | 北京,中國(guó) | 首都 |

| 2 | 比爾蓋茨是微軟的創(chuàng)始人。 | 比爾蓋茨,微軟 | 創(chuàng)始人 |

| 3 | 合肥位于安徽中部,是安徽省會(huì)。 | 合肥,安徽 | 位于,是省會(huì) |

顧名思義,關(guān)系抽取的目的就是從文本數(shù)據(jù)中抽取出關(guān)系。直觀來(lái)講,關(guān)系必然存在于兩個(gè)(或多個(gè)實(shí)體)之間,比如在“合肥位于安徽中部”這一文本中,“位于”是“合肥”和“安徽”之間的關(guān)系,而撇開(kāi)實(shí)體或者單看某單一實(shí)體時(shí)不會(huì)有關(guān)系這一概念的出現(xiàn)。從上表第三個(gè)例子又可以看出,”合肥“和”安徽“之間同時(shí)具有”位于“和”省會(huì)“兩個(gè)關(guān)系,即一個(gè)文本中的實(shí)體對(duì)之間事實(shí)上可以存在多個(gè)不同的關(guān)系。因此,在不考慮發(fā)現(xiàn)未知的新關(guān)系時(shí),我們可以將關(guān)系抽取定義成一個(gè)「給定實(shí)體對(duì)」情況下的「多標(biāo)簽分類」(multi-label classification) 任務(wù),其中的標(biāo)簽即為實(shí)體對(duì)之間的關(guān)系。

關(guān)系抽取的難點(diǎn)

從上一節(jié)對(duì)關(guān)系抽取任務(wù)的定義可以看出,要訓(xùn)練一個(gè)關(guān)系抽取模型,數(shù)據(jù)中應(yīng)同時(shí)包含對(duì)實(shí)體對(duì)和關(guān)系的標(biāo)注。實(shí)體的標(biāo)注對(duì)應(yīng)了實(shí)體識(shí)別任務(wù),目前可以通過(guò)較為成熟的命名實(shí)體識(shí)別 (NER) 等技術(shù)來(lái)進(jìn)行高質(zhì)量自動(dòng)標(biāo)注。但關(guān)系的標(biāo)注通常較為困難,一些句子中甚至不會(huì)顯式的出現(xiàn)定義好的關(guān)系的相近描述。如“合肥是安徽的省會(huì)”一句中事實(shí)上是蘊(yùn)含了“位于”這一關(guān)系,但句子中并沒(méi)有顯式地出現(xiàn)“位于”的相關(guān)描述,我們需要通過(guò)一些人類的常識(shí)進(jìn)行推斷。因此,在構(gòu)建精確標(biāo)注的關(guān)系抽取數(shù)據(jù)集時(shí),大量人工標(biāo)注通常是必不可少的,這就導(dǎo)致數(shù)據(jù)集的構(gòu)建成本非常高昂。

此外,如 Mintz 等人指出,在特定領(lǐng)域的語(yǔ)料上進(jìn)行關(guān)系標(biāo)注而訓(xùn)練得到的關(guān)系抽取模型通常具有偏置 (bias) [2]。比如,發(fā)表于 ACL2020 的一篇文章 [3] 中對(duì)關(guān)系抽取中存在的性別偏見(jiàn) (Gender Bias) 進(jìn)行了討論,感興趣的讀者可以去讀一下這篇文章。

在上文中我們提到了僅利用給定語(yǔ)料上精確標(biāo)注數(shù)據(jù)集進(jìn)行關(guān)系抽取模型訓(xùn)練存在的兩個(gè)問(wèn)題,即「標(biāo)注成本高」和存在「偏置」。那么該怎樣解決這些問(wèn)題呢?

標(biāo)注成本高問(wèn)題

如果我們繼續(xù)采用監(jiān)督學(xué)習(xí) (supervised learning) 來(lái)對(duì)模型進(jìn)行訓(xùn)練,那這個(gè)問(wèn)題就很難回避。盡管我們可以通過(guò)少樣本學(xué)習(xí) (few shot learning) 等技術(shù)來(lái)充分利用已有的少量精確標(biāo)注數(shù)據(jù),但這些標(biāo)注本身就更容易產(chǎn)生偏置,這就會(huì)導(dǎo)致第二個(gè)問(wèn)題變得更加突出。

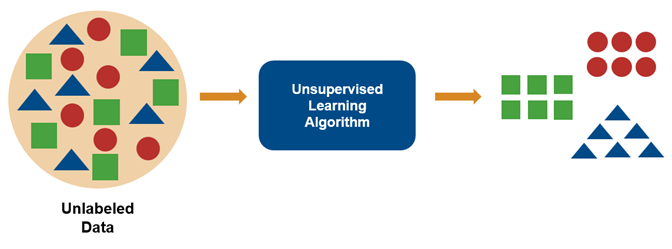

因此,要想從根本上緩解標(biāo)注成本高問(wèn)題,我們應(yīng)該考慮放棄監(jiān)督學(xué)習(xí),轉(zhuǎn)而采用弱監(jiān)督、無(wú)監(jiān)督,或者探索一種新的學(xué)習(xí)方式。

偏置問(wèn)題

偏置問(wèn)題產(chǎn)生的主要原因是在若干個(gè)特定領(lǐng)域的標(biāo)注語(yǔ)料庫(kù)上進(jìn)行訓(xùn)練,因此解決偏置問(wèn)題最簡(jiǎn)單粗暴的做法自然是選擇覆蓋面較廣的數(shù)據(jù)。幸運(yùn)地是,我們并不缺少這種數(shù)據(jù):現(xiàn)在網(wǎng)絡(luò)、書刊等媒體上充斥著大量文本,這些文本獲取成本低且覆蓋領(lǐng)域廣,如果能夠有效利用這些數(shù)據(jù),那偏置問(wèn)題將在很大程度上得到緩解。然而,這些數(shù)據(jù)又轉(zhuǎn)而面臨標(biāo)注成本高問(wèn)題。

遠(yuǎn)程監(jiān)督

為同時(shí)解決以上兩個(gè)問(wèn)題,Mintz 等人于 2009 年提出一種能夠在未經(jīng)精確標(biāo)注的文本上進(jìn)行關(guān)系抽取的新學(xué)習(xí)框架---「遠(yuǎn)程監(jiān)督」(distant supervision) [2]。

何為遠(yuǎn)程監(jiān)督

遠(yuǎn)程監(jiān)督通過(guò)文本之外的、由大量實(shí)體對(duì)與關(guān)系構(gòu)成的知識(shí)庫(kù)來(lái)對(duì)文本進(jìn)行關(guān)系標(biāo)注。其中,“遠(yuǎn)程”可以理解為利用了文本之外的知識(shí)庫(kù),而“監(jiān)督”可以理解為提供了關(guān)系標(biāo)簽(即監(jiān)督信息)。

遠(yuǎn)程監(jiān)督的基本假設(shè)

遠(yuǎn)程監(jiān)督具有如下假設(shè) [2]:

「如果一對(duì)實(shí)體之間具有某種關(guān)系,那么所有包含這對(duì)實(shí)體的句子都將表達(dá)這個(gè)關(guān)系的含義。」

因此,對(duì)于一個(gè)已經(jīng)識(shí)別出某實(shí)體對(duì)的句子,知識(shí)庫(kù)中所有該實(shí)體對(duì)之間具有的關(guān)系都可以被看成句子的標(biāo)簽。

遠(yuǎn)程監(jiān)督的基本流程

從上文介紹中可以看出,利用遠(yuǎn)程監(jiān)督進(jìn)行關(guān)系抽取模型的學(xué)習(xí),我們只需要收集文本,在文本中識(shí)別實(shí)體對(duì),然后與知識(shí)庫(kù)中進(jìn)行比對(duì)以標(biāo)注關(guān)系即可。需要注意,根據(jù)遠(yuǎn)程監(jiān)督的基本假設(shè),實(shí)體對(duì)之間所有能夠成立的關(guān)系都會(huì)成為句子的標(biāo)簽。其基本流程可用下例來(lái)表示。

很明顯,遠(yuǎn)程監(jiān)督方法極大地?cái)U(kuò)充了關(guān)系抽取能夠利用的數(shù)據(jù)量,其標(biāo)注成本極低,覆蓋面可以極廣。如果標(biāo)注的每個(gè)句子都是正確的,那么問(wèn)題就歸結(jié)于一個(gè)相對(duì)較為簡(jiǎn)單的文本分類任務(wù)。

但是,細(xì)心的讀者可能已經(jīng)發(fā)現(xiàn)了,我們假定存在給定實(shí)體對(duì)的句子就能表示這對(duì)實(shí)體之間的所有關(guān)系,這勢(shì)必會(huì)「引入錯(cuò)誤的標(biāo)注」。如“合肥”和“安徽”之間同時(shí)存在“位于”、“是省會(huì)”兩個(gè)關(guān)系,那對(duì)于“合肥位于安徽”這一句子,我們也會(huì)同時(shí)給他標(biāo)注“位于”和“是省會(huì)”兩個(gè)關(guān)系。但很明顯,這句話并沒(méi)有表達(dá)”是省會(huì)“這一關(guān)系的含義。如果模型在這錯(cuò)誤的標(biāo)注上進(jìn)行訓(xùn)練并將這個(gè)模式“記住”,即”A位于B“蘊(yùn)含了A是B的省會(huì),那在遇到”黃山位于安徽“這一句子時(shí),它就會(huì)認(rèn)為”黃山“和”安徽“之間也具有”是省會(huì)“這一關(guān)系,這明顯是不合理的。因此,利用遠(yuǎn)程監(jiān)督進(jìn)行關(guān)系抽取的關(guān)鍵在于「如何消除錯(cuò)誤標(biāo)注樣本對(duì)模型訓(xùn)練的影響」。

遠(yuǎn)程監(jiān)督關(guān)系抽取模型

為了消除錯(cuò)誤標(biāo)注樣本的影響,遠(yuǎn)程監(jiān)督關(guān)系抽取模型主要采用了兩種方法:錯(cuò)誤標(biāo)注樣本「篩除」法和錯(cuò)誤標(biāo)注樣本「轉(zhuǎn)正確標(biāo)注」法。

在本節(jié)中,我們將從上述兩種方法出發(fā)簡(jiǎn)單介紹幾個(gè)經(jīng)典的模型。受篇幅限制,我們?cè)诒疚闹袃H介紹這些模型的核心思路,技術(shù)細(xì)節(jié)請(qǐng)參照原文。因此類模型大都考慮句子級(jí)文本,在下文中涉及到數(shù)據(jù)的描述時(shí)我們不再對(duì)“句子”和“文本”進(jìn)行區(qū)分。

錯(cuò)誤標(biāo)注樣本篩除

PCNN

可以設(shè)想,在遠(yuǎn)程監(jiān)督框架下,如果我們每次都將一個(gè)帶標(biāo)注的句子作為模型訓(xùn)練的樣本,那甚至可以說(shuō)訓(xùn)練過(guò)程中所使用的大部分樣本都是被錯(cuò)誤標(biāo)注的,這將會(huì)極大地影響模型在實(shí)際應(yīng)用中的效果。

因此,Zeng 等 在 PCNN [4] 一文中提出將多實(shí)例學(xué)習(xí) (multi-instance learning) 應(yīng)用于遠(yuǎn)程監(jiān)督中。其采用 expressed-at-least-once [5] 假設(shè):

「當(dāng)一對(duì)實(shí)體之間存在某個(gè)關(guān)系,那么包含這對(duì)實(shí)體的句子中至少有一個(gè)能夠表達(dá)這個(gè)關(guān)系。」

在上述假設(shè)下,Zeng 等不再將帶標(biāo)注的句子逐個(gè)送入模型進(jìn)行訓(xùn)練,而是將具有相同實(shí)體對(duì)和關(guān)系標(biāo)注的所有(也可以是一部分,但直觀上來(lái)講越多越好)句子看成一個(gè)整體,稱為「包 (bag)」,然后將標(biāo)注的關(guān)系作為整個(gè)包的標(biāo)簽進(jìn)行訓(xùn)練。如下圖

這樣一來(lái),即便存在句子是被錯(cuò)誤標(biāo)注為了某關(guān)系的,但包中有這么多句子,我們總能找到一個(gè)句子是具有這個(gè)關(guān)系的吧!再退一步,就算包中所有句子都不表達(dá)所標(biāo)注的關(guān)系,那結(jié)果也不會(huì)變得更壞了。因此從整體上來(lái)看,錯(cuò)誤標(biāo)注的幾率被降低。

顯然,接下來(lái)的工作就是如何「從包中選擇」出那個(gè)被正確標(biāo)注的樣本來(lái)進(jìn)行接下來(lái)的訓(xùn)練了。PCNN 一文中采取的方式是挑選使得條件概率 p(包的標(biāo)簽|句子) 最大的那個(gè)句子作為正確標(biāo)注樣本,具體實(shí)現(xiàn)細(xì)節(jié)在此不再贅述。

其他模型

PCNN 每次只選取包中一個(gè)句子作為正確標(biāo)注樣本的做法存在一個(gè)問(wèn)題:如果包中有多個(gè)句子是被正確標(biāo)注的,那么它們中的大部分都將被舍棄,從而造成了數(shù)據(jù)的浪費(fèi)。為此,一系列基于「注意力機(jī)制」(attention mechanism) 的模型被提出 [6,7,8],它們通過(guò)對(duì)包中的句子進(jìn)行注意力權(quán)重的分配來(lái)同時(shí)選擇多個(gè)句子。若包中存在多個(gè)被正確標(biāo)注的句子,那么它們的注意力權(quán)重都會(huì)較高,從而都會(huì)在最終關(guān)系預(yù)測(cè)中發(fā)揮作用;此外,被正確標(biāo)注的置信度(即注意力權(quán)重)越高,發(fā)揮的作用將越大。這種軟選擇 (soft selection) 機(jī)制有效地緩解了 PCNN 中硬選擇 (hard selection) 帶來(lái)的數(shù)據(jù)浪費(fèi)問(wèn)題,從而可能在相同樣本量的情況下達(dá)到更高的性能。

錯(cuò)誤標(biāo)注樣本轉(zhuǎn)正確標(biāo)注

無(wú)論怎樣進(jìn)行樣本的篩選,部分確定被錯(cuò)誤標(biāo)注的樣本總是可以被看成在數(shù)據(jù)集中剔除掉了。那么,這些錯(cuò)誤標(biāo)注的樣本真的對(duì)遠(yuǎn)程監(jiān)督關(guān)系抽取不起作用嗎?(此句借用了 Shang 等論文 [9] 的題目)至少在一些論文的作者看來(lái),答案是否定的。

比如,Shang 等 [9] 利用無(wú)監(jiān)督聚類的方法來(lái)為錯(cuò)誤標(biāo)注的樣本重新分配新的標(biāo)簽;而 Wu 等 [10] 認(rèn)為每個(gè)句子的現(xiàn)有標(biāo)注和其應(yīng)有標(biāo)注之間存在映射關(guān)系,于是通過(guò)學(xué)習(xí)轉(zhuǎn)移矩陣來(lái)模擬該映射,進(jìn)而將每個(gè)句子的標(biāo)注都轉(zhuǎn)換成其應(yīng)有標(biāo)注。

通過(guò)將錯(cuò)誤標(biāo)注樣本轉(zhuǎn)換為正確標(biāo)注,此類模型在一定程度上擴(kuò)充了數(shù)據(jù)量,也為提升關(guān)系抽取的質(zhì)量提供了新的可能性。但要注意的是,轉(zhuǎn)換后的樣本標(biāo)注可能還是錯(cuò)的,有時(shí)仍需要進(jìn)行進(jìn)一步的篩選。

總結(jié)

在不考慮發(fā)現(xiàn)未知的新關(guān)系時(shí),關(guān)系抽取本質(zhì)上是一個(gè)多標(biāo)簽分類任務(wù)。但因任務(wù)的特殊性,關(guān)系抽取常面臨標(biāo)注數(shù)據(jù)不足等問(wèn)題。遠(yuǎn)程監(jiān)督的提出在一定程度上解決了這些問(wèn)題,但它同時(shí)也引入了錯(cuò)誤標(biāo)注樣本。因此,如何在存在錯(cuò)誤標(biāo)注樣本的數(shù)據(jù)上學(xué)習(xí)一個(gè)優(yōu)秀的分類器成為遠(yuǎn)程監(jiān)督關(guān)系抽取模型的關(guān)鍵。

[1] Ji, S., Pan, S., Cambria, E., Marttinen, P., & Yu, P. S. (2020). A Survey on Knowledge Graphs: Representation, Acquisition and Applications. arXiv preprint arXiv:2002.00388.

[2] Mintz, M., Bills, S., Snow, R., & Jurafsky, D. (2009). Distant supervision for relation extraction without labeled data. Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP: Volume 2 - ACL-IJCNLP ’09, 2(2005), 1003.

[3] Gaut, A., Sun, T., Tang, S., Huang, Y., Qian, J., ElSherief, M., Zhao, J., Mirza, D., Belding, E., Chang, K.-W., & Wang, W. Y. (2020). Towards Understanding Gender Bias in Relation Extraction. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, 1(1), 2943–2953.

[4] Zeng, D., Liu, K., Chen, Y., & Zhao, J. (2015). Distant supervision for relation extraction via Piecewise Convolutional Neural Networks. Conference Proceedings - EMNLP 2015: Conference on Empirical Methods in Natural Language Processing, September, 1753–1762.

[5] Riedel, S., Yao, L., & McCallum, A. (2010). Modeling relations and their mentions without labeled text. Lecture Notes in Computer Science (Including Subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics), 6323 LNAI(PART 3), 148–163.

[6] Lin, Y., Shen, S., Liu, Z., Luan, H., & Sun, M. (2016). Neural relation extraction with selective attention over instances. 54th Annual Meeting of the Association for Computational Linguistics, ACL 2016 - Long Papers, 4, 2124–2133.

[7] Han, X., Yu, P., Liu, Z., Sun, M., & Li, P. (2018). Hierarchical relation extraction with coarse-to-fine grained attention. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, EMNLP 2018, 2236–2245.

[8] Ye, Z.-X., & Ling, Z.-H. (2019). Distant Supervision Relation Extraction with Intra-Bag and Inter-Bag Attentions. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, 1, 2810–2819.

[9] Shang, Y., Huang, H.-Y., Mao, X.-L., Sun, X., & Wei, W. (2020). Are Noisy Sentences Useless for Distant Supervised Relation Extraction? Proceedings of the AAAI Conference on Artificial Intelligence, 34(05), 8799–8806.

[10] Wu, S., Fan, K., & Zhang, Q. (2019). Improving Distantly Supervised Relation Extraction with Neural Noise Converter and Conditional Optimal Selector. Proceedings of the AAAI Conference on Artificial Intelligence, 33, 7273–7280.

作者簡(jiǎn)介:張占秋,2018年畢業(yè)于中國(guó)科學(xué)技術(shù)大學(xué)數(shù)學(xué)科學(xué)學(xué)院,獲得理學(xué)學(xué)士學(xué)位。現(xiàn)于中國(guó)科學(xué)技術(shù)大學(xué)電子工程與信息科學(xué)系的 MIRA Lab 實(shí)驗(yàn)室攻讀博士生,師從王杰教授。研究興趣包括知識(shí)圖譜與自然語(yǔ)言處理。

責(zé)任編輯:xj

原文標(biāo)題:遠(yuǎn)程監(jiān)督在關(guān)系抽取中的應(yīng)用

文章出處:【微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

人工智能

+關(guān)注

關(guān)注

1804文章

48717瀏覽量

246525 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8492瀏覽量

134092 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122484

原文標(biāo)題:遠(yuǎn)程監(jiān)督在關(guān)系抽取中的應(yīng)用

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

使用MATLAB進(jìn)行無(wú)監(jiān)督學(xué)習(xí)

BP神經(jīng)網(wǎng)絡(luò)與深度學(xué)習(xí)的關(guān)系

AI自動(dòng)化生產(chǎn):深度學(xué)習(xí)在質(zhì)量控制中的應(yīng)用

深度學(xué)習(xí):遠(yuǎn)程監(jiān)督在關(guān)系抽取中的應(yīng)用

深度學(xué)習(xí):遠(yuǎn)程監(jiān)督在關(guān)系抽取中的應(yīng)用

評(píng)論