人工智能(AI)最初只是實驗室研究,但如今機器學習和深度學習等人工智能技術正越來越多地應用到現實世界中,例如檢測金融交易中的欺詐行為、分析零售數據以提供個性化的購物體驗,或者找到運輸工具的最佳路線。

這些趨勢意味著人工智能正迅速成為許多企業工作流程中不可或缺的一部分,從電子郵件到CRM或ERP,尤其是數據分析,從組織自身的數據集中收集商業智能見解,以提高效率,甚至創造新的商業機會。

這并不奇怪,IDC最近的一項調查顯示,85%的企業正在評估人工智能或已經在生產中使用人工智能。然而,IDC發現,大多數組織報告說,在他們的人工智能項目中,有四分之一的機構報告說,失敗率高達50%。這些失敗都歸因于缺乏熟練員工或文化上的挑戰,但另一個常見的失敗原因是無法從概念驗證項目擴展到能夠服務于整個組織的生產能力。

退一步講,重要的是要區分那些投資于人工智能以獲得顯著的戰略優勢或可能重塑其整個商業模式的組織,而不是那些僅僅尋求簡化運營或使用人工智能來自動化某些任務的組織。對于后者,基于云的AI功能生態系統已經興起,可以通過API進行訪問并將其集成到業務工作流程中。

另一類公司則以電子商務巨頭阿里巴巴(Alibaba)分拆出來的一家銀行為例,該銀行使用人工智能來管理其所有金融服務,在貸款審批等流程方面,它的速度比競爭對手快得多,而且員工人數只占其一小部分。正如《哈佛商業評論》(Harvard Business Review)所詳述的,這家新銀行的核心是一個基于人工智能的“決策工廠”,它將決策視為一門科學,利用數據來推動預測和洞察,從而指導和自動化公司的運營工作流程。

對于這類業務,實施你的人工智能戰略首先要有正確的數據,并且要理解如何使用它。這意味著不僅要雇傭數據科學家,還要雇傭數據戰略家,他們是能夠將業務問題轉化為分析解決方案和見解的專業人士。

人工智能是建立在數據基礎上的

大量的數據是開發機器學習(ML)或深度學習(DL)算法的最終根本。您在模型上投入的樣本數據越多,就可以將模型“訓練”得越好,并且其輸出越準確可靠。結果是,與傳統的企業IT環境相比,為AI項目存儲和處理數據通常需要與高性能計算(HPC)安裝有更多共同點的硬件。

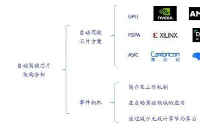

訓練一個深度學習模型或分析大量數據需要大量的處理能力。這可以通過使用一堆服務器和高端處理器芯片并行處理問題來實現。但更有效的解決方案是求助于專門的加速器,如GPU,或圖形處理單元。

GPU之所以得名,是因為它們最初是3D圖形的加速器,需要數百萬次重復計算才能渲染圖像。因此,它們具有使用數百個簡單處理核心的大規模并行體系結構,事實證明,它們也適用于AI模型所涉及的計算。

例如,谷歌發現一個僅用于48個Nvidia GPU即可處理用于在線圖像識別的AI系統,該系統需要16,000個CPU。

這并不意味著GPU會完全取代用于AI工作負載的計算基礎架構中的CPU。在許多情況下,仍然需要CPU來處理應用程序邏輯和其他數據科學計算,因此在大多數情況下,結合使用CPU和GPU的計算節點將被證明是最佳解決方案。

存儲源計算

與傳統的HPC體系結構一樣,獲得最佳性能的關鍵是保持計算節點及其gpu以足夠高的速率接收數據,以使它們保持忙碌,這意味著存儲基礎結構在提供所需的性能級別方面起著至關重要的作用。正確的數據存儲系統必須提供高吞吐量,以防止昂貴的gpu閑置,但它也必須具有靈活性和可擴展性。

更復雜的是,不同的AI工作負載將以讀寫數據的方式顯示不同的訪問模式,存儲層需要能夠處理所有這些模式。ML訓練工作負載往往遵循一種不可預測的訪問模式,例如,生成大量的讀寫操作,這些讀寫操作可能包括大小不等的隨機訪問和順序訪問,存儲層必須能夠吸收這些數據并提供高吞吐量。

當訓練數據集足夠小時,例如在試驗性部署中,它可能被緩存在本地內存中,或者從小型計算節點群集中的本地閃存驅動器(SSD)中提供服務,這可以提供足夠的性能級別,特別是當閃存SSD是NVMe驅動器時。

NVMe是一種存儲標準,它使用高速PCIe總線將SSD直接鏈接到系統中的處理器,而不是傳統接口(如SAS或SATA)。它還指定了一種新的高效協議,可以減少軟件開銷,從而最大限度地提高閃存提供的低延遲。NVMe的一個關鍵特性是支持多個I/O隊列(最多65535個),從而使閃存能夠并行處理多個請求。這利用了NAND存儲設備的內部并行性,并允許比SAS或SATA高得多的原始吞吐量。

然而,擴展這樣一個試驗性部署來支持生產性人工智能用例所需的大量數據是困難的和/或昂貴的,這可能是一些人工智能項目無法超越概念驗證階段的原因。

成本也是一個因素。許多全閃存存儲體系結構都依賴于單獨的對象存儲池或類似的存儲池來保存訪問頻率較低的冷數據。相比之下,存儲公司DDN有一個名為熱池的功能,用戶可以通過在用于熱數據的閃存層和用于冷數據的更大的旋轉磁盤層之間自動遷移數據,將所有內容保存在一個文件系統中。這降低了由于管理開銷而導致的成本,同時使所有數據更接近你的手邊。

加速任意規模的AI

這方面的一個很好的例子可以從DDN的加速、任意規模的AI(A3I)投資組合中看到,DDN是一家專門從事高性能存儲的公司。A3I系列是一套基于DDN EXAScaler系統的預配置設備,可選擇所有閃存NVMe SSD或閃存與硬盤驅動器存儲的混合,以提高存儲容量。

為了擴大規模,客戶只需添加額外的設備,每個AI200X/AI400X設備的閃存NVMe容量高達256TB,或AI7990X型號的混合存儲容量為4PB。每個文件系統都可以看作是一個構建塊,可以聚合成一個可以在容量、性能和功能上進行擴展的文件系統。

根據DDN,A3I設備針對所有類型的訪問模式和數據布局進行了優化,以確保GPU資源的充分利用。每個設備還具有多個高速主機接口,最多有8個HDR100 InfiniBand或100Gbit/s以太網端口。

AI基礎設施認證

認識到這一點,領先的GPU供應商Nvidia在其參考架構中將DDNA3I存儲與DGX A100系統結合在一起,DGX A100系統是一個專用的AI計算系統,其中包含八個最新的A100 Tensor Core GPU和一對AMD Epyc CPU。DGX A100系統的架構被設計為適用于所有AI工作負載的通用系統,可消耗高達192GB / s的大量數據。但是,四個并行工作的DDN AI400X存儲設備能夠使所有這些GPU完全存滿數據。

雖然DGX A100是相當新的產品,但是客戶已經在AI應用程序中將DDN存儲與Nvidia的舊DGX-1平臺一起使用。日本東北大學醫學大銀行組織(ToMMo)已實現DDN EXAScaler存儲,該存儲連接到運行Parabricks基因組分析軟件的基于DGX-1 GPU的分析服務器,作為其醫療超級計算機系統的一部分。

據該大學稱,這極大地提高了其分析能力和樣品量。因為由于能夠處理更大的數據集,所以以前只存在于理論上的方法現在變得可行,從而提高了數據分析的準確性。

不過教訓是,要使用A來I轉變業務運營,組織需要能夠處理大量數據。這反過來又意味著要建立一個能夠處理這些數據量的基礎設施,以及在不破壞銀行資金的情況下擴大對數據和計算資源的訪問的方法,以支持未來的增長。

希望通過采用全面的數據戰略來領先于競爭對手的公司需要確保自己不會在基礎架構方面承擔額外風險。選擇一家在要求最苛刻的數據密集型的環境中提供一系列解決方案方面具有豐富經驗的存儲供應商是一個明智的起點。

責任編輯:tzh

-

AI

+關注

關注

88文章

35194瀏覽量

280314 -

人工智能

+關注

關注

1807文章

49035瀏覽量

249786 -

機器學習

+關注

關注

66文章

8505瀏覽量

134677

發布評論請先 登錄

【「算力芯片 | 高性能 CPU/GPU/NPU 微架構分析」閱讀體驗】+NVlink技術從應用到原理

能效提升3倍!異構計算架構讓AI跑得更快更省電

iTOP-3588S開發板四核心架構GPU內置GPU可以完全兼容0penGLES1.1、2.0和3.2。

超越CPU/GPU:NPU如何讓AI“輕裝上陣”?

GPU渲染才是大勢所趨?CPU渲染與GPU渲染的現狀與未來

深度學習工作負載中GPU與LPU的主要差異

GPU會完全取代用于AI工作負載的計算基礎架構中的CPU?

GPU會完全取代用于AI工作負載的計算基礎架構中的CPU?

評論