來(lái)自復(fù)旦大學(xué)、上海市智能信息處理重點(diǎn)實(shí)驗(yàn)室和香港大學(xué)的研究者提出了一種基于 DINO 知識(shí)蒸餾架構(gòu)的分層級(jí)聯(lián) Transformer (HCTransformer) 網(wǎng)絡(luò)。

小樣本學(xué)習(xí)是指從非常少量的標(biāo)記數(shù)據(jù)中進(jìn)行學(xué)習(xí)的問(wèn)題,它有望降低標(biāo)記成本,實(shí)現(xiàn)低成本、快速的模型部署,縮小人類智能與機(jī)器模型之間的差距。小樣本學(xué)習(xí)的關(guān)鍵問(wèn)題是如何高效地利用隱藏在標(biāo)注數(shù)據(jù)中的豐富信息中進(jìn)行學(xué)習(xí)。近年來(lái),視覺(jué) Transformer (ViT [1]) 作為計(jì)算機(jī)視覺(jué)領(lǐng)域的新興架構(gòu),因其在很多主流任務(wù)中都取得了反超 CNN 的表現(xiàn)而受到廣泛關(guān)注。我們注意到 ViT 在訓(xùn)練時(shí)易于陷入過(guò)擬合的狀態(tài)而表現(xiàn)出較差的性能,現(xiàn)有的研究大部分關(guān)注其在大、中型數(shù)據(jù)集上的表現(xiàn),而幾乎沒(méi)有將其應(yīng)用于針對(duì)更加敏感于過(guò)擬合的小樣本任務(wù)上的相關(guān)研究。 ?

為了緩解這一問(wèn)題,提高小數(shù)據(jù)集下數(shù)據(jù)的利用效率,來(lái)自復(fù)旦大學(xué)、上海市智能信息處理重點(diǎn)實(shí)驗(yàn)室和香港大學(xué)的研究者提出了一種基于 DINO [2] 知識(shí)蒸餾架構(gòu)的分層級(jí)聯(lián) Transformer (HCTransformer) 網(wǎng)絡(luò),通過(guò)譜聚類 tokens 池化以利用圖像的內(nèi)在結(jié)構(gòu)來(lái)減少前景內(nèi)容和背景噪聲的模糊性,同時(shí)也提供了對(duì)不同數(shù)據(jù)集對(duì)于 patch token 切分大小的不同需求的適用性選擇;并利用一種非傳統(tǒng)的監(jiān)督方式,通過(guò)標(biāo)簽的潛在屬性在圖像標(biāo)簽中找到更豐富的視覺(jué)信息,而非簡(jiǎn)單地學(xué)習(xí)由標(biāo)簽分類的視覺(jué)概念。實(shí)驗(yàn)表明,本文的方法在各個(gè)流行的 Few-Shot Classification 數(shù)據(jù)集上均取得了 SOTA 性能。 ?

論文鏈接:https://arxiv.org/abs/2203.09064

代碼鏈接:https://github.com/StomachCold/HCTransformers

目前,這項(xiàng)研究已被 CVPR2022 接收,完整訓(xùn)練代碼及模型已經(jīng)開(kāi)源。 ? 方法

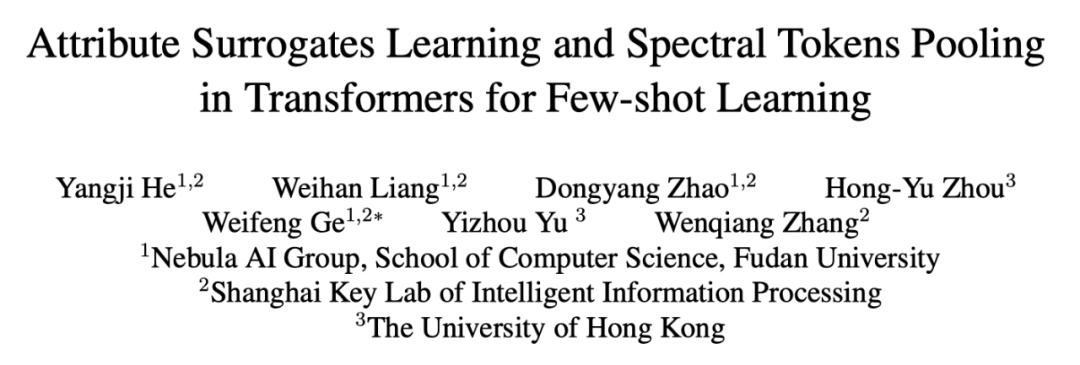

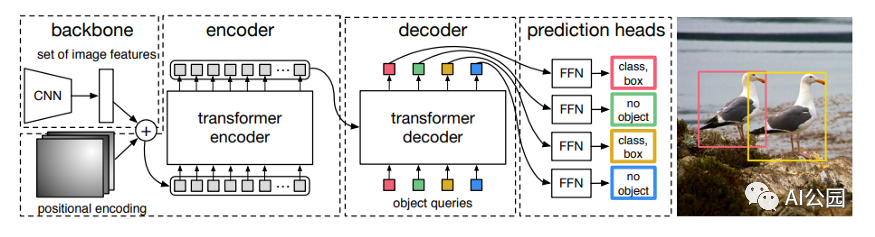

圖 1:方法整體架構(gòu)。包括三個(gè)級(jí)聯(lián)的 Transformer 網(wǎng)絡(luò),每一階段都是一個(gè) teacher-student 的知識(shí)蒸餾結(jié)構(gòu)。 ? DINO 自監(jiān)督架構(gòu) ? DINO 是一種基于知識(shí)蒸餾架構(gòu)的自監(jiān)督網(wǎng)絡(luò),和 BYOL [3] 類似,但 DINO 使用 Transformer 代替了 BYOL 中的 CNN。其中 Student 模型和 Teacher 模型的結(jié)構(gòu)是完全一樣的。 ? 在訓(xùn)練過(guò)程中,Teacher 模型并不通過(guò)輸入來(lái)更新參數(shù),它的權(quán)重更新是通過(guò)對(duì) Student 模型權(quán)重的 EMA(exponential moving average ) 來(lái)更新的。此外,Teacher 和 Student 都有獨(dú)立的數(shù)據(jù)增強(qiáng)方式。在這種設(shè)定下,整個(gè)網(wǎng)絡(luò)會(huì)把 Teacher 網(wǎng)絡(luò)的輸出當(dāng)作是 Student 網(wǎng)絡(luò)的標(biāo)簽,從而指導(dǎo)全局更新。因?yàn)榫W(wǎng)絡(luò)沒(méi)有直接使用圖片的類別標(biāo)簽,所以可以支持使用較高維度的特征(如 65536)而不必局限于圖像的類別數(shù)量,使得網(wǎng)絡(luò)可以學(xué)習(xí)到更加細(xì)膩的特征表示。但在自監(jiān)督的架構(gòu)下,由于小樣本學(xué)習(xí)的數(shù)據(jù)集較小,直接應(yīng)用 DINO 進(jìn)行訓(xùn)練很難取得較好的效果。 ?

屬性代理監(jiān)督

基于這一前提,本文設(shè)法將 DINO 改成有監(jiān)督模型,但 Transformer 在小數(shù)據(jù)集上直接使用 one-hot 向量作為標(biāo)簽,不僅需要將網(wǎng)絡(luò)輸出維度改成圖片類別數(shù)導(dǎo)致學(xué)習(xí)相對(duì)粗糙,而且會(huì)產(chǎn)生較嚴(yán)重的過(guò)擬合現(xiàn)象。因此,本文針對(duì)小樣本任務(wù),為 Transformer 設(shè)計(jì)了一種屬性代理監(jiān)督的傳播方案,以避免傳統(tǒng)監(jiān)督帶來(lái)的局限性。 ? 具體來(lái)說(shuō),對(duì)于標(biāo)簽空間中的每個(gè)視覺(jué)概念 y,我們的目標(biāo)是為其學(xué)習(xí)一個(gè)語(yǔ)義屬性的代理向量 ,進(jìn)而使同一個(gè)標(biāo)簽的輸出均向這個(gè)代理向量在向量空間中靠攏,也同時(shí)影響到該代理向量的更新。其中,y 是輸入數(shù)據(jù)的標(biāo)簽,D' 是整個(gè)網(wǎng)絡(luò)的輸出維度。 ?

,進(jìn)而使同一個(gè)標(biāo)簽的輸出均向這個(gè)代理向量在向量空間中靠攏,也同時(shí)影響到該代理向量的更新。其中,y 是輸入數(shù)據(jù)的標(biāo)簽,D' 是整個(gè)網(wǎng)絡(luò)的輸出維度。 ?

在 Transformer 中,輸入圖片在通過(guò) Encoder 后會(huì)得到一個(gè) class token 和 N 個(gè) patch tokens。一般來(lái)說(shuō)在分類任務(wù)中,只會(huì)單一使用某一種token作為最終輸出結(jié)果進(jìn)行監(jiān)督,而丟棄另一種token。相較于傳統(tǒng)設(shè)計(jì),本文將 class token 和 patch tokens 同時(shí)都用于監(jiān)督,以更大限度提高數(shù)據(jù)利用率。

Class Token 監(jiān)督

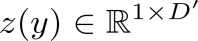

圖片輸入到 DINO 網(wǎng)絡(luò)中,會(huì)經(jīng)過(guò) encoder 后生成一個(gè) class token 和 N 個(gè)的 patch tokens,之后 class token 再通過(guò)一個(gè) MLP 得到最終的輸出。不同于傳統(tǒng)監(jiān)督方式,由于 DINO 本身的自監(jiān)督設(shè)計(jì),導(dǎo)致最終的輸出并不是一個(gè) one-hot 向量,而是一個(gè)更高維度的向量。因此我們?yōu)槊恳粋€(gè)標(biāo)簽設(shè)計(jì)了一個(gè)維度的可學(xué)習(xí)向量作為該類別的代理屬性,通過(guò) KL 散度將同一標(biāo)簽的輸出聚攏。

在公式 1 中, 是 student 網(wǎng)絡(luò)中的 class token 經(jīng)過(guò) MLP 的最終輸出,是該標(biāo)簽對(duì)應(yīng)的語(yǔ)義屬性代理向量。

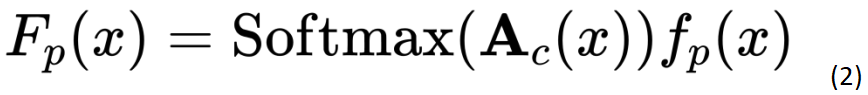

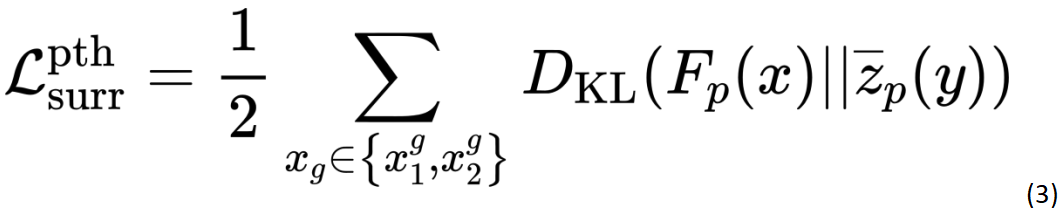

是 student 網(wǎng)絡(luò)中的 class token 經(jīng)過(guò) MLP 的最終輸出,是該標(biāo)簽對(duì)應(yīng)的語(yǔ)義屬性代理向量。 為 KL 散度計(jì)算。 ? Patch Tokens 監(jiān)督 ? 在 Transformer 中,由于缺少 patch 級(jí)別的標(biāo)簽信息,patch tokens 一般很難與 class token 同時(shí)用來(lái)監(jiān)督網(wǎng)絡(luò)。為了對(duì) patch tokens 進(jìn)行監(jiān)督,我們把 N 個(gè) patch tokens 用經(jīng)過(guò) softmax 操作后的注意力矩陣進(jìn)行加權(quán)合并計(jì)算,得到一個(gè)全局 token,然后采用和 class token 相同的監(jiān)督方式對(duì)該全局 token 進(jìn)行監(jiān)督。 ?

為 KL 散度計(jì)算。 ? Patch Tokens 監(jiān)督 ? 在 Transformer 中,由于缺少 patch 級(jí)別的標(biāo)簽信息,patch tokens 一般很難與 class token 同時(shí)用來(lái)監(jiān)督網(wǎng)絡(luò)。為了對(duì) patch tokens 進(jìn)行監(jiān)督,我們把 N 個(gè) patch tokens 用經(jīng)過(guò) softmax 操作后的注意力矩陣進(jìn)行加權(quán)合并計(jì)算,得到一個(gè)全局 token,然后采用和 class token 相同的監(jiān)督方式對(duì)該全局 token 進(jìn)行監(jiān)督。 ?

其中, 為 class token 對(duì)其他 patch tokens 的注意力矩陣,

為 class token 對(duì)其他 patch tokens 的注意力矩陣, 是 encoder 后輸出的 patch tokens,

是 encoder 后輸出的 patch tokens, 為加權(quán)合并后的全局 token。 ?

為加權(quán)合并后的全局 token。 ?

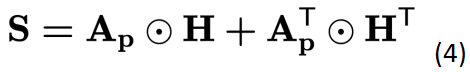

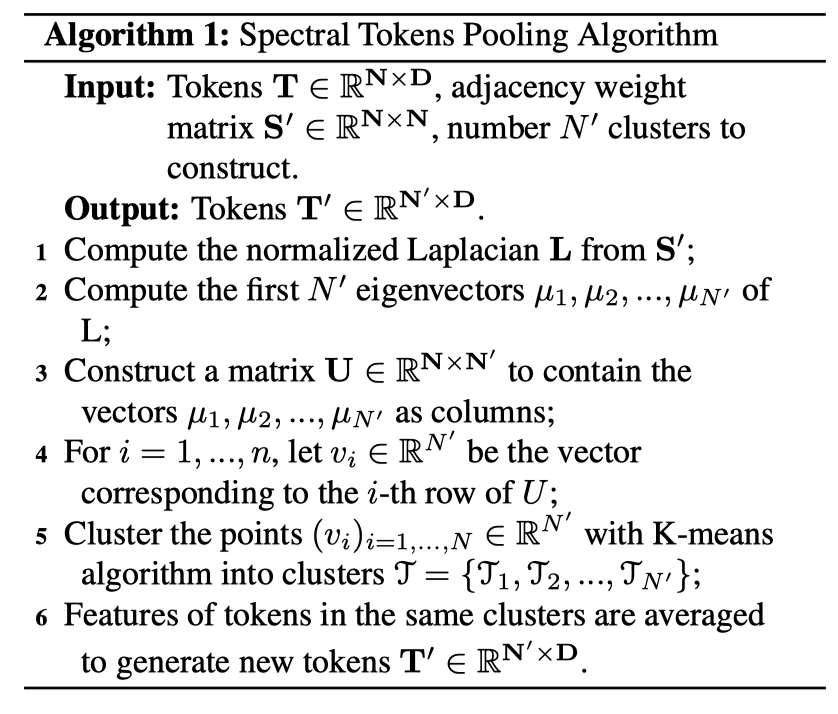

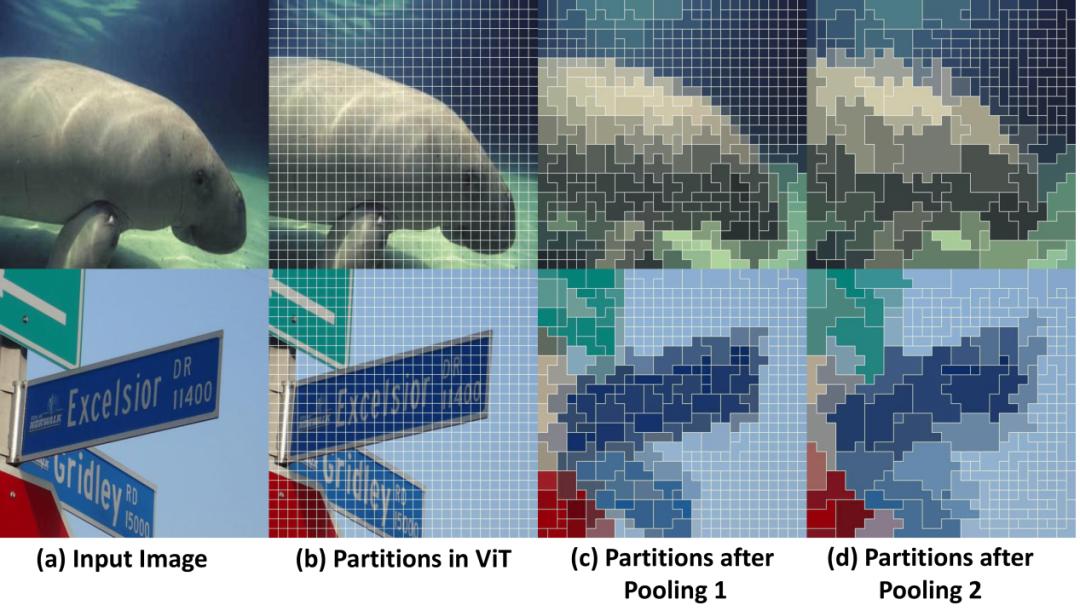

公式 3 與公式 1 采用相同的策略。 ? 譜聚類 tokens 池化 ? 許多工作, 如 GroupFPN [4] 和 GLOM [5] 都證明了多尺度層次結(jié)構(gòu)對(duì) CNN 和 Transformer 都有效。本文的設(shè)計(jì)目的是為了將層次結(jié)構(gòu)嵌入到 Transformer 中來(lái)提高網(wǎng)絡(luò)對(duì)特征的判別能力。與 Swin Transformer [4] 使用固定的網(wǎng)格池化方案不同,本文利用不規(guī)則網(wǎng)格池化方法來(lái)更靈活地匹配圖像結(jié)構(gòu)。由于 Transformer 將在 tokens 之間生成自注意力矩陣,因此它為譜聚類算法 [5] 提供了強(qiáng)大的先驗(yàn)經(jīng)驗(yàn),以根據(jù)語(yǔ)義相似性和空間布局對(duì) tokens 進(jìn)行分割合并。因此我們提出了一種基于譜聚類的池化方法,稱為譜聚類 tokens 池化。 ? 為了保持各 patch 之間原有的位置關(guān)系信息,本文對(duì)于 ViT 中的 N 個(gè) patch tokens 之間的注意力矩陣加上了鄰接限制,使每個(gè) patch 只和相鄰的 8 個(gè) patch 有相似性。 ?

其中,A_p 是 patch tokens 的注意力矩陣,H 是包含位置信息的鄰接矩陣。 然后我們對(duì) S 矩陣做一個(gè) softmax 操作得到我們最終需要的 S' 矩陣作為譜聚類 tokens 池化的輸入。 ?

如上算法所示,每一次池化后我們將得到同類聚類數(shù)量減半的新 tokens。 ? 在本文的網(wǎng)絡(luò)設(shè)計(jì)中,訓(xùn)練階段首先會(huì)訓(xùn)練第一階段的 Transformer 網(wǎng)絡(luò)來(lái)得到一個(gè)有較好表征能力的特征生成器,隨后再引入池化操作,加上二三階段 Transformer 共同訓(xùn)練。最終在三階段中通過(guò)驗(yàn)證集挑選出最優(yōu)結(jié)果作為最終輸出。 ?

圖 2:譜聚類池化的可視化圖 ?

實(shí)驗(yàn)結(jié)果

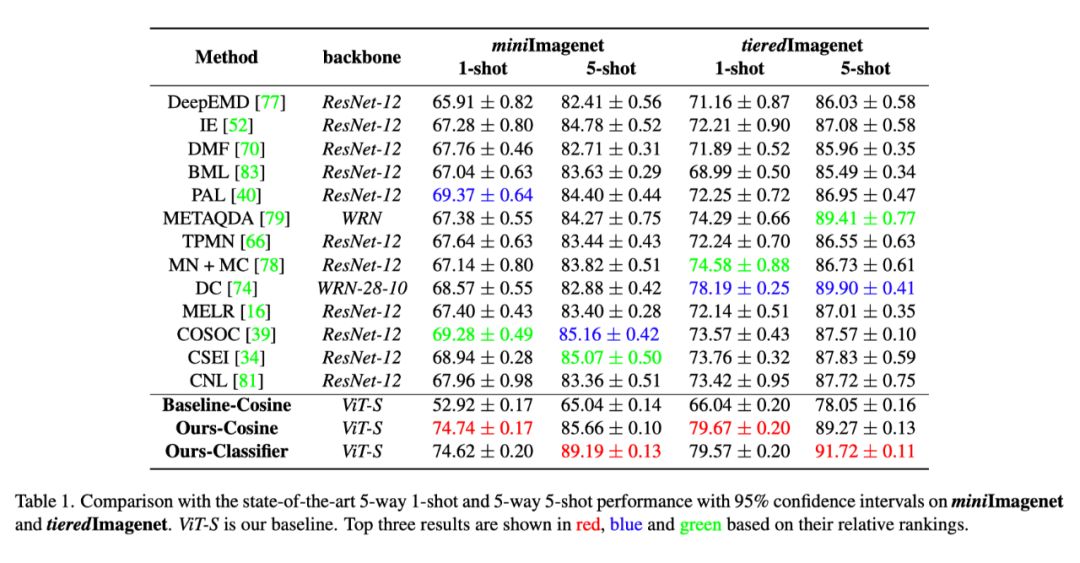

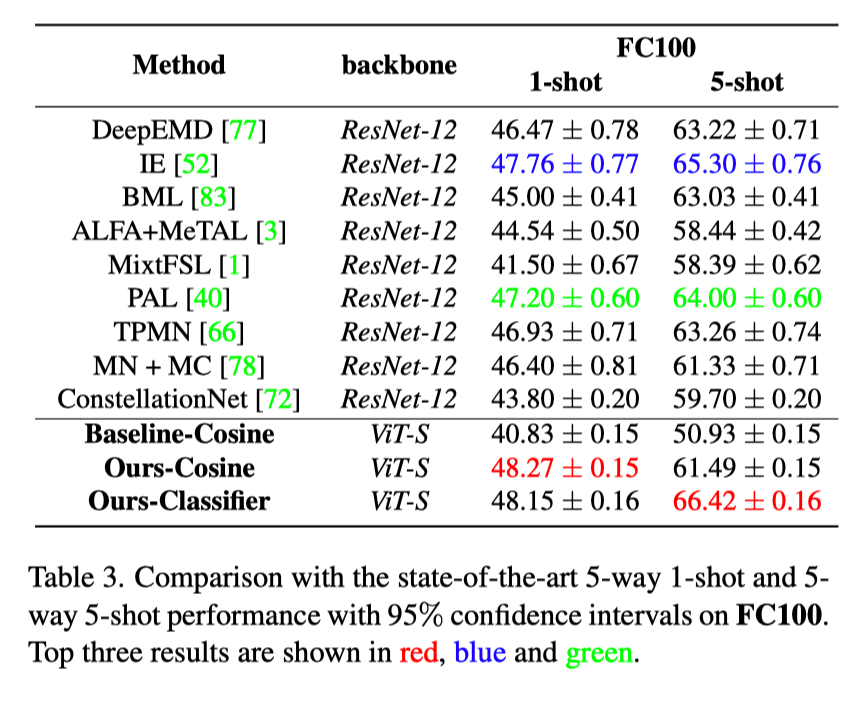

我們分別在四個(gè)流行的 Few-Shot Classification 數(shù)據(jù)集:mini-Imagenet, tiered-Imagenet, CIFAR-FS 和 FC100 上做了詳盡的實(shí)驗(yàn)。 ?

最終結(jié)果如表 1,2,3 所示:相比于現(xiàn)有的 SOTA 模型,HCTransformers 在 1-shot 和 5-shot 的結(jié)果上都顯示出明顯的性能優(yōu)勢(shì)。例如,如表 1 所示,在 miniImagnet 上,HCTransformers 比最優(yōu) SOTA 結(jié)果分別高出 5.37%(1-shot) 和 4.03%(5-shot)。在 tieredImagenet 上,我們的方法在 1-shot 和 5-shot 上的表現(xiàn)分別比最好的 DC [6] 方法高出 1.48% 和 1.81%。與 DC 相比,我們不需要從 base 訓(xùn)練集中借用類某類圖像的統(tǒng)計(jì)信息,并且使用更輕量級(jí)的分類器。此外,我們的方法和第三好的方法之間的差距是 5.09%,這也進(jìn)一步驗(yàn)證了我們的貢獻(xiàn)。 ? 這樣令人印象深刻的結(jié)果要?dú)w功于我們的網(wǎng)絡(luò)結(jié)構(gòu),它能學(xué)習(xí)到數(shù)據(jù)中固有的內(nèi)在信息,并具有良好的泛化能力。表 2 和表 3 分別顯示了在小分辨率數(shù)據(jù)集 CIFAR-FS 和 FC100 上的結(jié)果。HCTransformers 在這些低分辨率設(shè)置中顯示出和 SOTA 類似或更好的結(jié)果: 在 CIFAR-FS 上提高了 1.02%(1-shot) 和 0.76%(5-shot); 在 FC100 上提高了 0.51%(1-shot) 和 1.12%(5-shot)。在小分辨率數(shù)據(jù)集上,我們并沒(méi)有超越以前的 SOTA 方法很多,我們將其歸因于 ViT 的 patch 機(jī)制:當(dāng)圖像分辨率較小時(shí),如 32*32,每一個(gè) patch 所包含的實(shí)際像素過(guò)少,很難提取出有用的特征表示。DeepEMD [7] 的實(shí)驗(yàn)也佐證了 patch cropping 會(huì)對(duì)小分辨率圖像產(chǎn)生負(fù)面影響。即便如此,我們的方法仍然在這兩個(gè)基準(zhǔn)上都取得了新的 SOTA 結(jié)果。 ?

參考文獻(xiàn)

[1]. Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov,Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner,Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, and Neil Houlsby. An imageis worth 16x16 words: Transformers for image recognition at scale. In 9th International Conference on Learning Representations, ICLR 2021, Virtual Event, Austria, May 3-7, 2021.OpenReview.net,2021. 1, 2, 3, 7, 8

[2]. Mathilde Caron, Hugo Touvron, Ishan Misra, Herv′e J′egou, Julien Mairal, Piotr Bojanowski, and Armand Joulin. Emerging properties in self-supervised vision transformers. arXiv preprint arXiv:2104.14294, 2021. 3, 5

[3]. Jean-Bastien Grill, Florian Strub, Florent Altch′e, Corentin Tallec, Pierre H.Richemond, Elena Buchatskaya, Carl Doersch, Bernardo ′Avila Pires, Zhaohan Guo, Mohammad Gheshlaghi Azar, Bilal Piot, Koray Kavukcuoglu, R′emi Munos, and Michal Valko. Bootstrap your own latent-A new approach to self-supervised learning. In Hugo Larochelle, Marc’Aurelio Ranzato, Raia Hadsell, Maria- Florina Balcan, and Hsuan-Tien Lin, editors, Advances in Neural Information Processing Systems 33: Annual Conference on Neural Information Processing Systems 2020, NeurIPS 2020, December 6-12, 2020, virtual, 2020. 3

[4]. Gangming Zhao, Weifeng Ge, and Yizhou Yu. Graphfpn:Graph feature pyramid network for object detection. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 2763–2772, 2021. 1

[5]. Geoffrey Hinton. How to represent part-whole hierarchies in a neural network. arXiv preprint arXiv:2102.12627, 2021. 1

[6]. Ze Liu, Yutong Lin, Yue Cao, Han Hu, Yixuan Wei, Zheng Zhang, Stephen Lin, and Baining Guo. Swin transformer: Hierarchical vision transformer using shifted windows. International Conference on Computer Vision (ICCV), 2021. 2, 4

[7]. Andrew Y Ng, Michael I Jordan, and Yair Weiss. On spectral clustering: Analysis and an algorithm. In Advances in neural information processing systems, pages 849–856, 2002. 1, 5

[8]. Shuo Yang, Lu Liu, and Min Xu. Free lunch for few-shot learning: Distribution calibration. In International Conference on Learning Representations (ICLR), 2021. 6

[9]. Chi Zhang, Yujun Cai, Guosheng Lin, and Chunhua Shen. Deepemd: Few-shot image classification with differentiable earth mover’s distance and structured classifiers. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 2020. 6, 7, 8

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論