Shuler說:“傳感器融合是20世紀90年代出現(xiàn)的一種理念。你要把它變成機器可以處理的通用的數(shù)據(jù)格式。如果你在軍隊里,你擔(dān)心有人向你開槍。對于自動駕駛汽車而言,這就像面前有人推嬰兒車。所有這些系統(tǒng)都需要非常高的帶寬,并且都必須在其中內(nèi)置安全措施。最重要的是,你必須保護數(shù)據(jù),因為安全正在成為越來越大的問題。因此,你需要的是計算效率和編程效率。”

這是今天的許多設(shè)計中所缺少的,因為太多的開發(fā)是由現(xiàn)成的零件搭建的。

Cadence高級架構(gòu)師以及深度學(xué)習(xí)小組總監(jiān)Samer Hijazi說:“如果你優(yōu)化網(wǎng)絡(luò)、優(yōu)化問題、最小化位數(shù),并使用為卷積神經(jīng)網(wǎng)絡(luò)定制的硬件,那么你可以實現(xiàn)功率降低2~3倍的改進。效率來自軟件算法和硬件IP。”

谷歌正嘗試改變這個公式。谷歌開發(fā)了Tensor處理單元(TPU),這是專門為機器學(xué)習(xí)而創(chuàng)建的ASIC。為了加快AI的發(fā)展,谷歌在2015年開源了TensorFlow軟件。

其他公司擁有自己的平臺。但這些都不是最終產(chǎn)品。這是進化的過程,沒有人能確定未來十年AI將如何發(fā)展。部分是因為AI技術(shù)的使用案例正在逐漸被發(fā)現(xiàn)。在某個領(lǐng)域里有效的AI技術(shù)(如視覺處理)不一定適用于另一個領(lǐng)域(例如確定某種氣味是危險的還是安全的,抑或是二者的組合)。

NetSpeed Systems營銷和業(yè)務(wù)開發(fā)副總裁Anush Mohandass說:“我們在黑暗中摸索,我們知道如何做機器學(xué)習(xí)和人工智能,但卻不知道它們真正的工作方式。目前的方法是使用大量擁有不同計算能力和不同種類的計算引擎——用于神經(jīng)網(wǎng)絡(luò)應(yīng)用的CPU、DSP,你需要確定它是有效的。但這只是第一代AI。重點是計算能力和異構(gòu)性。”

然而,隨著問題的解決變得更有針對性,這有望改變。就像早期版本的物聯(lián)網(wǎng)器件一樣,沒有人知道各類市場如何演變,因此系統(tǒng)公司投入了一切,并使用現(xiàn)有的芯片技術(shù)將產(chǎn)品推向市場。在智能手表的案例中,結(jié)果是電池充電后只能續(xù)航幾個小時。隨著針對這些特定應(yīng)用的新芯片的開發(fā),功耗和性能會實現(xiàn)平衡,方法是更有針對性的功能、本地處理與云處理之間更智能的分布、以及對于設(shè)計中的瓶頸的更深入的理解這三者的結(jié)合。

ARM模型技術(shù)總監(jiān)Bill Neifert說:“我們的挑戰(zhàn)是找到未知的瓶頸和限制。但根據(jù)于工作負載,處理器與軟件的交互方式不同,軟件本質(zhì)上是并行應(yīng)用程序。因此,如果你正在考慮工作負載,如金融建模或天氣圖,它們強調(diào)基礎(chǔ)系統(tǒng)的方式是不同的。你只能通過深入探索來理解。”

Neifert指出,軟件方面需要解決的問題需要從更高層次的抽象來看,因為這使得它們更容易約束和修復(fù)。這是拼圖的一個關(guān)鍵部分。隨著AI進軍更多市場,所有這些技術(shù)都需要發(fā)展,以達到一般技術(shù)行業(yè),特別是半導(dǎo)體行業(yè)的同等效率。

Mohandass說:“現(xiàn)在我們發(fā)現(xiàn),如果他們只處理好一種類型的計算,那么架構(gòu)就會很困難。但異構(gòu)性的缺點是,將整體分而治之的方法變得土崩瓦解。因此,該解決方案通常涉及到超量供應(yīng)或供應(yīng)不足。”

新方法

隨著AI的應(yīng)用案例超越了自動駕駛汽車領(lǐng)域,其應(yīng)用將會擴展。

這就是為什么英特爾去年八月收購了Nervana。Nervana開發(fā)了2.5D深度學(xué)習(xí)芯片,該芯片利用高性能處理器內(nèi)核,將數(shù)據(jù)通過中介層移動到高帶寬內(nèi)存。 Nervana聲稱的目標是,與基于GPU的解決方案相比,該芯片訓(xùn)練深度學(xué)習(xí)模型的時間將縮短100倍。

eSilicon營銷副總裁Mike Gianfagna說:“這些看起來很像高性能計算芯片,本質(zhì)上是使用硅中介層的2.5D芯片。你將需要大量的吞吐量和超高帶寬內(nèi)存。我們已經(jīng)看到一些公司在關(guān)注它,但尚不足幾十家。它還為時尚早,實現(xiàn)機器學(xué)習(xí)和自適應(yīng)算法,以及如何將這些與傳感器和信息流整合,是非常復(fù)雜的。例如自動駕駛汽車,它從多個不同的來源串流數(shù)據(jù)并添加自適應(yīng)算法,以避免碰撞。”

Gianfagna表示,實現(xiàn)這些器件有兩個挑戰(zhàn)。其一是可靠性和認證。其二是安全。

對于AI,可靠性需要在系統(tǒng)級考慮,其中包括硬件和軟件。ARM在12月收購Allinea提供了一個參照。另一個參照來自斯坦福大學(xué),研究人員試圖量化來自軟件的裁剪計算的影響。他們發(fā)現(xiàn),大規(guī)模切割或修剪不會對最終產(chǎn)品產(chǎn)生顯著影響。加州大學(xué)伯克利分校已經(jīng)開發(fā)了一個類似的方法,基于的計算接近100%的準確率。

正在研究節(jié)能深度學(xué)習(xí)的斯坦福大學(xué)博士研究生韓松說“與精粒修剪相比,粗粒修剪不會降低精度。”他表示,斯坦福開發(fā)的稀疏矩陣要求計算減少10倍,內(nèi)存占用減少8倍,比DRAM的能耗減少120倍。它應(yīng)用于斯坦福所謂的高效語音識別引擎,壓縮導(dǎo)致了推理過程的加快。(Cadence最近的嵌入式神經(jīng)網(wǎng)絡(luò)峰會上提出了這些發(fā)現(xiàn)。)

量子計算為AI系統(tǒng)增加了另一個選擇。 Leti首席執(zhí)行官Marie Semeria表示,量子計算是她的團隊未來的方向之一,特別是AI應(yīng)用。IBM Research的科學(xué)與解決方案團隊副總裁Dario Gil解釋說,使用經(jīng)典計算,如果四張卡片三藍一紅,那么有四分之一的機會猜中那張紅色的卡片。使用量子計算機和量子比特的疊加和糾纏,通過扭轉(zhuǎn)糾纏,系統(tǒng)每次都會給出正確答案。

結(jié)論

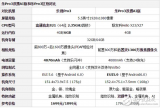

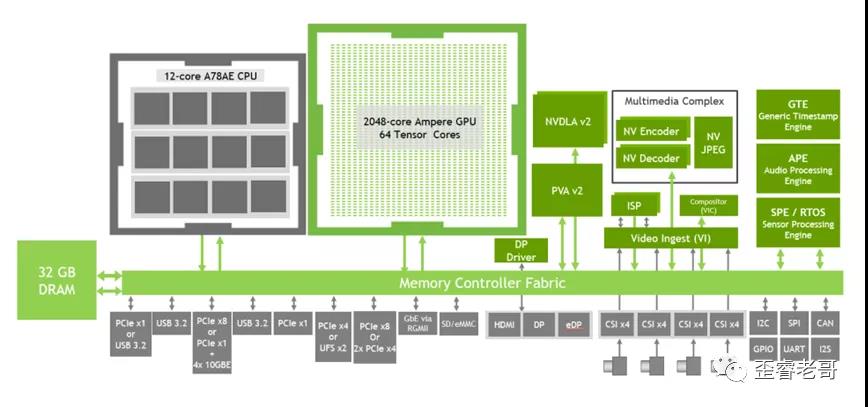

AI不是一件事,因此沒有單一的系統(tǒng)在任何地方都能完美地工作。但AI系統(tǒng)有一些通用要求,如下圖所示。

AI在許多市場都有應(yīng)用,所有這些都需要廣泛的改進、昂貴的工具,以及支持它們的生態(tài)系統(tǒng)。經(jīng)過多年來依靠萎縮器件來提高功率、性能和成本,如今整個市場部門都在重新思考如何進入新市場。這對于架構(gòu)師來說是一個巨大的勝利,這為設(shè)計團隊增加了巨大的創(chuàng)造性選擇,也將刺激從工具和IP供應(yīng)商一直到包裝和流程開發(fā)的巨大發(fā)展。這就像為技術(shù)行業(yè)按下了重啟按鈕,可以證明,這對于未來整個生態(tài)系統(tǒng)的業(yè)務(wù)都是有益的。

電子發(fā)燒友App

電子發(fā)燒友App

評論