人工智能 (AI) 可以追溯到古代,當(dāng)時(shí)的哲學(xué)家們編造出了許多關(guān)于人造實(shí)體如何被賦予人類智能或意識(shí)的寓言、神話和謠言。隨著大數(shù)據(jù)、機(jī)器學(xué)習(xí)、神經(jīng)網(wǎng)絡(luò)技術(shù)的不斷演進(jìn),AI 技術(shù)逐漸從遙遠(yuǎn)的寓言和神話中走入真實(shí)世界。

近幾十年來,AI 一直處于技術(shù)進(jìn)步的前沿,它被廣泛應(yīng)用于安防監(jiān)控、自動(dòng)駕駛、金融預(yù)測(cè)、醫(yī)療診斷、視頻游戲等領(lǐng)域。

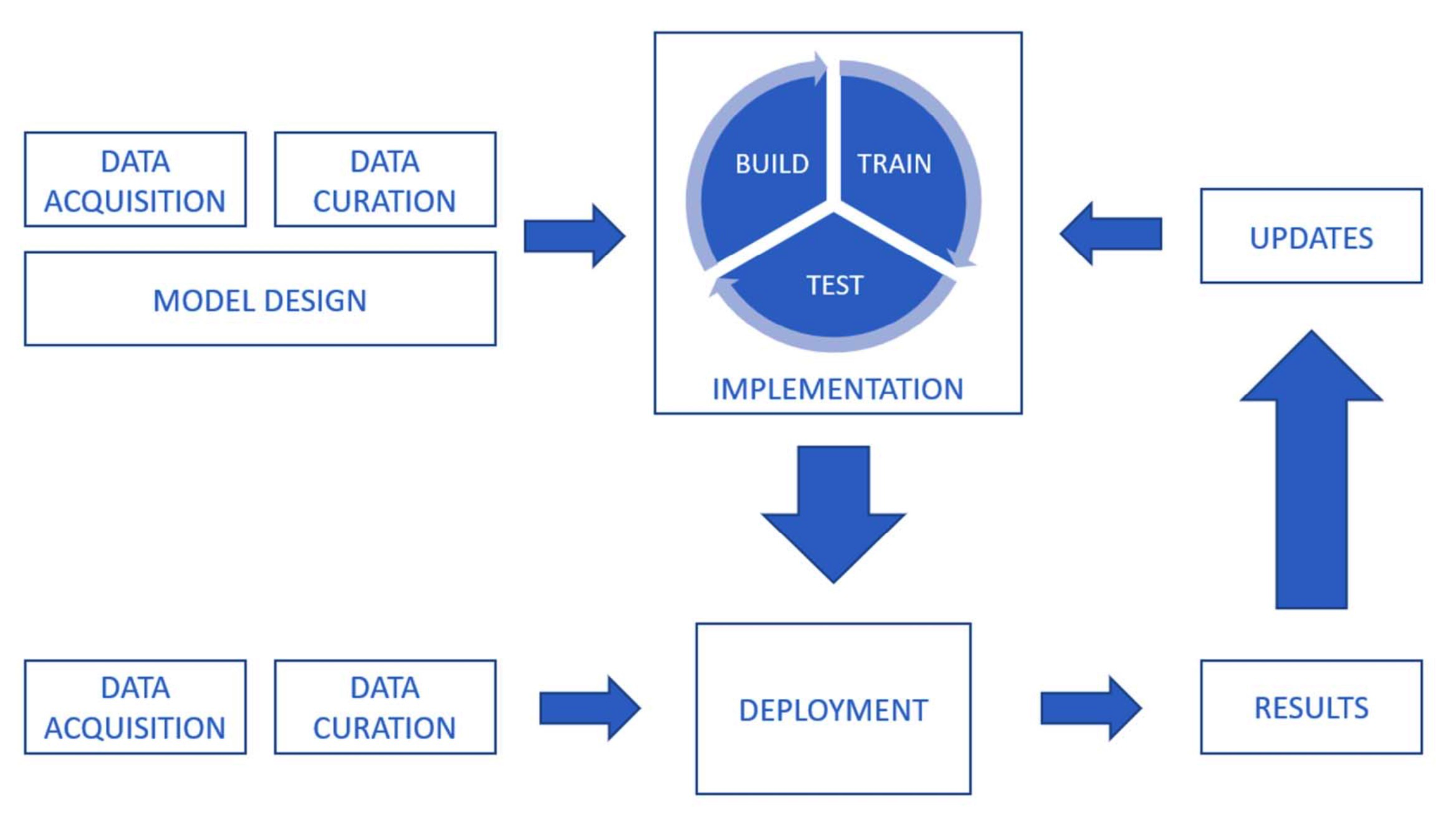

一些 AI 成果包括人臉識(shí)別、自然語言處理、語音識(shí)別、文本生成、語言翻譯、藥物開發(fā)等已經(jīng)深刻改變了人們對(duì)健康、生活、學(xué)習(xí)和其他方面的看法。毫無疑問,在未來,許多企業(yè)將依靠人工智能來提高效率和工作流程。

但是,在 AI 推動(dòng)生產(chǎn)效率的提升和產(chǎn)業(yè)的數(shù)字化轉(zhuǎn)型升級(jí)的同時(shí),它所帶來的技術(shù)風(fēng)險(xiǎn)和隱私倫理問題同樣值得警惕,黑客也在利用 AI 技術(shù)開發(fā)軟件程序并執(zhí)行隱形攻擊。

更重要的是,AI 技術(shù)本身也存在安全漏洞。當(dāng)前主流的深度神經(jīng)網(wǎng)絡(luò)等技術(shù)具有的“黑箱屬性”,導(dǎo)致 AI 算法存在不可解釋性。這也就意味著 AI 技術(shù)在算法安全性上存在著不確定因素,可能會(huì)在產(chǎn)業(yè)應(yīng)用落地中出現(xiàn)各種安全隱患和風(fēng)險(xiǎn)。

當(dāng)身處數(shù)字化轉(zhuǎn)型升級(jí)的各個(gè)產(chǎn)業(yè)正在享受這一波新的智能化技術(shù)紅利的時(shí)候,AI 安全問題,就如同網(wǎng)絡(luò)安全、信息安全一樣,被提上產(chǎn)業(yè)數(shù)字化建設(shè)的日程表了。

那么,如何部署 AI 技術(shù)才會(huì)更安全?我們?cè)撊绾畏婪独盟惴┒磳?duì) AI 系統(tǒng)進(jìn)行的惡意攻擊?在訓(xùn)練 AI 模型時(shí),如何保障數(shù)據(jù)的隱私和安全?帶著這些問題,我們采訪到了瑞萊智慧 RealAI 公司首席執(zhí)行官田天,請(qǐng)他來與我們聊一聊 AI 安全領(lǐng)域面臨的挑戰(zhàn)以及應(yīng)對(duì)之策。

以下為訪談實(shí)錄,經(jīng)編輯:

InfoQ:目前 AI 領(lǐng)域面臨的安全威脅都有哪些?

田天:前幾年大家更多關(guān)注的是,人工智能如何在場(chǎng)景中應(yīng)用起來,去提升生活質(zhì)量以及生產(chǎn)效率等等。但是近年來隨著人工智能開始應(yīng)用在很多高價(jià)值關(guān)鍵場(chǎng)景,比如金融、交通等領(lǐng)域,很多安全隱患開始逐步體現(xiàn)出來。我們關(guān)注到至少有三方面存在比較重大的安全隱患:

第一,模型算法本身的安全性、可靠性問題。現(xiàn)階段人工智能的發(fā)展很多都是基于深度學(xué)習(xí)、深度神經(jīng)網(wǎng)絡(luò)。隨著神經(jīng)網(wǎng)絡(luò)模型結(jié)構(gòu)越來越復(fù)雜,模型越來越大,參數(shù)越來越多。其實(shí)反過來講,神經(jīng)網(wǎng)絡(luò)模型也是一個(gè)越來越復(fù)雜、越來越難以理解的黑盒模型。然而黑盒模型就有可能存在一些難以被發(fā)現(xiàn)的錯(cuò)誤邏輯,或者說結(jié)構(gòu)性的算法漏洞、算法后門,黑客可以利用這些漏洞發(fā)起攻擊。

以目前大規(guī)模落地的人臉識(shí)別系統(tǒng)為例,人臉識(shí)別系統(tǒng)依靠海量人臉數(shù)據(jù)進(jìn)行特征提取、訓(xùn)練,進(jìn)而進(jìn)行識(shí)別,整個(gè)過程為黑箱模式,缺乏可解釋性,黑產(chǎn)分子可利用漏洞進(jìn)行多種模式的繞過與攻擊。例如對(duì)抗樣本攻擊,在人臉照片上添加少量干擾或?qū)?duì)抗補(bǔ)丁打印制作后由真人佩戴,就能欺騙人臉識(shí)別系統(tǒng)。除了人臉識(shí)別系統(tǒng),自動(dòng)駕駛汽車搭載的感知系統(tǒng)也同樣能夠被攻擊,比如障礙物上加裝干擾因素,改變表面顏色、修改形狀,就可能誤導(dǎo)感知算法,讓車輛無法感知到障礙物,這些都是算法層的安全漏洞,存在巨大的安全隱患。

第二,數(shù)據(jù)安全。人工智能的發(fā)展離不開大數(shù)據(jù),要構(gòu)造能力更強(qiáng)的人工智能,需要更多、更關(guān)鍵以及更高價(jià)值的數(shù)據(jù)。但是高價(jià)值數(shù)據(jù)往往與個(gè)人隱私信息,甚至商業(yè)機(jī)密信息相綁定。那么在落地 AI 的過程中,就可能在數(shù)據(jù)應(yīng)用或者流通環(huán)節(jié)造成信息泄露。比如近些年愈演愈烈的電信詐騙,源頭就來自于個(gè)人信息泄露,詐騙分子利用非法渠道獲取的隱私數(shù)據(jù)偽造身份信息實(shí)行欺詐。所以,如何在保證發(fā)揮人工智能作用的同時(shí),確保數(shù)據(jù)使用的安全,這是非常關(guān)鍵的問題。

第三,技術(shù)的應(yīng)用可控問題,簡(jiǎn)單來講就是 AI 濫用問題。因?yàn)槿斯ぶ悄苁且粋€(gè)能力非常強(qiáng)的工具,但是工具就具有兩面性質(zhì),可以被用于造福人類的場(chǎng)景,反過來也可能被不正當(dāng)?shù)睦谩1热缱畹湫偷纳疃群铣杉夹g(shù),也就是我們熟知的“AI 換臉”,這項(xiàng)技術(shù)能夠升級(jí)影視制作、廣告營銷等場(chǎng)景中的內(nèi)容制作效率和質(zhì)量,并為一些全新場(chǎng)景提供了技術(shù)可能,例如虛擬主播。但這項(xiàng)技術(shù)目前卻被大規(guī)模的濫用,比如通過“AI 換臉”技術(shù)進(jìn)行色情視頻生成、編造虛假新聞等。一些黑產(chǎn)分子甚至通過使用軟件程序低成本地合成帶有各種動(dòng)作的人臉視頻,結(jié)合注入攻擊手段后便可以輕易欺騙線上人臉識(shí)別系統(tǒng),進(jìn)而從事詐騙行為。我們認(rèn)為防范 AI 濫用,也是整個(gè)人工智能應(yīng)用環(huán)節(jié)必須要關(guān)注到的安全風(fēng)險(xiǎn)。

InfoQ:現(xiàn)在大家對(duì)抗性機(jī)器學(xué)習(xí)的受關(guān)注熱度比較高,什么是對(duì)抗性機(jī)器學(xué)習(xí),常見的對(duì)抗性機(jī)器學(xué)習(xí)的場(chǎng)景有哪些?

田天:對(duì)抗性機(jī)器學(xué)習(xí)最典型的是針對(duì)深度學(xué)習(xí)、深度神經(jīng)網(wǎng)絡(luò)的對(duì)抗,也就是上個(gè)問題中算法安全部分我們提到的。深度神經(jīng)網(wǎng)絡(luò)其實(shí)是非常復(fù)雜的模型,而復(fù)雜模型本身就是一個(gè)黑盒,黑盒的設(shè)計(jì)者、開發(fā)者也不知道模型內(nèi)部結(jié)構(gòu)、算法的運(yùn)算邏輯是怎樣的。對(duì)抗機(jī)器學(xué)習(xí)包含攻擊手段與防御手段。攻擊端就是利用攻擊手段去尋找模型設(shè)計(jì)過程中存在的缺陷或漏洞,相當(dāng)于找模型什么時(shí)候會(huì)出錯(cuò)。防御側(cè)則是在發(fā)現(xiàn)隱患或漏洞后,通過對(duì)抗訓(xùn)練、外部接入保護(hù)措施等方式,來提升整個(gè)模型的安全性,保證模型在受到攻擊后的安全運(yùn)行。

其實(shí),在人工智能應(yīng)用的各個(gè)場(chǎng)景中,廣泛存在著對(duì)抗機(jī)器學(xué)習(xí)的問題。典型的比如圖像領(lǐng)域的人臉識(shí)別、圖像分類以及目標(biāo)檢測(cè),都存在算法安全問題,像上面提到的通過特定的攻擊方式能夠讓模型失效,因此需要通過對(duì)抗學(xué)習(xí)的方式來提升安全性。除此,語音識(shí)別、推薦系統(tǒng),甚至自然語言處理等等,各個(gè)場(chǎng)景都存在著對(duì)抗。另外按照攻擊類型來分,可分為有目標(biāo)攻擊和無目標(biāo)攻擊等不同類型。所以整個(gè)對(duì)抗機(jī)器學(xué)習(xí)是一個(gè)非常大的技術(shù)體系,需要進(jìn)行專門研究。

InfoQ:我們花費(fèi)大量的人力、物力研發(fā)出了一個(gè)模型以后,是不是攻擊者也要付出很大的代價(jià)來攻擊它?

田天:對(duì)于攻擊者來說,如果要做白盒攻擊,就需要獲得被攻擊模型的所有信息,包括網(wǎng)絡(luò)結(jié)構(gòu)、參數(shù)等等,這其實(shí)是非常難、成本很高的一件事情。退而求其次,如果去做黑盒攻擊,實(shí)施起來相對(duì)就會(huì)容易一些,一類被稱為查詢攻擊的方法是需要去持續(xù)請(qǐng)求被攻擊模型,獲得該模型在特定樣本上給出來的反饋結(jié)果,另一類被稱為遷移攻擊的方法,甚至可以不用在實(shí)施真正的攻擊前去請(qǐng)求被攻擊模型。所以攻擊技術(shù)也在演化,相當(dāng)于是很多人在嘗試去降低攻擊的成本,而且隨著技術(shù)的開源化、工具化,攻擊的難度和成本肯定是逐步降低的。

InfoQ:目前對(duì)抗性機(jī)器學(xué)習(xí)對(duì)于 AI 和機(jī)器學(xué)習(xí)系統(tǒng)造成的主要危害有哪些?

田天:主要危害在于讓算法出錯(cuò),使 AI 系統(tǒng)無法給出正確的結(jié)果。以人臉識(shí)別為例,比如刷臉閘機(jī),正常情況下,只有存有身份信息獲得授權(quán)的人員才能通過。但是利用算法漏洞,我作為一個(gè)未授權(quán)人員通過在面部添加特定干擾,就能讓系統(tǒng)出錯(cuò)通過閘機(jī)。這相當(dāng)于產(chǎn)品的基本功能失效了,存在明顯的危害。

InfoQ:在自動(dòng)駕駛領(lǐng)域,比如很多車企之前就曝光因自動(dòng)駕駛系統(tǒng)失控發(fā)生多起安全事故,威脅到駕駛員的人身安全,對(duì)于這種現(xiàn)象您怎么看?

田天:自動(dòng)駕駛的很多安全問題也源自于算法本身的不可靠、魯棒性差。一方面在于,自動(dòng)駕駛系統(tǒng)本身的魯棒性就比較差,在特殊的場(chǎng)景下,或者一些極端情況下很容易出錯(cuò)另外,還有可能被人利用算法漏洞惡意發(fā)起攻擊,與上面人臉識(shí)別的問題類似,攻擊者修改目標(biāo)物體的顏色、形狀等,就能讓自動(dòng)駕駛車輛的攝像頭,甚至激光雷達(dá)失效,目前這類攻擊成功率是非常高的。

InfoQ:針對(duì)這樣的安全隱患,我們有哪些防范措施?

田天:針對(duì)這個(gè)問題,我們?cè)谧鰞煞矫娴墓ぷ鳌R跃W(wǎng)絡(luò)安全作為對(duì)比,隨著互聯(lián)網(wǎng)的發(fā)展,互聯(lián)網(wǎng)領(lǐng)域存在很多網(wǎng)絡(luò)安全隱患,因此出現(xiàn)了一系列工具來增強(qiáng)網(wǎng)絡(luò)系統(tǒng)的安全性,比如大家比較熟悉的殺毒軟件、防火墻。

類似的,我們?cè)谧鲠槍?duì) AI 系統(tǒng)的殺毒軟件和防火墻。這里的“殺毒軟件”是我們推出的業(yè)內(nèi)首個(gè)人工智能安全平臺(tái) RealSafe,通過內(nèi)置一系列攻擊算法和防御算法,提供從模型安全測(cè)試到模型安全加固一站式能力。例如一套人臉識(shí)別系統(tǒng),接入到平臺(tái)后,可以調(diào)用攻擊算法模塊對(duì)系統(tǒng)自動(dòng)進(jìn)行模擬攻擊,平臺(tái)會(huì)輸出安全性評(píng)分報(bào)告,借此得知系統(tǒng)模型在什么樣的情況下容易受到攻擊。在發(fā)現(xiàn)安全隱患之后,針對(duì)每一種漏洞或攻擊風(fēng)險(xiǎn),平臺(tái)搭載了對(duì)應(yīng)的防御模塊,通過對(duì)抗訓(xùn)練或者其他方式來增強(qiáng)模型的安全性。

另外,我們也開發(fā)標(biāo)準(zhǔn)化的 AI 安全防火墻。比如現(xiàn)階段的人臉識(shí)別系統(tǒng)存在一系列的模型和算法漏洞,容易受到攻擊,我們?cè)诂F(xiàn)有人臉識(shí)別流程中前置防火墻模塊,識(shí)別請(qǐng)求先過防火墻,防火墻來判斷里面輸入數(shù)據(jù)中是否存在攻擊。如果沒有攻擊,正常進(jìn)入后面的識(shí)別環(huán)節(jié),如果有攻擊就直接拒絕,保證系統(tǒng)不受攻擊,更加安全。

InfoQ:您說的 AI 安全平臺(tái)以及防火墻這樣的工具,目前的效果是怎么樣的,如果要給這個(gè)效果從 1-10 打分,您會(huì)打幾分?

田天:安全問題進(jìn)入 AI 時(shí)代,最明顯的特征就是深度神經(jīng)網(wǎng)絡(luò)增強(qiáng)了 AI 的自我學(xué)習(xí)和升級(jí)迭代能力,而這種能力自然也被攻擊者所掌握。所以,AI 時(shí)代談安全,其實(shí)不僅僅是談“魔高一尺道高一丈”的問題,更是談“魔”和“道”誰對(duì)誰的感知能力更強(qiáng),誰更有預(yù)見性和主動(dòng)權(quán)的問題。針對(duì)這樣的新特點(diǎn),瑞萊智慧人臉識(shí)別防火墻 RealGuard 具備兩個(gè)最主要的優(yōu)勢(shì):一是對(duì)人臉識(shí)別物理和數(shù)字世界的全景式安全態(tài)勢(shì)感知能力,始終力爭(zhēng)讓“道”走在“魔”的前面,這其中的底氣來源于瑞萊智慧依托清華多年來對(duì)人工智能安全算法、對(duì)構(gòu)建第三代人工智能的科研攻堅(jiān)。二是對(duì)攻擊防御的高準(zhǔn)確率,目前,RealGuard 可以針對(duì)對(duì)抗樣本攻擊、面部替換攻擊、表情操縱攻擊等新型人臉識(shí)別安全風(fēng)險(xiǎn),做到全覆蓋防御。如果說要對(duì)效果進(jìn)行打分,那我更愿意用產(chǎn)品的客觀運(yùn)行數(shù)據(jù)說話,RealGuard 目前針對(duì)攻擊的拒絕率達(dá)到 98% 以上。

InfoQ:這兩款產(chǎn)品目前的應(yīng)用進(jìn)展如何,有取得哪些成效?

田天:目前這兩款產(chǎn)品已經(jīng)在金融、政府等領(lǐng)域落地。比如在金融領(lǐng)域,我們與多家國有行、股份制銀行合作,提供人臉識(shí)別系統(tǒng)的安全檢測(cè)與加固服務(wù);在政府領(lǐng)域,我們與公安部門合作,提供監(jiān)控視頻智能化方案,基于攻防加固提升監(jiān)控系統(tǒng)的安全性;包括我們與多家整車廠商合作,提供自動(dòng)駕駛安全解決方案。

InfoQ:經(jīng)過多年的發(fā)展,您認(rèn)為人工智能安全的研究發(fā)展到了哪個(gè)階段?

田天:現(xiàn)在這個(gè)領(lǐng)域已經(jīng)走出實(shí)驗(yàn)室,進(jìn)入到產(chǎn)業(yè)化的階段。隨著近年來安全事件的層出不窮,以及政策監(jiān)管的重視,市場(chǎng)迫切需要針對(duì) AI 應(yīng)用的安全產(chǎn)品。其實(shí)包括我們?cè)趦?nèi),國內(nèi)外近年來也陸續(xù)出現(xiàn)一些團(tuán)隊(duì)開始從事這一領(lǐng)域,布局商業(yè)化的 AI 安全產(chǎn)品,推出相關(guān)的軟件、系統(tǒng)、硬件等等。尤其今年來看,產(chǎn)業(yè)已經(jīng)開始進(jìn)入快速發(fā)展的落地期,金融、公安等重點(diǎn)領(lǐng)域都開始落地。

InfoQ:您覺得未來 AI 安全將會(huì)朝哪個(gè)方向發(fā)展,有哪些技術(shù)值得關(guān)注?

田天:第一,AI 對(duì)抗攻防技術(shù)必須要持續(xù)研究。因?yàn)楣艉头烙且粋€(gè)持續(xù)升級(jí)的過程,新的攻擊手段會(huì)不斷地產(chǎn)生,因此也需要不斷研究新的防御手段;

第二,對(duì)合成技術(shù)的安全問題需要加大關(guān)注。因?yàn)殡S著技術(shù)的不斷成熟,合成類內(nèi)容在清晰度、流暢度、逼真度等各方面都有大幅提升,已經(jīng)超越了人眼分辨的極限,真假難辨的背后是對(duì)社會(huì)信任的沖擊,危害性在不斷增強(qiáng),因此必須依靠技術(shù)手段對(duì)這類偽造內(nèi)容進(jìn)行判別以及溯源;

第三,需要去發(fā)展與人工智能相適應(yīng)的隱私保護(hù)技術(shù),確保人工智能應(yīng)用過程中,對(duì)敏感數(shù)據(jù)的保護(hù),不泄露數(shù)據(jù)。并且,這三方面需要去并行發(fā)展。

編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論