美國(guó)斯坦福大學(xué)的研究人員已經(jīng)證明,可以直接在光學(xué)芯片上訓(xùn)練人工神經(jīng)網(wǎng)絡(luò)。這一重大突破表明,光學(xué)電路可以實(shí)現(xiàn)基于電子的人工神經(jīng)網(wǎng)絡(luò)的關(guān)鍵功能,進(jìn)而可以以更便宜、更快速和更節(jié)能的方式執(zhí)行語(yǔ)音識(shí)別、圖像識(shí)別等復(fù)雜任務(wù)。

2018-07-30 08:48:49 6741

6741 為了訓(xùn)練出高效可用的深層神經(jīng)網(wǎng)絡(luò)模型,在訓(xùn)練時(shí)必須要避免過(guò)擬合的現(xiàn)象。過(guò)擬合現(xiàn)象的優(yōu)化方法通常有三種。

2020-12-02 14:17:24 2322

2322

在神經(jīng)網(wǎng)絡(luò)建模中,經(jīng)常會(huì)出現(xiàn)關(guān)于神經(jīng)網(wǎng)絡(luò)應(yīng)該有多復(fù)雜的問(wèn)題,即它應(yīng)該有多少層,或者它的濾波器矩陣應(yīng)該有多大。這個(gè)問(wèn)題沒(méi)有簡(jiǎn)單的答案。與此相關(guān),討論網(wǎng)絡(luò)過(guò)擬合和欠擬合非常重要。過(guò)擬合是模型過(guò)于復(fù)雜

2023-11-24 15:35:47 237

237

英特爾正與百度合作開(kāi)發(fā)英特爾? Nervana?神經(jīng)網(wǎng)絡(luò)訓(xùn)練處理器(NNP-T)。這一合作包括全新定制化加速器,以實(shí)現(xiàn)極速訓(xùn)練深度學(xué)習(xí)模型的目的。

2019-07-05 17:25:00 847

847 STM32CubeMx.AI的使用歡迎使用Markdown編輯器在STM32論壇中看到這樣一個(gè)視頻:在視頻中,在STM32上驗(yàn)證神經(jīng)網(wǎng)絡(luò)模型(HAR人體活動(dòng)識(shí)別),一般需要STM32-F3/F4/L4/F7/L7系列高性能單片機(jī),運(yùn)行網(wǎng)絡(luò)模型一般需要3MB以上的閃存空間,單片機(jī)顯然不支持這...

2021-08-03 06:59:41

問(wèn)題最近在Ubuntu上使用Nvidia GPU訓(xùn)練模型的時(shí)候,沒(méi)有問(wèn)題,過(guò)一會(huì)再訓(xùn)練出現(xiàn)非常卡頓,使用nvidia-smi查看發(fā)現(xiàn),顯示GPU的風(fēng)扇和電源報(bào)錯(cuò):解決方案自動(dòng)風(fēng)扇控制在nvidia

2022-01-03 08:24:09

神經(jīng)網(wǎng)絡(luò)在訓(xùn)練時(shí)的優(yōu)化首先是對(duì)模型的當(dāng)前狀態(tài)進(jìn)行誤差估計(jì),然后為了減少下一次評(píng)估的誤差,需要使用一個(gè)能夠表示錯(cuò)誤函數(shù)對(duì)權(quán)重進(jìn)行更新,這個(gè)函數(shù)被稱為損失函數(shù)。損失函數(shù)的選擇與神經(jīng)網(wǎng)絡(luò)模型從示例中學(xué)

2022-10-20 17:14:15

第1章 概述 1.1 人工神經(jīng)網(wǎng)絡(luò)研究與發(fā)展 1.2 生物神經(jīng)元 1.3 人工神經(jīng)網(wǎng)絡(luò)的構(gòu)成 第2章人工神經(jīng)網(wǎng)絡(luò)基本模型 2.1 MP模型 2.2 感知器模型 2.3 自適應(yīng)線性

2012-03-20 11:32:43

的系統(tǒng)。在訓(xùn)練階段,開(kāi)發(fā)商利用諸如 Caffe 等的框架對(duì) CNN 進(jìn)行訓(xùn)練及優(yōu)化。參考圖像數(shù)據(jù)庫(kù)用于確定網(wǎng)絡(luò)中神經(jīng)元的最佳權(quán)重參數(shù)。訓(xùn)練結(jié)束即可采用傳統(tǒng)方法在 CPU、GPU 或 FPGA 上生成網(wǎng)絡(luò)

2017-12-21 17:11:34

,神經(jīng)網(wǎng)絡(luò)之父Hiton始終堅(jiān)持計(jì)算機(jī)能夠像人類一樣思考,用直覺(jué)而非規(guī)則。盡管這一觀點(diǎn)被無(wú)數(shù)人質(zhì)疑過(guò)無(wú)數(shù)次,但隨著數(shù)據(jù)的不斷增長(zhǎng)和數(shù)據(jù)挖掘技術(shù)的不斷進(jìn)步,神經(jīng)網(wǎng)絡(luò)開(kāi)始在語(yǔ)音和圖像等方面超越基于邏輯的人

2018-06-05 10:11:50

CV之YOLOv3:深度學(xué)習(xí)之計(jì)算機(jī)視覺(jué)神經(jīng)網(wǎng)絡(luò)Yolov3-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄

2018-12-24 11:51:47

CV之YOLO:深度學(xué)習(xí)之計(jì)算機(jī)視覺(jué)神經(jīng)網(wǎng)絡(luò)tiny-yolo-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄

2018-12-24 11:50:57

工智能應(yīng)用開(kāi)發(fā)可歸納為以下幾個(gè)步驟:(1)準(zhǔn)備數(shù)據(jù)集在傳統(tǒng)的有監(jiān)督的神經(jīng)網(wǎng)絡(luò)算法中,數(shù)據(jù)集對(duì)最終的算法性能起著決定性的關(guān)鍵作用。因此,神經(jīng)網(wǎng)絡(luò)算法訓(xùn)練的首要任務(wù),就是實(shí)現(xiàn)數(shù)據(jù)集的搜集工作。在機(jī)器視覺(jué)任務(wù)中,有

2020-05-18 17:13:24

我們在使用卷積神經(jīng)網(wǎng)絡(luò)或遞歸神經(jīng)網(wǎng)絡(luò)或其他變體時(shí),通常都希望對(duì)模型的架構(gòu)可以進(jìn)行可視化的查看,因?yàn)檫@樣我們可以 在定義和訓(xùn)練多個(gè)模型時(shí),比較不同的層以及它們放置的順序?qū)Y(jié)果的影響。還有可以更好地理

2022-11-02 14:55:04

遞歸網(wǎng)絡(luò)newelm 創(chuàng)建一Elman遞歸網(wǎng)絡(luò)2. 網(wǎng)絡(luò)應(yīng)用函數(shù)sim 仿真一個(gè)神經(jīng)網(wǎng)絡(luò)init 初始化一個(gè)神經(jīng)網(wǎng)絡(luò)adapt 神經(jīng)網(wǎng)絡(luò)的自適應(yīng)化train 訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)3. 權(quán)函數(shù)dotprod

2009-09-22 16:10:08

我在MATLAB中進(jìn)行了神經(jīng)網(wǎng)絡(luò)模型訓(xùn)練,然后將訓(xùn)練好的模型的閾值和權(quán)值導(dǎo)出來(lái),移植到STM32F407單片機(jī)上進(jìn)行計(jì)算,但是在單片機(jī)上的計(jì)算結(jié)果和在MATLAB上的不一樣,一直找不到原因。代碼在

2020-06-16 11:14:28

本教程以實(shí)際應(yīng)用、工程開(kāi)發(fā)為目的,著重介紹模型訓(xùn)練過(guò)程中遇到的實(shí)際問(wèn)題和方法。在機(jī)器學(xué)習(xí)模型開(kāi)發(fā)中,主要涉及三大部分,分別是數(shù)據(jù)、模型和損失函數(shù)及優(yōu)化器。本文也按順序的依次介紹數(shù)據(jù)、模型和損失函數(shù)

2018-12-21 09:18:02

Processing Engine(NPE) SDK主要是幫助開(kāi)發(fā)者在驍龍移動(dòng)平臺(tái)的Caffe/Caffe2或TensorFlow上運(yùn)行一個(gè)或者幾個(gè)被訓(xùn)練過(guò)的神經(jīng)網(wǎng)絡(luò)模型.幫助開(kāi)發(fā)者節(jié)省時(shí)間并且優(yōu)化在驍龍?jiān)O(shè)備上

2018-09-27 09:58:39

習(xí)神經(jīng)神經(jīng)網(wǎng)絡(luò),對(duì)于神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)是如何一直沒(méi)有具體實(shí)現(xiàn)一下:現(xiàn)看到一個(gè)簡(jiǎn)單的神經(jīng)網(wǎng)絡(luò)模型用于訓(xùn)練的輸入數(shù)據(jù):對(duì)應(yīng)的輸出數(shù)據(jù):我們這里設(shè)置:1:節(jié)點(diǎn)個(gè)數(shù)設(shè)置:輸入層、隱層、輸出層的節(jié)點(diǎn)

2021-08-18 07:25:21

`本篇主要介紹:人工神經(jīng)網(wǎng)絡(luò)的起源、簡(jiǎn)單神經(jīng)網(wǎng)絡(luò)模型、更多神經(jīng)網(wǎng)絡(luò)模型、機(jī)器學(xué)習(xí)的步驟:訓(xùn)練與預(yù)測(cè)、訓(xùn)練的兩階段:正向推演與反向傳播、以TensorFlow + Excel表達(dá)訓(xùn)練流程以及AI普及化教育之路。`

2020-11-05 17:48:39

對(duì)神經(jīng)網(wǎng)絡(luò)的學(xué)習(xí),講解其工作原理。4.基于PYNQ-Z2,用python實(shí)現(xiàn)一個(gè)神經(jīng)網(wǎng)絡(luò)。5.訓(xùn)練和測(cè)試神經(jīng)網(wǎng)絡(luò),完成神經(jīng)網(wǎng)絡(luò)最經(jīng)典的入門實(shí)驗(yàn)--手寫數(shù)字識(shí)別。6.如時(shí)間充足,會(huì)利用板子上

2019-01-09 14:48:59

項(xiàng)目名稱:基于PYNQ的卷積神經(jīng)網(wǎng)絡(luò)加速試用計(jì)劃:申請(qǐng)理由:本人研究生在讀,想要利用PYNQ深入探索卷積神經(jīng)網(wǎng)絡(luò)的硬件加速,在PYNQ上實(shí)現(xiàn)圖像的快速處理項(xiàng)目計(jì)劃:1、在PC端實(shí)現(xiàn)Lnet網(wǎng)絡(luò)的訓(xùn)練

2018-12-19 11:37:22

硬件的連接;2. 編寫底盤驅(qū)動(dòng)程序,達(dá)到根據(jù)PYNQ發(fā)出的控制信號(hào)控制底盤運(yùn)動(dòng)的功能;3. 在PYNQ平臺(tái)編寫采集神經(jīng)網(wǎng)絡(luò)數(shù)據(jù)集使用的手動(dòng)控制程序,編寫自動(dòng)駕駛程序;4. 搭建神經(jīng)網(wǎng)絡(luò),采集訓(xùn)練數(shù)據(jù)

2019-03-02 23:10:52

開(kāi)發(fā)流程在了解推理機(jī)工作內(nèi)容的基礎(chǔ)上,就需要知道其使用的神經(jīng)網(wǎng)絡(luò)計(jì)算是怎么得到的。在應(yīng)用層次,其實(shí)就是一堆加權(quán)系數(shù)的加減乘除運(yùn)算將輸入數(shù)據(jù)計(jì)算出一個(gè)推論結(jié)果。然而這里存在一個(gè)加權(quán)系數(shù)怎么得到的問(wèn)題,這就

2020-07-22 22:56:39

,神經(jīng)元才會(huì)生成輸出。因此,通過(guò)類比,我們可以知道神經(jīng)網(wǎng)絡(luò)在輸入值的加權(quán)和的基礎(chǔ)上應(yīng)用了非線性函數(shù)。 圖2(a)展示了計(jì)算神經(jīng)網(wǎng)絡(luò)的示意圖,圖的最左邊是接受數(shù)值的“輸入層”。這些值被傳播到中間層神經(jīng)

2017-06-14 21:01:14

指神經(jīng)網(wǎng)絡(luò)在學(xué)習(xí)新知識(shí)的同時(shí)要保持對(duì)之前學(xué)習(xí)的知識(shí)的記憶,而不是狗熊掰棒子SOM神經(jīng)網(wǎng)絡(luò)是一種競(jìng)爭(zhēng)學(xué)習(xí)型的無(wú)監(jiān)督神經(jīng)網(wǎng)絡(luò),它能將高維輸入數(shù)據(jù)映射到低維空間(通常為二維),同時(shí)保持輸入數(shù)據(jù)在高維空間

2019-07-21 04:30:00

在各個(gè)領(lǐng)域被廣泛應(yīng)用,例如金融網(wǎng)絡(luò)、交通網(wǎng)絡(luò)、教育網(wǎng)絡(luò)等。時(shí)序圖是包含時(shí)間屬性的圖數(shù)據(jù)。在金融交易領(lǐng)域,時(shí)間屬性是反欺詐、反套現(xiàn)等眾多應(yīng)用場(chǎng)景的重要屬性。因此如何對(duì)時(shí)序圖神經(jīng)網(wǎng)絡(luò)進(jìn)行高效的訓(xùn)練和推理

2022-09-28 10:34:13

這個(gè)網(wǎng)絡(luò)輸入和相應(yīng)的輸出來(lái)“訓(xùn)練”這個(gè)網(wǎng)絡(luò),網(wǎng)絡(luò)根據(jù)輸入和輸出不斷地調(diào)節(jié)自己的各節(jié)點(diǎn)之間的權(quán)值來(lái)滿足輸入和輸出。這樣,當(dāng)訓(xùn)練結(jié)束后,我們給定一個(gè)輸入,網(wǎng)絡(luò)便會(huì)根據(jù)自己已調(diào)節(jié)好的權(quán)值計(jì)算出一個(gè)輸出。這就是神經(jīng)網(wǎng)絡(luò)的簡(jiǎn)單原理。 神經(jīng)網(wǎng)絡(luò)原理下載-免費(fèi)

2008-06-19 14:40:42

通過(guò)堆疊卷積層使得模型更深更寬,同時(shí)借助GPU使得訓(xùn)練再可接受的時(shí)間范圍內(nèi)得到結(jié)果,推動(dòng)了卷積神經(jīng)網(wǎng)絡(luò)甚至是深度學(xué)習(xí)的發(fā)展。下面是AlexNet的架構(gòu):AlexNet的特點(diǎn)有:1.借助擁有1500萬(wàn)標(biāo)簽

2018-05-08 15:57:47

優(yōu)化神經(jīng)網(wǎng)絡(luò)訓(xùn)練方法有哪些?

2022-09-06 09:52:36

請(qǐng)問(wèn)用matlab編程進(jìn)行BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)時(shí),訓(xùn)練結(jié)果很多都是合適的,但如何確定最合適的?且如何用最合適的BP模型進(jìn)行外推預(yù)測(cè)?

2014-02-08 14:23:06

本文首先簡(jiǎn)單的選取了少量的樣本并進(jìn)行樣本歸一化,這樣就得到了可供訓(xùn)練的訓(xùn)練集和測(cè)試集。然后訓(xùn)練了400×25×2的三層BP神經(jīng)網(wǎng)絡(luò),最后對(duì)最初步的模型進(jìn)行了誤差分析并找到了一種效果顯著的提升方法!

2021-07-12 06:49:37

采用并提高他們的生產(chǎn)力。采用降低精度的浮點(diǎn)格式帶來(lái)了許多好處。直到幾年前,神經(jīng)網(wǎng)絡(luò)的訓(xùn)練主要是使用 IEEE 標(biāo)準(zhǔn)的 32 位浮點(diǎn)數(shù)來(lái)計(jì)算的。發(fā)現(xiàn)具有越來(lái)越多層的大型網(wǎng)絡(luò)在 NN 任務(wù)中越

2022-09-15 15:15:46

十余年來(lái)快速發(fā)展的嶄新領(lǐng)域,越來(lái)越受到研究者的關(guān)注。卷積神經(jīng)網(wǎng)絡(luò)(CNN)模型是深度學(xué)習(xí)模型中最重要的一種經(jīng)典結(jié)構(gòu),其性能在近年來(lái)深度學(xué)習(xí)任務(wù)上逐步提高。由于可以自動(dòng)學(xué)習(xí)樣本數(shù)據(jù)的特征表示,卷積

2022-08-02 10:39:39

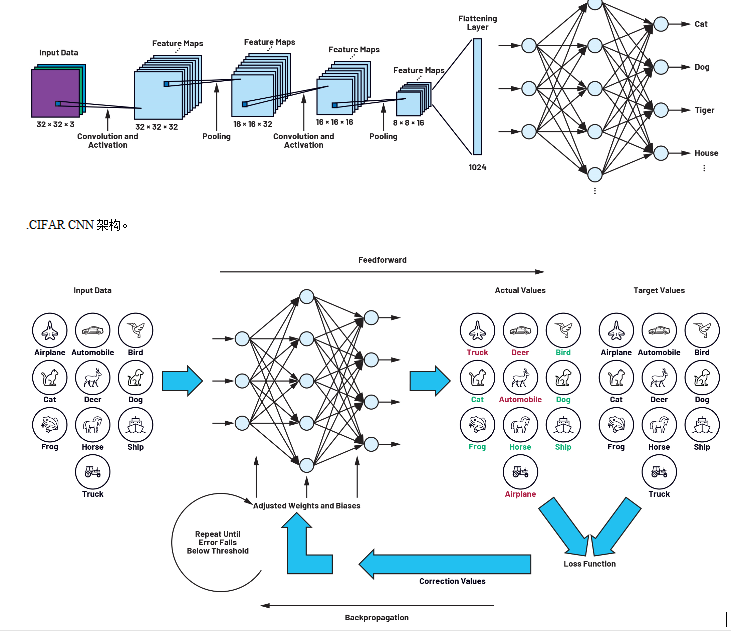

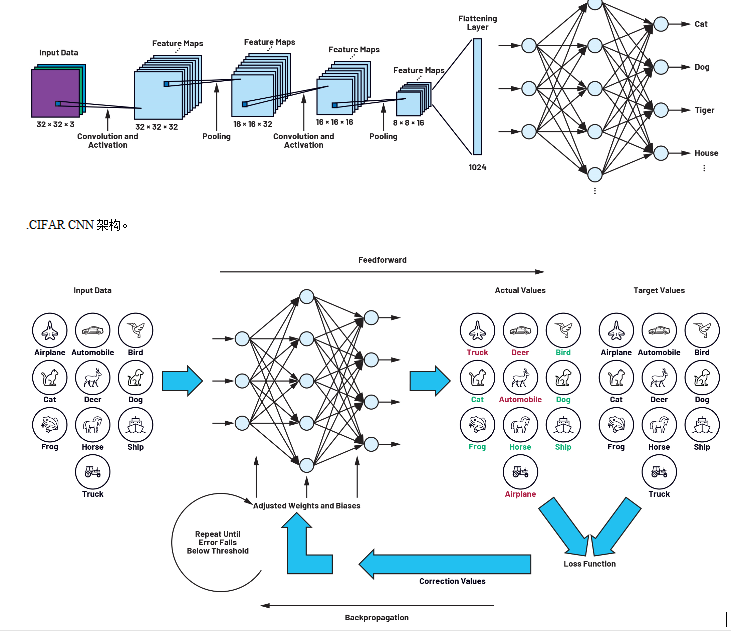

。圖2.一個(gè)小型神經(jīng)網(wǎng)絡(luò)。圖3.使用CIFAR-10數(shù)據(jù)集訓(xùn)練的CIFAR網(wǎng)絡(luò)模型。CIFAR-10 是一個(gè)常用于訓(xùn)練 CIFAR 神經(jīng)網(wǎng)絡(luò)的特定數(shù)據(jù)集。它由 60,000 張 32 × 32 張彩色

2023-02-23 20:11:10

1、卷積神經(jīng)網(wǎng)絡(luò)長(zhǎng)尾數(shù)據(jù)集識(shí)別的技巧包 最近,長(zhǎng)尾識(shí)別持續(xù)引起關(guān)注,產(chǎn)生了很多不同的方法,這些方法屬于不同的范式,度量學(xué)習(xí),元學(xué)習(xí)和知識(shí)遷移。盡管這些方法在長(zhǎng)尾數(shù)據(jù)集上取得了穩(wěn)定的精度的提升,但是

2022-11-30 15:26:31

什么是卷積神經(jīng)網(wǎng)絡(luò)?ImageNet-2010網(wǎng)絡(luò)結(jié)構(gòu)是如何構(gòu)成的?有哪些基本參數(shù)?

2021-06-17 11:48:22

多種復(fù)雜的網(wǎng)絡(luò)模型結(jié)構(gòu)。完善的文檔: 擁有 API 文檔,入門指南,優(yōu)化指南。入門簡(jiǎn)單: 多個(gè)從簡(jiǎn)單到復(fù)雜的例子,完全開(kāi)源。MCU 上的神經(jīng)網(wǎng)絡(luò)能做什么?語(yǔ)音關(guān)鍵詞識(shí)別 (KeyWord

2019-05-01 19:03:01

我們可以對(duì)神經(jīng)網(wǎng)絡(luò)架構(gòu)進(jìn)行優(yōu)化,使之適配微控制器的內(nèi)存和計(jì)算限制范圍,并且不會(huì)影響精度。我們將在本文中解釋和探討深度可分離卷積神經(jīng)網(wǎng)絡(luò)在 Cortex-M 處理器上實(shí)現(xiàn)關(guān)鍵詞識(shí)別的潛力。關(guān)鍵詞識(shí)別

2021-07-26 09:46:37

為提升識(shí)別準(zhǔn)確率,采用改進(jìn)神經(jīng)網(wǎng)絡(luò),通過(guò)Mnist數(shù)據(jù)集進(jìn)行訓(xùn)練。整體處理過(guò)程分為兩步:圖像預(yù)處理和改進(jìn)神經(jīng)網(wǎng)絡(luò)推理。圖像預(yù)處理主要根據(jù)圖像的特征,將數(shù)據(jù)處理成規(guī)范的格式,而改進(jìn)神經(jīng)網(wǎng)絡(luò)推理主要用于輸出結(jié)果。 整個(gè)過(guò)程分為兩個(gè)步驟:圖像預(yù)處理和神經(jīng)網(wǎng)絡(luò)推理。需要提前安裝Tengine框架,

2021-12-23 08:07:33

基于光學(xué)芯片的神經(jīng)網(wǎng)絡(luò)訓(xùn)練解析,不看肯定后悔

2021-06-21 06:33:55

。———————————————————————————— 最終,我們用了不到20分鐘的時(shí)間,在8核筆記本電腦的CPU上對(duì)這一神經(jīng)網(wǎng)絡(luò)進(jìn)行了訓(xùn)練。 訓(xùn)練數(shù)據(jù)包括7600+張標(biāo)記的圖片。下載后,會(huì)有兩個(gè)文件夾,分別

2018-05-03 20:19:47

FPGA 上實(shí)現(xiàn)卷積神經(jīng)網(wǎng)絡(luò) (CNN)。CNN 是一類深度神經(jīng)網(wǎng)絡(luò),在處理大規(guī)模圖像識(shí)別任務(wù)以及與機(jī)器學(xué)習(xí)類似的其他問(wèn)題方面已大獲成功。在當(dāng)前案例中,針對(duì)在 FPGA 上實(shí)現(xiàn) CNN 做一個(gè)可行性研究

2019-06-19 07:24:41

基于遺傳優(yōu)化神經(jīng)網(wǎng)絡(luò)的電子舌在黃酒檢測(cè)中的應(yīng)用采用遺傳學(xué)習(xí)算法和誤差反向傳播(BP)算法相結(jié)合的混合算法來(lái)訓(xùn)練前饋人工神經(jīng)網(wǎng)絡(luò),從而提高神經(jīng)網(wǎng)絡(luò)的收斂質(zhì)量和收斂速度,并將此算法運(yùn)用到電子舌對(duì)黃酒

2009-09-19 09:32:15

本文介紹了如何使用Keras框架,搭建一個(gè)小型的神經(jīng)網(wǎng)絡(luò)-多層感知器,并通過(guò)給定數(shù)據(jù)進(jìn)行計(jì)算訓(xùn)練,最好將訓(xùn)練得到的模型提取出參數(shù),放在51單片機(jī)上進(jìn)行運(yùn)行。

2021-11-22 07:00:41

有很多方法可以將經(jīng)過(guò)訓(xùn)練的神經(jīng)網(wǎng)絡(luò)模型部署到移動(dòng)或嵌入式設(shè)備上。不同的框架在各種平臺(tái)上支持Arm,包括TensorFlow、PyTorch、Caffe2、MxNet和CNTK,如Android

2023-08-02 06:43:57

原文鏈接:http://tecdat.cn/?p=5725 神經(jīng)網(wǎng)絡(luò)是一種基于現(xiàn)有數(shù)據(jù)創(chuàng)建預(yù)測(cè)的計(jì)算系統(tǒng)。如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?神經(jīng)網(wǎng)絡(luò)包括:輸入層:根據(jù)現(xiàn)有數(shù)據(jù)獲取輸入的層隱藏層:使用反向傳播優(yōu)化輸入變量權(quán)重的層,以提高模型的預(yù)測(cè)能力輸出層:基于輸入和隱藏層的數(shù)據(jù)輸出預(yù)測(cè)

2021-07-12 08:02:11

訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)并移植到Lattice FPGA上,通常需要開(kāi)發(fā)人員既要懂軟件又要懂?dāng)?shù)字電路設(shè)計(jì),是個(gè)不容易的事。好在FPGA廠商為我們提供了許多工具和IP,我們可以在這些工具和IP的基礎(chǔ)上做

2020-11-26 07:46:03

稱為BP神經(jīng)網(wǎng)絡(luò)。采用BP神經(jīng)網(wǎng)絡(luò)模型能完成圖像數(shù)據(jù)的壓縮處理。在圖像壓縮中,神經(jīng)網(wǎng)絡(luò)的處理優(yōu)勢(shì)在于:巨量并行性;信息處理和存儲(chǔ)單元結(jié)合在一起;自組織自學(xué)習(xí)功能。與傳統(tǒng)的數(shù)字信號(hào)處理器DSP

2019-08-08 06:11:30

提高吞吐量、提高訓(xùn)練性能。綜上,針對(duì)時(shí)序圖神經(jīng)網(wǎng)絡(luò)中出現(xiàn)的高額設(shè)備間通信開(kāi)銷問(wèn)題,本文提出了局部性感知的數(shù)據(jù)劃分策略和高效的任務(wù)調(diào)度策略,以縮減時(shí)序圖神經(jīng)網(wǎng)絡(luò)訓(xùn)練時(shí)的通信開(kāi)銷。同時(shí)本文在時(shí)序圖神經(jīng)網(wǎng)絡(luò)中

2022-09-28 10:37:20

人工神經(jīng)網(wǎng)絡(luò)在AI中具有舉足輕重的地位,除了找到最好的神經(jīng)網(wǎng)絡(luò)模型和訓(xùn)練數(shù)據(jù)集之外,人工神經(jīng)網(wǎng)絡(luò)的另一個(gè)挑戰(zhàn)是如何在嵌入式設(shè)備上實(shí)現(xiàn)它,同時(shí)優(yōu)化性能和功率效率。 使用云計(jì)算并不總是一個(gè)選項(xiàng),尤其是當(dāng)

2021-11-09 08:06:27

當(dāng)訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)用于應(yīng)用的時(shí)候,權(quán)值是不是不能變了????就是已經(jīng)訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)是不是相當(dāng)于得到一個(gè)公式了,權(quán)值不能變了

2016-10-24 21:55:22

工作探索了如何在小型數(shù)據(jù)集上從頭開(kāi)始訓(xùn)練ViT。也有工作在探索如何在24小時(shí)內(nèi)對(duì)文本數(shù)據(jù)訓(xùn)練BERT模型,但它使用8個(gè)GPU的服務(wù)器,而作者將自己限制在單個(gè)GPU。Primer建議尋找

2022-11-24 14:56:31

、檢測(cè)和分割等視覺(jué)任務(wù),因?yàn)樗鼈?b class="flag-6" style="color: red">在已建立的基準(zhǔn)數(shù)據(jù)集(如Imagenet、COCO、PascalVOC、ADE20K和其他類似數(shù)據(jù)集)上具有很強(qiáng)的性能。當(dāng)在移動(dòng)設(shè)備等資源普遍受限的邊緣設(shè)備上部署cnn

2022-10-13 14:46:42

能力訓(xùn)練出規(guī)模足夠大的神經(jīng)網(wǎng)絡(luò)來(lái)使用現(xiàn)有的海量數(shù)據(jù)集。具體來(lái)說(shuō),即使你積累了更多的數(shù)據(jù),但應(yīng)用在類似于對(duì)數(shù)幾率回歸(logistic regression)這樣較傳統(tǒng)的學(xué)習(xí)算法上,其性能表現(xiàn)

2018-11-30 16:45:03

可以輕松快速地進(jìn)行原型設(shè)計(jì)。它支持各種 DNN,如RNN、CNN,甚至是兩者的組合。任何深度學(xué)習(xí)網(wǎng)絡(luò)都由四個(gè)重要部分組成:數(shù)據(jù)集、定義模型(網(wǎng)絡(luò)結(jié)構(gòu))、訓(xùn)練/學(xué)習(xí)和預(yù)測(cè)/評(píng)估。可以在

2020-07-28 14:34:04

嵌入式設(shè)備自帶專用屬性,不適合作為隨機(jī)性很強(qiáng)的人工智能深度學(xué)習(xí)訓(xùn)練平臺(tái)。想象用S3C2440訓(xùn)練神經(jīng)網(wǎng)絡(luò)算法都會(huì)頭皮發(fā)麻,PC上的I7、GPU上都很吃力,大部分都要依靠服務(wù)器來(lái)訓(xùn)練。但是一旦算法訓(xùn)練

2021-08-17 08:51:57

請(qǐng)問(wèn)用matlab編程進(jìn)行BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)時(shí),訓(xùn)練結(jié)果很多都是合適的,但如何確定最合適的?且如何用最合適的BP模型進(jìn)行外推預(yù)測(cè)?

2014-02-08 14:19:12

用于計(jì)算機(jī)視覺(jué)訓(xùn)練的圖像數(shù)據(jù)集

2021-02-26 07:35:08

針對(duì)模糊神經(jīng)網(wǎng)絡(luò)訓(xùn)練采用BP算法比較依賴于網(wǎng)絡(luò)的初始條件,訓(xùn)練時(shí)間較長(zhǎng),容易陷入局部極值的缺點(diǎn),利用粒子群優(yōu)化算法(PSO)的全局搜索性能,將PSO用于模糊神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過(guò)程.由于基本PSO算法存在

2010-05-06 09:05:35

脈沖耦合神經(jīng)網(wǎng)絡(luò)(PCNN)在FPGA上的實(shí)現(xiàn),實(shí)現(xiàn)數(shù)據(jù)分類功能,有報(bào)酬。QQ470345140.

2013-08-25 09:57:14

CV之YOLOv3:深度學(xué)習(xí)之計(jì)算機(jī)視覺(jué)神經(jīng)網(wǎng)絡(luò)Yolov3-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄(第二次)——Jason niu

2018-12-24 11:52:25

我在matlab中訓(xùn)練好了一個(gè)神經(jīng)網(wǎng)絡(luò)模型,想在labview中調(diào)用,請(qǐng)問(wèn)應(yīng)該怎么做呢?或者labview有自己的神經(jīng)網(wǎng)絡(luò)工具包嗎?

2018-07-05 17:32:32

了TensorFlow2.0Beta版本,同pytorch一樣支持動(dòng)態(tài)執(zhí)行(TensorFlow2.0默認(rèn)eager模式,無(wú)需啟動(dòng)會(huì)話執(zhí)行計(jì)算圖),同時(shí)刪除了雜亂低階API,使用高階API簡(jiǎn)單地構(gòu)建復(fù)雜神經(jīng)網(wǎng)絡(luò)模型,本文主要分享用高階API構(gòu)建模型和數(shù)據(jù)集使用。

2020-11-04 07:49:09

應(yīng)用神經(jīng)網(wǎng)絡(luò)理論,建立了預(yù)測(cè)狀態(tài)監(jiān)測(cè)數(shù)據(jù)趨勢(shì)的BP 神經(jīng)網(wǎng)絡(luò)模型,并通MATLAB 實(shí)現(xiàn)了仿真編程。實(shí)驗(yàn)中,選取多組數(shù)據(jù)對(duì)網(wǎng)絡(luò)進(jìn)行了訓(xùn)練和測(cè)試,證實(shí)了算法和模型的有效性。

2009-09-11 15:53:10 26

26 該文提出了一種嵌入自聯(lián)想神經(jīng)網(wǎng)絡(luò)的高斯混合模型,它充分利用了神經(jīng)網(wǎng)絡(luò)和高斯混合模型各自的優(yōu)點(diǎn),以最大似然概率(ML)為準(zhǔn)則,把它們作為一個(gè)整體來(lái)進(jìn)行訓(xùn)練。訓(xùn)練過(guò)程中

2010-03-05 16:27:12 15

15 基于小波神經(jīng)網(wǎng)絡(luò)的信息系綜合評(píng)價(jià)系統(tǒng)的訓(xùn)練算法

為了對(duì)基于小波神經(jīng)網(wǎng)絡(luò)的信息系統(tǒng)綜合評(píng)價(jià)系統(tǒng)進(jìn)行訓(xùn)練,必須確定網(wǎng)絡(luò)參數(shù)Wk ,bk

2009-02-27 09:36:12 665

665

基于自適應(yīng)果蠅算法的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)訓(xùn)練_霍慧慧

2017-01-03 17:41:58 0

0 項(xiàng)兩部分。誤差項(xiàng)衡量神經(jīng)網(wǎng)絡(luò)模型在訓(xùn)練數(shù)據(jù)集上的擬合程度,而正則項(xiàng)則是控制模型的復(fù)雜程度,防止出現(xiàn)過(guò)擬合現(xiàn)象。

2017-11-16 15:30:54 12889

12889 為提高大樣本集情況下BP神經(jīng)網(wǎng)絡(luò)的訓(xùn)練效率,提出了一種基于局部收斂權(quán)陣進(jìn)化的BP神經(jīng)網(wǎng)絡(luò)MapReduce訓(xùn)練方法,以各Map任務(wù)基于其輸入數(shù)據(jù)分片訓(xùn)練產(chǎn)生的局部收斂權(quán)陣作為初始種群,在Reduce

2017-11-23 15:07:40 12

12 針對(duì)深度神經(jīng)網(wǎng)絡(luò)在分布式多機(jī)多GPU上的加速訓(xùn)練問(wèn)題,提出一種基于虛擬化的遠(yuǎn)程多GPU調(diào)用的實(shí)現(xiàn)方法。利用遠(yuǎn)程GPU調(diào)用部署的分布式GPU集群改進(jìn)傳統(tǒng)一對(duì)一的虛擬化技術(shù),同時(shí)改變深度神經(jīng)網(wǎng)絡(luò)在分布式

2018-03-29 16:45:25 0

0 如何在Node.js環(huán)境下使用訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)模型(Inception、SSD)識(shí)別圖像中的物體。

2018-04-06 13:11:12 8632

8632 網(wǎng)絡(luò)模型一旦選定,三要素中結(jié)構(gòu)和算法就確定了,接下來(lái)要對(duì)權(quán)值進(jìn)行調(diào)整。神經(jīng)網(wǎng)絡(luò)是將一組訓(xùn)練集(training set)送入網(wǎng)絡(luò),根據(jù)網(wǎng)絡(luò)的實(shí)際輸出與期望輸出間的差別來(lái)調(diào)整權(quán)值。

2018-04-28 15:10:00 22203

22203

算法進(jìn)行訓(xùn)練。值得指出的是,BP算法不僅可用于多層前饋神經(jīng)網(wǎng)絡(luò),還可以用于其他類型的神經(jīng)網(wǎng)絡(luò),例如訓(xùn)練遞歸神經(jīng)網(wǎng)絡(luò)。但我們通常說(shuō) “BP 網(wǎng)絡(luò)” 時(shí),一般是指用 BP 算法訓(xùn)練的多層前饋神經(jīng)網(wǎng)絡(luò)。

2018-06-19 15:17:15 42819

42819

我們訓(xùn)練了一個(gè)大型的深度卷積神經(jīng)網(wǎng)絡(luò),來(lái)將在ImageNet LSVRC-2010 大賽中的120萬(wàn)張高清圖像分為1000 個(gè)不同的類別。對(duì)測(cè)試數(shù)據(jù),我們得到了top-1 誤差率37.5%,以及

2019-12-03 15:29:00 15

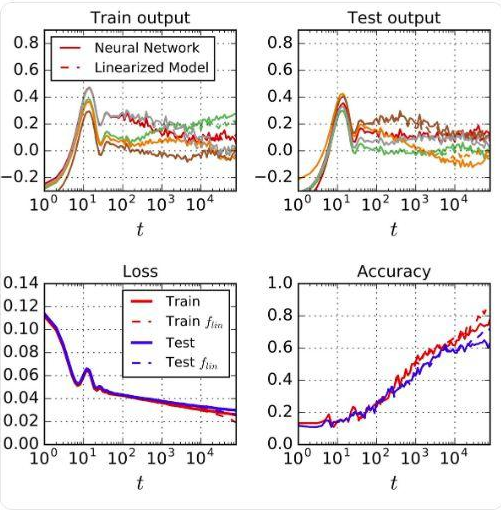

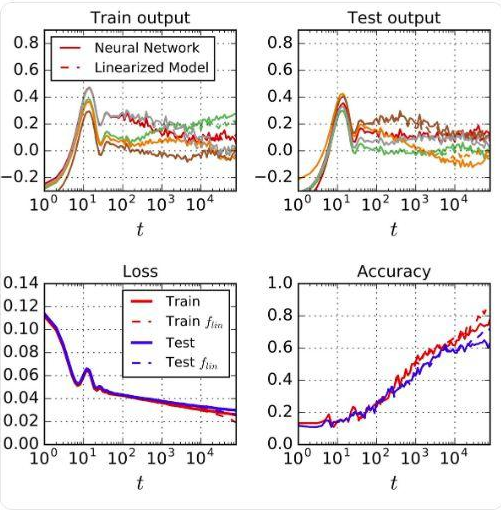

15 實(shí)驗(yàn)中,他們將一個(gè)實(shí)際的神經(jīng)網(wǎng)絡(luò)訓(xùn)練過(guò)程與線性模型的訓(xùn)練過(guò)程相比,發(fā)現(xiàn)兩者高度一致。這里用到的神經(jīng)網(wǎng)絡(luò)是一個(gè)wide ResNet,包括ReLU層、卷積層、pooling層和batch normalization;線性模型是用ResNet關(guān)于其初始(隨機(jī))參數(shù)的泰勒級(jí)數(shù)建立的網(wǎng)絡(luò)。

2020-04-17 11:15:45 2883

2883

成功訓(xùn)練計(jì)算機(jī)視覺(jué)任務(wù)的深層卷積神經(jīng)網(wǎng)絡(luò)需要大量數(shù)據(jù)。這是因?yàn)檫@些神經(jīng)網(wǎng)絡(luò)具有多個(gè)隱藏的處理層,并且隨著層數(shù)的增加,需要學(xué)習(xí)的樣本數(shù)也隨之增加。如果沒(méi)有足夠的訓(xùn)練數(shù)據(jù),則該模型往往會(huì)很好地學(xué)習(xí)訓(xùn)練數(shù)據(jù),這稱為過(guò)度擬合。如果模型過(guò)擬合,則其泛化能力很差,因此對(duì)未見(jiàn)的數(shù)據(jù)的表現(xiàn)很差。

2020-05-04 08:59:00 2727

2727 每當(dāng)我們訓(xùn)練自己的神經(jīng)網(wǎng)絡(luò)時(shí),我們都需要注意稱為神經(jīng)網(wǎng)絡(luò)的?泛化?的問(wèn)題。從本質(zhì)上講,這意味著我們的模型在從給定數(shù)據(jù)中學(xué)習(xí)以及將...

2020-12-14 21:02:35 557

557 EdgeImpulse是一個(gè)為嵌入式設(shè)備提供在線訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型服務(wù)的網(wǎng)站,它是我們OpenMV的合作伙伴,同時(shí)也均為ST意法半導(dǎo)體的官方合作伙伴。目前EdgeImpulse對(duì)我們OpenMV用戶

2021-03-11 09:33:16 19763

19763 我們訓(xùn)練了一個(gè)大型的深度卷積神經(jīng)網(wǎng)絡(luò),來(lái)將在 ImageNet LSVRC-2010 大賽中的 120萬(wàn)張高清圖像分為 1000 個(gè)不同的類別。對(duì)測(cè)試數(shù)據(jù),我們得到了 top-1 誤差率 37.5

2021-03-29 14:12:05 4

4 為提高卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)檢測(cè)模型精度并增強(qiáng)檢測(cè)器對(duì)小目標(biāo)的檢測(cè)能力,提出一種脫離預(yù)訓(xùn)練的多尺度目標(biāo)檢測(cè)網(wǎng)絡(luò)模型。采用脫離預(yù)訓(xùn)練檢測(cè)網(wǎng)絡(luò)使其達(dá)到甚至超過(guò)預(yù)訓(xùn)練模型的精度,針對(duì)小目標(biāo)特點(diǎn)

2021-04-02 11:35:50 26

26 本文介紹了如何使用Keras框架,搭建一個(gè)小型的神經(jīng)網(wǎng)絡(luò)-多層感知器,并通過(guò)給定數(shù)據(jù)進(jìn)行計(jì)算訓(xùn)練,最好將訓(xùn)練得到的模型提取出參數(shù),放在51單片機(jī)上進(jìn)行運(yùn)行。

2021-11-13 19:21:02 12

12 深度學(xué)習(xí)是推動(dòng)當(dāng)前人工智能大趨勢(shì)的關(guān)鍵技術(shù)。在 MATLAB 中可以實(shí)現(xiàn)深度學(xué)習(xí)的數(shù)據(jù)準(zhǔn)備、網(wǎng)絡(luò)設(shè)計(jì)、訓(xùn)練和部署全流程開(kāi)發(fā)和應(yīng)用。聯(lián)合高性能 NVIDIA GPU 加快深度神經(jīng)網(wǎng)絡(luò)訓(xùn)練和推斷。

2022-02-18 13:31:44 1714

1714 使用 INT4 算法實(shí)現(xiàn)所有矩陣乘法的 Transformer 訓(xùn)練方法。 模型訓(xùn)練得快不快,這與激活值、權(quán)重、梯度等因素的要求緊密相關(guān)。 神經(jīng)網(wǎng)絡(luò)訓(xùn)練需要一定計(jì)算量,使用低精度算法(全量化訓(xùn)練或 FQT 訓(xùn)練)有望提升計(jì)算和內(nèi)存的效率。FQT 在原始的全精度計(jì)算圖中增加

2023-07-02 20:35:01 403

403

神經(jīng)網(wǎng)絡(luò)是一個(gè)具有相連節(jié)點(diǎn)層的計(jì)算模型,其分層結(jié)構(gòu)與大腦中的神經(jīng)元網(wǎng)絡(luò)結(jié)構(gòu)相似。神經(jīng)網(wǎng)絡(luò)可通過(guò)數(shù)據(jù)進(jìn)行學(xué)習(xí),因此,可訓(xùn)練其識(shí)別模式、對(duì)數(shù)據(jù)分類和預(yù)測(cè)未來(lái)事件。

2023-07-26 18:28:41 1623

1623

python卷積神經(jīng)網(wǎng)絡(luò)cnn的訓(xùn)練算法? 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)一直是深度學(xué)習(xí)領(lǐng)域重要的應(yīng)用之一,被廣泛應(yīng)用于圖像、視頻、語(yǔ)音等領(lǐng)域

2023-08-21 16:41:37 859

859 模型訓(xùn)練是將模型結(jié)構(gòu)和模型參數(shù)相結(jié)合,通過(guò)樣本數(shù)據(jù)的學(xué)習(xí)訓(xùn)練模型,使得模型可以對(duì)新的樣本數(shù)據(jù)進(jìn)行準(zhǔn)確的預(yù)測(cè)和分類。本文將詳細(xì)介紹 CNN 模型訓(xùn)練的步驟。 CNN 模型結(jié)構(gòu) 卷積神經(jīng)網(wǎng)絡(luò)的輸入

2023-08-21 16:42:00 885

885 cnn卷積神經(jīng)網(wǎng)絡(luò)模型 卷積神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型 生成卷積神經(jīng)網(wǎng)絡(luò)模型? 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)是一種深度學(xué)習(xí)神經(jīng)網(wǎng)絡(luò),最初被廣泛應(yīng)用于計(jì)算機(jī)

2023-08-21 17:11:47 681

681 。訓(xùn)練神經(jīng)網(wǎng)絡(luò)的挑戰(zhàn)在訓(xùn)練數(shù)據(jù)集的新示例之間取得平衡。七個(gè)具體的技巧,可幫助您更快地訓(xùn)練出更好的神經(jīng)網(wǎng)絡(luò)模型。學(xué)習(xí)和泛化使用反向傳播設(shè)計(jì)和訓(xùn)練網(wǎng)絡(luò)需要做出許多看似任

2023-12-30 08:27:54 319

319

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論