lwIP是瑞士計算機科學院(Swedish Institute of Computer Science)的Adam Dunkels等開發的一套用于嵌入式系統的開放源代碼TCP/IP協議棧。Lwip既可以移植到操作系統上,又可以在無操作系統的情況下獨立運行。

1、LwIP的特性

(2) 支持ICMP協議

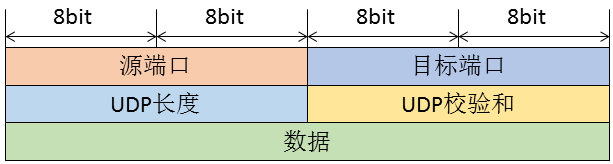

(3) 包括實驗性擴展的的UDP(用戶數據報協議)

(4) 包括阻塞控制,RTT估算和快速恢復和快速轉發的TCP(傳輸控制協議)

(5) 提供專門的內部回調接口(Raw API)用于提高應用程序性能

(6) 可選擇的Berkeley接口API(多線程情況下)

(7) 在最新的版本中支持ppp

(8) 新版本中增加了的IP fragment的支持。

(9) 支持DHCP協議,動態分配ip地址。

2 Lwip在ucos上的移植。

2.1 系統初始化

sys_int必須在tcpip協議棧任務tcpip_thread創建前被調用。

#define MAX_QUEUES 20

#define MAX_QUEUE_ENTRIES 20

typedef struct {

OS_EVENT* pQ;//ucos中指向事件控制塊的指針

void* pvQEntries[MAX_QUEUE_ENTRIES];//消息隊列

//MAX_QUEUE_ENTRIES消息隊列中最多消息數

} TQ_DESCR, *PQ_DESCR;

typedef PQ_DESCR sys_mbox_t;//可見lwip中的mbox其實是ucos的消息隊列

static char pcQueueMemoryPool[MAX_QUEUES * sizeof(TQ_DESCR) ];

void sys_init(void)

{

u8_t i;

s8_t ucErr;

pQueueMem = OSMemCreate( (void*)pcQueueMemoryPool, MAX_QUEUES, sizeof(TQ_DESCR), &ucErr );//為消息隊列創建內存分區

//init lwip task prio offset

curr_prio_offset = 0;

//init lwip_timeouts for every lwip task

//初始化lwip定時事件表,具體實現參考下面章節

for(i=0;i《LWIP_TASK_MAX;i++){

lwip_timeouts[i].next = NULL;

}

}

2.2 創建一個和tcp/ip相關新進程

lwip中的進程就是ucos中的任務,創建一個新進程的代碼如下:

#define LWIP_STK_SIZE 10*1024//和tcp/ip相關任務的堆棧大小。可以根據情況自

//一點也沒有關系:)

//max number of lwip tasks

#define LWIP_TASK_MAX 5 //和tcp/ip相關的任務最多數目

//first prio of lwip tasks

#define LWIP_START_PRIO 5 //和tcp/ip相關任務的起始優先級,在本例中優先級可

//以從(5-9)。注意tcpip_thread在所有tcp/ip相關進程中//應該是優先級最高的。在本例中就是優先級5

//如果用戶需要創建和tcp/ip無關任務,如uart任務等,

//不要使用5-9的優先級

OS_STK LWIP_TASK_STK[LWIP_TASK_MAX][LWIP_STK_SIZE];//和tcp/ip相關進程

//的堆棧區

u8_t curr_prio_offset ;

sys_thread_t sys_thread_new(void (* function)(void *arg), void *arg,int prio)

{

if(curr_prio_offset 《 LWIP_TASK_MAX){

OSTaskCreate(function,(void*)0x1111, &LWIP_TASK_STK[curr_prio_offset][LWIP_STK_SIZE-1],

LWIP_START_PRIO+curr_prio_offset );

curr_prio_offset++;

return 1;

} else {

// PRINT(“ lwip task prio out of range ! error! ”);

}

}

從代碼中可以看出tcpip_thread應該是最先創建的。

2.3 Lwip中的定時事件

在tcp/ip協議中很多時候都要用到定時,定時的實現也是tcp/ip協議棧中一個重要的部分.lwip中定時事件的數據結構如下。

struct sys_timeout {

struct sys_timeout *next;//指向下一個定時結構

u32_t time;//定時時間

sys_timeout_handler h;//定時時間到后執行的函數

void *arg;//定時時間到后執行函數的參數。

};

struct sys_timeouts {

struct sys_timeout *next;

};

struct sys_timeouts lwip_timeouts[LWIP_TASK_MAX];

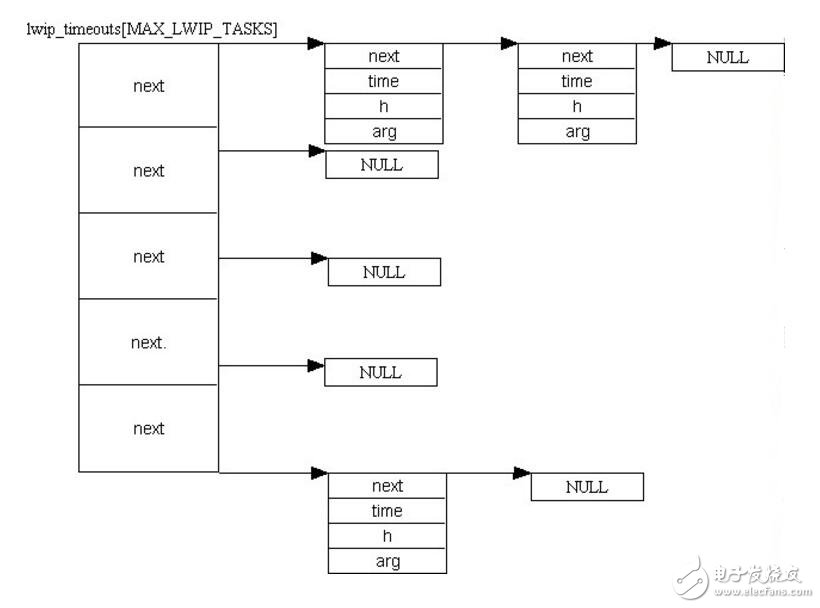

Lwip中的定時事件表的結構如下圖,每個和tcp/ip相關的任務的一系列定時事件組成一個單向鏈表。每個鏈表的起始指針存在lwip_timeouts的對應表項中。

函數sys_arch_timeouts返回對應于當前任務的指向定時事件鏈表的起始指針。該指針存在lwip_timeouts[MAX_LWIP_TASKS]中。

struct sys_timeouts null_timeouts;

struct sys_timeouts * sys_arch_timeouts(void)

{

u8_t curr_prio;

s16_t err,offset;

OS_TCB curr_task_pcb;

null_timeouts.next = NULL;

//獲取當前任務的優先級

err = OSTaskQuery(OS_PRIO_SELF,&curr_task_pcb);

curr_prio = curr_task_pcb.OSTCBPrio;

offset = curr_prio - LWIP_START_PRIO;

//判斷當前任務優先級是不是tcp/ip相關任務,優先級5-9

if(offset 《 0 || offset 》= LWIP_TASK_MAX)

{

return &null_timeouts;

}

return &lwip_timeouts[offset];

}

注意:楊曄大俠移植的代碼在本函數有一個bug.楊曄大俠的移植把上面函數中的OS_TCB curr_task_tcb定義成了全局變量,使本函數成為了一個不可重入函數。我也是在進行如下測試時發現了這個bug.我的開發板上設置的ip地址是192.168.1.95.我在windows的dos窗口內運行

ping 192.168.1.95 –l 2000 –t,不間斷用長度為2000的數據報進行ping測試,同時使用tftp客戶端軟件給192.168.1.95下載一個十幾兆程序,同時再使用telnet連接192.168.1.95端口7(echo端口),往該端口寫數測試echo功能。

在運行一段時間以后,開發板進入不再響應。我當時也是經過長時間的分析才發現是因為在低優先級任務運行ys_arch_timeouts()時被高優先級任務打斷改寫了curr_task_tcb的值,從而使sys_arch_timeouts返回的指針錯誤,進而導致系統死鎖。函數sys_timeout給當前任務增加一個定時事件:

void sys_timeout(u32_t msecs, sys_timeout_handler h, void *arg)

{

struct sys_timeouts *timeouts;

struct sys_timeout *timeout, *t;

timeout = memp_malloc(MEMP_SYS_TIMEOUT);//為定時事件分配內存

if (timeout == NULL) {

return;

}

timeout-》next = NULL;

timeout-》h = h;

timeout-》arg = arg;

timeout-》time = msecs;

timeouts = sys_arch_timeouts();//返回當前任務定時事件鏈表起始指針

if (timeouts-》next == NULL) {//如果鏈表為空直接增加該定時事件

timeouts-》next = timeout;

return;

}

//如果鏈表不為空,對定時事件進行排序。注意定時事件中的time存儲的是本事件

//時間相對于前一事件的時間的差值

if (timeouts-》next-》time 》 msecs) {

timeouts-》next-》time -= msecs;

timeout-》next = timeouts-》next;

timeouts-》next = timeout;

} else {

for(t = timeouts-》next; t != NULL; t = t-》next) {

timeout-》time -= t-》time;

if (t-》next == NULL ||

t-》next-》time 》 timeout-》time) {

if (t-》next != NULL) {

t-》next-》time -= timeout-》time;

}

timeout-》next = t-》next;

t-》next = timeout;

break;

}

}

}

}

函數sys_untimeout從當前任務定時事件鏈表中刪除一個定時事件

void sys_untimeout(sys_timeout_handler h, void *arg)

{

struct sys_timeouts *timeouts;

struct sys_timeout *prev_t, *t;

timeouts = sys_arch_timeouts();//返回當前任務定時事件鏈表起始指針

if (timeouts-》next == NULL)//如果鏈表為空直接返回

{

return;

}

//查找對應定時事件并從鏈表中刪除。

for (t = timeouts-》next, prev_t = NULL; t != NULL; prev_t = t, t = t-》next)

{

if ((t-》h == h) && (t-》arg == arg))

{

/* We have a match */

/* Unlink from previous in list */

if (prev_t == NULL)

timeouts-》next = t-》next;

else

prev_t-》next = t-》next;

/* If not the last one, add time of this one back to next */

if (t-》next != NULL)

t-》next-》time += t-》time;

memp_free(MEMP_SYS_TIMEOUT, t);

return;

}

}

return;

}

2.2.3 “mbox”的實現:

(1)mbox的創建

sys_mbox_t sys_mbox_new(void)

{

u8_t ucErr;

PQ_DESCR pQDesc;

//從消息隊列內存分區中得到一個內存塊

pQDesc = OSMemGet( pQueueMem, &ucErr );

if( ucErr == OS_NO_ERR ) {

//創建一個消息隊列

pQDesc-》pQ=OSQCreate(&(pQDesc-》pvQEntries[0]), MAX_QUEUE_ENTRIES );

if( pQDesc-》pQ != NULL ) {

return pQDesc;

}

}

return SYS_MBOX_NULL;

}

(2)發一條消息給”mbox”

const void * const pvNullPointer = 0xffffffff;

void sys_mbox_post(sys_mbox_t mbox, void *data)

{

INT8U err;

if( !data )

data = (void*)&pvNullPointer;

err= OSQPost( mbox-》pQ, data);

}

在ucos中,如果OSQPost (OS_EVENT *pevent, void *msg)中的msg==NULL 會返回一條OS_ERR_POST_NULL_PTR錯誤。而在lwip中會調用sys_mbox_post(mbox,NULL)發送一條空消息,我們在本函數中把NULL變成一個常量指針0xffffffff.

(3)從”mbox”中讀取一條消息

#define SYS_ARCH_TIMEOUT 0xffffffff

void sys_mbox_fetch(sys_mbox_t mbox, void **msg)

{

u32_t time;

struct sys_timeouts *timeouts;

struct sys_timeout *tmptimeout;

sys_timeout_handler h;

void *arg;

again:

timeouts = sys_arch_timeouts();////返回當前任務定時事件鏈表起始指針

if (!timeouts || !timeouts-》next) {//如果定時事件鏈表為空

sys_arch_mbox_fetch(mbox, msg, 0);//無超時等待消息

} else {

if (timeouts-》next-》time 》 0) {

//如果超時事件鏈表不為空,而且第一個超時事件的time !=0

//帶超時等待消息隊列,超時時間等于超時事件鏈表中第一個超時事件的time,

time = sys_arch_mbox_fetch(mbox, msg, timeouts-》next-》time);

//在后面分析中可以看到sys_arch_mbox_fetch調用了ucos中的OSQPend系統調

//用從消息隊列中讀取消息。

//如果”mbox”消息隊列不為空,任務立刻返回,否則任務進入阻塞態。

//需要重點說明的是sys_arch_mbox_fetch的返回值time:如果sys_arch_mbox_fetch

//因為超時返回,time=SYS_ARCH_TIMEOUT,

//如果sys_arch_mbox_fetch因為收到消息而返回,

//time = 收到消息時刻的時間-執行sys_arch_mbox_fetch時刻的時間,單位是毫秒

//由于在ucos中任務調用OSQPend系統調用進入阻塞態,到收到消息重新開始執行

//這段時間沒有記錄下來,所以我們要簡單修改ucos的源代碼。(后面我們會看到)。

} else {

//如果定時事件鏈表不為空,而且第一個定時事件的time ==0,表示該事件的定時

//時間到

time = SYS_ARCH_TIMEOUT;

}

if (time == SYS_ARCH_TIMEOUT) {

//一個定時事件的定時時間到

tmptimeout = timeouts-》next;

timeouts-》next = tmptimeout-》next;

h = tmptimeout-》h;

arg = tmptimeout-》arg;

memp_free(MEMP_SYS_TIMEOUT, tmptimeout);

//從內存中釋放該定時事件,并執行該定時事件中的函數

if (h != NULL) {

h(arg);

}

//因為定時事件中的定時時間到或者是因為sys_arch_mbo_fetch超時到而執行到

//這里,返回本函數開頭重新等待mbox的消息

goto again;

} else {

//如果sys_arch_mbox_fetch無超時收到消息返回

//則刷新定時事件鏈表中定時事件的time值。

if (time 《= timeouts-》next-》time) {

timeouts-》next-》time -= time;

} else {

timeouts-》next-》time = 0;

}

}

}

}

u32_t sys_arch_mbox_fetch(sys_mbox_t mbox, void **data, u32_t timeout)

{

u32_t ucErr;

u16_t ucos_timeout;

//在 lwip中 ,timeout的單位是ms

// 在ucosII ,timeout 的單位是timer tick

ucos_timeout = 0;

if(timeout != 0){

ucos_timeout = (timeout )*( OS_TICKS_PER_SEC/1000);

if(ucos_timeout 《 1)

ucos_timeout = 1;

else if(ucos_timeout 》 65535)

ucos_timeout = 65535;

}

//如果data!=NULL就返回消息指針,

if(data != NULL){

*data = OSQPend( mbox-》pQ, (u16_t)ucos_timeout, &ucErr );

}else{

OSQPend(mbox-》pQ,(u16_t)ucos_timeout,&ucErr);

}

//這里修改了ucos中的OSQPend系統調用,

//原來的void *OSQPend (OS_EVENT *pevent, INT16U timeout, INT8U *err)

// err的返回值只有兩種:收到消息就返回OS_NO_ERR,超時則返回OS_TIMEOUT

//這里先將err從8位數據改變成了16位數據 OSQPend(*pevent,timeout, INT16U *err)

//重新定義了OS_TIMEOUT

//在ucos中原有#define OS_TIMEOUT 20

//改為 #define OS_TIMEOUT -1

//err返回值的意義也改變了,如果超時返回OS_TIMEOUT

// 如果收到消息,則返回OSTCBCur-》OSTCBDly修改部分代碼如下

//if (msg != (void *)0) { /* Did we get a message? */

// OSTCBCur-》OSTCBMsg = (void *)0;

// OSTCBCur-》OSTCBStat = OS_STAT_RDY;

// OSTCBCur-》OSTCBEventPtr = (OS_EVENT *)0;

// *err = OSTCBCur-》OSTCBDly;// zhangzs @2003.12.12

// OS_EXIT_CRITICAL();

// return (msg); /* Return message received */

// }

//關于ucos的OSTBCur-》OSTCBDly的含義請查閱ucos的書籍

if( ucErr == OS_TIMEOUT ) {

timeout = SYS_ARCH_TIMEOUT;

} else {

if(*data == (void*)&pvNullPointer )

*data = NULL;

//單位轉換,從ucos tick-》ms

timeout = (ucos_timeout -ucErr)*(1000/ OS_TICKS_PER_SEC);

}

return timeout;

}

semaphone的實現和mbox類似,這里就不再重復了.

3、LwIP移植心得

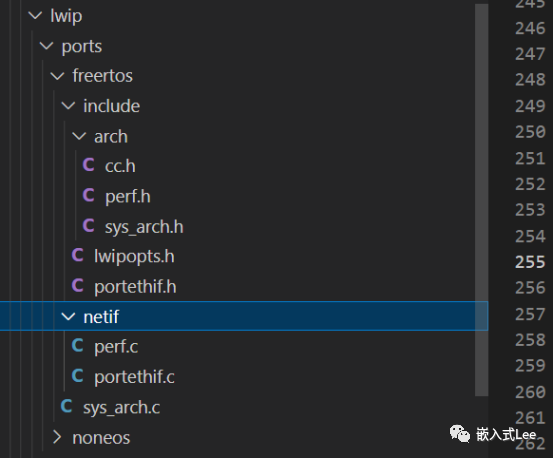

平臺是LPC2136+ENC28J60,32K的RAM,軟件是uCOS-II 2.51+LwIP 1.1.1。

感覺主要解決兩個問題:

操作系統仿真層的移植。這個基于uCOS-II的代碼太多了。COPY下就行!

1)設備驅動的移植

驅動的移植主要就是完成ethernetif.c的工作。作者已經給好了驅動的接口。

struct netif {

struct netif *next;

struct ip_addr ip_addr;

struct ip_addr netmask;

struct ip_addr gw;

err_t (* input)(struct pbuf *p, struct netif *inp);

err_t (* output)(struct netif *netif, struct pbuf *p,

struct ip_addr *ipaddr);

err_t (* linkoutput)(struct netif *netif, struct pbuf *p);

void *state;

#if LWIP_DHCP

struct dhcp *dhcp;

#endif

unsigned char hwaddr_len;

unsigned char hwaddr[NETIF_MAX_HWADDR_LEN];

u16_t mtu;

char name[2];

u8_t num;

u8_t flags;

};

主要就是:

err_t (* input)(struct pbuf *p, struct netif *inp);

這個是被驅動調用的,傳遞一個數據包給TCP/IP棧。

err_t (* output)(struct netif *netif, struct pbuf *p,struct ip_addr *ipaddr);

這個是被IP模塊調用的,向以太網上發送一個數據包,函數要先通過IP地址獲得解決硬件地址,然后發包。

err_t (* linkoutput)(struct netif *netif, struct pbuf *p);

這個是直接發送數據包的接口。

相應的作者在ethernetif.c里面給了幾個函數框架,這個文件相當于一個硬件抽象層。

static void low_level_init(struct netif *netif)

網卡初始化函數

static err_t low_level_output(struct netif *netif, struct pbuf *p)

鏈路層發送函數,實現err_t (* linkoutput)接口。

static struct pbuf *low_level_input(struct netif *netif)

得到一整幀數據

static err_t ethernetif_output(struct netif *netif, struct pbuf *p,struct ip_addr *ipaddr)

實現發送線程,實現err_t (* output)接口。

static void ethernetif_input(struct netif *netif)

實現接收線程,識別數據包是ARP包還是IP包

err_t ethernetif_init(struct netif *netif)

初始化底層接口,給作者給好了驅動的接口賦值啊啥的。

其實,寫驅動的時候只要自己再建個ethernet.c,實際的網絡硬件控制的文件

然后提供幾個函數

比如:

void EMACInit( void )

硬件的初始化

void EMACPacketSend ( u8_t *buffer, u16_t length )

用來將buffer里面的包復制到網絡設備的發送緩沖里面,發送。

u16_t EMACPacketReceive ( u8_t *buffer, u16_t max_length )

用來將網絡設備的接收緩沖里面的包數據復制到buffer里面。

u16_t EMACPacketLength ( u16_t max_length )

獲得包長度

還有其他控制類函數。

最后,用ethernet.c里的函數完成ethernetif.c里的框架。這樣脈絡可能會清楚一點。

2)應用層的那邊問題

(1).lwip提供三種API:1)RAW API 2)lwip API 3)BSD API。

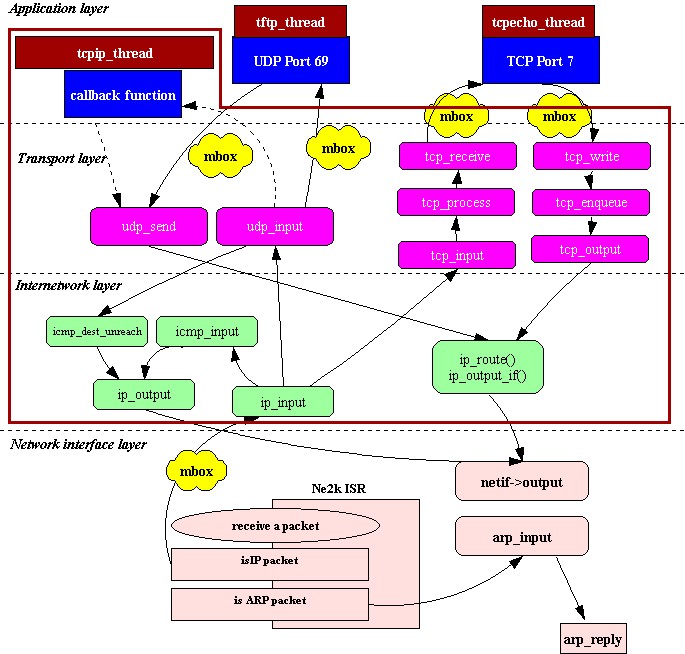

對于多任務系統而言,因為lwip采用的是將TCP/IP協議放在一個單獨的線程里面,所以那個線程是tcpip_thread。采用RAW API回調技術,就得把應用層程序寫在tcpip_thread這個線程里面,作為同一個任務運行。

而采用lwip API,就可以將TCP/IP協議和應用層程序放在不同的任務里面,通過調api_lib.c提供的函數,編寫相應的應用層代碼。好象一般都會采用這種方式。

BSD API就是那sockets.c里面的,沒用過。

(2)任務間是如何調度的

從底層到應用層,一般將底層數據接收做為一個線程,可以建個任務也可以直接在中斷里解決。

然后tcpip_thread是一個線程,最后是應用層一個線程。

底層的郵箱投遞活動是通過調用tcpip.c里的tcpip_input。這個函數向tcpip_thread投遞消息。高層的投遞應該是通過tcpip_apimsg。

遇到的問題:

一開始移植的時候,驅動寫好的,能PING通,但TCP的任務沒反應,這個我那問題是lwip協議棧的問題,換個版本的協議棧就搞定了,網上吧,下的協議棧,有的是有問題的。

電子發燒友App

電子發燒友App

評論