上個月,OpenAI 發(fā)布其最新語言模型——GPT-2,但因?yàn)閾?dān)心它可能被用來制造大量偽造和虛假的信息,頗為戲劇性地決定不開源該模型。

這一決定也使得 AI 社區(qū)開始討論:如何檢測這類虛假新聞。

在一項(xiàng)新實(shí)驗(yàn)中,來自麻省理工學(xué)院-IBM Watson 人工智能實(shí)驗(yàn)室和哈佛大學(xué)自然語言處理實(shí)驗(yàn)室的研究人員思考,能夠生成如此逼真的文本的語言模型,是否可以用來檢測其他語言模型生成的文本的真假。

圖 丨 OpenAI GPT-2 生成的假新聞。(來源:HENDRIK STROBELT AND SEBASTIAN GEHRMANN)

這個假設(shè)背后的想法很簡單:語言模型通過不斷預(yù)測單詞序列中的下一個概率最大的單詞來產(chǎn)生句子。因此,如果某個語言模型能夠輕松地預(yù)測某一段落中的大部分詞語,那這段文本很可能就是這個語言模型生成的。

研究人員通過構(gòu)建基于 OpenAI GPT-2 開源的小模型的交互式工具來測試他們的想法。當(dāng)為該工具提供一段文字時,它會讓每個單詞高亮不同的顏色,從綠色到黃色到紅色,表示預(yù)測幾率逐漸下降;如果語言模型根本沒有預(yù)測出某一單詞,它會用紫色高亮該單詞。所以從理論上講,紅色和紫色詞的越多,該文本由人類書寫的概率就越大;如果綠色和黃色詞的份額越大,該文本由語言模型生成的概率就越大。

圖 丨 OpenAI GPT-2 小模型生成的文本。(來源:HENDRIK STROBELT AND SEBASTIAN GEHRMANN)

事實(shí)上,研究人員發(fā)現(xiàn),GPT-2 的小模型和完整版本的模型所寫的段落幾乎完全是綠色和黃色,而人類寫的科學(xué)文摘和美國入學(xué)標(biāo)準(zhǔn)化測試中閱讀理解段落中的文字有很多紅色和紫色。

圖 丨 美國入學(xué)標(biāo)準(zhǔn)化測試中的閱讀理解短文,由人類書寫。(來源:HENDRIK STROBELT AND SEBASTIAN GEHRMANN)

但事情沒有想象中的簡單。Janelle Shane 是一位負(fù)責(zé)運(yùn)營“Letting Neural Networks Be Weird“博客的研究員,她并未參與前文所述的研究。她將該工具用于更嚴(yán)格的測試,不僅僅提供 GPT-2 生成的文本,還提供了由其他語言模型生成的文本,包括一個用亞馬遜評論訓(xùn)練的模型和一個用《龍與地下城》語料訓(xùn)練的模型。

她發(fā)現(xiàn),這個工具無法預(yù)測每個段落中的大部分單詞,因此該工具認(rèn)為這些文本是人類寫的。這說明一個重要觀點(diǎn):語言模型可能擅長檢測自己的輸出,但不一定擅長檢測其他語言模型的輸出。

看來,人類打擊互聯(lián)網(wǎng)假新聞還是任重道遠(yuǎn)啊。

-

互聯(lián)網(wǎng)

+關(guān)注

關(guān)注

54文章

11229瀏覽量

105556 -

AI

+關(guān)注

關(guān)注

87文章

34146瀏覽量

275284

原文標(biāo)題:假新聞AI也可用于檢測消息真假,你信嗎?

文章出處:【微信號:lianggezhizi,微信公眾號:兩個質(zhì)子】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

適用于數(shù)據(jù)中心和AI時代的800G網(wǎng)絡(luò)

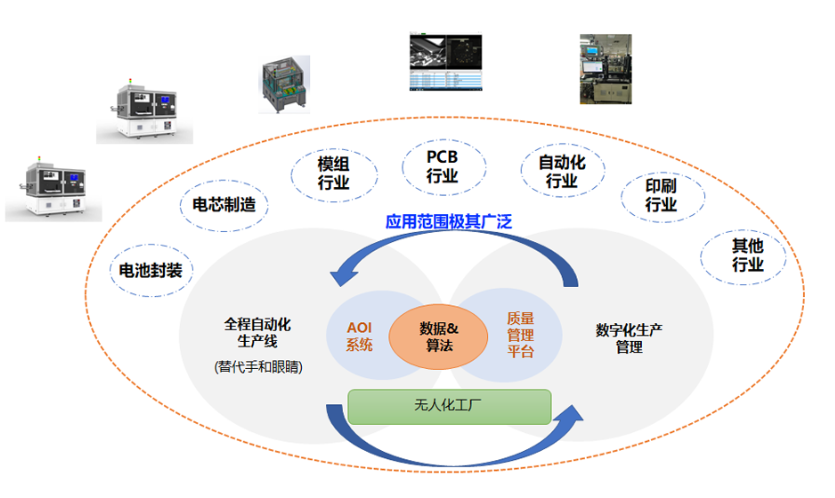

AI智能質(zhì)檢系統(tǒng) 工業(yè)AI視覺檢測

工業(yè)AI視覺檢測項(xiàng)目實(shí)施第四步:工廠驗(yàn)收

汽車行業(yè)AI視覺檢測(下):創(chuàng)新驅(qū)動品質(zhì)提升

AI干貨補(bǔ)給站04 | 工業(yè)AI視覺檢測項(xiàng)目實(shí)施第三步:模型構(gòu)建

直播報(bào)名丨第4講:AI檢測系統(tǒng)落地工具詳解

AI干貨補(bǔ)給站03 | 工業(yè)AI視覺檢測項(xiàng)目實(shí)施第二步:數(shù)據(jù)收集

直播報(bào)名丨第2講:熱門AI檢測案例解析

AI學(xué)堂首播丨一節(jié)課詳解AI檢測系統(tǒng)開發(fā)全流程

使用TI Edge AI Studio和AM62A進(jìn)行基于視覺AI的缺陷檢測

ai煙火檢測解決方案

AI如何檢測這類虛假新聞

AI如何檢測這類虛假新聞

評論