近日,谷歌AI團隊新發布的BERT模型,在NLP業內引起巨大反響,認為是NLP領域里程碑式的進步。BERT的創新點在哪里?新智元專欄作者潘晟鋒對這篇論文進行了深度解讀。

最近谷歌研究人員通過新的BERT模型在11項NLP任務中奪得STOA結果,這在自然語言處理學界以及工業界都引起了不小的熱議。

作者通過在33億文本的語料上訓練語言模型,再分別在不同的下游任務上微調,這樣的模型在不同的任務均得到了目前為止最好的結果,并且有一些結果相比此前的最佳成績得到了幅度不小的提升。

作者的這一研究其實是今年深度學習在自然語言處理中一個新熱點方向的延續,故事還得從更早一點說起。

論文地址:

https://arxiv.org/abs/1810.04805

BERT的“前任”們

早在2015年的時候,微軟研究院的何凱明和他的同事們發表了殘差網絡的論文,第一次通過殘差的方式將卷積神經網絡推進到了100層以上,并在圖像識別的任務上刷新了當時的最高紀錄。自那以后起,隨著網絡不斷地加深,效果也在不斷提升。然而大量的數據訓練出來的大型網絡雖然效果更好,但隨著網絡的加深以及數據集的不斷擴大,完全重新訓練一個模型所需要的成本也在不斷地增加。

因此在計算機視覺處理中,人們越來越多地采用預訓練好的大型網絡來提取特征,然后再進行后續任務。目前這種處理方式已經是圖像處理中很常見的做法了。

相比之下,自然語言處理目前通常會使用預訓練的詞向量來進行后續任務。但詞向量是通過淺層網絡進行無監督訓練,雖然在詞的級別上有著不錯的特性,但卻缺少對連續文本的內在聯系和語言結構的表達能力。因此大家也希望能像圖像領域那樣,通過大量數據來預訓練一個大型的神經網絡,然后用它來對文本提取特征去做后續的任務,以期望能得到更好的效果。其實這一方向的研究一直在持續,直到今年的早些時候AllenAI提出的[ELMo](https://arxiv.org/pdf/1802.05365.pdf)由于其在后續任務上的優異表現獲得了不小的關注。

在ELMo獲得成功以后不久FastAI就推出了[ULMFiT](https://arxiv.org/abs/1801.06146),其大體思路是在微調時對每一層設置不同的學習率。此后OpenAI又提出了[GPT](https://blog.openai.com/language-unsupervised/)。

從上面提及的這些論文的結果以及學界和工業界的反饋來看,這種使用大量的語料進行預訓練,然后再在預訓練好的模型上進行后續任務訓練,雖然訓練方式各有不同,但在后續任務都有不同程度的提高。

而谷歌提出的BERT就是在OpenAI的GPT的基礎上對預訓練的目標進行了修改,并用更大的模型以及更多的數據去進行預訓練,從而得到了目前為止最好的效果。

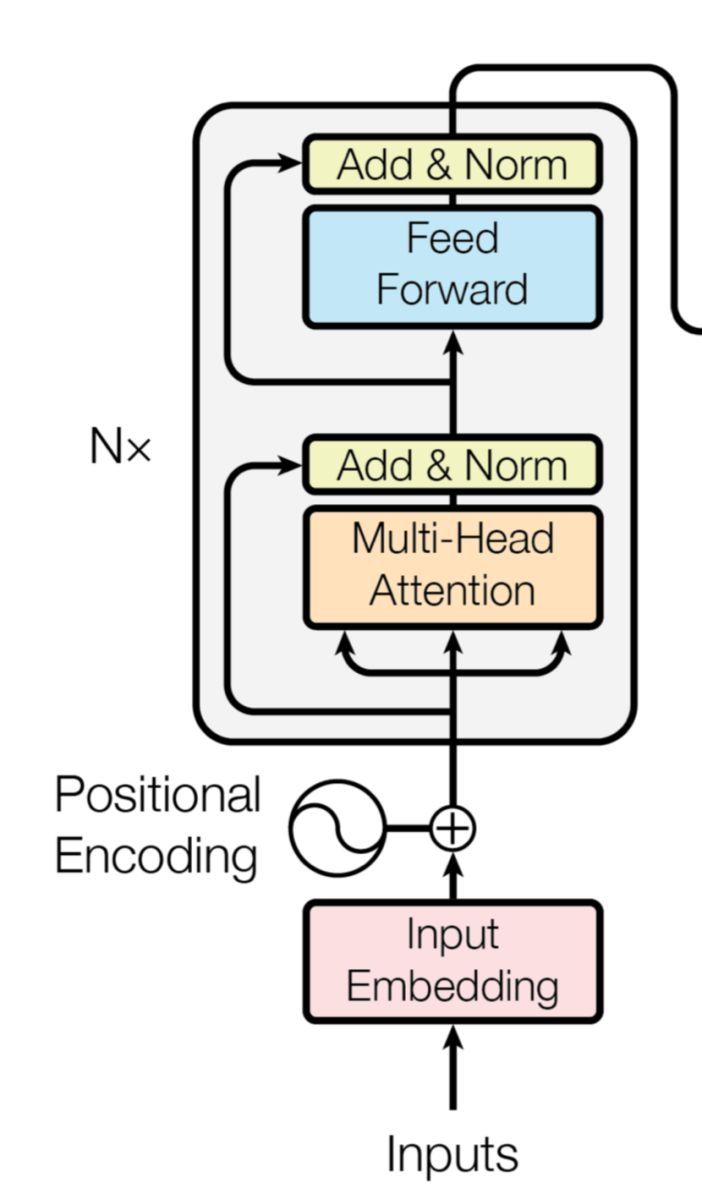

Transformer的編碼器結構

BERT的主體結構和創新點

BERT模型沿襲了GPT模型的結構,采用[Transfomer](https://arxiv.org/abs/1706.03762)的編碼器作為主體模型結構。Transformer舍棄了RNN的循環式網絡結構,完全基于注意力機制來對一段文本進行建模。

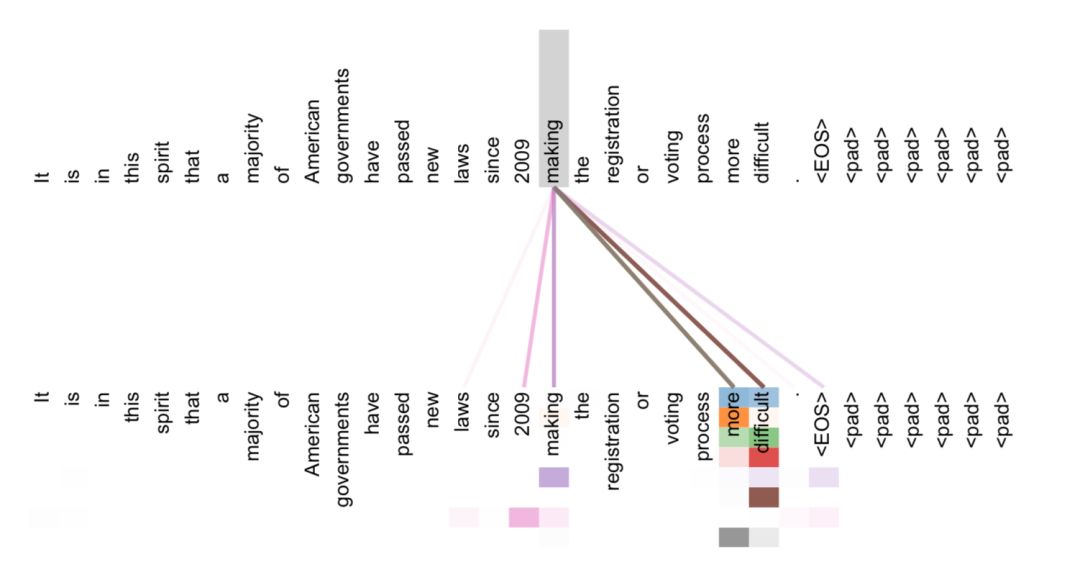

Transformer所使用的注意力機制的核心思想是去計算一句話中的每個詞對于這句話中所有詞的相互關系,然后認為這些詞與詞之間的相互關系在一定程度上反應了這句話中不同詞之間的關聯性以及重要程度。因此再利用這些相互關系來調整每個詞的重要性(權重)就可以獲得每個詞新的表達。這個新的表征不但蘊含了該詞本身,還蘊含了其他詞與這個詞的關系,因此和單純的詞向量相比是一個更加全局的表達。

Transformer通過對輸入的文本不斷進行這樣的注意力機制層和普通的非線性層交疊來得到最終的文本表達。

Transformer的注意力層得到的詞-詞之間關系

GPT則利用了Transformer的結構來進行單向語言模型的訓練。所謂的語言模型其實是自然語言處理中的一種基礎任務,其目標是給定一個序列文本,預測下一個位置上會出現的詞。

模型學習這樣的任務過程和我們人學習一門語言的過程有些類似。我們學習語言的時候會不斷地練習怎么選用合適的詞來造句,對于模型來說也這樣。例如:

> 今天 天氣 不錯, 我們 去 公園 玩 吧。

這句話,單向語言模型在學習的時候是從左向右進行學習的,先給模型看到“今天 天氣”兩個詞,然后告訴模型下一個要填的詞是“不錯”。然而單向語言模型有一個欠缺,就是模型學習的時候總是按照句子的一個方向去學的,因此模型學習每個詞的時候只看到了上文,并沒有看到下文。更加合理的方式應該是讓模型同時通過上下文去學習,這個過程有點類似于完形填空題。例如:

>今天 天氣 { }, 我們 去 公園 玩 吧。

通過這樣的學習,模型能夠更好地把握“不錯”這個詞所出現的上下文語境。

而BERT對GPT的第一個改進就是引入了雙向的語言模型任務。

此前其實也有一些研究在語言模型這個任務上使用了雙向的方法,例如在ELMo中是通過雙向的兩層RNN結構對兩個方向進行建模,但兩個方向的loss計算相互獨立。

而BERT的作者指出這種兩個方向相互獨立或只有單層的雙向編碼可能沒有發揮最好的效果,我們可能不僅需要雙向編碼,還應該要加深網絡的層數。但加深雙向編碼網絡卻會引入一個問題,導致模型最終可以間接地“窺探”到需要預測的詞。這個“窺探”的過程可以用下面的圖來表示:

從圖中可以看到經過兩層的雙向操作,每個位置上的輸出就已經帶有了原本這個位置上的詞的信息了。這樣的“窺探”會導致模型預測詞的任務變得失去意義,因為模型已經看到每個位置上是什么詞了。

為了解決這個問題,我們可以從預訓練的目標入手。我們想要的其實是讓模型學會某個詞適合出現在怎樣的上下文語境當中;反過來說,如果給定了某個上下文語境,我們希望模型能夠知道這個地方適合填入怎樣的詞。從這一點出發,其實我們可以直接去掉這個詞,只讓模型看上下文,然后來預測這個詞。但這樣做會丟掉這個詞在文本中的位置信息,那么還有一種方式是在這個詞的位置上隨機地輸入某一個詞,但如果每次都隨機輸入可能會讓模型難以收斂。

BERT的作者提出了采用MaskLM的方式來訓練語言模型。

通俗地說就是在輸入一句話的時候,隨機地選一些要預測的詞,然后用一個特殊的符號來代替它們。盡管模型最終還是會看到所有位置上的輸入信息,但由于需要預測的詞已經被特殊符號代替,所以模型無法事先知道這些位置上是什么詞,這樣就可以讓模型根據所給的標簽去學習這些地方該填的詞了。

然而這里還有一個問題,就是我們在預訓練過程中所使用的這個特殊符號,在后續的任務中是不會出現的。

因此,為了和后續任務保持一致,作者按一定的比例在需要預測的詞位置上輸入原詞或者輸入某個隨機的詞。當然,由于一次輸入的文本序列中只有部分的詞被用來進行訓練,因此BERT在效率上會低于普通的語言模型,作者也指出BERT的收斂需要更多的訓練步數。

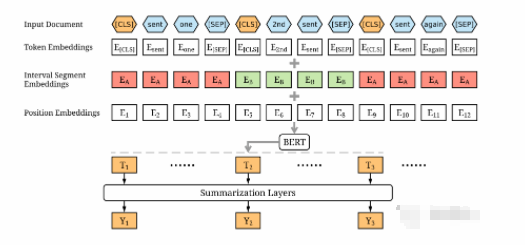

BERT另外一個創新是在雙向語言模型的基礎上額外增加了一個句子級別的連續性預測任務。這個任務的目標也很簡單,就是預測輸入BERT的兩端文本是否為連續的文本,作者指出引入這個任務可以更好地讓模型學到連續的文本片段之間的關系。在訓練的時候,輸入模型的第二個片段會以50%的概率從全部文本中隨機選取,剩下50%的概率選取第一個片段的后續的文本。

除了模型結構,模型大小和數據量都很重要

以上的描述涵蓋了BERT在模型結構和訓練目標上的主要創新點,而BERT的成功還有一個很大的原因來自于模型的體量以及訓練的數據量。

BERT訓練數據采用了英文的開源語料BooksCropus 以及英文維基百科數據,一共有33億個詞。同時BERT模型的標準版本有1億的參數量,與GPT持平,而BERT的大號版本有3億多參數量,這應該是目前自然語言處理中最大的預訓練模型了。

當然,這么大的模型和這么多的數據,訓練的代價也是不菲的。谷歌用了16個自己的TPU集群(一共64塊TPU)來訓練大號版本的BERT,一共花了4天的時間。對于是否可以復現預訓練,作者在[Reddit]( https://www.reddit.com/r/MachineLearning/comments/9nfqxz/r_bert_pretraining_of_deep_bidirectional/?utm_campaign=NLP%20News&utm_medium=email&utm_source=Revue%20newsletter)上有一個大致的回復,指出OpenAI當時訓練GPT用了將近1個月的時間,而如果用同等的硬件條件來訓練BERT估計需要1年的時間。不過他們會將已經訓練好的模型和代碼開源,方便大家訓練好的模型上進行后續任務。

雖然訓練的代價很大,但是這個研究還是帶來了一些思考和啟發。例如雙向語言模型的運用,多任務對預訓練的幫助以及模型深度帶來的收益。相信在未來的一段時間,自然語言處理中預訓練的神經網絡語言模型會得到更多的關注和運用。

-

深度學習

+關注

關注

73文章

5554瀏覽量

122468 -

自然語言處理

+關注

關注

1文章

628瀏覽量

14004

原文標題:解讀谷歌最強NLP模型BERT:模型、數據和訓練

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

J-BERT N4903A高性能串行BERT手冊

BERT模型的PyTorch實現

用圖解的方式,生動易懂地講解了BERT和ELMo等模型

圖解BERT預訓練模型!

基于BERT+Bo-LSTM+Attention的病歷短文分類模型

基于BERT的中文科技NLP預訓練模型

如何使用BERT模型進行抽取式摘要

什么是BERT?為何選擇BERT?

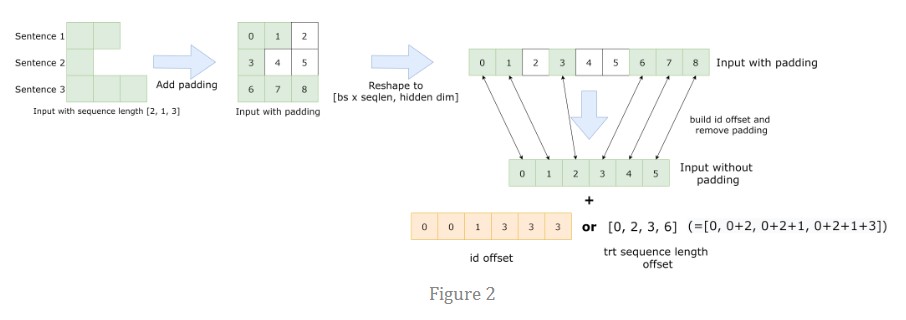

總結FasterTransformer Encoder(BERT)的cuda相關優化技巧

NLP入門之Bert的前世今生

谷歌大型模型終于開放源代碼,遲到但重要的開源戰略

谷歌AI團隊新發布的BERT模型,BERT的創新點在哪里?

谷歌AI團隊新發布的BERT模型,BERT的創新點在哪里?

評論