數據中心與能源消耗

預計到2025年,全球發電量將達到26,787TWh,其中數據中心和加密貨幣將消耗約536TWh,約占全球總發電量的2%。按照目前的趨勢,數據中心的電力消耗到2030年很可能達到甚至超過1,000TWh,接近全球總電力消耗的5%。

如今,全球電力供應仍主要依賴煤炭、天然氣、石油等非可再生能源,但隨著數字化轉型步伐越來越快,電力需求將會越來越高,因此必須提升可再生能源發電量來為這些技術提供支持,同時還要提高這些應用場景的能源利用效率。

在超大規模數據中心〔包括運行人工智能(AI)和高性能計算(HPC)工作負載的數據中心〕中,電子設備冷卻是一個耗電量非常大的領域。各類AI和HPC部署對冷卻的要求高低不一、差異巨大,但通常都需要長時間持續工作,而且它們的功率密度可能高達常規數據中心服務器應用的10倍以上。能源的價格正持續上漲,但電力供應卻難以跟上,因此提高數據中心冷卻效率已成為近年來值得關注的焦點問題。

一些新建的數據中心采用了與可再生能源發電設施同步建設的方式,旨在利用這些可再生能源為數據中心供電。從能源使用的角度來看,這種做法非常經濟高效,但冷卻技術帶來的工作能耗需求仍然很高,足以大幅推高此類項目的初始資本成本。

業界專家設計了許多創新方法,將數據中心轉型為更節能的平臺,例如在沿海地區部署全浸沒在水下的數據中心艙。然而,美國傳統的數據中心通常建在氣候干旱的偏遠地區。廉價土地的充足供應、較少的監管限制以及優惠的稅收政策,使這些地區成為了理想的數據中心選址地點,但代價就更高的冷卻需求以及有限或昂貴的水資源供應。

本文將探討當今數據中心設施的冷卻方法,以及未來有望改變電子設備冷卻行業的新技術。

01數據中心冷卻技術的發展趨勢

超高密度數據中心的機架功率密度已從不到10kW上升到某些情況下超過100kW。在如此高的功率密度面前,大家普遍認為風冷技術無法滿足要求,而且效率過低,難以和液冷技術競爭。在這些方法中,單相直接芯片(DTC)液冷技術在亟需更高效冷卻方法的市場中具備優勢。

DTC技術在冷卻主要處理硬件方面已經頗為成熟并且高效。然而,這種方法往往無法顧及網絡、內存和存儲等硬件芯片,致使它們只能采用風冷。而單相或兩相浸沒式冷卻就是解決這一問題的潛在方案。在浸沒式冷卻中,整個數據中心機架都浸沒在具有良好熱傳導性能的絕緣液體中,從而有效地將電子元器件產生的熱量傳遞至液體中,隨后通過熱交換器(單相)或蒸汽與冷凝管理系統(雙相)實現高效冷卻。后門熱交換器也正在逐漸普及,尤其是在改造風冷為主的傳統數據中心的場景中。

風冷的前期成本非常低,而DTC和浸沒式冷卻則屬于成本高、復雜的冷卻方式之一。對于資金充裕、盈利預期良好的新建數據中心而言,液冷方案顯然是理想選擇。然而,在高昂的前期成本面前,一些老舊數據中心甚至某些新建項目仍在依賴采用傳統空調技術、效率低下的風冷系統。部分地區的監管要求可能會限制此類低效冷卻技術的應用,但運營成本上升帶來的經濟壓力更可能促使數據中心放棄傳統風冷方案。目前,通過優化風扇布局、機架位置以及氣流設計等手段,已經可以顯著提升系統效率、降低成本。

浸沒式冷卻技術有望成為一種非常高效、可持續的冷卻技術,尤其是考慮到該技術能夠應對非常高的熱密度。根據估計,與傳統風冷相比,浸沒式冷卻技術可將數據中心的冷卻能耗降低達90%。隨著AI和HPC領域的新技術推動機架功率密度不斷提高,這項冷卻技術有望進一步得到普及。不過,由于浸沒式冷卻還是一項比較新的技術,其基礎設施的供應暫時還無法跟上數據中心大規模部署的步伐。然而,隨著越來越多浸沒式冷卻企業涌現,并從數據中心的大規模投資中獲利,這一狀況在未來幾年內有望改變。

液冷方法(尤其是浸沒式冷卻)的另一項潛在優勢,在于它能夠將廢熱收集起來,為游泳池、學校、商業區、室內園藝設施、廢棄物處理、化學加工/精煉等應用領域供熱;廢熱甚至還可以供應給熱能儲存系統,這些系統可根據用電需求將廢熱轉化為電能。

02數據中心冷卻技術的未來

新技術的發展,對AI和HPC的響應速度提出了更高的要求,因而需要將它們部署在更接近終端用戶的位置,這與上文討論的限制因素疊加在一起,構成了更大的挑戰。越來越多的應用場景都開始采用AI、虛擬現實(VR)、增強現實(AR)和自動化功能,它們都需要毫秒級的響應時間,所以必須部署在靠近用戶的地方。而大多數此類終端應用場景都位于人口稠密的城市地區,要想在這里建設更多數據中心,勢必要面臨房租貴、空間小、污染和用水限制嚴格、供電容量不足等問題。在空間受限的前提下,要實現數據中心的性能目標,就必須在密度上做文章了。

因此,數據中心機架的功率密度將會不斷提高,比如一個晶圓級AI處理器的功耗就可能高達數十千瓦;然而冷卻技術卻滯后于數據中心的增長和擴張。隨著越來越多AI和HPC技術得到部署,以及云基礎設施為了滿足日益增長的需求而不斷擴展,這種趨勢只會進一步惡化。

對數據中心運營商來說,擺在他們面前的一項艱巨任務,就是徹底改造傳統風冷系統,并將液冷技術融入到新的數據中心設計中。畢竟,對正在運行的數據中心進行任何環境改動,都伴隨著巨大的風險和復雜的運維工作。因此,在資金充足的情況下,運營商為了適應新變化,都更傾向于從頭開始建設新的數據中心,而不是改造現有的數據中心。隨著電子設備冷卻行業不斷并購,數據中心運營商與冷卻企業之間的合作日益增多,這將促進先進冷卻技術的普及。

要追趕這一趨勢,需要使用更嚴謹的傳感、分析和優化方案。傳統的算法冷卻控制系統可能會被更先進的冷卻優化技術(包括AI)所取代,以協調數據中心內可能存在的數以萬計的傳感器和冷卻裝置。而實現優化的方式之一,是借助先進的監控和分析技術,讓數據中心能夠運行在高于傳統目標值的溫度下,同時又能夠確保沒有任何硬件的溫度達到導致性能下降的程度。

結語

目前,風冷仍占據數據中心冷卻的主導地位,但在不久之后,改造和新建的數據中心就會開始采用風冷/液冷混合技術,而未來的數據中心或超高密度數據中心將會采用先進的液冷技術。為了實現這樣的目標,DTC必須進一步提高可靠性,因為即使是幾秒鐘的DTC故障,也可能導致服務器長時間停機或損壞。浸沒式冷卻技術可以滿足這一可靠性需求,而且能夠實現更高的功率密度,但其代價是復雜性增加,以及需要更專業的安裝和維護。

未來,機架功率密度將會超過100kW乃至300kW,工程師在考慮散熱問題時不能只局限于機架。如何將冷卻過程中產生的多余熱能加以收集利用,將變得愈發關鍵,尤其是在許多政府和機構正尋求立法,要求數據中心實現顯著的可持續性水平的背景下。

-

冷卻

+關注

關注

0文章

45瀏覽量

18171 -

數據中心

+關注

關注

16文章

5130瀏覽量

73186

原文標題:AI與HPC:數據中心冷卻技術的發展和未來展望

文章出處:【微信號:貿澤電子,微信公眾號:貿澤電子】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

? 尼得科從5月開始量產AI數據中心新型冷卻系統產品——行間式(In Row式)大型CDU

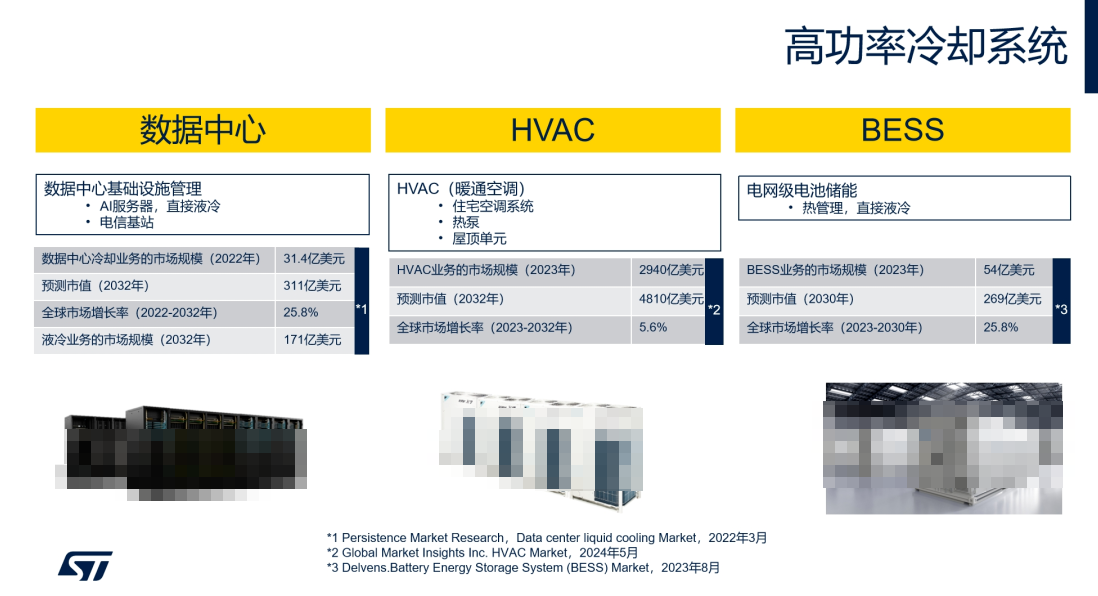

ST電機控制方案如何為數據中心等高功率冷卻系統“降溫增效”

華為亮相2025數據中心冷卻高峰論壇(長三角)

華為全新升級星河AI數據中心網絡

Molex莫仕助力數據中心浸沒式冷卻系統未來發展

數據中心發展與改造

華為發布2025數據中心能源十大趨勢

超云亮相2024數據中心標準大會,展示AI全棧推理硬件創新成果

NPU的市場前景與發展趨勢

引領智算中心的冷卻技術,下一個風口在哪里?

數據中心冷卻技術的發展趨勢

數據中心冷卻技術的發展趨勢

評論