云原生Ingress網關高并發高可用解決思路

當Ingress網關面臨高并發請求(如 QPS 超過 10萬+)時,可能導致服務崩潰、響應延遲激增或資源耗盡。以下是系統性解決方案和分布式網關架構設計思路:

一、單點性能優化

首先優化現有 Ingress 網關的性能,挖掘單節點潛力:

1.硬件與資源調優

?垂直擴容:提升節點配置(CPU/內存/網絡帶寬)。

?內核參數優化:

# 調整連接數、端口范圍、TIME_WAIT 復用 net.core.somaxconn = 65535 net.ipv4.tcp_max_syn_backlog = 65535 net.ipv4.tcp_tw_reuse = 1 net.ipv4.ip_local_port_range = 1024 65535

?啟用 DPDK/用戶態協議棧:如 Nginx 的DPDK 模式、Envoy 的Kernel Bypass。

2.Ingress 配置優化

?連接復用:啟用 HTTP/2、gRPC 長連接。

?緩沖與超時:合理設置proxy_buffer、proxy_timeout。

?靜態資源緩存:在 Ingress 層緩存靜態內容(如圖片、JS)。

# Nginx Ingress 緩存示例

proxy_cache_path/tmp/nginx_cache levels=1:2keys_zone=my_cache:10mmax_size=1g;

location/static/ {

proxy_cachemy_cache;

proxy_passhttp://backend;

}

3.限流與熔斷

?限流策略:

# Nginx Ingress 限流(每秒 1000 請求) annotations: nginx.ingress.kubernetes.io/limit-rps:"1000"

?熔斷降級:集成 Hystrix 或 Sentinel,在網關層攔截異常流量。

二、分布式網關架構

突破單點性能瓶頸,設計分布式高可用網關集群:

1.水平擴展(Scale Out)

?多副本負載均衡:部署多個 Ingress 實例,通過 DNS 輪詢或外部負載均衡器(如 AWS ALB、Nginx)分發流量。

?自動擴縮容(HPA):基于 CPU、內存或自定義指標(QPS)自動擴縮。

# Kubernetes HPA 示例 apiVersion:autoscaling/v2 kind:HorizontalPodAutoscaler metadata: name:ingress-hpa spec: scaleTargetRef: apiVersion:apps/v1 kind:Deployment name:ingress-nginx minReplicas:3 maxReplicas:100 metrics: -type:Resource resource: name:cpu target: type:Utilization averageUtilization:80

2.分層網關架構

?邊緣層:使用云廠商的全球負載均衡(如 AWS Global Accelerator、Cloudflare)就近接入用戶。

?區域層:在多個區域部署 Ingress 集群,通過 Anycast 或 GeoDNS 路由流量。

?服務層:每個服務獨立部署專用 Ingress,避免全局瓶頸。

3.高性能替代方案

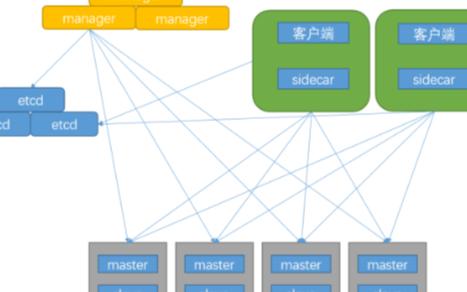

?Envoy + xDS 控制平面:

? 使用 Envoy 作為數據平面,支持動態配置更新和高效連接管理。

? 集成 Istio 或 Gloo 作為控制平面,實現流量拆分、金絲雀發布。

?云原生 API 網關:

?Kong:基于 Nginx 和 OpenResty,支持插件擴展。

?APISIX:基于 etcd 的動態路由,支持多協議(MQTT、gRPC)。

?服務網格(Service Mesh):

? 將流量管理下沉到 Sidecar(如 Istio、Linkerd),分散網關壓力。

三、流量治理與異步化

1.流量卸載

?靜態資源 CDN 化:將圖片、CSS、JS 等靜態資源卸載到 CDN。

?API 緩存:對查詢類 API 使用 Redis 或 Varnish 緩存響應。

2.異步處理

?請求隊列:將非實時請求寫入 Kafka/RabbitMQ,后端異步消費。

?邊緣計算:在靠近用戶的邊緣節點處理部分邏輯(如鑒權、過濾)。

3.協議優化

?二進制協議:使用 Protobuf、Thrift 替代 JSON 降低序列化開銷。

?QUIC/HTTP3:減少連接建立延遲,提升弱網性能。

四、監控與容災

1.全鏈路監控

?指標采集:監控 QPS、延遲、錯誤率(Prometheus + Grafana)。

?分布式追蹤:集成 Jaeger 或 Zipkin 定位慢請求。

2.容災策略

?多活容災:跨地域部署網關集群,支持流量快速切換。

?故障注入:通過 Chaos Engineering 測試系統韌性。

五、典型分布式網關架構示例

用戶請求 → 全球負載均衡(DNS/Anycast) → 區域 Ingress 集群(Envoy/Nginx)

邊緣緩存(CDN) 服務網格 Sidecar(Istio)

異步隊列(Kafka) 后端服務集群

總結

?單點優化:最大化單節點性能,配置限流、緩存、資源調優。

?水平擴展:通過多副本 + 自動擴縮容分散壓力。

?架構升級:采用 Envoy/APISIX 等高性能網關,結合服務網格和 CDN。

?異步治理:通過隊列、邊緣計算、協議優化降低實時壓力。

最終方案需結合業務場景(如實時性要求、成本預算)選擇,可先通過壓力測試(如 JMeter、wrk)驗證優化效果。

鏈接:https://blog.csdn.net/Franklin7B/article/details/145693326?spm=1001.2014.3001.5502

-

cpu

+關注

關注

68文章

11031瀏覽量

215924 -

網關

+關注

關注

9文章

5258瀏覽量

52434 -

云原生

+關注

關注

0文章

257瀏覽量

8199

原文標題:云原生Ingress網關高并發高可用解決思路

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Kubernetes Ingress 高可靠部署最佳實踐

從服務端視角看高并發難題

亞信AX58200 EtherCAT轉Modbus TCP網關解決方案介紹視頻

AX58400 EtherCAT轉IO-Link網關與馬達控制解決方案演示視頻

性能提升1倍,成本直降50%!基于龍蜥指令加速的下一代云原生網關

飛騰攜手寶蘭德推出應用服務器聯合解決方案,助力大數據高并發處理

BFE Ingress Controller基于BFE實現的Kubernetes Ingress Controller

Ingress網關高并發請求的解決方案

Ingress網關高并發請求的解決方案

評論