DeepSeek 系列模型概覽

DeepSeek 系列包括大型語言模型(如 DeepSeek LLM、R1)及多模態模型(DeepSeek-VL)和編程模型(DeepSeek Coder)等,參數量從十億量級到數百億甚至千億級不等。例如,DeepSeek LLM 67B 在多項評測中已超過同級別開源模型。這些模型通常采用 Transformer 架構及如多頭潛在注意力(MLA)、專家混合(MoE)等優化技術,從而在性能上取得優異表現。但其計算和內存需求也極高:部署原始的大型模型往往需要多卡 GPU 集群(如數十到上百塊 H100)才能在合理速度下推理。總體來看,DeepSeek 模型在邊緣端 原生運行難度極大 ,但其設計也鼓勵通過壓縮和加速來實現邊緣部署的可能性。下面從算力需求、部署優化、芯片架構、應用場景和產業趨勢等方面詳述 DeepSeek 對邊緣 AI 芯片的影響。

1. 算力需求與推理效率

- 模型規模及資源需求 :DeepSeek 系列模型規模巨大,如 DeepSeek LLM 67B、DeepSeek-R1 671B 等都遠超普通嵌入式模型。這意味著完整模型推理時需要數十至數百 GB 內存,以及強大的并行算力。行業分析指出,要匹配 DeepSeek 官方報告的吞吐量,需要部署數十甚至上百塊高端 GPU(如 NVIDIA H100)。因此,對典型邊緣 NPU 或 FPGA 而言,直接運行數百億參數的模型并不可行,必須借助模型壓縮或分布式推理等手段。

- 推理效率優化 :DeepSeek 模型采用了多頭潛在注意力(MLA)等創新結構,將所有注意力頭的鍵值信息合并成共享隱向量,從而大幅減少注意力緩存需求。這一設計可以在一定程度上緩解內存帶寬和容量壓力,對邊緣推理尤為有益。同時,DeepSeek 團隊也強調了流水線并行(prefill/decode)和專家并行等策略來提升推理吞吐。例如,開源社區復現中使用了預填充-解碼拆分和大規模專家并行,在每節點約 52K 輸入 token/s 的吞吐上幾近官方報告水平。這些優化手段說明,DeepSeek 模型的架構更側重推理效率,但也意味著硬件需支持復雜并行計算和緩存管理。

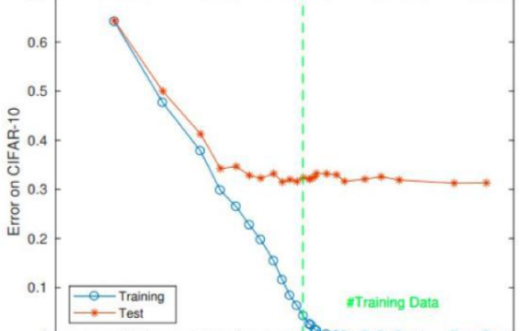

- 能效和內存需求 :盡管有結構性優化,DeepSeek 模型推理能耗依然很高。業內認為,新一代芯片設計必須更加關注 推理端的能效優化 ,對低精度運算和稀疏計算給予更好支持。例如,模型壓縮后的小模型可在手機上實時生成文本,可見硬件需提供足夠的計算力和帶寬。根據 DeepSeek 提供的數據,量化和剪枝等技術可顯著降低模型體積和運算量,例如 4-bit 量化可使模型體積縮減約75%、推理速度提高3–5倍;結構化剪枝可去除約50%參數、使延遲減少60%。這些數據表明,為支持邊緣推理,芯片對 大規模低精度矩陣運算 、大型片上緩存和高帶寬互連等硬件資源有新要求。

2. 部署挑戰與優化策略

- 模型壓縮技術 :部署 DeepSeek 模型的最大瓶頸是其龐大的規模,因此壓縮技術至關重要。DeepSeek 社區總結了量化、剪枝、低秩分解等模型壓縮方法,以及知識蒸餾技術。這些方法組合使用能夠系統化地縮減模型大小并保留性能。官方報告顯示,將模型量化到 4-bit 或使用混合精度可極大降低存儲需求,結合 GPU/NPU 的低精度計算單元,可直接提升推理效率。結構化剪枝可按通道或神經元移除冗余權重,從硬件友好性角度出發保留張量連續性,這使得剪枝后的模型能夠在現有芯片上加速推理,同時延遲大幅降低。

- 知識蒸餾 :DeepSeek 通過蒸餾訓練得到多個輕量級學生模型,以便在邊緣設備上部署。蒸餾后的小模型可以保有原模型高達95%以上的性能。例如,DeepSeek R1 發布了 1.5B 和 7B 蒸餾版,1.5B 版甚至可在瀏覽器中直接運行,每秒約生成 60 個 token;也有用戶成功在普通手機端流暢部署 1.5B 蒸餾模型,無需高端 GPU。另據披露,4-bit 量化后的 7B 模型可在僅 2GB 內存的筆記本上運行,并支持 CPU/GPU 混合推理。這些實例表明,通過蒸餾和量化后,DeepSeek 大模型在邊緣設備上具有實際運行的 潛力 。

- 部署工具鏈與框架 :為了降低部署門檻,業界已開始將 DeepSeek 等模型兼容到現有推理框架中。例如,SiFive 利用 RISC-V 向量擴展(RVV)優化了 Llama/Llama2 等模型推理,在其 X390 平臺上對 TinyLlama(1.1B)實現了單核實時推理。類似地,可在 ONNX Runtime 或專用加速庫中定制指令來加速矩陣乘法、注意力計算。另外,一些芯片廠商(如 RaiderChip)已經為 DeepSeek-R1 系列提供了原生硬件支持,允許用戶在其通用 AI NPU 上“即插即換”不同 LLM,實現低成本的本地推理部署。總的來說,上述優化策略和工具鏈的成熟使得將 DeepSeek 類大模型部署到邊緣設備的技術可行性大為提升。

3. 對芯片架構的啟發

DeepSeek 等大模型的發展對新一代芯片設計提出了新的思路:

- 推理優化為設計重點 :業界觀點認為,此類模型使芯片設計更注重“推理端”的加速和能效。供應鏈分析指出,未來邊緣 AI 芯片將提供專用的稀疏計算單元和低精度運算支持,以靈活地應對 MoE 等復雜架構。在這種方向下,芯片不再僅僅是離散模塊的簡單拼裝,而是需要從整體上深度集成(比如將 CPU、GPU、NPU 共享內存池)以實現更低延遲和更高帶寬。例如,有分析特別提到,蘋果 M 系列芯片的統一內存架構(CPU/GPU/NPU 共享 192GB 內存)非常契合大模型推理需求,這提示新型邊緣芯片可能趨向采用統一或更大容量的片上存儲設計。

- 支持多模態和大上下文 :DeepSeek-VL 等視覺語言模型說明未來應用需要同時處理圖像和文本等多模態數據,這對芯片架構提出多樣化需求。SiMa.ai 在其第二代 Modalix 芯片中就明確定位為“通用多模態 SoC”,其內部集成了改進的 AI 加速器,可同時加速 CNN(用于圖像)和 Transformer(用于語言)任務。為兼顧 Transformer 所需的精度與能效,Modalix 選擇支持 BF16 浮點運算并添加了針對 LLM 常用激活函數(如分段多項式函數)的硬件加速。這表明下代芯片可能內置混合精度運算單元,既能滿足多模態的計算精度,也保持低功耗。

- 擴展指令集與加速器 :為高效執行深度學習運算,芯片開始在指令集層面擴展專用指令。RISC-V 社區推動的向量擴展(RVV)就是一例,可直接用于矩陣乘法和張量運算加速。SiFive 的案例表明,通過RVV優化和定制化指令,RISC-V 智能核心能夠實現在單核上運行 1.1B 級別 LLM 并達到實時性能。未來芯片可能整合類似向量處理單元(VPUs)或張量單元(TPUs),以提高對 Transformer 中矩陣運算、注意力計算的硬件加速。綜合來看,DeepSeek 的多模態、稀疏化設計思路正引導芯片向更加高集成、多功能加速的方向演進。

4. 實際應用場景

DeepSeek 系列模型及其輕量化版本在多種邊緣場景中展現出應用潛力:

- 自動駕駛 :DeepSeek-VL 提供了豐富的視覺-語言理解能力,可應用于自動駕駛的多源感知與決策。例如某技術分析提到,DeepSeek 可融合攝像頭、激光雷達等信息進行復雜場景理解和策略生成。模型壓縮實驗表明,對自動駕駛用的 3D 目標檢測模型進行壓縮后,其推理延遲可從 100ms 降至 30ms,顯著提升了緊急制動等系統響應速度,說明可降低自動駕駛系統對昂貴算力的依賴。

- 智能攝像頭與物聯網 :在安防攝像頭、無人機、工業傳感器等物聯網設備上,DeepSeek 蒸餾版模型展現了在低功耗終端的可部署性。邊緣行業報道指出,DeepSeek 的優化技術能夠讓大型模型“更快、更小、更節能”,可直接在安全攝像頭、傳感器、無人機、手機和車輛等設備上運行。例如,壓縮后的模型可在手機上實現實時文本生成(<500ms),在智能家居和傳感網絡中用于實時決策和預測維護。

- 機器人與嵌入式 AI :嵌入式 AI(如人形機器人)對視覺、語音和多模態理解有復雜需求。行業觀察提到,“Embodied AI”(人形機器人)是與多模態 AI 類似的熱點應用。DeepSeek 模型的多模態能力可用于機器人視覺問答、環境理解等場景。此外,機器人任務往往對帶寬和低延遲要求極高,促使芯片設計兼顧復雜推理和感知數據流。

- AIOps 與運維場景 :在邊緣計算中心和企業級監控中,DeepSeek R1 可用于實時分析日志(MELT:度量、事件、日志、追蹤)并生成運維建議。專家認為,將 LLM 與觀測平臺結合可以實現更主動的維護和故障預測。DeepSeek 的可解釋決策能力也有助于增強 IT 運營的自動化和信任度。總體而言,無論是自動駕駛、智能攝像頭、IoT 設備,還是機器人和 AIOps,DeepSeek 大模型的蒸餾版本都在推動越來越多的邊緣智能應用落地。

5. 市場與產業趨勢

DeepSeek 系列模型的興起正在推動產業鏈上下游做出相應調整:

- 芯片廠商并購與合作 :大型半導體公司積極收購和合作以增強邊緣 AI 能力。2025年,意法半導體(ST)收購了加拿大初創企業 Deeplite,正是看中了其“DeepSeek 技術”——基于模型優化、量化和壓縮的解決方案,以加速自家 STM32N6 MCU 的部署。同樣,高通收購 Edge Impulse、NXP 收購 Kinara 等案例表明業界正在加緊布局。業內普遍預期,隨著邊緣 AI 需求爆發,傳統的 MCU 與 SoC 廠商將加大對嵌入式 NPU 和 AI 加速器的投入。

- 新一代芯片發布 :針對 LLM 推理,已有新芯片問世。Fabless 企業 RaiderChip 推出了面向邊緣推理的 GenAI NPU,專門支持 DeepSeek-R1 等蒸餾模型,用戶可在該芯片上“即插即用”不同 LLM,實現本地化推理加速。SiMa.ai 的 Modalix SoC 則定位為多模態 AI 加速器,針對大型 Transformer 模型優化了算力架構。預計未來各大芯片廠商(例如寒武紀、華為、英特爾、NVIDIA等)也會推出適配大模型推理的產品或加速卡,以搶占邊緣 AI 市場。

- 算力需求激增 :資本市場和研究機構注意到,DeepSeek 等頭部大模型正在迅速擴大算力需求。平安證券等機構分析認為,當國民級應用(如微信)接入 DeepSeek 模型后,推理算力需求會急劇上升,標志著從訓練算力驅動向推理算力驅動的轉變。這種需求的轉變意味著 AI 芯片行業迎來了重要機遇與挑戰,各廠商需提前規劃滿足海量低延遲推理的能力。

- 生態閉環與安全性 :DeepSeek 也促使部分廠商考慮構建全生態閉環。一些報道傳聞其母公司正在招聘芯片設計人才,探索自主可控的“算力—算法—應用”一體化生態。此外,與依賴云端相比,在芯片端運行模型還帶來隱私和安全優勢:RaiderChip CTO 就強調,本地推理可提升方案的獨立性和隱私性。這些趨勢表明,DeepSeek 的流行正在影響芯片設計策略,促進邊緣 AI 生態的快速完善。

綜上所述 ,DeepSeek 系列大模型由于其巨大規模和多模態能力,對邊緣 AI 芯片提出了新的挑戰與需求,同時也激發了量化剪枝等優化技術的應用,推動了支持稀疏計算、低精度運算和統一內存的新架構芯片研發。在自動駕駛、IoT、智能攝像頭、機器人等場景中,精簡版的 DeepSeek 模型已經展現出邊緣部署潛力;市場上芯片廠商正通過并購和新產品開發,積極應對這一趨勢。未來,預計 DeepSeek 這類模型的發展將繼續引領邊緣 AI 芯片向更高性能、更低功耗、更強泛化能力的方向演進。

**參考資料:**結合 DeepSeek 官方資料、業界博客和分析報告,如 DeepSeek 模型發布頁、LMSys/EdgeIR 技術文章、芯片廠商新聞(RaiderChip)、行業媒體報道(騰訊新聞、Sina、36氪、Supplyframe)等進行歸納整理。上述引用文獻編號對應網頁內容。

-

芯片

+關注

關注

459文章

52091瀏覽量

435382 -

邊緣AI

+關注

關注

0文章

145瀏覽量

5319 -

DeepSeek

+關注

關注

1文章

765瀏覽量

1261

發布評論請先 登錄

能效比達2TOPS/W!解密邊緣AI芯片低功耗設計之法

risc-v多核芯片在AI方面的應用

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

AI賦能邊緣網關:開啟智能時代的新藍海

FPGA+AI王炸組合如何重塑未來世界:看看DeepSeek東方神秘力量如何預測......

Deepseek海思SD3403邊緣計算AI產品系統

基于ZU3EG的低功耗高性能嵌入式AI高性能計算模組

利用AI提高性能和降低功耗及重塑芯片的設計

AI邊緣盒子,高算力、高性能、低功耗、提供算法移植服務

智界無感·算力覺醒:DeepSeek與BLE技術融合引爆邊緣AI萬億市場

DeepSeek 引領邊緣 AI 芯片向更高性能、更低功耗、更強泛化能力的方向演進

DeepSeek 引領邊緣 AI 芯片向更高性能、更低功耗、更強泛化能力的方向演進

評論