近年來,隨著千億級參數模型的崛起,AI訓練對算力的需求呈現指數級增長。傳統服務器架構在應對分布式訓練、高并發計算和顯存優化等場景時逐漸顯露瓶頸。而RAKsmart為超大規模模型訓練提供了全新的算力解決方案。

超大規模模型訓練的算力困境

當前AI模型的訓練成本與參數規模呈非線性增長關系。以1750億參數的GPT-3為例,其單次訓練需消耗近128萬GPU小時,而更復雜的多模態模型對算力的需求已突破傳統服務器的承載極限。行業普遍面臨三大挑戰:

顯存墻限制:單個GPU的顯存容量難以容納超大型模型的參數與梯度數據;

通信效率瓶頸:分布式訓練中,跨節點數據傳輸延遲導致計算資源閑置率高達30%;

能源成本失控:傳統集群的能效比(TFLOPS/Watt)難以滿足千卡級訓練任務的經濟性要求。

這些痛點直接制約著AI研發效率與商業落地進程。

RAKsmart的AI原生架構設計

針對上述挑戰,RAKsmart提出“硬件-軟件-網絡”三位一體的AI原生架構,通過深度協同設計打破算力天花板。

1.硬件層:異構計算與高速互聯

GPU集群優化:采用NVIDIAH100TensorCoreGPU構建計算單元,通過NVLink4.0實現單節點8卡間900GB/s的帶寬,較PCIe5.0提升7倍;

顯存擴展技術:集成ZeRO-3(零冗余優化器)與梯度分片算法,將模型參數動態分配到多GPU顯存中,支持單集群訓練參數量突破萬億級;

存儲加速方案:配置Optane持久內存與NVMeSSD組成的混合存儲池,實現訓練數據預處理吞吐量達40GB/s,較傳統方案提升5倍。

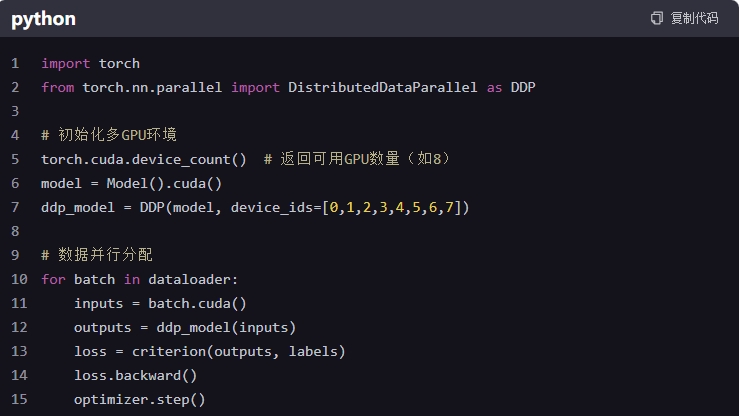

2.軟件層:框架深度調優

分布式訓練加速:針對PyTorch、DeepSpeed等框架定制通信庫,將AllReduce操作延遲降低至15μs(行業平均50μs),梯度同步效率提升70%;

動態資源調度:基于強化學習開發智能調度引擎,可實時感知訓練任務的計算密度,自動調整GPU/CPU資源配比,使集群利用率穩定在92%以上;

容錯機制創新:采用Checkpoint快照壓縮技術,將模型保存間隔從30分鐘縮短至5分鐘,故障恢復時間減少80%。

3.網絡層:低延遲拓撲重構

部署RoCEv2(RDMAoverConvergedEthernet)網絡協議,實現節點間200Gbps超低延遲通信;

采用Dragonfly拓撲結構,確保任意兩節點間最大跳數不超過3,使大規模集群的通信效率衰減率控制在8%以內(傳統FatTree架構為25%)。

通過硬件重構、算法協同與網絡創新,RAKsmart不僅解決了超大規模模型訓練的算力困境,更重新定義了AI時代的基礎設施標準。想了解更多服務器相關內容請關注RAKsmart網站。

審核編輯 黃宇

-

服務器

+關注

關注

12文章

9663瀏覽量

87197 -

AI

+關注

關注

87文章

34001瀏覽量

275122 -

算力

+關注

關注

2文章

1133瀏覽量

15420

發布評論請先 登錄

AI原生架構升級:RAKsmart服務器在超大規模模型訓練中的算力突破

AI原生架構升級:RAKsmart服務器在超大規模模型訓練中的算力突破

評論