背景

經常買 Raspberry Pi 的朋友們都知道,Raspberry Pi 5 作為業內最優秀的 SBC(Single Board Computer),除了其本身優秀的軟硬件綜合性能之外,為了方便更多高性能外設的拓展,新增了一組 PCIE3.0x1 外設接口,可以通過 FFC 線纜連接到官方或者第三方 HAT 組件。從去年開始樹莓派就陸陸續續介紹了各種基于 HAT PCIE 拓展的方案

今年春節之后,隨著 DeepSeek 破圈,樹莓派的開發者們也不再限于只使用 Raspberry Pi5 運行傳統的CNN小模型(例如 YOLO)。社區對大語音模型、多模態大模型、生成模型在樹莓派板卡上高效率部署的訴求也越來越多。

今天開始分享由國內優秀的端側AI芯片公司愛芯元智推出的基于 Raspberry Pi 5 的算力拓展解決方案,看看有哪些樹莓派生態硬件已經/即將支持,以及其簡單易上手的特性。

優勢

相比樹莓派官方的 Hailo8 或者 Halio8L 的算力套件,其優勢如下

AI示例豐富

支持但不限于以下內容

大語言模型

DeepSeek R1 Distill、Qwen、Llama3、MiniCPM、SmolLM2、InternML

多模態大模型

Qwen2.5-VL、InternVL2.5、MiniCPM-V、SmolVLM、Janus Pro

語音類模型

Whisper、WeNet、MeloTTS、OpenVoice

生成似模型

StableDiffusionv1.5、LivePortrait

多模態模型

CLIP、YOLOWorldv2

主流 CNN&Transformer 模型

Ultralytics YOLO 全系列、SAM、DepthAnythingv2、Metric3D、RAFT-Stereo、MixFormerv2 等

資源消耗小

獨立存儲,運行各種AI模型不占用 樹莓派5 系統的 DDR 帶寬;獨立編解碼模塊,最大支持 32 路 1080P30 解碼

二次開發簡單

提供 C++/Python API,編解碼單元已適配 FFmpeg。國內本土全棧技術方案,解決方案豐富成熟,技術支持高效

功耗低

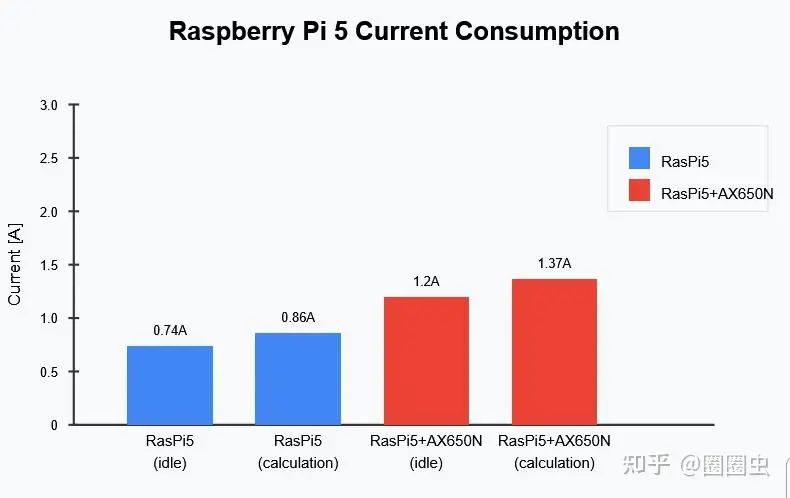

滿載功耗<8w,可被動散熱,不需額外供電,采用 樹莓派5 標準的適配器,通過 FFC 給 HAT 拓展算力配件供電即可

性價比高

價格實惠

硬件介紹

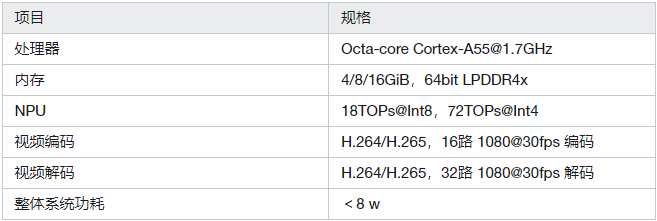

無論是通過已有 HAT 拓展的 M.2 2280 標準算力卡,還是針對 樹莓派5 定制的 HAT AI Module,共有產品特性如下:

M.2 算力卡

HAT AI Module

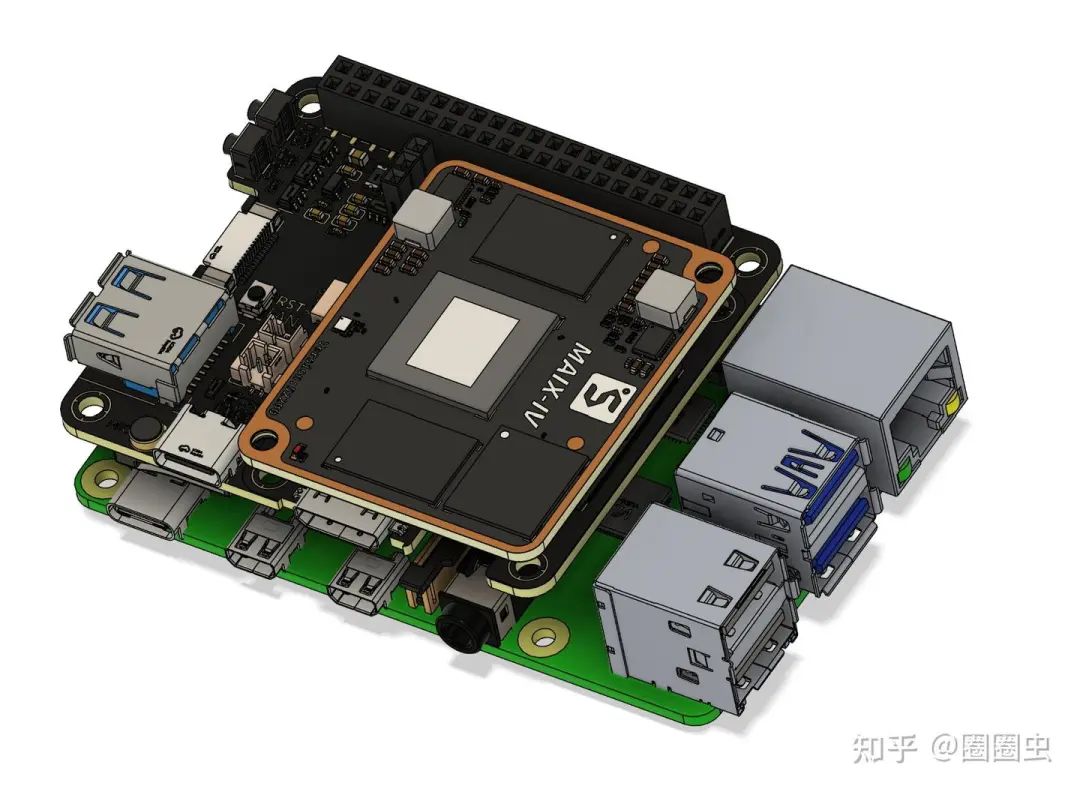

硬件安裝

M.2 算力卡

在樹莓派 5 上安裝 M.2 加速卡時,首先需要準備一塊 M.2 HAT+ 擴展板。參考官方鏈接,M.2 HAT+ 的官方版本只支持 2230、2242 的 M.2 M Key 卡,通常 AX650 加速卡是 2280 的,您可能需要考慮購買第三方的支持 2280 長度的 M.2 HAT+ 擴展板。

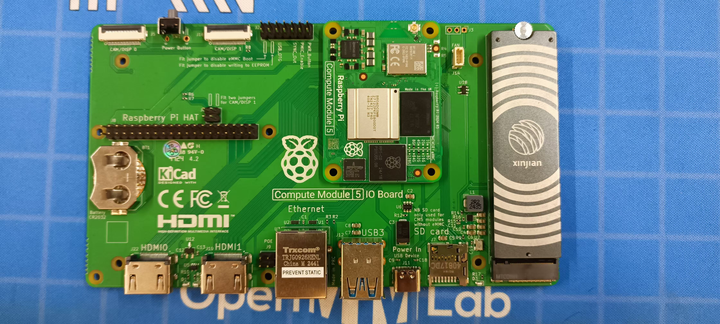

如果是 CM5 的用戶,建議直接使用 CM5 配套的 Compute Module 5。

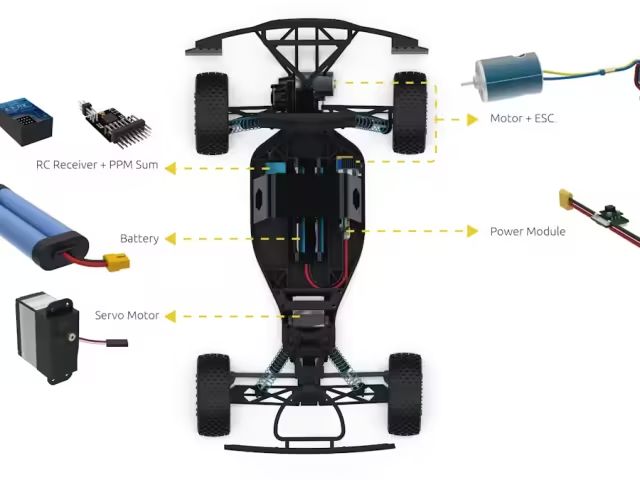

示意圖

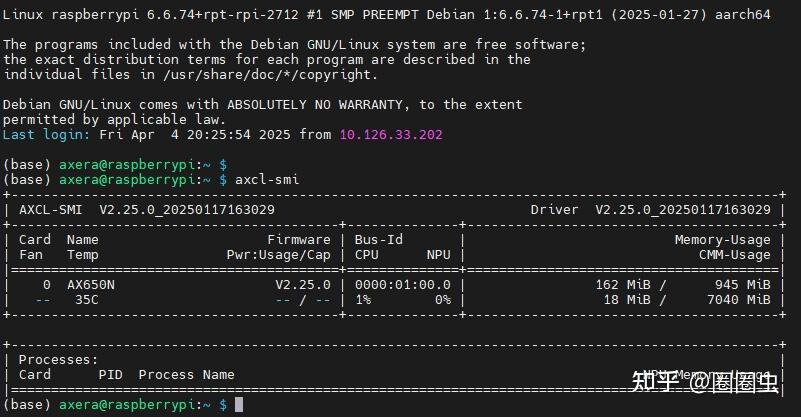

軟件安裝

AXCL 是用于在Axera芯片平臺上開發深度神經網絡推理、轉碼等應用的 C、Python 語言 API 庫,提供運行資源管理,內存管理,模型加載和執行,媒體數據處理等 API。基于樹莓派5安裝 AXCL 驅動軟件的詳細過程可參考

https://axcl-pi5-examples-cn.readthedocs.io/zh-cn/latest/doc_guide_setup_sw.html

正確安裝 AXCL 驅動包后,AXCL-SMI 即安裝成功,直接執行axcl-smi顯示內容如下:

AI 易用性

API 兼容 ONNXRuntime

考慮到樹莓派開發者中,通常為了快速進行產品開發,會使用 Python API 進行快速功能驗證。通常會使用 ONNXRuntime CPU 進行模型部署。因此 AXCL 的 NPU Python API 提供了“像素級”兼容,原則上只需要在以往的 ONNXRuntime Python 腳本中,僅需將 import onnxruntime as ort 修改為 import axengine as ort 即可。詳細使用說明請參考 pyaxengine

AI 示例展示

普通模型

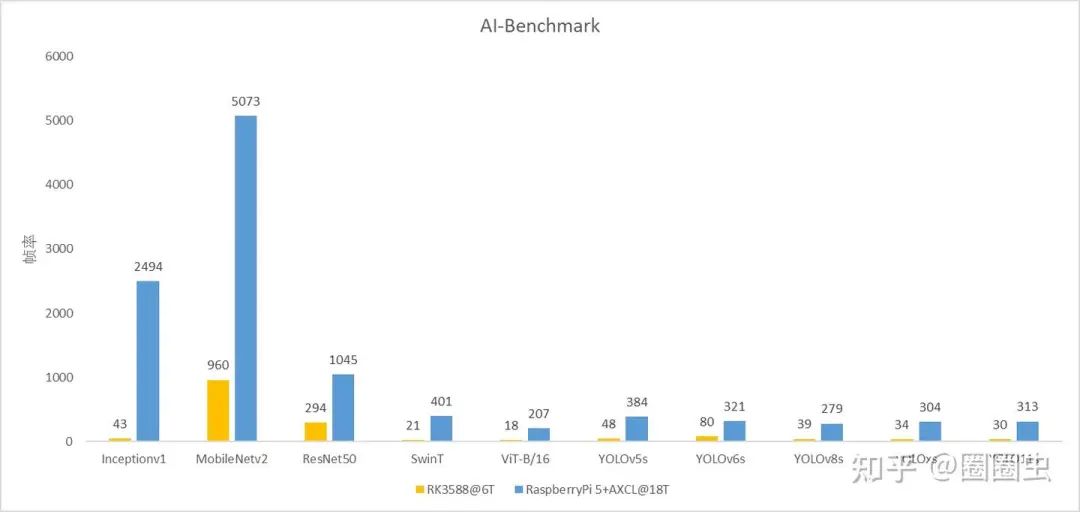

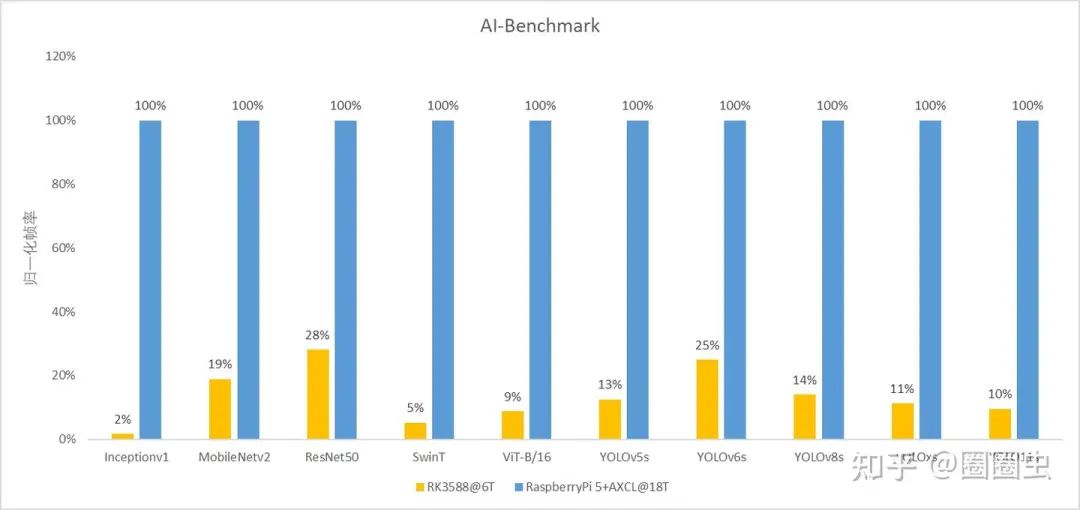

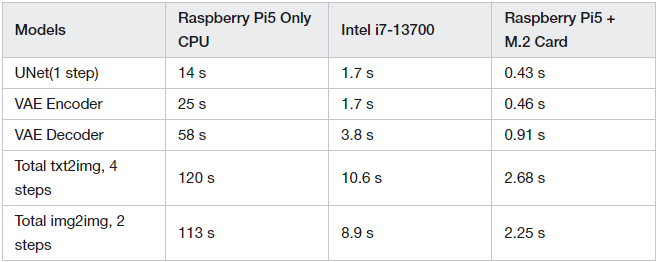

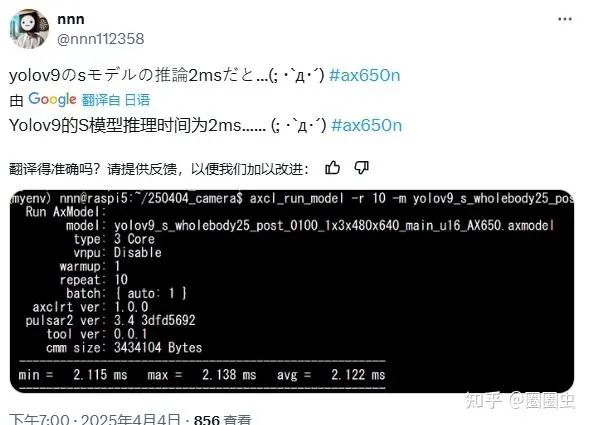

這里橫向對比下其他內置算力的 SBC,從圖中可以看出運行普通的 CNN 和 Transformer,RaspberryPi5+M.2 算力卡的組合計算效果更高。

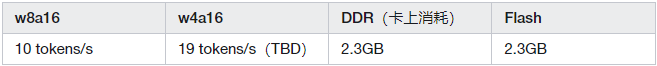

Qwen2.5-1.5B

大語言模型基本應用

模型文件獲取 Huggingface

https://huggingface.co/AXERA-TECH/Qwen2.5-1.5B-Instruct-CTX-Int8

支持較長的上下文,2.5k

支持 System Prompt 緩存

支持 prefill 優化

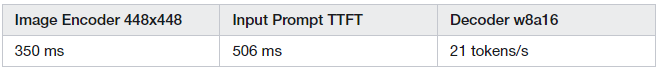

InternVL2_5-1B

圖片理解,真正的的多模態大模型

模型文件獲取 Huggingface

https://huggingface.co/AXERA-TECH/InternVL2_5-1B

StableDiffusionv1.5

文生圖、圖生圖

模型文件獲取 Huggingface

https://huggingface.co/AXERA-TECH/lcm-lora-sdv1-5

Raspberry Pi5 使用基于 AX650N 的算力模組拓展,SD1.5 的推理性能可以提升 40 倍(生成圖片大小 512x512)

Whisper

模型文件獲取 Huggingface

https://huggingface.co/AXERA-TECH/Whisper

測試音頻一共 4 秒,在 愛芯派Pro 上 Whisper small 模型運行耗時 740 ms,RTF(?Real-Time Factor) = 0.19,RTF 越低?:意味著 ASR 系統處理語音的速度越快。實時因子低的 ASR 系統在需要實時響應的應用場景(如語音助手)中尤為關鍵?。

社區反饋

其實 樹莓派 + M.2大模型算力卡 的拓展形態,已經有海外社區用戶提前嘗鮮,從反饋看,還是相當滿意,可玩性很高。

后續計劃

本篇文章只是投石問路,我們會根據樹莓派社區的反饋,積極輸出大家更想了解的算力拓展解決方案。希望通過這樣的組合方式,解決樹莓派生態中算力欠缺的劣勢,賦能樹莓派生態拓展更多有價值的AI產品方案。

不斷適配前沿流行的大模型

聯合硬件生態合作伙伴,推出更多適用于樹莓派主機的算力配件

進一步提升算力模組的軟件易用性,開源 視頻解碼硬件+智能分析+業務后處理 一站式解決方案

聯合樹莓派生態,拓展各種垂直領域的智能解決方案

-

AI

+關注

關注

87文章

34146瀏覽量

275322 -

樹莓派

+關注

關注

121文章

1936瀏覽量

106971 -

大模型

+關注

關注

2文章

3020瀏覽量

3813

發布評論請先 登錄

樹莓派“吉尼斯世界記錄”:將樹莓派的性能發揮到極致的項目!

樹莓派5 與 樹莓派4:深度對比與獨特優勢!

能夠精準定位的樹莓派機器人!

你的樹莓派為什么越用越卡?揭秘SD卡里的&amp;quot;圖書館管理員&amp;quot;

樹莓派&AXCL:樹莓派離線大模型新范式!

樹莓派&AXCL:樹莓派離線大模型新范式!

評論