深度學(xué)習(xí)模型介紹

DeepDive系統(tǒng)在數(shù)據(jù)處理階段很大程度上依賴于NLP工具,如果NLP的過程中存在錯(cuò)誤,這些錯(cuò)誤將會(huì)在后續(xù)的標(biāo)注和學(xué)習(xí)步驟中被不斷傳播放大,影響最終的關(guān)系抽取效果。為了避免這種傳播和影響,近年來深度學(xué)習(xí)技術(shù)開始越來越多地在關(guān)系抽取任務(wù)中得到重視和應(yīng)用。本章主要介紹一種遠(yuǎn)程監(jiān)督標(biāo)注與基于卷積神經(jīng)網(wǎng)絡(luò)的模型相結(jié)合的關(guān)系抽取方法以及該方法的一些改進(jìn)技術(shù)。

Piecewise Convolutional Neural Networks(PCNNs)模型

PCNNs模型由Zeng et al.于2015提出,主要針對(duì)兩個(gè)問題提出解決方案:

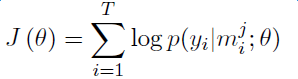

針對(duì)遠(yuǎn)程監(jiān)督的wrong label problem,該模型提出采用多示例學(xué)習(xí)的方式從訓(xùn)練集中抽取取置信度高的訓(xùn)練樣例訓(xùn)練模型。

針對(duì)傳統(tǒng)統(tǒng)計(jì)模型特征抽取過程中出現(xiàn)的錯(cuò)誤和后續(xù)的錯(cuò)誤傳播問題,該模型提出用 piecewise 的卷積神經(jīng)網(wǎng)絡(luò)自動(dòng)學(xué)習(xí)特征,從而避免了復(fù)雜的NLP過程。

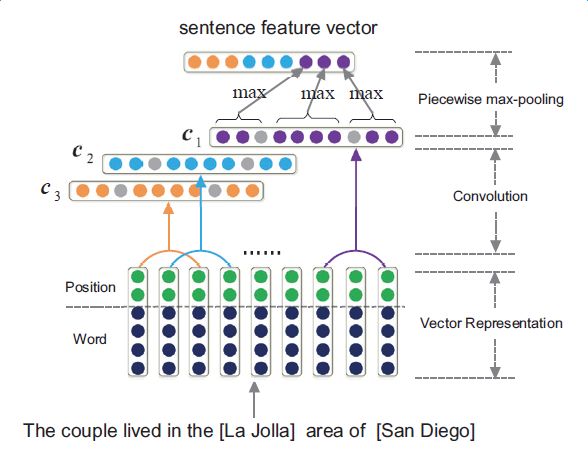

下圖是PCNNs的模型示意圖:

PCNNs模型主要包括以下幾個(gè)步驟:

實(shí)驗(yàn)證明,PCNNs + 多實(shí)例學(xué)習(xí)的方法 Top N 上平均值比單純使用多示例學(xué)習(xí)的方法高了 5 個(gè)百分點(diǎn)。

Attention機(jī)制和其它改進(jìn)

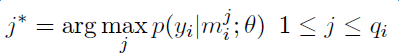

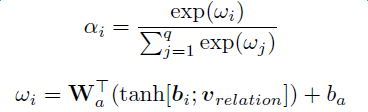

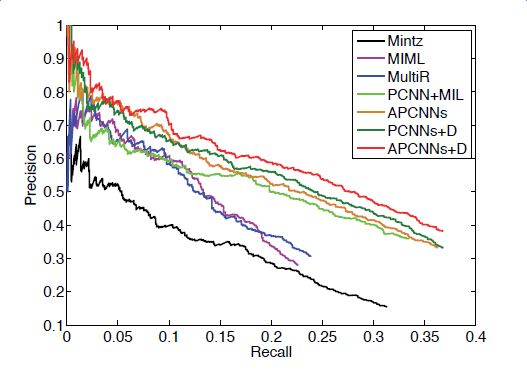

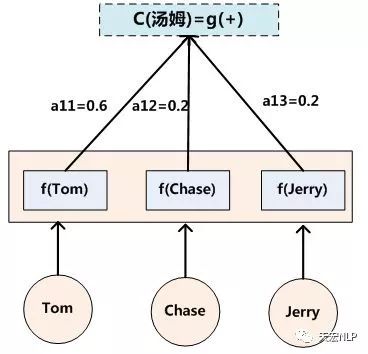

上述模型對(duì)于每個(gè)實(shí)體對(duì)只選用一個(gè)句子進(jìn)行學(xué)習(xí)和預(yù)測(cè),損失了大量的來自其它正確標(biāo)注句子的信息。為了在濾除wrong label case的同時(shí),能更有效地利用盡量多的正確標(biāo)注的句子,Lin et al. 于2016年提出了PCNNs+Attention(APCNNs)算法。相比之前的PCNNs模型,該算法在池化層之后,softmax層之前加入了一種基于句子級(jí)別的attention機(jī)制,算法的示意圖如下:

除了Attention機(jī)制外,還有一些其它的輔助信息也被加入多示例學(xué)習(xí)模型來改關(guān)系抽取的質(zhì)量,例如在計(jì)算實(shí)體向量的時(shí)候加入實(shí)體的描述信息(Ji et al.,2017);利用外部神經(jīng)網(wǎng)絡(luò)獲取數(shù)據(jù)的可靠性和采樣的置信度等信息對(duì)模型的訓(xùn)練進(jìn)行指導(dǎo)(Tang et al.,2017)。

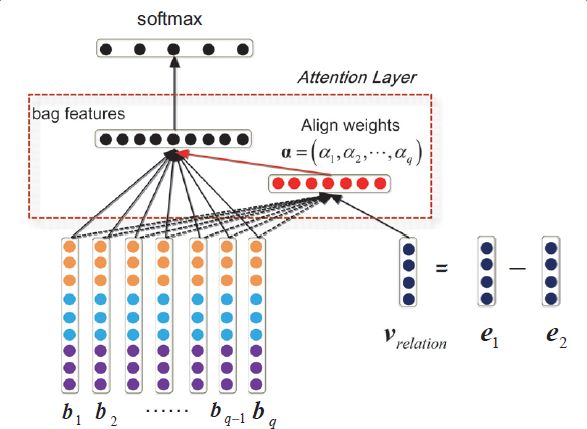

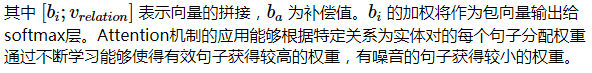

下圖顯示了各模型和改進(jìn)算法的準(zhǔn)確率和召回率的對(duì)比,其中Mintz不對(duì)遠(yuǎn)程監(jiān)督的wrong label problem做處理,直接用所有標(biāo)注樣例進(jìn)行訓(xùn)練;MultiR和MIML是采用概率圖模型進(jìn)行示例篩選的兩種多示例學(xué)習(xí)模型;PCNN+MIL是本章第一小節(jié)介紹的模型;APCNNs 在PCNN+MIL基礎(chǔ)上添加了attention機(jī)制;PCNNs+D在PCNN+MIL基礎(chǔ)上添加了對(duì)描述信息的使用;APCNNs+D在APCNNs基礎(chǔ)上添加了對(duì)描述信息的使用。實(shí)驗(yàn)采用的是該領(lǐng)域評(píng)測(cè)中使用較廣泛的New York Times(NYT)數(shù)據(jù)集(Riedel et al.,2010)。

深度學(xué)習(xí)方法在圖譜構(gòu)建中的應(yīng)用進(jìn)展

深度學(xué)習(xí)模型在神馬知識(shí)圖譜數(shù)據(jù)構(gòu)建中的應(yīng)用目前還處于探索階段,本章將介紹當(dāng)前的工作進(jìn)展和業(yè)務(wù)落地過程中遇到的一些問題。

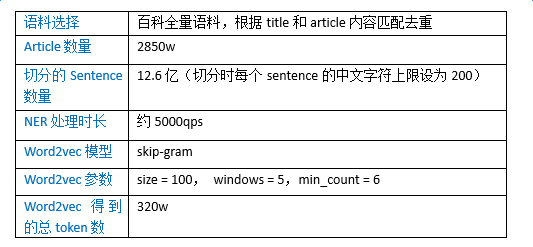

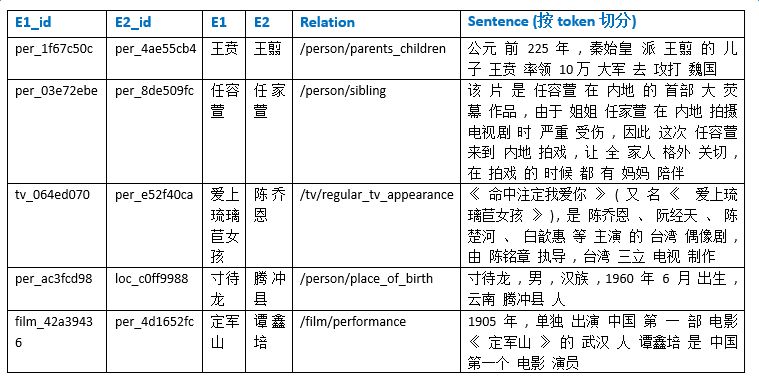

語料準(zhǔn)備和實(shí)體向量化

深度學(xué)習(xí)模型較大程度依賴于token向量化的準(zhǔn)確性。與基于DeepDive方法的語料準(zhǔn)備相同,這里的token切分由以詞為單位,改為以實(shí)體為單位,以NER環(huán)節(jié)識(shí)別的實(shí)體粒度為準(zhǔn)。Word2vec生成的向量表征token的能力與語料的全面性和語料的規(guī)模都很相關(guān),因此我們選擇百科全量語料作為word2vec的訓(xùn)練語料,各統(tǒng)計(jì)數(shù)據(jù)和模型參數(shù)設(shè)置如下表所示:

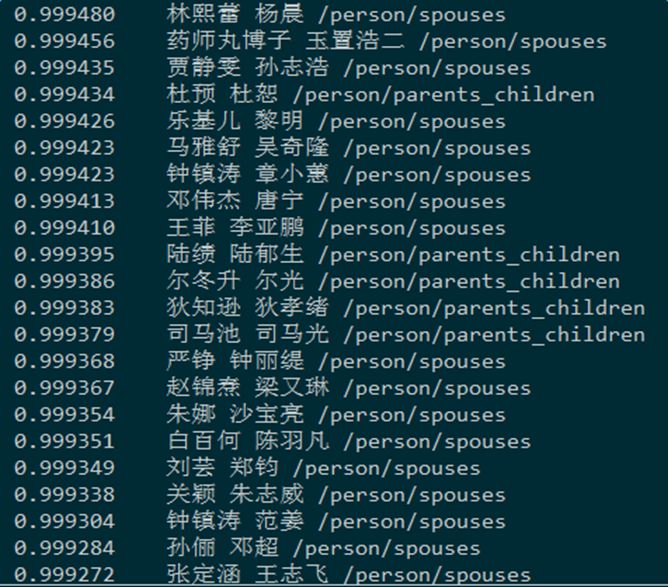

為了驗(yàn)證詞向量訓(xùn)練的效果,我們對(duì)word2vec的結(jié)果做了多種測(cè)試,這里給出部分實(shí)驗(yàn)數(shù)據(jù)。下圖所示的是給定一個(gè)實(shí)體,查找最相關(guān)實(shí)體的實(shí)驗(yàn):

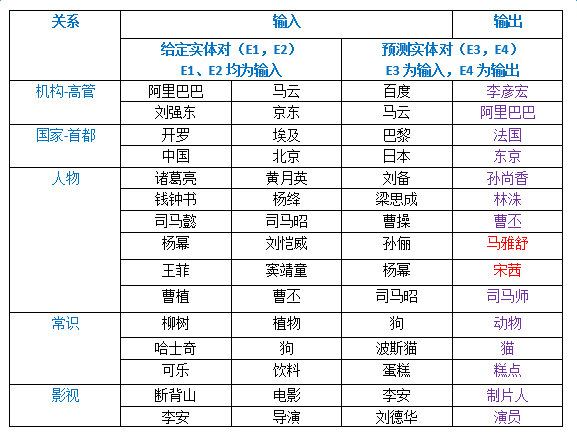

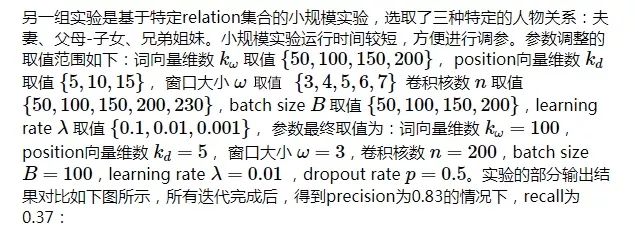

以下是給定一個(gè)實(shí)體對(duì)和預(yù)測(cè)實(shí)體對(duì)的其中一個(gè)實(shí)體,計(jì)算預(yù)測(cè)實(shí)體對(duì)中另一個(gè)實(shí)體的實(shí)驗(yàn)。隨機(jī)選取了五種預(yù)測(cè)關(guān)系,構(gòu)造了15組給定實(shí)體對(duì)和預(yù)測(cè)實(shí)體對(duì),預(yù)測(cè)結(jié)果如下圖所示,除了飄紅的兩個(gè)例子,其余預(yù)測(cè)均正確:

模型選取與訓(xùn)練數(shù)據(jù)準(zhǔn)備

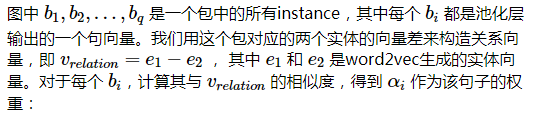

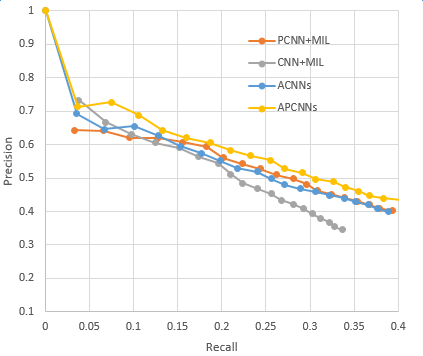

具體應(yīng)用中我們選擇采用APCNNs模型。我們?cè)贜YT標(biāo)準(zhǔn)數(shù)據(jù)集上復(fù)現(xiàn)了上一章提到的幾種關(guān)鍵模型,包括CNN+MIL,PCNN+MIL,CNNs(基于Attention機(jī)制的CNN模型)和APCNNs。復(fù)現(xiàn)結(jié)果與論文中給出的baseline基本一致,APCNNs模型的表現(xiàn)明顯優(yōu)于其它模型。下圖是幾種模型的準(zhǔn)召結(jié)果對(duì)比:

為了得到豐富的訓(xùn)練數(shù)據(jù),我們?nèi)≈R(shí)圖譜中建設(shè)相對(duì)完善的人物、地理位置、組織機(jī)構(gòu)、電影、電視、圖書等領(lǐng)域下的15個(gè)核心關(guān)系,如電影演員、圖書作者、公司高管、人物出生地等,對(duì)照百科全量語料,產(chǎn)出relation值為15個(gè)關(guān)系之一的標(biāo)注正例,合計(jì)數(shù)目在千萬量級(jí),產(chǎn)出無relation值標(biāo)注(relation值為NA)的示例超過1億。

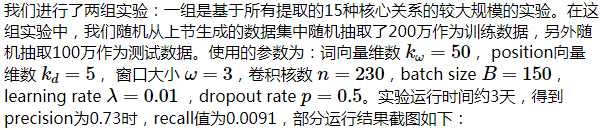

應(yīng)用嘗試和問題分析

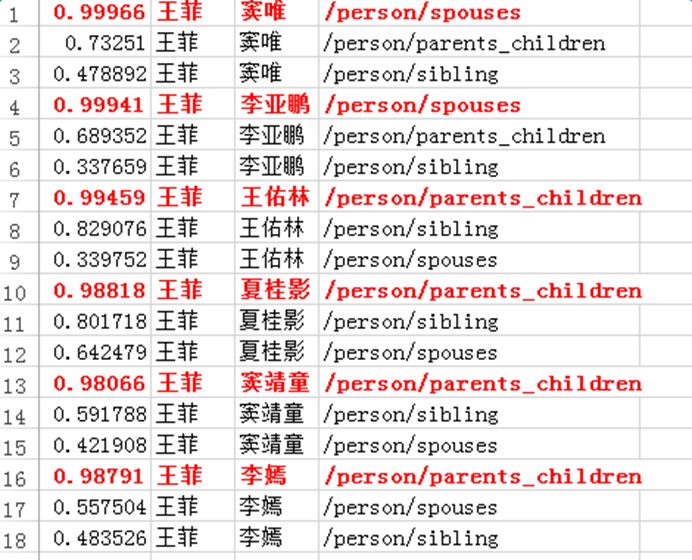

APCNNs模型在輔助知識(shí)圖譜數(shù)據(jù)構(gòu)建中目前還處于嘗試階段。就運(yùn)算能力而言,APCNNs模型相比DeepDive系統(tǒng)更有優(yōu)勢(shì),能在大規(guī)模語料上同時(shí)針對(duì)多個(gè)關(guān)系進(jìn)行計(jì)算,且迭代更新過程無需人工校驗(yàn)交互。但在業(yè)務(wù)落地過程中,我們也遇到了一些問題,總結(jié)如下:

大規(guī)模實(shí)驗(yàn)耗時(shí)過長(zhǎng),給參數(shù)的調(diào)整和每一次算法策略上的迭代增加了難度

目前學(xué)術(shù)界通用的測(cè)試語料是英文的NYT數(shù)據(jù)集,相同的模型應(yīng)用于中文語料時(shí),存在準(zhǔn)召率對(duì)標(biāo)困難的問題

深度學(xué)習(xí)的過程人工難以干預(yù)。假設(shè)我們要預(yù)測(cè)(楊冪,劉愷威)的婚姻關(guān)系,但從最初的基于大規(guī)模語料的詞向量生成開始,如果該語料中(楊冪,劉愷威)共現(xiàn)時(shí)的主導(dǎo)關(guān)系就不是婚姻關(guān)系,而是影視劇中的合作關(guān)系(如“該片講述楊冪飾演的夏晚晴在遭遇好友算計(jì)、男友婚變的窘境下,被劉愷威飾演的花花公子喬津帆解救,但卻由此陷入更大圈套的故事。”),或基于某些活動(dòng)的共同出席關(guān)系(如“楊冪與劉愷威共同擔(dān)任了新浪廈門愛心圖書館的公益大使”),則在attention步驟中得到的關(guān)系向量就會(huì)偏向合作關(guān)系,這將導(dǎo)致計(jì)算包中每個(gè)句子的權(quán)值時(shí),表達(dá)婚姻關(guān)系的句子難以獲得高分,從而導(dǎo)致后續(xù)學(xué)習(xí)中的偏差。

深度學(xué)習(xí)模型的結(jié)果較難進(jìn)行人工評(píng)測(cè),尤其對(duì)于知識(shí)圖譜中沒有出現(xiàn)的實(shí)體對(duì),需要在大規(guī)模的中間過程矩陣中進(jìn)行匹配和提取,將權(quán)重矩陣可視化為包中每個(gè)句子的得分,對(duì)計(jì)算資源和人工都有不小的消耗。

總結(jié)與展望

基于DeepDive的方法和基于深度學(xué)習(xí)的方法各有優(yōu)勢(shì)和缺陷,以下從4個(gè)方面對(duì)這兩種方法進(jìn)行總結(jié)和對(duì)比:

1、 語料的選取和范圍

Deepdive可適用于較小型、比較專門的語料,例如歷史人物的關(guān)系挖掘;可以針對(duì)語料和抽取關(guān)系的特點(diǎn)進(jìn)行調(diào)整規(guī)則,如婚姻關(guān)系的一對(duì)一或一對(duì)多,如偏文言文的語料的用語習(xí)慣等。

APCNNs模型適用于大規(guī)模語料,因?yàn)閍ttention機(jī)制能正常運(yùn)行的前提是word2vec學(xué)習(xí)到的實(shí)體向量比較豐富全面。

2、 關(guān)系抽取

Deepdive僅適用于單一關(guān)系的判斷,分類結(jié)果為實(shí)體對(duì)間某一關(guān)系成立的期望值。針對(duì)不同的關(guān)系,可以運(yùn)營(yíng)不同的規(guī)則,通過基于規(guī)則的標(biāo)注能較好地提升訓(xùn)練集的標(biāo)注準(zhǔn)確率。

APCNNs模型適用于多分類問題,分類結(jié)果為relation集合中的關(guān)系得分排序。無需針對(duì)relation集合中特定的某個(gè)關(guān)系做規(guī)則運(yùn)營(yíng)。

3、 長(zhǎng)尾數(shù)據(jù)

Deepdive更適用于長(zhǎng)尾數(shù)據(jù)的關(guān)系挖掘,只要是NER能識(shí)別出的實(shí)體對(duì),即使出現(xiàn)頻率很低,也能根據(jù)該實(shí)體對(duì)的上下文特征做出判斷。

APCNNs模型需要保證實(shí)體在語料中出現(xiàn)的次數(shù)高于一定的閾值,如min_count>=5,才能保證該實(shí)體有word2vec的向量表示。bag中有一定數(shù)量的sentence,便于選取相似度高的用于訓(xùn)練

4、 結(jié)果生成與檢測(cè)

Deepdive對(duì)輸出結(jié)果正誤的判斷僅針對(duì)單個(gè)句子,同樣的實(shí)體對(duì)出現(xiàn)在不同的句子中可能給出完全不同的預(yù)測(cè)結(jié)果。測(cè)試需要結(jié)合原句判斷結(jié)果是否準(zhǔn)確,好處是有原句作為依據(jù),方便進(jìn)行人工驗(yàn)證。

APCNNs模型針對(duì)特定的實(shí)體對(duì)做判斷,對(duì)于給定的實(shí)體對(duì),系統(tǒng)給出一致的輸出結(jié)果。對(duì)于新數(shù)據(jù)的結(jié)果正確性判斷,需要結(jié)合中間結(jié)果,對(duì)包中被選取的句子集合進(jìn)行提取和驗(yàn)證,增加了人工檢驗(yàn)有的難度。

在未來的工作中,對(duì)于基于DeepDive的方法,我們?cè)跀U(kuò)大抓取關(guān)系數(shù)目的同時(shí),考慮將業(yè)務(wù)實(shí)踐中沉淀的改進(jìn)算法流程化、平臺(tái)化,同時(shí)構(gòu)建輔助的信息增補(bǔ)工具,幫助減輕DeepDive生成結(jié)果寫入知識(shí)圖譜過程中的人工檢驗(yàn)工作,例如,對(duì)于婚姻關(guān)系的實(shí)體對(duì),我們可以從圖譜獲取人物的性別、出生年月等信息,來輔助關(guān)系的正誤判斷。

對(duì)于基于深度學(xué)習(xí)的方法,我們將投入更多的時(shí)間和精力,嘗試從以下幾方面促進(jìn)業(yè)務(wù)的落地和模型的改進(jìn):

將已被DeepDive證明有效的某些改進(jìn)算法應(yīng)用到深度學(xué)習(xí)方法中,例如根據(jù)關(guān)系相關(guān)的關(guān)鍵詞進(jìn)行過濾,縮小數(shù)據(jù)規(guī)模,提高運(yùn)行效率。

將計(jì)算中間結(jié)果可視化,分析attention過程中關(guān)系向量與sentence選取的關(guān)聯(lián),嘗試建立選取結(jié)果好壞的評(píng)判機(jī)制,嘗試?yán)酶S富的信息獲得更準(zhǔn)確的關(guān)系向量。

考慮如何突破預(yù)先設(shè)定的關(guān)系集合的限制,面向開放領(lǐng)域進(jìn)行關(guān)系抽取,自動(dòng)發(fā)現(xiàn)新的關(guān)系和知識(shí)。

探索除了文本以外其它形式數(shù)據(jù)的關(guān)系抽取,如表格、音頻、圖像等。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4806瀏覽量

102708 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122449

原文標(biāo)題:首次公開:深度學(xué)習(xí)在阿里知識(shí)圖譜構(gòu)建中的應(yīng)用

文章出處:【微信號(hào):thejiangmen,微信公眾號(hào):將門創(chuàng)投】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

如何才能高效地進(jìn)行深度學(xué)習(xí)模型訓(xùn)練?

深度學(xué)習(xí)在預(yù)測(cè)和健康管理中的應(yīng)用

深度學(xué)習(xí)模型是如何創(chuàng)建的?

什么是深度學(xué)習(xí)?使用FPGA進(jìn)行深度學(xué)習(xí)的好處?

Attention的具體原理詳解

為什么要有attention機(jī)制,Attention原理

移植深度學(xué)習(xí)算法模型到海思AI芯片

ChatGPT反思大語言模型的技術(shù)精要

大模型為什么是深度學(xué)習(xí)的未來?

簡(jiǎn)述深度學(xué)習(xí)中的Attention機(jī)制

深度學(xué)習(xí)模型介紹,Attention機(jī)制和其它改進(jìn)

深度學(xué)習(xí)模型介紹,Attention機(jī)制和其它改進(jìn)

評(píng)論