Hugging Face平臺于1月23日發布博文,推出了兩款令人矚目的輕量級AI模型——SmolVLM-256M-Instruct和SmolVLM-500M-Instruct。

其中,SmolVLM-256M-Instruct僅有2.56億參數,是有史以來發布的最小視覺語言模型,可在內存低于1GB的PC上運行并提供卓越性能。SmolVLM-500M-Instruct有5億參數,主要針對硬件資源限制,幫助開發者應對大規模數據分析挑戰。

這兩款模型具備先進的多模態能力,可執行圖像描述、短視頻分析以及回答關于PDF或科學圖表的問題等任務。其開發依賴于The Cauldron和Docmatix兩個專有數據集。The Cauldron包含50個高質量圖像和文本數據集,側重于多模態學習;Docmatix專為文檔理解定制,將掃描文件與詳細標題配對以增強理解。

此外,模型采用了更小的視覺編碼器SigLIP base patch-16/512,通過優化圖像標記處理方式,減少了冗余,還將圖像編碼速率提升至每個標記4096像素,相比早期版本的每標記1820像素有了顯著改進。

Hugging Face此次推出的最小AI視覺語言模型,為AI在低資源設備上的應用開辟了新的道路。

-

人工智能

+關注

關注

1806文章

49011瀏覽量

249347 -

語言模型

+關注

關注

0文章

561瀏覽量

10787 -

AI視覺

+關注

關注

0文章

88瀏覽量

4786

發布評論請先 登錄

如何基于Android 14在i.MX95 EVK上運行Deepseek-R1-1.5B和性能

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

DeepSeek模型為何掀起如此大的波瀾

新品| LLM630 Compute Kit,AI 大語言模型推理開發平臺

AI大語言模型開發步驟

NaVILA:加州大學與英偉達聯合發布新型視覺語言模型

大語言模型開發語言是什么

谷歌全新推出開放式視覺語言模型PaliGemma

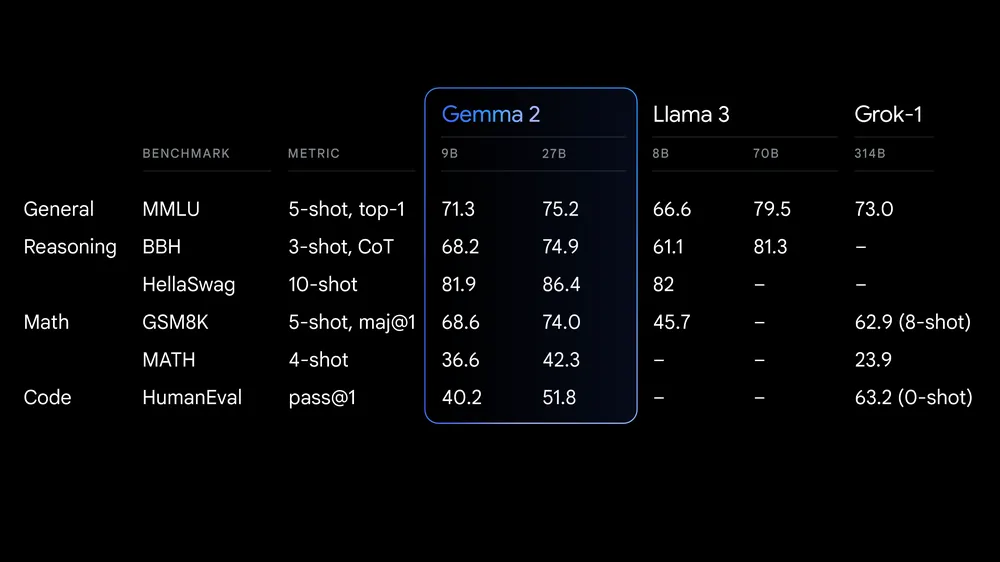

谷歌推出效率與性能躍階的全新開放模型標準

借助Arm Neoverse加速Hugging Face模型

Hugging Face推出最小AI視覺語言模型

Hugging Face推出最小AI視覺語言模型

評論