記錄一下RNN為什么可以記錄以前歷史信息,如何從公式中體現(xiàn)出?

那么首先介紹一下為什么普通的神經(jīng)網(wǎng)絡(luò)不能記憶以前的歷史信息,然后引出RNN的相應(yīng)能力,因為如果普通的神經(jīng)網(wǎng)絡(luò)能夠記錄以前的歷史信息的話,那么也就不會有RNN思想的誕生了。

1普通神經(jīng)網(wǎng)絡(luò)(MLP)

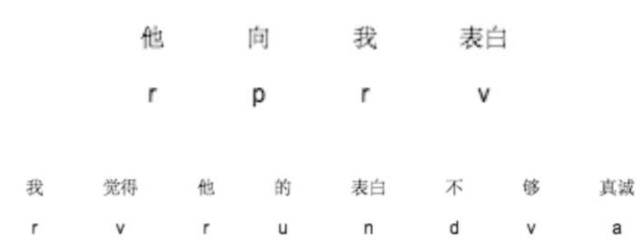

首先我們有一個任務(wù),就是進行詞性標注,下面有兩個訓練數(shù)據(jù)。

他向我表白我覺得他的表白不夠真誠

正確的詞性是:

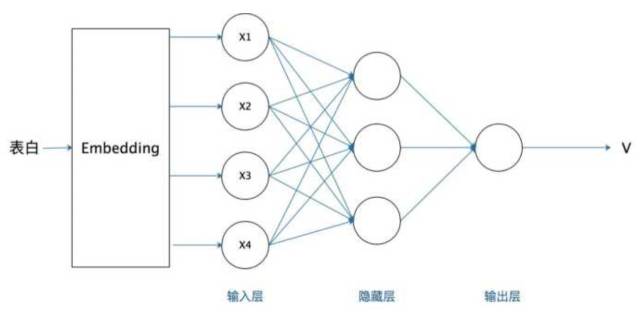

那么將這些訓練數(shù)據(jù)送給神經(jīng)網(wǎng)絡(luò)進行訓練,比如第一個數(shù)據(jù) “他/r”,神經(jīng)網(wǎng)絡(luò)學習 “他->r”的一個映射,第二個數(shù)據(jù) “向/p”,神經(jīng)網(wǎng)絡(luò)學習一個 “向->p”的映射,這樣一直將訓練數(shù)據(jù)學習完,更新到最后的參數(shù),從而學習到model,但是問題來了。

學習示例圖如下:

在上面的訓練數(shù)據(jù)中,有些詞語的詞性并不是唯一的,比如“表白”一詞,在“他向我表白”這句話中作為動詞v,在“我覺得他的表白不夠真誠”這句話中作為名詞n,所以對于神經(jīng)網(wǎng)絡(luò)來說,它是會學亂的。

一下子神經(jīng)網(wǎng)絡(luò)要學習“表白”是動詞,一下子又要學習“表白”是名詞,神經(jīng)網(wǎng)絡(luò)也很無辜呀,它沒有能力來處理什么情況下應(yīng)該將“表白”判別為名詞,什么情況下降“表白”判斷為動詞,因為神經(jīng)網(wǎng)絡(luò)學習不到周圍的語境。喂給神經(jīng)網(wǎng)絡(luò)的數(shù)據(jù)和之前的數(shù)據(jù)并沒有聯(lián)系。

所以我們這個時候就需要一個能夠記憶以前歷史信息的網(wǎng)絡(luò)出現(xiàn),比如在第一句話中,碰到表達一詞的時候,我知道他前面的詞是“我”/代詞,那么代詞后面的表白作為動詞的概率就遠大于名詞的表白,當然RNN還能夠看到他前面好幾個詞語,理論上rnn可以記憶當前詞語前面的任何詞。

同理在第二句話的時候,碰到“表白”一詞的時候,我們的網(wǎng)絡(luò)能夠知道他前面的詞是“的”/助詞,那么助詞后面的“表白”作為名詞的概率就遠大于動詞的”表白“。

所以我們希望能夠有一個網(wǎng)絡(luò)在預(yù)測當前任務(wù)的時候,能夠記憶以前的知識幫助當前的任務(wù)完成,這樣RNN就閃亮登場了,可能有些小伙伴會說,它存在很多問題,比如不能長期記憶,但是這篇文章不介紹,但是無論如何,RNN提供了這種問題解決的可能。

2循環(huán)神經(jīng)網(wǎng)絡(luò)記錄歷史信息RNN

首先來介紹一下RNN

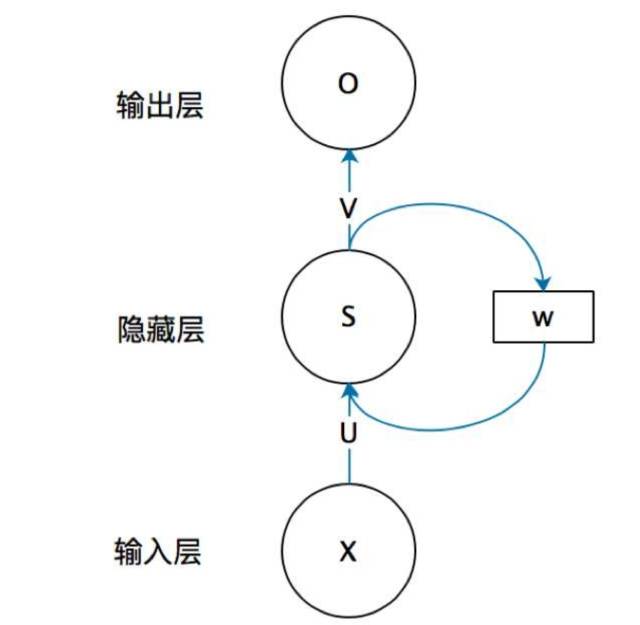

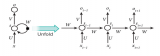

首先看一個簡單的循環(huán)神經(jīng)網(wǎng)絡(luò)如,它由輸入層、一個隱藏層和一個輸出層組成:

不知道初學的同學能夠理解這個圖嗎,反正我剛開始學習的時候是懵逼的,每個結(jié)點到底代表的是一個值的輸入,還是說一層的向量結(jié)點集合,如何隱藏層又可以連接到自己,等等這些疑惑~這個圖是一個比較抽象的圖。

我們現(xiàn)在這樣來理解,如果把上面有W的那個帶箭頭的圈去掉,它就變成了最普通的全連接神經(jīng)網(wǎng)絡(luò)。x是一個向量,它表示輸入層的值(這里面沒有畫出來表示神經(jīng)元節(jié)點的圓圈);s是一個向量,它表示隱藏層的值(這里隱藏層面畫了一個節(jié)點,你也可以想象這一層其實是多個節(jié)點,節(jié)點數(shù)與向量s的維度相同);

-

rnn

+關(guān)注

關(guān)注

0文章

89瀏覽量

7063

原文標題:【干貨】循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)為什么能夠記憶歷史信息

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

有關(guān)充電電池不得不說的幾個問題

什么是RNN (循環(huán)神經(jīng)網(wǎng)絡(luò))?

遞歸神經(jīng)網(wǎng)絡(luò)(RNN)

筆記本電池不得不說的秘密

筆記本電池不得不說的秘密

循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)的詳細介紹

三個最流行神經(jīng)網(wǎng)絡(luò)

普通神經(jīng)網(wǎng)絡(luò)MLP與RNN不得不說的秘密

普通神經(jīng)網(wǎng)絡(luò)MLP與RNN不得不說的秘密

評論