隨著人工智能生成內容(AIGC)的跨越式發展,算力需求呈爆炸式增長,帶動了數據中心的功耗和熱管理需求的飛速上升。AI模型訓練和推理過程中的高計算資源需求,導致服務器發熱量大幅增加,對散熱技術提出了更高的要求。根據Colocation America發布的數據,2020年全球數據中心單機柜平均功率已經達到16.5kW,比2008年增加了175%。液冷技術因此成為數據中心散熱技術的新熱點。

在今年的GTC大會上,英偉達不僅展示了B200和GB200芯片,還重點介紹了與其配套的液冷技術。同時,在2024年SIEPR經濟峰會上,英偉達CEO黃仁勛透露,下一代DGX GPU服務器將全面采用液冷散熱。英偉達的選擇也成為行業內的一個風向標,為液冷技術的發展注入了新的動力。

隨著AI技術的不斷進步,液冷技術的重要性也愈加凸顯。液冷技術不僅能夠有效降低數據中心的能耗,還能夠提高服務器的運行效率,延長設備的使用壽命。因此,液冷技術正逐步成為數據中心散熱解決方案的首選。

數據中心冷卻方式的比較

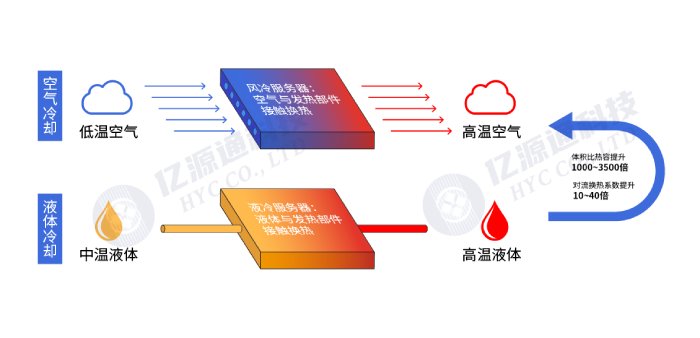

目前數據中心基礎設施的制冷方式主要有風冷和液冷兩種方式。液冷技術是指利用液體取代空氣作為冷卻介質,與服務器發熱元器件進行熱交換,將服務器元器件產生的熱量帶走,以保證服務器工作在安全溫度范圍內的一種冷卻方法。風冷技術依賴于風扇和空調系統,通過空氣流動帶走熱量。液冷技術通過液體直接冷卻發熱器件,液體的導熱能力是空氣的25倍,液體的體積比熱容是空氣的1000~3500倍,液體的對流換熱系數是空氣的10~40倍,同等情況下,液冷的冷卻能力遠高于空氣。

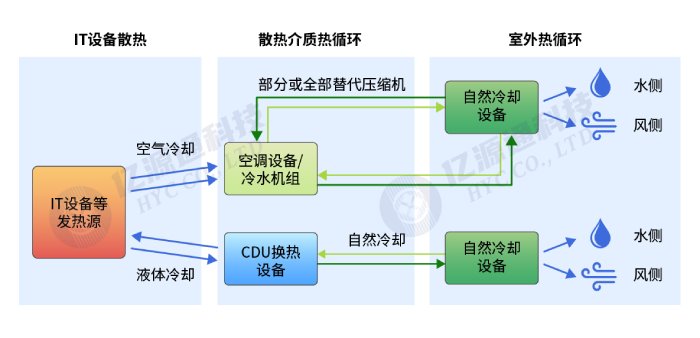

數據中心散熱架構圖

數據中心散熱架構圖  數據中心液冷VS風冷

數據中心液冷VS風冷

相比風冷技術,液冷技術具有更高的冷卻效率和更低的能耗。在高密度計算環境中,風冷系統往往無法滿足散熱需求,而液冷技術則能夠有效解決這一問題。此外,液冷技術還具有噪音低、占地面積小等優點,非常適合現代數據中心的高密度布局和綠色節能需求。

AI時代下,液冷發展有哪些推動力?

①算力芯片熱功率不斷攀升,風冷單點散熱已達極限

隨著AI技術的快速發展,算力需求不斷攀升,芯片發熱量和熱流密度也在不斷增加。當芯片長時間處于高溫運行狀態,會影響其性能及使用壽命,增加故障率。研究表明,當芯片的工作溫度接近70-80℃時,溫度每升高10℃,芯片性能會降低約50%。當前,Intel多款CPU的TDP已達350W,英偉達的H100達到700W,未來B100或將達到1000W,這已逼近風冷單點散熱極限800W。未來計算芯片功耗或將持續增長,而CPU和GPU的整體功耗在AI服務器總功耗中占比達到80%左右,繼續采用風冷散熱,將導致行間空調需求數量陡增,高密度散熱場景下液冷方案成本和性能優勢顯著。

除了芯片側,在機柜側,數據中心單機柜功率密度也在持續上升。傳統風冷技術通常可以解決12KW~15KW以內的機柜制冷極限需求,根據 UptimeInstitute 發布的《2022 年全球數據中心調查報告》,英偉達DGX A100服務器的單體最大功率為6.5KW,一個標準的 42U 高度的機柜大約可以放置 5個 5U 高度的 AI 服務器,單機柜總功率超過 20KW。傳統的風冷遠遠無法滿足AI服務器機柜的散熱需求。

②數據中心節能需求驅動,PUE更高要求

PUE(Power Usage Effectiveness)是評價數據中心能源效率的核心指標,計算公式為 PUE = 數據中心總能耗/IT設備能耗,數值越接近1,數據中心能效越高,PUE的值越高,數據中心的整體效率越低。

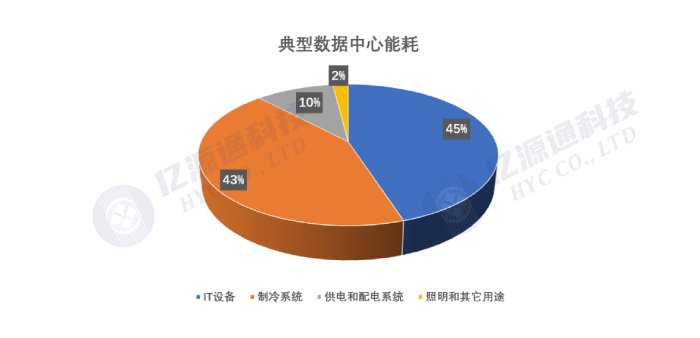

數據中心的電能消耗主要由IT設備(45%)、制冷設備(43%)、供配電系統(10%)、照明等(2%)構成。空調系統在數據中心能耗占比僅次于IT設備,在無法升級IT系統時,降低空調系統能耗是重要環節。國內在“雙碳” “東數西算” 政策的導向下,可以從近期國家有關部門發布的《綠色數據中心政府采購需求標準(試行)》的通知要求看出對于PUE的要求越來越高,其通知要求采購人采購數據中心相關設備、運維服務時,從2023年6月起數據中心PUE不高于1.4,2025年起數據中心PUE不高于1.3。 根據CDCC與浪潮信息,風冷方案數據中心PUE一般在1.4-1.5左右,而液冷數據中心PUE可降低至1.2以下,采用更加節能、效率較高的液冷散熱技術是大勢所趨。

數據中心的能源消耗一直是行業關注的焦點,尤其是在全球能源資源緊張和環保意識增強的背景下,提升數據中心的能效顯得尤為重要。液冷技術通過更高效的散熱方式,減少了空調系統的能耗,從而顯著降低了數據中心的PUE值。這不僅有助于降低運營成本,還能夠減少碳排放,符合可持續發展的要求。

典型數據中心能耗占比

典型數據中心能耗占比

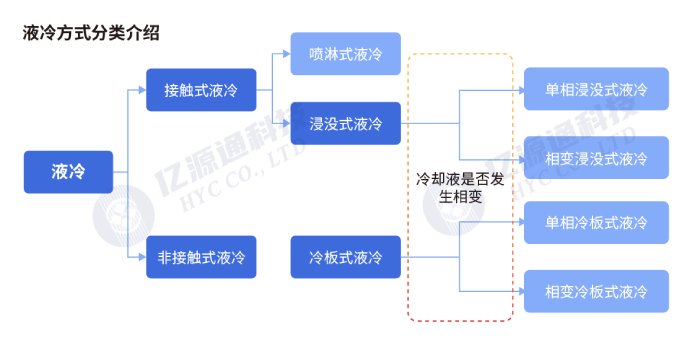

液冷技術的分類

液冷系統根據液體與硬件直接的接觸方式分為直接液冷和間接液冷,直接液冷就是液體與需要冷卻的硬件組件直接接觸達到冷卻的目的,又可分為浸沒式和噴淋式;間接液冷是指液體不與硬件直接接觸,通過一個中介組件(散熱器或冷卻板)將熱量帶走達到冷卻,一般常見的為冷板式液冷,根據冷卻介質是否發生相變又可分為單相冷板式和兩相冷板式。

液冷技術的分類

液冷技術的分類

①從冷板到浸沒式

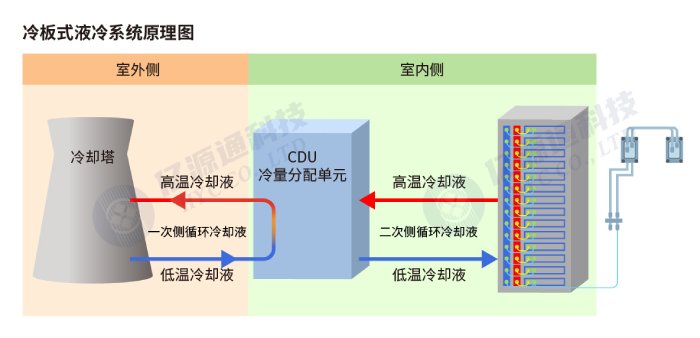

冷板式液冷是通過冷板把發熱器件的熱量傳遞到冷卻液體,通過冷卻液體本身的制冷特性將產生的熱量帶走。工作液體不與電子器件直接接觸,該技術對計算機系統改動不大,僅需將原風冷散熱片替換為液冷散熱套件并將冷媒管路引出機箱即可。適用于中高熱流密度散熱。

冷板式液冷系統主要由冷卻塔、冷量分配單元(CDU)、一次側&二次側液冷管路、冷卻介質、液冷機柜組成。一次側是指將二次側的熱量排至室外環境或其他熱回收單元的環路;二次側是指從服務器帶走熱量并在一次側進行散熱的環路,兩個部分中間通過CDU即冷量分配單元來進行換熱。

冷板式液冷系統的工作原理相對簡單,但在實際應用中,需要考慮冷板的設計、冷卻液的選擇以及系統的維護等問題。此外,冷板式液冷系統在高熱流密度環境中表現出色,非常適合現代數據中心的高密度布局需求。

冷板式液冷系統工作原理

冷板式液冷系統工作原理

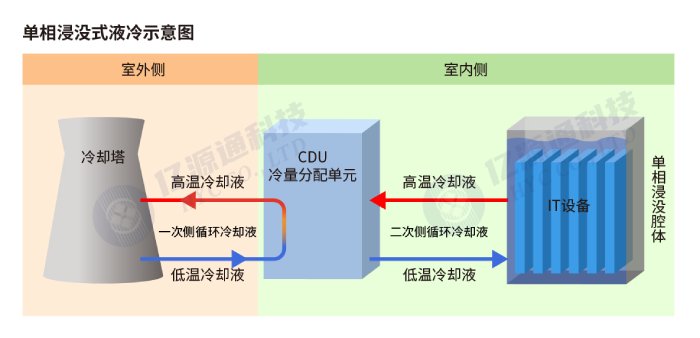

浸沒式液冷系統通過直接將發熱器件浸入不導電的冷卻液中實現高效散熱。按照冷卻液在循環散熱過程中是否發生相變,可以分為單相浸沒式液冷和雙相浸沒式液冷?

單相浸沒式液冷技術在交換過程中冷卻液溫度發生變化而不存在相態轉變,過程中完全依靠物質的顯熱變化傳遞熱量,即利用液體受熱后體積膨脹密度減小,較熱的冷卻液會自然上浮,通過外部冷卻回路的熱交換器冷卻,冷卻后的液體在重力作用下自然下沉,以此來完成循環散熱。這是其中一個方式,冷卻液在循環散熱過程中始終保持液態? 雙相浸沒式液冷的散熱過程中冷卻液會發生從液態到氣態再從氣態到液態的相變過程。

浸沒式液冷系統包括室內側與室外側,室外側包含冷卻塔、一次側管網、一次側冷卻液;室內側包含冷量分配單元(CDU)、浸沒腔體(Tank機柜)、IT設備、二次側管網和二次側冷卻液。使用過程中IT設備完全浸沒在冷卻液中,因此冷卻的選擇需要考慮不導電液體,例如硅油、氟化液等。

浸沒式液冷系統工作原理

浸沒式液冷系統工作原理

此外,還有噴淋式液冷,現階段落地應用較少,不適合高密度服務器和大規模數據中心。短期內,冷板式液冷因技術成熟、與現有系統兼容性好、維護方便和改造成本較低,非常適合AI時代對散熱的需求和數據中心從風冷向液冷的過渡階段。長期看,浸沒式液冷憑借其良好的導熱性能、高效的余熱回收能力和支持更高機柜功率的優勢,會更適合未來數據中心冷卻需求的演變,尤其是在機柜單元功率不斷增加的情況下,浸沒式液冷可以提供更高效的冷卻解決方案,并且助力降低數據中心的總體能源使用效率(PUE)。

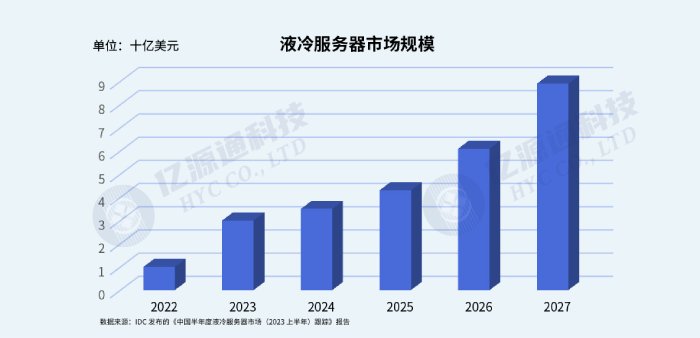

②智算中心首選 – 液冷

隨著功率密度的提升,采用液冷方案成為更多新建 GPU 算力中心的選擇。根據 IDC 發布的《中國半年度液冷服務器市場(2023 上半年)跟蹤》報告數據顯示, 2023 中國液冷服務器市場規模達到 15.1 億美元。 IDC 預計,2022-2027 年,中國液冷服務器市場年復合增長率將達到 54.7%,2027 年市場 規模將達到 89 億美元。

液冷技術在智算中心的應用,不僅提升了計算性能,還顯著降低了能耗和運營成本。液冷技術的推廣,將推動數據中心向更加高效、綠色和智能的方向發展,為AI時代的數據處理需求提供堅實的基礎。

液冷服務器市場規模

液冷服務器市場規模

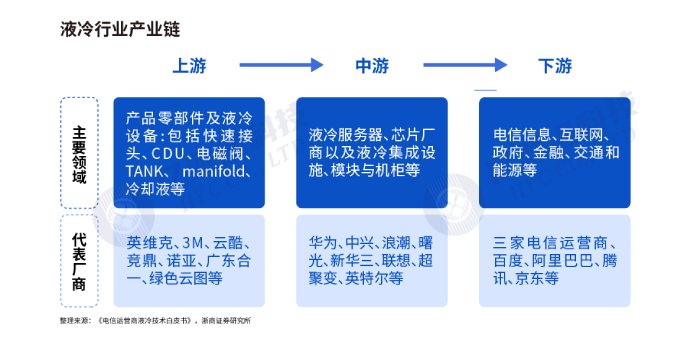

液冷產業鏈

液冷產業鏈包括上游的產品零部件提供商、中游的液冷服務器提供商、下游的算力使用者。目前下游的用戶,國內用戶阿里巴巴以單相浸沒式液冷為主要發展方向,其他如百度、騰訊、京東等互聯網企業更多的以冷板式液冷應用居多。海外用戶浸沒式發展優于冷板式,以美國公司為首,如英特爾、Google、Meta等互聯網大公司在AI加持下更多的推動浸沒式液冷的快速發展。

液冷產業鏈

液冷產業鏈

浸沒式液冷技術可能面臨的問題

冷卻液選擇

冷卻液是液冷技術的關鍵原材料之一,具備較高技術壁壘。在浸沒式液冷技術中,冷卻液需要與電子產品直接接觸,因此對冷卻液的性能具有較高的要求,需要具備優異的導熱性、良好的絕緣性、材料相容性等,此外對于氣味、毒性、降解難易等環境方面特性也是有一定要求,應盡可能的易于操作及環境又好型。目前應用最為廣泛的浸沒式冷卻液主要有碳氫及有機硅類(俗稱“油類”,如礦物油等)和碳氟化合物類(如氟化液等)。氟化液綜合性能較好,是比較理想的液冷材料。但氟化液目前的痛點在于成本較高。隨著愈發嚴格的環境保護要求,硅油擁有更高的導熱系數與更低的密度,同時對于環境更友好。冷卻介質選擇的差異主要由于冷卻過程的不同。

光路密封性問題

冷卻液如氟化液或硅油等具有良好的絕緣性,能夠有效防止電路短路。在低頻信號條件下,冷卻液對信號的影響幾乎可以忽略不計。然而,在高頻信號的情況下,冷卻液對信號傳輸的影響則需要謹慎評估和控制。但整體而言,對電路的影響是可控的。

而對于光路來說,數據中心的光模塊多數采用“非氣密”封裝設計,這意味著如果不進行相應的改進,冷卻液可能會進入光學腔體,影響光學性能。即便是采用氣密封裝的光模塊,仍有部分無源光路處于氣密腔之外,例如透鏡等光學元件。

光路的設計通常基于空氣的折射率(約為1.0),當光學元件浸沒在冷卻液中時,冷卻液的折射率不同于空氣,會導致光的焦點和耦合效率發生變化。例如,氟油的折射率通常在1.3左右,這種折射率的變化會引起光路設計參數的調整。

為應對浸沒式液冷對光路和電路的潛在影響,業界正在采取多種措施。例如,開發適應冷卻液環境的新型光模塊封裝技術,優化高頻信號的電路設計,以及研究更適合浸沒冷卻的光學材料和結構。

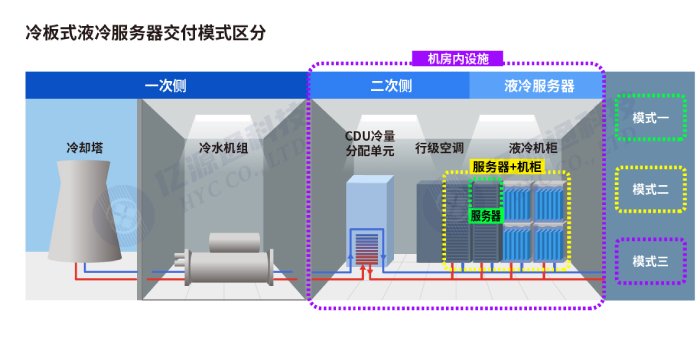

一體化交付還是解耦式交付

目前冷板式液冷服務器有三種交付模式,①IT設備側僅交付液冷服務器;②IT側交付“液冷服務器+液冷機柜”;③IT側交付“液冷服務器+液冷機柜+CDU+二次側管路”。當下應用較為廣泛的為第三種交付模式,即一體化交付,整體機柜由同一廠商一體化交付,由廠商自定義標準進行集成化設計開發。解耦交付是液冷機柜與液冷服務器之間遵循用戶統一制定的接口設計規范,機柜與服務器解耦,由不同廠家交付,基礎設施和服務器廠家需協調合作。解耦式交付易于規模化推廣與靈活部署。

冷板式液冷服務器交付模式

冷板式液冷服務器交付模式

目前國內液冷技術規劃化程度較低,各家服務器設備、冷卻液、制冷管路、供配電等產品形態各異,尚無統一接口標準,面臨著難以標準化、規模化推廣應用的問題。國內三大運營商發表液冷技術白皮書中提出液冷三年愿景,逐步開展液冷技術的驗證、實驗,將于2025年開展液冷技術的大規模應用,預計應用于50%以上數據項目,推動形成標準統一化、規模化,助推液冷解耦式交付。

HYC可提供定制化液冷光互聯方案

基于二十多年的光互聯關鍵技術積累,HYC具有高精度機械設計、模具、注塑設計與精密制造能力,以及光學設計、模擬仿真等技術平臺,能夠配合客戶做一系列的應用于液冷數據中心的布線系統ODM/JDM服務。

審核編輯 黃宇

-

數據中心

+關注

關注

16文章

5117瀏覽量

73165 -

AIGC

+關注

關注

1文章

382瀏覽量

2184

發布評論請先 登錄

英特爾引領液冷革新,與殼牌共筑數據中心高效冷卻新范式

RAKsmart液冷技術如何實現PUE<1.2的綠色數據中心

流量與壓力傳感:數據中心液冷的″智慧之眼″

華為亮相2025數據中心冷卻高峰論壇(長三角)

適用于數據中心和AI時代的800G網絡

施耐德電氣即將亮相2025中國數據中心液冷技術大會

偉創力收購數據中心液冷公司JetCool Technologies

龍蟠科技:以安全為核心樹立數據中心液冷技術新標桿

ALDC 2024第四屆數據中心液冷產業大會圓滿舉辦

液冷技術:迎接AIGC時代數據中心的散熱挑戰

液冷技術:迎接AIGC時代數據中心的散熱挑戰

評論