BP神經(jīng)網(wǎng)絡(luò)(Backpropagation Neural Network)是一種多層前饋神經(jīng)網(wǎng)絡(luò),通過反向傳播算法進行訓(xùn)練。它在許多領(lǐng)域,如模式識別、數(shù)據(jù)挖掘、預(yù)測分析等,都有廣泛的應(yīng)用。本文將介紹如何使用Python實現(xiàn)BP神經(jīng)網(wǎng)絡(luò)進行數(shù)據(jù)預(yù)測。

1. 神經(jīng)網(wǎng)絡(luò)基礎(chǔ)

1.1 神經(jīng)元模型

神經(jīng)元是神經(jīng)網(wǎng)絡(luò)的基本單元,它接收輸入信號,通過激活函數(shù)轉(zhuǎn)換,輸出信號。一個神經(jīng)元的數(shù)學(xué)模型如下:

[ y = f(sum_{i=1}^{n} w_i x_i + b) ]

其中,( x_i ) 是輸入信號,( w_i ) 是權(quán)重,( b ) 是偏置,( f ) 是激活函數(shù)。

1.2 激活函數(shù)

激活函數(shù)用于引入非線性,使得神經(jīng)網(wǎng)絡(luò)能夠?qū)W習(xí)和模擬復(fù)雜的函數(shù)映射。常見的激活函數(shù)包括:

- Sigmoid函數(shù):( f(x) = frac{1}{1 + e^{-x}} )

- Tanh函數(shù):( f(x) = tanh(x) )

- ReLU函數(shù):( f(x) = max(0, x) )

1.3 損失函數(shù)

損失函數(shù)用于衡量模型預(yù)測值與實際值之間的差異。常見的損失函數(shù)包括:

- 均方誤差(MSE):( L = frac{1}{n} sum_{i=1}^{n} (y_i - hat{y}_i)^2 )

- 交叉熵損失:常用于分類問題。

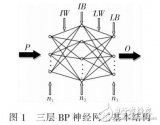

2. BP神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)

BP神經(jīng)網(wǎng)絡(luò)由輸入層、隱藏層和輸出層組成。數(shù)據(jù)從輸入層進入,通過隱藏層的非線性變換,最終在輸出層得到預(yù)測結(jié)果。

2.1 輸入層

輸入層的神經(jīng)元數(shù)量與問題的特征維度相同。

2.2 隱藏層

隱藏層可以有多個,每個隱藏層可以包含不同數(shù)量的神經(jīng)元。隱藏層的數(shù)量和神經(jīng)元數(shù)量需要根據(jù)具體問題進行調(diào)整。

2.3 輸出層

輸出層的神經(jīng)元數(shù)量取決于問題的輸出維度。對于回歸問題,輸出層通常只有一個神經(jīng)元;對于分類問題,輸出層的神經(jīng)元數(shù)量等于類別數(shù)。

3. 反向傳播算法

反向傳播算法是BP神經(jīng)網(wǎng)絡(luò)的核心,用于通過梯度下降法最小化損失函數(shù)。

3.1 前向傳播

數(shù)據(jù)從輸入層逐層傳遞到輸出層,每層的輸出作為下一層的輸入。

3.2 計算損失

使用損失函數(shù)計算模型預(yù)測值與實際值之間的差異。

3.3 反向傳播

從輸出層開始,逐層計算梯度,更新權(quán)重和偏置。

4. Python實現(xiàn)BP神經(jīng)網(wǎng)絡(luò)

4.1 導(dǎo)入庫

import numpy as np

4.2 初始化網(wǎng)絡(luò)參數(shù)

def initialize_parameters(layers):

params = {}

for i in range(1, len(layers)):

params['W' + str(i)] = np.random.randn(layers[i], layers[i-1]) * 0.01

params['b' + str(i)] = np.zeros((layers[i], 1))

return params

4.3 激活函數(shù)及其導(dǎo)數(shù)

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def sigmoid_derivative(x):

return x * (1 - x)

4.4 前向傳播

def forward_propagation(X, parameters):

caches = {}

A = X

for i in range(1, len(parameters) // 2 + 1):

W = parameters['W' + str(i)]

b = parameters['b' + str(i)]

Z = np.dot(W, A) + b

A = sigmoid(Z)

caches['A' + str(i)] = A

caches['Z' + str(i)] = Z

return A, caches

4.5 計算損失

def compute_cost(A3, Y):

m = Y.shape[1]

cost = (1 / m) * np.sum((A3 - Y) ** 2)

return cost

4.6 反向傳播

def backward_propagation(parameters, caches, X, Y):

grads = {}

m = X.shape[1]

A3 = caches['A3']

dA3 = - (np.divide(Y, A3) - np.divide(

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

7239瀏覽量

90972 -

BP神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

2文章

127瀏覽量

30845 -

python

+關(guān)注

關(guān)注

56文章

4823瀏覽量

86138 -

輸入信號

+關(guān)注

關(guān)注

0文章

471瀏覽量

12829

發(fā)布評論請先 登錄

用matlab編程進行BP神經(jīng)網(wǎng)絡(luò)預(yù)測時如何確定最合適的,BP模型

關(guān)于BP神經(jīng)網(wǎng)絡(luò)預(yù)測模型的確定!!

labview BP神經(jīng)網(wǎng)絡(luò)的實現(xiàn)

【案例分享】基于BP算法的前饋神經(jīng)網(wǎng)絡(luò)

如何設(shè)計BP神經(jīng)網(wǎng)絡(luò)圖像壓縮算法?

基于BP神經(jīng)網(wǎng)絡(luò)的PID控制

BP神經(jīng)網(wǎng)絡(luò)風(fēng)速預(yù)測方法

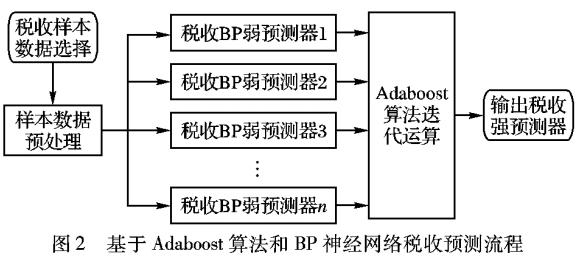

BP神經(jīng)網(wǎng)絡(luò)的稅收預(yù)測

BP神經(jīng)網(wǎng)絡(luò)概述

python做bp神經(jīng)網(wǎng)絡(luò)預(yù)測數(shù)據(jù)

python做bp神經(jīng)網(wǎng)絡(luò)預(yù)測數(shù)據(jù)

評論