BP(Back-propagation,反向傳播)神經(jīng)網(wǎng)絡(luò)是一種多層前饋神經(jīng)網(wǎng)絡(luò),通過反向傳播算法訓(xùn)練,以最小化預(yù)測(cè)值與實(shí)際值之間的誤差。BP神經(jīng)網(wǎng)絡(luò)因其廣泛的應(yīng)用和靈活性,在機(jī)器學(xué)習(xí)、人工智能以及數(shù)據(jù)處理等領(lǐng)域中占據(jù)重要地位。本文將以MATLAB為例,詳細(xì)介紹BP神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)方式,涵蓋基本原理、代碼實(shí)現(xiàn)及優(yōu)化策略,力求為讀者提供一個(gè)全面而深入的理解。

一、BP神經(jīng)網(wǎng)絡(luò)基本原理

BP神經(jīng)網(wǎng)絡(luò)的核心在于反向傳播算法,其基本原理可以簡(jiǎn)單概括為“信號(hào)的正向傳播,誤差的反向傳播”。具體而言,在訓(xùn)練過程中,輸入數(shù)據(jù)通過神經(jīng)網(wǎng)絡(luò)的各層進(jìn)行前向傳播,最終生成輸出。隨后,通過計(jì)算輸出值與期望輸出值之間的誤差,并反向傳播這個(gè)誤差,通過調(diào)整網(wǎng)絡(luò)中的權(quán)重和偏置,使得誤差逐漸減小。

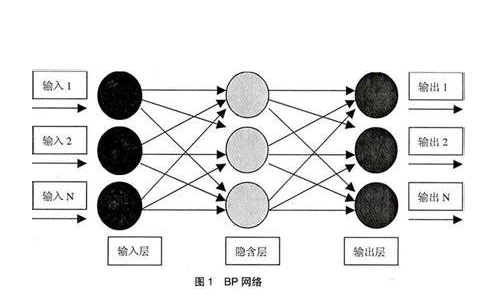

BP神經(jīng)網(wǎng)絡(luò)通常包括三層:輸入層、隱藏層和輸出層。其中,輸入層負(fù)責(zé)接收外部數(shù)據(jù),隱藏層對(duì)數(shù)據(jù)進(jìn)行復(fù)雜處理,輸出層則輸出最終結(jié)果。各層之間的連接通過權(quán)重和偏置實(shí)現(xiàn),并通過激活函數(shù)引入非線性因素,使得網(wǎng)絡(luò)能夠逼近復(fù)雜的非線性函數(shù)。

二、MATLAB中BP神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)

MATLAB提供了強(qiáng)大的神經(jīng)網(wǎng)絡(luò)工具箱(Neural Network Toolbox),使得在MATLAB中創(chuàng)建、訓(xùn)練和測(cè)試BP神經(jīng)網(wǎng)絡(luò)變得簡(jiǎn)單快捷。以下是一個(gè)詳細(xì)的步驟和示例代碼,展示如何在MATLAB中實(shí)現(xiàn)BP神經(jīng)網(wǎng)絡(luò)。

1. 數(shù)據(jù)準(zhǔn)備

首先,需要準(zhǔn)備用于訓(xùn)練的數(shù)據(jù)集。這包括輸入數(shù)據(jù)(特征)和對(duì)應(yīng)的目標(biāo)輸出(標(biāo)簽)。數(shù)據(jù)應(yīng)被劃分為訓(xùn)練集、驗(yàn)證集和測(cè)試集,以便在訓(xùn)練過程中評(píng)估模型的性能。

% 假設(shè)X為輸入數(shù)據(jù),Y為目標(biāo)輸出

load data.mat; % 加載數(shù)據(jù)

[trainInd, valInd, testInd] = dividerand(size(X, 2), 0.7, 0, 0.3); % 劃分?jǐn)?shù)據(jù)集

P_train = X(:, trainInd);

T_train = Y(:, trainInd);

P_test = X(:, testInd);

T_test = Y(:, testInd);

2. 數(shù)據(jù)歸一化

為了提高神經(jīng)網(wǎng)絡(luò)的訓(xùn)練效率和性能,通常需要對(duì)輸入數(shù)據(jù)進(jìn)行歸一化處理,將數(shù)據(jù)映射到同一量綱下。MATLAB中可以使用mapminmax函數(shù)進(jìn)行歸一化。

% 歸一化訓(xùn)練集

[Pn_train, inputps] = mapminmax(P_train, -1, 1);

% 應(yīng)用歸一化到測(cè)試集

Pn_test = mapminmax('apply', P_test, inputps);

3. 創(chuàng)建神經(jīng)網(wǎng)絡(luò)

在MATLAB中,可以使用newff函數(shù)來創(chuàng)建一個(gè)新的BP神經(jīng)網(wǎng)絡(luò)。這個(gè)函數(shù)允許用戶指定網(wǎng)絡(luò)的層數(shù)、每層的神經(jīng)元數(shù)量、激活函數(shù)以及訓(xùn)練算法。

% 假設(shè)網(wǎng)絡(luò)具有一個(gè)隱藏層,隱藏層有10個(gè)神經(jīng)元

inputnum = size(Pn_train, 1); % 輸入層節(jié)點(diǎn)數(shù)

hiddennum = 10; % 隱藏層節(jié)點(diǎn)數(shù)

outputnum = size(T_train, 1); % 輸出層節(jié)點(diǎn)數(shù)

net = newff(minmax(Pn_train), [hiddennum outputnum], {'logsig', 'purelin'}, 'trainlm');

4. 設(shè)置訓(xùn)練參數(shù)

在訓(xùn)練網(wǎng)絡(luò)之前,可以設(shè)置一些訓(xùn)練參數(shù),如學(xué)習(xí)率、訓(xùn)練次數(shù)、目標(biāo)精度等。

net.trainParam.epochs = 1000; % 訓(xùn)練次數(shù)

net.trainParam.lr = 0.01; % 學(xué)習(xí)率

net.trainParam.goal = 0.001; % 目標(biāo)精度

5. 訓(xùn)練網(wǎng)絡(luò)

使用train函數(shù)來訓(xùn)練網(wǎng)絡(luò)。訓(xùn)練完成后,可以通過view函數(shù)查看網(wǎng)絡(luò)的架構(gòu)和權(quán)重。

net = train(net, Pn_train, T_train);

view(net);

6. 測(cè)試網(wǎng)絡(luò)

訓(xùn)練完成后,使用測(cè)試集來評(píng)估網(wǎng)絡(luò)的性能。通過sim函數(shù)計(jì)算網(wǎng)絡(luò)的輸出,并計(jì)算誤差。

% 測(cè)試集預(yù)測(cè)

TestResults = sim(net, Pn_test);

TestResults = mapminmax('reverse', TestResults, outputps); % 反歸一化

TestError = TestResults - T_test;

TestMSE = mse(TestError);

% 繪制預(yù)測(cè)結(jié)果和真實(shí)值

figure;

plot(T_test, 'b-');

hold on;

plot(TestResults, 'r-');

legend('真實(shí)值', '預(yù)測(cè)值');

title('測(cè)試集預(yù)測(cè)結(jié)果');

grid on;

7. 性能評(píng)估與優(yōu)化

在BP神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)過程中,性能評(píng)估是不可或缺的一環(huán)。除了直接觀察預(yù)測(cè)結(jié)果的準(zhǔn)確性外,還可以利用多種性能指標(biāo)來量化網(wǎng)絡(luò)的性能,如均方誤差(MSE)、均方根誤差(RMSE)、平均絕對(duì)誤差(MAE)等。

7.1 性能評(píng)估

在前面的示例中,我們已經(jīng)計(jì)算了測(cè)試集的MSE(均方誤差)作為性能評(píng)估的一個(gè)指標(biāo)。此外,還可以根據(jù)需要計(jì)算其他指標(biāo),如:

% 計(jì)算RMSE

TestRMSE = sqrt(mean(TestError.^2));

% 計(jì)算MAE

TestMAE = mean(abs(TestError));

fprintf('測(cè)試集MSE: %fn', TestMSE);

fprintf('測(cè)試集RMSE: %fn', TestRMSE);

fprintf('測(cè)試集MAE: %fn', TestMAE);

7.2 網(wǎng)絡(luò)優(yōu)化

如果網(wǎng)絡(luò)的性能不滿足要求,可以通過多種方式進(jìn)行優(yōu)化:

- 調(diào)整網(wǎng)絡(luò)結(jié)構(gòu) :增加或減少隱藏層的層數(shù)、改變隱藏層的神經(jīng)元數(shù)量。一般來說,更復(fù)雜的網(wǎng)絡(luò)結(jié)構(gòu)能夠逼近更復(fù)雜的函數(shù),但也可能導(dǎo)致過擬合和訓(xùn)練時(shí)間增加。

- 修改激活函數(shù) :不同的激活函數(shù)對(duì)網(wǎng)絡(luò)的性能有不同的影響。例如,ReLU函數(shù)在很多情況下比Sigmoid或Tanh函數(shù)表現(xiàn)更好,因?yàn)樗軌蚓徑馓荻认栴}。

- 調(diào)整訓(xùn)練參數(shù) :包括學(xué)習(xí)率、動(dòng)量項(xiàng)、訓(xùn)練次數(shù)等。適當(dāng)?shù)膶W(xué)習(xí)率可以加快訓(xùn)練速度并避免過擬合;動(dòng)量項(xiàng)可以幫助網(wǎng)絡(luò)跳出局部最小值;增加訓(xùn)練次數(shù)可能提高模型的精度,但也可能導(dǎo)致過擬合。

- 使用正則化技術(shù) :如L1正則化、L2正則化或Dropout等,以減輕過擬合現(xiàn)象。

- 早停法(Early Stopping) :在驗(yàn)證集上監(jiān)控模型的性能,當(dāng)驗(yàn)證集上的性能開始下降時(shí)停止訓(xùn)練,以避免過擬合。

- 使用預(yù)訓(xùn)練模型 :在相關(guān)領(lǐng)域的數(shù)據(jù)集上預(yù)訓(xùn)練的模型可以作為初始模型,進(jìn)一步在特定任務(wù)上進(jìn)行微調(diào),以加快訓(xùn)練速度和提高性能。

8. 實(shí)際應(yīng)用與部署

BP神經(jīng)網(wǎng)絡(luò)訓(xùn)練完成后,可以將其應(yīng)用于實(shí)際問題的解決中。在MATLAB中,可以通過編寫腳本或函數(shù)來封裝訓(xùn)練好的網(wǎng)絡(luò),以便在其他數(shù)據(jù)上進(jìn)行預(yù)測(cè)。此外,MATLAB還提供了將訓(xùn)練好的模型導(dǎo)出為獨(dú)立應(yīng)用程序或代碼文件的功能,以便在沒有MATLAB環(huán)境的情況下進(jìn)行部署和使用。

對(duì)于需要高性能或?qū)崟r(shí)處理的場(chǎng)景,可以考慮將MATLAB模型轉(zhuǎn)換為C/C++代碼或使用MATLAB Compiler SDK進(jìn)行部署。這樣可以在保持模型精度的同時(shí),提高運(yùn)行效率和可移植性。

結(jié)論

BP神經(jīng)網(wǎng)絡(luò)作為一種經(jīng)典的神經(jīng)網(wǎng)絡(luò)模型,在MATLAB中通過神經(jīng)網(wǎng)絡(luò)工具箱可以方便地進(jìn)行實(shí)現(xiàn)、訓(xùn)練和測(cè)試。通過合理的數(shù)據(jù)準(zhǔn)備、網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)、訓(xùn)練參數(shù)調(diào)整以及性能評(píng)估與優(yōu)化,可以構(gòu)建出高性能的BP神經(jīng)網(wǎng)絡(luò)模型,并成功應(yīng)用于各種實(shí)際問題的解決中。希望本文的介紹能夠?yàn)樽x者在MATLAB中實(shí)現(xiàn)BP神經(jīng)網(wǎng)絡(luò)提供一定的幫助和參考。

-

matlab

+關(guān)注

關(guān)注

188文章

2995瀏覽量

233189 -

BP神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

2文章

127瀏覽量

30846 -

人工智能

+關(guān)注

關(guān)注

1804文章

48677瀏覽量

246341

發(fā)布評(píng)論請(qǐng)先 登錄

求利用LABVIEW 實(shí)現(xiàn)bp神經(jīng)網(wǎng)絡(luò)的程序

求基于labview的BP神經(jīng)網(wǎng)絡(luò)算法的實(shí)現(xiàn)過程

用matlab編程進(jìn)行BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)時(shí)如何確定最合適的,BP模型

關(guān)于BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型的確定!!

關(guān)于開關(guān)磁阻電機(jī)的matlab BP神經(jīng)網(wǎng)絡(luò)數(shù)學(xué)建模方面的資料

labview BP神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)

【案例分享】基于BP算法的前饋神經(jīng)網(wǎng)絡(luò)

如何設(shè)計(jì)BP神經(jīng)網(wǎng)絡(luò)圖像壓縮算法?

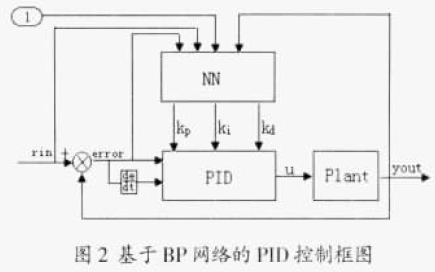

基于BP神經(jīng)網(wǎng)絡(luò)的PID控制

BP神經(jīng)網(wǎng)絡(luò)概述

BP神經(jīng)網(wǎng)絡(luò)的簡(jiǎn)單MATLAB實(shí)例免費(fèi)下載

如何使用BP神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)PID參數(shù)的在線整定及MATLAB仿真

基于MATLAB的BP神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)方式

基于MATLAB的BP神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)方式

評(píng)論