深度神經(jīng)網(wǎng)絡(luò)(Deep Neural Networks,DNNs)中的前饋過程是其核心操作之一,它描述了數(shù)據(jù)從輸入層通過隱藏層最終到達(dá)輸出層的過程,期間不涉及任何反向傳播或權(quán)重調(diào)整。這一過程是神經(jīng)網(wǎng)絡(luò)進(jìn)行預(yù)測或分類任務(wù)的基礎(chǔ)。

一、引言

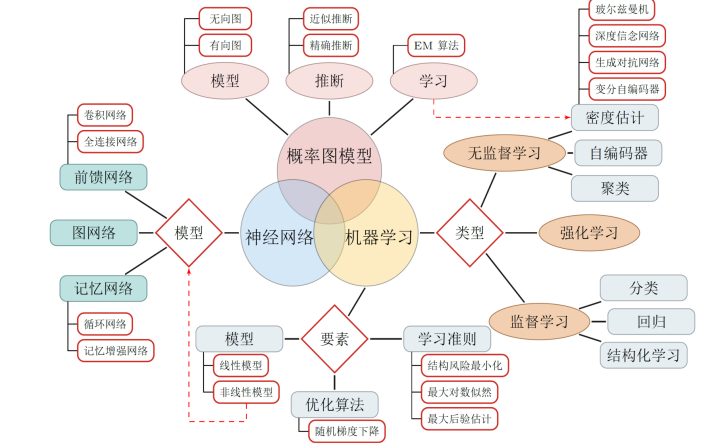

深度神經(jīng)網(wǎng)絡(luò)作為深度學(xué)習(xí)領(lǐng)域的基石,通過多層非線性變換來捕捉數(shù)據(jù)中的復(fù)雜模式和特征,進(jìn)而實(shí)現(xiàn)高精度的預(yù)測和分類任務(wù)。在前饋神經(jīng)網(wǎng)絡(luò)(Feedforward Neural Networks,F(xiàn)NNs)中,信息嚴(yán)格地從輸入層流向輸出層,每一層都通過一系列的權(quán)重和偏置對輸入進(jìn)行線性組合和非線性變換,最終生成網(wǎng)絡(luò)的輸出。本文將深入剖析深度神經(jīng)網(wǎng)絡(luò)中的前饋過程,包括其基本原理、實(shí)現(xiàn)步驟、激活函數(shù)的作用以及實(shí)際應(yīng)用中的挑戰(zhàn)與解決方案。

二、深度神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)

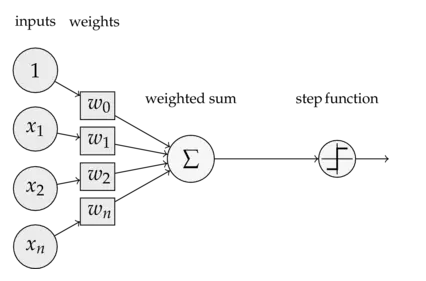

深度神經(jīng)網(wǎng)絡(luò)由多個層次組成,包括輸入層、隱藏層和輸出層。每一層都包含一定數(shù)量的神經(jīng)元(或稱節(jié)點(diǎn)),神經(jīng)元之間通過權(quán)重和偏置相互連接。在前饋過程中,輸入數(shù)據(jù)首先被送入輸入層,然后逐層向前傳播,經(jīng)過各隱藏層的線性組合和非線性變換,最終生成輸出層的結(jié)果。

- 輸入層 :接收原始數(shù)據(jù)作為輸入,不進(jìn)行任何變換,僅將數(shù)據(jù)傳遞給下一層。

- 隱藏層 :位于輸入層和輸出層之間,是神經(jīng)網(wǎng)絡(luò)中最重要的部分。隱藏層可以對輸入數(shù)據(jù)進(jìn)行多次非線性變換,提取出數(shù)據(jù)中的高級特征。隨著隱藏層數(shù)的增加,網(wǎng)絡(luò)能夠?qū)W習(xí)到更加復(fù)雜和抽象的特征表示。

- 輸出層 :接收來自隱藏層的最后一組數(shù)據(jù),經(jīng)過適當(dāng)?shù)淖儞Q后輸出最終的結(jié)果。對于分類任務(wù),輸出層通常采用softmax函數(shù)等將輸出轉(zhuǎn)換為概率分布;對于回歸任務(wù),則直接輸出預(yù)測值。

三、前饋過程的實(shí)現(xiàn)步驟

深度神經(jīng)網(wǎng)絡(luò)中的前饋過程可以概括為以下幾個步驟:

- 初始化參數(shù) :在訓(xùn)練開始前,需要隨機(jī)初始化網(wǎng)絡(luò)中的權(quán)重和偏置。這些參數(shù)將在訓(xùn)練過程中通過反向傳播算法進(jìn)行更新。

- 接收輸入數(shù)據(jù) :將待處理的數(shù)據(jù)送入輸入層。在實(shí)際應(yīng)用中,輸入數(shù)據(jù)通常需要經(jīng)過預(yù)處理操作,如標(biāo)準(zhǔn)化、歸一化等,以加快訓(xùn)練速度和提高模型性能。

- 前向傳播 :從輸入層開始,逐層計算每一層的輸出。對于隱藏層中的每一個神經(jīng)元,其輸入為前一層所有神經(jīng)元的輸出加權(quán)和加上偏置項(xiàng);然后,通過激活函數(shù)對加權(quán)和進(jìn)行非線性變換,得到該神經(jīng)元的輸出。這一過程將一直持續(xù)到輸出層生成最終結(jié)果。

- 計算輸出 :在輸出層,根據(jù)具體任務(wù)的需求對最后一層神經(jīng)元的輸出進(jìn)行適當(dāng)?shù)淖儞Q(如softmax函數(shù)、sigmoid函數(shù)等),以得到最終的預(yù)測結(jié)果或分類概率。

四、激活函數(shù)的作用

激活函數(shù)是深度神經(jīng)網(wǎng)絡(luò)中不可或缺的一部分,它引入了非線性因素,使得神經(jīng)網(wǎng)絡(luò)能夠?qū)W習(xí)復(fù)雜的模式和表示。在前饋過程中,激活函數(shù)對每一層神經(jīng)元的加權(quán)和進(jìn)行非線性變換,從而生成該神經(jīng)元的輸出。常見的激活函數(shù)包括Sigmoid、ReLU、Tanh等。

- Sigmoid函數(shù) :將輸入映射到(0,1)區(qū)間內(nèi),常用于二分類問題的輸出層。然而,Sigmoid函數(shù)在深度網(wǎng)絡(luò)中容易出現(xiàn)梯度消失問題,且其輸出不是以0為中心的,這可能導(dǎo)致收斂速度變慢。

- ReLU函數(shù) (Rectified Linear Unit):是目前最常用的激活函數(shù)之一。它對于所有正數(shù)輸入返回其本身,對于負(fù)數(shù)輸入則返回0。ReLU函數(shù)具有計算簡單、收斂速度快等優(yōu)點(diǎn),且在一定程度上緩解了梯度消失問題。然而,當(dāng)輸入小于0時,ReLU函數(shù)的導(dǎo)數(shù)為0,這可能導(dǎo)致部分神經(jīng)元在訓(xùn)練過程中“死亡”,即不再對輸入數(shù)據(jù)產(chǎn)生任何響應(yīng)。

- Tanh函數(shù) :將輸入映射到(-1,1)區(qū)間內(nèi),其輸出是以0為中心的。與Sigmoid函數(shù)相比,Tanh函數(shù)在訓(xùn)練初期收斂速度更快,但其計算復(fù)雜度和梯度消失問題仍然存在。

五、實(shí)際應(yīng)用中的挑戰(zhàn)與解決方案

在將深度神經(jīng)網(wǎng)絡(luò)應(yīng)用于實(shí)際問題時,可能會遇到一系列挑戰(zhàn),如梯度消失/爆炸、過擬合、計算資源限制等。針對這些問題,研究人員提出了多種解決方案:

- 梯度消失/爆炸 :通過選擇合適的激活函數(shù)(如ReLU)、使用批歸一化(Batch Normalization)等技術(shù)來緩解梯度消失/爆炸問題。此外,調(diào)整學(xué)習(xí)率、采用更先進(jìn)的優(yōu)化算法(如Adam)等也有助于改善梯度傳播效果。

- 過擬合 :通過增加數(shù)據(jù)集規(guī)模、采用正則化技術(shù)(如L1/L2正則化、Dropout等)、提前停止訓(xùn)練等方法來防止過擬合。此外,還可以利用集成學(xué)習(xí)方法,如Bagging、Boosting等,通過結(jié)合多個模型的預(yù)測結(jié)果來提高整體模型的泛化能力。

- 計算資源限制 :隨著深度神經(jīng)網(wǎng)絡(luò)層數(shù)的增加和模型復(fù)雜度的提升,對計算資源的需求也急劇增加。為了應(yīng)對這一挑戰(zhàn),研究人員開發(fā)了多種優(yōu)化技術(shù),包括模型剪枝(去除不重要的神經(jīng)元和連接)、量化(將模型權(quán)重從浮點(diǎn)數(shù)轉(zhuǎn)換為整數(shù)或更低精度的浮點(diǎn)數(shù))、知識蒸餾(將一個大型模型的知識遷移到一個小型模型中)等。此外,利用分布式計算和并行處理技術(shù)也是加速深度神經(jīng)網(wǎng)絡(luò)訓(xùn)練的有效手段。

- 數(shù)據(jù)不平衡 :在實(shí)際應(yīng)用中,不同類別的樣本數(shù)量往往存在顯著差異,這會導(dǎo)致模型在少數(shù)類樣本上的性能較差。為了解決數(shù)據(jù)不平衡問題,可以采用過采樣(增加少數(shù)類樣本的數(shù)量)、欠采樣(減少多數(shù)類樣本的數(shù)量)、合成少數(shù)類過采樣技術(shù)(SMOTE)等方法來平衡各類樣本的數(shù)量。同時,調(diào)整損失函數(shù),如使用加權(quán)交叉熵?fù)p失,也可以在一定程度上緩解數(shù)據(jù)不平衡帶來的問題。

- 可解釋性 :雖然深度神經(jīng)網(wǎng)絡(luò)在許多任務(wù)上取得了卓越的性能,但其決策過程往往難以解釋,這在一些需要高度可解釋性的領(lǐng)域(如醫(yī)療、法律等)中成為了一個障礙。為了提高深度神經(jīng)網(wǎng)絡(luò)的可解釋性,研究人員提出了多種方法,如特征可視化、注意力機(jī)制、LIME(Local Interpretable Model-agnostic Explanations)等。這些方法可以幫助我們理解模型是如何做出決策的,從而增加我們對模型預(yù)測結(jié)果的信任度。

六、前饋過程在深度學(xué)習(xí)框架中的實(shí)現(xiàn)

在現(xiàn)代深度學(xué)習(xí)框架(如TensorFlow、PyTorch等)中,前饋過程的實(shí)現(xiàn)變得非常簡便。這些框架提供了豐富的API和工具,使得我們可以輕松地構(gòu)建、訓(xùn)練和評估深度神經(jīng)網(wǎng)絡(luò)。在這些框架中,前饋過程通常通過定義一個計算圖(Computational Graph)來實(shí)現(xiàn),該圖描述了數(shù)據(jù)在網(wǎng)絡(luò)中的流動方向和變換過程。在訓(xùn)練過程中,框架會自動執(zhí)行前饋過程,并根據(jù)損失函數(shù)的梯度進(jìn)行反向傳播和參數(shù)更新。

七、結(jié)論與展望

深度神經(jīng)網(wǎng)絡(luò)中的前饋過程是神經(jīng)網(wǎng)絡(luò)進(jìn)行預(yù)測和分類任務(wù)的基礎(chǔ)。通過逐層傳遞和變換輸入數(shù)據(jù),深度神經(jīng)網(wǎng)絡(luò)能夠?qū)W習(xí)到數(shù)據(jù)中的復(fù)雜模式和特征,并生成準(zhǔn)確的預(yù)測結(jié)果。然而,在實(shí)際應(yīng)用中,我們還需要面對梯度消失/爆炸、過擬合、計算資源限制、數(shù)據(jù)不平衡和可解釋性等挑戰(zhàn)。為了解決這些問題,研究人員提出了多種優(yōu)化技術(shù)和方法。未來,隨著深度學(xué)習(xí)技術(shù)的不斷發(fā)展和完善,我們有理由相信深度神經(jīng)網(wǎng)絡(luò)將在更多領(lǐng)域發(fā)揮重要作用,并為人類帶來更多的便利和福祉。

同時,我們也應(yīng)該注意到,雖然深度神經(jīng)網(wǎng)絡(luò)在許多任務(wù)上取得了令人矚目的成績,但其背后仍存在許多未解之謎和待探索的領(lǐng)域。例如,如何進(jìn)一步提高深度神經(jīng)網(wǎng)絡(luò)的泛化能力、如何更好地理解和解釋深度神經(jīng)網(wǎng)絡(luò)的決策過程、如何更有效地利用有限的計算資源等。這些問題的解決不僅需要我們不斷探索和創(chuàng)新,還需要我們加強(qiáng)跨學(xué)科合作和交流,共同推動深度學(xué)習(xí)技術(shù)的發(fā)展和進(jìn)步。

-

函數(shù)

+關(guān)注

關(guān)注

3文章

4367瀏覽量

64076 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122432 -

深度神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

0文章

62瀏覽量

4665

發(fā)布評論請先 登錄

深度學(xué)習(xí)前饋神經(jīng)網(wǎng)絡(luò)技術(shù)分析

【案例分享】基于BP算法的前饋神經(jīng)網(wǎng)絡(luò)

基于三層前饋BP神經(jīng)網(wǎng)絡(luò)的圖像壓縮算法解析

懲罰函數(shù)優(yōu)化的前饋神經(jīng)網(wǎng)絡(luò)盲多用戶檢測

基于遞歸神經(jīng)網(wǎng)絡(luò)和前饋神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)預(yù)測算法

快速了解神經(jīng)網(wǎng)絡(luò)與深度學(xué)習(xí)的教程資料免費(fèi)下載

深度神經(jīng)網(wǎng)絡(luò)中的前饋過程

深度神經(jīng)網(wǎng)絡(luò)中的前饋過程

評論