生成式 AI 概述

生成式AI(Generative AI)是一種人工智能技術,它通過機器學習模型和深度學習技術,從大量歷史數據中學習對象的特征和規律,從而能夠生成全新的、完全原創的內容,包括文本、圖像、音頻和視頻等。與傳統的基于規則或模板的生成方法不同,生成式AI能夠自主創造內容,類似于人類的創作過程。

生成式AI的核心在于其能夠捕捉數據的內在結構和模式,并據此生成新的數據實例。這種能力依賴于復雜的模型架構和大量的訓練數據。例如,自然語言處理領域的生成式AI模型如GPT-3,能夠生成高質量的自然語言文本,用于聊天、寫作、自動化客服等多種場景。在圖像生成領域,生成對抗網絡(GANs)則是最具代表性的模型之一,它能夠生成逼真的圖像和視頻。

生成式 AI 的應用

生成式AI的應用范圍非常廣泛,包括但不限于以下幾個方面:

- 內容創作 :自動生成文章、詩歌、小說等文學作品,以及新聞稿、廣告文案等商業內容。

- 圖像和視頻生成 :生成逼真的圖像、視頻和動畫,用于娛樂、廣告、電影制作等領域。

- 輔助設計 :在建筑、時尚、工業設計等領域,生成式AI可以輔助設計師快速生成設計方案和草圖。

- 信息檢索 :通過生成式問答系統,提供基于自然語言的問題解答,提升用戶體驗。

- 語音合成 :將文本轉換為逼真的語音,應用于虛擬助理、有聲讀物等領域。

如何用 C++ 創建簡單的生成式 AI 模型

雖然C++不是構建和訓練復雜深度學習模型的首選語言(因為缺乏Python等語言提供的豐富庫和工具),但可以使用C++來調用或封裝在其他框架(如TensorFlow、PyTorch)中訓練的模型,或者使用特定的C++機器學習庫(如MLPack、DLib)來構建簡單的機器學習模型。

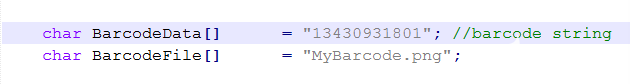

下面,我們將通過一個簡單的例子,展示如何使用C++加載和運行一個已經訓練好的生成式AI模型。這里假設我們有一個基于TensorFlow的已訓練模型,并希望在C++環境中進行推理。

步驟 1: 準備已訓練模型

首先,你需要在Python環境中使用TensorFlow訓練一個生成式AI模型,并將其保存為TensorFlow SavedModel格式。這個模型可以是任何類型的生成式模型,比如一個用于生成文本或圖像的模型。

步驟 2: 在 C++ 中加載模型

接下來,在C++環境中,你需要使用TensorFlow C++ API來加載這個模型。以下是一個簡化的示例代碼,展示了如何加載和運行一個SavedModel。

#include < tensorflow/core/public/session.h >

#include < tensorflow/core/platform/env.h >

#include < iostream >

#include < string >

#include < vector >

int main() {

// 指定模型的路徑

std::string export_dir = "/path/to/your/saved_model";

// 創建一個Session選項

tensorflow::SessionOptions sess_options;

// 創建一個新的Session

std::unique_ptr< tensorflow::Session > session(tensorflow::NewSession(sess_options));

// 準備輸入數據(這里只是一個示例,你需要根據你的模型輸入來準備數據)

std::vector< tensorflow::Tensor > inputs;

// 假設你的模型有一個名為"input_tensor"的輸入張量,并且你需要傳遞一個float類型的向量

tensorflow::Tensor input_tensor(tensorflow::DT_FLOAT, tensorflow::TensorShape({1, 10}));

// 假設輸入形狀為[1, 10]

auto input_tensor_mapped = input_tensor.tensor< float, 2 >();

// 填充輸入數據(這里只是示例數據)

for (int i = 0; i < 1; ++i) {

for (int j = 0; j < 10; ++j) {

input_tensor_mapped(i, j) = i + j;

}

}

inputs.push_back(input_tensor);

// 準備輸出張量的名稱(你需要根據你的模型輸出來指定)

std::vector< std::string > output_tensor_names = {"output_tensor"};

// 假設輸出張量名為"output_tensor"

// 運行Session

std::vector< tensorflow::Tensor > outputs;

tensorflow::RunOptions run_options;

tensorflow::Status status = session- >Run(

/* 運行的圖 */{},

/* 輸入張量 */{{"input_tensor", inputs[0]}},

/* 輸出張量 */output_tensor_names,

/* 目標節點(對于推理來說通常不需要) */{},

&outputs,

&run_options);

if (!status.ok()) {

std::cerr < < "Running model failed: " < < status.ToString() < < std::endl;

return -1;

}

// 輸出結果

// 假設輸出是一個float類型的張量,并且我們知道其形狀

if (!outputs.empty()) {

const tensorflow::Tensor& output_tensor = outputs[0];

auto output_tensor_mapped = output_tensor.tensor< float, 2 >();

// 假設輸出形狀為[1, n],其中n是生成的元素數量

int n = output_tensor.shape().dim_size(1);

std::cout < < "Generated Output:" < < std::endl;

for (int j = 0; j < n; ++j) {

std::cout < < output_tensor_mapped(0, j) < < " ";

}

std::cout < < std::endl;

}

return 0;

}

// 注意:上面的代碼是一個高度簡化的示例,用于展示如何在C++中加載和運行TensorFlow SavedModel。

// 在實際應用中,你需要根據模型的具體輸入輸出調整代碼,并且處理更復雜的數據結構和錯誤情況。

// 編譯和運行

// 要編譯上面的代碼,你需要有TensorFlow C++ API的庫文件。這通常涉及到下載TensorFlow源代碼并編譯它,或者使用預編譯的庫。

// 編譯命令可能類似于(具體取決于你的系統和TensorFlow版本):

// g++ -std=c++11 -o run_model run_model.cpp -I/path/to/tensorflow/include -L/path/to/tensorflow/lib -ltensorflow_cc -ltensorflow_framework

// 運行編譯后的程序:

// ./run_model

深入討論

挑戰與限制

- 復雜性 :C++相比于Python等語言,在編寫深度學習模型時更為復雜和低效。C++缺乏Python那樣的高級抽象和豐富的庫支持,因此需要更多的手動工作來管理內存、處理數據類型和調用API。

- 生態系統 :雖然TensorFlow提供了C++ API,但其C++生態系統相比于Python來說還不夠成熟和廣泛。這意味著你可能會遇到較少的教程、示例和社區支持。

- 性能 :盡管C++通常用于追求高性能,但在深度學習領域,Python的庫(如NumPy和PyTorch)經過高度優化,可以提供接近或達到C++的性能。此外,Python的靈活性也使其更適合于快速原型設計和實驗。

替代方案

- Python 封裝 :如果你更熟悉Python,并且你的項目允許,可以考慮在Python中訓練模型,并將其封裝為服務或使用其他語言(如C++)的庫來調用。

- 使用其他C++庫 :除了TensorFlow,還有其他一些C++機器學習庫(如MLPack、DLib)也支持簡單的機器學習模型。這些庫可能更適合于那些不需要深度學習或只需要簡單模型的項目。

- 跨語言接口 :你可以使用如gRPC或ZeroMQ這樣的跨語言通信框架,在Python中運行深度學習模型,并通過網絡接口與C++應用程序進行交互。

結論

生成式AI是一個強大的工具,能夠生成全新的、高質量的內容。盡管C++不是構建和訓練復雜生成式AI模型的首選語言,但它仍然可以在模型推理和部署階段發揮重要作用。通過結合使用C++和Python(或其他高級語言),你可以充分利用兩種語言的優點,構建出既高效又靈活的生成式AI應用。

-

人工智能

+關注

關注

1804文章

48677瀏覽量

246343 -

C++

+關注

關注

22文章

2117瀏覽量

74770 -

生成式AI

+關注

關注

0文章

525瀏覽量

703

發布評論請先 登錄

NVIDIA AI Foundry 為全球企業打造自定義 Llama 3.1 生成式 AI 模型

使用CUBEAI部署tflite模型到STM32F0中,模型創建失敗怎么解決?

如何用STM32CubeMX生成底層代碼?代碼中C++的編寫要注意哪些事項?

NVIDIA 為全球企業帶來生成式 AI 推出用于創建大型語言模型和視覺模型的云服務

GTC23 | NVIDIA 為全球企業帶來生成式 AI,推出用于創建大型語言模型和視覺模型的云服務

什么是生成式AI?生成式AI的四大優勢

如何選擇創建c語言和c++

生成式AI與神經網絡模型的區別和聯系

三行代碼完成生成式AI部署

如何用C++創建簡單的生成式AI模型

如何用C++創建簡單的生成式AI模型

評論