Firefly開(kāi)源團(tuán)隊(duì)推出了 Llama3 部署包,提供簡(jiǎn)易且完善的部署教程,過(guò)程無(wú)需聯(lián)網(wǎng),簡(jiǎn)單快捷完成本地化部署。

Step.1

準(zhǔn)備部署包

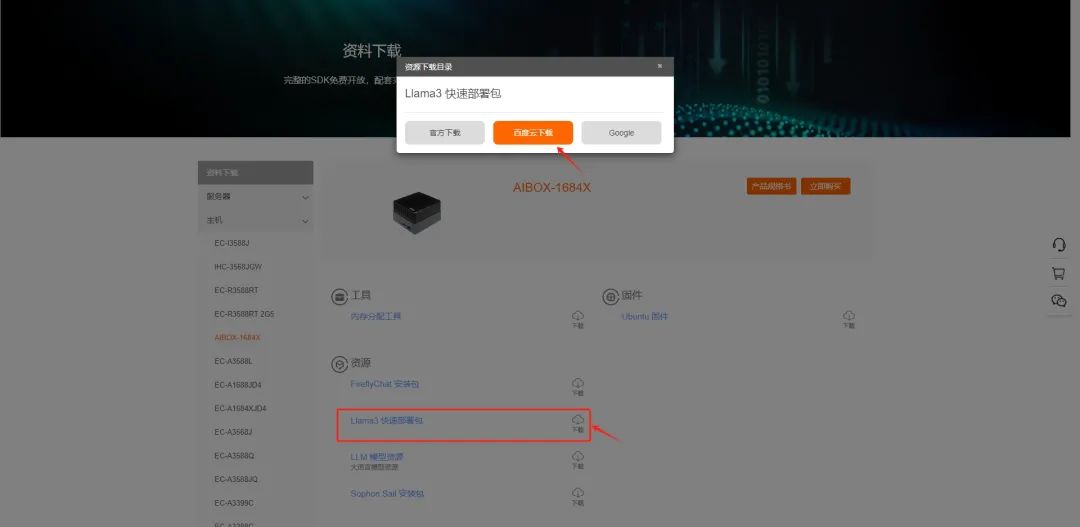

進(jìn)入 Firefly下載中心,下載 Llama3 部署包。

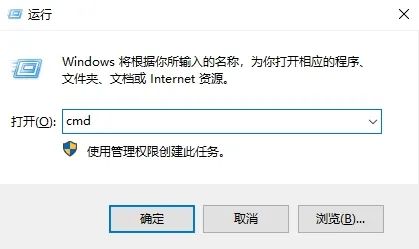

在電腦上以管理員身份打開(kāi)cmd:

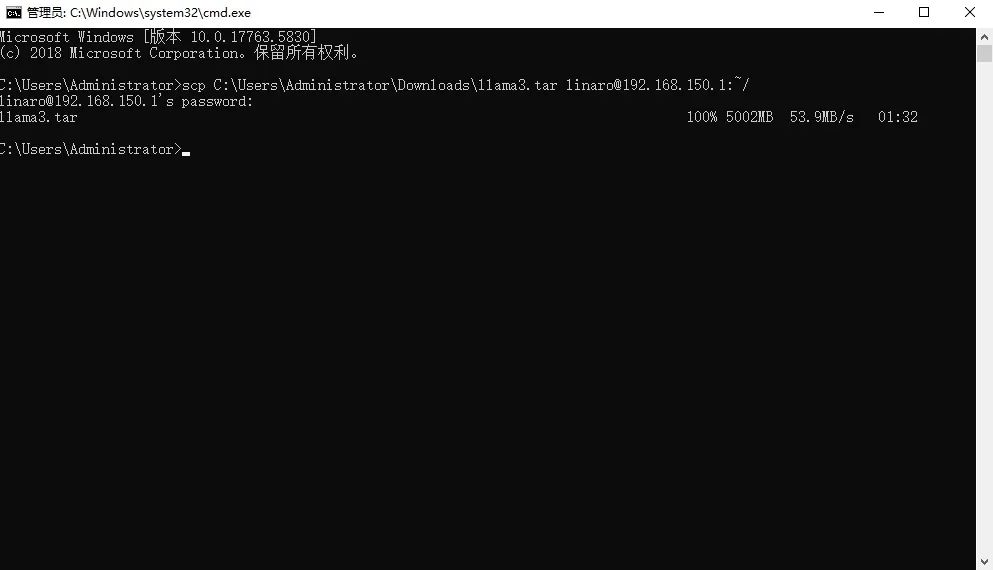

執(zhí)行 scp 命令傳輸部署包至AIBOX,并輸入密碼 linaro 獲取訪問(wèn)權(quán)限。

scpllama3.tarlinaro@:~/

其中為模型實(shí)際的文件路徑, 是 AIBOX-BM1684X 的 IP 地址

例:scp C:\Users\Administrator\Downloads\llama3.tar [email protected]:~/

Step.2

部署Llama3

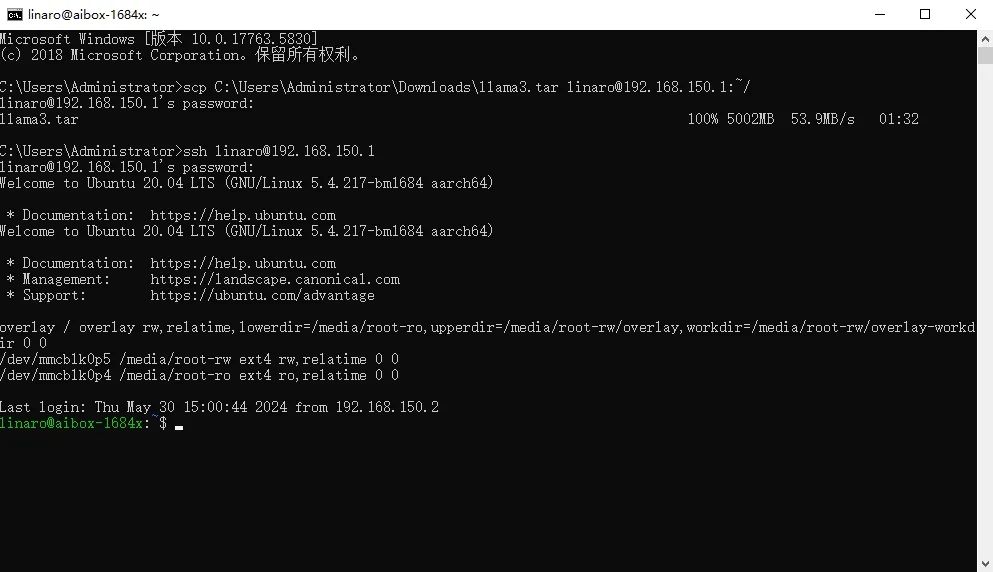

完成部署包的傳輸后,執(zhí)行登錄命令,連接 AIBOX,并輸入密碼 linaro。

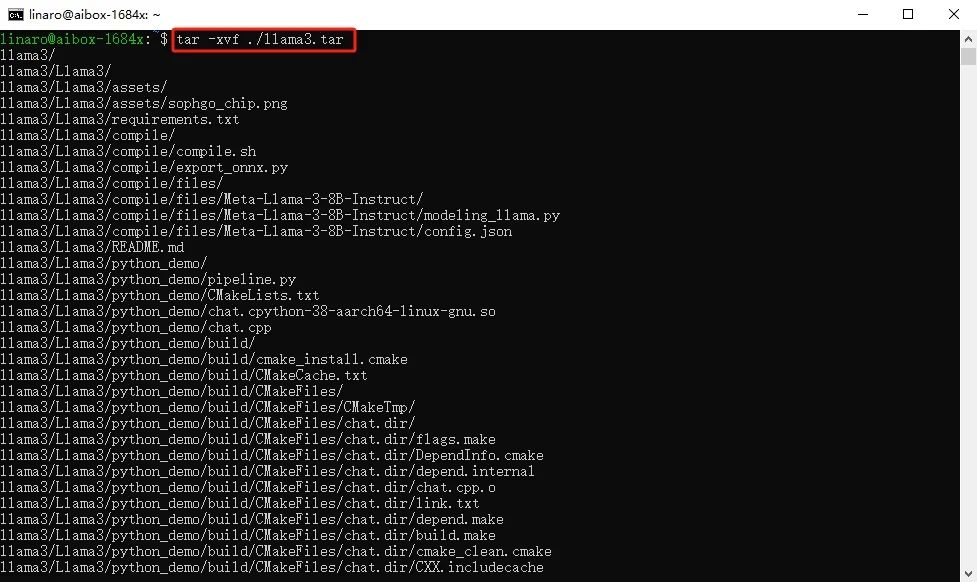

執(zhí)行以下解壓命令,解壓部署包,等到解壓完成。

tar-xvf./llama3.tar

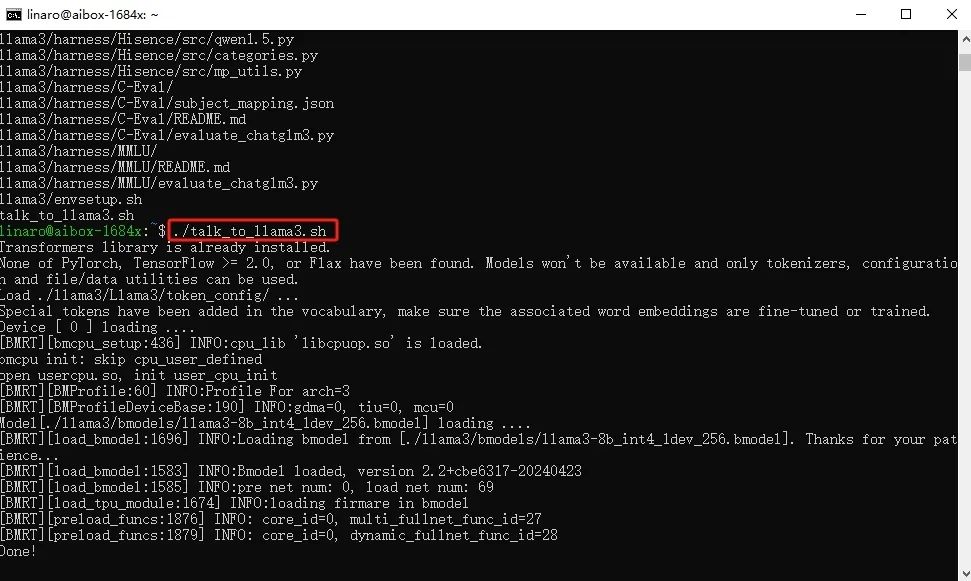

解壓完成后,執(zhí)行部署腳本,等待部署完成。

./talk_to_llama3.sh

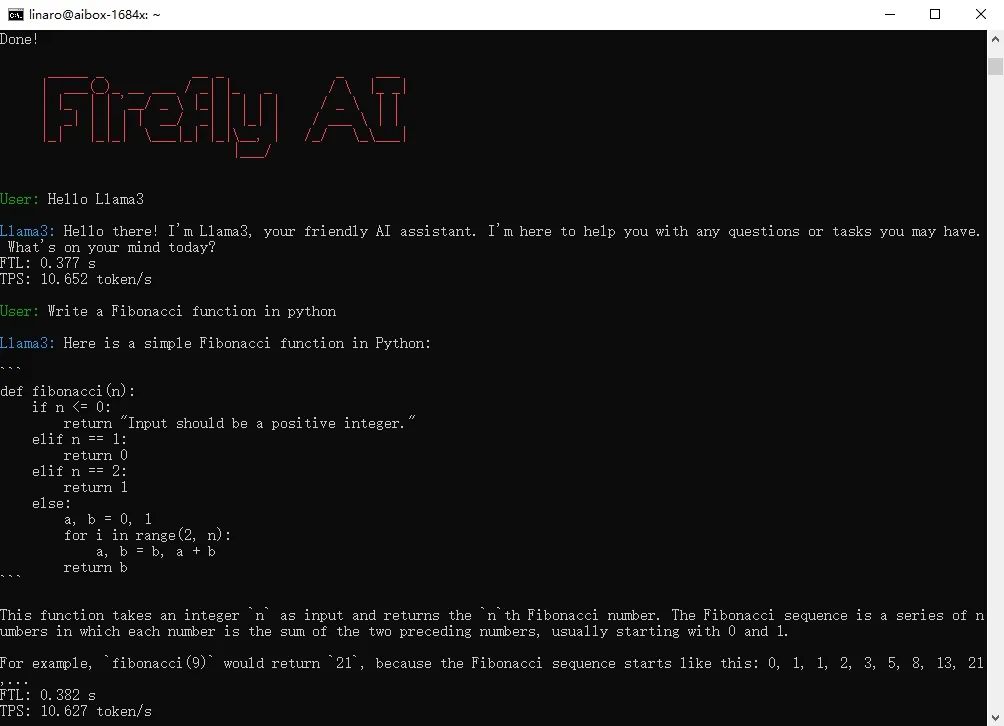

使用Llama3

部署完成后,即可使用 Llama3。

Tip:部署過(guò)程中無(wú)需聯(lián)網(wǎng),首次部署 Llama3 需要花費(fèi)較長(zhǎng)時(shí)間進(jìn)行相應(yīng)的軟件安裝(3-5min),請(qǐng)耐心等待。

-

軟件

+關(guān)注

關(guān)注

69文章

5117瀏覽量

88898 -

Firefly

+關(guān)注

關(guān)注

2文章

541瀏覽量

7387

發(fā)布評(píng)論請(qǐng)先 登錄

龍芯2K0300蜂鳥(niǎo)板快速上手指南

HMI-Board OTA升級(jí)快速上手指南

Raspberry Pi樹(shù)莓派新手指南

【AIBOX應(yīng)用】通過(guò) NVIDIA TensorRT 實(shí)現(xiàn)實(shí)時(shí)快速的語(yǔ)義分割

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

Llama 3 的未來(lái)發(fā)展趨勢(shì)

Llama 3 與開(kāi)源AI模型的關(guān)系

Llama 3 性能評(píng)測(cè)與分析

Llama 3 適合的行業(yè)應(yīng)用

Llama 3 語(yǔ)言模型應(yīng)用

使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型

[技術(shù)] 【飛凌嵌入式OK3576-C開(kāi)發(fā)板體驗(yàn)】llama2.c部署

源2.0-M32大模型發(fā)布量化版 運(yùn)行顯存僅需23GB 性能可媲美LLaMA3

【AIBOX上手指南】快速部署Llama3

【AIBOX上手指南】快速部署Llama3

評(píng)論